朴素贝叶斯分类及R语言实现

贝叶斯模型 r语言

贝叶斯模型 r语言贝叶斯模型是一种常用的概率模型,它基于贝叶斯定理,用于从已知数据中推断未知参数的概率分布。

在R语言中,我们可以使用贝叶斯统计学包(Bayesian statistics package)进行贝叶斯分析。

贝叶斯模型的核心思想是将先验知识和观测数据相结合,通过贝叶斯定理得到后验概率分布。

贝叶斯定理表示,给定观测数据D和模型参数θ,后验概率P(θ|D)与先验概率P(θ)和似然函数P(D|θ)的乘积成正比。

可以表示为:P(θ|D) = P(D|θ) * P(θ) / P(D)其中,P(θ|D)是后验概率,P(D|θ)是似然函数,P(θ)是先验概率,P(D)是边缘概率。

在R语言中,我们可以使用贝叶斯统计学包进行贝叶斯推断。

首先,我们需要定义先验分布和似然函数。

先验分布表示我们对参数的初始认识,似然函数表示参数在观测数据下的概率分布。

然后,通过贝叶斯定理,我们可以计算出后验概率分布。

在贝叶斯模型中,还需要确定一个重要的参数,即超参数(hyperparameter)。

超参数是模型参数的先验分布的参数,它的选择对于后验概率的精度和准确性有很大影响。

通常,我们通过最大似然估计或经验贝叶斯方法来确定超参数的值。

在R语言中,我们可以使用各种统计学包来进行贝叶斯模型的分析。

例如,rstan、JAGS和BUGS等包提供了灵活的工具来进行贝叶斯统计分析。

这些包可以对复杂的模型进行建模和推断,并提供了丰富的函数和工具来进行参数估计、模型比较和预测。

除了基本的贝叶斯模型,R语言还提供了一些扩展的贝叶斯方法。

例如,贝叶斯网络(Bayesian network)是一种图形模型,用于表示随机变量之间的依赖关系。

贝叶斯网络在机器学习和数据挖掘中广泛应用,可以用于分类、回归和聚类等任务。

R语言还提供了一些贝叶斯模型的评估和比较方法。

例如,贝叶斯信息准则(Bayesian information criterion,BIC)和迭代贝叶斯模型平均(iterative Bayesian model averaging,IBMA)等方法可以用来选择最优的模型。

朴素贝叶斯算法的实现步骤(Ⅲ)

朴素贝叶斯算法(Naive Bayes)是一种基于贝叶斯定理和特征条件独立假设的分类算法。

它是一种常用的机器学习算法,被广泛应用于文本分类、垃圾邮件过滤、情感分析等领域。

本文将介绍朴素贝叶斯算法的实现步骤,包括数据预处理、模型训练和分类预测等环节。

通过本文的学习,读者可以掌握朴素贝叶斯算法的基本原理和实现方法。

一、数据预处理在应用朴素贝叶斯算法之前,首先需要进行数据预处理。

数据预处理包括数据清洗、特征提取和数据划分等步骤。

首先,需要对原始数据进行清洗,去除缺失值和异常值。

然后,通过特征提取的方法,将文本数据转换成特征向量表示。

最后,将数据划分为训练集和测试集,用于模型的训练和评估。

二、模型训练在数据预处理完成之后,就可以开始进行朴素贝叶斯模型的训练。

首先,需要计算训练集中每个类别的先验概率。

先验概率可以通过统计每个类别样本的数量并进行归一化得到。

然后,需要计算每个特征在每个类别下的条件概率。

条件概率可以通过统计每个特征在每个类别下的频数并进行归一化得到。

最后,将先验概率和条件概率组合起来,得到朴素贝叶斯模型。

三、分类预测模型训练完成之后,就可以用训练好的朴素贝叶斯模型进行分类预测。

对于新的样本,首先需要计算每个类别的后验概率。

后验概率可以通过先验概率和条件概率进行计算得到。

然后,选择具有最大后验概率的类别作为预测结果。

四、模型评估最后,需要对朴素贝叶斯模型进行评估。

评估指标包括准确率、精确率、召回率和F1值等。

准确率是分类正确的样本数量占总样本数量的比例。

精确率是分类为正例的样本中真正为正例的比例。

召回率是真正为正例的样本中被正确分类为正例的比例。

F1值是精确率和召回率的调和平均数。

通过评估指标的计算,可以得到对朴素贝叶斯模型的性能评价。

总结朴素贝叶斯算法是一种简单且高效的分类算法。

通过对数据预处理、模型训练、分类预测和模型评估等环节的实现步骤的介绍,读者可以深入了解朴素贝叶斯算法的原理和实现方法。

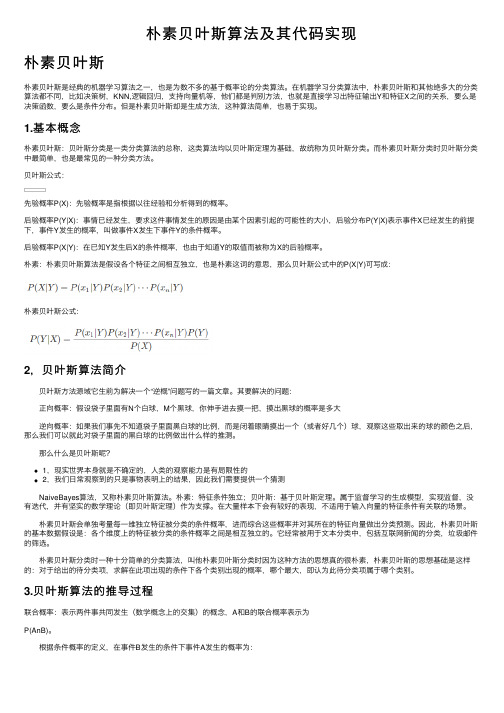

朴素贝叶斯算法及其代码实现

朴素贝叶斯算法及其代码实现朴素贝叶斯朴素贝叶斯是经典的机器学习算法之⼀,也是为数不多的基于概率论的分类算法。

在机器学习分类算法中,朴素贝叶斯和其他绝多⼤的分类算法都不同,⽐如决策树,KNN,逻辑回归,⽀持向量机等,他们都是判别⽅法,也就是直接学习出特征输出Y和特征X之间的关系,要么是决策函数,要么是条件分布。

但是朴素贝叶斯却是⽣成⽅法,这种算法简单,也易于实现。

1.基本概念朴素贝叶斯:贝叶斯分类是⼀类分类算法的总称,这类算法均以贝叶斯定理为基础,故统称为贝叶斯分类。

⽽朴素贝叶斯分类时贝叶斯分类中最简单,也是最常见的⼀种分类⽅法。

贝叶斯公式:先验概率P(X):先验概率是指根据以往经验和分析得到的概率。

后验概率P(Y|X):事情已经发⽣,要求这件事情发⽣的原因是由某个因素引起的可能性的⼤⼩,后验分布P(Y|X)表⽰事件X已经发⽣的前提下,事件Y发⽣的概率,叫做事件X发⽣下事件Y的条件概率。

后验概率P(X|Y):在已知Y发⽣后X的条件概率,也由于知道Y的取值⽽被称为X的后验概率。

朴素:朴素贝叶斯算法是假设各个特征之间相互独⽴,也是朴素这词的意思,那么贝叶斯公式中的P(X|Y)可写成:朴素贝叶斯公式:2,贝叶斯算法简介 贝叶斯⽅法源域它⽣前为解决⼀个“逆概”问题写的⼀篇⽂章。

其要解决的问题: 正向概率:假设袋⼦⾥⾯有N个⽩球,M个⿊球,你伸⼿进去摸⼀把,摸出⿊球的概率是多⼤ 逆向概率:如果我们事先不知道袋⼦⾥⾯⿊⽩球的⽐例,⽽是闭着眼睛摸出⼀个(或者好⼏个)球,观察这些取出来的球的颜⾊之后,那么我们可以就此对袋⼦⾥⾯的⿊⽩球的⽐例做出什么样的推测。

那么什么是贝叶斯呢?1,现实世界本⾝就是不确定的,⼈类的观察能⼒是有局限性的2,我们⽇常观察到的只是事物表明上的结果,因此我们需要提供⼀个猜测 NaiveBayes算法,⼜称朴素贝叶斯算法。

朴素:特征条件独⽴;贝叶斯:基于贝叶斯定理。

属于监督学习的⽣成模型,实现监督,没有迭代,并有坚实的数学理论(即贝叶斯定理)作为⽀撑。

朴素贝叶斯分类及R语言实现精品PPT课件

垃圾邮件的条件概率:

非垃圾邮件的条件概率:

利用似然表中数据可得垃圾邮件的总似然: 非垃圾邮件的总似然: 因为0.012/0.002=6,所以认为该消息是垃圾邮件的可能性是非垃圾邮件可能 的6倍,即更有可能是垃圾邮件。

由于分母被忽视掉,所以还需在结果后除以分母:

垃圾邮件的概率=0.012/(0.012+0.002)=0.857

(2/84) ⅹ (15/84) ⅹ (9/84) ⅹ (24/84) ⅹ (80/100)=0.0001

这表明该消息是垃圾邮件的概率为80%,是非垃圾邮件的概率为20%,显然, 这个结果比由单词Groceries单独决定的结果更合理。

接下来看一个例子——基于贝叶斯算法的手机垃圾短信过滤

基本步骤

第1步: 收集数据

朴素贝叶斯分类及R语言实现

201721100219

朴素贝叶斯的理论基础

贝叶斯定理便是基于条件概率,通过P(A|B)来求P (B|A):

顺便提一下,上式中的分母P(A),可以根据全 概率公式分解为:

朴素贝叶斯的理论基础

分类过程如图所示:

似然 后验概率

先验概率 边际似然

数据挖掘朴素贝叶斯算法r的实现

数据挖掘朴素贝叶斯算法r的实现朴素贝叶斯算法是一种基于贝叶斯定理的分类算法,其核心思想是通过已知的训练数据集学习一个分类器,对新数据进行分类。

下面是一个简单的R语言实现朴素贝叶斯算法的示例:```r导入必要的库library(e1071)生成训练数据(123)train_data <- (feature1 = rnorm(100),feature2 = rnorm(100),feature3 = rnorm(100),class = sample(c("A", "B"), 100, replace = TRUE))将特征向量和类别合并成一个矩阵train_matrix <- (train_data[1:3])train_factor <- (train_data$class)训练朴素贝叶斯分类器nb_model <- naiveBayes(train_matrix, train_factor, laplace = 1)生成测试数据test_data <- (feature1 = rnorm(10),feature2 = rnorm(10),feature3 = rnorm(10))对测试数据进行预测predicted_classes <- predict(nb_model, newdata = (test_data))print(predicted_classes)```在上面的示例中,我们首先导入了e1071包,它包含了朴素贝叶斯算法的实现。

然后,我们生成了一个包含三个特征和两个类别的训练数据集。

接着,我们将特征向量和类别合并成一个矩阵,并使用naiveBayes函数训练了一个朴素贝叶斯分类器。

最后,我们生成了一个包含三个特征的测试数据集,并使用predict函数对新数据进行分类。

朴素贝叶斯roc曲线r语言

朴素贝叶斯roc曲线r语言朴素贝叶斯分类器是一种常用的机器学习算法,它基于贝叶斯定理和特征条件独立假设,用于分类问题。

而ROC曲线(Receiver Operating Characteristic curve)则是一种用于评估分类器性能的工具,它以真阳性率(True Positive Rate)为纵坐标,假阳性率(False Positive Rate)为横坐标,展示了在不同阈值下分类器的性能。

在R语言中,我们可以使用现有的机器学习库来实现朴素贝叶斯分类器,并绘制ROC曲线。

以下是一种可能的实现方法:首先,我们需要加载相关的库,例如`e1071`和`pROC`。

你可以通过以下代码安装这些库:R.install.packages("e1071")。

install.packages("pROC")。

然后,我们可以使用`e1071`库中的`naiveBayes()`函数来构建朴素贝叶斯分类器。

这个函数接受训练数据和对应的标签作为输入,并返回一个训练好的分类器模型。

例如:R.library(e1071)。

# 假设我们有一个训练集 train_data 和对应的标签train_labels.model <naiveBayes(train_data, train_labels)。

接下来,我们可以使用训练好的模型对测试数据进行预测,并计算出预测结果的概率。

例如:R.# 假设我们有一个测试集 test_data.predicted_probabilities <predict(model, test_data, type = "raw")。

然后,我们可以使用`pROC`库中的`roc()`函数来计算ROC曲线的各个点。

这个函数接受真实标签和对应的预测概率作为输入,并返回一个包含ROC曲线信息的对象。

例如:R.library(pROC)。

# 假设我们有一个测试集的真实标签 test_labels.roc_curve <roc(test_labels, predicted_probabilities)。

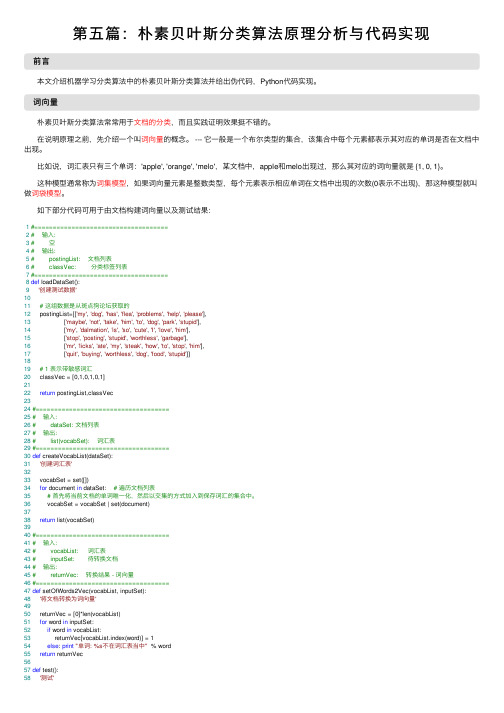

第五篇:朴素贝叶斯分类算法原理分析与代码实现

第五篇:朴素贝叶斯分类算法原理分析与代码实现前⾔本⽂介绍机器学习分类算法中的朴素贝叶斯分类算法并给出伪代码,Python代码实现。

词向量朴素贝叶斯分类算法常常⽤于⽂档的分类,⽽且实践证明效果挺不错的。

在说明原理之前,先介绍⼀个叫词向量的概念。

--- 它⼀般是⼀个布尔类型的集合,该集合中每个元素都表⽰其对应的单词是否在⽂档中出现。

⽐如说,词汇表只有三个单词:'apple', 'orange', 'melo',某⽂档中,apple和melo出现过,那么其对应的词向量就是 {1, 0, 1}。

这种模型通常称为词集模型,如果词向量元素是整数类型,每个元素表⽰相应单词在⽂档中出现的次数(0表⽰不出现),那这种模型就叫做词袋模型。

如下部分代码可⽤于由⽂档构建词向量以及测试结果:1#====================================2# 输⼊:3# 空4# 输出:5# postingList: ⽂档列表6# classVec: 分类标签列表7#====================================8def loadDataSet():9'创建测试数据'1011# 这组数据是从斑点狗论坛获取的12 postingList=[['my', 'dog', 'has', 'flea', 'problems', 'help', 'please'],13 ['maybe', 'not', 'take', 'him', 'to', 'dog', 'park', 'stupid'],14 ['my', 'dalmation', 'is', 'so', 'cute', 'I', 'love', 'him'],15 ['stop', 'posting', 'stupid', 'worthless', 'garbage'],16 ['mr', 'licks', 'ate', 'my', 'steak', 'how', 'to', 'stop', 'him'],17 ['quit', 'buying', 'worthless', 'dog', 'food', 'stupid']]1819# 1 表⽰带敏感词汇20 classVec = [0,1,0,1,0,1]2122return postingList,classVec2324#====================================25# 输⼊:26# dataSet: ⽂档列表27# 输出:28# list(vocabSet): 词汇表29#====================================30def createVocabList(dataSet):31'创建词汇表'3233 vocabSet = set([])34for document in dataSet: # 遍历⽂档列表35# ⾸先将当前⽂档的单词唯⼀化,然后以交集的⽅式加⼊到保存词汇的集合中。

使用R语言的BNLearn包实现贝叶斯网络

使用R语言的BNLearn包实现贝叶斯网络(1)标签:生活2013-08-01 22:26 星期四1. 加载程序包导入数据library(bnlearn) #CRAN中有,可以直接用install.packages(“bnlearn”)安装或者去网上下载后复制到library文件夹下即可。

library(Rgraphviz) #用于绘图。

这个包CRAN中没有,需要到/packages/release/BiocViews.html#___Software去下载。

data(learning.test) #导入数据,数据框中的变量必须全部为因子型(离散)或数值型(连续)。

lear.test =read.csv("***.csv", colClasses ="factor") #也可以直接从csv文件直接导入数据。

需要注意的是如果数据中含有0-1之类的布尔型,或者1-3之类的等级数据,需要强行指定其为因子型,不然许多BN函数会报错。

因为read函数只会自动的将字符型转换成因子型,其他的不会自动转换。

该包包含贝叶斯网络的结构学习、参数学习和推理三个方面的功能,其中结构学习包含基于约束的算法、基于得分的算法和混合算法,参数学习包括最大似然估计和贝叶斯估计两种方法。

此外还有引导(bootstrap),交叉验证(cross-validation)和随机模拟(stochastic simulation)等功能,附加的绘图功能需要调用前述的Rgraphviz and lattice包。

Bayesian network structure learning (via constraint-based, score-based and hybrid algorithms), parameter learning (via ML and Bayesian estimators) and inference. This package implements some algorithms for learning the structure of Bayesian networks. Constraint-based algorithms, also known as conditional independence learners, are all optimized derivatives of the Inductive Causation algorithm (Verma and Pearl, 1991).These algorithms use conditional independence tests to detect the Markov blankets of the variables, which in turn are used to compute the structure of the Bayesian network.Score-based learning algorithms are general purpose heuristic optimization algorithms which rank network structures with respect to a goodness-of-fit score.Hybrid algorithms combine aspects of both constraint-based and score-based algorithms, as they use conditional independence tests (usually to reduce the search space) and network scores (to find the optimal network in the reduced space) at the same time. Several functions for parameter estimation, parametric inference, bootstrap, cross-validation and stochastic simulation are available. Furthermore, advanced plotting capabilities are implemented on top of the Rgraphviz and latticepackages.使用R语言的BNLearn包实现贝叶斯网络(2)标签:生活2013-08-01 22:27 星期四2 基于约束的算法Bnlearn包中可使用的基于约束的算法有gs、iamb、fast.iamb、inter.iamb。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

能很好地处理噪声数据和缺失数据

需要用来训练的案例相对较少,但同 样能很好地处理大量的案例

很容易获得一个预测的估计概率值

垃圾邮件的条件概率:

非垃圾邮件的条件概率:

利用似然表中数据可得垃圾邮件的总似然:

非垃圾邮件的总似然:

因为0.012/0.002=6,所以认为该消息是垃圾邮件的可能性是非垃圾邮件可 能的6倍,即更有可能是垃圾邮件。

由于分母被忽视掉,所以还需在结果后除以分母: 垃圾邮件的概率=0.012/(0.012+0.002)=0.857 同样 非垃圾邮件的概率=0.002/(0.012+0.002) =0.143 2、拉普拉斯估计 将朴素贝叶斯应用于更复杂的问题前,有一些细微差别需要考虑。假设 我们收到另一条 消息,这次该消息包含所有4个单词:Viagra、Money、 Groceries和Unsubscribe。像之前一样使用贝叶斯算法,我们可以如下计算 垃圾邮件的似然: (4/20)ⅹ(10/20) ⅹ (0/20) ⅹ (12/20) ⅹ (20/100)=0 非垃圾邮件的似然为: (1/80) ⅹ (14/80) ⅹ (8/80) ⅹ (23/80) ⅹ (80/100) =0.00005 该消息是非垃圾邮件的概率为:0.00005/(0+0.00005)=1 这些结果表明该消息是垃圾邮件的概率为0,是非垃圾邮件的概率为100%。

朴素贝叶斯分类及R语言实现

数学与科学学院 201721100219

统计学专业

唐容

朴素贝叶斯的理论基础

贝叶斯定理便是基于条件概率,通过P(A|B)来求P (B|A):

顺便提一下,上式中的分母P(A),可以根据全 概率公式分解为:所示:

似然

先验概率

后验概率

取拉普拉斯值为:1给每个似然函数的分子加上1;给每个条件概率 分母加上分子中增加1的总数。 垃圾邮件的似然为: (5/24)ⅹ(11/24) ⅹ (1/24) ⅹ (13/24) ⅹ (20/24) =0.0004 非垃圾邮件的似然为: (2/84) ⅹ (15/84) ⅹ (9/84) ⅹ (24/84) ⅹ (80/100) =0.0001 这表明该消息是垃圾邮件的概率为80%,是非垃圾邮件的概率为20%,显然, 这个结果比由单词Groceries单独决定的结果更合理。 接下来看一个例子——基于贝叶斯算法的手机垃圾短信过滤

第1步: 收集数据 第2步: 探索和准 备数据 第3步: 基于数据 训练模型 第4步: 评估模型 的性能 第5步: 提高模型 的性能

1、清理和标准化文本数据

2、将文本档拆分成词语 3、建立训练数据集和测试数据集 4、可视化文本数据——词云 5、为频繁出现的单词创建指示特征收

基本步骤

朴素贝叶斯算法的优缺点

对于类的一个或多个水平,如果一个事件从来没有发生过,那么就有可能 出现这样的问题。例如,单词Groceries之前从来没有出现在垃圾邮件消息中, 因此,P(垃圾邮件|groceries)=0。 由于在朴素贝叶斯公式中,概率值是链式相乘的,所以概率为0的值将导 致垃圾邮件的后验概率为0,及单词Groceries能有效抵消或否定其他的证据。 即该邮件很有可能被预测为垃圾邮件,但是由于垃圾邮件中没有出现单词 Groceries就总是否决其他证据,并导致该邮件为垃圾邮件的概率为0。 这个问题的解决涉及使用一种叫做 拉普拉斯估计(Laplace estimator) 的方法,该方法是以法国数学家皮埃尔—西蒙斯—拉普拉斯(PierreSimon Laplce)的名字命名的。本质上,拉普拉斯估计是频率表中的每个 计数加上一个较小的数,这样就保证每类中的每一个特征发生的概率是非 零。 通常情况下,拉普拉斯估计中加上的数值设定为1,这样就保证每类—特 征组合至少在数据中出现一次。 下面观察拉普拉斯估计如何影响我们对消息的预测结果:

似然

总计 20

垃圾邮 件

非垃圾 邮件 总计

1/80 5/95

79/80 95/100

14/80 34/100

66/80 76/100

8/80 8/100

71/80 91/100

23/80 35/10 0

57/80 65/10 0

80 100

设Viagra=Yes、Money=No、Groceries=No、Unsubscribe=Yes。

边际似然

似然表

Viagra

频率 垃圾邮件 非垃圾邮件 总计 Yes 4 1 5 No 16 79 95 总计 20 80 100

Viagra 似然 垃圾邮件 Yes 4/20 No 16/20 总计 20

非垃圾邮件

总计

1/80

5/100

79/80

95/100

80

100

P(Viagra|垃圾邮件)ⅹP(垃圾邮件)=(4/20)ⅹ(20/100)=0.04

朴素贝叶斯分类: 除了对单词Viagra之外,还可增加对Money、Groceries和Unsubscribe 的检测来改善垃圾邮件过滤器。

Viagra Yes 4/20 No 16/20 Money Yes 10/20 No 10/20 Groceries Yes 0/20 No 20/20 Unsubscribe Yes 12/20 No 8/20