第4章 数据采集与清洗习题答案

数据采集课后习题答案马明建共49页文档

36、“不可能”这个字(法语是一个字 ),只 在愚人 的字典 中找得 到。--拿 破仑。 37、不要生气要争气,不要看破要突 破,不 要嫉妒 要欣赏 ,不要 托延要 积极, 不要心 动要行 动。 38、勤奋,机会,乐观是成功的三要 素。(注 意:传 统观念 认为勤 奋和机 会是成 功的要 素,但 是经过 统计学 和成功 人士的 分析得 出,乐 观是成 功的第 三要素 。

Than承 诺,踏 上旅途 ,义无 反顾。 40、对时间的价值没有没有深切认识 的人, 决不会 坚韧勤 勉。

6、最大的骄傲于最大的自卑都表示心灵的最软弱无力。——斯宾诺莎 7、自知之明是最难得的知识。——西班牙 8、勇气通往天堂,怯懦通往地狱。——塞内加 9、有时候读书是一种巧妙地避开思考的方法。——赫尔普斯 10、阅读一切好书如同和过去最杰出的人谈话。——笛卡儿

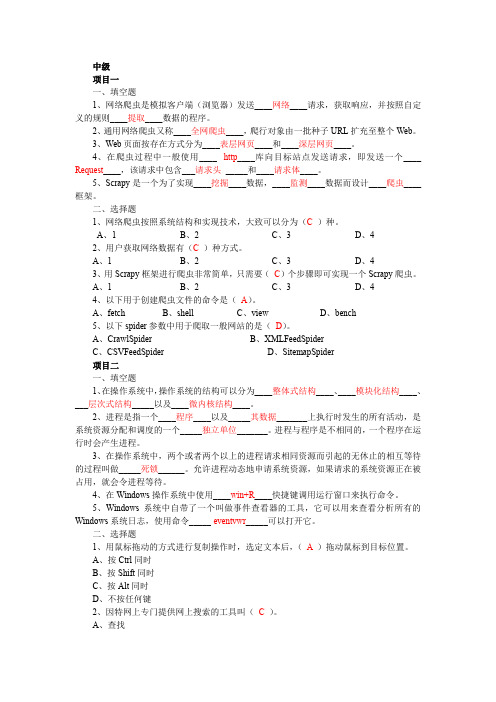

《数据采集》-中级-题库及答案

中级项目一一、填空题1、网络爬虫是模拟客户端(浏览器)发送____网络____请求,获取响应,并按照自定义的规则____提取____数据的程序。

2、通用网络爬虫又称____全网爬虫____,爬行对象由一批种子URL扩充至整个Web。

3、Web页面按存在方式分为____表层网页____和____深层网页____。

4、在爬虫过程中一般使用____http____库向目标站点发送请求,即发送一个____ Request____,该请求中包含___请求头_____和____请求体____。

5、Scrapy是一个为了实现____挖掘____数据,____监测____数据而设计____爬虫____框架。

二、选择题1、网络爬虫按照系统结构和实现技术,大致可以分为(C )种。

A、1B、2C、3D、42、用户获取网络数据有(C )种方式。

A、1B、2C、3D、43、用Scrapy框架进行爬虫非常简单,只需要(C)个步骤即可实现一个Scrapy爬虫。

A、1B、2C、3D、44、以下用于创建爬虫文件的命令是(A)。

A、fetchB、shellC、viewD、bench5、以下spider参数中用于爬取一般网站的是(D)。

A、CrawlSpiderB、XMLFeedSpiderC、CSVFeedSpiderD、SitemapSpider项目二一、填空题1、在操作系统中,操作系统的结构可以分为____整体式结构____、____模块化结构____、___层次式结构_____以及____微内核结构____。

2、进程是指一个____程序____以及_____其数据_______上执行时发生的所有活动,是系统资源分配和调度的一个_____独立单位_______。

进程与程序是不相同的,一个程序在运行时会产生进程。

3、在操作系统中,两个或者两个以上的进程请求相同资源而引起的无休止的相互等待的过程叫做_____死锁______。

允许进程动态地申请系统资源,如果请求的系统资源正在被占用,就会令进程等待。

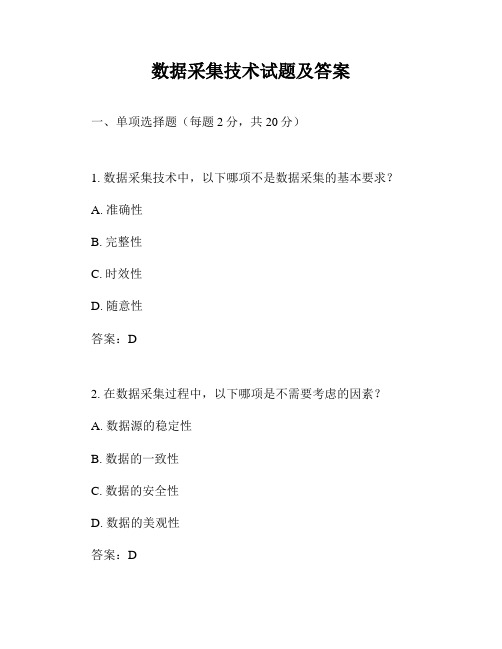

数据采集技术试题及答案

数据采集技术试题及答案一、单项选择题(每题2分,共20分)1. 数据采集技术中,以下哪项不是数据采集的基本要求?A. 准确性B. 完整性C. 时效性D. 随意性答案:D2. 在数据采集过程中,以下哪项是不需要考虑的因素?A. 数据源的稳定性B. 数据的一致性C. 数据的安全性D. 数据的美观性答案:D3. 数据采集技术中,以下哪项不是数据预处理的步骤?A. 数据清洗B. 数据转换C. 数据存储D. 数据压缩答案:C4. 在数据采集技术中,以下哪项不是数据采集的常用方法?A. 传感器采集B. 网络爬虫C. 人工录入D. 随机猜测答案:D5. 数据采集技术中,以下哪项不是数据采集过程中可能遇到的问题?A. 数据丢失B. 数据冗余C. 数据不一致D. 数据完美答案:D6. 在数据采集技术中,以下哪项不是数据采集系统的主要组成部分?A. 数据源B. 数据采集器C. 数据存储设备D. 数据分析软件答案:D7. 数据采集技术中,以下哪项不是数据采集过程中的常见数据格式?A. 文本格式B. 图像格式C. 音频格式D. 视频格式答案:D8. 在数据采集技术中,以下哪项不是数据采集的基本原则?A. 合法性B. 合规性C. 合理性D. 随意性答案:D9. 数据采集技术中,以下哪项不是数据采集过程中可能用到的工具?A. 数据库B. 传感器C. 网络爬虫D. 游戏机答案:D10. 在数据采集技术中,以下哪项不是数据采集的常见应用领域?A. 工业自动化B. 环境监测C. 医疗健康D. 艺术创作答案:D二、多项选择题(每题3分,共15分)11. 数据采集技术中,以下哪些因素会影响数据采集的准确性?()A. 传感器精度B. 数据传输过程中的干扰C. 数据存储设备的可靠性D. 数据分析软件的算法答案:ABCD12. 在数据采集技术中,以下哪些步骤属于数据预处理?()A. 数据清洗B. 数据转换C. 数据压缩D. 数据备份答案:ABC13. 数据采集技术中,以下哪些是数据采集过程中可能遇到的问题?()A. 数据丢失B. 数据冗余C. 数据不一致D. 数据泄露答案:ABCD14. 在数据采集技术中,以下哪些是数据采集系统的主要组成部分?()A. 数据源B. 数据采集器C. 数据存储设备D. 数据分析软件答案:ABC15. 数据采集技术中,以下哪些是数据采集过程中的常见数据格式?()A. 文本格式B. 图像格式C. 音频格式D. 视频格式答案:ABCD三、判断题(每题2分,共20分)16. 数据采集技术中,数据的准确性是最重要的要求之一。

数据采集课后习题答案--马明建

RS RS = 100 时, RG = ∴ 当G= 100 RG

又∵ RS = 100±15% 100±

第4章 习题与思考题 章

当 RS = 100+15%时, 100+15%时

(100 + 100 × 15%) × 10 RG = = 1150Ω 100

3

当 RS = 100-15%时, 100-15%时

n

1 2 n π t AP

1

f max πt AP

1 = = 16025.641 3 −9 10 × 10 × 3.14 × 2 × 10

第5章 习题与思考题 章

1 相对分辨率 = n × 100% 2 1 = × 100% = 0.00624% 16025.641

n ≈ 14

则有

第5章 习题与思考题 章

由于

则

第6章 习题与思考题

(100 − 100 × 15%) × 10 RG = = 850Ω 100

3

第4章 习题与思考题 章

其接线原理图

U+ +IN

1 14 8 10 13 12 7 11 2 3 5 4 10KΩ 10KΩ 6

RS

100KΩ 100KΩ

RG

UOUT

-IN U-

第5章 习题与思考题

第5章 习题与思考题 章

第5章 习题与思考题 章

5-7. 一个数据采集系统的孔径时间tAP=2ns, 一个数据采集系统的孔径时间t =2ns, 试问一个10kHz信号在其变化率最大点 试问一个10kHz信号在其变化率最大点 被采样时所能达到的分辨率是多少? 被采样时所能达到的分辨率是多少? 解:∵ f max = ∴ 2 =

数据采集及处理答案

第一章1. 答:数据采集的任务就是采集传感器输出的模拟信号并转换成计算机能识别的数字信号,然后送入计算机进行相应的计算和处理,得出所需数据。

同时,将计算得到的数据进行显示或打印,以便实现对某些物理量的监视,其总一部分数据还将被生产过程中的计算机控制系统用来控制某些物理量。

2.答:数据采集系统主要实现以下9个方面的基本功能:数据采集;模拟信号处理;数字信号处理;开关信号处理;二次数据计算;屏幕显示;数据存储;打印输出;人机联系。

3.答:数据采集系统的基本结构形式主要有两种:一种是微型计算机数据采集系统,另一种是集散型数据采集系统。

微型计算机数据采集系统的特点是:系统结构简单,技术容易实现,满足中小规模数据采集要求;对环境要求不高;价格低廉,系统成本低;可座位集散型数据采集系统的一个基本组成部分;其相关模板和软件都比较齐全,容易构成西欧它能够,便于使用与维修。

集散型数据采集系统的主要特点是:系统适应能力强;系统可靠性高;系统实时响应性好;对系统硬件要求不高;特别适合在恶劣环境下工作。

4.答:数据采集系统软件功能模块一般由以下部分组成:1)模拟信号采集与处理程序。

其主要功能是对模拟输入信号进行采集、标度变换、滤波处理以及二次数据计算,并将数据存入磁盘。

2)数字信号采集与处理程序。

其功能是对数字输入信号进行采集及码制之间的转换。

3)脉冲信号处理程序。

其功能是对输入的脉冲信号进行电平高低判断和计数。

4)开关信号处理程序。

其功能是判断开关信号输入状态变化情况,若发生变化,则执行相应的处理程序。

5)运行参数设置程序。

其功能是对数据采集系统的运行参数进行设置。

6)系统管理(主控)程序。

其功能是将各个模块程序组织成一个程序系统,并管理和调用各个功能模块程序,其次是用来管理数据文件的存储和输出。

7)通信程序。

其功能是设置数据传送的波特率(速率),上位机向数据采集站群发送机号,上位机接收和判断数据采集站发挥的机号,命令相应的数据采集站传送数据,上位机接受数据采集站传送来的数据。

第4章数据采集与清洗习题答案

第4章数据采集与清洗习题答案1)请阐述数据采集有哪些方法?(1)系统日志采集许多公司的平台每天会产生大量的日志(一般为流式数据,如搜索引擎的pv,查询等),处理这些日志需要特定的日志系统。

因此日志采集系统的主要工作就是收集业务日志数据供离线和在线的分析系统使用。

这种大数据采集方式可以高效地收集、聚合和移动大量的日志数据,并且能提供可靠的容错性能。

高可用性、高可靠性和可扩展性是日志采集系统的基本特征。

目前常用的开源日志采集平台包含有:Apache Flume、Fluentd、Logstash、Chukwa、Scribe以及Splunk Forwarder等。

这些采集平台大部分采用的是分布式架构,以满足大规模日志采集的需要。

具体的日志采集平台在下一节会介绍。

(2)网络数据采集网络数据采集是指利用互联网搜索引擎技术实现有针对性、行业性、精准性的数据抓取,并按照一定规则和筛选标准进行数据归类,并形成数据库文件的一个过程。

目前网络数据采集采用的技术基本上是利用垂直搜索引擎技术的网络蜘蛛(或数据采集机器人)、分词系统、任务与索引系统等技术进行综合运用而完成,并且随着互联网技术的发展和网络海量信息的增长,对信息的获取与分拣会成为一种越来越大的需求。

目前常用的网页爬虫系统有Apache Nutch、Crawler4j、Scrapy等框架。

由于采用多个系统并行抓取数据,这种方式能充分利用机器的计算资源和存储能力,大大提高系统抓取数据的能力,同时大大降低了开发人员的开发速率,使得开发人员可以很快的完成一个数据系统的开发。

(3)数据库采集数据库采集是将实时产生的数据以记录的形式直接写入到企业的数据库中,然后使用特定的数据处理系统进行进一步分析。

目前比较常见的数据库采集主要有MySQL、Oracle、Redis、Bennyunn以及MongoDB等。

这种方法通常在采集端部署大量数据库,并对如何在这些数据库之间进行负载均衡和分片进行深入的思考和设计。

2.2.1《数据采集的途径》课后作业 信息技术-数据管理与分析选修3

《数据采集的途径》作业一、选择题1. 下列哪种途径不属于数据采集的范畴?A. 问卷调查B. 网络爬虫C. 数据清洗D. 传感器采集答案:C解析:数据清洗是对已经采集到的数据进行处理和优化的过程,不属于数据采集的范畴。

而问卷调查、网络爬虫和传感器采集都是常见的数据采集方法。

2. 在大数据环境下,以下哪种技术常用于实时数据采集?A. SQL数据库B. NoSQL数据库C. 关系型数据库D. Excel表格答案:B解析:NoSQL数据库(如MongoDB、Cassandra)因其灵活的数据模型和高扩展性,常被用于大数据环境下的实时数据采集。

3. 下列哪种工具主要用于网页数据采集?A. PythonB. ExcelC. SPSSD. SQL Server答案:A解析:Python通过其强大的库(如BeautifulSoup、Scrapy)支持网页数据采集,而Excel、SPSS和SQL Server主要用于数据分析和处理。

4. 在物联网中,常用的数据采集设备是?A. 智能手机B. 传感器C. 笔记本电脑D. 平板电脑答案:B解析:传感器是物联网中最常用的数据采集设备,可以实时监测和记录各种物理量(如温度、湿度、压力等)。

5. 在企业中,常用的内部数据采集方法不包括?A. 业务系统日志B. 客户反馈调查C. 员工满意度调查D. 公开数据集下载答案:D解析:公开数据集下载属于外部数据采集方法,而业务系统日志、客户反馈调查和员工满意度调查则是企业内部数据采集的常用方法。

二、填空题6. 在数据采集中,_____是一种通过编写程序自动从网页抓取数据的方法。

答案:网络爬虫解析:网络爬虫是一种自动化技术,用于从互联网上抓取大量数据,广泛应用于市场分析、舆情监控等领域。

7. 在物联网应用中,_____常用于实时监测环境参数。

答案:传感器解析:传感器能够实时感知并记录环境中的各种参数(如温度、湿度、光照强度等),是物联网应用中不可或缺的数据采集设备。

大数据技术与应用习题答案第3-4章

3.7 习题一、选择题1. B2. C3. B4. D5. B6. C7. D8. D二、填空题1.在HDFS文件系统读取文件的过程中,客户端通过对输入流调用_read() 方法开始读取数据;写入文件的过程中客户端通过对输出流调用___write()___方法开始写入数据。

2.HDFS全部文件的元数据是存储在NameNode节点的___硬盘______(硬盘/内存),为了解决这个瓶颈,HDFS产生了____HA_____机制。

三、简答题1. 举例说明Hadoop的体系结构。

Hadoop其实是由一系列的软件库组成的框架。

这些软件库也可称作功能模块,它们各自负责了Hadoop的一部分功能,其中最主要的是Common、HDFS和YARN。

Common提供远程调用RPC、序列化机制,HDFS负责数据的存储,YARN则负责统一资源调度和管理等。

2.HDFS中数据副本的存放策略是什么?HDFS默认的副本系数是3,这适用于大多数情况。

副本存放策略是将第一个副本存放在本地机架的节点上,将第二个副本放在同一机架的另一个节点上,将第三个副本放在不同机架的节点上。

这种策略减少了机架间的数据传输,这就提高了写操作的效率。

Node和DataNode的功能分别是什么?元数据节点NameNode是管理者,一个Hadoop集群只有一个NameNode节点,是一个通常在HDFS实例中的单独机器上运行的软件。

NameNode主要负责HDFS文件系统的管理工作,具体包括命名空间管理(namespace)和文件block管理。

NameNode决定是否将文件映射到DataNode的复制块上。

对于最常见的3个复制块,第一个复制块存储在同一个机架的不同节点上,最后一个复制块存储在不同机架的某个节点上。

NameNode是HDFS的大脑,它维护着整个文件系统的目录树,及目录树里所有的文件和目录,这些信息以两种文件存储在本地文件中:一种是命名空间镜像,也称为文件系统镜像(file system image,FSImage),即HDFS元数据的完整快照,每次NameNode启动时,默认会加载最新的命名空间镜像,另一种是命名空间镜像的编辑日志(edit log)。

数据采集1+x初级习题含答案

数据采集1+x初级习题含答案一、单选题(共41题,每题1分,共41分)1.DB指的是是A、数据库B、数据库管理系C、关系型数据库D、数据库应用正确答案:A2.数据库结构的描述和定义是DBMS运行的基本依据,它们存储于( )A、封锁表B、数据字典C、索引D、日志正确答案:B3.删除数据表文件的命令是()A、DELETE TABLEB、DROP TABLEC、DROPD、DELETE正确答案:B4.以下属于应用层协议的是()A、IPB、UDPC、TCPD、FTP正确答案:D5.网站SEO优化时,网站进行友情链接多少个为适中()。

A、1~5个B、20~30个C、30~40个D、40个以上正确答案:B6.centos7中超级用户的命令提示符是()A、#C、%D、&正确答案:A7.httpd采用( )模块化设计方法A、modulesB、core +moduleC、core + modulesD、core正确答案:C8.以下不属于JavaScript基本数据类型的是()A、StringB、ObjectC、NumberD、Boolean正确答案:B9.下列哪些属于()规范数据信息收集的方式与要求A、自然人的个人信息受法律保护B、未经用户同意,电信业务经营者、互联网信息服务提供者不得收集、使用用户个人信息C、发现网络运营者收集、存储的其个人信息有错误的,有权要求网络运营者予以更正D、网络运营者应当对其收集的用户信息严格保密,并建立健全用户信息保护制度正确答案:A10.在Linux环境下的Tomcat容器数据的采集中,启动Tomcat容器的代码是( )。

A、httpdB、logstashC、filebeatD、startup.sh正确答案:D11.若k为整形,下述while循环执行的次数为() k=1000 while k>1: print(k) k = k/2B、1000C、9D、10正确答案:D12.哪个表达式用来选取属性?A、/B、.C、..D、@正确答案:D13.FTP 的主要特点不包括()。

中国石油大学--数据采集--考试习题答案

答:单臂:

双臂:

11 12、有一钢板,原长 l=1 米,钢板的弹性模量 E 2 10 Pa ,使用 BP-3 箔式应变片 R=120 欧姆,灵敏度系数 S=2,测出的

拉伸应变值为 300 。求:弹簧伸长量△ l ,应变 ,△R/R 及△R。如果测出 1 应变值的对应的△R/R 是多少? 答: l x l

3

C

r 2

d

( 2 )如果测量电路的放大倍数 K1 100V / pF ,读数仪表的灵敏度 S2 5格/mv ,则此时仪表指示值变化多少格?

格数=

C K1 103 5

14、15、关于电桥的电压关系:

UO

R1 R3 R2 R4 UI R1 R2 R3 R4

第 1 章 绪论 1.数据采集的定义:将温度、压力、流量、位移等模拟量采集、转换成数字量后,再由计算机进行存储、处理、显示或打印 的过程。 2.数据采集系统的组成:硬件和软件。(传感器:将非电量转换为电信号。 多路开关:分时切换各路模拟量与采样/保持器 的通路。程控放大器:对模拟信号进行放大。采样/保持器:保持模拟信号电压。A/D 转换器:将模拟信号转换为数字信号。 接口电路:将数字信号进行整形或电平调整。微机及外部设备:管理和控制数据采集系统。定时与逻辑控制电路:产生逻辑 控制信号,控制时序。) 3.数据采集系统性能的好坏是如何评价的? 1) 采样精度: 精度越高,系统性能越好-分辨率 2) 采样速度: 速度越快,系统性能越好-采样率 3) 通道数:通道数是指数据采集板卡能够同时输入的信号路数。 4.数据采集的任务是什么? 1) 采集传感器输出的模拟信号,并转换成数字信号,然后送入计算机。 2) 系统计算机对数字信号进行处理,得到所需的数据。 5.画出数据采集系统的硬件组成框图,并说明各组成部分的作用

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1)请阐述数据采集有哪些方法?

(1)系统日志采集

许多公司的平台每天会产生大量的日志(一般为流式数据,如搜索引擎的pv,查询等),处理这些日志需要特定的日志系统。

因此日志采集系统的主要工作就是收集业务日志数据供离线和在线的分析系统使用。

这种大数据采集方式可以高效地收集、聚合和移动大量的日志数据,并且能提供可靠的容错性能。

高可用性、高可靠性和可扩展性是日志采集系统的基本特征。

目前常用的开源日志采集平台包含有:Apache Flume、Fluentd、Logstash、Chukwa、Scribe以及Splunk Forwarder等。

这些采集平台大部分采用的是分布式架构,以满足大规模日志采集的需要。

具体的日志采集平台在下一节会介绍。

(2)网络数据采集

网络数据采集是指利用互联网搜索引擎技术实现有针对性、行业性、精准性的数据抓取,并按照一定规则和筛选标准进行数据归类,并形成数据库文件的一个过程。

目前网络数据采集采用的技术基本上是利用垂直搜索引擎技术的网络蜘蛛(或数据采集机器人)、分词系统、任务与索引系统等技术进行综合运用而完成,并且随着互联网技术的发展和网络海量信息的增长,对信息的获取与分拣会成为一种越来越大的需求。

目前常用的网页爬虫系统有Apache Nutch、Crawler4j、Scrapy等框架。

由于采用多个系统并行抓取数据,这种方式能充分利用机器的计算资源和存储能力,大大提高系统抓取数据的能力,同时大大降低了开发人员的开发速率,使得开发人员可以很快的完成一个数据系统的开发。

(3)数据库采集

数据库采集是将实时产生的数据以记录的形式直接写入到企业的数据库中,然后使用特定的数据处理系统进行进一步分析。

目前比较常见的数据库采集主要有MySQL、Oracle、Redis、Bennyunn以及MongoDB等。

这种方法通常在采集端部署大量数据库,并对如何在这些数据库之间进行负载均衡和分片进行深入的思考和设计。

2)数据采集平台有哪些?

Flume、Fluentd、Logstash、Chukwa、Scribe、Kafka

3)为什么要进行数据清洗?

数据的不断剧增是大数据时代的显著特征,大数据必须经过清洗、分析、建模、可视化才能体现其潜在的价值。

然而在众多数据中总是存在着许多“脏”数据,即不完整、不规范、不准确的数据,因此数据清洗就是指把“脏数据”彻底洗掉,包括检查数据一致性,处理无效值和缺失值等,从而提高数据质量。

在实际的工作中,数据清洗通常占开发过程的50%-70%左右的时间。

4)数据清洗有哪些流程?

(1)数据清洗-预处理

(2)数据清洗-缺省值清洗

(3)数据清洗-格式与内容清洗

(4)数据清洗-逻辑错误清洗

(5)数据清洗-多余的数据清洗

(6)数据清洗-关联性验证

5)什么是数据标准化?

数据的标准化,是通过一定的数学变换方式,将原始数据按照一定的比例进行转换,使之落入到一个小的特定区间内,例如0~1或-1~1的区间内,消除不同变量之间性质、量纲、数量级等特征属性的差异,将其转化为一个无量纲的相对数值。

因此标准化数值是使各指标的数值都处于同一个数量级别上,从而便于不同单位或数量级的指标能够进行综合分析和比较。

6)请阐述什么是数据仓库。

数据仓库是决策支持系统和联机分析应用数据源的结构化数据环境,它研究和解决从数据库中获取信息的问题,并为企业所有级别的决策制定过程,提供所有类型数据支持的战略集合。

7)实施ETL有哪些常见工具?

目前在市场上常见的ETL工具包含有:

(1)Talend

Talend是第一家针对的数据集成工具市场的ETL开源软件供应商。

T alend 以它的技术和商业双重模式为ETL 服务提供了一个全新的远景。

它打破了传统的独有封闭服务,提供了一个针对所有规模的公司的公开的,创新的,强大的灵活的软件解决方案。

(2)DataStage

DataStage是IBM公司的商业软件,是一种数据集成软件平台,能够帮助企业从散布在各个系统中的复杂异构信息获得更多价值。

DataStage 支持对数据结构从简单到高度复杂的大量数据进行收集、变换和分发操作。

并且Datastage全部的操作在同一个界面中,不用切换界面,能够看到数据的来源,整个job的情况。

(3)Kettle

Kettle 中文名称叫水壶,是一款国外开源的ETL工具,纯java编写,可以在Windows、Linux、Unix上运行,数据抽取高效稳定。

Kettle中有两种脚本文件,transformation和job,transformation完成针对数据的基础转换,job则完成整个工作流的控制。

(4)Informatica PowerCenter

Informatica PowerCenter是一款非常强大的ETL工具,支持各种数据源之间的数据抽取、转换、加载等数据传输,多用于大数据和商业智能等领域。

一般应用企业根据自己的业务数据构建数据仓库,在业务数据和数据仓库间进行ETL 操作。