BP神经网络学习及算法

BP神经网络详解-最好的版本课件(1)

月份 1

销量 月份 销量

2056 7

1873

2

2395 8

1478

3

2600 9

1900

4

2298 10

1500

5

1634 11

2046

6

1600 12

1556

BP神经网络学习算法的MATLAB实现

➢%以每三个月的销售量经归一化处理后作为输入

P=[0.5152

0.8173 1.0000 ;

0.8173

计算误差函数对输出层的各神经元的偏导

数

。 o ( k )

p

e e yio w ho y io w ho

(

yio(k) h who

whohoh(k)bo)

who

hoh(k)

e

yio

(12oq1(do(k)yoo(k)))2 yio

(do(k)yoo(k))yoo(k)

(do(k)yoo(k))f(yio(k)) o(k)

1.0000 0.7308;

1.0000

0.7308 0.1390;

0.7308

0.1390 0.1087;

0.1390

0.1087 0.3520;

0.1087

0.3520 0.0000;]';

➢%以第四个月的销售量归一化处理后作为目标向量

T=[0.7308 0.1390 0.1087 0.3520 0.0000 0.3761];

BP神经网络模型

三层BP网络

输入层 x1

x2

隐含层

输出层

-

y1

z1

1

T1

y2

z2

-

2

BP神经网络算法步骤

BP神经网络算法步骤

<br>一、概述

BP神经网络(Back Propagation Neural Network,BPNN)是一种经

典的人工神经网络,其发展始于上世纪80年代。

BP神经网络的原理是按

照误差反向传播算法,以及前馈神经网络的模型,利用反向传播方法来调

整网络各层的权值。

由于其具有自动学习和非线性特性,BP神经网络被

广泛应用在很多和人工智能、计算智能紧密相关的诸如计算机视觉、自然

语言处理、语音识别等领域。

<br>二、BP神经网络的结构

BP神经网络经常使用的是一种多层前馈结构,它可以由输入层,若

干隐藏层,以及输出层三部分组成。

其中,输入层是输入信号的正向传输

路径,将输入信号正向传送至隐藏层,在隐藏层中神经元以其中一种复杂

模式对输入信号进行处理,并将其正向传送至输出层,在输出层中将获得

的输出信号和设定的模式进行比较,以获得预期的输出结果。

<br>三、BP神经网络的学习过程

BP神经网络的学习过程包括正向传播和反向传播两个阶段。

其中,

正向传播是指从输入层到隐藏层和输出层,利用现有的训练数据,根据神

经网络结构,计算出网络每一层上各结点的的激活值,从而得到输出结果。

正向传播的过程是完全可以确定的。

BP神经网络算法原理

隐藏层节点数

合理选择隐藏层节点数 可以提高像识别、语音识别、自然语言处理等领域有广泛应用,并且不断发展和完善。

隐含层

通过多层神经元的计算和传 递信息,提取输入数据的特 征。

输出层

输出神经元将经过计算后的 结果作为最终预测或分类的 结果。

前向传播算法

前向传播是从输入层到输出层的信息流传递过程,各层神经元依次计算并传 递信息,最终得到预测结果。

反向传播算法

反向传播是通过计算输出误差对权值和偏置进行更新,以最小化输出与实际值之间的误差。

权值更新与训练过程

1

初始化权值

随机初始化权值和偏置,开始训练过程。

2

前向传播计算

通过前向传播算法计算输出结果。

3

反向传播更新

根据误差计算反向传播梯度并更新权值和偏置。

优化技巧与常见问题

学习率

学习率的选择会影响算 法的收敛速度和稳定性。

过拟合

过拟合问题可能导致训 练集表现良好但测试集 表现不佳,需要采取正 则化等方法进行处理。

BP神经网络算法原理

BP神经网络算法是一种基于误差反向传播原理的机器学习算法,用于解决复 杂的非线性问题。

BP神经网络算法的基本思想

BP神经网络通过输入层、隐含层和输出层构成,利用前向传播和反向传播的 机制不断调整权值以减小输出与真实值之间的误差。

BP神经网络的结构

输入层

负责接收外部输入数据的层 级。

BP神经网络算法程序

BP神经网络算法程序一、BP神经网络算法原理BP神经网络算法包括输入层、隐藏层和输出层三个层次。

每个层次的神经元节点与下一层次的神经元节点之间存在权重系数。

神经元节点通过输入信号经过激活函数的处理得到输出信号,并将输出信号传递给下一层次的神经元节点。

反向传播过程中,首先根据误差评估结果计算输出层的误差信号,再根据该误差信号分别计算隐藏层和输入层的误差信号。

然后根据误差信号的计算结果,逐层更新网络的权重系数。

二、BP神经网络算法步骤1.初始化网络权重:随机初始化网络各层次之间的权重系数。

2.设置学习率和最大迭代次数。

3.迭代训练网络:重复以下步骤直到满足停止条件为止。

a)根据当前样本的输入信号,通过前向传播算法计算输出结果。

c)根据误差信号,通过反向传播算法更新网络的权重系数。

4.测试网络:使用独立的测试数据集,通过前向传播算法计算网络的输出结果,评估网络的泛化能力。

三、BP神经网络算法示例程序下面给出一个简单的使用Python编写的BP神经网络算法示例程序。

```pythonimport numpy as npclass BPNeuralNetwork:def __init__(self, input_dim, hidden_dim, output_dim): self.input_dim = input_dimself.hidden_dim = hidden_dimself.output_dim = output_dimself.W1 = np.random.randn(input_dim, hidden_dim)self.W2 = np.random.randn(hidden_dim, output_dim)def sigmoid(self, x):return 1 / (1 + np.exp(-x))def sigmoid_derivative(self, x):return x * (1 - x)def forward_propagation(self, X):self.z2 = np.dot(X, self.W1)self.a2 = self.sigmoid(self.z2)self.z3 = np.dot(self.a2, self.W2)self.y_hat = self.sigmoid(self.z3)return self.y_hatdef backward_propagation(self, X, y, lr):self.loss = y - self.y_hatdelta3 = self.loss * self.sigmoid_derivative(self.y_hat) dW2 = np.dot(self.a2.T, delta3)delta2 = np.dot(delta3, self.W2.T) *self.sigmoid_derivative(self.a2)dW1 = np.dot(X.T, delta2)self.W2 += lr * dW2self.W1 += lr * dW1def train(self, X, y, lr=0.1, epochs=1000):for i in range(epochs):y_hat = self.forward_propagation(X)self.backward_propagation(X, y, lr)def predict(self, X):return np.round(self.forward_propagation(X))#示例用法X = np.array([[0, 0], [0, 1], [1, 0], [1, 1]])y = np.array([[0], [1], [1], [0]])nn = BPNeuralNetwork(2, 2, 1)print("预测结果:")print(nn.predict(X))```以上是一个简单的BP神经网络算法示例程序,用于训练一个XOR逻辑门的分类模型。

BP神经网络算法

1

目

录

一、BP神经网络算法概述

二、BP神经网络算法原理

三、BP神经网络算法特点及改进

2

一.BP神经网络算法概述

BP神经网络(Back-Propagation Neural Network),即误差

后向传播神经网络,是一种按误差逆向传播算法训练的多层前馈网

络,是目前应用最广泛的网络模型之一。

11

二.BP神经网络算法原理

图5 Tan-Sigmoid函数在(-4,4)范围内的函数曲线

12

二.BP神经网络算法原理

激活函数性质:

① 非线性

② 可导性:神经网络的优化是基于梯度的,求解梯度需要确保函

数可导。

③ 单调性:激活函数是单调的,否则不能保证神经网络抽象的优

化问题转化为凸优化问题。

④ 输出范围有限:激活函数的输出值范围有限时,基于梯度的方

= 1

=1

7

,

= 1,2,3 … , q

二.BP神经网络算法原理

输出层节点的输出为:

j = 2 ,

= 1,2,3. . . ,

=1

至此,BP网络完成了n维空间向量对m维空间的近似映射。

图2 三层神经网络的拓扑结构

8

二.BP神经网络算法原理

BP神经网络是多层前馈型神经网络中的一种,属于人工神经网

络的一类,理论可以对任何一种非线性输入输出关系进行模仿,因

此 被 广 泛 应 用 在 分 类 识 别 ( classification ) 、 回 归

(regression)、压缩(compression)、逼近(fitting)等领域。

在工程应用中,大约80%的神经网络模型都选择采用BP神经网

bp神经网络算法原理

bp神经网络算法原理BP神经网络算法(Backpropagation algorithm)是一种监督学习的神经网络算法,其目的是通过调整神经网络的权重和偏置来实现误差的最小化。

BP神经网络算法基于梯度下降和链式法则,在网络的前向传播和反向传播过程中进行参数的更新。

在前向传播过程中,输入样本通过网络的各个神经元计算,直到达到输出层。

每个神经元都会对上一层的输入进行加权求和,并经过一个非线性激活函数得到输出。

前向传播的结果即为网络的输出。

在反向传播过程中,首先需要计算网络的输出误差。

误差是实际输出与期望输出的差异。

然后,从输出层开始,沿着网络的反方向,通过链式法则计算每个神经元的误差贡献,并将误差从输出层反向传播到输入层。

每个神经元根据自身的误差贡献,对权重和偏置进行调整。

这一过程可以看作是通过梯度下降来调整网络参数,以最小化误差。

具体而言,对于每个样本,BP神经网络算法通过以下步骤来更新网络的参数:1. 前向传播:将输入样本通过网络,计算得到网络的输出。

2. 计算误差:将网络的输出与期望输出进行比较,计算得到输出误差。

3. 反向传播:从输出层开始,根据链式法则计算每个神经元的误差贡献,并将误差沿着网络反向传播到输入层。

4. 参数更新:根据每个神经元的误差贡献,使用梯度下降方法更新神经元的权重和偏置。

5. 重复以上步骤,直到达到预设的训练停止条件,例如达到最大迭代次数或误差小于某个阈值。

总的来说,BP神经网络算法通过计算输出误差和通过反向传播调整网络参数的方式,实现对神经网络的训练。

通过不断迭代优化网络的权重和偏置,使得网络能够更准确地进行分类、回归等任务。

机器学习-BP(back propagation)神经网络介绍

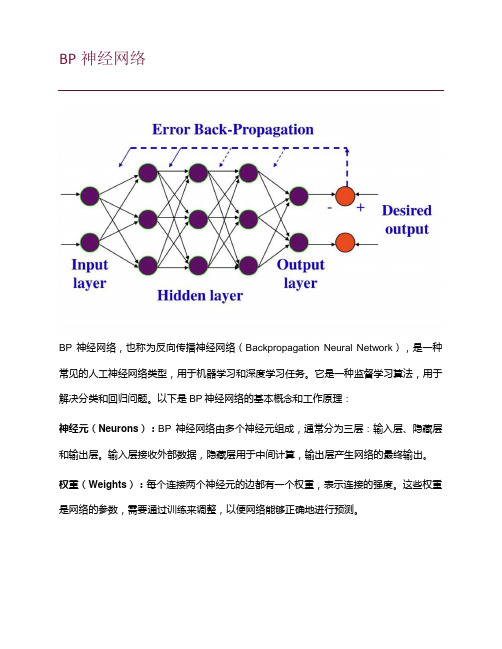

BP神经网络BP神经网络,也称为反向传播神经网络(Backpropagation Neural Network),是一种常见的人工神经网络类型,用于机器学习和深度学习任务。

它是一种监督学习算法,用于解决分类和回归问题。

以下是BP神经网络的基本概念和工作原理:神经元(Neurons):BP神经网络由多个神经元组成,通常分为三层:输入层、隐藏层和输出层。

输入层接收外部数据,隐藏层用于中间计算,输出层产生网络的最终输出。

权重(Weights):每个连接两个神经元的边都有一个权重,表示连接的强度。

这些权重是网络的参数,需要通过训练来调整,以便网络能够正确地进行预测。

激活函数(Activation Function):每个神经元都有一个激活函数,用于计算神经元的输出。

常见的激活函数包括Sigmoid、ReLU(Rectified Linear Unit)和tanh(双曲正切)等。

前向传播(Forward Propagation):在训练过程中,输入数据从输入层传递到输出层的过程称为前向传播。

数据经过一系列线性和非线性变换,最终产生网络的预测输出。

反向传播(Backpropagation):反向传播是BP神经网络的核心。

它用于计算网络预测的误差,并根据误差调整网络中的权重。

这个过程分为以下几个步骤:1.计算预测输出与实际标签之间的误差。

2.将误差反向传播回隐藏层和输入层,计算它们的误差贡献。

3.根据误差贡献来更新权重,通常使用梯度下降法或其变种来进行权重更新。

训练(Training):训练是通过多次迭代前向传播和反向传播来完成的过程。

目标是通过调整权重来减小网络的误差,使其能够正确地进行预测。

超参数(Hyperparameters):BP神经网络中有一些需要人工设置的参数,如学习率、隐藏层的数量和神经元数量等。

这些参数的选择对网络的性能和训练速度具有重要影响。

BP神经网络在各种应用中都得到了广泛的使用,包括图像分类、语音识别、自然语言处理等领域。

BP学习算法范文

BP学习算法范文BP神经网络(Back Propagation)是一种常见的人工神经网络,通过反向传播算法对网络权值进行调整,从而实现对输入样本的学习和模式识别。

下面将详细介绍BP神经网络的学习算法。

首先,BP神经网络是一种多层前馈网络,由输入层、隐含层和输出层构成。

输入层接收外部的输入信号,隐含层进行信息的加工和处理,输出层将处理结果输出。

每一层都由若干个神经元组成,相邻层之间的神经元互相连接,通过连接权值进行信息传递。

BP神经网络的学习过程主要包括前向传播和反向传播两个阶段。

首先是前向传播,通过将输入样本从输入层传递至输出层,计算网络的输出结果。

计算的过程是从输入层开始,逐层按照前一层的输出结果和连接权值计算当前层的输出结果。

具体计算步骤如下:1.初始化网络参数:包括连接权值和阈值。

2.将输入样本传递至输入层,计算输入层的输出结果。

3.依次计算每一层的输出结果,直至输出层。

计算方法为将上一层的输出结果与连接权值相乘,再经过激活函数得到当前层的输出结果。

4.网络输出层的输出结果即为网络对输入样本的预测结果。

然后是反向传播,通过对网络输出结果与实际样本进行比较,计算损失函数,然后将误差通过反向传播从输出层向输入层进行调整,更新网络参数。

具体计算步骤如下:1.计算损失函数:通过比较网络输出结果与实际样本之间的差异,计算网络的损失函数。

2.反向传播误差:根据损失函数,将误差从输出层向隐含层和输入层进行反向传播。

具体过程为按照输出层的误差,通过连接权值将误差分配至相应的神经元上。

3.更新网络参数:根据反向传播得到的误差,通过学习率和连接权值的调整准则更新网络参数。

具体过程为根据误差计算相应的梯度,并按照梯度下降法更新连接权值和阈值。

4.重复以上步骤,直至达到预定的停止条件(如达到最大迭代次数或误差小于设定阈值)。

最后,需要注意的是,在BP神经网络的学习过程中,需要选择合适的激活函数、学习率和停止条件,以及初始化连接权值和阈值的方法,这些都会对学习算法的性能产生影响。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

BP神经网络学习及算法

1.前向传播:

在BP神经网络中,前向传播用于将输入数据从输入层传递到输出层,其中包括两个主要步骤:输入层到隐藏层的传播和隐藏层到输出层的传播。

(1)输入层到隐藏层的传播:

首先,输入数据通过输入层的神经元进行传递。

每个输入层神经元都

与隐藏层神经元连接,并且每个连接都有一个对应的权值。

输入数据乘以

对应的权值,并通过激活函数进行处理,得到隐藏层神经元的输出。

(2)隐藏层到输出层的传播:

隐藏层的输出被传递到输出层的神经元。

同样,每个隐藏层神经元与

输出层神经元连接,并有对应的权值。

隐藏层输出乘以对应的权值,并通

过激活函数处理,得到输出层神经元的输出。

2.反向传播:

在前向传播后,可以计算出网络的输出值。

接下来,需要计算输出和

期望输出之间的误差,并将误差通过反向传播的方式传递回隐藏层和输入层,以更新权值。

(1)计算误差:

使用误差函数(通常为均方差函数)计算网络输出与期望输出之间的

误差。

误差函数的具体形式根据问题的特点而定。

(2)反向传播误差:

从输出层开始,将误差通过反向传播的方式传递回隐藏层和输入层。

首先,计算输出层神经元的误差,然后将误差按照权值比例分配给连接到该神经元的隐藏层神经元,并计算隐藏层神经元的误差。

依此类推,直到计算出输入层神经元的误差。

(3)更新权值:

利用误差和学习率来更新网络中的权值。

通过梯度下降法,沿着误差最速下降的方向对权值和阈值进行更新。

权值的更新公式为:Δwij = ηδjxi,其中η为学习率,δj为神经元的误差,xi为连接该神经元的输入。

以上就是BP神经网络的学习算法。

在实际应用中,还需要考虑一些其他的优化方法和技巧,比如动量法、自适应学习率和正则化等,以提高网络的性能和稳定性。

此外,BP神经网络也存在一些问题,比如容易陷入局部极小值、收敛速度慢等,这些问题需要根据实际情况进行调优和改进。