卡方检验模型验证方法

卡方检验在统计学中的应用

公式

根据不同的理论分布,拟合优度 卡方检验的公式也有所不同,但 基本思路是计算样本数据与理论 分布之间的差异程度。

应用场景

例如,判断某地区居民的身高是 否符合正态分布。

03 卡方检验在统计学中的应 用场景

分类变量间关系的研究

研究两个分类变量之间的关系,判断它们 是否独立。通过卡方检验可以比较观测频 数与期望频数的差异,从而判断两个分类 变量之间是否存在关联或因果关系。

公式

与独立性卡方检验类似,但计算的是同一观察对象在不同条件下的实际观测频数与期望频数的差异程度。

应用场景

例如,判断某药物在不同剂量下的疗效是否一致。

拟合优度卡方检验

定义

拟合优度卡方检验用于检验一个 样本数据是否符合某个理论分布 或模型。假设有一组样本数据, 拟合优度卡方检验的目的是判断 这组数据是否符合正态分布、二 项分布等理论分布。

数据来源

市场调查中的消费者数据,包括消费者的年龄、性别、收 入等信息以及他们对某一产品的评价和偏好。

分析方法

使用卡方检验分析不同消费者群体对同一产品的偏好程度 ,判断是否存在显著性差异。

结果解释

如果卡方检验结果显著,说明不同消费者群体对同一产品 的偏好程度存在显著差异;如果结果不显著,则说明消费 者偏好较为接近。

它通过计算观测频数与期望频 数之间的卡方值,评估两者之 间的差异是否具有统计学显著 性。

卡方检验常用于分类数据的分 析,如计数数据和比例数据。

卡方检验的基本思想

1 2

基于假设检验原理

卡方检验基于假设检验的基本思想,首先提出原 假设和备择假设,然后通过样本数据对原假设进 行检验。

比较实际观测与期望值

要点二

自由度

生物统计学第四章——卡方检验

p f x0 8 1 1 5 2 2 0 3 1 0 4 5 5 2 0.191

nN

1 6 00

4.1 适合度检验

•用Excel函数BINOMDIST(i,n,p,0)计算二项分布的理论 概率:

4.1 适合度检验

• 将理论概率乘以苹果总箱数(N=60),得到理论次数:

下面,点击确定。

4.1 适合度检验

• ④ SPSS • 点击确定,即可得到结果:

4.1 适合度检验

•例 4.3 某批苹果进行保存实验,共60箱,每箱10个,实 验结束后检查每箱苹果的变质情况,结果如下表,试检 验苹果的变质数是否服从二项分布?

4.1 适合度检验

•设每个苹果变质的平均概率为p,变质数x服从二项分布,

4.1 适合度检验

② 6SQ统计插件 弹出对话框,无需修改设置:

4.1 适合度检验

•卡②方值6S为Q3统0计2.6插2件9,p=0.000<0.01,表明观测值比例与 •理论点比击有确非定常,显即著可的得差到异结。果:

4.1 适合度检验

③ DPS (1)输入数据与选择数据,点击菜单分类数据统计→模 型拟合优度检验:

• ① Minitab • 输入数据,点击菜单统计→表格→卡方拟合优度检验

(单变量):

4.1 适合度检验

•检①验下Mi面nit选ab择按历史计数制定的比率,下拉条选择输入 •列,弹将出理对论话选框择,到将按实历际史选计择数到制观定测的计比数率后后面面,:豌豆性状

选择到类别名称(可选)后面。

4.1 适合度检验

第四章 卡方检验

• 卡方(χ2)检验主要有三种类型: • 第一是适合性检验,比较观测值与理论值是否符合; • 第二是独立性检验,比较两个或两个以上的因子相互

6 卡方检验

未知,故由样本去估计( 解 由于总体µ、σ未知,故由样本去估计(采用 点估计): 点估计):

µ = x =95.60 σ = S = 5.274

首先算出各组的理论频率: 首先算出各组的理论频率:

xi +1 − µ xi − µ pi = Φ − Φ σ σ

拟合优度检验(适合性检验) 第一节 拟合优度检验(适合性检验)

所谓拟合优度, 所谓拟合优度,就是指观察到的样本表现与某种理论 拟合优度 模型吻合的程度。 模型吻合的程度。拟合优度检验就是对观察的样本表现与 所选某种理论模型的拟合程度作推断判决。 所选某种理论模型的拟合程度作推断判决。 比如眼下有观察资料, 比如眼下有观察资料,需判明它是来自遵从何种分布 的总体,我们可以根据已有的经验对它作是“ 的总体,我们可以根据已有的经验对它作是“来自某种总 的假定(假设), ),即 体”的假定(假设),即 H0:F(x) = F0(x) 式中, 表示已知的某种分布, 式中,F0(x)表示已知的某种分布,如正态分布、二项分布、 表示已知的某种分布 如正态分布、二项分布、 χ2分布等。值得注意的是在这里建立统计假设不同于以前 分布等。值得注意的是在这里建立统计假设不同于以前 所作的假设检验, 所作的假设检验,前面作假设检验时总是选择欲否定的内 容作成立的假定; 容作成立的假定;而在这里我们通常是选择最有可能接近 的类型作成立的假设。 的类型作成立的假设。

组中值 组频率 f 理论频率 偏差量 83 3 2.381 0.619 86 6 5.637 0.363 89 12 12.40 -0.40 92 20 19.72 0.285 95 23 22.68 0.316 98 19 18.88 0.118 101 10 11.37 -1.37 104 5 4.952 0.048 107 2 1.981 0.019

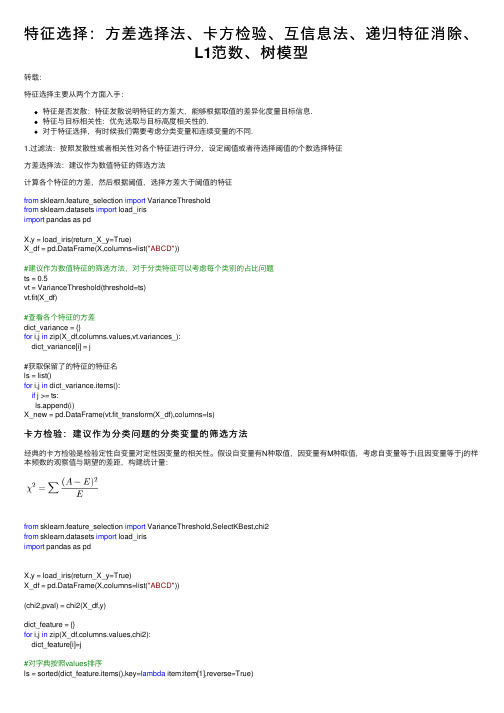

特征选择:方差选择法、卡方检验、互信息法、递归特征消除、L1范数、树模型

特征选择:⽅差选择法、卡⽅检验、互信息法、递归特征消除、L1范数、树模型转载:特征选择主要从两个⽅⾯⼊⼿:特征是否发散:特征发散说明特征的⽅差⼤,能够根据取值的差异化度量⽬标信息.特征与⽬标相关性:优先选取与⽬标⾼度相关性的.对于特征选择,有时候我们需要考虑分类变量和连续变量的不同.1.过滤法:按照发散性或者相关性对各个特征进⾏评分,设定阈值或者待选择阈值的个数选择特征⽅差选择法:建议作为数值特征的筛选⽅法计算各个特征的⽅差,然后根据阈值,选择⽅差⼤于阈值的特征from sklearn.feature_selection import VarianceThresholdfrom sklearn.datasets import load_irisimport pandas as pdX,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))#建议作为数值特征的筛选⽅法,对于分类特征可以考虑每个类别的占⽐问题ts = 0.5vt = VarianceThreshold(threshold=ts)vt.fit(X_df)#查看各个特征的⽅差dict_variance = {}for i,j in zip(X_df.columns.values,vt.variances_):dict_variance[i] = j#获取保留了的特征的特征名ls = list()for i,j in dict_variance.items():if j >= ts:ls.append(i)X_new = pd.DataFrame(vt.fit_transform(X_df),columns=ls)卡⽅检验:建议作为分类问题的分类变量的筛选⽅法经典的卡⽅检验是检验定性⾃变量对定性因变量的相关性。

假设⾃变量有N种取值,因变量有M种取值,考虑⾃变量等于i且因变量等于j的样本频数的观察值与期望的差距,构建统计量:from sklearn.feature_selection import VarianceThreshold,SelectKBest,chi2from sklearn.datasets import load_irisimport pandas as pdX,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))(chi2,pval) = chi2(X_df,y)dict_feature = {}for i,j in zip(X_df.columns.values,chi2):dict_feature[i]=j#对字典按照values排序ls = sorted(dict_feature.items(),key=lambda item:item[1],reverse=True)#特征选取数量k =2ls_new_feature=[]for i in range(k):ls_new_feature.append(ls[i][0])X_new = X_df[ls_new_feature]互信息法:建议作为分类问题的分类变量的筛选⽅法经典的互信息也是评价定性⾃变量对定性因变量的相关性的,为了处理定量数据,最⼤信息系数法被提出,互信息计算公式如下:from sklearn.feature_selection import VarianceThreshold,SelectKBest,chi2from sklearn.datasets import load_irisimport pandas as pdfrom sklearn.feature_selection import mutual_info_classif#⽤于度量特征和离散⽬标的互信息X,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))feature_cat = ["A","D"]discrete_features = []feature = X_df.columns.values.tolist()for k in feature_cat:if k in feature:discrete_features.append(feature.index(k))mu = mutual_info_classif(X_df,y,discrete_features=discrete_features,n_neighbors=3, copy=True, random_state=None)dict_feature = {}for i,j in zip(X_df.columns.values,mu):dict_feature[i]=j#对字典按照values排序ls = sorted(dict_feature.items(),key=lambda item:item[1],reverse=True)#特征选取数量k =2ls_new_feature=[]for i in range(k):ls_new_feature.append(ls[i][0])X_new = X_df[ls_new_feature]from sklearn.feature_selection import VarianceThreshold,SelectKBest,chi2from sklearn.datasets import load_irisimport pandas as pdfrom sklearn.feature_selection import mutual_info_classif,mutual_info_regression#⽤于度量特征和连续⽬标的互信息X,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))feature_cat = ["A","D"]discrete_features = []feature = X_df.columns.values.tolist()for k in feature_cat:if k in feature:discrete_features.append(feature.index(k))mu = mutual_info_regression(X_df,y,discrete_features=discrete_features,n_neighbors=3, copy=True, random_state=None)dict_feature = {}for i,j in zip(X_df.columns.values,mu):dict_feature[i]=j#对字典按照values排序ls = sorted(dict_feature.items(),key=lambda item:item[1],reverse=True)#特征选取数量k =2ls_new_feature=[]for i in range(k):ls_new_feature.append(ls[i][0])X_new = X_df[ls_new_feature]2.包装法递归特征消除法:⽤⼀个基模型来进⾏多轮训练,每轮训练后,消除若⼲权值系数的特征,再基于新的特征集进⾏下⼀轮训练from sklearn.datasets import load_irisimport pandas as pdfrom sklearn.feature_selection import RFE,RFECVfrom sklearn.ensemble import RandomForestClassifierX,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))refCV = RFECV(estimator=RandomForestClassifier(),step=0.5,cv =5,scoring=None,n_jobs=-1)refCV.fit(X_df,y)#保留特征的数量refCV.n_features_#保留特征的False、True标记refCV.support_feature_new = X_df.columns.values[refCV.support_]#交叉验证分数refCV.grid_scores_3.嵌⼊的⽅法基于L1范数:使⽤带惩罚项的基模型,除了筛选出特征外,同时也进⾏了降维from sklearn.datasets import load_irisimport pandas as pdfrom sklearn.feature_selection import SelectFromModelfrom sklearn.linear_model import LogisticRegressionX,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))sf = SelectFromModel(estimator=LogisticRegression(penalty="l1", C=0.1),threshold=None,prefit=False,norm_order=1)sf.fit(X_df,y)X_new = X_df[X_df.columns.values[sf.get_support()]]基于树模型的特征选择法:树模型中GBDT也可⽤来作为基模型进⾏特征选择,使⽤feature_selection库的SelectFromModel类结合GBDT模型from sklearn.datasets import load_irisimport pandas as pdfrom sklearn.feature_selection import SelectFromModelfrom sklearn.ensemble import GradientBoostingClassifierX,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))sf = SelectFromModel(estimator=GradientBoostingClassifier(),threshold=None,prefit=False,norm_order=1)sf.fit(X_df,y)X_new = X_df[X_df.columns.values[sf.get_support()]]。

卡方检验基本公式检验方法

配对四格表资料的χ2检验 (McNemar's test)

H0:b,c来自同一个实验总体(B=C);

注:B=C=(b+c)/2

H1:b,c来自不同的实验总体(B C );α=0.05。

当b c 40时, 2 (b c)2 , 1

bc

b c 40时,需作连续性校正, 2 ( b c 1)2 , 1

1122.59 15

18

卡方值

χ2检验的基本公式

2 ( A T )2 ,

T

(R 1)(C 1)

上述检验统计量由K. Pearson提出,因此许多统计软 件上常称这种检验为Pearson’s Chi-square test,下面将要 介绍的其他卡方检验都是在此基础上发展起来的。

二、四格表资料专用公式

2

,(2Biblioteka )服从均数为,方差为2的正态分布χ2分布(Chi-square distribution)

0.5 0.4

f

( 2)

1 2(

/ 2)

2 2

(

/ 21)

e2 / 2

纵高

0.3 0.2 0.1 0.0

0

自由度=1 自由度=2 自由度=3 自由度=6 P=0.05的临界值

3 3.84 6 7.81 9

检验假设: (以P119 例7-6为例,进一步分析)

H0: A

,任两对比组的总体有效率相等

B

H1: A B,任两对比组的总体有效率不等

0.05

检验水准调整:(否则结果会自相矛盾!)

2 31.586 41 3

P 0.005

7.4 行×列表资料的 2检验

卡方检验和精确概率法-概述说明以及解释

卡方检验和精确概率法-概述说明以及解释1.引言1.1 概述卡方检验和精确概率法是统计学中常用的两种假设检验方法。

它们都是用于检验数据之间的相关性或者关联度,以判断某种因素与某种结果之间是否存在显著的统计关系。

卡方检验是一种非参数的假设检验方法,主要用于分析分类数据的关联性。

它通过统计观察值与期望值之间的差异,来决定变量之间是否存在显著性关系。

卡方检验可以处理多个分类变量之间的相关性问题,并且不受数据分布的限制。

在实际应用中,卡方检验经常用于医学研究、社会科学调研等领域,帮助研究者发现变量之间的关联性,从而进一步分析和解读数据。

精确概率法,又称为精确检验法,是一种基于排列组合原理的计算方法。

它主要用于处理小样本或者数据限制条件较多的情况下的假设检验问题。

与卡方检验不同的是,精确概率法通过枚举出所有可能的组合情况,计算出达到当前观察值或更极端情况下的事件发生概率,从而得出假设检验的结果。

精确概率法的主要优势在于其统计推断的准确性和稳定性,适用于小样本和稀有事件的研究。

本文将会介绍卡方检验和精确概率法的原理和应用,并比较它们的优缺点。

在结论部分,将会对两种方法进行对比分析,进一步探讨它们适用的场景和应用前景。

通过本文的阐述,读者将对卡方检验和精确概率法有更加全面的了解,并能够根据具体问题的特点选择适合的检验方法。

1.2文章结构1.2 文章结构本文将分为三个主要部分,分别是引言、正文和结论。

在引言部分,将对卡方检验和精确概率法的背景和概述进行介绍。

首先会对这两种方法进行简要的概述,包括其原理和应用领域。

接下来会明确本文的结构和目的,为读者提供整体上的概括。

在正文部分,将详细探讨卡方检验和精确概率法。

首先,在2.1节将详细介绍卡方检验的原理和应用。

会对卡方检验的基本原理进行解释,包括假设检验的流程和计算统计量的方法。

同时,会介绍卡方检验的应用领域,包括医学、社会科学和市场调研等。

接着,会对卡方检验的优缺点进行分析和讨论,以便读者全面了解其适用范围和局限性。

卡方检验的结果解读

卡方检验的结果解读1.引言1.1 概述卡方检验是一种常用的统计方法,用于判断两个分类变量之间是否存在相关性或者一致性。

它是基于统计推断的方法,通过比较实际观察值与理论期望值之间的差异来进行判断。

在实际应用中,卡方检验被广泛用于比较两个或多个分类变量的分布情况,包括但不限于医学研究、社会调查以及市场分析等领域。

它能够帮助我们判断两个或多个分类变量是否独立,从而揭示变量之间的关联关系。

本文旨在对卡方检验的结果进行解读和分析。

首先,我们将介绍卡方检验的基本原理,包括计算卡方值和自由度的方法。

其次,我们将探讨卡方检验在实际应用中的一些典型场景,比如用于比较不同人群中某一特征的分布情况,或者用于评估某一策略对用户行为变化的影响等。

在解读卡方检验结果时,我们需要关注卡方值和P值。

卡方值反映了观察值与理论期望值之间的差异程度,而P值则是用来判断这种差异是否具有统计学意义的指标。

通常来说,如果P值小于预先设定的显著性水平(通常为0.05),则可以拒绝原假设,即认为变量之间存在相关性或一致性。

然而,卡方检验也有其局限性。

例如,样本量过小可能导致研究结论不准确,而样本量过大则可能会使得小的差异也变得显著。

此外,卡方检验只能判断变量是否相关,而不能确定其具体的关系强度和方向性。

综上所述,卡方检验是一种重要的统计方法,可以帮助我们判断变量之间的关系。

对于卡方检验结果的解读,我们需要综合考虑卡方值和P值,并且意识到其存在的局限性。

在实际应用中,我们可以根据具体问题选择合适的卡方检验方法,并合理解读其结果,以便得出准确的结论。

1.2文章结构文章结构部分应该对整篇长文的大致结构进行介绍,并说明各个部分内容的关联性和重要性。

具体内容如下:1.2 文章结构本文主要围绕卡方检验的结果进行解读展开。

全文分为引言、正文和结论三个部分。

在引言部分,我们将对卡方检验进行概述,介绍其基本原理,并明确文章的目的。

同时,我们也会提及本文的结构,让读者对文章整体有个初步的认识。

列联表、卡方检验与对数线性模型

统计软件的选项中有关于分布的选项

高维表的检验统计量和二维表一样也包含了Pearson c2统计量和似然比c2统计量。

两种对数线性模型

用table7.sav数据拟合对数线性模型 假定(多项分布)对数线性模型为 这里ai为收入(i=1,2,3代表收入的低、中、高三个水平),bj为观点(j=1,2代表不赞成和赞成两个水平),gk为性别(k=1,2代表女性和男性两个水平), mijk代表三维列联表对于三个变量的第ijk水平组合的出现次数。 而从相应的参数估计输出结果,可以得到对ai的三个值的估计为0.5173, 0.2549,0.0000,对bj的两个值的估计为-0.6931,0.0000,对gk的两个值的估计为 0.1139,0.0000。(多项对数线性模型常数无意义,输出的常数项仅仅是数学意义)

而每种组合的数目(也就是列联表中的频数)在number那一列上面,这就是每种组合的权重(weight),需要把这个数目考虑进去,称为加权(weight).如果不加权,最后结果按照所有组合只出现一次来算(也就是说,按照列联表每一格的频数为1).由于在后面的选项中没有加权的机会,因此在一开始就要加权.方法是点击图标中的小天平(“权”就是天平的意思),出现对话框之后点击Weight cases,然后把“number”选入即可。

(多项分布)对数线性模型

注意,无论你对模型假定了多少种效应,并不见得都有意义;有些可能是多余的。本来没有交叉影响,但如果写入,也没有关系,在分析过程中一般可以知道哪些影响是显著的,而那些是不显著的。

STEP4

STEP3

STEP2

STEP1

前面介绍的多项分布对数线性模型假定所有的可能格子里面的频数满足多项分布。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

卡方检验模型验证方法模型参数的验证方法主要使用卡方拟合度检验( Chi-square Goodness-of-fit Test )结合最大似然

估计( Maximum Likelihood Estimation ),并且使用QQ图(Quantile-Quantile Plot)证明验证结果。

具体的说,就是先假定采集的样本数据符合某一分布,通过最大似然估计方法估计出该分布的参数,然后代入并用卡方检验计算相对于该分布的偏差。

实践中我们对于一组样本数据,计算所有常见分布的偏差值,选取偏差最小的分布做为该样本的拟合结果。

另外,从QQ图直观上看,该分布做为拟合结果描绘出的曲线

必须近似为接近参考线的直线(见3.3),否则我们就将数据拆分为多个部分进行分段的拟合(如对终端请求包大小的拟合)。

1.1 卡方拟合度检验卡方检验是一种大样本假设检验法,用于检验随机事件中提出的样本数据是否符合某一给定分布。

它需要较

大量的样本数据及已知的待检验概率分布函数。

1.1.1 卡方检验原理对于一个服从二项分布的随机变量Y服从Binomial( n, p) ,均值为,方差。

由中心极限定理,符合标准正态分布N (0, 1),所以服从自由度为1的卡方分布。

设服从Binomial( n, p1 ), , , 则

有

所以

同理对于k个随机变量,均值分别为

,

在数据拟合时,先对数据分组,每组数据的实际个数即为随机变量

,,,则数据拟合即为判断

是否符合分布,

该卡方分布的自由度为k-1-nep(k为随机变量个数,nep为估计参数的个数)。

1.1.2 卡方检验步骤:假定样本服从某一给定分布。

根据样本数据用最大似然法估计分布的密度函数参数。

设定置信度,对n个样本数据排序。

把排序后的数据分成k组,确定每组的上下限,(上下限确定方法不同对验证能力有影响,

每组数据不少于5个),为了方便起见,本项目中采用平均划分分组间隔,即使为常数,

对于所有的成立。

计算每组数据实际个数,第i组实际个数为。

计算每组数据期望个数,第i组期望个数为:

连续:,其中F(x)为待验证的概率分布函数,

离散:。

计算。

理论上说如果,则数据符合分布函数为F(x)的分布,

其中,nep为估计的参数的个数。

但是由于实际采集的数据并非完全地符合某一分布,

总存在一定的偏差,计算出的值并不满足这个条件,

所以我们使用的拟合标准为采用卡方估计值最小的分布作为验证结果。