基于条件随机场CRFs的中文词性标注方法_洪铭材

用条件随机场CRF进行字标注中文分词(Python实现)

⽤条件随机场CRF进⾏字标注中⽂分词(Python实现)主题本⽂运⽤字标注法进⾏中⽂分词,使⽤4-tag对语料进⾏字标注,观察分词效果。

模型⽅⾯选⽤开源的条件随机场⼯具包“ ”进⾏分词。

本⽂使⽤的中⽂语料资源是SIGHAN提供的语料,⽬前封闭测试最好的结果是4-tag+CFR标注分词,在北⼤语料库上可以在准确率,召回率以及F值上达到92%以上的效果,在微软语料库上可以到达96%以上的效果。

第⼀部分条件随机场模型⼯具包安装说明在Linux或者Mac OS系统下,下载C++源代码安装包(这⾥⽤的是)之后,按照如下步骤进⾏安装:1.进⼊到代码主⽬录后,正常按照“configure & make & (sudo) make install就可以完成C++库的安装。

2.再进⼊到⼦⽬录python下,安装python包:python setup.py build & (sudo) python setup.py install,这个python库是通过强⼤的⽣成的。

3.安装完毕之后,可以在python解释器下测试,是否能成功import CRFPP,如果ok,则准备⼯作就绪。

注意:在安装过程中或者是后⾯的运⾏过程中(具体什么时候我忘记了),如果报出下⾯的错误:ImportError: libcrfpp.so.0: cannot open shared object file: No such file or directory错误的原因是未能引⼊libcrfpp.so.0库,查找库⽂件存在,于是建⽴链接:32位系统 ln -s /usr/local/lib/libcrfpp.so.* /usr/lib/64位系统 ln -s /usr/local/lib/libcrfpp.so.* /usr/lib64/问题解决。

第⼆部分模型相关知识介绍在CRF++ example⾥有个seg⽬录,这个seg⽬录对应的是⼀个⽇⽂分词的样例,正好可以套⽤到我们的中⽂分词中来。

基于条件随机场CRFs的中文词性标注方法_洪铭材

行文本标注时 , 先对文本进行初始标注 , 然后按照规则获取的 次序应用规则进行标注 。 该方法在英文词性标注上取得了很 好的效果 。 其主要问题是学习规则的时间过长 。 针对这一问 题 , 周明等提出一个快速学习算法 , 使训练速度大大提高[ 2] 。

③基于统计的方法 。 基于统计的方法是目前应用最广泛 的词性标注方法 。 白栓虎提出基于统计的汉语词性自动标注 方法 , 使用二元语法模型 和动态 规划的 方法进 行汉语 的词性 标注 。当前 大部分汉语词性系统采用基于二元语法模型或三 元语法模型的隐马尔可夫模型 , 通过 EM 训练的方法 , 给每个 词和词性标签对分配一个 联合概率 , 通 过维特 比解码 的动态 规划方法来获取一个句子对应的最佳的词性标注序列 。 隐马 尔可夫模型的缺点是假设词的词性只与 词本身和它 前面的 n 个词有关 , 而与该词后 面的词 没有关 系 。 这个假 设与实 际情 况并不吻合 。 基于最大熵模 型的词 性标注 方法 , 有效地 利用 了上下文信息 , 在一定的 约束条 件下可 以得到 与训练 数据一 致的概率分布 , 得到了 很好标 注效果 。 但 是最大 熵模型 存在 一种称为“ label bias” 问题 的弱点[ 1] , 在 某些 训练 集上得 到的 模型可能会得到很差的标注效果 。 常见的基于统计的方法还 有神经元网络 、决策树 、线性分离网络标注模型等 。

词性标注是自然语言处 理的重 要内容 之一 , 是其他 信息 的标注正确率 , 其封 闭测 试和开 放测 试的 准确率 分别 为 98.

处理技术的基础 , 被广 泛地应 用于机 器翻译 、文字 识别 、语音 56%和 96.60 %, 兼类 词和未 登录 词的 标注 也取 得了 很好 的

基于条件随机场的中文命名实体识别算法的研究

基于条件随机场的中文命名实体识别算法的研究中文命名实体识别,简称中文NER,是中文自然语言处理领域的一个重要研究方向,该技术的目的是从文本中识别出人名、地名、组织机构名等实体,对后续的文本分析、数据挖掘等任务有很重要的作用。

而条件随机场(Conditional Random Fields,CRF)作为一种非常有效的序列标注方法,在中文NER任务中表现出了优秀的性能和广泛的应用。

本文将探讨基于条件随机场的中文命名实体识别算法的研究。

一、条件随机场简介条件随机场是一种基于概率图模型的方法,最早由Lafferty、McCallum和Pereira在2001年提出。

它的本质是给定输入序列 $\mathbf{x}={x_1,x_2,...,x_n}$,以及对应的输出序列 $\mathbf{y}={y_1,y_2,...,y_n}$,计算条件概率分布$P(\mathbf{y}|\mathbf{x})$,即在给定输入序列的情况下输出序列的概率。

CRF 的特点是可以考虑序列上各个位置的标注之间的相互依赖关系,而且可以自适应地学习特征权值,因此常被用于序列标注任务。

二、CRF在中文NER中的应用在中文NER任务中,CRF在标注序列的时候,可以考虑上下文语境信息,从而提高准确性。

具体来说,中文NER任务可以分为两步,首先是分词与特征提取,然后是标注。

其中,特征提取非常重要,需要基于分词后的词汇以及前后文进行特征提取,如词性、词义、上下文等等。

CRF 适合处理这种带有标注耦合关系的任务,具有较好效果。

CRF 也可以处理多种类型的实体,包括人名、地名、组织机构名和时间等等。

三、基于CRF的中文NER算法流程基于CRF的中文NER算法一般可以分为以下几个步骤:(1)特征提取:通过分词后的词汇产生特征,其中包括词性、词义、字形等等。

(2)特征模板设计:选择合适的特征模板,一般包括当前单词、前一个单词和后一个单词的序列特征等。

条件随机场模型中的标注问题与解决方法(六)

条件随机场模型中的标注问题与解决方法条件随机场(Conditional Random Field, CRF)是一种概率图模型,常用于自然语言处理领域的标注问题。

标注问题是指给定一组观测数据,需要为每个观测数据打上相应的标签,比如词性标注、命名实体识别等。

在实际应用中,标注问题往往面临着数据稀疏、标签信息不一致等各种挑战,因此需要采用有效的方法来解决这些问题。

一、条件随机场模型条件随机场模型是一种判别式模型,用于建模给定输入数据下的标记序列的条件概率分布。

其核心思想是利用特征函数来表示输入数据和标记序列之间的关系,通过最大化条件概率来求解最优的标记序列。

条件随机场模型能够充分考虑观测数据的上下文信息,因此在标注问题中取得了较好的效果。

二、标注问题的挑战在实际应用中,标注问题往往面临数据稀疏和标签信息不一致等挑战。

数据稀疏指的是观测数据中存在大量的未标记数据,这会导致模型学习和推断的困难。

标签信息不一致则表示在标注数据集中存在着标签标注不一致的情况,这会对模型的训练和泛化能力造成影响。

三、解决方法为了应对标注问题的挑战,研究者们提出了许多有效的解决方法。

其中,一种常见的方法是引入大量的特征函数来丰富条件随机场模型的表达能力。

通过设计合适的特征函数,能够充分利用观测数据的上下文信息,从而提高模型在标注问题上的性能。

另外,近年来,深度学习技术的发展为解决标注问题提供了新的思路。

研究者们提出了许多基于深度学习的标注模型,如双向长短时记忆网络(BiLSTM)、注意力机制等。

这些模型能够有效地捕捉输入数据的复杂特征,并在标注问题上取得了较好的效果。

此外,为了解决标签信息不一致的问题,研究者们提出了一些有效的数据预处理和模型训练方法。

例如,可以采用数据清洗和标签纠错的方法来减少标签信息不一致的影响;另外,在模型训练时,可以采用集成学习等方法来减小标注数据中标签不一致的影响。

四、总结条件随机场模型在标注问题中具有良好的建模能力和泛化能力,能够充分利用观测数据的上下文信息,取得了不错的效果。

《基于CRF的蒙古文人名自动识别》范文

《基于CRF的蒙古文人名自动识别》篇一一、引言在信息时代的浪潮下,蒙古文的文本处理与应用技术日趋重要。

对于文本内容,如何有效准确地从文本中提取特定信息一直是人工智能领域的重点研究方向。

尤其是针对蒙古文这类使用非拉丁文字符系统的语言,识别和分析文中的人名成为处理蒙古文文本的重要一环。

本文将介绍一种基于条件随机场(CRF)的蒙古文人名自动识别方法,并详细阐述其实现过程及效果。

二、蒙古文人名自动识别的背景与意义蒙古文文本中的人名通常具有丰富的文化背景和特定的命名规则,如具有复杂的词缀结构等。

对蒙古文人名进行自动识别不仅可以辅助学者和专家在相关研究中获得更为准确的语料数据,同时也有助于蒙古文化的传播、提高信息的提取效率和为各类服务如自动翻译等提供技术支撑。

因此,对于蒙古文人名自动识别研究具有极其重要的应用价值。

三、条件随机场(CRF)理论基础条件随机场(CRF)是一种用于序列标注问题的统计模型,具有较高的标注精度和泛化能力。

它利用给定标记序列的概率最大准则对问题进行求解,具有考虑全局序列的特性,能够有效减少孤立词语识别误差的干扰。

基于这一特点,CRF模型在自然语言处理领域中得到了广泛的应用。

四、基于CRF的蒙古文人名自动识别方法1. 数据预处理:首先对蒙古文文本进行预处理,包括分词、去除无关字符等步骤,将文本转换为CRF模型能够处理的序列数据格式。

2. 特征提取:针对蒙古文人名的特点,提取有意义的特征信息,如词性、上下文关系等。

这些特征信息对于模型的训练和识别至关重要。

3. 模型训练:利用CRF模型进行训练,通过大量的训练数据和特征信息,使模型学习到蒙古文人名的规律和特点。

4. 识别与后处理:模型训练完成后,对新的文本进行人名识别,并进行后处理操作,如去除冗余结果等。

五、实验结果及分析1. 实验环境:在MongoDB数据库上进行数据采集和处理工作,同时借助深度学习工具和统计学习方法完成算法开发和优化。

2. 实验过程:本文设计了不同大小和不同类型的数据集进行实验,通过调整模型参数和特征选择等方法来优化模型性能。

基于条件随机场的中文分词技术研究

基于条件随机场的中文分词技术研究中文是一门复杂的语言,分词是其中很关键的一部分,因为中文单词没有像英文单词那样明显的空格分隔。

分词技术旨在将连续的汉字序列划分成有意义的单词序列。

在自然语言处理中,分词是其中很基础的工作,是其它任务如语言模型、信息检索和机器翻译的前置步骤。

微软、阿里等大企业都已经在中文分词技术上有所突破,其中最为流行的模型是基于条件随机场(Conditional Random Fields,简称CRF)的中文分词模型。

CRF的基本思路是利用一系列特征函数来说明序列中相邻两个位置的状态关系,并通过训练得到最优的模型参数。

然而,中文分词中还存在很多细节和难点,如名词重叠、未登录词和歧义问题等。

以下从几个方面探讨基于CRF的中文分词技术的研究进展和挑战。

一、特征选择选择好的特征函数是CRF模型中的关键步骤。

目前,在中文分词领域中,特征函数可以分为以下几类:字级别特征、词级别特征和上下文特征等。

字级别特征主要考虑每个字的本身信息,如Unicode编码、字频、位置等。

词级别特征主要考虑到字之间与词的关联,比如最大匹配法、最长规则等。

上下文特征则主要考虑前后两个词之间的关系,如词性、词频、词典频率等。

特征函数选择的挑战在于不同的特征函数组合会对分词效果产生不同影响。

一般来说,特定任务和应用所需要的特征不同,因此选择不同的特征集合是必然的。

二、歧义问题在中文分词中,歧义问题是很常见的,即同一组汉字序列可以有多种分词方案。

对于这种情况,既需要利用上下文信息进行判断,又需要考虑四个基本的原则:颗粒度最小原则、上下文信息原则、词频统计原则和规则原则。

颗粒度最小原则是指在尽可能少的情况下划分语言单位;上下文信息原则是指利用前后上下文信息进行判断;词频统计原则是指优先划分高频词;规则原则是指利用人类语言规则判断语言单位的划分方式。

三、未登录词问题未登录词指的是新的词语,也就是没有出现在词典中的词语。

当出现未知词时,传统的基于字典和规则的中文分词方法将失效,因为它不知道如何分割这些词。

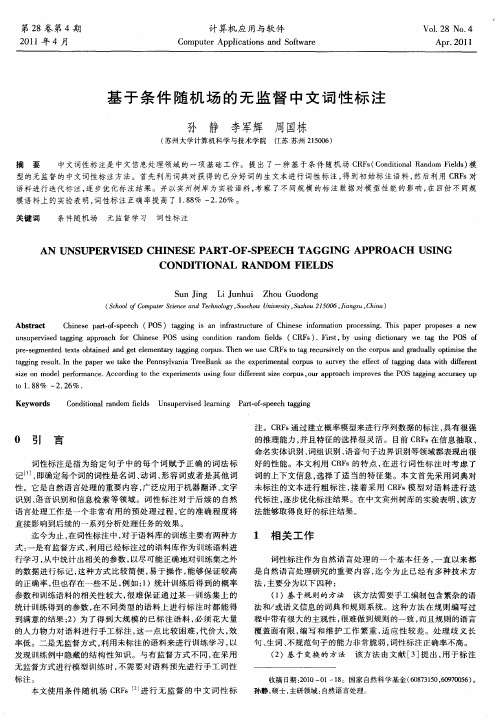

基于条件随机场的无监督中文词性标注

S n Jn L u h i Z o u d n u ig i n u h u G o o g J

( colfC m ue Si c a dTcnl y,oco nvrt,uhu2 5 0 J n s C ia Sho o o p t c ne n eh o g Sohw U i syS zo 1 06,i gu,hn ) r e o ei a

u sp r sdt gn prah f hn s P S uig cn io ad m f l ( R s . it b s g dco a etg t O f nu e i gig apoc o C iee O s odt n rn o e s C F ) Fr , y ui i i r w a h P S o ve a r n i id s n tn y e

注 。C F 通过建立 概率模 型来进行序 列数据 的标注 , Rs 具有很强

0 引 言

词性 标 注 是 指 为 给 定 句 子 中 的 每 个 词 赋 予 正 确 的 词 法 标 记… , 即确定每个词 的词 性是 名词 、 动词 、 容词或 者是其他 词 形 性 。它 是 自然 语 言 处 理 的重 要 内容 , 泛 应 用 于 机 器 翻 译 、 字 广 文

型 的 无 监 督 的 中文 词 性标 注 方 法 。 首 先利 用词 典 对 获得 的 已分 好 词 的 生 文 本进 行 词 性 标 注 , 到 初 始 标 注 语 料 , 后 利 用 C F 对 得 然 Rs 语 料 进行 迭 代 标 注 , 步 优 化 标 注 结 果 。 并 以宾 州 树 库 为 实 验 语 料 , 察 了不 同规 模 的 标 注 数据 对模 型 性 能 的 影 响 , 四 份 不 同规 逐 考 在 模 语 料 上 的 实 验表 明 , 性 标 注 正 确 率 提 高 了 18 % ~ .6 。 词 .8 22%

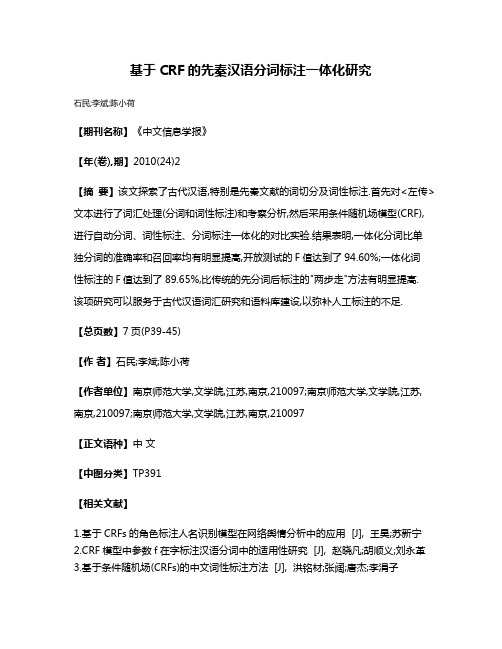

基于CRF的先秦汉语分词标注一体化研究

基于CRF的先秦汉语分词标注一体化研究

石民;李斌;陈小荷

【期刊名称】《中文信息学报》

【年(卷),期】2010(24)2

【摘要】该文探索了古代汉语,特别是先秦文献的词切分及词性标注.首先对<左传>文本进行了词汇处理(分词和词性标注)和考察分析,然后采用条件随机场模型(CRF),进行自动分词、词性标注、分词标注一体化的对比实验.结果表明,一体化分词比单独分词的准确率和召回率均有明显提高,开放测试的F值达到了94.60%;一体化词

性标注的F值达到了89.65%,比传统的先分词后标注的"两步走"方法有明显提高.

该项研究可以服务于古代汉语词汇研究和语料库建设,以弥补人工标注的不足.

【总页数】7页(P39-45)

【作者】石民;李斌;陈小荷

【作者单位】南京师范大学,文学院,江苏,南京,210097;南京师范大学,文学院,江苏,南京,210097;南京师范大学,文学院,江苏,南京,210097

【正文语种】中文

【中图分类】TP391

【相关文献】

1.基于CRFs的角色标注人名识别模型在网络舆情分析中的应用 [J], 王昊;苏新宁

2.CRF模型中参数f在字标注汉语分词中的适用性研究 [J], 赵晓凡;胡顺义;刘永革

3.基于条件随机场(CRFs)的中文词性标注方法 [J], 洪铭材;张阔;唐杰;李涓子

4.基于CRF的古汉语分词标注模型研究 [J], 严顺

5.基于弱标注数据的汉语分词领域移植 [J], 朱运; 李正华; 黄德朋; 张民

因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

征信息 。 同时根据汉语的构 词特点 , 使用 词的后 缀信息 作为 每个词最可能的词性标记 , 然后用该标记标注训练语料库 , 称

特征 , 在标注未登录词时起到了很好的效果 。

为初始标注 , 然后通过规 则学习 的方法 获取新 的规则 。 在 进

洪铭材 硕士生 , 研究方向为信息抽取 、信息检索 ;张 阔 博士生 , 研究方向为信息抽取 、语义网络 ;唐 杰 博士生 , 研究方向为信息 抽取 、语 义网络 、信息集成 ;李涓子 副教授 , 研究方向为自然语言处理 、语 遍历输入数据 序列的 所有 位置 , f (y , x , i)表示 在 i 位

置时各个特征 组成 的特 征向 量 。 于 是 , C RFs 定 义的 条 件概

率分布为

p λ(Y

,

X)=ex p[

λ· F(Y , Z λ(X)

X )]

(2)

其中

Z λ(X)=∑ ex p[ λ· F(y , x)] y

H ON G Ming-Cai Z HA NG K uo T A N G Jie L I Juan-Zi

(K now ledge Engineering Lab , D CS T , Tsin ghua U ni v ., Bei ji ng 100084)

Abstract T his paper presents a new appr oach to par t-of-speech (PO S)tagg ing fo r Chinese tex ts using conditional r andom fields (CRFs).T o take adv antag e of the ability of using a rbitra ry features as input in CRFs , no t o nly contex ts o f

确定 。每个 局部特征可能是一个状 态特征 s(y , x , i), 也可能

是一个转移特征 t(y , y′, x , i), 其中 , y , y′是标 注的结果 标签 ,

x 是一个输入数据序列 , i 是输入序列的某个位置 。 为了表示

统一 , 用

s(y , y′, x , i)=s(y′, x , i)

词性是词 的句 法功 能类 别 。 在各 种 自然 语言 处 理过 程

与它前面的 n 个词有关 , 而与 它后面 的词无 关 。 这个假 设在 中 , 几乎都有一个词性标注的阶段 。 因此 , 词性标注的正确率

词性标注任务中并不 符合 实际 。 最 大熵 模型(M EM M )能够 充分利用词的上下文信息 , 但是存在着“ label bia s”[ 1] 的弱点 。

y

比解码(Viterbi decoding)方法来得到最佳的标注结果序列 。

CRF s 具有很强的推理能力 , 并且 能够使 用复杂 、有 重叠

性和非独立的特征进 行训练 和推理 , 能够 充分地 利用上 下文

信息作为特征 , 还可以任意地添加其他外部特征 , 使得模型能

够获取的信 息非 常丰 富 。 同 时 , CRFs 解决 了最 大熵 模型 中

的“ label bias” 问题 。C RF s 与最大熵模型的本质区别是 :最大

熵模型在每个状态都 有一个 概率模型 , 在 每个状 态转移 时都

要进行归一化 。 如果某 个状态 只有一 个后续 状态 , 那么该 状

态到后续状态 的跳 转概率 即为 1。 这 样 , 不管 输入为 任何 内

容 , 它都 向该后 续状态跳 转 。 而 C RFs 是 在所有 的状态 上建

s(y , x , i)=s(y i , x , i)

t(y , x , i)=

t(yi -1 , yi , x , i) 0

i >1 i =0

来表示所有的状态特征 s 和转移特征 t 。

对于输入数据序列 x 和标 注结 果序列 y , 条件 随机 场 C

的全局特征表示为

F(y , x)∑ f(y , x , i)

大致可以分为 3 类 : ①基于规则的方法 。 基于规则的方法 是最早提出的词性

进行序列数据 的标 注 。 与最 大熵 模型 一样 , C RF s 是 指 数形 标注方法 , 它手工编制包含繁杂的语法和/ 或语义信息的词典

式的模型 , 具有很强的 推理能 力 , 并 且能够 使用复 杂 、有 重叠 和规则系统 。 这种方法 不仅费 时费力 , 而且 带有很 大的主 观

②基于变换的方 法 。 该方 法由 Eric Bill 提 出 , 用于标 注

时不但利用了词的上下文 信息作为 特征 , 而且 充分利 用了训 英语的词性 , 其基本思想是 利用一 个带词 性标注 的语料 库来

练集的统计信息作为特征 , 为兼 类词的 标注提 供了更 多的特 例示实现设计好的模 板 , 从 一个已 标注词 性的语 料库中 统计

计算机科学 2006V ol.33 №.10

基于条件随机场(CRFs)的中文词性标注方法

洪铭材 张 阔 唐 杰 李涓子

(清华大学计算机系知识工程组 北京 100084)

摘 要 本文提出一种基于 CRF s 模型的中文词性标 注方法 。 该 方法利 用 C RF s 模型 能够添 加任意 特征的 优点 , 在

使用词的上下文信息的同时 , 针对兼类词 和未登录词添加了新 的统计 特征 。 在《 人民 日报》 1 月份 语料库 上进行 的封 闭测试和开放测试中 , 该方法的标注准确 率分别为 98 .56%和 96.60 %。

关键词 词性标注 , 条件随机场 , 维特比解码

A Chinese Part-of-speech Tagging Approach Using Conditional Random Fields

· 148 ·

行文本标注时 , 先对文本进行初始标注 , 然后按照规则获取的 次序应用规则进行标注 。 该方法在英文词性标注上取得了很 好的效果 。 其主要问题是学习规则的时间过长 。 针对这一问 题 , 周明等提出一个快速学习算法 , 使训练速度大大提高[ 2] 。

③基于统计的方法 。 基于统计的方法是目前应用最广泛 的词性标注方法 。 白栓虎提出基于统计的汉语词性自动标注 方法 , 使用二元语法模型 和动态 规划的 方法进 行汉语 的词性 标注 。当前 大部分汉语词性系统采用基于二元语法模型或三 元语法模型的隐马尔可夫模型 , 通过 EM 训练的方法 , 给每个 词和词性标签对分配一个 联合概率 , 通 过维特 比解码 的动态 规划方法来获取一个句子对应的最佳的词性标注序列 。 隐马 尔可夫模型的缺点是假设词的词性只与 词本身和它 前面的 n 个词有关 , 而与该词后 面的词 没有关 系 。 这个假 设与实 际情 况并不吻合 。 基于最大熵模 型的词 性标注 方法 , 有效地 利用 了上下文信息 , 在一定的 约束条 件下可 以得到 与训练 数据一 致的概率分布 , 得到了 很好标 注效果 。 但 是最大 熵模型 存在 一种称为“ label bias” 问题 的弱点[ 1] , 在 某些 训练 集上得 到的 模型可能会得到很差的标注效果 。 常见的基于统计的方法还 有神经元网络 、决策树 、线性分离网络标注模型等 。

将直接影响到后续 的分析 处理结 果 。 基于其 很高的 重要性 , 词性标注一直是自然语言处理的 重要内容 。 词性标注的方法

本 文 使 用 条 件 随 机 场 (Co nditional Rando m Fields , C RFs)[ 1] 进行中文的 词性标 注 。 CRF s 通过 建立 概率模 型来

3 CRFs 理论及其训练方法

3.1 CRFs 的定义

给定数据序列随机变量 X , CRF s C 定义了标注结果序列

随机变量 Y 的条件概率 分布 p(Y X), 它 通过训 练的方 法来

使得条件概率 p(Y X)最大 。C RFs 是无向图 模型 , 其最简单

的形式是线性的 CRFs , 即 模型 中各 个节 点之 间构 成线 性结

(彭 , 楚政 , 再 , 获 , 全国 , 民族 , 团结 , 进步 , 模范 , 称 号

。), y 则表示 该句子中每 个词的词 性序列 y =(nr, nr, d , v ,

n, n, a, v , n, n, w)。

对于(X , Y), C 由 局部特征 向量 f 和对 应的权 重向 量 λ

了广泛的应用并取得了很好的效果 。

文章的组织结构如 下 :第 2 节介 绍中文 词性标 注的相 关

在基于统计方法的词性 标注中 , 对兼 类词和 未登录 词的 工作 ;第 3 节阐述 CRF s 理论 及其训 练方法 ;使用 CRFs 进行

标注是两个需要解决的 问题 。 对于 兼类词 , 可以 根据该 词的 中文词性 标注的方 法将在第 4 节中介绍 ;第 5 节是实验 结果

上下文信息来 确定 该词 在句 子中 的唯 一词 性 。 对于 未 登录 和实验分析 ;最后是对本文的概括以及对未来工作的展望 。

词 , 能够获取关于该词的信息相对较少 , 可以根据词的上下文 信息以及词的 构词 特点 来确 定其 词性 。 在 基于 隐马 尔 可夫

2 相关工作

(H M M)模 型的词性标 注方 法中 , 通 常假 设中 心词 的词 性只

词性标注是自然语言处 理的重 要内容 之一 , 是其他 信息 的标注正确率 , 其封 闭测 试和开 放测 试的 准确率 分别 为 98.

处理技术的基础 , 被广 泛地应 用于机 器翻译 、文字 识别 、语音 56%和 96.60 %, 兼类 词和未 登录 词的 标注 也取 得了 很好 的

识别 、信息检索等领域 。 目前基 于统计的 词性标 注方法 得到 结果 。

spectively . Keywords P art-of-speech tag ging , Co nditional r andom fields (CRFs), Viterbi decoding