Spark流式计算-深入理解Spark Streaming-与Storm的对比

利用Spark进行实时大数据处理的最佳实践

利用Spark进行实时大数据处理的最佳实践在当今数字化时代,大数据处理已成为企业不可或缺的一环。

为了满足日益增长的数据处理需求,传统的批处理方式已无法满足实时性和性能的要求。

而Apache Spark作为一个快速、通用、容错且易用的大数据处理引擎,成为了处理实时大数据的最佳实践之一。

Spark提供了丰富的API和内置的组件,可以在实时大数据处理过程中实现高效的数据处理和分析。

以下是利用Spark进行实时大数据处理的最佳实践。

1. 选择合适的集群模式:Spark可以在多种集群模式下运行,包括单机模式、本地模式、独立模式和云模式。

根据数据量和需求,选择合适的集群模式可以提高实时大数据处理的效率和性能。

2. 使用Spark Streaming处理流式数据:Spark Streaming是Spark的一部分,支持从各种数据源(如Kafka、Flume和HDFS)实时接收数据并进行处理。

使用Spark Streaming可以实时处理数据流,并支持窗口和滑动窗口操作,以满足不同的实时数据分析需求。

3. 使用Spark SQL进行结构化数据处理:Spark SQL是Spark的SQL查询引擎,可以通过SQL语句处理结构化数据。

通过使用Spark SQL,可以方便地进行实时查询、过滤和转换操作,以满足实时大数据处理的需求。

4. 使用Spark MLlib进行机器学习:Spark MLlib是Spark的机器学习库,提供了各种机器学习算法和工具,可以在实时大数据处理中应用机器学习。

通过使用Spark MLlib,可以进行实时的数据挖掘和模型训练,帮助企业发现隐藏在大数据中的信息和模式。

5. 使用Spark GraphX进行图处理:Spark GraphX是Spark的图处理库,用于处理大规模的图数据。

通过使用Spark GraphX,可以进行实时的图分析和图计算,帮助企业发现图数据中的关联和模式。

6. 使用Spark Streaming和Spark SQL进行流与批处理的无缝集成:Spark提供了将流处理和批处理无缝集成的能力,可以在同一个应用程序中同时处理实时数据流和批处理数据。

Spark介绍

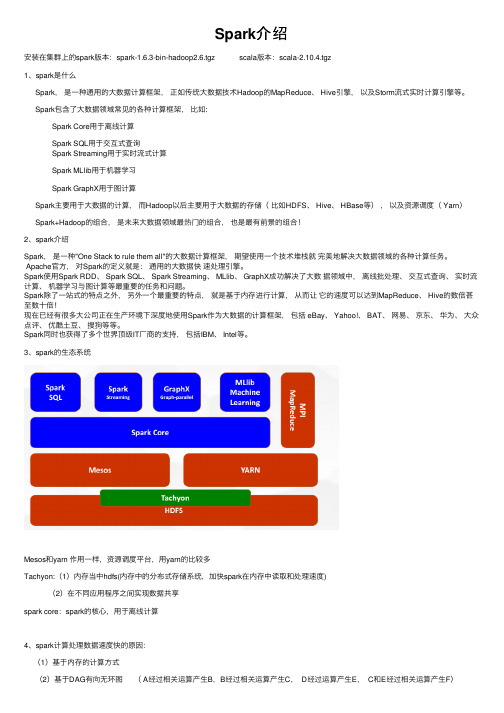

Spark介绍安装在集群上的spark版本:spark-1.6.3-bin-hadoop2.6.tgz scala版本:scala-2.10.4.tgz1、spark是什么Spark,是⼀种通⽤的⼤数据计算框架,正如传统⼤数据技术Hadoop的MapReduce、 Hive引擎,以及Storm流式实时计算引擎等。

Spark包含了⼤数据领域常见的各种计算框架,⽐如:Spark Core⽤于离线计算Spark SQL⽤于交互式查询Spark Streaming⽤于实时流式计算Spark MLlib⽤于机器学习Spark GraphX⽤于图计算Spark主要⽤于⼤数据的计算,⽽Hadoop以后主要⽤于⼤数据的存储(⽐如HDFS、 Hive、 HBase等),以及资源调度( Yarn)Spark+Hadoop的组合,是未来⼤数据领域最热门的组合,也是最有前景的组合!2、spark介绍Spark,是⼀种"One Stack to rule them all"的⼤数据计算框架,期望使⽤⼀个技术堆栈就完美地解决⼤数据领域的各种计算任务。

Apache官⽅,对Spark的定义就是:通⽤的⼤数据快速处理引擎。

Spark使⽤Spark RDD、 Spark SQL、 Spark Streaming、 MLlib、 GraphX成功解决了⼤数据领域中,离线批处理、交互式查询、实时流计算、机器学习与图计算等最重要的任务和问题。

Spark除了⼀站式的特点之外,另外⼀个最重要的特点,就是基于内存进⾏计算,从⽽让它的速度可以达到MapReduce、 Hive的数倍甚⾄数⼗倍!现在已经有很多⼤公司正在⽣产环境下深度地使⽤Spark作为⼤数据的计算框架,包括 eBay、 Yahoo!、 BAT、⽹易、京东、华为、⼤众点评、优酷⼟⾖、搜狗等等。

Spark同时也获得了多个世界顶级IT⼚商的⽀持,包括IBM、 Intel等。

Spark编程基础:Spark-Streaming单元测验与答案

一、单选题1、以下流计算框架中,哪个不是开源的。

()A.IBM StreamBaseB.Twitter StormC.Yahoo! S4D.Spark Streaming正确答案:A2、下面关于Spark Streaming的描述错误的是()。

A.Spark Streaming的基本原理是将实时输入数据流以时间片为单位进行拆分,然后采用Spark引擎以类似批处理的方式处理每个时间片数据B.Spark Streaming最主要的抽象是DStream(Discretized Stream,离散化数据流),表示连续不断的数据流C.Spark Streaming可整合多种输入数据源,如Kafka、Flume、HDFS,甚至是普通的TCP套接字D.Spark Streaming的数据抽象是DataFrame正确答案:D3、下面关于Spark Streaming和Storm的描述正确的是()。

A.Spark Streaming无法实现毫秒级的流计算,而Storm可以实现毫秒级响应B.Spark Streaming可以实现毫秒级的流计算,而Storm无法实现毫秒级响应C.Spark Streaming和Storm都可以实现毫秒级的流计算D.Spark Streaming和Storm都无法实现毫秒级的流计算正确答案:A4、下面描述错误的是()。

A.在RDD编程中需要生成一个SparkContext对象B.在Spark SQL编程中需要生成一个SparkSession对象C.运行一个Spark Streaming程序,就需要首先生成一个StreamingContext对象D.在Spark SQL编程中需要生成一个StreamingContext对象正确答案:D5、下面不属于Spark Streaming基本输入源的是()。

A.文件流B.套接字流C.RDD队列流D.双向数据流正确答案:D二、多选题1、以下关于流数据特征的描述,哪些是正确的。

大数据处理中的实时计算方法

大数据处理中的实时计算方法随着互联网和物联网的发展,大数据的规模和速度都呈现出爆炸式增长的趋势。

如何高效地处理大数据,尤其是实时计算,成为了当今信息技术领域亟需解决的问题之一。

本文将介绍几种常见的大数据处理中的实时计算方法。

一、流式计算(Streaming)流式计算是大数据处理中常用的一种方法,它以连续不断的数据流为基础,实时计算出结果。

流式计算主要有以下特点:1. 实时性高:流式计算可以在数据到达时立即进行处理,实时性较强。

2. 数据流动:流式计算处理的是数据流,数据以流的形式一直向前传递,不需要保存在磁盘或内存中。

3. 有限窗口:流式计算通常采用滑动窗口的方式,将数据按时间段进行划分,计算结果基于窗口内的数据。

二、复杂事件处理(CEP)复杂事件处理是一种基于流式计算的方法,它通过定义规则和模式,从数据流中识别出具有特定含义的事件。

CEP主要有以下特点:1. 实时识别:CEP能够在大规模数据流中实时识别出复杂事件,如异常情况、重要事件等。

2. 事件关系:CEP能够识别事件之间的关系,包括时序关系、逻辑关系等。

3. 规则定义:CEP通过定义规则和模式来识别重要事件,可以快速修改规则以应对不同需求。

三、内存计算(In-Memory Computing)内存计算是指将数据存储在内存中进行计算和处理的方法,相较于传统的硬盘存储,内存计算具有更高的速度和性能表现。

内存计算主要有以下特点:1. 快速响应:内存计算可以使计算速度更快,减少了磁盘IO的开销,提供更快的响应时间。

2. 实时计算:内存计算能够将数据直接加载到内存中,实现实时计算和分析。

3. 分布式处理:内存计算通常采用分布式计算的方式,将计算任务分布到多个节点上进行并行计算,提高处理效率。

四、流式数据集(DataStream)流式数据集是一种结合了流式计算和内存计算的方法,它通过将数据流转化为可操作的数据集合来实现实时计算。

流式数据集主要有以下特点:1. 弹性计算:流式数据集能够根据需求进行弹性计算,灵活调整计算规模。

kafka各个版本特点介绍和总结

kafka各个版本特点介绍和总结kafka各个版本特点介绍和总结1.1 kafka的功能特点:分布式消息队列消息队列的数据模型,形成流式数据。

提供Pub/Sub⽅式的海量消息处理。

以⾼容错的⽅式存储海量数据流。

保证数据流的顺序。

消费者:⼀份消息可多个消费者都处理,也可以只由⼀个消费者处理线性扩展,⾼可⽤分布式系统,易于向外扩展。

所有的producer、broker和consumer都会有多个,均为分布式的。

⽆需停机即可扩展机器。

动态的增加⼀个topic的partition⽂件数量,就可以线性扩展⼀个topic的处理能⼒。

以⾼容错的⽅式存储海量数据流。

每个topic包含多个partition,partiton⼜有多个副本,均匀的分布在多个机器上。

⾼吞吐量:⽣成和消费速度⾮常快1. kafka server ⽣成⽇志的速度可以接近磁盘的只写速度(⼏⼗兆 ~ 百兆)。

kafka的实现思想是⽂件直写(直接使⽤linux ⽂件系统的cache)的commit log. 速度⾮常的快.如果消息⼤⼩为百字节级别的话,那么也就是说单机写⼊可以达到⼏⼗W/S。

2. 磁盘顺序读写3. 采⽤linux Zero-Copy提⾼消息发送到consumer的性能。

减少IO操作步骤;可以提⾼60%的数据发送性能。

1.2 kafka的使⽤场景:kafka的使⽤场景,即kafka的⽤途。

数据总线(数据管道)Kafka主要⽤途是数据集成,或者说是流数据集成,以Pub/Sub形式的消息总线形式提供。

Kafka可以让合适的数据以合适的形式出现在合适的地⽅。

1. 降低系统组⽹复杂度。

2. 降低编程复杂度,各个⼦系统不在是相互协商接⼝,各个⼦系统类似插⼝插在插座上,Kafka承担⾼速数据总线的作⽤。

⽇志收集,⽤户⾏为数据,运维监控数据收集,都可以适合该场景。

海量数据发布/订阅的消息队列实时计算的流式数据源(storm,spark-streaming)离线计算的数据源1. kafka的数据⽂件作为离线计算的数据源。

Spark实践——基于SparkStreaming的实时日志分析系统

Spark实践——基于SparkStreaming的实时⽇志分析系统本⽂基于《Spark 最佳实践》第6章 Spark 流式计算。

我们知道⽹站⽤户访问流量是不间断的,基于⽹站的访问⽇志,即 Web log 分析是典型的流式实时计算应⽤场景。

⽐如百度统计,它可以做流量分析、来源分析、⽹站分析、转化分析。

另外还有特定场景分析,⽐如安全分析,⽤来识别 CC 攻击、 SQL 注⼊分析、脱库等。

这⾥我们简单实现⼀个类似于百度分析的系统。

1.模拟⽣成 web log 记录在⽇志中,每⾏代表⼀条访问记录,典型格式如下:分别代表:访问 ip,时间戳,访问页⾯,响应状态,搜索引擎索引,访问 Agent。

简单模拟⼀下数据收集和发送的环节,⽤⼀个 Python 脚本随机⽣成 Nginx 访问⽇志,为了⽅便起见,不使⽤ HDFS,使⽤单机⽂件系统。

⾸先,新建⽂件夹⽤于存放⽇志⽂件然后,使⽤ Python 脚本随机⽣成 Nginx 访问⽇志,并为脚本设置执⾏权限, 代码见设置可执⾏权限的⽅法如下之后,编写 bash 脚本,⾃动⽣成⽇志记录,并赋予可执⾏权限,代码见赋予权限执⾏ genLog.sh 查看效果,输⼊ ctrl+c 终⽌。

2.流式分析创建 Scala 脚本,代码见3.执⾏同时开启两个终端,分别执⾏ genLog.sh ⽣成⽇志⽂件和执⾏ WebLogAnalyse.scala 脚本进⾏流式分析。

执⾏ genLog.sh执⾏ WebLogAnalyse.scala, 使⽤ spark-shell 执⾏ scala 脚本效果如下,左边是 WebLogAnalyse.scala,右边是 genLog.sh。

大数据导论思维第10章 大数据实时流计算 Spark Streaming

后还可以将处理结果存储到文件系统,数据库和现场仪表盘。

Spark Streaming 数据流:

Kafka

Flume HDFS/S3 Kinesis

Spark Streaming

HDFS Databases Dashboards

概述

Spark Streaming 工作原理: ① 接收实时的输入数据流 ② 根据一定的时间间隔(比如1秒钟)拆分成一批批的数据 ③ 然后通过Spark引擎处理这些批数据 ④ 最终得到处理后的一批批结果数据

resourcBiblioteka sstatic scheduling of continuous operators to nodes can cause bottlenecks

dynamic scheduling of tasks ensures even distribution of load

动态负载均衡

Spark系统将数据划分为小批量,允许对资源进行细粒度分配。 例如: 当输入数据流需要由一个键值来分区处理。

Input data Stream

Spark Streaming

Batches of Input data

Spark Engine

Batches of Processed data

概述

Spark Streaming支持一个高层的抽象,叫做离散流(Discretized Stream)或者DStream,它代表连续的数据流。 在内部,DStream是由一系列RDD组成。对应的批数据,在Spark内核 对应一个RDD 实例。因此,对应流数据的DStream可以看成是一组 RDD,即RDD的一个序列。

Spark大数据技术与应用 第6章 Spark Streaming:实时计算框架

描述

源DStream的每个元素通过函数func返回一个新的DStream

类似map操作,不同的是每个元素可以被映射出0或者更多的输出元素 对源DStream中的每一个元素应用func方法进行计算,如果func函数返回结 果为true,则保留该元素,否则丢弃该元素,返回一个新的Dstream 合并两个DStream,生成一个包含两个DStream中所有元素的新DStream对 象 统计DStream中每个RDD包含的元素的个数,得到一个新的DStream 使用func将源DStream中的每个元素进行聚合操作,返回一个内部所包含的 RDD只有一个元素的新DStream

TCP sockets ➢ 不仅可以通过调用map,reduce,join和window等API函数来处理数据,

也可以使用机器学习、图算法来处理数据 ➢ 最终结果可以保存在文件系统、数据库或者实时Dashboard展示

3

初探Spark Streaming

Spark Streaming运行原理

Spark Streaming的输入数据按照时间片(batch size)分成一段 一段的数据,得到批数据(batch data),每一段数据都转换成 Spark中的RDD,然后将Spark Streaming中对DStream的 Transformation操作变为针对Spark中的RDD的Transformation 操作,将RDD经过操作变成中间结果保存在内存中。整个流式计 算根据业务的需求可以对中间的结果进行叠加或者存储到外部设 备。

DStream的操作可以通过RDD的Transformation生成新的DStream。

Байду номын сангаас13

掌握DStream编程模型

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

的,无法做更精细地控制。比如,调度周期1秒请可在能此已输入经文达本到请极在限此输了入,文更本小

的周期意义已经不大。

请在此输入文本请在此输入文本

6

与Storm的对比

• 数据的可靠性也是以批次为粒度的,但好处也很明显,就是有可能实现更大 的吞吐量。另外,得益于Spark平台的良好整合性,完成相同任务的流式计

核心还支持Python、Ruby等其他语言

分布式、容错、可扩展

10

性能测试视硬件、网络、程序等多方因素而定请,在无此法输直接入对文比本,请这里在只此是输引入文本

用一些公开的数据:

请在此输入文本请在此输入文本

Spark Streaming:40万记录/秒/节点

Storm:100万/秒/节点

Scala

Clojure

Scala、Java、Python

Trident 只 支 持 Clojure 、 Java 、 Scala ,

算程序与历史批量处理程序的代码基本相同,添而且加还标可题以使用平台上的其他

模块比如SQL、机器学习、图计算的计算能力,请在在开此输发入效文率本上请占在此有输优入势文。本

请在此输入文本请在此输入文本 请在此输入文本请在此输入文本

7

与Storm的对比

• 而Storm的核心数据抽象是tuple,是命名的值列表,相当于消息,不是分布

• 下表是两者的详细对比,仅供参考。

表 Spark Streaming与Storm对比

计算模型 实时性 数据可靠性

性能

实现语言 编程语言 相同点

Spark Streaming

Storm

小批量计算

实时数据流计理一次

添加标题 核心支持最少一次或最多一次;

T精ri确de一n请t支次在持此全部输最入少文一本次请、最在多此一输次入、文本

添加标题

请在此输入文本请在此输入文本 请在此输入文本请在此输入文本 请在此输入文本请在此输入文本

3

与Storm的对比

添加标题

请在此输入文本请在此输入文本 请在此输入文本请在此输入文本 请在此输入文本请在此输入文本

4

与Storm的对比

• 大体上两者非常接近,而且都处于快速迭代过程中,即便一时的对比可能某 一方占优势,但后者可能很快就追赶上来。比如在性能方面,Spark Streaming刚发布不久,有基准测试显示性能超过Storm几十倍,原因是Spark

5

与Storm的对比

• 但是两者的基因不同,更具体地说就是核心数据抽象不同。这是无法改变的,

而且也不会轻易改变,这样的基因也决定了它们各自最适合的应用场景。前

面已经讲过,Spark Streaming的核心抽象是DSTream,里面是RDD,下层是

Spark核心DAG调度,所以Spark Streaming的这一添基加因标决题定了其粒度是小批量

Streaming采用了小批量模式,而Storm是一条消添息加一标条消题息地计算。但后来

请在此输入文本请在此输入文本

Storm也推出了称为Trident的小批量计算模式,请性在能此应输该入文不本是请差在距此了输入。文而本且 双方都在持续更新,底层的一个通信框架的更新请在或此者输某入个文路本请径在的此代输码入优文本化都 可能让性能有较大的提升。

持各类数据源,基本可以实现流式计算的功能,添但加延标时题无法进一步缩短了。

请在此输入文本请在此输入文本

但Storm的设计初衷就是实时计算,毫秒级的计请算在当此然输不入文在本话请下在,此而输入且文后本期 通过更高级别的Trident也实现了小批次处理功能请。在此输入文本请在此输入文本

9

与Storm的对比

Spark流式计算-深入理解 Spark Streaming-与 Storm的对比

1

与Storm的对比

• Spark一直是后来者,在批处理领域出现在Hadoop MR之后,但凭

借优秀的性能表现大有超越之势。它在流式计算领域也是后来者,

在Spark Streaming出现之前,业界已经有添了加St标or题m并且应用广泛,

式的,所以Storm更擅长细粒度的消息级别的控制,比如延时可以实现毫秒

级,数据可靠性也是以消息为粒度的。

添加标题

请在此输入文本请在此输入文本

请在此输入文本请在此输入文本

请在此输入文本请在此输入文本

8

与Storm的对比

• 核心数据抽象的不同导致了它们在计算模式上的本质区别。Spark Streaming 在本质上其实是像MR一样的批处理计算,但将批处理的周期从常规的几十 分钟级别尽可能缩短至秒级,也算达到了实时计算的延时指标。而且,它支

Storm在2014年9月从0.9.1版本开始正式成请在为此A输p入ac文he本旗请在下此的输顶入文级本项

请在此输入文本请在此输入文本

目。

请在此输入文本请在此输入文本

2

与Storm的对比

• Storm是开源免费的分布式实时计算系统, 可以简单、实时、可靠地处理海量的数据 流,具有高性能、可扩展、自动容错、确 保数据不丢失等特性。它支持非常多的语 言,可以应用在实时分析、在线实时机器 学习、分布式RPC、ETL等众多领域,其结 构如右图所示。