数据压缩与信源编码第3讲霍夫曼编码

霍夫曼编码在数据压缩中的应用

10级电子信息工程《信息论与编码技术》学习报告霍夫曼编码在数据压缩中的应用姓名学号班级成绩2012年11月现代社会是信息社会,我们无时无刻都在跟信息打交道,如上网查阅图文资料,浏览最新的新闻,QQ聊天或者传送文件等。

人类对信息的要求越来越丰富,希望无论何时何地都能够方便、快捷、灵活地通过文字、语音、图像以及视频等多媒体进行通信。

在早期的通信领域中,能够处理和传输的主要是文字和声音,因此,早期的计算机和通信设备的处理能力跟人类的需求有相当大的差距。

随着通信信道及计算机容量和速度的提高,如今信息已成为通信领域市场的热点之一。

可是,大数据量的信息会给存储器的存储容量、通信干线信道的宽度以及计算机的处理速度增加极大的压力。

单纯依靠增加存储器容量、提高通信网络带宽和计算机处理速度来解决问题,在技术和经济上都不太现实。

显然,在信道宽度、通信链路容量一定的前提下,采用编码压缩技术、减少传输数据量,是提高通信速度的重要手段。

在信息化高度发达的当今社会,我们必须对信息的传递有着较高的要求,我们希望信息在传递的过程中,能够保持节省性、保密性、无损性和高效性,而著名的霍夫曼编码就能够达到这样的要求。

因此研究霍夫曼编码对信息的压缩就是相当有必要的。

一、霍夫曼编码简介霍夫曼编码是一种可变字长编码的方式。

霍夫曼于1952年提出这种编码方法,该方法完全依据字符出现概率来构造异字头的平均长度最短的的码字,是一种构造最佳码的方法。

霍夫曼编码的码长是变化的,对于出现频率高的信息,编码的长度较短;而对于出现频率低的信息,编码长度较长。

这样,处理全部信息的总码长一定小于实际信息的符号长度。

霍夫曼编码是一种根据字母的使用频率而设计的变长码,能提高信息的传输效率,至今仍有广泛的应用。

霍夫曼编码方法的具体过程是:1、首先把信源的各个输出符号序列按概率递降的顺序排列起来,求其中概率最小的两个序列的概率之和,并把这个概率之和看做是一个符号序列的概率,再与其他序列依概率递降顺序排列(参与求概率之和的这两个序列不再出现在新的排列之中);2、然后,对参与概率求和的两个符号序列分别赋予二进制数字0和1。

c语言实现霍夫曼编码 概述及解释说明

c语言实现霍夫曼编码概述及解释说明1. 引言1.1 概述本篇长文主要介绍了C语言如何实现霍夫曼编码。

霍夫曼编码是一种广泛应用于信息压缩领域的算法,通过利用字符出现频率的统计信息,能够将常见字符用较短的二进制串来表示,从而实现数据的高效压缩和传输。

文章将详细说明霍夫曼编码的基本原理,以及在C语言中实施该算法所需的步骤和思路。

1.2 文章结构本文按照以下结构来组织内容:第一部分为引言部分,对文章进行概述并介绍文章结构;第二部分将介绍霍夫曼编码的基本原理,包括信息压缩与编码的关系、霍夫曼编码的定义以及构建霍夫曼树的过程;第三部分详细说明了在C语言中实现霍夫曼编码所需的算法思路和步骤,包括文本文件的读取与处理、统计字符频率并构造优先队列、构建霍夫曼树及生成编码表等;第四部分给出了示例代码演示,在这一部分中我们提供了完整的C语言实现代码示例,并解释了样例文件的压缩与解压缩过程;最后一部分是结论与讨论,我们将探讨霍夫曼编码在信息压缩中的应用价值,并对C语言实现霍夫曼编码的工作进行总结和展望。

1.3 目的本文的目的是帮助读者理解霍夫曼编码算法及其在C语言中的实现。

通过阅读本文,读者将能够掌握如何使用C语言来处理文本文件、统计字符频率并构建优先队列、构建霍夫曼树以及生成对应的编码表。

同时,本文还将探讨霍夫曼编码在信息压缩中的应用价值,并对C语言实现霍夫曼编码进行总结和展望。

2. 霍夫曼编码的基本原理2.1 信息压缩与编码霍夫曼编码是一种常用的无损数据压缩算法,通过对不同字符赋予不同的可变长度编码来达到有效压缩数据的目的。

在信息压缩中,我们希望用更少的位数来表示出现频率较高的字符,而用更多的位数来表示出现频率较低的字符,从而减小整个消息占用的存储空间。

2.2 霍夫曼编码的定义霍夫曼编码是一种前缀编码,即没有一个字符是另一个字符编码序列的前缀。

这确保了在解析编码时不会存在歧义。

根据霍夫曼编码规则,出现频率较低的字符使用比较长的二进制串来表示,而出现频率较高的字符则使用较短的二进制串进行表示。

Huffman编码压缩效率分析

Huffman编码压缩效率分析Huffman编码是一种常用的数据压缩算法,通过使用变长编码来对不同符号进行表示,使得出现频率高的符号可以使用较短的编码,而出现频率低的符号则可以使用较长的编码,以此来实现数据压缩的效果。

本文将就Huffman编码的压缩效率进行深入分析。

一、Huffman编码的原理Huffman编码的压缩效率是建立在理解其原理的基础之上的。

Huffman编码的原理是通过构建霍夫曼树来实现,具体步骤如下:1. 统计输入数据中各个符号的出现频率;2. 将所有的符号按照出现频率构建为叶子节点,生成一个森林;3. 重复以下步骤,直到所有节点都合并为一个根节点:a. 从森林中选择出现频率最小的两个节点,合并为一个新节点;b. 将新节点放回森林中;4. 根据生成的霍夫曼树,给每个符号赋予唯一的编码;5. 将原始数据根据所生成的编码进行替换;6. 按照编码后的位数进行数据压缩。

二、Huffman编码的压缩效率Huffman编码作为一种无损压缩算法,其压缩效率取决于输入数据中各个符号的出现频率。

出现频率越高的符号所得到的编码越短,从而可以实现更高的压缩效率。

为了更直观地了解Huffman编码的压缩效率,我们可以通过一个简单的例子来进行说明。

假设输入数据包含以下4个符号A、B、C、D,并且它们的出现频率分别为0.4、0.3、0.2、0.1。

根据Huffman编码的原理,我们可以得到如下的霍夫曼树:```A: 0.4/ \B: 0.3/ \C: 0.2/ \D: 0.1```根据霍夫曼树给符号赋予编码,我们可以得到编码表如下:A: 0B: 10C: 110D: 111假设输入数据为"AABCD",根据编码表替换后,数据变为"00110111",可以看出编码后的数据长度为8位,相比原始数据的长度为5位进行了压缩。

通过以上例子可以看出,Huffman编码通过根据出现频率来给符号赋予编码,使得出现频率高的符号获得较短的编码,从而实现数据的压缩。

哈夫曼编码在数据压缩中的应用

哈夫曼编码在数据压缩中的应用哈夫曼编码是一种常用的数据压缩算法,广泛应用于通信、存储和传输等领域。

它以最小的存储空间来表示高频出现的字符,从而实现对数据的高效压缩。

本文将介绍哈夫曼编码的原理和应用,并探讨其在数据压缩中的重要性。

一、哈夫曼编码原理哈夫曼编码是一种无损压缩算法,它通过构建哈夫曼树来实现对数据的编码和解码。

其基本原理是将频率较高的字符用较短的编码表示,而频率较低的字符则用较长的编码表示,从而实现对数据的压缩。

具体实现时,哈夫曼编码通过以下几个步骤来完成:1. 统计字符出现的频率。

2. 根据字符的频率构建一个哈夫曼树。

3. 根据哈夫曼树的结构,为每个字符分配相应的二进制编码。

4. 将原始数据转换为对应的哈夫曼编码。

5. 将编码后的数据存储或传输。

二、哈夫曼编码的应用1. 数据压缩哈夫曼编码在数据压缩中广泛应用。

通过使用最短的编码来表示高频字符,可以大大减小数据的存储空间和传输带宽。

尤其在图像、音频、视频等大数据文件的传输和存储中,哈夫曼编码可以有效地降低数据的体积。

2. 文件压缩与解压哈夫曼编码常被用于文件压缩和解压缩。

在压缩文件时,通过对文件中的字符进行编码,可以减小文件的大小,使其更容易存储和传输。

而在解压缩时,通过对哈夫曼编码进行解码,可以还原成原始的文件内容。

3. 数据传输与存储哈夫曼编码在数据传输和存储中也起到重要的作用。

在数据传输中,由于带宽的限制,通过对数据进行压缩可以提高传输效率。

而在数据存储中,通过对数据进行压缩可以节省存储空间,提高存储效率。

三、哈夫曼编码的优势相比其他压缩算法,哈夫曼编码有以下优势:1. 哈夫曼编码是一种无损压缩算法,不会丢失原始数据的任何信息。

2. 哈夫曼编码可以根据不同字符的频率分配不同长度的编码,使得高频字符的编码长度更短,从而提高压缩效率。

3. 哈夫曼编码可以根据具体应用场景进行定制,使其更好地适应不同数据的特点,提高压缩率。

四、总结哈夫曼编码在数据压缩中扮演着重要的角色,它通过构建哈夫曼树和分配不同长度的编码,实现对数据的高效压缩。

Huffman编码原理简介

以下是Huffman编码原理简介:霍夫曼(Huffman)编码是1952年为文本文件而建立,是一种统计编码。

属于无损压缩编码。

霍夫曼编码的码长是变化的,对于出现频率高的信息,编码的长度较短;而对于出现频率低的信息,编码长度较长。

这样,处理全部信息的总码长一定小于实际信息的符号长度。

对于学多媒体的同学来说,需要知道Huffman编码过程的几个步骤:l)将信号源的符号按照出现概率递减的顺序排列。

(注意,一定要递减)2)将最下面的两个最小出现概率进行合并相加,得到的结果作为新符号的出现概率。

3)重复进行步骤1和2直到概率相加的结果等于1为止。

4)在合并运算时,概率大的符号用编码0表示,概率小的符号用编码1表示。

5)记录下概率为1处到当前信号源符号之间的0,l序列,从而得到每个符号的编码。

下面我举个简单例子:一串信号源S={s1,s2,s3,s4,s5}对应概率为p={40,30,15,10,5},(百分率)按照递减的格式排列概率后,根据第二步,会得到一个新的概率列表,依然按照递减排列,注意:如果遇到相同概率,合并后的概率放在下面!最后概率最大的编码为0,最小的编码为1。

如图所示:所以,编码结果为s1=1s2=00s3=010s4=0110s5=0111霍夫曼编码具有如下特点:1) 编出来的码都是异字头码,保证了码的唯一可译性。

2) 由于编码长度可变。

因此译码时间较长,使得霍夫曼编码的压缩与还原相当费时。

3) 编码长度不统一,硬件实现有难度。

4) 对不同信号源的编码效率不同,当信号源的符号概率为2的负幂次方时,达到100%的编码效率;若信号源符号的概率相等,则编码效率最低。

5) 由于0与1的指定是任意的,故由上述过程编出的最佳码不是唯一的,但其平均码长是一样的,故不影响编码效率与数据压缩性能。

霍夫曼编码的C语言实现#include <stdio.h>#include <malloc.h>#include <conio.h>#include <string.h>#include <stdlib.h>#define HuffmanTree HF#define HuffmanCode HMCtypedef struct{unsigned int weight;unsigned int parent,lchild,rchild;} HTNode,*HF;typedef char **HMC;typedef struct {unsigned int s1;unsigned int s2;} MinCode;void Error(char *message);HMC HuffmanCoding(HF HT,HMC HC,unsigned int *w,unsigned int n); MinCode Select(HF HT,unsigned int n);void Error(char *message){fprintf(stderr,"Error:%s\n",message);exit(1);}HMC HuffmanCoding(HF HT,HMC HC,unsigned int *w,unsigned int n) {unsigned int i,s1=0,s2=0;HF p;char *cd;unsigned int f,c,start,m;MinCode min;if(n<=1) Error("Code too small!");m=2*n-1;HT=(HF)malloc((m+1)*sizeof(HTNode));for(p=HT,i=0;i<=n;i++,p++,w++){p->weight=*w;p->parent=0;p->lchild=0;p->rchild=0;}for(;i<=m;i++,p++){p->weight=0;p->parent=0;p->lchild=0;p->rchild=0;}for(i=n+1;i<=m;i++){min=Select(HT,i-1);s1=min.s1;s2=min.s2;HT[s1].parent=i;HT[s2].parent=i;HT[i].rchild=s2;HT[i].weight=HT[s1].weight+HT[s2].weight;}printf("HT List:\n");printf("Number\t\tweight\t\tparent\t\tlchild\t\trchild\n"); for(i=1;i<=m;i++)printf("%d\t\t%d\t\t%d\t\t%d\t\t%d\n",i,HT[i].weight,HT[i].parent,HT[i].lchild,HT[i].rchild); HC=(HMC)malloc((n+1)*sizeof(char *));cd=(char *)malloc(n*sizeof(char *));cd[n-1]='\0';for(i=1;i<=n;i++){start=n-1;for(c=i,f=HT[i].parent;f!=0;c=f,f=HT[f].parent)if(HT[f].lchild==c) cd[--start]='0';else cd[--start]='1';HC[i]=(char *)malloc((n-start)*sizeof(char *));strcpy(HC[i],&cd[start]);}free(cd);return HC;}void main(){MinCode Select(HF HT,unsigned int n);HF HT=NULL;HuffmanCode HC=NULL;unsigned int *w=NULL;printf("请输入节点数n:");scanf("%d",&n);w=(unsigned int *)malloc((n+1)*sizeof(unsigned int *)); w[0]=0;printf("请输入权重:\n");for(i=1;i<=n;i++){printf("w[%d]=",i);scanf("%d",&w[i]);}HC=HuffmanCoding(HT,HC,w,n);printf("HMC:\n");printf("Number\t\tWeight\t\tCode\n");for(i=1;i<=n;i++)printf("%d\t\t%d\t\t%s\n",i,w[i],HC[i]);}MinCode Select(HF HT,unsigned int n){unsigned int min,secmin;unsigned int temp;unsigned int i,s1,s2,tempi;MinCode code;s1=1;s2=1;for(i=1;i<=n;i++)if(HT[i].parent==0){min=HT[i].weight;s1=i;break;}tempi=i++;for(;i<=n;i++)if(HT[i].weight<min&&HT[i].parent==0){min=HT[i].weight;s1=i;}for(i=tempi;i<=n;i++)if(HT[i].parent==0&&i!=s1){secmin=HT[i].weight;s2=i;break;}for(i=1;i<=n;i++)if(HT[i].weight<secmin&&i!=s1&&HT[i].parent==0) {secmin=HT[i].weight;s2=i;}if(s1>s2){temp=s1;s1=s2;s2=temp;}code.s1=s1;code.s2=s2;return code;}。

霍夫曼编码压缩率

霍夫曼编码压缩率霍夫曼编码压缩率:原理、计算方法与应用引言:在当今信息爆炸的时代,数据的传输和存储已经成为了我们生活中不可或缺的一部分。

然而,随着大数据和互联网的快速发展,数据量的增加也带来了挑战,因为大量的数据会占据大量的存储空间和带宽资源。

因此,如何在节省存储空间和减少数据传输时间的基础上保证数据的完整性和准确性成为了一个新的问题。

其中一种解决方案就是使用压缩算法来减小数据的大小。

本文将重点讨论一种常用的压缩算法——霍夫曼编码算法,以及如何计算霍夫曼编码的压缩率。

一、霍夫曼编码的原理霍夫曼编码是由霍夫曼(David A. Huffman)于1952年提出的一种可变字长编码方法,它是一种前缀编码技术。

它的思想非常简单,即为每个待编码的符号(通常是字符)分配一个唯一的二进制码字,使得位数较多的码字分配给出现频率较低的符号,位数较少的码字分配给出现频率较高的符号。

这样做的好处是可以通过调整不同符号的编码长度来最大限度地减少编码后的文件大小。

二、如何计算霍夫曼编码的压缩率下面将介绍计算霍夫曼编码的压缩率的方法:1. 统计字符频率:首先需要对待压缩的数据进行字符频率的统计。

字符频率是指在待压缩的数据中每个字符出现的次数。

可以通过扫描整个待压缩的数据,统计每个字符出现的次数来得到字符频率表。

2. 构建霍夫曼树:根据字符频率表,可以构建一棵霍夫曼树。

霍夫曼树的构建过程是将字符按照频率从小到大进行排序,然后每次选取频率最小的两个字符节点,将它们合并成一个新的节点,该新节点的频率是选取的两个节点的频率之和。

重复这个过程,直到所有的字符节点都被合并成一个根节点为止。

3. 霍夫曼编码:通过遍历霍夫曼树,可以得到每个字符对应的霍夫曼编码。

在遍历过程中,左侧路径记为0,右侧路径记为1。

当遍历到叶子节点时,即可得到该字符对应的霍夫曼编码。

将每个字符及其对应的霍夫曼编码存储在编码表中。

4. 计算压缩率:在进行霍夫曼编码后,可以计算原始数据和编码后的数据的大小。

无失真信源编码之霍夫曼编码

0 1

三、霍夫曼编码优缺点 优点:

霍夫曼编码效率高, 1 , 常用于文 件传真, 语音处理和图象处理的数据压 缩。

Page 14

不足之处:

(1)霍夫曼编码没有错误纠正能力,一般只 能适合于低噪声优质信道中传输。 (2)霍夫曼编码硬件实现较复杂,且需要根 据实际通信系统特性设计合适的缓冲寄存器。 (3)霍夫曼编码是概率匹配编码,需预先知 道信源的概率分布。

Page 15

谢谢各位!

信息理论与编码

无失真信源编码 ——游程编码

工程技术学院 电气与电子信息系 郭堃

课程简介

寻找通信过程中的共同规律,以提高 通信的有效性、可靠性和保密性,使通信

系统达到最优化。

Page 2

本次课内容概要

无失真信源编码 霍夫曼编码

1、编码过程及码树的构造 2、霍夫曼编码效率 3、多元霍夫曼编码

霍夫曼编码优缺点

二元huffman码的编码步骤2将码符号01分配给两个最小概率的信源符号并将其概率值合并成为一个信源符号3再重新排序分配01重复步骤2直至最后剩下两个信源01000001000114从树根到叶子节点顺序写出树枝编码即可的到相应编码page100011001000001信源符号码元page11满足式才能充分利用短码信源缩减次数若不满足则需增加每次合并时信源符号减少的数量page12huffman033032031030020100page13霍夫曼编码效率高常用于文件传真语音处理和图象处理的数据压优点

S1

01 000 0010 0011

s1 0.4

0

1

s2 0.2

0 1

s3 0.2

0

1

s4

s5

P( s i )

哈夫曼编码1952年Huffma...

第三章多媒体数据压缩3.1 数据压缩的基本原理和方法3.1 数据压缩的基本原理和方法•压缩的必要性音频、视频的数据量很大,如果不进行处理,计算机系统几乎无法对它进行存取和交换。

例如,一幅具有中等分辨率(640×480)的真彩色图像(24b/像素),它的数据量约为7.37Mb/帧,一个100MB(Byte)的硬盘只能存放约100帧图像。

若要达到每秒25帧的全动态显示要求,每秒所需的数据量为184Mb,而且要求系统的数据传输率必须达到184Mb/s。

对于声音也是如此,若采用16b样值的PCM编码,采样速率选为44.1kHZ ,则双声道立体声声音每秒将有176KB的数据量。

3.1 数据压缩的基本原理和方法•视频、图像、声音有很大的压缩潜力信息论认为:若信源编码的熵大于信源的实际熵,该信源中一定存在冗余度。

原始信源的数据存在着很多冗余度:空间冗余、时间冗余、视觉冗余、听觉冗余等。

3.1.1 数据冗余的类型•空间冗余:在同一幅图像中,规则物体和规则背景的表面物理特性具有相关性,这些相关性的光成像结果在数字化图像中就表现为数据冗余。

–一幅图象中同一种颜色不止一个象素点,若相邻的象素点的值相同,象素点间(水平、垂直)有冗余。

–当图象的一部分包含占主要地位的垂直的源对象时,相邻线间存在冗余。

3.1.1 数据冗余的类型•时间冗余:时间冗余反映在图像序列中就是相邻帧图像之间有较大的相关性,一帧图像中的某物体或场景可以由其它帧图像中的物体或场景重构出来。

–音频的前后样值之间也同样有时间冗余。

–若图象稳定或只有轻微的改变,运动序列帧间存在冗余。

3.1.1 数据冗余的类型•信息熵冗余:信源编码时,当分配给第i 个码元类的比特数b (y i )=-log p i ,才能使编码后单位数据量等于其信源熵,即达到其压缩极限。

但实际中各码元类的先验概率很难预知,比特分配不能达到最佳。

实际单位数据量d>H (S ),即存在信息冗余熵。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

建立码树/码表

恢复码树/码表

传送码表

接收压缩码流

编码-传送压缩码流

解码-恢复原码

编码结束

解码结束

Huffman编码编程

编码开始 对原始数据出现次数进行统计,将次 数存储在数组counter中。 概率统计

a2(0.4) a4

’(0.2)

符号 编码3

a1 10

a2 00

a3 11

a4 010

a5 011

最小方差Huffman编码算法

符号 编码1

编码2 编码3

a1 10

01 10

a2 0

1 00

a3 110

001 11

a4 1110

0001 010

a5 1111

0000 011

Huffman编码1和2码字长度在1~4之间,码长方差较大, 编码3的码字长度在2~3之间,码长方差较小。 为什么码长方差小的编码最佳? 对于一定速率的信源,例如1000symbol/秒, Huffman编 码平均码长为2.2bits,则平均编码码流输出为2200bit/秒, 假定信道带宽为2200bit/秒,能够满足传输要求。

最小方差Huffman编码算法

符号 编码1

编码2 编码3

a1 10

01 10

a2 0

1 00

a3 110

001 11

a4 1110

0001 010

a5 1111

0000 011

对于一定速率的信源,例如1000symbol/秒, Huffman编 码平均码长为2.2bits,则平均编码码流输出为2200bit/秒, 假定信道带宽为2200bit/秒,能够满足传输要求。 如果信源连续输出a2,则编码1码流输出为1000bit/秒,浪 费信道带宽。 如果信源连续输出a5,则编码1码流输出为4000bit/秒,信 道带宽又不足。

Huffman编码算法

符号 概率 Huffman编 码 定长码 a1 0.2 10 000 a2 0.4 0 001 a3 0.2 110 010 a4 0.1 1110 011 a5 0.1 1111 100

Huffman编码平均码长 =0.2*2+0.4*1+0.2*3+0.1*4+0.1*4=2.2bits 如果使用定长码,每个符号需要3bits,Huffman编码平均 每符号节约0.8bits,压缩比3:2.2=1.36倍。

0000 011

2200bit/s 1,1 1,1 1,1 1,1 1,1

最小方差Huffman编码算法

符号 编码1

编码2 编码3

a1 10

01 10

a2 0

1 00

a3 110

001 11

a4 1110

0001 010

a5 1111

0000 011

如果信源连续输出a2,则编码1码流输出为1000bit/秒,浪 费信道带宽。 如果信源连续输出a5,则编码1码流输出为4000bit/秒,信 道带宽又不足。 编码的码长方差越大,缓冲必须越大; 编码的码长方差越小,缓冲可以越小; 因此,最佳的Huffman编码为最小方差Huffman编码。

0.6

1 0.4 1

0 a3

0

a4 Huffman编码树

0.2 1 a5

Huffman编码算法

符号 概率 Huffman编 码 a1 0.2 10 a2 0.4 0 a3 0.2 110 a4 0.1 1110 a5 0.1 1111

Huffman编码平均码长 =0.2*2+0.4*1+0.2*3+0.1*4+0.1*4=2.2bits 信源的熵 H ( A) P(ai )i(ai ) P(ai ) log P(ai ) 2.122bit / symbol Huffman编码冗余度=Huffman编码平均码长-信源的熵 =0.078bits/symbol Huffman编码没有达到压缩能力的极限,仍存在继续压缩 的可能。

a5 0.1

0 1 a2’(1.0)

0 1

a3

’(0.4)

符号 Huffman 编码

a1 10

a2 0

a3 110

a4 1110

a5 1111

Huffman编码算法

符号 Huffman 编码 a1 10 a2 0 a3 110 a4 1110 a5 1111

编码示例: 信源输出符号序列a1,a2,a3,a4,a5,a2,a1,a2 Huffman编码输出为100110111011110100

Huffman编码算法

符号 概率

a2(0.4) a1(0.2) a3(0.2) a4(0.1) a5(0.1) 0 1

a1 0.2

a2(0.4) a1(0.2) a3(0.2) a4’(0.2)

a2 0.4

a2(0.4)

a3 0.2

0 a1(0.2)

a4 0.1

a2(0.4) 1 a1

‘(0.6)

1 00

110

001 11

1110

0001 010

1111

0000 011

Huffman编码的码长虽然是可变的,但却不需要另外附加同 步代码。 例如,10011011101111按照编码1可解释为a1a2a3a4a5。 又如,100011010011按照编码3可解释为a1a2a3a4a5。

规范Huffman码字

a5 0.05

1 0 a2’(1.0)

1 0

a3

’(0.4)

霍夫曼编码中0和1的分配是任意的

a1 a2 a3 a4 a5

符号

编码1

编码2

10

01

0

1

110

001

1110

0001

1111

0000

Huffman编码算法

符号 概率

a2(0.4) a1(0.2) a3(0.2) a4(0.1) a5(0.1) 1 0

Huffman编码特点

符号 a1 a2 a3 a4 a5

编码1

编码2 编码3

10

01 10

0

1 00

110

001 11

1110

0001 010

1111

0000 011

哈夫曼编码方法构造出来的码不是惟一的。

Huffman编码特点

符号 a1 a2 a3 a4 a5

编码1

编码2 编码3

10

01 10

0

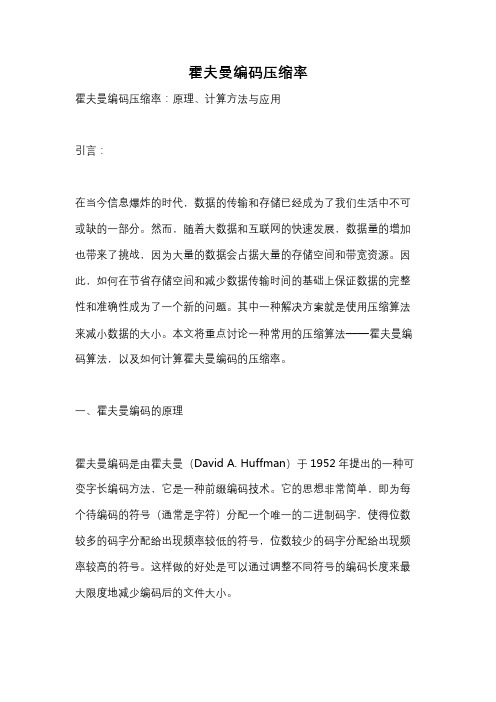

规范的Huffman码字这样产生 first[6]=0; for x:=5 downto 1 do first[x]=[(first[x+1]+numl[x+1])/2] 其中,[y]表示取不小于y的最小整数。

码长 Length

码字个数 Numl

1

0

2

0

3

4

4

0

5

5

6

7

起始编码 first

2

4

3

5

4

Huffman编码算法

符号

概率 编码

a1

0.2 10

a2

0.4 0

a3

0.2 110

a4

0.1 1110

0 1.0 1 0 a1

a5

0.1 1111

Huffman编码平均码长 =0.2*2+0.4*1+0.2*3+0.1*4+0.1*4 a2 =2.2bits 假定以每个内节点的所有孩子节点的概率 之和表示该节点的值,Huffman编码树的 内节点之和等于平均码长。

数据压缩与信源编码 第3讲 霍夫曼编码

西安电子科技大学 电子工程学院 主讲 :林三虎

Huffman编码算法

基本规则

① 出现概率越高的符号采用越短的编码。 ② 出现概率最低的两个符号采用相同长度的编码。

具体步骤

① 将符号出现概率从高到低排序。

② 将概率最低的两个符号合并成一个符号,它们概率之

和为新符号的概率。 ③ 重复上面两个步骤,直到概率为1。 ④ 每次合并符号,用0和1区分两个符号。 ⑤ 从根节点开始搜索每个符号,记录其0,1序列即为该 符号的编码。

规范的霍夫曼码字是从Huffman码字从特意挑选出来的, 目的是便于在译码时检测码字的长度。 下面两个编码中,编码2为规范的Huffman码字。

符号 编码1 编码2 符号 编码1 编码2 1 000 011 9 10100 01000 2 001 100 10 101010 000000 3 010 101 11 101011 000001 4 011 110 12 101100 000010 5 10000 00100 13 101101 000011 6 10001 00101 14 101110 000100 7 10010 00110 15 101111 000101 8 10011 00111 16 110000 000110

最小方差Huffman编码算法

符号 编码1

编码2 编码3

1000symbol/s a5 a5 a5 a2 a1 1 1 0 0 1 1 1 1 1 1 1 0 1 1 1 1 1 1 1 1 1 1

a1 10

01 10

a2 0

1 00

a3 110

001 11

a4 1110

0001 010

a5 1111

码长 Length 码字个数 Numl 起始编码 first

1 0 2

2 0 4

3 4 3

4 0 5

5 5 4

6 7 0

规范Huffman码字

码长 Length 码字个数 Numl 起始编码 first 1 0 2 2 0 4 3 4 3 4 0 5 5 5 4 6 7 0