数学建模决策树

决策树数量确定方法

决策树数量确定方法决策树是数据挖掘中一种非常受欢迎的机器学习方法,它通过一系列的判断规则对数据进行分类或回归分析。

然而,决策树数量的确定对于模型的性能有着至关重要的影响。

本文将详细介绍几种常用的决策树数量确定方法,帮助您在构建模型时做出更明智的决策。

一、交叉验证法交叉验证法是一种常用的决策树数量确定方法。

该方法将数据集分为k个大小相等的子集,每次用k-1个子集的数据训练模型,剩下的1个子集的数据验证模型的性能。

重复进行k次,每次选择不同的验证集,最后取平均值作为模型的性能指标。

通过调整决策树的数量,找到使模型性能最佳的树的数量。

二、预剪枝法预剪枝法是在决策树生长过程中,提前停止树的生长。

具体方法包括设定树的最大深度、最小样本数等参数。

当满足这些条件时,停止生长新的叶子节点。

通过调整这些参数,可以控制决策树的数量。

预剪枝法可以避免过拟合,但可能导致模型性能不如未剪枝的决策树。

三、后剪枝法后剪枝法是在决策树完全生长后,对树进行剪枝。

具体方法包括减少树的高度、删除不重要的节点等。

后剪枝法可以保留更多的树结构信息,从而提高模型的泛化能力。

但是,后剪枝法计算量较大,时间复杂度高。

四、基于信息增益的剪枝方法基于信息增益的剪枝方法是通过计算每个节点的信息增益,判断是否需要剪枝。

当节点的信息增益小于某个阈值时,停止生长新的叶子节点。

这种方法可以有效地减少过拟合现象,但需要合理选择阈值。

五、贝叶斯信息准则(BIC)法贝叶斯信息准则(BIC)法是一种基于模型复杂度和数据拟合度的剪枝方法。

BIC准则考虑了模型参数的数量和训练数据的拟合程度。

通过比较不同决策树数量下的BIC值,选择使BIC最小的树的数量。

总结:决策树数量的确定方法有多种,包括交叉验证法、预剪枝法、后剪枝法、基于信息增益的剪枝方法和贝叶斯信息准则法等。

在实际应用中,可以根据具体问题、数据集特点以及计算资源选择合适的方法。

需要注意的是,不同的剪枝方法可能适用于不同的问题,因此需要结合实际情况进行选择和调整。

数学学习中的数学与管理学的应用

数学学习中的数学与管理学的应用数学是一门广泛应用于各个领域的学科,其中与管理学的关联尤为密切。

在数学学习中,我们可以利用数学的原理和方法来解决管理学中的问题,提高管理效率和决策质量。

本文将探讨数学学习中数学与管理学的应用,并着重介绍线性规划和决策树两个在管理学中常用的数学工具。

一、线性规划线性规划是一种数学建模技术,它在管理学中被广泛应用于资源配置、生产计划、物流管理等方面。

线性规划通过建立线性模型,解决约束条件下的最优化问题。

它的数学表达形式如下:Max(或Min)z = c₁x₁ + c₂x₂+ … + cₙxₙ满足:a₁₁x₁ + a₁₂x₂ + … + a₁ₙxₙ ≤ b₁a₂₁x₁ + a₂₂x₂ + … + a₂ₙxₙ ≤ b₂⋮aₙ₁x₁ + aₙ₂x₂ + … + aₙₙxₙ ≤ bₙ其中,x₁、x₂、…、xₙ为决策变量,c₁、c₂、…、cₙ为目标函数系数,a₁₁、a₁₂、…、aₙₙ为约束条件的系数,b₁、b₂、…、bₙ为约束条件的取值范围。

通过线性规划,我们可以优化资源配置和制定最佳决策。

例如,在生产计划中,我们可以利用线性规划来确定各个产品的生产数量,以最大化利润或者最小化成本。

在物流管理中,线性规划可以帮助我们优化运输路线和货物调度,从而实现运输成本的最小化。

二、决策树决策树是一种可视化的决策支持工具,它在管理学中被广泛应用于决策分析、风险评估等方面。

决策树通过将问题划分为一系列的决策和事件,根据各个决策和事件发生的概率和结果的价值,计算出最优决策路径。

决策树的构建过程如下:1. 选择决策节点:根据决策问题确定第一个决策节点。

2. 选择事件节点:根据可能发生的事件确定与该决策相关的事件节点。

3. 计算概率和价值:计算各个事件节点发生的概率和相应结果的价值。

4. 计算预期价值:根据概率和价值计算决策节点的预期价值,并选择具有最大预期价值的决策路径。

5. 重复上述步骤:对于每个事件节点,重复上述步骤,直到得到最优决策路径。

决策树计算公式

决策树计算公式

决策树是一种监督学习算法,用于解决分类问题。

其计算公式如下:

1.特征选择:根据某个特征的信息增益、信息增益比、基尼系数等指标,选择最优的特征进行划分。

2.划分节点:根据选择的最优特征,将数据集划分成多个子集或子节点。

3.递归构建:对每个子节点,重复步骤1和步骤2,直到满足终止条件(例如,节点只含有一类样本,或者达到最大深度等)。

4.终止条件:可以是以下情况之一:

-节点只包含一类样本,无需继续划分;

-达到预设的最大深度;

-无法选择一个特征进行划分。

5.样本分类:根据叶子节点的类别标签进行分类。

需要注意的是,决策树的计算过程是一个递归的过程,通过选择最优特征进行划分,将数据集分成更小的子集,最终得到树形结构的分类模型。

决策树还有其他一些拓展形式,例如随机森林、梯度提升树等。

这些拓展形式在计算公式上可能会有一些差异,但核心的思想和基本的计算过程与原始决策树相似。

数学建模c题常用模型

数学建模c题常用模型摘要:一、数学建模C 题简介1.数学建模C 题背景2.C 题考查的能力和素质二、常用的数学建模C 题模型1.分类模型a.逻辑回归b.决策树c.支持向量机d.随机森林e.神经网络2.预测模型a.线性回归b.多元线性回归c.非线性回归d.时间序列分析e.灰色关联分析3.优化模型a.线性规划b.整数规划c.动态规划d.网络优化e.遗传算法正文:数学建模C 题是针对本科生的一项重要赛事,旨在通过对现实生活中的问题进行抽象、建模和求解,培养学生的创新意识、团队协作精神和实际问题解决能力。

C 题涵盖了众多领域,如经济、管理、环境、资源等,因此,熟练掌握一些常用的数学建模C 题模型对于参赛者来说至关重要。

首先,我们来介绍几种常用的分类模型。

逻辑回归是一种简单的分类模型,通过计算线性函数的输出值来判断样本属于哪一类。

决策树是一种树形结构的分类模型,通过递归地进行特征选择,将数据集划分为不同的子集。

支持向量机是一种基于最大间隔的分类模型,通过找到一个最优的超平面来分隔不同类别的数据。

随机森林是一种集成分类模型,通过构建多个决策树并将它们的预测结果综合来提高分类准确性。

神经网络是一种模拟人脑神经元结构的分类模型,通过训练神经元之间的连接权重来实现分类功能。

其次,我们来介绍几种常用的预测模型。

线性回归是一种简单的预测模型,通过拟合一个线性函数来预测目标变量的值。

多元线性回归是在线性回归的基础上,考虑多个自变量对目标变量的影响。

非线性回归是一种针对非线性关系的预测模型,可以通过对线性模型进行非线性变换来实现。

时间序列分析是一种针对时间序列数据的预测模型,可以分析数据中的周期性和趋势性。

灰色关联分析是一种基于灰色理论的预测模型,通过对变量之间的关联程度进行评估,找到影响目标变量的主要因素。

最后,我们来介绍几种常用的优化模型。

线性规划是一种求解线性目标函数和线性约束条件的优化模型。

整数规划是在线性规划的基础上,要求部分或全部变量取整数值。

数学建模简单13个例子全解

数学建模简单13个例子全解1. 线性回归模型线性回归是一种基本的数学建模方法,用于预测一个因变量与一个或多个自变量之间的关系。

通过最小化误差平方和来拟合一个直线或平面,使其能够最好地拟合数据。

2. 逻辑回归模型逻辑回归是一种用于分类问题的建模方法。

它通过将线性回归模型的输出变换为一个概率值,从而将输入样本分为两个不同的类别。

3. K-means聚类模型K-means聚类是一种无监督学习算法,用于将样本分为若干个不同的簇。

它根据样本之间的相似性将它们分配到不同的簇中。

4. 决策树模型决策树是一种基于规则的分类模型。

它通过一系列的决策节点和叶节点来对输入样本进行分类。

5. 随机森林模型随机森林是一种集成学习模型,它由多个决策树组成。

它通过对每个决策树的预测结果进行投票来进行分类。

6. 支持向量机模型支持向量机是一种基于最大间隔原则的分类模型。

它通过寻找一个超平面来将数据样本分成不同的类别。

7. 主成分分析模型主成分分析是一种降维技术,它将原始数据投影到一个低维空间中,以便尽可能保留数据的方差。

8. 马尔可夫链模型马尔可夫链是一种离散时间概率模型,它假设过去的状态对于预测未来的状态是有用的。

9. 指数平滑模型指数平滑是一种时间序列预测方法,它使用加权平均法来对下一个时间点的预测值进行估计。

10. 神经网络模型神经网络是一种模拟人类神经系统的方法,它通过多层神经元之间的连接来进行学习和预测。

11. 遗传算法模型遗传算法是一种通过模拟生物进化过程来求解优化问题的方法。

它通过交叉、变异和选择等操作来生成新的解,并逐步优化。

12. 时间序列模型时间序列模型用于分析和预测随时间变化的数据。

常用的时间序列模型包括自回归移动平均模型(ARMA)、自回归整合移动平均模型(ARIMA)等。

13. 蒙特卡洛模拟模型蒙特卡洛模拟是一种概率方法,用于通过随机模拟来解决复杂的数学问题。

它通常通过重复随机抽样和运算来估计问题的解。

决策数学知识点总结

决策数学知识点总结决策数学是运用数学方法和模型研究决策问题的一门交叉学科。

它将数学的思维方式和技巧运用到决策问题的建模、分析和解决过程中,帮助决策者做出科学、合理的决策。

本文将围绕决策数学的主要知识点进行总结,包括决策模型、决策分析、风险管理、优化理论等方面的内容。

一、决策模型1. 决策树模型决策树模型是一种常用的决策分析方法,它通过构建决策树来描述决策问题的各种可能的决策选择和结果,以及它们之间的关系。

决策树模型可以帮助决策者更直观地理解决策问题,从而做出更科学、更有效的决策。

2. 马尔可夫决策过程马尔可夫决策过程是描述在某种随机环境下,决策者为了达到某种目标而采取不同行为的一种数学模型。

它通过建立状态、决策和转移概率等要素的数学关系来描述决策问题,从而找到最优的决策策略。

3. 线性规划模型线性规划模型是一种常用的优化模型,它将决策问题转化为一个线性约束条件下的最优化问题,即通过确定决策变量的取值来最大化或最小化某种目标函数。

线性规划模型在实际应用中有着广泛的应用,包括生产调度、资源配置、运输优化等领域。

二、决策分析1. 决策目标设定决策目标设定是决策分析的第一步,它涉及到对决策问题的目标、约束条件和评价指标等方面的明确定义和量化,从而为后续的决策分析提供基础。

2. 决策风险评估在进行决策分析时,需要对决策问题的风险进行评估,包括确定风险的可能性和影响程度,从而为决策者提供科学的风险管理建议。

3. 决策方案评价决策方案评价是决策分析的核心环节,它通过对各种决策方案的优劣进行定量分析和比较,从而为决策者提供最优的决策建议。

三、风险管理1. 风险度量与分析风险度量与分析是对决策问题中各种风险因素进行量化和分析的过程,包括确定风险的可能性、影响程度和相互关联等方面的内容。

2. 风险控制与规避在面临各种风险时,决策者需要采取相应的控制和规避措施来降低风险的发生和影响,包括风险的传播路径、控制措施和应急预案等内容。

决策树名词解释

决策树名词解释决策树(DecisionTree)是一种常见的数据挖掘技术,也称为决策树分类(Decision Tree Classification)。

决策树是一种以树状结构表示数据的模型,它可以用来描述一组数据集的概念,它可以用来作出决策。

策树是一种数据挖掘的常用算法,它可以用于分类、回归任务,以及关联规则建模,它可以帮助智能系统理解数据,从而实现更好的决策。

决策树的基本原理很简单,它是一种将每个属性值与实例的关联转换成树形结构的方法。

在这种树形结构中,每个节点存储关联属性的值,从而决定一个决策。

策树通常用于研究一组已知数据,它可以用来预测未知数据的结果,也可以用来归类数据,从而发现数据的规律性。

决策树的建立有很多步骤,但是大致可以分为以下几个步骤:(1)数据集准备:首先,需要对数据集进行预处理,将数据分成训练集和测试集。

(2)决策树划分:根据训练集中的特征属性,将数据集划分为不同的分支,并且不断划分,直到达到决策树模型所需要的精度或停止条件为止。

(3)估属性:根据训练集中的数据,选择最优的划分属性,用于对训练集进行划分。

(4)决策树剪枝:新建的决策树可能过度拟合训练数据,这会使训练出来的决策树在测试数据上的表现变差,因此,需要使用剪枝算法,来减少决策树的过拟合现象。

(5)测试:根据训练好的决策树,对测试集数据进行分类,统计测试集分类正确率,从而对决策树进行评估。

决策树在实际应用中可以用于社会决策分析、企业决策分析、关联规则挖掘等应用场景,但是决策树也有若干缺点。

其一,决策树生成过程中属性之间的关系可能非线性,而决策树假设属性之间的关系是线性的,因此可能导致决策树模型的准确性不足。

其二,决策树的剪枝操作可能会过度剪枝,也影响模型的准确性。

总之,决策树是一种常用的数据挖掘技术,它可以用于推理和预测数据,它可以用来帮助智能系统理解数据,从而改善决策效率。

但是,因为决策树的局限性,仍然需要其他的数据挖掘技术来提高决策的准确性。

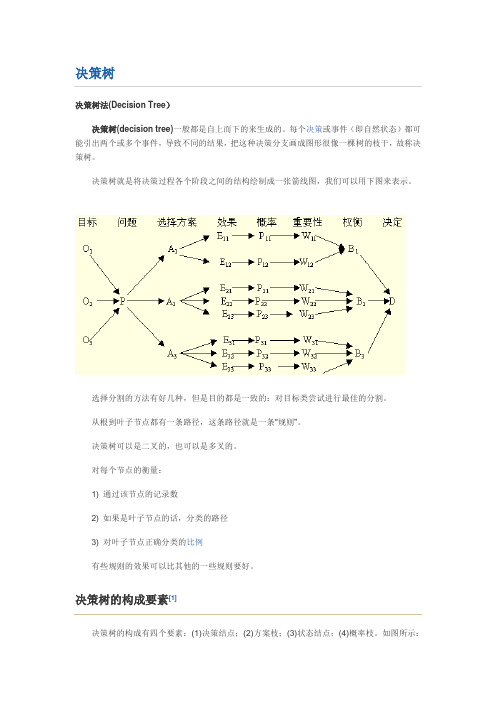

决策树

决策树决策树法(Decision Tree)决策树(decision tree)一般都是自上而下的来生成的。

每个决策或事件(即自然状态)都可能引出两个或多个事件,导致不同的结果,把这种决策分支画成图形很像一棵树的枝干,故称决策树。

决策树就是将决策过程各个阶段之间的结构绘制成一张箭线图,我们可以用下图来表示。

选择分割的方法有好几种,但是目的都是一致的:对目标类尝试进行最佳的分割。

从根到叶子节点都有一条路径,这条路径就是一条“规则”。

决策树可以是二叉的,也可以是多叉的。

对每个节点的衡量:1) 通过该节点的记录数2) 如果是叶子节点的话,分类的路径3) 对叶子节点正确分类的比例有些规则的效果可以比其他的一些规则要好。

决策树的构成要素[1]决策树的构成有四个要素:(1)决策结点;(2)方案枝;(3)状态结点;(4)概率枝。

如图所示:总之,决策树一般由方块结点、圆形结点、方案枝、概率枝等组成,方块结点称为决策结点,由结点引出若干条细支,每条细支代表一个方案,称为方案枝;圆形结点称为状态结点,由状态结点引出若干条细支,表示不同的自然状态,称为概率枝。

每条概率枝代表一种自然状态。

在每条细枝上标明客观状态的内容和其出现概率。

在概率枝的最末稍标明该方案在该自然状态下所达到的结果(收益值或损失值)。

这样树形图由左向右,由简到繁展开,组成一个树状网络图。

决策树对于常规统计方法的优缺点优点:1)可以生成可以理解的规则;2)计算量相对来说不是很大;3) 可以处理连续和种类字段;4) 决策树可以清晰的显示哪些字段比较重要。

缺点:1) 对连续性的字段比较难预测;2) 对有时间顺序的数据,需要很多预处理的工作;3) 当类别太多时,错误可能就会增加的比较快;4) 一般的算法分类的时候,只是根据一个字段来分类。

决策树的适用范围[1]科学的决策是现代管理者的一项重要职责。

我们在企业管理实践中,常遇到的情景是:若干个可行性方案制订出来了,分析一下企业内、外部环境,大部分条件是己知的,但还存在一定的不确定因素。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

用熵度量样例的均一性(纯度)

熵的定义

举例

用信息增益度量期望熵最低

举例

ID3算法(Iterative Dichotomiser 3)

创建树的Root结点 如果Examples都为正,那么返回label=+中的单结点Root 如果Examples都为反,那么返回lable=-单结点树Root 如果Attributes为空,那么返回单节点树Root,lable=Examples中最普遍的目标属性值 否则开始

决策树

概要

简介 决策树表示法 决策树学习的适用问题 基本的决策树学习算法 决策树学习中的假想空间搜索 决策树学习的常见问题

简介

决策树方法是应用最广的归纳推理算法之一 一种逼近离散值目标函数的方法 对噪声数据有很好的健壮性且能学习析取表达式

决策树的表示法

决策树通过把实例从根节点排列到某个叶子节 点来分类实例,叶子节点即为实例所属的分类。 树上的每一个节点说明了对实例的某个属性的 测试,并且该节点的每一个后继分支对应于该 属性的一个可能值

AAttributes中分类能力最好的属性 Root的决策属性A 对于每个可能值

在Root下加一个新的分支对应测试A=vi 令Example-vi为Examples中满足A属性值为vi的子集 如果Examples-vi为空

在这个新分支下加一个叶子结点,节点的lable=Examples中最普遍的 目标属性值 否则在这个新分支下加一个子树ID3(example-vi,targetattribute,attributes-|A| 结束 返回 Root

= 0.01571

Gain(S,Hair) = 0.45443 Gain(S,Height) = 0.26571 Gain(S,Weight) = 0.01571 Gain(S,Lotion) = 0.3475 Gain(S,Hair) is maximum, so it is considered as the root node

= 0.01571 For attribute ‘Lotion’: Values(Lotion) : [Yes, No] SYes = [0+,3-] E(SYes) = 0 SNo = [3+,2-] E(SNo) = 0.97095 Gain(S,Lotion) = 0.95443 – [(3/8)*0 + (5/8)*0.97095]

Name Hair Height Weigh Lotion Sunbur

t

ned

Sarah Blonde Averag Light No e

Dana Blonde Tall Averபைடு நூலகம்g Yes e

Example 2

Factors affecting sunburn

Name Hair

Height Weight Lotion Result

Sarah Blonde Average Light

No

Sunburned

Dana Blonde Tall

Average Yes None

Alex Brown Short

Average Yes None

Annie Blonde Short

Average No

Sunburned

Emily Red

Average Heavy No

Sunburned

Pete Brown Tall

Heavy No

None

John Brown Average Heavy No

None

Kate Blonde Short

= 0.26571 For attribute ‘Weight’: Values(Weight) : [Light, Average, Heavy] SLight = [1+,1-] E(SLight) = 1 SAverage = [1+,2-] E(SAverage) = 0.91829 SHeavy = [1+,2-] E(SHeavy) = 0.91829 Gain(S,Weight) = 0.95443 – [(2/8)*1 + (3/8)*0.91829 + (3/8)*0.91829]

= 0.45443

For attribute ‘Height’: Values(Height) : [Average, Tall, Short] SAverage = [2+,1-] E(SAverage) = 0.91829 STall = [0+,2-] E(STall) = 0 SShort = [1+,2-] E(SShort) = 0.91829 Gain(S,Height) = 0.95443 – [(3/8)*0.91829 + (2/8)*0 + (3/8)*0.91829]

图

表达式

决策树学习的适用问题

实例是由属性-值对表示的 目标函数具有离散的输出值 训练数据可以包含错误 训练数据可以包含缺少属性值的实例

属性选择

构造好的决策树的关键在于如何选择好的逻辑判断或 属性。对于同样一组例子,可以有很多决策树能符合 这组例子。人们研究出,一般情况下或具有较大概率 地说,树越小则树的预测能力越强。要构造尽可能小 的决策树,关键在于选择恰当的逻辑判断或属性。由 于构造最小的树是NP-难问题,因此只能采取用启发 式策略选择好的逻辑判断或属性。

Light

Yes None

S = [3+, 5-] Entropy(S) = -(3/8)log2(3/8) – (5/8)log2(5/8)

= 0.95443

Find IG for all 4 attributes: Hair, Height, Weight, Lotion

For attribute ‘Hair’: Values(Hair) : [Blonde, Brown, Red] S = [3+,5-] SBlonde = [2+,2-] E(SBlonde) = 1 SBrown = [0+,3-] E(SBrown) = 0 SRed = [1+,0-] E(SRed) = 0 Gain(S,Hair) = 0.95443 – [(4/8)*1 + (3/8)*0 + (1/8)*0]