基于MATLAB的一对一M_SVM算法实现

matlab svm多分类算法

标题:MATLAB中SVM多分类算法的研究与应用摘要:支持向量机(Support Vector Machine,SVM)是一种常用的机器学习算法,在分类问题中表现出色。

然而,在面对多分类问题时,SVM的应用和优化仍然具有挑战性。

本文将对MATLAB中SVM 多分类算法的研究和应用进行深入探讨,分析其原理、优化方法以及实际应用。

通过本文的阅读,读者将能够全面了解MATLAB中SVM多分类算法的特点和应用技巧。

关键词:支持向量机;多分类算法;MATLAB;优化方法;应用技巧一、介绍支持向量机(SVM)是一种通过寻找最优超平面来进行分类的监督学习算法。

在二分类问题中,SVM表现出色,然而在面对多分类问题时,SVM的应用和性能仍然具有挑战性。

MATLAB作为一种强大的科学计算软件,具有丰富的机器学习工具包,其中包括了用于多分类问题的SVM算法。

本文将围绕MATLAB中SVM多分类算法的原理、优化方法以及实际应用展开讨论。

二、MATLAB中SVM多分类算法的原理1. SVM的基本原理SVM的基本原理是通过寻找一个最优的超平面来将不同类别的样本分开,使得两个类别的间隔最大化。

对于多分类问题,可以借助一对一(One-Versus-One)或一对其余(One-Versus-All)等方法来实现多个类别之间的分类。

MATLAB中的SVM多分类算法就是基于这样的原理进行实现的。

2. MATLAB中SVM多分类算法的实现MATLAB中提供了SVM多分类的函数,如fitcecoc和fitcsvm等,分别对应一对一和一对其余的多分类方法。

这些函数可以方便地对SVM进行训练和预测,同时还支持参数调优和模型评价等功能。

读者可以通过调用这些函数,快速实现SVM多分类算法的应用。

三、MATLAB中SVM多分类算法的优化方法1. 参数调优在使用SVM进行多分类时,参数的设置对算法的性能具有重要影响。

MATLAB中的SVM多分类算法支持对参数进行调优,如调整核函数类型、惩罚参数等,以提高算法的分类准确率和泛化能力。

Matlab的SVM算法进行线性和非线性分类实例_20131128

Matlab_svmtranin_example1.Linear classification%Two Dimension Linear-SVM Problem,Two Class and Separable Situation%Method from Christopher J.C.Burges:%"A Tutorial on Support Vector Machines for Pattern Recognition",page9 %Optimizing||W||directly:%Objective:min"f(A)=||W||",p8/line26%Subject to:yi*(xi*W+b)-1>=0,function(12);clear all;close allclc;sp=[3,7;6,6;4,6;5,6.5]%positive sample pointsnsp=size(sp);sn=[1,2;3,5;7,3;3,4;6,2.7]%negative sample pointsnsn=size(sn)sd=[sp;sn]lsd=[true true true true false false false false false]Y=nominal(lsd)figure(1);subplot(1,2,1)plot(sp(1:nsp,1),sp(1:nsp,2),'m+');hold onplot(sn(1:nsn,1),sn(1:nsn,2),'c*');subplot(1,2,2)svmStruct=svmtrain(sd,Y,'showplot',true);2.NonLinear classification%Two Dimension quadratic-SVM Problem,Two Class and Separable Situation %Method from Christopher J.C.Burges:%"A Tutorial on Support Vector Machines for Pattern Recognition",page9 %Optimizing||W||directly:%Objective:min"f(A)=||W||",p8/line26%Subject to:yi*(xi*W+b)-1>=0,function(12);clear all;close allclc;sp=[3,7;6,6;4,6;5,6.5]%positive sample pointsnsp=size(sp);sn=[1,2;3,5;7,3;3,4;6,2.7;4,3;2,7]%negative sample pointsnsn=size(sn)sd=[sp;sn]lsd=[true true true true false false false false false false false]Y=nominal(lsd)figure(1);subplot(1,2,1)plot(sp(1:nsp,1),sp(1:nsp,2),'m+');hold onplot(sn(1:nsn,1),sn(1:nsn,2),'c*');subplot(1,2,2)%svmStruct=svmtrain(sd,Y,'Kernel_Function','linear','showplot',true);svmStruct=svmtrain(sd,Y,'Kernel_Function','quadratic','showplot',true);%use the trained svm(svmStruct)to classify the dataRD=svmclassify(svmStruct,sd,'showplot',true)%RD is the classification result vector3.Svmtrainsvmtrain Train a support vector machine classifierSVMSTRUCT=svmtrain(TRAINING,Y)trains a support vector machine(SVM) classifier on data taken from two groups.TRAINING is a numeric matrix of predictor data.Rows of TRAINING correspond to observations;columns correspond to features.Y is a column vector that contains the knownclass labels for TRAINING.Y is a grouping variable,i.e.,it can be a categorical,numeric,or logical vector;a cell vector of strings;or a character matrix with each row representing a class label(see help forgroupingvariable).Each element of Y specifies the group thecorresponding row of TRAINING belongs to.TRAINING and Y must have the same number of rows.SVMSTRUCT contains information about the trained classifier,including the support vectors,that is used by SVMCLASSIFY for classification.svmtrain treats NaNs,empty strings or'undefined' values as missing values and ignores the corresponding rows inTRAINING and Y.SVMSTRUCT=svmtrain(TRAINING,Y,'PARAM1',val1,'PARAM2',val2,...) specifies one or more of the following name/value pairs:Name Value'kernel_function'A string or a function handle specifying thekernel function used to represent the dotproduct in a new space.The value can be one ofthe following:'linear'-Linear kernel or dot product(default).In this case,svmtrainfinds the optimal separating planein the original space.'quadratic'-Quadratic kernel'polynomial'-Polynomial kernel with defaultorder3.To specify another order,use the'polyorder'argument.'rbf'-Gaussian Radial Basis Functionwith default scaling factor1.Tospecify another scaling factor,use the'rbf_sigma'argument.'mlp'-Multilayer Perceptron kernel(MLP)with default weight1and defaultbias-1.To specify another weightor bias,use the'mlp_params'argument.function-A kernel function specified using@(for example@KFUN),or ananonymous function.A kernelfunction must be of the formfunction K=KFUN(U,V)The returned value,K,is a matrixof size M-by-N,where M and N arethe number of rows in U and Vrespectively.'rbf_sigma'A positive number specifying the scaling factorin the Gaussian radial basis function kernel.Default is1.'polyorder'A positive integer specifying the order of thepolynomial kernel.Default is3.'mlp_params'A vector[P1P2]specifying the parameters of MLPkernel.The MLP kernel takes the form:K=tanh(P1*U*V'+P2),where P1>0and P2<0.Default is[1,-1].'method'A string specifying the method used to find theseparating hyperplane.Choices are:'SMO'-Sequential Minimal Optimization(SMO)method(default).It implements the L1soft-margin SVM classifier.'QP'-Quadratic programming(requires anOptimization Toolbox license).Itimplements the L2soft-margin SVMclassifier.Method'QP'doesn't scalewell for TRAINING with large number ofobservations.'LS'-Least-squares method.It implements theL2soft-margin SVM classifier.'options'Options structure created using either STATSET orOPTIMSET.*When you set'method'to'SMO'(default),create the options structure using STATSET.Applicable options:'Display'Level of display output.Choicesare'off'(the default),'iter',and'final'.Value'iter'reports every500iterations.'MaxIter'A positive integer specifying themaximum number of iterations allowed.Default is15000for method'SMO'.*When you set method to'QP',create theoptions structure using OPTIMSET.For detailsof applicable options choices,see QUADPROGoptions.SVM uses a convex quadratic program,so you can choose the'interior-point-convex'algorithm in QUADPROG.'tolkkt'A positive scalar that specifies the tolerancewith which the Karush-Kuhn-Tucker(KKT)conditionsare checked for method'SMO'.Default is1.0000e-003.'kktviolationlevel'A scalar specifying the fraction of observationsthat are allowed to violate the KKT conditions formethod'SMO'.Setting this value to be positivehelps the algorithm to converge faster if it isfluctuating near a good solution.Default is0.'kernelcachelimit'A positive scalar S specifying the size of thekernel matrix cache for method'SMO'.Thealgorithm keeps a matrix with up to S*Sdouble-precision numbers in memory.Default is5000.When the number of points in TRAININGexceeds S,the SMO method slows down.It'srecommended to set S as large as your systempermits.'boxconstraint'The box constraint C for the soft margin.C can bea positive numeric scalar or a vector of positivenumbers with the number of elements equal to thenumber of rows in TRAINING.Default is1.*If C is a scalar,it is automatically rescaledby N/(2*N1)for the observations of group one,and by N/(2*N2)for the observations of grouptwo,where N1is the number of observations ingroup one,N2is the number of observations ingroup two.The rescaling is done to take intoaccount unbalanced groups,i.e.,when N1and N2are different.*If C is a vector,then each element of Cspecifies the box constraint for thecorresponding observation.'autoscale'A logical value specifying whether or not toshift and scale the data points before training.When the value is true,the columns of TRAININGare shifted and scaled to have zero mean unitvariance.Default is true.'showplot'A logical value specifying whether or not to showa plot.When the value is true,svmtrain creates aplot of the grouped data and the separating linefor the classifier,when using data with2features(columns).Default is false. SVMSTRUCT is a structure having the following properties:SupportVectors Matrix of data points with each row correspondingto a support vector.Note:when'autoscale'is false,this fieldcontains original support vectors in TRAINING.When'autoscale'is true,this field containsshifted and scaled vectors from TRAINING.Alpha Vector of Lagrange multipliers for the supportvectors.The sign is positive for support vectorsbelonging to the first group and negative forsupport vectors belonging to the second group. Bias Intercept of the hyperplane that separatesthe two groups.Note:when'autoscale'is false,this fieldcorresponds to the original data points inTRAINING.When'autoscale'is true,this fieldcorresponds to shifted and scaled data points. KernelFunction The function handle of kernel function used. KernelFunctionArgs Cell array containing the additional argumentsfor the kernel function.GroupNames A column vector that contains the knownclass labels for TRAINING.Y is a groupingvariable(see help for groupingvariable). SupportVectorIndices A column vector indicating the indices of supportvectors.ScaleData This field contains information about auto-scale.When'autoscale'is false,it is empty.When'autoscale'is set to true,it is a structurecontaining two fields:shift-A row vector containing the negativeof the mean across all observationsin TRAINING.scaleFactor-A row vector whose value is1./STD(TRAINING).FigureHandles A vector of figure handles created by svmtrainwhen'showplot'argument is TRUE.Example:%Load the data and select features for classificationload fisheririsX=[meas(:,1),meas(:,2)];%Extract the Setosa classY=nominal(ismember(species,'setosa'));%Randomly partitions observations into a training set and a test %set using stratified holdoutP=cvpartition(Y,'Holdout',0.20);%Use a linear support vector machine classifiersvmStruct=svmtrain(X(P.training,:),Y(P.training),'showplot',true);C=svmclassify(svmStruct,X(P.test,:),'showplot',true);errRate=sum(Y(P.test)~=C)/P.TestSize%mis-classification rate conMat=confusionmat(Y(P.test),C)%the confusion matrix。

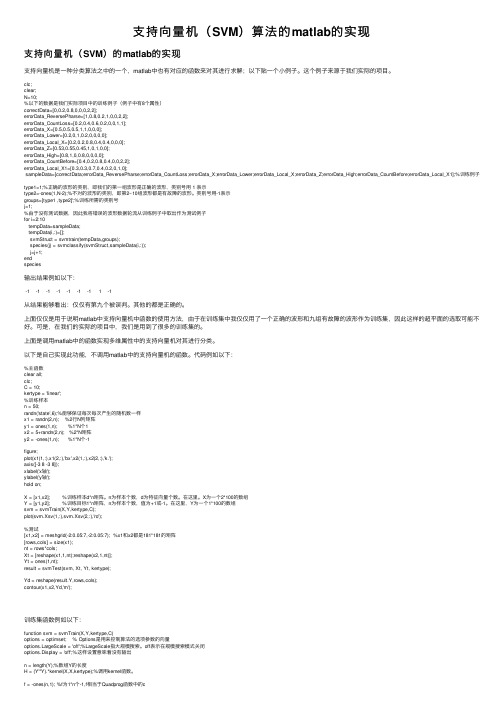

支持向量机(SVM)算法的matlab的实现

⽀持向量机(SVM)算法的matlab的实现⽀持向量机(SVM)的matlab的实现⽀持向量机是⼀种分类算法之中的⼀个,matlab中也有对应的函数来对其进⾏求解;以下贴⼀个⼩例⼦。

这个例⼦来源于我们实际的项⽬。

clc;clear;N=10;%以下的数据是我们实际项⽬中的训练例⼦(例⼦中有8个属性)correctData=[0,0.2,0.8,0,0,0,2,2];errorData_ReversePharse=[1,0.8,0.2,1,0,0,2,2];errorData_CountLoss=[0.2,0.4,0.6,0.2,0,0,1,1];errorData_X=[0.5,0.5,0.5,1,1,0,0,0];errorData_Lower=[0.2,0,1,0.2,0,0,0,0];errorData_Local_X=[0.2,0.2,0.8,0.4,0.4,0,0,0];errorData_Z=[0.53,0.55,0.45,1,0,1,0,0];errorData_High=[0.8,1,0,0.8,0,0,0,0];errorData_CountBefore=[0.4,0.2,0.8,0.4,0,0,2,2];errorData_Local_X1=[0.3,0.3,0.7,0.4,0.2,0,1,0];sampleData=[correctData;errorData_ReversePharse;errorData_CountLoss;errorData_X;errorData_Lower;errorData_Local_X;errorData_Z;errorData_High;errorData_CountBefore;errorData_Local_X1];%训练例⼦type1=1;%正确的波形的类别,即我们的第⼀组波形是正确的波形,类别号⽤ 1 表⽰type2=-ones(1,N-2);%不对的波形的类别,即第2~10组波形都是有故障的波形。

基于MATLAB的SVM支持向量机手写识别算法

信息通信INFORMATION & COMMUNICATIONS2020年第1期(总第205期)2020(Sum. No 205)基于MATLAB 的SVM 支持向量机手写识别算法唐蔗(佳木斯大学信息电子技术学院,黑龙江佳木斯154007)摘要:近年来伴随着大数据的积累以及计算能力的不断提升,SVM 支持向量机作为机器学习领域的典型代表逐渐被应用于手写数字识别。

不同于传统手写识别算法,SVM 支持向量机可以利用深层次结构学习更加丰富的特征表达,能有效解决手写数字识别问题。

基于此,本课题将对SVM 支持向量机手写识别算法展开研究,并借助MATLAB 完成了 SVM 支持向量机手写识别模型训练,验证了算法的合理性及性能优化。

关键词:SVM ;MATLAB ;手写识别;PCA 中图分类号:TP391文献标识码:A文章编号:1673-1131(2020)01-0154-021概述随着图像手写识别技术不断发展,手写识别逐渐被社会认可,在公共安全、国防安全、入口控制、身份验证、智能视频监控、视频会议、智能解锁等在生产生活各个领域应用越来越深入和 广泛,并且拥有巨大的应用前景。

机器学习技术是图像识别领域应用非常广泛的技术之一,关于机器学习的研究成果已经很 多,同时机器学习各个领域的应用也越来越多,而基于SVM 的 手写识别技术就是其中一个非常重要的主流识别技术,其在算 法研究和实际应用中等很多方面己经取得了不错的成就。

但随着人们对手写识别系统要求的不断提高,研究设计快速准确的手写识别仍然具有较强的应用价值和现实意义。

2基于SVM 支持向量机的手写识别算法支持向量机是建立在统计学理论基础上的,它是机器学 习方法的一种,也可以认为其是分类算法模型之一。

支持向量机主要的目的就是为了将分类的超平面明确下来。

因为只 有部分很少的样本信息决定了分类超平面的使用,因此,上述这部分样本就被叫作是支持向量。

2.1支持向量机的基本原理在一定的训练样本集里面,通过利用特征空间来明确分离超平面,在这个超平面的帮助下,将训练样本集分为各种类。

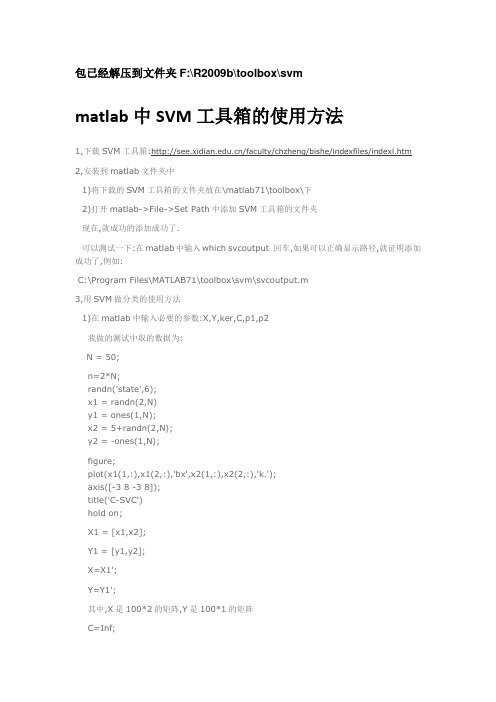

(1)matlab中SVM工具箱的使用方法

包已经解压到文件夹F:\R2009b\toolbox\svmmatlab中SVM工具箱的使用方法1,下载SVM工具箱:/faculty/chzheng/bishe/indexfiles/indexl.htm 2,安装到matlab文件夹中1)将下载的SVM工具箱的文件夹放在\matlab71\toolbox\下2)打开matlab->File->Set Path中添加SVM工具箱的文件夹现在,就成功的添加成功了.可以测试一下:在matlab中输入which svcoutput 回车,如果可以正确显示路径,就证明添加成功了,例如:C:\Program Files\MATLAB71\toolbox\svm\svcoutput.m3,用SVM做分类的使用方法1)在matlab中输入必要的参数:X,Y,ker,C,p1,p2我做的测试中取的数据为:N = 50;n=2*N;randn('state',6);x1 = randn(2,N)y1 = ones(1,N);x2 = 5+randn(2,N);y2 = -ones(1,N);figure;plot(x1(1,:),x1(2,:),'bx',x2(1,:),x2(2,:),'k.');axis([-3 8 -3 8]);title('C-SVC')hold on;X1 = [x1,x2];Y1 = [y1,y2];X=X1';Y=Y1';其中,X是100*2的矩阵,Y是100*1的矩阵C=Inf;ker='linear';global p1 p2p1=3;p2=1;然后,在matlab中输入:[nsv alpha bias] = svc(X,Y,ker,C),回车之后,会显示:Support Vector Classification_____________________________Constructing ...Optimising ...Execution time: 1.9 secondsStatus : OPTIMAL_SOLUTION|w0|^2 : 0.418414Margin : 3.091912Sum alpha : 0.418414Support Vectors : 3 (3.0%)nsv =3alpha =0.00000.00000.00000.00000.00002)输入预测函数,可以得到与预想的分类结果进行比较.输入:predictedY = svcoutput(X,Y,X,ker,alpha,bias),回车后得到:predictedY =1111111113)画图输入:svcplot(X,Y,ker,alpha,bias),回车补充:X和Y为数据,m*n:m为样本数,n为特征向量数比如:取20组训练数据X,10组有故障,10组无故障的,每个训练数据有13个特征参数,则m=20,n=13Y为20*1的矩阵,其中,10组为1,10组为-1.对于测试数据中,如果取6组测试数据,3组有故障,3组无故障的,则m=6,n=13Y中,m=6,n=1/SV M_soft.htmlSVM - Support Vector MachinesSoftwareTrain support vector machine classifier/access/helpdesk/help/toolbox/bioinfo/ref/svmtrain.html一些问题???????1.今天我在使用SVM通用工具箱对眼电的信号数据进行分类时出现如下错误:Support Vector Classification_____________________________Constructing ...Optimising ...??? Dimension error (arg 3 and later).Error in ==> svc at 60[alpha lambda how] = qp(H, c, A, b, vlb, vub, x0, neqcstr);不知道是什么原因?答:今天上午终于找到出现这一错误的原因:它并不是SVM程序的问题,是我在整理样本时,把参数需要的样本行列颠倒所致。

SVM多分类问题libsvm在matlab中的应用

SVM多分类问题libsvm在matlab中的应⽤转载⾃对于⽀持向量机,其是⼀个⼆类分类器,但是对于多分类,SVM也可以实现。

主要⽅法就是训练多个⼆类分类器。

⼀、多分类⽅式1、⼀对所有(One-Versus-All OVA)给定m个类,需要训练m个⼆类分类器。

其中的分类器 i 是将 i 类数据设置为类1(正类),其它所有m-1个i类以外的类共同设置为类2(负类),这样,针对每⼀个类都需要训练⼀个⼆类分类器,最后,我们⼀共有 m 个分类器。

对于⼀个需要分类的数据 x,将使⽤投票的⽅式来确定x的类别。

⽐如分类器 i 对数据 x 进⾏预测,如果获得的是正类结果,就说明⽤分类器 i 对 x 进⾏分类的结果是: x 属于 i 类,那么,类i获得⼀票。

如果获得的是负类结果,那说明 x 属于 i 类以外的其他类,那么,除 i 以外的每个类都获得⼀票。

最后统计得票最多的类,将是x的类属性。

2、所有对所有(All-Versus-All AVA)给定m个类,对m个类中的每两个类都训练⼀个分类器,总共的⼆类分类器个数为 m(m-1)/2 .⽐如有三个类,1,2,3,那么需要有三个分类器,分别是针对:1和2类,1和3类,2和3类。

对于⼀个需要分类的数据x,它需要经过所有分类器的预测,也同样使⽤投票的⽅式来决定x最终的类属性。

但是,此⽅法与”⼀对所有”⽅法相⽐,需要的分类器较多,并且因为在分类预测时,可能存在多个类票数相同的情况,从⽽使得数据x属于多个类别,影响分类精度。

对于多分类在matlab中的实现来说,matlab⾃带的svm分类函数只能使⽤函数实现⼆分类,多分类问题不能直接解决,需要根据上⾯提到的多分类的⽅法,⾃⼰实现。

虽然matlab⾃带的函数不能直接解决多酚类问题,但是我们可以应⽤libsvm⼯具包。

libsvm⼯具包采⽤第⼆种“多对多”的⽅法来直接实现多分类,可以解决的分类问题(包括C- SVC、n - SVC )、回归问题(包括e - SVR、n - SVR )以及分布估计(one-class-SVM )等,并提供了线性、多项式、径向基和S形函数四种常⽤的核函数供选择。

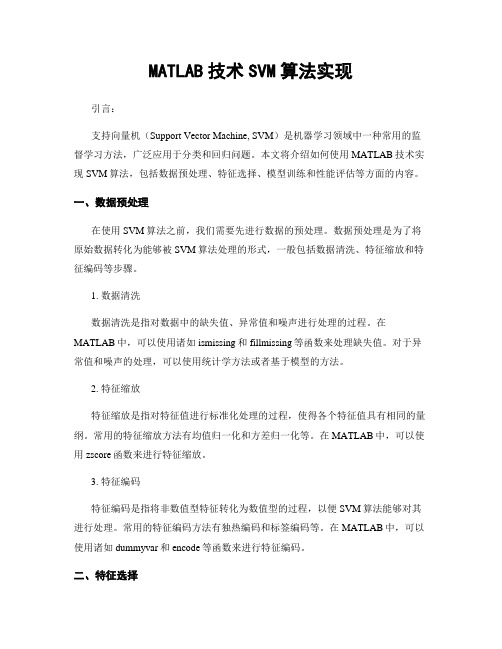

MATLAB技术SVM算法实现

MATLAB技术SVM算法实现引言:支持向量机(Support Vector Machine, SVM)是机器学习领域中一种常用的监督学习方法,广泛应用于分类和回归问题。

本文将介绍如何使用MATLAB技术实现SVM算法,包括数据预处理、特征选择、模型训练和性能评估等方面的内容。

一、数据预处理在使用SVM算法之前,我们需要先进行数据的预处理。

数据预处理是为了将原始数据转化为能够被SVM算法处理的形式,一般包括数据清洗、特征缩放和特征编码等步骤。

1. 数据清洗数据清洗是指对数据中的缺失值、异常值和噪声进行处理的过程。

在MATLAB中,可以使用诸如ismissing和fillmissing等函数来处理缺失值。

对于异常值和噪声的处理,可以使用统计学方法或者基于模型的方法。

2. 特征缩放特征缩放是指对特征值进行标准化处理的过程,使得各个特征值具有相同的量纲。

常用的特征缩放方法有均值归一化和方差归一化等。

在MATLAB中,可以使用zscore函数来进行特征缩放。

3. 特征编码特征编码是指将非数值型特征转化为数值型的过程,以便SVM算法能够对其进行处理。

常用的特征编码方法有独热编码和标签编码等。

在MATLAB中,可以使用诸如dummyvar和encode等函数来进行特征编码。

二、特征选择特征选择是指从原始特征中选择出最具有代表性的特征,以减少维度和提高模型性能。

在SVM算法中,选择合适的特征对分类效果非常关键。

1. 相关性分析通过分析特征与目标变量之间的相关性,可以选择与目标变量相关性较高的特征。

在MATLAB中,可以使用corrcoef函数计算特征之间的相关系数。

2. 特征重要性评估特征重要性评估可以通过各种特征选择方法来实现,如基于统计学方法的方差分析、基于模型的递归特征消除和基于树模型的特征重要性排序等。

在MATLAB 中,可以使用诸如anova1、rfimportance等函数进行特征重要性评估。

三、模型训练与评估在进行完数据预处理和特征选择之后,我们可以开始进行SVM模型的训练和评估了。

matlab svm多分类算法 -回复

matlab svm多分类算法-回复什么是SVM多分类算法?支持向量机(Support Vector Machine,SVM)是一种常用的机器学习算法,用于分类和回归分析。

它的主要思想是在特征空间中找到一个最优的超平面,将不同类别的样本点分开。

SVM被广泛应用于二分类问题,但在现实世界中,多分类问题更为常见。

SVM多分类算法是基于SVM算法的扩展,用于解决多类别分类问题。

SVM多分类算法的原理是什么?基本的SVM算法是建立在二分类的基础上的,它通过寻找一个最大化间隔的超平面来进行分类。

然而,在多分类问题中,我们需要一种方法来将多个类别进行有效地分类。

常用的方法有一对一(One-vs-One)和一对其余(One-vs-Rest)。

一对一方法将每两个类别之间都构造一个二分类器。

例如,对于k个类别,需要构建k*(k-1)/2个分类器,每个分类器负责将两个类别中的一个划分出来。

当需要对一个未知类别的样本进行分类时,每个分类器都会给出一个类别的判断结果,最后根据这些结果进行投票或决策,选择得票最多的类别作为最终的分类结果。

一对其余方法则是将一个类别与其他所有类别作为一个整体进行分类。

同样以k个类别为例,需要构建k个二分类器,每个分类器负责将一个类别与其他k-1个类别作区分。

对于未知类别的样本进行分类时,分别计算它与每个类别的距离得分,选择距离最大的类别作为最终的分类结果。

SVM多分类算法的具体实现步骤是什么?以下是一种常见的SVM多分类算法实现步骤的概述:1. 读取数据集:首先,我们需要从数据集中读取样本数据和对应的类别标签。

确保数据集的类别标签是数字或字符串形式。

2. 数据预处理:对于SVM算法,特征归一化是一个重要的预处理步骤。

通过对特征进行归一化或标准化,可以避免样本特征之间的比例差异对分类结果的影响。

3. 划分训练集和测试集:将数据集划分为训练集和测试集,用于构建和评估模型的性能。

4. 对每对分类器进行训练:根据选择的一对一或一对其余方法,依次对每个二分类器进行训练。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

四、Ma tla b 程序实现一对一方式 M- S VM 本文使用的 Matlab 版本为 7.1, 为方便起见, 所要分类 的类别为三类, 输入向量的维数为四维。类 1 训练样本数 取 50, 类 2 训 练 样 本 数 取 50, 类 3 训 练 样 本 数 取 50, 待 预 测样本为 1000。利用三个二分类 SVM 模型构造一个三分 类 SVM 模型。 ( 一) 二分类情况 Matlab7.1 中 提 供 了 关 于 二 分 类 支 持 向 量 机 的 函 数 svmtrain( train, group) 和 svmclassify( SVMStruct, test) , 其 中 train 为 训 练 样 本 集 , group 为 train 中 各 样 本 所 属 的 类 别 , svmtain 用于训 练 支 持 向 量 机 模 型 , svmclassify 用 于 对 未 知 类 别 数 据 test 进 行 预 测 , SVMStruct 为 训 练 好 的 支 持 向 量 机模型。数据类型格式如图 2 所示, 输入 向 量 格 式 为 xi= {ai, bi, ci, di };

MATLAB 是 MathWorks 公司于 1982 年推 出 的 一 套 高 性 能 的 数 值 计 算 和 可 视 化 软 件 。它 集 数 值 分 析 、矩 阵 运 算 、

l

. ! ! w, b, c " = 1 2

2

‖w‖ -

ai !yi & <w·x>+b

i=1

/ - 1

", 但由于计

信 号 处 理 和 图 形 显 示 于 一 体 , 构 成 了 一 个 方 便 、界 面 友 好 算 的 复 杂 性 , 一 般 不 直 接 求 解 , 而 是 依 据 拉 格 朗 日 对 偶 理

SVM 可以解决二分类和多分类的问题, 可以考虑使用 Matlab 来实现 SVM 的分类功能。SVM 的训练以及决策时 需要运算大量的数据, 然而 Matlab 在处理大量数据时, 如 果程序的算法不恰当, 程序执行效率是很低的, 运行时间 较长。事实上, 在 Matlab 程序中尽量避免使用循环语句, 而 改用对矩阵的处理, 将会大大提高运算速度。本文就 SVM 在一对一投票法解决多分类问题时 , [3] 遇到的大量数据计 算, 给出了 Matlab 矩阵运算方式的算法。

三、一对一方式的 M- S VM SVM 的方法是针对二分类问题提出的。对于多分类问 题 , 目 前 的 多 分 类 支 持 向 量 机( M- SVM) 主 要 有 俩 方 面 的 方 法[4]: 一是直接求解一个含多类问题的优化问题, 通过适当 的修改求解原始最优化问题, 使它能同时一次性计算出所 有多分类的预测函数, 一次性的进行多类分类。该方法花 费的时间较长, 计算量较大, 求解过程复杂, 没有很广泛的 被应用; 另一个是基于二分类问题算法的, 构造或组建多个二 分类器来实现多分类问题。该方法简单实用, 其中包括一 对多和一对一以及决策树等方式。 一对一分类是在 N 类训练样本中构造所有可能的两 类分类器, 每个分类器仅仅在 N 类中的两类训练样本上训 练, 结果共构造 N( N- 1) /2 个分类器。测试样本经过各个分 类器进行分类, 对所有组合类进行投票, 得票最多的类为 测试样本所属的类。

)

l

ll

. .. +

++maxmise

+ +

ak -

k=1

1 2

ai aj yi yj <xi·xj >

i=1 j=1

*

+

l

+

. ++subject to

+

ai yi =0, ai (0, i=1, …, l

,

i=1

求 解 得 到 的 最 优 解 为 a* =( a1 * , … , al * ) T 这 样 , 计 算 得

result=c1+c2·5+c3·10+c4·16; result 就 是 待 预 测 数 据 test 经 过 三 分 类 后 的 结 果 , 分 别用 1、5、10、16 标出。

性软间隔分类。常用的核函数包括多项式核, 径向基核, 以

现给出两类训练样本集的分类问题

及 Sigmoid 核 等 , 对 于 非 线 性 分 类 , SVM 运 算 只 考 虑 特 征

D= #!x1 , y1 ", …, !x1 , y1 "$, x∈Rn , y∈ # - 1, 1 $

该 问 题 的 分 类 就 是 寻 找 最 优 超 平 面( w, x) +b=0, 使 得

山西煤炭管理 146

干部学院学报

2008.1

图 2 支持向量机数据格式

图 3 各二分类器训练数据格式

利用以上训练数据分别训练 SVM, 可得到三个二分类 器模型, 代码如下:

SVMStruct12=svmtrain( train12, group12) ; SVMStruct23=svmtrain( train23, group23) ; SVMStruct13=svmtrain( train13, group13) ; 接下来就可以用以上三个模型去预测待分类的数据 test, test 的数据格式也和训练数据的类型格 式 一 样 , 所 不 同的是 test 数据是未知类别的。代码如下: class12 = svmclassify( SVMStruct12, test) class23=svmclassify( SVMStruct23, test) class13=svmclassify( SVMStruct13, test) 接下来该解决投票问题了。test 中各输入向量 Xi 的最 终归属类别取决于 class12、class23、class13 的分类情况, 对 于某个输入向量 Xi 的最终归属类别应该是经过 三 个 模 型 预测后, 被预测为类别最多的那个类别。对本文中的三分 类情况, test 中某个 Xi 经过三个模型预测后, 所属类别情 况只可能是图 4 所示的情况。

l

. 标函数改为 求 " ! w, ! " = 1 2

2

‖w‖ +C !i 最 小 , 就 可 以 解

i=1

决样本点线性不可分的情况了。其中, C 为惩罚参数。其求

解方式和线性可分情况几乎完全相同, 只是约束条件变为

二、S VM 基本原理

01ai 1C, 最优预测函数的形式与式( 2) 一样。由于对偶形

支 持 向 量 机 SVM ( Support Vector Machine) 是 AT&TBell 实验室的 V.Vapnik 提出的针对分类和回归问题 的统计学习理论。[2]由于 SVM 方法具有许多引人注目的优 点和有前途的实验性能, 越来越受重视。该技术已成为机 器学习研究领域中的热点, 并取得很理想的效果, 如人脸 识 别 、手 写 体 数 字 识 别 和 网 页 分 类 等 。

干部学院学报

2008.1

线性 SVM 核形式的最优判别函数为

l

! f( x) =sgn( ai * K( x·xi) +b* ) i=1

在具体的实现上, 只要将所要训练 SVM 的 数 据 按 一 定的格式组成输入向量, 对 SVM 进行训练就可 求 得 一 组 参数, 得到一个支持向量机模型, 用得到的 SVM 模 型 去 预 测未知类别的数据( 数据格式同训练数据格式) , 就可得到 分类结果。

的用户环境。Matlab 语言是一种以矩阵和阵列为基本编程 论, 求解以下对偶问题式:

单元, 拥有完整的控制语句、数据结构、函数编写与调用格 式和输入输出功能的编程语言, 相对于其他编程语言来 说 , 在 矩 阵 运 算 、数 据 处 理 和 图 形 显 示 功 能 方 面 Matlab 更 具优势, [1]对于复杂算法可用简洁的脚本式语句编写程序 , 方便快捷。

l

. 到 w* = ai xi yi ; b* =- i=1

1 2

<w* , xr +xs >;

其中 xr , xs 是俩类中

任意的支持 向 量 ( SV)( 依 据 Karush- Kuhn- Tucker 互 补 条

件, 少量最靠近超平面样本点的 ai 值不为零的点, 称为支

持向量) , 最终预测函数为:

基于 MATLAB 的一对一 M- S VM 算 法实现

窦智宙, 孟昭进

( 内蒙古师范大学计算机与信息工程学院, 内蒙古 呼和浩 特 010022)

训练样本集完全正确分开, 同时满足距离超平面最近的两 类点间隔最大( 如图 1 所示) 。

摘要: 简述了多分类支持向量机( Multi- class Support Vector

Machine , M- SVM) 的 原 理 及 算 法 。 在 此 基 础 上 , 利 用

MATLAB 实现了一对一多分类支持向量机的多分类算法,

图 1 最优分类面示意图

利 用 MATLAB 的 矩 阵 处 理 方 式 解 决 了 算 法 中 投 票 机 制 。 该算 法 避 免 了 MATLAB 中 循 环 语 句 的 使 用 , 提 高 了 算 法 效率, 缩短了运行时间。 关键词: MATLAB; 多分类支持向量机; 一对一 中 图 分 类 号 : TP 319 文 献 标 识 码 : A 文 章 编 号 : 1008- 8881( 2008) 01- 0145- 03

l

. f( x) =sgn( ai * y(i x·xi) +b* )

( 2)

i=1

( 二) 线性不可分 SVM

对 于 分 类 问 题 线 性 不 可 分 的 情 况 , 只 要 在( 1) 式 中 引

入 松 驰 项 !i (0, 成 为 yi &<w, xi >+b /(1- !, i=1, … , l 将 目