K-means 聚类算法研究综述

K-means算法研究综述

the Application of Computer Technology •计算机技术应用Electronic Technology & Software Engineering 电子技术与软件工程• 155【关键词】k-means 算法 初始聚类中心 相似性度量 离群点K-means 聚类算法是由Steinhaus 1955 年、Lloyd 1957 年、Ball & Hall 1965 年、McQueen 1967 年分别在各自的不同的科学研究领域独立的提出。

K-means 聚类算法被提出来后,经过多年的实践证明,k-means 算法依然是简单、高效的算法,并且被广泛应用在科学研究以及工业应用中,发展出大量的改进的算法。

目前,k-means 算法仍然是一个研究热点。

K-means 算法的改进主要从以下几个方面:一是如何确定合适的k 值,二是如何选取好的初始聚类中心,三是离群点的检测与去除,四是距离与相似度度量的改进以及其他方面的改进等等。

本文则从以上几个方面对k-means 算法的研究进展进行综述。

本文第一部分介绍传统的k-means 算法,第二部分从各个方面介绍k-means 算法的优化,第三部分进行总结以及展望。

1 传统的k-means算法K-means 算法是一种简单、高效的聚类算法,并得到了广泛的应用。

K-means 算法的基本思想是首先随机选取初始聚类中心,然后计算每个样本点到初始聚类中心的欧式距离,按照距离最近的准则将它们分配给相似度最大的聚类中心所代表的类。

计算每个类别所有样本点的均值,更新聚类中心,直到目标准则函数收敛为止。

具体算法步骤如下:(1)用户输入类簇数目的值k ,从n 个样本点中随机选取k 个点作为初始聚类中心;(2)遍历所有的样本点,计算每个样本点到初始聚类中心的欧式距离,欧氏距离的大K-means 算法研究综述文/丛思安 王星星小作为相似度的评判标准,欧氏距离越小,相似度越大。

k-means算法研究综述

K-means算法研究综述聚类被认为是机器学习中最常使用的技术之一, 它历史悠久、应用广泛,几乎应用于环境学、医学、生物学、天文学、经济学等各个领域。

其中K-means是最为常用的聚类算法。

现在我们来详细介绍一下K-means算法。

1 K-means算法简介K-means算法(Lloyod,1982)是简单而又有效的统计聚类算法,使机器能够将具有相同属性的样本归置到一块儿。

与分类不同,对于一个分类器,通常需要告诉它“这个样本被分成哪些类”这样一些标签,在最理想情况下,一个分类器会从所得到的训练集中进行“学习”,我们将这种提供训练的过程称为“监督学习”。

但是在聚类下,我们并不关心某一类是什么,我们的目的是想将相似的样本归置在一起,这样,一个聚类算法通常只要知道该如何计算样本间的相似度并将相似样本归并到一起就可以操作了,因此聚类通常并不需要使用训练数据进行学习,这在机器学习中被称作“无监督学习”。

K-means算法就是这种用于统计的无监督聚类技术。

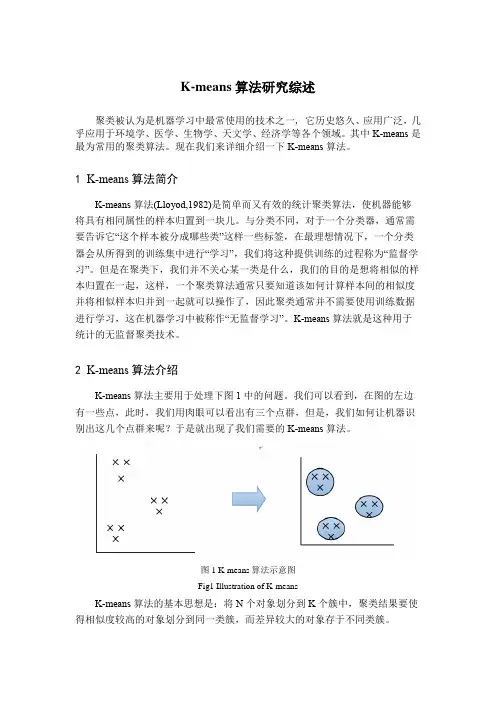

2 K-means算法介绍K-means算法主要用于处理下图1中的问题。

我们可以看到,在图的左边有一些点,此时,我们用肉眼可以看出有三个点群,但是,我们如何让机器识别出这几个点群来呢?于是就出现了我们需要的K-means算法。

图1 K-means算法示意图Fig1 Illustration of K-meansK-means算法的基本思想是:将N个对象划分到K个簇中,聚类结果要使得相似度较高的对象划分到同一类簇,而差异较大的对象存于不同类簇。

K-means算法的基本流程如下表1所示。

表1 K-means算法步骤Tab.1 Training steps of K-meansK-means:输入:训练样本V={v(1),v(2),…,v(n)},v={v1,v2,…,v ni},k:聚类个数;输出:C={C1,C2,…,C k};步骤1 在数据集中随机选取K个对象作为初始聚类中心c1, c2……c k;步骤2 计算数据集中每个对象到聚类中心的距离,选取最小距离min|v- c j|,分配到聚类中,其中v={v1,v2,…,v n},j=1,2……k;步骤3 计算每个聚类中的所有对象均值,将此均值作为新的聚类中心,c j=1 n j ∑X in ji=1,n j为第j类中对象的个数,j=1,2,……k;步骤4 如果每个簇的聚类中心不再发生变化,聚类准则函数J c=∑∑|X i(j)−c j|n ji=1kj=1收敛,则算法结束。

Kmeans聚类算法的研究

Kmeans聚类算法的研究一、概述聚类分析是数据挖掘与机器学习领域中的一种无监督学习方法,旨在将一组数据对象按照其内在相似性或距离度量进行分组,使得同一组内的数据对象尽可能相似,而不同组间的数据对象尽可能相异。

在众多聚类算法中,Kmeans聚类算法因其简洁性、高效性和易于实现等优点而广受关注和应用。

Kmeans算法通过迭代优化数据点的划分,使得每个数据点都归属于最近的聚类中心,并不断更新聚类中心的位置,直到满足终止条件。

本文将对Kmeans聚类算法进行深入研究,探讨其基本原理、算法流程、优缺点以及在实际应用中的挑战与改进策略,以期为相关领域的研究者与实践者提供有益的参考和启示。

1. 聚类分析简介聚类分析是一种无监督的机器学习技术,其主要目的是将数据集中的对象或数据点划分为多个类或簇,使得同一簇内的数据点尽可能相似,而不同簇之间的数据点尽可能不同。

这种技术广泛应用于数据挖掘、模式识别、图像处理、生物信息学等多个领域。

聚类分析的基本思想是通过某种相似性度量方法,如距离度量或密度度量,来确定数据点之间的相似性或亲疏关系。

根据这些关系,聚类算法将数据点逐步合并成不同的簇,直到满足某种停止条件或达到预定的簇数量。

在众多聚类算法中,Kmeans算法是一种广受欢迎且简单易懂的算法。

它的核心思想是通过迭代的方式,将数据集划分为K个簇,并使得每个簇内数据点的平均距离(即簇内误差平方和)最小。

Kmeans 算法具有计算效率高、可解释性强等优点,因此在许多实际应用中得到了广泛应用。

Kmeans算法也存在一些局限性,如需要事先指定簇的数量K、对初始簇中心的选择敏感、容易陷入局部最优解等。

在实际应用中,需要结合具体的数据特点和问题背景,选择合适的聚类算法,并进行相应的参数调整和优化。

聚类分析是一种重要的数据分析工具,它可以帮助我们发现数据中的潜在结构和规律,为后续的数据挖掘和决策支持提供有力的支持。

而Kmeans算法作为其中的一种经典算法,具有广泛的应用前景和研究价值。

K-means聚类算法研究

个数据对象作为初始的聚类中心 , 初 始的代表一个 聚类 。对于剩下的其他数据集 。 则分别计算它们 到 这些聚类中心的相似度 ( 以欧 氏距离作 为相似度 测 量准则) ,并根据最短距离将每个数据对象赋给 各 个聚类中心 。然后再计算新获得 的每一个聚类的距 离平均值得 到新 的聚类 中心 , 如果连续两次计算 出

进 行 了详 细 的分析 。

关键词 : 聚类分析 ; K — m e a n s 算法 中图分类号 : T P 3 1 1 文献标识码 : A 文章编号 : 1 6 7 2 - 4 4 7 X ( 2 0 1 3 ) 0 5 - 0 0 1 7 - 0 3 文 采 用 Ma l t a b 7 . 0实 现 了 K- me a n s 聚 类 算

法, 下面这个例子 , 显示 K - me a d s 聚类算法对于一 组二维数据集合 的聚类效果。

输入 : 包含 n 个数据对象的集合置,

x ={ X l , x 2 , … , X n }

b e i g n f o r j = 1 t o k d o

c o m p u t e D ( , z j ) = x i 一 l; / / 计算剩下的数

据对象到各聚类中心的距离 i f D ( , z ) = m i n { D ( X i Z ) } t h e n ∈ C j ; / / 根 据最 短距离将数据对象分类

J 已经收敛 , 聚类算法结束。通常采用平方误差准则

函数 作为 聚类目 标准则, 即 . , = ∑ : 。 ∑ 鹇I P 一 『,

∑g z 。 是分类 的中心 , 即 = 。 的数据 , 可以降低数据量及计算量 , 并可 以避免 杂 p是一个数据 对象 , ¨ 一,目 质的不 良影响。 上述算法的特 点是首先必须指定 k个初 始聚类 中 本 文简要介绍了 K - me a n s 聚类算法 的算法流 心, 然后借着 反复迭代运算 , 逐次降低 目标准则函 程, 复杂度 , 并用 Ma d a b实现 , 根据实验结果分析 了

K-means聚类算法的研究共3篇

K-means聚类算法的研究共3篇K-means聚类算法的研究1K-means聚类算法的研究聚类是数据挖掘和统计分析领域中非常重要的方法,它能够从大量的数据中抽象出有意义的类别。

K-means聚类算法是一个经典的聚类算法,它的思想简单而有效,广泛应用于数据分析、图像处理、生物信息学等领域。

本文将从算法原理、优缺点、应用及改进等方面进行研究和探讨。

一、算法原理K-means算法是一种基于距离的聚类算法,其基本原理是将数据点划分到k个不同的簇中,使得簇内的数据点尽可能相似,而簇间的数据点尽可能不同。

具体步骤如下:1. 随机选择k个中心点(centroid)作为初始的聚类中心。

2. 对于每个数据点,计算其到各个聚类中心的距离,并将其归类到距离最近的簇中。

3. 对于每个簇,重新计算其聚类中心,即为该簇内所有数据点的平均值。

4. 重复执行步骤2和3,直到聚类中心不再改变,或达到预设的迭代次数。

二、优缺点K-means算法具有以下优缺点:优点:1. 算法简单、易于实现和理解,计算速度快,适用于大规模数据。

2. 对于点密集的数据集,聚类效果较好。

3. 可以很好地处理凸型和球型簇。

缺点:1. K值需要事先确定,不确定时需要多次试验,计算量大。

2. 算法容易陷入局部最优解,结果不稳定,可能需要多次运行来得到最优解。

3. 对于噪声和离群点的敏感度较高。

三、应用K-means算法适用于以下数据挖掘任务:1. 分类问题:根据数据的属性特征将其划分到不同的组别,如客户分群、市场分析等。

2. 图像分割:将图像中的像素点划分到不同的区域,实现图像分割。

3. 地质勘探:对地面的物质进行分离和分类,例如岩性分类、照片过滤等。

4. 生物信息学:对基因序列进行聚类分析,以发现有共性的基因序列。

四、改进K-means算法有许多改进算法,尝试解决其缺点和不足,如以下算法:1. K-means++算法:改进了初始聚类中心的选择方法,使得聚类结果更加稳定和准确。

请简述k-means算法的主要步骤、及其优缺点。

请简述k-means算法的主要步骤、及其优缺点。

K-means算法是一种经典的聚类算法,用于将样本数据集划分为K个不相交的聚类。

这种算法的主要步骤包括初始化聚类中心、计算样本与聚类中心的距离、更新聚类中心、重复计算直至收敛。

其优点包括算法简单高效、可扩展性强,但也存在缺点,如初始聚类中心的选择对结果影响较大。

下面将详细介绍K-means算法的主要步骤及其优缺点。

1.初始化聚类中心:首先,需要确定聚类数K,并随机选择K个样本作为初始聚类中心。

这些初始聚类中心代表了K个聚类的质心。

2.计算样本与聚类中心的距离:对于每个样本,计算其与每个聚类中心的距离,并将样本分配到与其距离最近的聚类中心所对应的类别中。

距离通常采用欧氏距离或曼哈顿距离来衡量。

3.更新聚类中心:对于每个聚类,计算该聚类内所有样本的均值,并将均值作为新的聚类中心。

这样,每个聚类的中心会根据当前样本的分配情况得到更新。

4.重复计算直至收敛:重复步骤2和步骤3,直到聚类中心不再发生变化,即算法收敛。

此时,得到K个聚类,每个样本属于其中一个聚类。

算法的收敛条件可以是聚类中心不再发生明显变化,或者达到预定义的最大迭代次数。

K-means算法的优点如下:1.简单高效:K-means算法是一种基于迭代的聚类算法,具有简单的操作步骤和高效的计算性能。

算法复杂度为O(tkn),其中t为迭代次数,k为聚类数,n为样本数。

2.可扩展性强:K-means算法适用于大规模数据集,可以通过增加计算资源来提高算法的计算速度。

3.容易理解和实现:K-means算法基于距离度量进行样本分类,原理直观且易于理解。

其算法流程简单,可以方便地实现。

4.聚类结果可解释性强:K-means算法得到的聚类结果通常可以较好地解释数据特征,对于数据的分析和可视化具有一定的帮助。

K-means算法的缺点如下:1.对初始聚类中心的选择敏感:初始聚类中心的选择会对最终的聚类结果产生较大影响。

k-means聚类算法研究及应用

k-means聚类算法研究及应用

K-means聚类算法研究及应用

一、简介

K-means聚类算法是一种非监督学习算法,它是一种广泛应用在模式分类和无监督式学习的数据挖掘技术。

它使用了基于距离的聚类算法,以相似性作为衡量子簇类别的标准,任务是将样本(属性)空间中的数据分为K个不同的类,使聚类的误差平方和最小化:通常假设样本由簇中心所处的子空间所构建,每个子空间由一个簇中心控制,因此K-means算法常常被形象地称为“均值聚类”算法。

二、原理

K-means聚类算法是一种迭代算法,它的基本思想是:首先,随机选取若干个“簇中心”,然后将其他的数据点根据其与“簇中心”的距离,归到最近的“簇中心”所代表的簇中。

然后根据新聚集的簇,重新更新这些“簇中心”;如此不断迭代,最终计算得到一组稳定的“簇中心”,这组“簇中心”所代表的簇就是最后的结果了。

三、应用

1、生物信息学:K-means聚类算法用于基因芯片和定量PCR,以及蛋白质表达数据。

2、计算机视觉:K-means用于图像分割,聚类,像素重新分配等。

3、自然语言处理:K-means用于文本聚类,文档分类,文本挖掘等方面。

4、机器学习:K-means用于各种拟合问题,比如参数估计,探索异常

值等等。

四、总结

K-means聚类算法是一种简单高效的聚类算法,它可以有效地将数据空间分割成几个簇,属于非监督学习算法,它的核心在于划分数据空间,对数据的模式分类和无监督式学习有较好的应用,如生物信息学、计

算机视觉、自然语言处理、机器学习等领域。

k-means聚类算法的研究全解

k-means聚类算法的研究1.k-means算法简介1.1 k-means算法描述给定n个对象的数据集D和要生成的簇数目k,划分算法将对象组织划分为k个簇(k<=n),这些簇的形成旨在优化一个目标准则。

例如,基于距离的差异性函数,使得根据数据集的属性,在同一个簇中的对象是“相似的”,而不同簇中的对象是“相异的”。

划分聚类算法需要预先指定簇数目或簇中心,通过反复迭代运算,逐步降低目标函数的误差值,当目标函数收敛时,得到最终聚类结果。

这类方法分为基于质心的(Centroid-based)划分方法和基于中心的(Medoid-based)划分方法,而基于质心的划分方法是研究最多的算法,其中k-means算法是最具代表和知名的。

k-means算法是1967年由MacQueen首次提出的一种经典算法,经常用于数据挖掘和模式识别中,是一种无监督式的学习算法,其使用目的是对几何进行等价类的划分,即对一组具有相同数据结构的记录按某种分类准则进行分类,以获取若干个同类记录集。

k-means聚类是近年来数据挖掘学科的一个研究热点和重点,这主要是因为它广泛应用于地球科学、信息技术、决策科学、医学、行为学和商业智能等领域。

迄今为止,很多聚类任务都选择该算法。

k-means算法是应用最为广泛的聚类算法。

该算法以类中各样本的加权均值(成为质心)代表该类,只用于数字属性数据的聚类,算法有很清晰的几何和统计意义,但抗干扰性较差。

通常以各种样本与其质心欧几里德距离总和作为目标函数,也可将目标函数修改为各类中任意两点间欧几里德距离总和,这样既考虑了类的分散度也考虑了类的紧致度。

k-means算法是聚类分析中基于原型的划分聚类的应用算法。

如果将目标函数看成分布归一化混合模型的似然率对数,k-means算法就可以看成概率模型算法的推广。

k-means算法基本思想:(1)随机的选K个点作为聚类中心;(2)划分剩余的点;(3)迭代过程需要一个收敛准则,此次采用平均误差准则。

k-means聚类算法的研究和应用

k-means聚类算法的研究和应用

K-Means聚类算法是一种用于数据挖掘和分类的有效的机器学习技术。

它的思想是一

组数据通过K个类别自动划分,这使得它可以迅速地确定大量数据中具有相似特征的数据,并将其分类、聚合到相应类别中。

K-Means聚类算法运行是一种迭代过程,逐步优化结果,使用随机初始值来确定K个

类别的中心以及与中心的距离。

在每次迭代的过程中,都会调整这K个类别的中心,以最

大程度减小数据集之间的差异。

K-Means聚类算法最终得出的结果是K个类别,每个类别

有一个中心点表示其特征,并将数据集中所有其他数据点分布在各自的类别中。

K-Means聚类算法在机器学习中应用广泛,在电影推荐、搜索引擎技术、知识挖掘、

银行推荐系统等领域有着重要的应用。

目前,已经开发出许多尝试克服K-Means聚类带来

的问题的方法,如K-Means++聚类算法、改进的K-Means聚类算法和随机K-Means聚类算

法等。

这些研究和应用加深了人们对K-Means聚类算法的理解,使得它被用于不同的领域,提高了它的分类准确性,帮助企业提高效率。

k-means聚类算法实验总结

K-means聚类算法实验总结在本次实验中,我们深入研究了K-means聚类算法,对其原理、实现细节和优化方法进行了探讨。

K-means聚类是一种无监督学习方法,旨在将数据集划分为K个集群,使得同一集群内的数据点尽可能相似,不同集群的数据点尽可能不同。

实验步骤如下:1. 数据准备:选择合适的数据集,可以是二维平面上的点集、图像分割、文本聚类等。

本实验中,我们采用了二维平面上的随机点集作为示例数据。

2. 初始化:随机选择K个数据点作为初始聚类中心。

3. 迭代过程:对于每个数据点,根据其与聚类中心的距离,将其分配给最近的聚类中心所在的集群。

然后,重新计算每个集群的聚类中心,更新聚类中心的位置。

重复此过程直到聚类中心不再发生明显变化或达到预设的迭代次数。

4. 结果评估:通过计算不同指标(如轮廓系数、Davies-Bouldin指数等)来评估聚类效果。

实验结果如下:1. K-means聚类能够有效地将数据点划分为不同的集群。

通过不断迭代,聚类中心逐渐趋于稳定,同一集群内的数据点逐渐聚集在一起。

2. 在实验中,我们发现初始聚类中心的选择对最终的聚类结果有一定影响。

为了获得更好的聚类效果,可以采用多种初始聚类中心并选择最优结果。

3. 对于非凸数据集,K-means算法可能会陷入局部最优解,导致聚类效果不佳。

为了解决这一问题,可以考虑采用其他聚类算法,如DBSCAN、层次聚类等。

4. 在处理大规模数据集时,K-means算法的时间复杂度和空间复杂度较高,需要进行优化。

可以采用降维技术、近似算法等方法来提高算法的效率。

通过本次实验,我们深入了解了K-means聚类算法的原理和实现细节,掌握了其优缺点和适用场景。

在实际应用中,需要根据数据集的特点和需求选择合适的聚类算法,以达到最佳的聚类效果。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

K -means 聚类算法研究综述摘要:总结评述了K -means 聚类算法的研究现状,指出K -means 聚类算法是一个NP 难优化问题,无法获得全局最优。

介绍了K -means 聚类算法的目标函数,算法流程,并列举了一个实例,指出了数据子集的数目K ,初始聚类中心选取,相似性度量和距离矩阵为K -means 聚类算法的3个基本参数。

总结了K -means 聚类算法存在的问题及其改进算法,指出了K -means 聚类的进一步研究方向。

关键词:K -means 聚类算法;NP 难优化问题;数据子集的数目K ;初始聚类中心选取;相似性度量和距离矩阵Review of K-means clustering algorithmAbstract: K-means clustering algorithm is reviewed. K-means clustering algorithm is a NP hard optimal problem and global optimal result cannot be reached. The goal , main steps and example of K-means clustering algorithm are introduced. K-means algorithm requires three user-specified parameters: number of clusters K , cluster initialization , and distance metric. Problems and improvement of K-means clustering algorithm are summarized then. Further study directions of K-means clustering algorithm are pointed at last.Key words: K-means clustering algorithm; NP hard optimal problem; number of clusters K; cluster initialization; distance metricK -means 聚类算法是由Steinhaus 1955年、Lloyed 1957年、Ball & Hall 1965年、McQueen 1967年分别在各自的不同的科学研究领域独立的提出。

K -means 聚类算法被提出来后,在不同的学科领域被广泛研究和应用,并发展出大量不同的改进算法。

虽然K -means 聚类算法被提出已经超过50年了,但目前仍然是应用最广泛的划分聚类算法之一[1]。

容易实施、简单、高效、成功的应用案例和经验是其仍然流行的主要原因。

文中总结评述了K -means 聚类算法的研究现状,指出K -means 聚类算法是一个NP 难优化问题,无法获得全局最优。

介绍了K -means 聚类算法的目标函数、算法流程,并列举了一个实例,指出了数据子集的数目 K 、初始聚类中心选取、相似性度量和距离矩阵为K -means 聚类算法的3个基本参数。

总结了K -means 聚类算法存在的问题及其改进算法,指出了K -means 聚类的进一步研究方向。

1经典K -means 聚类算法简介1.1 K -means 聚类算法的目标函数对于给定的一个包含n 个 d 维数据点的数据集12{x ,x ,,x ,,x }i n X =⋅⋅⋅⋅⋅⋅,其中d i x R ∈,以及要生成的数据子集的数目K ,K -means 聚类算法将数据对象组织为K 个划分{c ,i 1,2,}k C K ==⋅⋅⋅。

每个划分代表一个类c k ,每个类c k 有一个类别中心i μ。

选取欧氏距离作为相似性和距离判断准则,计算该类内各点到聚类中心i μ的距离平方和2(c )i ik i kx C J x μ∈=-∑(1)聚类目标是使各类总的距离平方和1(C)(c)Kkk J J ==∑最小。

221111(C)(c )i iK KK nk i kki i k k k x C k i J J x d x μμ==∈====-=-∑∑∑∑∑(2)其中,10i ikii ix c d x c ∈⎧=⎨∉⎩若若 ,显然,根据最小二乘法和拉格朗日原理,聚类中心k μ应该取为类别k c 类各数据点的平均值。

K -means 聚类算法从一个初始的K 类别划分开始 ,然后将各数据点指派到各个类别中,以减小总的距离平方和。

因为K -means 聚类算法中总的距离平方和随着类别个数K 的增加而趋向于减小(当K n =时,(C)0J =)。

因此,总的距离平方和只能在某个确定的类别个数K 下,取得最小值。

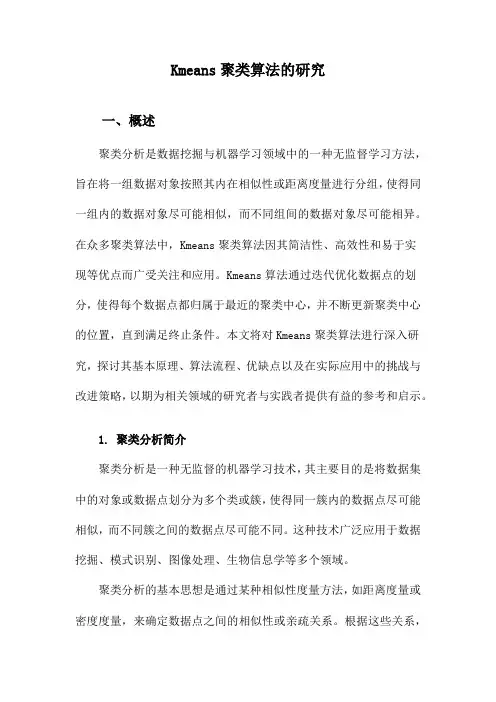

1.2 K -means 算法的算法流程K -means 算法是一个反复迭代过程,目的是使聚类域中所有的样品到聚类中心距离的平方和(C)J 最小,算法流程包括4个步骤[1],具体流程图如图1所示。

图1K-means聚类算法流程图Fig.1Steps of K-means clustering algorithm1.3K-means聚类算法实例图2显示的是K-means算法将一个2维数据集聚成3类的过程示意图。

2K-means聚类算法是一个NP难优化问题K-means聚类算法是一个NP难优化问题吗?在某个确定的类别个数K下,在多项式时间内,最小的总距离平方和(C)J值和对应的聚类划分能否得到?目前,不同的学者有不同的答案。

Aristidis Likas等人[2]认为在多项式时间内最小的值和对应的聚类划分能够得到,并于2002年提出了全局最优的K-means聚类算法。

但给出的“The global K-means clusteringalgorithm”只有初始聚类中心选取的算法步骤,而缺乏理论证明。

很快,pierre Hansen等人[3]就提出“The global K-meansclustering algorithm”不过是一个启发式增量算法,并不能保证得到全局最优,文章最后还给出了反例。

很多学者指出,如果数据点的维数1d=,最小的总距离平方和(C)J值和对应的聚类划分能够在2(Kn)O时间内使用动态规划获得,例如Bellman and Dreyfus[4]。

PierreHansen等人[3]认为,K-means聚类算法时间复杂度未知。

但是,更多的学者认为,对于一般的数据维数d和类别个数K,K-means聚类算法是一个NP难优化问题[5]。

SanjoyDasgupta等人认为即使在类别个数K=2的情况下,K-means聚类算法也是一个NP难优化问题。

Meena Mahajan等人[6]认为即使在数据点的维数2d=下,对于平面的K-means聚类问题,也是NP难的。

本研究也认为,对于一般的数据维数d和类别个数K,K-means聚类算法是一个NP难优化问题。

K-means聚类算法是一个贪心算法,在多项式时间内,仅能获得局部最优,而不可能获得全局最优。

(a)将被分成3类的2维原始输入数据 (b) 选择3个种子数据点作为3个类的初始聚类中心(a) two-dimensional input data with three clusters (b) Three seed points selected as cluster centers and initial assignmentof the data points to clusters(c)更新聚类类别和类别中心的第二次迭代过程 (d)更新聚类类别和类别中心的第3次的迭代过程 (e)K-means聚类算法收敛所获得的最终聚类结果(c) step two of intermediate literations updating (d)Step three of intermediate iterations updating (e)final clustering obtained by K-means algorithm cluster labels and their centers cluster labels and their centers at convergence图2K-means算法示意图Fig.2Illustration of K-means algorithm3K-means聚类算法的参数及其改进K-means聚类算法需要用户指定3个参数:类别个数K,初始聚类中心、相似性和距离度量。

针对这3个参数,K-means聚类算法出现了不同的改进和变种。

3.1类别个数KK-means聚类算法最被人所诟病的是类别个数K的选择。

因为缺少严格的数学准则,学者们提出了大量的启发式和贪婪准则来选择类别个数K。

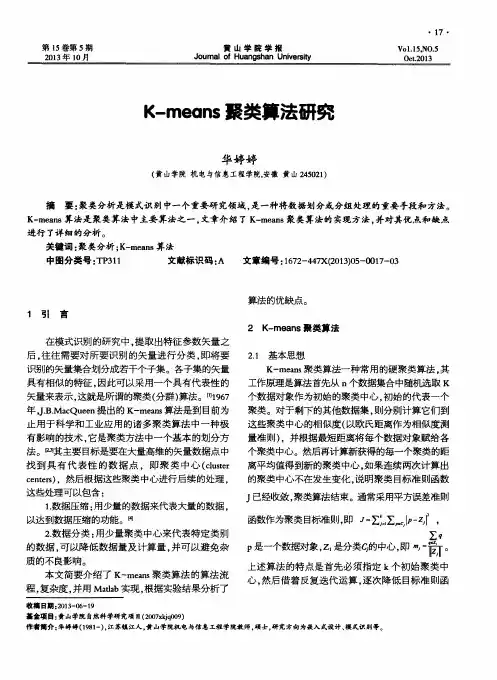

最有代表性的是,令K逐渐增加,如1,2,K=⋅⋅⋅,因为K-means聚类算法中总的距离平方和J随着类别个数K的增加而单调减少。

最初由于K较小,类型的分裂(增加)会使J值迅速减小,但当K增加到一定数值时,J值减小速度会减慢,直到当K等于总样本数N时,0J=,这时意味着每类样本自成一类,每个样本就是聚类中心。

如图3所示,曲线的拐点A对应着接近最优的K值,最优K值是对J值减小量、计算量以及分类效果等进行权衡得出的结果。

而在实际应用中,经常对同一数据集,取不同的K值,独立运行K-means聚类算法,然后由领域专家选取最有意义的聚类划分结果。

图3J-K关系曲线Fig.3Relationship curve between J and K并非所有的情况都容易找到J-K关系曲线的拐点,此时K值将无法确定。

对类别个数K的选择改进的算法是Ball & Hall[7]于1965年提出的迭代自组织的数据分析算法(Iterative Self-organizing Data Analysis Technique Algorithm, ISODA TA),该算法在运算的过程中聚类中心的数目不是固定不变的,而是反复进行修改,以得到较合理的类别数K,这种修改通过模式类的合并和分裂来实现,合并与分裂在一组预先选定的参数指导下进行。

3.2初始聚类中心的选取越来越多的学者倾向于认为最小化总距离平方和(C)J值和对应的聚类划分是一个NP难优化问题。

因此,K-means聚类算法是一个贪心算法,在多项式时间内,仅能获得局部最优。

而不同的初始聚类中心选取方法得到的最终局部最优结果不同。

因此,大量的初始聚类中心选取方案被提出。

经典的K-means聚类算法的初始聚类中心是随机选取的。