nginx 负载均衡宕机配置

nginx负载均衡 规则

nginx负载均衡规则Nginx 负载均衡规则Nginx 是一个高性能的开源 Web 服务器和反向代理服务器。

它能够通过负载均衡技术,将流量分发到多台服务器上,提高系统的可靠性和性能。

在进行 Nginx 负载均衡配置时,需要遵循一些规则和原则,以确保系统正常运行。

1. 选择合适的负载均衡算法:Nginx 支持多种负载均衡算法,如轮询、IP 哈希、最小连接数等。

根据实际需求选择合适的算法。

轮询算法会按顺序将请求分发到每台服务器,适用于服务器性能相近的情况;IP 哈希算法会根据客户端 IP 地址将请求分发到特定的服务器,适用于需要保持会话的场景;最小连接数算法会将请求发送到当前连接数最少的服务器上,适用于服务器性能差异较大的情况。

2. 配置健康检查:为了确保分发到的流量都是发送到可用的服务器上,可以配置健康检查。

Nginx 能够定期检查后端服务器的可用性,并根据检查结果调整请求的分发。

如果某个服务器无法正常响应,将会暂时从请求池中剔除,直到恢复正常。

3. 设置会话保持:对于需要保持会话的应用,可以配置会话保持功能。

Nginx能够将来自同一个客户端的请求发送到同一台服务器上,确保会话信息的连续性和一致性。

通过设置相同的会话 Cookie,Nginx 可以将请求与正确的后端服务器关联起来。

4. 动态调整权重:如果后端服务器的性能存在差异,可以通过调整权重实现动态负载均衡。

Nginx 允许为每台服务器配置一个权重值,数值越高表示分配的请求越多。

根据服务器的实时负载情况和性能状况,可以动态调整权重,使得服务器能够更加均衡地处理流量。

5. 配置缓存:对于一些静态资源,可以配置缓存以减轻后端服务器的压力。

Nginx 可以将静态文件缓存在内存中,或者在磁盘上建立静态文件缓存,通过直接返回缓存的数据,减少对后端服务器的请求。

Nginx 负载均衡功能强大灵活,通过合理地配置规则,可以提高系统的性能、稳定性和可靠性。

特别是在高并发场景下,利用 Nginx 的负载均衡功能,能够更好地满足用户需求。

nginx负载均衡配置,宕机自动切换方式

nginx负载均衡配置,宕机⾃动切换⽅式严格来说,nginx⾃带是没有针对负载均衡后端节点的健康检查的,但是可以通过默认⾃带的ngx_http_proxy_module模块和ngx_http_upstream_module模块中的相关指令来完成当后端节点出现故障时,⾃动切换到健康节点来提供访问。

下⾯列出这两个模块中相关的指令:语法: proxy_connect_timeout time;默认值: proxy_connect_timeout 60s;设置与后端服务器建⽴连接的超时时间。

应该注意这个超时⼀般不可能⼤于75秒。

语法: proxy_read_timeout time;默认值: proxy_read_timeout 60s;定义从后端服务器读取响应的超时。

此超时是指相邻两次读操作之间的最长时间间隔,⽽不是整个响应传输完成的最长时间。

如果后端服务器在超时时间段内没有传输任何数据,连接将被关闭。

利⽤nginx_upstream_check_module模块对后端节点做健康检查在nginx.conf配置⽂件⾥⾯的upstream加⼊健康检查,如下:upstream name {server 192.168.0.21:80;server 192.168.0.22:80;check interval=3000 rise=2 fall=5 timeout=1000 type=http;}上⾯配置的意思是,对name这个负载均衡条⽬中的所有节点,每个3秒检测⼀次,请求2次正常则标记realserver状态为up,如果检测 5 次都失败,则标记 realserver的状态为down,超时时间为1秒。

这⾥列出nginx_upstream_check_module模块所⽀持的指令意思:Syntax: check interval=milliseconds [fall=count] [rise=count] [timeout=milliseconds] [default_down=true|false][type=tcp|http|ssl_hello|mysql|ajp] [port=check_port]Default: 如果没有配置参数,默认值是:interval=30000 fall=5 rise=2 timeout=1000 default_down=true type=tcpContext: upstream该指令可以打开后端服务器的健康检查功能。

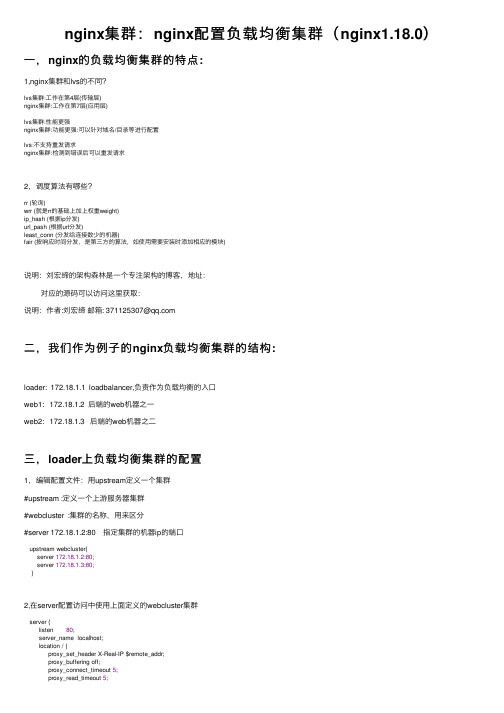

nginx集群:nginx配置负载均衡集群(nginx1.18.0)

nginx集群:nginx配置负载均衡集群(nginx1.18.0)⼀,nginx的负载均衡集群的特点:1,nginx集群和lvs的不同?lvs集群:⼯作在第4层(传输层)nginx集群:⼯作在第7层(应⽤层)lvs集群:性能更强nginx集群:功能更强:可以针对域名/⽬录等进⾏配置lvs:不⽀持重发请求nginx集群:检测到错误后可以重发请求2,调度算法有哪些?rr (轮询)wrr (就是rr的基础上加上权重weight)ip_hash (根据ip分发)url_pash (根据url分发)least_conn (分发给连接数少的机器)fair (按响应时间分发,是第三⽅的算法,如使⽤需要安装时添加相应的模块)说明:刘宏缔的架构森林是⼀个专注架构的博客,地址:对应的源码可以访问这⾥获取:说明:作者:刘宏缔邮箱: 371125307@⼆,我们作为例⼦的nginx负载均衡集群的结构:loader: 172.18.1.1 loadbalancer,负责作为负载均衡的⼊⼝web1: 172.18.1.2 后端的web机器之⼀web2: 172.18.1.3 后端的web机器之⼆三,loader上负载均衡集群的配置1,编辑配置⽂件:⽤upstream定义⼀个集群#upstream :定义⼀个上游服务器集群#webcluster :集群的名称,⽤来区分#server 172.18.1.2:80 指定集群的机器ip的端⼝upstream webcluster{server 172.18.1.2:80;server 172.18.1.3:80;}2,在server配置访问中使⽤上⾯定义的webcluster集群server {listen 80;server_name localhost;location / {proxy_set_header X-Real-IP $remote_addr;proxy_buffering off;proxy_connect_timeout 5;proxy_read_timeout 5;proxy_send_timeout 5;proxy_pass http://webcluster;}}3,配置中各个指令的说明:proxy_pass将代理转发给上⽅ upstream 中配置的集群中的两台服务器去处理X-Real-IP⽤来得到真实ip,否则在后端看到的都是loader的ipproxy_set_header X-Real-IP $remote_addr;proxy_buffering默认值是on,这⾥我们把它关闭,off它负责开启从后端被代理服务器的响应body缓冲,我们需要从后端服务器按收实时的数据,所以关闭proxy_connect_timeout该指令设置与upstream server的连接超时时间,默认值60s,最⾼不能超过75秒注意这个不是等待后端返回页⾯的时间(那个时长是由proxy_read_timeout变量来定义)。

Nginx负载均衡

Nginx负载均衡:由理论到实践Nginx负载均衡的应用很广,很多场景下都在使用这种架构。

环境如下:192.168.1.100 (master node) server1192.168.1.109 (slave) server2192.168.1.106 (slave) server3安装nginx在上面三台服务器上,分别安装nginxyum install nginx配置nginx在上面三台服务器上,分别配置nginxuser nginx;worker_processes 1;error_log /var/log/nginx_error.log crit;worker_rlimit_nofile 8192;events {worker_connections 1024; # you might need to increase this setting for busy serversuse epoll; # Linux kernels 2.6.x change to epoll}http {server_names_hash_max_size 2048;server_names_hash_bucket_size 512;server_tokens off;include mime.types;default_type application/octet-stream;sendfile on;tcp_nopush on;tcp_nodelay on;keepalive_timeout 10;# Gzip ongzip on;gzip_min_length 1100;gzip_buffers 4 32k;gzip_types text/plain application/x-javascript text/xml text/css;ignore_invalid_headers on;client_max_body_size 8m;client_header_timeout 3m;client_body_timeout 3m;send_timeout 3m;connection_pool_size 256;client_header_buffer_size 4k;large_client_header_buffers 4 64k;request_pool_size 4k;output_buffers 4 32k;postpone_output 1460;# Cache most accessed static filesopen_file_cache max=10000 inactive=10m;open_file_cache_valid 2m;open_file_cache_min_uses 1;open_file_cache_errors on;# Include each virtual hostinclude "/etc/nginx/conf.d/*.conf";配置虚拟主机在server2和server3上nano -w /etc/nginx/conf.d/.confserver {access_log off;error_log /var/log/-error.log;listen 80;server_name ;location~* .(gif|jpg|jpeg|png|ico|wmv|3gp|avi|mpg|mpeg|mp4|flv|mp3|mid|js|css |wml|swf)$ {root /var/www/;expires max;add_header Pragma public;add_header Cache-Control "public, must-revalidate, proxy-revalidate";}location / {root /var/www/;index index.php index.html index.htm;}}在server1上nano -w /etc/nginx/conf.d/.confupstream balancer {server 192.168.1.100:80 ;server 192.168.1.106:80 ;server {listen 192.168.1.100:80;server_name ;error_log /var/log/-error.log;location / {proxy_pass http://balancer;}}重启nginxservice nginx restartDNS记录 IN A 192.168.1.100www IN A 192.168.1.100如果仅仅是为了测试,直接绑定hosts文件。

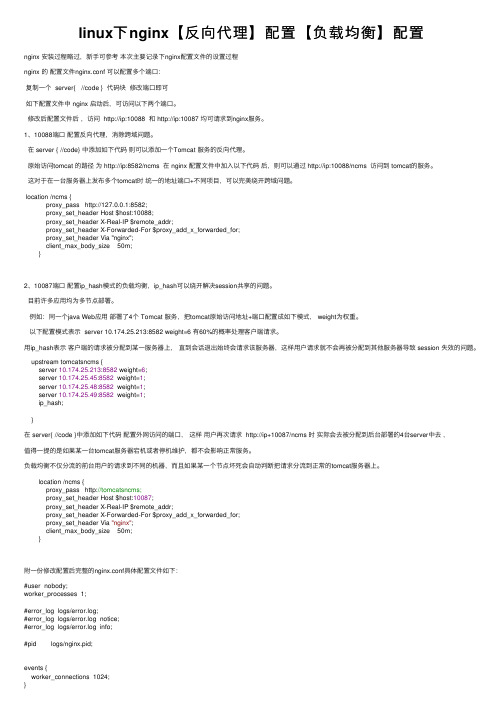

linux下nginx【反向代理】配置【负载均衡】配置

linux下nginx【反向代理】配置【负载均衡】配置nginx 安装过程略过,新⼿可参考本次主要记录下nginx配置⽂件的设置过程nginx 的配置⽂件nginx.conf 可以配置多个端⼝:复制⼀个 server{ //code } 代码块修改端⼝即可如下配置⽂件中 nginx 启动后,可访问以下两个端⼝。

修改后配置⽂件后,访问 http://ip:10088 和 http://ip:10087 均可请求到nginx服务。

1、10088端⼝配置反向代理,消除跨域问题。

在 server { //code} 中添加如下代码则可以添加⼀个Tomcat 服务的反向代理。

原始访问tomcat 的路径为 http://ip:8582/ncms 在 nginx 配置⽂件中加⼊以下代码后,则可以通过 http://ip:10088/ncms 访问到 tomcat的服务。

这对于在⼀台服务器上发布多个tomcat时统⼀的地址端⼝+不同项⽬,可以完美绕开跨域问题。

location /ncms {proxy_pass http://127.0.0.1:8582;proxy_set_header Host $host:10088;proxy_set_header X-Real-IP $remote_addr;proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;proxy_set_header Via "nginx";client_max_body_size 50m;}2、10087端⼝配置ip_hash模式的负载均衡,ip_hash可以绕开解决session共享的问题。

⽬前许多应⽤均为多节点部署。

例如:同⼀个java Web应⽤部署了4个 Tomcat 服务,把tomcat原始访问地址+端⼝配置成如下模式, weight为权重。

以下配置模式表⽰ server 10.174.25.213:8582 weight=6 有60%的概率处理客户端请求。

学会使用Nginx进行Web服务器配置和负载均衡

学会使用Nginx进行Web服务器配置和负载均衡Nginx(发音为engine-x)是一个高性能的开源Web服务器。

它被广泛应用于构建高性能和可靠的网站,实现负载均衡,进行反向代理,以及提供动态内容的缓存。

本文将介绍如何使用Nginx 进行Web服务器配置和负载均衡。

第一章:Nginx简介Nginx是一款轻量级的服务器,它具有卓越的性能和可扩展性。

与传统的Web服务器相比,Nginx采用了事件驱动的架构,能够处理大量的并发请求,同时占用较少的系统资源。

此外,Nginx还支持高级功能如负载均衡、反向代理和HTTPS。

第二章:安装和配置Nginx安装Nginx非常简单。

在Linux系统中,可以通过包管理器(如apt-get或yum)进行安装。

一旦安装完成,我们需要对Nginx进行基本配置。

首先,我们需要编辑Nginx的主配置文件,通常位于/etc/nginx/nginx.conf。

在此文件中,我们可以配置Nginx的全局设置,如监听的端口、日志文件的位置等。

我们还可以创建一个新的配置文件,用于特定的虚拟主机。

第三章:配置虚拟主机Nginx支持多个虚拟主机配置,每个虚拟主机都可以有独立的设置和规则。

为了配置虚拟主机,我们需要在Nginx的配置文件中添加server块。

在server块中,我们可以指定虚拟主机的监听端口、域名以及其他相关设置。

此外,我们还可以使用location块来定义URL路径的匹配规则,并指定相应的动作。

例如,我们可以将所有以/api 开头的请求转发到后端API服务器。

第四章:负载均衡负载均衡是将请求分发到多个服务器上,以实现更好的性能和可用性。

Nginx提供了多种负载均衡策略,如轮询、加权轮询和IP哈希。

要配置负载均衡,我们需要在Nginx的配置文件中添加upstream块。

在upstream块中,我们可以列出多个后端服务器,并为每个服务器指定权重。

然后,我们将这个upstream块与虚拟主机的location块关联起来,以实现请求的负载均衡。

NGINX负载均衡实战教程

NGINX负载均衡实战教程nginx调度算法解析1、轮询(默认)每个请求按时间顺序逐⼀分配到不同的后端服务,如果后端某台服务器死机,⾃动剔除故障系统,使⽤户访问不受影响。

2、weight(轮询权值)weight的值越⼤分配到的访问概率越⾼,主要⽤于后端每台服务器性能不均衡的情况下。

或者仅仅为在主从的情况下设置不同的权值,达到合理有效的地利⽤主机资源。

注意:此算法为常⽤的算法3、ip_hash每个请求按访问IP的哈希结果分配,使来⾃同⼀个IP的访客固定访问⼀台后端服务器,并且可以有效解决动态⽹页存在的session共享问题。

4、fair⽐ weight、ip_hash更加智能的负载均衡算法,fair算法可以根据页⾯⼤⼩和加载时间长短智能地进⾏负载均衡,也就是根据后端服务器的响应时间来分配请求,响应时间短的优先分配。

Nginx本⾝不⽀持fair,如果需要这种调度算法,则必须安装upstream_fair模块5、url_hash按访问的URL的哈希结果来分配请求,使每个URL定向到⼀台后端服务器,可以进⼀步提⾼后端缓存服务器的效率。

Nginx本⾝不⽀持url_hash,如果需要这种调度算法,则必须安装Nginx的hash软件包。

实验环境说明:nginx/1.13.3 centos7-3.10.0-693.11.1.el7负载均衡服务器lb01:192.168.199.244节点服务器web01:192.168.100.238节点服务器web02:192.168.100.220节点服务器web03:192.168.100.221⼀、负载服务器配置1.nginx.c o nfuser nginx;worker_processes 1;pid /run/nginx.pid;include /etc/nginx/modules-enabled/*.conf;events {worker_connections 768;}http {include /etc/nginx/mime.types;default_type application/octet-stream;sendfile on;upstream default_pools { 负载均衡代理池01server 192.168.100.238:80 weight=1;}upstream static_pools { 负载均衡代理池02server 192.168.100.220:80 weight=1;}upstream upload_pools { 负载均衡代理池03server 192.168.100.221:80 weight=1;}server {autoindex on;server_name ;location / {proxy_pass http://default_pools;}location /static/ {proxy_pass http://static_pools;}location /upload/ {proxy_pass http://upload_pools;}}}2.ho sts解析192.168.199.244 ⼆、web01user nginx;worker_processes 1;pid /run/nginx.pid;events {worker_connections 768;}http {include /etc/nginx/mime.types;default_type application/octet-stream;sendfile on;server {listen 80;server_name localhost;root /usr/share/nginx/www;index proxy.html;}}在web01的站点⽬录/usr/share/nginx/www下新增proxy.html⽂件proxy.hmtl内容如下:192.168.100.238.default.html三、web02user nginx;worker_processes 1;pid /run/nginx.pid;events {worker_connections 768;}http {include /etc/nginx/mime.types;default_type application/octet-stream;sendfile on;server {listen 80;server_name localhost;root /usr/share/nginx/www;location /static/ {index proxy.html;}}}在web01的站点⽬录/usr/share/nginx/www下新增static⽬录,并在该⽬录下新增proxy.html⽂件proxy.hmtl内容如下:193.192.168.100.220-static.html四、web03user nginx;worker_processes 1;pid /run/nginx.pid;events {worker_connections 768;}http {include /etc/nginx/mime.types;default_type application/octet-stream;sendfile on;server {listen 80;server_name localhost;root /usr/share/nginx/www;location /upload/ {index proxy.html;}}}在web01的站点⽬录/usr/share/nginx/www下新增upload⽬录,并在该⽬录下新增proxy.html⽂件proxy.hmtl内容如下:192.168.100.221.upload.html五、实验结果192.168.199.244下执⾏curl 192.168.100.238.default.htmlcurl /upload/192.168.100.221.upload.htmlcurl /static/192.168.100.220-static.html注意点web节点在收到负载均衡服务器的请求时,会把节点下的第⼀个虚拟主机发给了反向代理,解决这个问题的办法就是在负载均衡服务器server标签内引⽤如下模块proxy_set_header Host $host⽇志格式中头部为负载均衡服务器的IP,想要设置为真实⽤户的IP,需要再负载均衡服务器server标签内引⽤如下模块,同时,节点服务器下的⽇志格式也要加⼊该⾏proxy_set_header X-Forwarded-For $remote_addr其他种类负载均衡本⽂中是根据URL⽬录的内容来实现转发;还有其他的,例如根据⽤户设备的种类来实现代理转发,这⾥可以引⽤http_user_agent模块来实现,这⾥就不举例说明了。

Nginx集群(负载均衡)

Nginx集群(负载均衡)⼀、集群介绍1、传统web访问模型(1)传统web访问模型完成⼀次请求的步骤1)⽤户发起请求2)服务器接受请求3)服务器处理请求(压⼒最⼤)4)服务器响应请求(2)传统模型缺点单点故障;单台服务器资源有限(客户端则是⽆限的);单台服务器处理耗时长(客户等待时间过长);(3)传统模型优化——单点故障解决⽅案优化⽅案⼀:部署⼀台备份服务器,宕机直接切换该⽅案可以有效解决服务器故障导致的单点故障,但且服务器利⽤率低、成本⾼,切换不及时,且⽆法解决服务器业务压⼒问题。

优化⽅案⼆:部署多台服务器,根据DNS的轮询解析机制去实现⽤户分发优势是⽤户处理速度得到了提升,但是当其中⼀台故障,dns并不会知道它故障了,依然将请求分给这个服务器,导致⼀部分⽤户访问不了业务。

2、并⾏处理解决⽅案1)DNS轮询解析⽅案2)多机阵列——集群模式图中,前⾯两台服务器负责接受请求和分发请求,它⾃⼰并不处理请求,将请求分发给后⾯的业务服务器来处理。

业务服务器处理完请求后,将请求发还给分发器,再由分发器将请求发送给客户,因此分发器还承担了响应请求的任务。

由此可见之前传统模型中服务器端需要承担的服务器接收请求和响应请求都交给分发器处理了,⽽业务压⼒最⼤的处理请求则交给业务服务器完成。

分发器和dns虽然都是进⾏了分发的⼯作,但不同点在于分发器是⾃⼰部署的服务器,⽽DNS都是使⽤的运营商的,因此可以调整分发器的逻辑判断规则。

3、集群计算机集群简称集群,是⼀种计算机系统,它通过⼀组松散集成的计算机软件或硬件连接起来⾼度紧密地协作完成计算⼯作。

在某种意义上,他们可以被看作是⼀台计算机。

(百度解释)将多个物理机器组成⼀个逻辑计算机,实现负载均衡和容错。

组成要素: 1)VIP:给分发器的⼀个虚IP 2)分发器:nginx 3)数据服务器:web服务器4、Nginx集群原理在Nginx集群中Nginx扮演的⾓⾊是:分发器。

Nginx负载均衡的详细配置及使用案例详解

Nginx负载均衡的详细配置及使用案例详解.技术无止境, 我们仍需努力!1,话不多说, 这里我们来说下很重要的负载均衡, 那么什么是负载均衡呢?由于目前现有网络的各个核心部分随着业务量的提高,访问量和数据流量的快速增长,其处理能力和计算强度也相应地增大,使得单一的服务器设备根本无法承担。

在此情况下,如果扔掉现有设备去做大量的硬件升级,这样将造成现有资源的浪费,而且如果再面临下一次业务量的提升时,这又将导致再一次硬件升级的高额成本投入,甚至性能再卓越的设备也不能满足当前业务量增长的需求。

针对此情况而衍生出来的一种廉价有效透明的方法以扩展现有网络设备和服务器的带宽、增加吞吐量、加强网络数据处理能力、提高网络的灵活性和可用性的技术就是负载均衡(Load Balance)。

2, 负载均衡的种类1)一种是通过硬件来进行解决,常见的硬件有NetScaler、F5、Radware 和Array等商用的负载均衡器,但是它们是比较昂贵的2)一种是通过软件来进行解决的,常见的软件有LVS、Nginx、apache 等,它们是基于Linux系统并且开源的负载均衡策略.3, 这里我们只来说Nginx(其他的大家有兴趣可以自行查阅相关文档) Nginx(发音同engine x)是一款轻量级的Web 服务器/反向代理服务器及电子邮件(IMAP/POP3)代理服务器,并在一个BSD-like 协议下发行。

由俄罗斯的程序设计师Igor Sysoev(伊戈尔·西索夫)所开发,供俄国大型的入口网站及搜索引擎Rambler(漫步者)(俄文:Рамблер)使用。

其特点是占有内存少,并发能力强,事实上nginx的并发能力确实在同类型的网页服务器中表现较好,中国大陆使用nginx网站用户有:新浪、网易、腾讯等。

优点:1:可运行linux,并有 Windows 移植版。

2:在高连接并发的情况下,Nginx是Apache服务器不错的替代品Nginx在美国是做虚拟主机生意的老板们经常选择的软件平台之一。

Nginx高可用负载均衡部署文档V102

Nginx高可用负载均衡部署文档V102 Nginx高可用负载均衡部署文档V102

一、Nginx高可用+负载均衡部署概述

这里我们采用软硬混合方式,使用Nginx作为反向代理,HAProxy实现负载均衡,实现Nginx的高可用+负载均衡部署。

二、Nginx高可用+负载均衡实现原理

1、Nginx高可用+负载均衡,将客户端访问的请求先代理到HAProxy 服务器,HAProxy将请求通过负载均衡算法轮询分配给Nginx服务器,客户端经过HAProxy实现了负载均衡,同时使用Nginx实现反向代理进行高可用。

2、为了在Nginx服务器出现问题的时候能够第一时间被发现,可以使用健康检查工具,例如keepalived,实现Nginx服务器之间的健康检查,当有Nginx服务出现问题的时候,及时将其剔除出HAProxy的可用Nginx列表,实现Nginx的高可用。

三、Nginx高可用+负载均衡部署步骤

1、准备硬件

首先,准备一台安装HAProxy的负载均衡服务器,和若干台安装Nginx的web服务器,为了实现高可用,Nginx服务器最好是偶数台,奇数台。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1.摘要(1)结论详细描述了nginx记录失效节点的6种状态(time out、connect refuse、500、502、503、504,后四项5XX需要配置proxy_next_upstream中的状态才可以生效)、失效节点的触发条件和节点的恢复条件、所有节点失效后nginx会进行恢复并进行重新监听。

(2)Nginx 负载均衡方式介绍Nginx的负载均衡方式一共有4种:rr(轮询模式)、ip_hash、fair、url_hash。

(3)Ngxin负载均衡和相关反向代理配置内容Nginx负载均衡和与容错相关的反向代理的配置。

(4)获取后端流程后端server的自动容错流程图。

(5)测试环境和测试结果针对几种错误方式进行自动容错测试。

2.结论(1)nginx 判断节点失效状态Nginx 默认判断失败节点状态以connect refuse和time out状态为准,不以HTTP错误状态进行判断失败,因为HTTP只要能返回状态说明该节点还可以正常连接,所以nginx判断其还是存活状态;除非添加了proxy_next_upstream指令设置对404、502、503、504、500和time out等错误进行转到备机处理,在next_upstream过程中,会对fails进行累加,如果备用机处理还是错误则直接返回错误信息(但404不进行记录到错误数,如果不配置错误状态也不对其进行错误状态记录),综述,nginx记录错误数量只记录timeout 、connect refuse、502、500、503、504这6种状态,timeout和connect refuse是永远被记录错误状态,而502、500、503、504只有在配置proxy_next_upstream后nginx才会记录这4种HTTP错误到fails中,当fails大于等于max_fails时,则该节点失效;(2)nginx 处理节点失效和恢复的触发条件nginx可以通过设置max_fails(最大尝试失败次数)和fail_timeout(失效时间,在到达最大尝试失败次数后,在fail_timeout的时间范围内节点被置为失效,除非所有节点都失效,否则该时间内,节点不进行恢复)对节点失败的尝试次数和失效时间进行设置,当超过最大尝试次数或失效时间未超过配置失效时间,则nginx会对节点状会置为失效状态,nginx不对该后端进行连接,直到超过失效时间或者所有节点都失效后,该节点重新置为有效,重新探测;(3)所有节点失效后nginx将重新恢复所有节点进行探测如果探测所有节点均失效,备机也为失效时,那么nginx会对所有节点恢复为有效,重新尝试探测有效节点,如果探测到有效节点则返回正确节点内容,如果还是全部错误,那么继续探测下去,当没有正确信息时,节点失效时默认返回状态为502,但是下次访问节点时会继续探测正确节点,直到找到正确的为止。

3.nginx负载均衡Nginx的负载均衡方式一共有4种:rr(轮询模式)、ip_hash、fair、url_hash;Nginx自带的2种负载均衡为rr和ip_hash,fair和url_hash为第三方的插件,nginx在不配置负载均衡的模式下,默认采用rr负载均衡模式。

●RR负载均衡模式:每个请求按时间顺序逐一分配到不同的后端服务器,如果超过了最大失败次数后(max_fails,默认1),在失效时间内(fail_timeout,默认10秒),该节点失效权重变为0,超过失效时间后,则恢复正常,或者全部节点都为down后,那么将所有节点都恢复为有效继续探测,一般来说rr可以根据权重来进行均匀分配。

●Ip_hash负载均衡模式:每个请求按访问ip的hash结果分配,这样每个访客固定访问一个后端服务器,可以解决session的问题,但是ip_hash会造成负载不均,有的服务请求接受多,有的服务请求接受少,所以不建议采用ip_hash模式,session共享问题可用后端服务的session共享代替nginx的ip_hash。

●Fair(第三方)负载均衡模式:按后端服务器的响应时间来分配请求,响应时间短的优先分配。

●url_hash(第三方)负载均衡模式:和ip_hash算法类似,是对每个请求按url的hash结果分配,使每个URL定向到一个同一个后端服务器,但是也会造成分配不均的问题,这种模式后端服务器为缓存时比较好。

4.Nginx 负载均衡配置Nginx的负载均衡采用的是upstream模块其中默认的采用的负载均衡模式是轮询模式rr(round_robin),具体配置如下:1)指令:ip_hash语法:ip_hash默认值:none使用字段:upstream这个指令将基于客户端连接的IP地址来分发请求。

哈希的关键字是客户端的C类网络地址,这个功能将保证这个客户端请求总是被转发到一台服务器上,但是如果这台服务器不可用,那么请求将转发到另外的服务器上,这将保证某个客户端有很大概率总是连接到一台服务器。

无法将权重(weight)与ip_hash联合使用来分发连接。

如果有某台服务器不可用,你必须标记其为“down”,如下例:upstream backend {ip_hash;server ;server ;server down;server ;}server语法:server name [parameters]默认值:none使用字段:upstream指定后端服务器的名称和一些参数,可以使用域名,IP,端口,或者unix socket。

如果指定为域名,则首先将其解析为IP。

●weight = NUMBER - 设置服务器权重,默认为1。

●max_fails = NUMBER - 在一定时间内(这个时间在fail_timeout参数中设置)检查这个服务器是否可用时产生的最多失败请求数,默认为1,将其设置为0可以关闭检查,这些错误在proxy_next_upstream或fastcgi_next_upstream(404错误不会使max_fails增加)中定义。

●fail_timeout = TIME - 在这个时间内产生了max_fails所设置大小的失败尝试连接请求后这个服务器可能不可用,同样它指定了服务器不可用的时间(在下一次尝试连接请求发起之前),默认为10秒,fail_timeout与前端响应时间没有直接关系,不过可以使用proxy_connect_timeout和proxy_read_timeout来控制。

●down - 标记服务器处于离线状态,通常和ip_hash一起使用。

●backup - (0.6.7或更高)如果所有的非备份服务器都宕机或繁忙,则使用本服务器(无法和ip_hash指令搭配使用)。

示例配置upstream backend {server weight=5;server 127.0.0.1:8080 max_fails=3 fail_timeout=30s;server unix:/tmp/backend3;}注意:如果你只使用一台上游服务器,nginx将设置一个内置变量为1,即max_fails和fail_timeout参数不会被处理。

结果:如果nginx不能连接到上游,请求将丢失。

解决:使用多台上游服务器。

upstream语法:upstream name { … }默认值:none使用字段:http这个字段设置一群服务器,可以将这个字段放在proxy_pass和fastcgi_pass指令中作为一个单独的实体,它们可以可以是监听不同端口的服务器,并且也可以是同时监听TCP和Unix socket的服务器。

服务器可以指定不同的权重,默认为1。

示例配置upstream backend {server weight=5;server 127.0.0.1:8080 max_fails=3 fail_timeout=30s;server unix:/tmp/backend3;}请求将按照轮询的方式分发到后端服务器,但同时也会考虑权重。

在上面的例子中如果每次发生7个请求,5个请求将被发送到,其他两台将分别得到一个请求,如果有一台服务器不可用,那么请求将被转发到下一台服务器,直到所有的服务器检查都通过。

如果所有的服务器都无法通过检查,那么将返回给客户端最后一台工作的服务器产生的结果。

2)变量版本0.5.18以后,可以通过log_module中的变量来记录日志:log_format timing '$remote_addr - $remote_user [$time_local] $request ' 'upstream_response_time $upstream_response_time ''msec $msec request_time $request_time';log_format up_head '$remote_addr - $remote_user [$time_local] $request ' 'upstream_http_content_type $upstream_http_content_type';●$upstream_addr前端服务器处理请求的服务器地址●$upstream_cache_status0.8.3版本中其值可能为:MISSEXPIRED - expired。

请求被传送到后端。

UPDATING - expired。

由于proxy/fastcgi_cache_use_stale正在更新,将使用旧的应答。

STALE - expired。

由于proxy/fastcgi_cache_use_stale,后端将得到过期的应答。

HIT●$upstream_status前端服务器的响应状态。

●$upstream_response_time前端服务器的应答时间,精确到毫秒,不同的应答以逗号和冒号分开。

●$upstream_http_$HEADER随意的HTTP协议头,如:$upstream_http_host●$upstream_http_host3)Proxy指令:proxy_next_upstream语法:proxy_next_upstream[error|timeout|invalid_header|http_500|http_502|http_503|http_504|http_404|off]默认值:proxy_next_upstream error timeout使用字段:http, server, location确定在何种情况下请求将转发到下一个服务器:error - 在连接到一个服务器,发送一个请求,或者读取应答时发生错误。