双网卡冗余技术

S7-400硬冗余连接设置说明

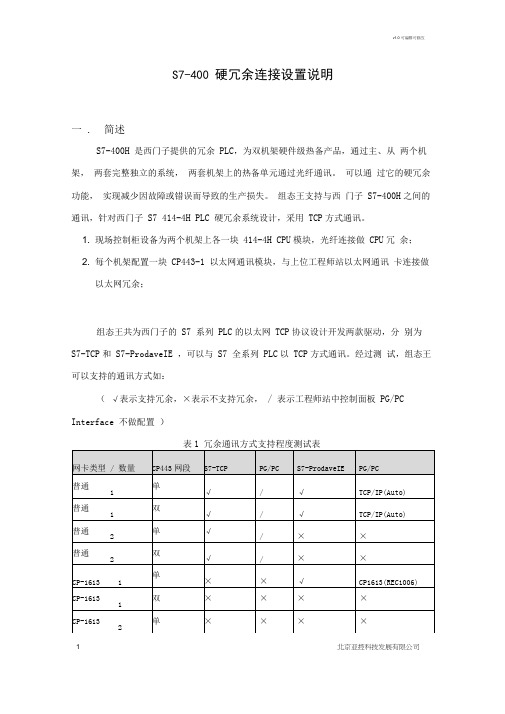

S7-400 硬冗余连接设置说明一. 简述S7-400H 是西门子提供的冗余PLC,为双机架硬件级热备产品,通过主、从两个机架,两套完整独立的系统,两套机架上的热备单元通过光纤通讯。

可以通过它的硬冗余功能,实现减少因故障或错误而导致的生产损失。

组态王支持与西门子S7-400H之间的通讯,针对西门子S7 414-4H PLC 硬冗余系统设计,采用TCP方式通讯。

1. 现场控制柜设备为两个机架上各一块414-4H CPU模块,光纤连接做CPU冗余;2. 每个机架配置一块CP443-1 以太网通讯模块,与上位工程师站以太网通讯卡连接做以太网冗余;组态王共为西门子的S7 系列PLC的以太网TCP协议设计开发两款驱动,分别为S7-TCP和S7-ProdaveIE ,可以与S7 全系列PLC以TCP方式通讯。

经过测试,组态王可以支持的通讯方式如:(√表示支持冗余,×表示不支持冗余,/ 表示工程师站中控制面板PG/PC Interface 不做配置)表冗余通讯方式支持程度测试表注:CP433网段单双指CP433的ip 地址是否在两个子网IP 段上。

如和为单网段,和为双网段1. 普通网卡+ S7-TCP 的适应支持能力最高,只需要在工程师站控制面板中为普通网卡配置相应网段信息,就可以完成S7 400H的单双网段,单双网卡冗余功能。

2. 普通网卡+ S7-ProdaveIE 需要在工程师站控制面板中配置PG/PC Interface 访问点能完成单网卡单双网段冗余。

3. CP-1613 + S7-ProdaveIE 在工程师站控制面板中配置PG/PC Interface 访问点后能完成单网卡,单网段冗余。

v1.0 可编辑可修改3 北京亚控科技发展有限公司以下各图为设备网络连接拓扑结构(普通网卡和 CP1613这里统称为通讯卡):图 1 单通讯卡单网段连接方式图 2 单通讯卡双网段连接方式S7 400H S7 400H工程师站v1.0 可编辑可修改1. 在 STEP 7编程软件中对 S7-400 硬件系统进行组态 填加 SIMATIC H Station 及其中的 CPU 模块 和 CP 模块,实际设置以用户 配置为准,此处不再赘述。

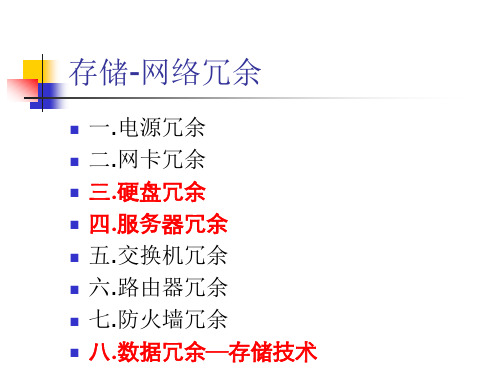

存储_网络冗余

AFT

Adapter Fault Torence “适配器容错” 在一台服务器中将二块网

卡设置为“AFT 组”,primary 和standy, 流量只在primary,如一个网卡或链接停止 ,则辅助网卡立即接管,从而保持服务 器网络链接连续性。

三.硬盘冗余

磁盘阵列:RAID1 RAID5 硬盘Hotspare

四.服务器冗余

类型 冗余方式

类型

按指令系统: CISC服务器 RISC服务器

CISC Complex Instruction Set Computer

基于Intel X86架构,PC服务器 XEON

Load ians frame=协议帧 name=XXX team=num Bind ians XXX team=1 primary(从网卡不必写primary参数)

Load ians commit mode=AFT/ALB

INTEL网卡的三种模式

AFT:Adapter Fault Torence ALB:Adapter Load Balance ALA:Adapter Link Aggregation

CPU、阵列卡的类型。 HP DL580系列服务器的特点? DELL PowerEDGE所采用的阵列卡?

五.交换机冗余

交换机技术: 1.Spanning-tree&portfast 2.GEC/FEC 3.VLAN

1.Spanning-tree

为网络提供路径冗余同时防止产生环路 两个工作站之间有两条路径,但有且只

总部:数据清算和集中交易 操作系统:Linux AS4、win2003 数据库:Oracle 服务器:HP DL580系列,IBM System

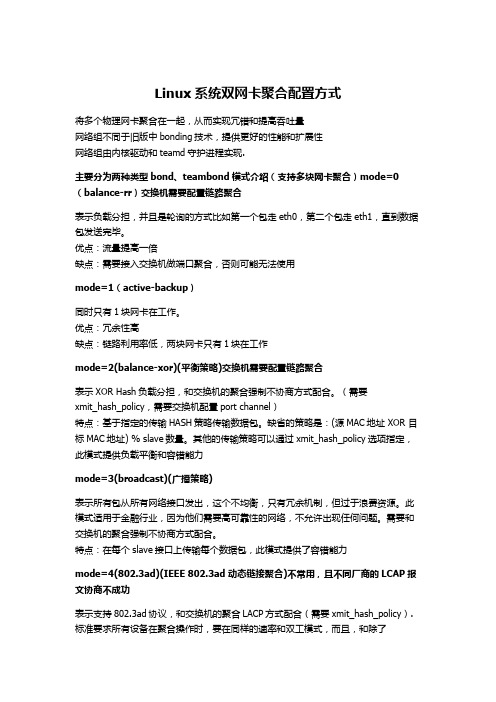

Linux系统双网卡聚合配置方式

Linux系统双网卡聚合配置方式将多个物理网卡聚合在一起,从而实现冗错和提高吞吐量网络组不同于旧版中bonding技术,提供更好的性能和扩展性网络组由内核驱动和teamd守护进程实现.主要分为两种类型bond、teambond模式介绍(支持多块网卡聚合)mode=0(balance-rr)交换机需要配置链路聚合表示负载分担,并且是轮询的方式比如第一个包走eth0,第二个包走eth1,直到数据包发送完毕。

优点:流量提高一倍缺点:需要接入交换机做端口聚合,否则可能无法使用mode=1(active-backup)同时只有1块网卡在工作。

优点:冗余性高缺点:链路利用率低,两块网卡只有1块在工作mode=2(balance-xor)(平衡策略)交换机需要配置链路聚合表示XOR Hash负载分担,和交换机的聚合强制不协商方式配合。

(需要xmit_hash_policy,需要交换机配置port channel)特点:基于指定的传输HASH策略传输数据包。

缺省的策略是:(源MAC地址 XOR 目标MAC地址) % slave数量。

其他的传输策略可以通过xmit_hash_policy选项指定,此模式提供负载平衡和容错能力mode=3(broadcast)(广播策略)表示所有包从所有网络接口发出,这个不均衡,只有冗余机制,但过于浪费资源。

此模式适用于金融行业,因为他们需要高可靠性的网络,不允许出现任何问题。

需要和交换机的聚合强制不协商方式配合。

特点:在每个slave接口上传输每个数据包,此模式提供了容错能力mode=4(802.3ad)(IEEE 802.3ad 动态链接聚合)不常用,且不同厂商的LCAP报文协商不成功表示支持802.3ad协议,和交换机的聚合LACP方式配合(需要xmit_hash_policy).标准要求所有设备在聚合操作时,要在同样的速率和双工模式,而且,和除了balance-rr模式外的其它bonding负载均衡模式一样,任何连接都不能使用多于一个接口的带宽。

VxWorks环境下双冗余网卡技术研究

( The 7 ns iut S , ng h 25 01, 23 I tt eofCI C Ya z ou 2 0 Chi ) na

A b ta t Thi p rr s a c s i o t o p sng a d o r tn rncp eofdu lr du a y n t sr c : spa e e e r he nt he c m o i n pe a i g p i i l a — e nd nc e —

分 2个不 同 的网卡 。所 以必须 声 明一个 全局 的指针 数组 , 并用 u i nt作为 指针 数组 的索 引给 它 赋值 。在

其它所 有 的操作 中 , 都 必须传 入参 数 u i, 也 nt指示 要

图 2 双冗 余 网 卡 示 意 图

使 用 哪块 网卡 进行操 作 。

2 Vx o k W r s系 统 配 置

路 检测 L 。 3 ]

#e d f n i /* I NCLUDE RTL 8 X9 END */ — 1 一 。

( )配 置 网 口数 3 在 Vx ok ( rjc Me u 的 配 置 中 ( Ne— W r s P oe t n ) 在 t

wo k c mp n n s b scn t r ntaiai nc r— r o o e t\ a i ewo k i i l t on i z o

— —

通 道 A

一

瘫痪 , 通信 阻断 。为 了提 高系统 的可 靠性 和稳定 性 , 满足 金融 、 军事 等领 域 的抗 损需 求 , 须对 网络 通信 必

…

…

通 道B

图 1 双 冗 余 网络 示 意 图

系统 进行 冗余设 计 , 障整 个 系 统在 局 部 硬 件故 障 保 的情 况下 仍然 能保 持正 常的数 据通信 。双 冗余 网络

双网卡绑定实现负载,冗余及内外网设置

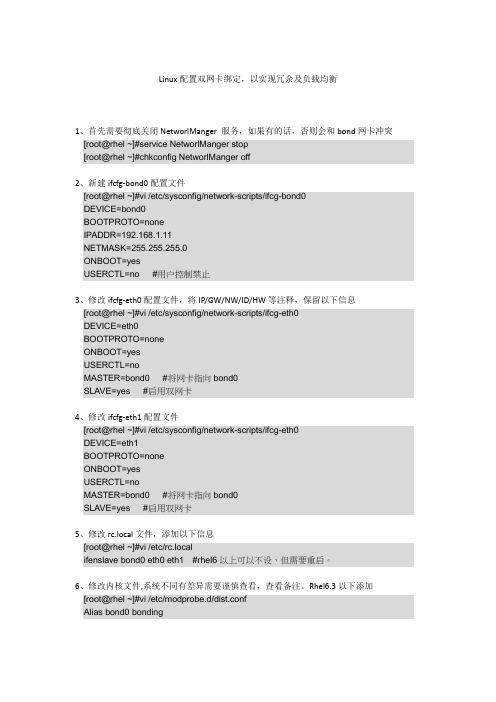

Linux配置双网卡绑定,以实现冗余及负载均衡1、首先需要彻底关闭NetworlManger 服务,如果有的话,否则会和bond网卡冲突[root@rhel ~]#service NetworlManger stop[root@rhel ~]#chkconfig NetworlManger off2、新建ifcfg-bond0配置文件[root@rhel ~]#vi /etc/sysconfig/network-scripts/ifcg-bond0DEVICE=bond0BOOTPROTO=noneIPADDR=192.168.1.11NETMASK=255.255.255.0ONBOOT=yesUSERCTL=no #用户控制禁止3、修改ifcfg-eth0配置文件,将IP/GW/NW/ID/HW等注释,保留以下信息[root@rhel ~]#vi /etc/sysconfig/network-scripts/ifcg-eth0DEVICE=eth0BOOTPROTO=noneONBOOT=yesUSERCTL=noMASTER=bond0 #将网卡指向bond0SLAVE=yes #启用双网卡4、修改ifcfg-eth1配置文件[root@rhel ~]#vi /etc/sysconfig/network-scripts/ifcg-eth0DEVICE=eth1BOOTPROTO=noneONBOOT=yesUSERCTL=noMASTER=bond0 #将网卡指向bond0SLAVE=yes #启用双网卡5、修改rc.local文件,添加以下信息[root@rhel ~]#vi /etc/rc.localifenslave bond0 eth0 eth1 #rhel6以上可以不设,但需要重启。

6、修改内核文件,系统不同有差异需要谨慎查看,查看备注。

Rhel6.3以下添加[root@rhel ~]#vi /etc/modprobe.d/dist.confAlias bond0 bondingOptions bond0 mode=1 miimon=50 #可在ifcfg-bond0中添加用BONDING_OPT=””连接。

局域网冗余技术

局域网冗余技术在当今数字化的时代,局域网作为企业、机构和组织内部信息流通的重要基础设施,其稳定性和可靠性至关重要。

一旦局域网出现故障,可能会导致业务中断、数据丢失等严重后果。

为了确保局域网的持续稳定运行,局域网冗余技术应运而生。

什么是局域网冗余技术呢?简单来说,它是一种通过在网络中添加额外的组件或链路,以提供备份和容错能力的技术手段。

当主组件或链路发生故障时,冗余的部分能够迅速接管工作,从而最大程度地减少网络中断的时间和影响。

局域网冗余技术主要包括链路冗余、设备冗余和电源冗余等方面。

链路冗余是最常见的一种冗余技术。

想象一下,在局域网中,数据就像是一辆辆行驶的汽车,而网络链路则是道路。

如果只有一条道路,一旦这条路出现问题,比如修路、发生车祸等,车辆就无法通行了。

但如果有多条道路可供选择,即使其中一条道路堵塞,车辆还可以通过其他道路继续行驶。

在网络中,我们可以通过使用多条网线、光纤或者无线链路来实现链路冗余。

例如,在交换机之间可以连接多条网线,当其中一条网线出现故障时,数据可以自动切换到其他正常的网线上进行传输,从而保证网络的连通性。

设备冗余也是保障局域网稳定运行的重要手段。

就像一个工厂里,如果只有一台关键机器在工作,一旦这台机器出故障,整个生产就会停滞。

但如果有备用的机器,在主机器出现问题时能够立即投入使用,生产就可以继续进行。

在局域网中,关键的网络设备如交换机、路由器等都可以采用冗余配置。

常见的设备冗余方式有热备份和冷备份。

热备份是指备用设备处于随时可投入使用的状态,当主设备出现故障时,能够在极短的时间内接管工作,几乎不会造成网络中断。

而冷备份则是指备用设备在平时处于关机或未连接状态,当主设备故障时,需要一定的时间来启动和配置备用设备,会造成短暂的网络中断,但相比没有备份的情况,仍然能够大大缩短恢复时间。

电源冗余同样不可忽视。

网络设备的正常运行离不开稳定的电源供应。

如果电源出现故障,设备将无法工作,从而导致网络中断。

冗余技术解析的作用

冗余技术解析的作用那么,如何保护服务器的数据安全呢?冗余技术是目前最常用的。

什么是冗余呢?听起来好像高深莫测,其实理解起来也没有那么难。

通俗地讲,冗余就是"把鸡蛋放在不同的篮子"里,也就是说,如果哪一个篮子破了,鸡蛋受损,其他篮子里的鸡蛋没事儿,还可以继续有鸡蛋吃。

用专业语言讲,冗余就是将相同的功能设计在两个或两个以上设备中,如果一个设备有问题,另外一个设备就会自动承担起有问题设备的任务,使网络继续畅通无阻。

一般来说,PC服务器主要是通过磁盘、电源、网卡和风扇的冗余配置来保护数据安全。

磁盘冗余磁盘冗余实际上就是指系统采用了RAID技术,目前常用的RAID类型可分为:RAID0、RAID1、RAID3、RAID5等。

RAID技术采用多块硬盘按照一定要求组成一个整体,整个磁盘阵列由阵列控制器管理。

同一数据在其他硬盘上有备份,如果其中的一块硬盘有故障,数据仍不丢失。

例如,采用4个硬盘的RAID5冗余系统中,由于一个硬盘仅仅作为校验盘用,实际上用来保存数据的硬盘就只有3个了,而当一个硬盘损坏后,其他两个硬盘就会将损坏的数据恢复到更换的新硬盘中。

当然,RAID技术还可提高系统的I/O性能,因为用户可以通过配置热插拔硬盘来避免由于硬盘损坏而造成的停机故障。

万全教育服务器是联想为适应教育行业对服务器产品的特别需求而推出的,该服务器以较低的价格提供RAID功能。

通过RAID1为用户提供数据的冗余备份,当用户服务器的一块硬盘发生故障时,通过IDERAID卡的硬件备份,另一块硬盘仍能保持服务的持续性和数据的完整性。

电源冗余电源冗余服务器的电源冗余一般是指配备双份支持热插拔的电源。

这种电源在正常工作时,两台电源各支持系统的一半功率,从而使每台电源都处于半负载状态,这样有利于电源稳定工作,若其中一台发生故障,则另一台就会满负荷地承担向服务器供电的工作,并通过灯光或声音告警。

此时,系统管理员可以在不关闭系统的前提下更换损坏的电源。

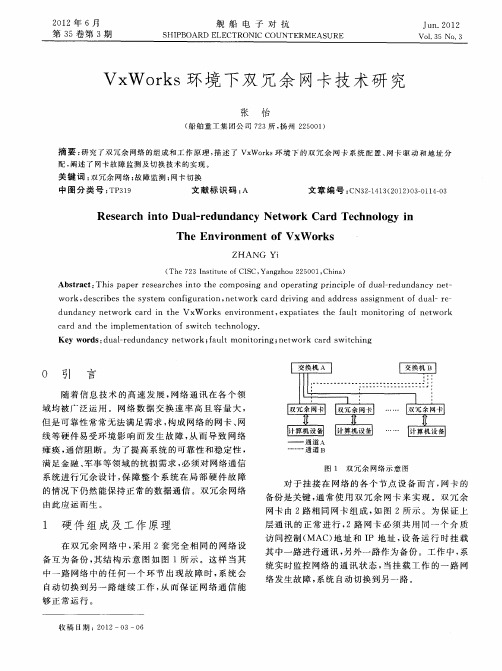

2 智能双冗余驱动程序实现

2 智能双冗余驱动程序实现2.1 智能双冗余驱动实现原理智能双冗余驱动的实现原理如图1所示,虚线框内为智能双冗余驱动。

在VxWorks系统启动时,首先要遍历配置文件confignet.h中的网卡设备表endDevTbl[ ],设备表中包含双端口网卡上两个网卡的地址及中断等配置参数;然后,系统会调用sysDethEnd.c中的sysDethEndLoad(…)函数,将两个网卡的配置参数以函数入口参数的形式传递给智能双冗余驱动的装载函数dethEndLoad(…);装载函数为每个网卡设备创建一个控制结构,对入口配置参数进行解析,并为每个网卡设备分配一块内存空间,用系统的配置要求初始化两个网卡,同时填写好网卡设备的控制结构;最后,智能双冗余驱动将主通道网卡设备的控制结构指针提交给MUX层,并发起网络故障诊断定时器任务和网络故障诊断任务。

网络故障诊断定时器任务配合网络故障诊断任务执行,使用看门狗定时器Watchdog timer完成1ms 定时,每定时1次释放1次二进制信号量sem_netDiagnose;网络故障诊断任务循环等待接收信号量se m_netDiagnose,取到信号量后立即判断主通道网卡设备的端口状态(连接/非连接),当端口处于连接状态时,任务循环等待下次信号量,当端口处于非连接状态时,网络故障诊断任务交换主通道与备用通道的控制结构内容,备用通道网卡设备变为主通道网卡设备开始工作,但对于上层应用来说,网卡的控制结构并没有改变。

2.2 网卡设备控制结构在智能双冗余网卡驱动中使用一个控制数据结构控制一块网卡设备,控制结构中包含网卡的中断向量、I/O基址、总线类型、介质类型、物理地址等特性信息。

这些信息有的在网卡设备表endDevTbl[ ]中,在系统启动过程中作为驱动装载函数的参数传递到驱动中;有的保存在网卡的PROM中,在网卡驱动程序初始化时,将这些特性参数写入网卡控制结构。

智能双冗余网卡驱动中定义了一个控制单网卡设备的控制结构,如下所示:typedef struct ne2000_device{……int unit;/*网卡单元号*/int ilevel;/*中断优先级*/int byteAccess;/*字节存储模式*/ULONG base;/*基地址*/int offset;/*内存对齐偏移量*/volatile ULONG imask;/*中断屏蔽码*/UCHAR enetAddr[6];/*网卡物理地址*/……} DETHEND_DEVICE;驱动中创建了两个网卡设备控制结构分别控制两块网卡。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

双网卡冗余技术双网卡冗余服务器典型技术我个人认为使用NIC Express绑定多网卡,在当今这个数据时代具有一定的实际意义,无论是对于互联网服务器还是局域网服务器的用户都有启发,当我们为服务器绑定多网卡形成阵列之后,不仅可以扩大服务器的网络带宽,而且可以有效均衡负载和提高容错能力,避免服务器出现传输瓶颈或者因某块网卡故障而停止服务。

也许你会说,在当今千兆网卡早已普及的时代,还费劲绑定几块百兆网卡做什么?其实绑定多网卡的目的并不是仅仅为了提高带宽,这样做还有一个最大的优点就是多块网卡可以有效增强服务器的负载承受能力和冗余容错能力。

也许你也经历过,当使用单块10M/100M网卡在局域网里拷贝1G以上大文件的时候,经常会出现电脑停止响应,或者速度奇慢接近死机的情况,当多网卡绑定之后,这种情况会得到明显改善。

所谓双网卡,就是通过软件将双网卡绑定为一个IP地址,这个技术对于许多朋友来说并不陌生,许多高档服务器网卡(例如intel8255x系列、3COM服务器网卡等)都具有多网卡绑定功能,可以通过软硬件设置将两块或者多块网卡绑定在同一个IP地址上,使用起来就好象在使用一块网卡,多网卡绑定的优点不少,首先,可以增大带宽,假如一个网卡的带宽是100M,理论上两块网卡就是200M,三块就是300M,当然实际上的效果是不会是这样简单的增加的,不过经实际测试使用多个网卡对于增加带宽,保持带宽的稳定性肯定是有裨益的,如果交换机等相关条件不错的话,这个效果还是很能令人满意;其次,可以形成网卡冗余阵列、分担负载,双网卡被绑定成“一块网卡”之后,同步一起工作,对服务器的访问流量被均衡分担到两块网卡上,这样每块网卡的负载压力就小多了,抗并发访问的能力提高,保证了服务器访问的稳定和畅快,当其中一块发生故障的时候,另一块立刻接管全部负载,过程是无缝的,服务不会中断,直到维修人员到来。

先下载一个软件NICExpress下载完软件,先不忙安装,咱们还是先准备好硬件。

第一部分:硬件安装虽然,理论上讲绑定越多网卡在一起,最终效果提升就越明显,但是考虑到复杂程度,这里就以绑定双网卡为例进行说明,如果读者觉得好玩,兴致很高的话,按照下面方法愿意绑定多少就绑定多少个网卡,其实一般同一台服务器,绑定2-3块网卡也就够了,太多了,据说因为链路聚合的先天缺点,会过多占用服务器资源,反过来会影响服务器速度(关于这个我没实验,不过我觉得凡事都离不开物极必反的道理,适度最好)。

打开服务器机箱,把两块网卡拧在主板PCI插槽上!硬件的安装很简单,我也不在这里说了。

省的大家骂我.第二部分:设置调试下面要进行设置及调试了,也就是要将这两块8139D廉价网卡,如同高档服务器网卡那样绑定在一起,使用同一个IP地址,同时同步工作。

其过程并不复杂,估计20分钟足够了。

将刚刚下载的NIC Express软件的安装包NIC4.rar解压缩得到安装文件“NICExpressW2KEE.exe”,双击它启动安装程序,一路NEXT,软件提示输入unlock key(注册码),如果没有注册码,就只好点击Demo,选择试用,这样可以获得30天的免费试用期,在这30天里如果觉得不错,你可以想办法去弄一个注册码.接着界面会显示:软件提示选择是否开启LOAD Balancing 功能?什么是LOAD Balancing 功能呢?LOAD Balancing的中文意思可以翻译为负载均衡,在这里就是网络负载均衡。

也就是当多块网卡被绑定合一之后,当数据流量很大的时候,软件会自动调整,将数据流量负载均衡地分配到各个网卡上,以减轻单块网卡的压力,达到畅快的访问效果。

我们绑定双网卡,其中目的之一就是为了实现负载均衡,我们自然要开启这个功能,所以,在这里一定要选择“Enabled”。

当然,如果你在这里选择错了也没关系,今后也可以通过NIC Express软件管理界面开启。

继续一路NEXT,在Windows XP里安装时如果遇到提示“NIC Express Virtual Miniport”没有通过Windows 测试,无法验证它同Windows XP的相容性,不要理会,选择“仍然继续”就行了。

大家看到这个界面一共分为上、中、下,三个窗口,上面的是空白,中间的写着8139-2,这个8139-2是我自己起的绑定之后的网卡组的名称,原来这里默认写的是New array,也可以不修改,你也可以根据自己喜好,写成别的名字。

在最下面的窗口里列出了目前服务器上安装的两块网卡的名字。

我们下一步就是要用鼠标选中下面的两块网卡名字,然后点击界面中间的Add键,把两块网卡加入上面的窗口里,这样两块网卡就这样被加入了网卡组里,初步绑定成一块“网卡”了,今后可以使用同一个IP地址了。

点击OK继续,NIC Express出现一个配置界面,选项很多,但是不必太操心,因为这些配置都不必修改,使用默认值就可以了,直接点击OK、点击Finish完成安装进程。

至此软件安装基本结束,剩下就需要对软件和网卡进行一些必要的设置工作。

点击桌面“开始”菜单,选择执行菜单里的“NIC Express Enterprise Edition”选项,这是NIC Express软件自带的一个监控程序,首先点击“setting”选项,在这里可以设置网卡流量计量单位,可以按照Packets/Sec、Mbits/Sec、Kbits/Sec三种单位来计算,一般都是使用默认的Mbits/Sec来计算,也就是兆/每秒,其实在这里只需要修改一下“Graph Detail(图形显示)”即可,将默认的“By Protocol”改成“By Incoming/Outgoing”,别的不需要改。

如果你想分别观察绑定组中每块网卡的流量或者整个组的流量,只需在“Select Device”选项中选择一下设备即可。

最后点击“Advanced”选项,设定网卡绑定的工作模式,在这里也可以点击“Load Balancing Disable”来关闭网卡负载均衡功能。

使用NIC Express绑定的双网卡组默认工作于“NIC Express ELB”模式下,这是NIC Express所特有的一种工作模式,实际效果很好。

我们都知道利用昂贵的Intel PROSET绑定的Intel 8255x的组合是运行在“802.3ad”工作模式下的,这一模式在NIC Express中也可以选择,但是多数使用者在实际使用后都认为“NIC Express ELB”模式的效果优于“802.3ad”模式,大家今后可以自己实践测试比较一下。

如果你也使用默认的“NIC Express ELB”模式,那么“Advanced”选项里也就不用改什么,一切默认即可。

至此NIC Express的设置结束。

第三部分:“虚拟网卡”设定最后还要看看网卡的设置,用鼠标在桌面“网上邻居”上点击右键弹出“网络和拨号连接”窗口,可以看到原来的两个网卡连接图标已经变成了三个,多出来的一个图标就是“NIC Express Virtual Adapter”,这个就是绑定后的网卡组,这个网卡组的使用和使用单一网卡完全一样,相当于一个单一的“虚拟网卡”。

用鼠标在这个图标上点击右键选择属性,可以为这个“虚拟网卡”设定IP地址、子网掩码、网关等等,其实在安装“NIC Express”过程中,如果服务器原来的单一网卡已经设置了这些,那么“虚拟网卡”就会自动设定和原来的网卡一样。

在这里选择“NIC Express Transport for Ethernet”还可以自由对网卡绑定组进行调整,例如,减少或者加入一块网卡,这个较之Intel PROSET要方便许多,Intel PROSET在增加或者减少绑定组里的网卡之前必须删除原来的绑定组然后重新创建。

好了,好了,至此一切都已经做好,我们的服务器已经成为一台地地道道的“双网卡冗余服务器”了.能,你可以玩双网卡绑定.公司的服务器访问量越来越大,客户端连接的速度越来越慢。

一块普通的百兆网卡已经不能满足应用的需要了。

怎么办呢?换千兆网卡不仅要花费好几百块钱,而且我们的交换机也是百光交换机,即使换了千兆网卡交换机也不能跟着换啊!问题总得解决,记得以前在购买服务器时看到很多高档服务器网卡可以通过软件将它们捆绑在一起使用,以实现网络访问的分流。

那么普通的网卡能够将它们绑定在一起吗?经过一翻搜索,还真的被我找到了解决的办法,那就是利用NICExpress,它可以将任意品牌、任意型号的网卡绑定在一起使用。

一、准备工作准备工作很简单,就是将两块或多块网卡安装到服务器,并安装好驱动程序即可。

一般来说可以根据网络负载程度选择绑定网卡的数量不宜过多,一般以绑定2-5块为宜,再说绑定那么多,你的主板也没有多余的PCI插糟可供使用啊。

另外为了使绑定后的网卡工作稳定、性能得以发挥,建议尽量使用同一品牌、同一型号的网卡。

二、安装设置下载并执行NICExpress的安装程序,待安装向导提示“Setup Type”时,选择“Enabled”(如图1),这样做的目的是启用网络负载平衡,当数据流量比较大时,该软件就会自动进行分流,使绑定的每块网卡都担当一定的任务,而不是把重任压在某一块网卡的身上。

小提示:如果是Windwos XP,那么在接下来的安装向导中可能会出现硬件无法通过兼容性测试,这里只要点击“仍然继续”按钮即可继续(如图2)。

根据安装向导的操作,待文件复制完毕即会进入绑定网卡设置窗口,可以看到窗口上方是计算机上已经安装的网卡,中间是设置组的名称,可以直接输入。

现在我们要做的就是在上方已经安装好的网卡列表中选中要绑定抽多卡,单击“Add”按钮,将其添加到“Assigned Adapters”框中去,被添加的网卡就是被绑定的网卡(如图3),添加好之后单击“OK”按钮,稍候片刻还会弹出一个参数设置窗口,在这里我们建议使用程序的默认参数即可。

三、应用设置现在我们绑定的网卡即可在工作了。

打开“网上邻居”的属性窗口,我们可以看到在原来物理网卡的基础上又多功能出一块虚拟的网卡(如图4)。

右击该网卡,选择“属性”命令打开网卡的设置窗口,我们可以看到在已安装的组件中多出一个“NIC Express Transport for Ethernet”,选中该项并单击“属性”按钮即可打开网卡绑定窗口,在这里我们可以增加其它绑定的网卡,也可以将绑定的网卡删除;如果打开“Internet协议(TCP/IP)”的属性窗口,那么还可以像普通网卡一样设置该虚拟网卡的IP地址等参数。

小提示:如果被绑定的网卡在绑定之前已经设置了IP地址,那么在绑定过程中程序会提示是否使用已经设置的IP地址。

四、综合应用现在我们就可以将两根网线连接到绑定的两块网卡,然后通过虚拟网卡的IP地址访问服务器,并进行操作,你就可以在网卡的指示灯上看到两个网卡都在进行数据交换。