主成分分析(PCA)详解(附带详细公式推导)

利用协方差阵求取主成分的步骤和公式

利用协方差阵求取主成分的步骤和公式在现代统计学中,主成分分析(PCA)是一种常用的数据降维方法。

它通过将原始数据投影到一个新的坐标系,从而实现对数据的简化和可视化。

PCA的原理基于协方差矩阵,协方差矩阵是一个描述数据之间关系的矩阵。

在这个过程中,我们需要利用协方差阵求取主成分,以下是详细的步骤和公式:我们需要计算数据的均值。

均值是一个重要的特征,它可以帮助我们消除数据中的量纲影响。

例如,如果我们有一个长度为n的数据向量x,那么它的均值就是x的平均值:均值= (1/n) * Σx_i接下来,我们需要计算协方差矩阵。

协方差矩阵是一个描述数据之间线性关系的特征矩阵。

对于一个n维数据向量x,它的协方差矩阵可以表示为:协方差矩阵 = (1/(n-1)) * Σ((x_i μ) * (x_j μ))其中,μ是数据向量的均值,Σ表示求和。

需要注意的是,协方差矩阵的上三角部分是正定的,这意味着我们可以直接求出它的特征值和特征向量。

这些特征值和特征向量构成了主成分。

为了求解协方差矩阵的特征值和特征向量,我们可以使用奇异值分解(SVD)。

奇异值分解是一种将矩阵分解为三个矩阵的乘积的方法。

对于一个n×n的矩阵A,它的奇异值分解可以表示为:A = U * S * V^T其中,U、S和V分别是正交矩阵,且S是一个对角矩阵,其对角线元素称为奇异值。

我们需要找到最大的奇异值对应的特征向量,这个特征向量就是我们要找的主成分。

具体来说,主成分的方向是由最大奇异值对应的特征向量确定的。

接下来,我们需要计算主成分的方差。

主成分的方差可以通过协方差矩阵的最大奇异值来表示。

设最大奇异值为λ1,那么主成分的方差就是:主成分方差= λ1^2 / (n-1)我们可以将原始数据投影到主成分上。

具体来说,对于一个n维数据向量x,它在第一个主成分上的投影就是:x_1 = x * Σ_j^0 * V^T_j^0 * S^(0/2) * U^(0,0)其中,Σ_j^0表示j=1,2,...,n-1时的特征值之和。

PCA简介ppt课件

9

(2)再利用公式:

山楂园昆虫群落协方差矩阵

sij

1 n 1

n

( xki

k 1

xi )(xkj

xj)

10

入选的特征值和特征向量

11

前四个主成分累积贡献率为:

1 2 3 4 85.10% 1 2 L 16 因此:只需取第1,2,3,4主成分即可。

从以上分析结果看出,引起山楂园昆虫演替的主要昆虫群落对 第一主成分贡献最大的是山楂虫螨,它的特征向量为-0.304, 其次是草履蚧,再次是桃蚜,这三种昆虫是第一主成分的基本 代表。对第二主成分,贡献较大的有顶梢卷叶蛾、苹毛金龟子。 特征向量分别为0.370和0.355。第三主成分,贡献最大的是山 楂木虱,其次为苹小卷叶蛾。特征向量分别为:0.430和0.426。 第四主成分,贡献最大的是舟形毛虫和桃小食心虫,其特征向 量分别为-0.466和-0.428。

主成分分析(PCA)

2011.03.19

1

一、PCA概述 二、PCA的基本原理 三、计算步骤 四、应用

2

一 、 PCA 主成分分析法是研究如何以最少的信息丢失将众多原

有变量浓缩成少数几个因子(主成分),使这些主成分在 一定的程度上复现原有变量所携带的信息的多元统计分析 方法。 主成分的特点: (1) 主成分个数远远少于原有变量的个数 。 (2) 主成分能够反映原有变量的绝大部分信息。 (3) 主成分之间应该互不相关。 (4) 主成分具有命名解释性 。

k

k 1

当累积贡献率大于85%时,就认为能足够反映原 来变量的信息了,对应的m就是抽取的前m个主成 分。

7

四、 应用

1.为研究某山楂园昆虫群落演替,分16个时期对园中16种主 要昆虫进行了调查,试进行主成分分析。

PCA-主成分分析的原理及解释

PCA-主成分分析的原理及解释主成分分析(principal component analysis ,PCA )PCA 利⽤正交变换将线性相关变量表⽰的观测数据转换为少数⼏个由线性⽆关变量表⽰的数据。

线性⽆关的变量称为主成分,其个数通常⼩于原始变量的个数,所以属于⽆监督学习中的降维⽅法。

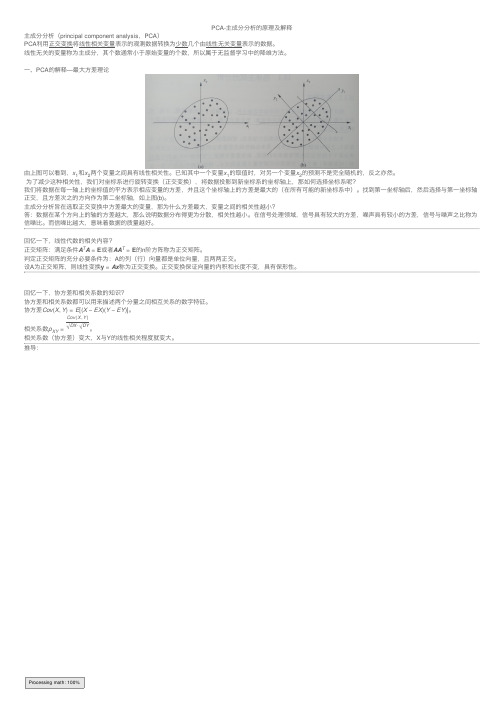

⼀、PCA 的解释—最⼤⽅差理论由上图可以看到,x 1和x 2两个变量之间具有线性相关性。

已知其中⼀个变量x 1的取值时,对另⼀个变量x 2的预测不是完全随机的,反之亦然。

为了减少这种相关性,我们对坐标系进⾏旋转变换(正交变换),将数据投影到新坐标系的坐标轴上,那如何选择坐标系呢?我们将数据在每⼀轴上的坐标值的平⽅表⽰相应变量的⽅差,并且这个坐标轴上的⽅差是最⼤的(在所有可能的新坐标系中)。

找到第⼀坐标轴后,然后选择与第⼀坐标轴正交,且⽅差次之的⽅向作为第⼆坐标轴,如上图(b)。

主成分分析旨在选取正交变换中⽅差最⼤的变量,那为什么⽅差最⼤,变量之间的相关性越⼩?答:数据在某个⽅向上的轴的⽅差越⼤,那么说明数据分布得更为分散,相关性越⼩。

在信号处理领域,信号具有较⼤的⽅差,噪声具有较⼩的⽅差,信号与噪声之⽐称为信噪⽐。

⽽信噪⽐越⼤,意味着数据的质量越好。

回忆⼀下,线性代数的相关内容?正交矩阵:满⾜条件A T A =E 或者AA T =E 的n 阶⽅阵称为正交矩阵。

判定正交矩阵的充分必要条件为:A 的列(⾏)向量都是单位向量,且两两正交。

设A 为正交矩阵,则线性变换y =Ax 称为正交变换。

正交变换保证向量的内积和长度不变,具有保形性。

回忆⼀下,协⽅差和相关系数的知识?协⽅差和相关系数都可以⽤来描述两个分量之间相互关系的数字特征。

协⽅差Cov (X ,Y )=E [(X −EX )(Y −EY )]。

相关系数ρXY =Cov (X ,Y )√DX ⋅√DY。

相关系数(协⽅差)变⼤,X 与Y 的线性相关程度就变⼤。

推导:Processing math: 100%矩阵和向量求导的相关公式::。

主成分分析(PCA)数学原理详解

主成分分析(PCA)数学原理详解PCA的数学原理可以分为以下几个步骤:1.数据中心化PCA首先将原始数据进行中心化处理,即将每个特征的均值减去相应特征的平均值,这是因为PCA假设数据围绕着原点分布,中心化可以消除数据的平移影响。

2.协方差矩阵的计算PCA的关键是计算数据的协方差矩阵。

协方差矩阵描述了不同特征之间的相关性。

对于一个n维的数据集,协方差矩阵是一个n×n的矩阵,其中第(i,j)个元素表示第i个特征和第j个特征的协方差。

协方差矩阵的计算公式如下:$C = \frac{1}{n-1} \sum _{i=1}^{n}(X_i - \overline{X})(X_i - \overline{X})^T$其中,X是一个n×m的矩阵,表示n个样本的m个特征,$\overline{X}$ 表示特征均值向量协方差矩阵是一个对称矩阵,通过对协方差矩阵的特征值分解,可以得到特征值和特征向量。

3.特征值和特征向量的计算对协方差矩阵进行特征值分解,可以得到特征值和对应的特征向量。

特征值代表了数据在特征向量方向上的方差,而特征向量表示了数据的主成分方向。

设协方差矩阵为C,有如下特征值方程:$Cv = \lambda v$其中,v是特征向量,λ是特征值。

将特征值按从大到小的顺序排序,选择前k个最大的特征向量,即主成分,作为新的基向量。

这些特征向量构成了一个新的坐标系,用于表示原始数据的新坐标。

4.数据转换将原始数据投影到新的坐标系上,得到降维后的数据。

设原始数据集为X,新的基向量为V(由前k个特征向量组成),降维后的数据集为Y,可以通过如下公式计算:$Y=XV$其中,X是一个n×m的矩阵,表示n个样本的m个特征,V是一个m×k的矩阵,Y是一个n×k的矩阵。

通过PCA降维,可以获得降维后的数据集Y,它是一个n×k的矩阵。

总结:主成分分析(PCA)通过计算数据的协方差矩阵,得到协方差矩阵的特征值和特征向量。

PCA-主成分分析详解

首先介绍 PCA 的计算过程: 假设我们得到的 2 维数据如下:

行代表了样例,列代表特征,这里有 10 个样例,每个样例两个特征。可以这样认 为,有 10 篇文档,x 是 10 篇文档中“learn”出现的 TF-IDF,y 是 10 篇文档中“study” 出现的 TF-IDF。也可以认为有 10 辆汽车,x 是千米/小时的速度,y 是英里/小时的速 度,等等。

第一步分别求 x 和 y 的平均值,然后对于所有的样例,都减去对应的均值。这里 x 的均值是 1.81,y 的均值是 1.91,那么一个样例减去均值后即为(0.69,0.49),得到

第二步,求特征协方差矩阵,如果数据是 3 维,那么协方差矩阵是

这里只有 x 和 y,求解得

对角线上分别是 x 和 y 的方差,非对角线上是协方差。协方差大于 0 表示 x 和 y 若有 一个增,另一个也增;小于 0 表示一个增,一个减;协方差为 0 时,两者独立。协方差绝 对值越大,两者对彼此的影响越大,反之越小。

假设我们还是用

来表示样例,m 个样例,n 个特征。特征向量为 e,

PCA-主成分分析(Principal components analysis)

转自:/dlutbrucezhang/article/details/8718350?utm_source=tuicool /dlutbrucezhang/article/details/8718366

下面将样本投影到某一维上,这里用一条过原点的直线表示(前处理的过程实质是将 原点移到样本点的中心点)。

假设我们选择两条不同的直线做投影,那么左右两条中哪个好呢?根据我们之前的方 差最大化理论,左边的好,因为投影后的样本点之间方差最大。

主成分分析法(PCA)

前 k 个主成分的贡献率之和

∑λ

i =1

k

i

∑λ

j =1

n

j

称为主成分 λ1 , λ2 L λk 的累计贡献率,它表明 z1 , z2 ,L zk 解释 x1 , x2 L xn 的能力。 通常取较小的 k ,使得累计贡献达到一个较高的百分比(如 80%~90%)。此时,z1 , z2 ,L zk 可用来代替 x1, x2 L xn ,从而 达到降维的目的,而信息的损失却不多。

i

1 2 i i min w + C ∑ (ζ + + ζ − ) 2 i

2

m

受限于

y − ( w x + b) ≤ ε + ζ

i T i

i + i −

( w x + b) − y ≤ ε + ζ

T i i

和我们做分类的方法一样,建立拉格朗日函 数,然后取它的对偶问题(这里也可以使用 核函数),与分类一样,我们也会得到一些 支持向量,而回归线将用它们表示.

总方差中属于主成分 zi 的比例为

λi

∑λ

j =1

k

j

称为主成分 zi 的贡献率。 第一主成分 z1的贡献率最大,表明它解释原始变量 x1 , x2 ,L xn 的能力最强,而 z1 , z2 L zk 的解释能力依次递减。 主成分分析的目的就是为了减少变量的个数,因而一般是不 会使用所有 主成分的,忽略一些带有较小方差的主成分将 不会给总方差带来大的影响。

同时我们还得到

T T w1 ∑ w1 = αw1 w1 = α

为了使方差最大,选择具有最大特征值的特征向量 , 因此,第一个主成分 w1 是输入样本的协方差阵的 具有最大特征值对应的特征向量

主成分分析(PCA)的推导和应用

主成分分析的主要目的是希望用较少的变量去解释原来资料中的大部分变异,将我们手中许多相关性很高的变量转化成彼此相互独立或不相关的变量,从而达到降维的目的。

在原始数据“预处理”阶段通常要先对它们采用PCA的方法进行降维。

本质上讲,PCA就是将高维的数据通过线性变换投影到低维空间上去,但并非随意投影,而是需要遵循一个规则:希望降维后的数据不能失真,也就是说被PCA降掉的那些维度只能是噪声或是冗余的数据。

噪声可以理解为样本数据各维度之间的相关性干扰,冗余可以理解为没有的维度(何为没用?我们PCA处理的基础是保持数据的可区分性,如果该维度上样本数据变异度很小,那么留它何用~~)。

以上是PCA的本质和基本思想。

下面我们来具体分析。

假设现在有很多个样本,每个样本都是多维的,他们自然都可以在多维坐标系上表示出来。

现在我们第一步是要进行维度的变换,实际上就是通过旋转形成新的坐标系直线(此时还没有降维)。

将各样本数据投影在这些直线上,其投影的长度是在新坐标系下的样本各维度值。

通过计算各直线上投影的方差值,我们可以进行排序。

方差值大说明这个新维度区分能力强,我们应该留下;反之则该去掉(降维去冗余)。

现在通过以上思想你应该可以推到出PCA的具体公式了。

至于具体的公式,本讲决定直接跳过(留给下一讲),现在我可以直接告诉你大概运用什么样的方法怎样来进行PCA。

完成PCA的关键是——协方差矩阵!!协方差矩阵度量的是维度与维度之间的关系,而非样本与样本之间,所以我们直接对协方差矩阵进行某种变化,是不是就可以到达降噪和去冗余的目的呢?Absolutely!!这种变化就是矩阵的对角化(对角化实际上还没有降维,只是同维度的变换)。

对角化之后非对角上的元素都是0,这就到达了去噪声的目的。

而对角线上的元素是新维度的方差(你应该明白对角化的矩阵依然是协方差矩阵吧),所以我们只需要在这些方差中挑选较大的一些,舍去较小的,这样就去冗余了。

通过这两步工作PCA最主要的工作就完成了。

PCA主成分分析方法

PCA主成分分析⽅法PCA: Principal Components Analysis,主成分分析。

1、引⼊ 在对任何训练集进⾏分类和回归处理之前,我们⾸先都需要提取原始数据的特征,然后将提取出的特征数据输⼊到相应的模型中。

但是当原始数据的维数特别⾼时,这时我们需要先对数据进⾏降维处理,然后将降维后的数据输⼊到模型中。

PCA算法是专门⽤来对⾼维数据进⾏降维⽽设计,通过将⾼维数据降维后得到的低维数能加快模型的训练速度,并且低维度的特征具有更好的可视化性质。

另外,数据的降维会导致⼀定的信息损失,通常我们可以设置⼀个损失阀值来控制信息的损失。

设原始样本集为:,即样本数为m个,每个样例有n个特征维度。

2、预处理 在使⽤PCA降维之前,样本集需要满⾜两个条件: 1)特征去均值化(即均值零化)。

对每个特征,使⽤当前特征的值减去该维特征的平均值。

对第i个样例的第j个特征,计算公式为: 其中第i个特征的均值为: 当处理⾃然图像时,则将每个特征减去图像本⾝的均值,⽽不是减去该特征的均值。

即: 为何需要去均值?这主要是去除均值对变换的影响,减去均值后数据的信息量没有变化,即数据的区分度(⽅差)是不变的。

如果不去均值,第⼀主成分,可能会或多或少的与均值相关。

[5] 2)归⼀化处理:将不同特征的数据范围归⼀化到同⼀范围中,⼀般将每个值除以当前维的最⼤值。

3、PCA算法 PCA算法的核⼼思想在于找出数据变化的主⽅向和次⽅向,如图3.1所⽰,向量u1 的⽅向可以认为是数据的主⽅向,⽽u2是次⽅向。

图3.1 数据变化的主次⽅向[1] 那么如何得到数据变化的主次⽅向?假设样本集有m个样例,每个样例有n个特征。

样本集可以表⽰为: 第i个样例的特征向量表⽰为: 则样本集的协⽅差矩阵为: 协⽅差矩阵为n*n⼤⼩的⽅阵,具有n个特征向量。

其中协⽅差计算公式为: 计算协⽅差矩阵的特征向量及对应的特征值。

将特征向量按特征值的⼤⼩按列排放,组成矩阵u=[u1 u2 … un],对应的特征值由⼤到⼩分别为:。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

主成分分析(PCA)详解(附带详细公式推导)

1.假设有一个m维的数据集X,其中每个数据点有n个样本。

需要将

其降维到k维,且k<m。

2. 首先需进行数据的中心化,即对每个维度的数据减去该维度的均值,即X' = X - mean(X)。

3.然后计算协方差矩阵C=(1/n)*X'*X'^T,其中X'^T表示X'的转置。

4.对协方差矩阵C进行特征值分解,得到特征值和对应的特征向量。

5.接下来,将特征值按从大到小的顺序排列,选取前k个最大的特征

值及其对应的特征向量。

6. 最后,将选取的k个特征向量组成一个投影矩阵W =

[e1,e2,...,ek],其中ei表示第i个特征向量。

7.对中心化的数据集进行降维,Y=W*X',其中Y即为降维后的数据。

上述推导过程中,协方差矩阵C的特征值代表了数据的方差,特征向

量则代表了数据的主成分。

选取最大的k个特征值和对应的特征向量,即

实现了数据的降维。

PCA的应用包括但不限于以下几个方面:

1.数据可视化:PCA能够将高维度的数据映射到二维或三维空间,从

而方便数据的可视化展示。

2.数据预处理:PCA能够降低数据的维度,从而减少噪声和冗余信息,提升后续模型的精度和效率。

3.特征提取:PCA能够提取数据中最重要的特征,从而辅助后续建模和特征工程。

4.噪声过滤:PCA能够降低数据的维度,从而过滤掉一些无关的噪声信息。

需要注意的是,PCA只能应用于线性数据,并且假设数据的方差和协方差是固定的。

同时,PCA对于数据中非线性关系的捕捉能力较弱,因此在处理非线性数据时,需考虑使用其他非线性降维方法,如核主成分分析(Kernel PCA)等。

综上所述,PCA是一种常用的多变量数据降维技术,在数据分析和机器学习领域有着广泛的应用。

通过线性变换,PCA将高维度的数据投影到低维空间中,从而减少数据的维度,并保留了数据中的主要信息。