机器学习-5-Bayes分类器

周志华-机器学习-西瓜书-全书16章-ppt-Chap07贝叶斯分类器

贝叶斯决策论

具体来说,若目标是最小化分类错误率,则误判损失 可写为

此时条件风险

N

R(ci | X x) ij P(c j | X x) P(c j | X x)

j 1

ji

1 P(ci | X x)

7.5

min i

R(ci | X

x) max

i

P(ci | X

x) 后验概率

贝叶斯决策论

具体来说,若目标是最小化分类错误率,则误判损失 可写为

此时条件风险

于是,最小化分类错误率的贝叶斯最优分类器为

即对每个样本 ,选择能使后验概率

最大的类别标记。

贝叶斯决策论

不难看出,使用贝叶斯判定准则来最小化决策风险,首先要获得后验

概率

。

然而,在现实中通常难以直接获得。机器学习所要实现的是基于有限

,

xm

)

P(X x1, x2, P(X x1,

, x2 ,

xm , Y=ci ) , xm )

7.7

贝叶斯决策论

生成式模型

贝叶斯决策论

生成式模型

P(Y=ci | X x1, x2,

, x2, P(X x1,

, x2 ,

xm , Y=ci ) , xm )

朴素贝叶斯分类器

估计后验概率

主要困难:类条件概率

上的联合概率难以从有限的训练样本估计获得。

是所有属性

P(Y=ci | X x1, x2,

,

xm

)

P

Y=ci

P X x1, x2, P( X x1, x2,

, xm | Y=ci , xm )

max P i

Y=ci | X

7.1

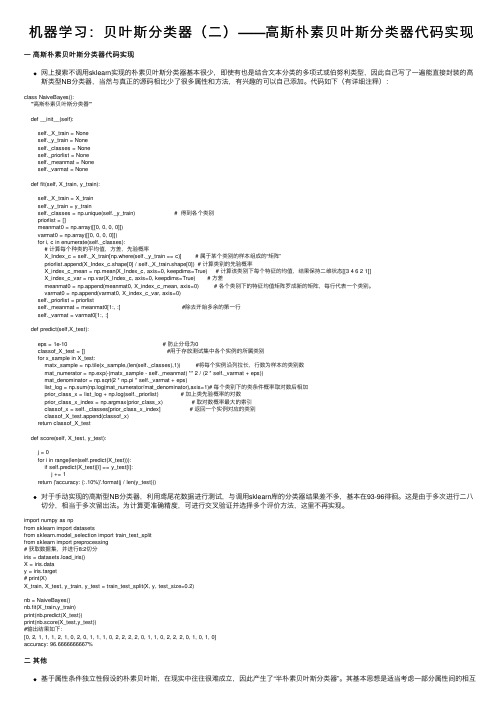

机器学习:贝叶斯分类器(二)——高斯朴素贝叶斯分类器代码实现

机器学习:贝叶斯分类器(⼆)——⾼斯朴素贝叶斯分类器代码实现⼀⾼斯朴素贝叶斯分类器代码实现⽹上搜索不调⽤sklearn实现的朴素贝叶斯分类器基本很少,即使有也是结合⽂本分类的多项式或伯努利类型,因此⾃⼰写了⼀遍能直接封装的⾼斯类型NB分类器,当然与真正的源码相⽐少了很多属性和⽅法,有兴趣的可以⾃⼰添加。

代码如下(有详细注释):class NaiveBayes():'''⾼斯朴素贝叶斯分类器'''def __init__(self):self._X_train = Noneself._y_train = Noneself._classes = Noneself._priorlist = Noneself._meanmat = Noneself._varmat = Nonedef fit(self, X_train, y_train):self._X_train = X_trainself._y_train = y_trainself._classes = np.unique(self._y_train) # 得到各个类别priorlist = []meanmat0 = np.array([[0, 0, 0, 0]])varmat0 = np.array([[0, 0, 0, 0]])for i, c in enumerate(self._classes):# 计算每个种类的平均值,⽅差,先验概率X_Index_c = self._X_train[np.where(self._y_train == c)] # 属于某个类别的样本组成的“矩阵”priorlist.append(X_Index_c.shape[0] / self._X_train.shape[0]) # 计算类别的先验概率X_index_c_mean = np.mean(X_Index_c, axis=0, keepdims=True) # 计算该类别下每个特征的均值,结果保持⼆维状态[[3 4 6 2 1]]X_index_c_var = np.var(X_Index_c, axis=0, keepdims=True) # ⽅差meanmat0 = np.append(meanmat0, X_index_c_mean, axis=0) # 各个类别下的特征均值矩阵罗成新的矩阵,每⾏代表⼀个类别。

bayes 分类器设置实验总结

bayes 分类器设置实验总结Bayes 分类器设置实验总结在机器学习领域中,分类算法是一个常见的任务之一。

Bayes 分类器是一种基于概率统计的分类算法,它基于贝叶斯定理对样本进行分类。

在本次实验中,我们将对Bayes 分类器的设置进行实验,并总结实验结果。

一、实验目的Bayes 分类器是一种简单但有效的分类算法,通过实验设置我们的目的是验证Bayes 分类器在不同参数下的分类效果,并探索如何对其进行优化。

我们希望通过实验的设计和分析,能够决定最佳的参数设置,并对Bayes 分类器的性能有更深入的了解。

二、数据集选择在进行实验之前,我们需要选择一个合适的数据集作为实验对象。

数据集应具备以下特点:1. 包含有标签的样本数据:由于Bayes 分类器是一种监督学习算法,我们需要有样本的标签信息来进行分类。

2. 具备多类别分类的情况:我们希望能够测试Bayes 分类器在多类别分类问题上的表现,以便更全面地评估其性能。

三、实验设置1. 数据预处理:根据所选数据集的特点,我们需要对数据进行适当的预处理。

可能的预处理步骤包括特征选择、特征缩放、处理缺失值等。

2. 分类器参数设置:Bayes 分类器的性能会受到不同参数的影响,我们希望通过实验找到最佳的参数设置。

例如,在朴素贝叶斯分类器中,我们可以选择不同的先验概率分布,或者使用不同的平滑技术来处理零概率问题。

3. 评价指标选择:为了评估分类器的性能,我们需要选择合适的评价指标。

常见的评价指标包括准确率、召回率、精确率和F1 分数等。

四、实验结果在实验完成后,我们将根据所选的评价指标对实验结果进行分析和总结。

我们可以比较不同参数设置下的分类器性能,并选择最佳的参数设置。

此外,我们还可以考虑其他因素对分类器性能的影响,如数据预处理方法和样本量等。

五、实验总结在本次实验中,我们通过对Bayes 分类器的设置进行实验,得到了一些有价值的结果和经验。

根据实验结果,我们可以总结以下几点:1. 参数设置的重要性:Bayes 分类器的性能受到参数设置的影响。

基于机器学习的文本分类方法及实用性评估

基于机器学习的文本分类方法及实用性评估在当今信息爆炸的时代,大量的文本数据使得人们面临一个重要的挑战:如何高效地对海量文本进行分类和分析。

机器学习作为一种能够自动从数据中学习并提取知识的方法,被广泛应用于文本分类任务中。

本文将介绍基于机器学习的文本分类方法以及其在实际应用中的评估。

一、基于机器学习的文本分类方法1. 文本特征表示方法在进行文本分类之前,首先需要将文本数据转化为机器学习算法可以处理的特征向量。

常用的文本特征表示方法有以下几种:(1) 词袋模型 (Bag-of-Words Model): 该模型将文本看作是一组无序的词汇集合,忽略了词语之间的顺序和语法结构,只关注每个词出现的频率。

通过统计每个词在文本中出现的次数或者使用TF-IDF进行权重计算,可以将文本转化为高维稀疏的向量表示。

(2) Word2Vec: Word2Vec是一种基于神经网络的词向量表示方法,通过预训练的神经网络模型将每个词映射到一个固定长度的稠密向量。

Word2Vec考虑了词语的语义信息,可以更好地捕捉词语之间的关系。

(3) 文本主题模型 (Topic Models): 主题模型是一种能够自动发现文本中的主题信息的方法。

通过对文本进行主题建模,可以将文本表示为一个主题分布的向量。

2. 文本分类算法基于机器学习的文本分类算法可以分为有监督和无监督学习算法。

有监督学习算法通过已标注的训练数据学习分类模型,而无监督学习算法则从未标注的数据中自动学习分类规则。

(1) 朴素贝叶斯分类器 (Naive Bayes Classifier): 朴素贝叶斯分类器是一种基于概率的分类方法,假设特征之间相互独立。

该算法通过计算给定特征条件下的类别概率,来预测文本的类别。

(2) 支持向量机 (Support Vector Machine, SVM): SVM是一种二分类模型,通过在特征空间中建立一个最优超平面来进行分类。

其核函数的选取可以应用于非线性文本分类任务。

Bayes分类器算法

⇒ x ∈ωi

2、具体步骤如下 A).算出各类别特征值的均值 B).求出特征值的协方差矩阵 C).将第二步所得矩阵代入判别函数 g1(x)、g2(x) D).将待测试样本集数据依次代入 g1(x)- g2(x),若 g1(x)- g2(x)>0,则判断其为第一类,反

之为第二类。 3、流程图

确定特征及先验概率

体重: clear all; load FEMALE.txt; load MALE.txt; fid=fopen('test2.txt','r'); test1=fscanf(fid,'%f %f %c',[3,inf]); test=test1';

fclose(fid); Fmean = mean(FEMALE); Mmean = mean(MALE); Fvar = std(FEMALE); Mvar = std(MALE); preM = 0.9; preF = 0.1; error=0; Nerror=0; figure; for i=1:300

Nerror = Nerror +1; end; else plot(test(i,1),test(i,2),'k*'); if (test(i,3)=='F')

Nerror = Nerror +1; end end hold on; end; title('身高体重不相关最小风险的 Bayes 决策'); ylabel('身高(cm)'),zlabel('体重(kg)'); error = Nerror/300*100; sprintf('%s %d %s %0.2f%s','分类错误个数:',Nerror,'分类错误率为:',error,'%')

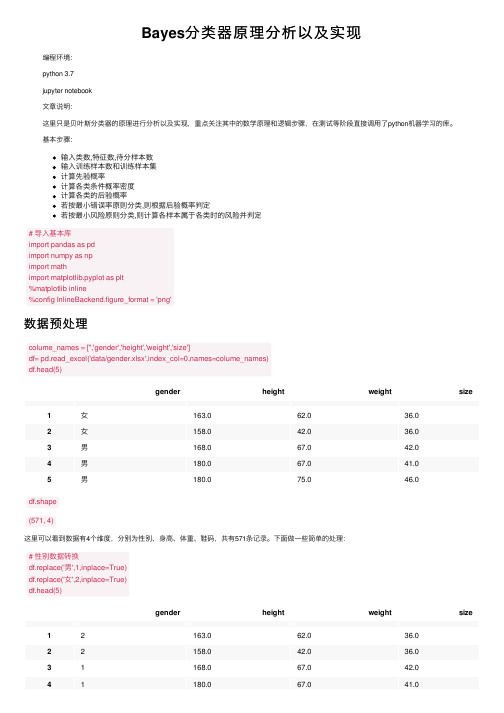

Bayes分类器原理分析以及实现

Bayes分类器原理分析以及实现编程环境:python 3.7jupyter notebook⽂章说明:这⾥只是贝叶斯分类器的原理进⾏分析以及实现,重点关注其中的数学原理和逻辑步骤,在测试等阶段直接调⽤了python机器学习的库。

基本步骤:输⼊类数,特征数,待分样本数输⼊训练样本数和训练样本集计算先验概率计算各类条件概率密度计算各类的后验概率若按最⼩错误率原则分类,则根据后验概率判定若按最⼩风险原则分类,则计算各样本属于各类时的风险并判定# 导⼊基本库import pandas as pdimport numpy as npimport mathimport matplotlib.pyplot as plt%matplotlib inline%config InlineBackend.figure_format = 'png'数据预处理colume_names = ['','gender','height','weight','size']df= pd.read_excel('data/gender.xlsx',index_col=0,names=colume_names)df.head(5)gender height weight size1⼥163.062.036.02⼥158.042.036.03男168.067.042.04男180.067.041.05男180.075.046.0df.shape(571, 4)这⾥可以看到数据有4个维度,分别为性别、⾝⾼、体重、鞋码,共有571条记录。

下⾯做⼀些简单的处理:# 性别数据转换df.replace('男',1,inplace=True)df.replace('⼥',2,inplace=True)df.head(5)gender height weight size12163.062.036.022158.042.036.031168.067.042.041180.067.041.0gender height weight size 51180.075.046.0# 男⽣⼥⽣数据分开male_df = df.loc[df['gender']==1]female_df = df.loc[df['gender']==2]female_df.head(5)gender height weight size 12163.062.036.022158.042.036.092160.045.036.0102163.048.037.0112161.045.036.01、单个特征——⾝⾼为了更加深⼊得理解贝叶斯分类器原理,我们从简单的⼀维特征开始。

贝叶斯分类

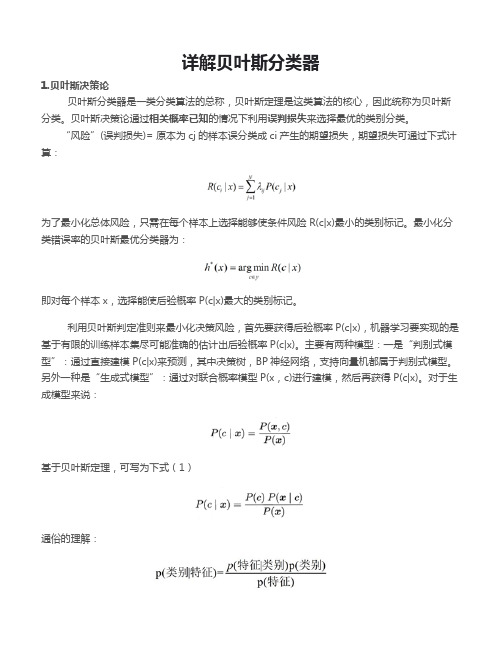

详解贝叶斯分类器1.贝叶斯决策论贝叶斯分类器是一类分类算法的总称,贝叶斯定理是这类算法的核心,因此统称为贝叶斯分类。

贝叶斯决策论通过相关概率已知的情况下利用误判损失来选择最优的类别分类。

“风险”(误判损失)= 原本为cj的样本误分类成ci产生的期望损失,期望损失可通过下式计算:为了最小化总体风险,只需在每个样本上选择能够使条件风险R(c|x)最小的类别标记。

最小化分类错误率的贝叶斯最优分类器为:即对每个样本x,选择能使后验概率P(c|x)最大的类别标记。

利用贝叶斯判定准则来最小化决策风险,首先要获得后验概率P(c|x),机器学习要实现的是基于有限的训练样本集尽可能准确的估计出后验概率P(c|x)。

主要有两种模型:一是“判别式模型”:通过直接建模P(c|x)来预测,其中决策树,BP神经网络,支持向量机都属于判别式模型。

另外一种是“生成式模型”:通过对联合概率模型P(x,c)进行建模,然后再获得P(c|x)。

对于生成模型来说:基于贝叶斯定理,可写为下式(1)通俗的理解:P(c)是类“先验”概率,P(x|c)是样本x相对于类标记c的类条件概率,或称似然。

p(x)是用于归一化的“证据”因子,对于给定样本x,证据因子p(x)与类标记无关。

于是,估计p(c|x)的问题变为基于训练数据来估计p(c)和p(x|c),对于条件概率p(x|c)来说,它涉及x所有属性的联合概率。

2.极大似然估计假设p(x|c))具有确定的形式并且被参数向量唯一确定,则我们的任务是利用训练集估计参数θc,将P(x|c)记为P(x|θc)。

令Dc表示训练集D第c类样本的集合,假设样本独立同分布,则参数θc对于数据集Dc的似然是对进行极大似然估计,就是去寻找能最大化P(Dc|θc)的参数值。

直观上看,极大似然估计是试图在θc所有可能的取值中,找到一个能使数据出现的“可能性”最大的值。

上式的连乘操作易造成下溢,通常使用对数似然:此时参数θc的极大似然估计为在连续属性情形下,假设概率密度函数,则参数和的极大似然估计为:也就是说,通过极大似然法得到的正态分布均值就是样本均值,方差就是的均值,在离散情况下,也可通过类似的方式估计类条件概率。

机器学习实验2-贝叶斯分类器设计

一、实验意义及目的1、掌握贝叶斯判别定理2、能利用matlab编程实现贝叶斯分类器设计3、熟悉基于matlab的算法处理函数,并能够利用算法解决简单问题二、算法原理贝叶斯定理是关于随机事件A和B的条件概率(或边缘概率)的一则定理。

其中P(A|B)是在B发生的情况下A发生的可能性公式为:贝叶斯法则:当分析样本大到接近总体数时,样本中事件发生的概率将接近于总体中事件发生的概率。

内容:(1)两类w服从正态分布,设计基于最小错误率的贝叶斯分类器,对数据进行分类。

(2)使用matlab进行Bayes判别的相关函数,实现上述要求。

(3)针对(1)中的数据,自由给出损失表,并对数据实现基于最小风险的贝叶斯分类。

三、实验内容(1)尝两类w服从正态分布,设计基于最小错误率的贝叶斯分类器,对数据进行分类。

代码清单:clc;clear all;meas=[0 0;2 0;2 2;0 2;4 4;6 4;6 6;4 6];%8x2矩阵这里一行一行2个特征[N n]=size(meas);species={'one';'one';'one';'one';'two';'two';'two';'two'};%这里也对应一行一行的sta=tabulate(species)[c k]=size(sta);priorp=zeros(c,1);for i=1:cpriorp(i)=cell2mat(sta(i,k))/100;%计算概率end%cell2mat(sta(:,2:3)) 提取数组中的数据本来sta数组中数据为矩阵不能直接用%估算类条件概率参数cpmean=zeros(c,n);cpcov=zeros(n,n,c);for i=1:ccpmean(i,:)=mean(meas(strmatch(char(sta(i,1)),species,'exact'),:));%exact精确查找cpmean放的每一类的均值点几类就几行cpcov(:,:,i)=cov(meas(strmatch(char(sta(i,1)),species,'exact'),:))*(N*priorp(i)-1)/(N*priorp(i));end%求(3 1)的后验概率x=[3 1];postp=zeros(c,1);for i=1:cpostp(i)=priorp(i)*exp(-(x-cpmean(i,:))*inv(cpcov(:,:,i))*(x-cpmean(i,:))'/2)/((2*pi)^(n/2)*det(cpcov(:,:,i)));endif postp(1)>postp(2)disp('第一类');elsedisp('第二类');end运行结果:(2)使用matlab进行Bayes判别的相关函数,实现上述要求。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

P( B y, M y ) P( B y M y ) 0.61 P( M y )

n n n

y y y

y y y

n n y

n y n

7.0E-9 1.3E-2 1.7E-4

机器学习基础-第五章Bayesian分类器

19

of

39

5.4贝叶斯网络

从这个例子中我们可以看出,需要计算的联 合概率分布P(B,E,A,M,J)上式包含25-1=31 个 参数,假设有n个二元变量,则需要的独立 参数数目为:2n-1,所以,直接使用联合概 率分布进行不确定性推理的计算复杂度很大 ,随着变量的个数呈指数级增长。因此,当 变量很多时,联合概率的获取、存储和运算 都变得相当困难。 基于以下原因,从而产生了贝叶斯网络: 全联合概率计算复杂性十分巨大 现实需要一种自然、有效的方式来捕捉和推 理——不确定性知识 变量之间的独立性和条件独立性可大大减少 为了定义全联合概率分布所需的概率数目。

自然状态 ┅ ω1 ω2 ┅ λ( ω 1 , α 1 ) λ( ω 2 , α 1 ) ┅ λ( ω 1 , α 2 ) λ( ω 2 , α 2 ) ⁞ ⁞ λ(ω1, αN) λ(ω2, αN) ⁞ ┅

4

ωN λ(ωN, α1) λ(ωN, α2) ⁞ λ(ωN, αN)

of

机器学习基础-第五章Bayesian分类器

39

决策αi风险: R i | x

N j 1

ij P j | x 总体风险: R(h) R h( x) | x Ex R( | x)

Bayes最 h* ( x) arg min R | x 优分类器: i Y 判别式模型(Discriminative Models):根据训练数据集D直接估 计后验概率模型。

贝叶斯网络(Bayes Network)是由 美国加州大学的珀尔(J.Pearl)于 1985年首先提出的一种模拟人类推 理过程中因果关系的不确定性处理 模型。 在综合先验信息(领域知识)和数 据样本信息的前提下,还可避免只 使用先验信息可能带来的主观偏见 贝叶斯网络方法的不确定性表示基 本上是保持了概率的表示方式,可 信度计算也是概率计算方法,只是 在实现时,各具体系统根据应用背 景的需要采用各种各样的近似计算 方法。

机器学习基础-第五章Bayesian分类器

11

of

39

5.2

平滑处理:某个属性值在训练集中没有与某个类同时出现过,会出现问题。如: P(敲=清|好)=0/8=0 P(好|测试)=0

Laplacian Correction:令N表示训练集D中可能的类比数,Ni表示第i个属性可能的 取值数。

Di 1 P(i ) D N

机器学习基础-第五章Bayesian分类器

10

of

39

5.2

P(触=硬|好)=6/8=0.75

P(触=硬|坏)=6/9=0.667

2 0.679 0.574 1 p midu 0.697 | hao exp 1.959 2 2 0.129 2 0.129 2 0.679 0.496 1 p midu 0.697 | huai exp 1.203 2 2 0.195 2 0.195

16

of

39

5.4贝叶斯网络

建立联合分布模型, 如果问题域由n个 布尔变量描述,则 需要O(2n)的概率表 作为知识库, O(2n) 的时间处理这个表。 实际问题中实现较 为困难。

利用条件独立性-贝叶斯网络

Cavity Toothache Catch Weather 其联合概率分布 需要32元素

Cavity Toothache Catch

Weather

其联合概率分布 8个元素和4个 元素的表构造

of

机器学习基础-第五章Bayesian分类器

39

5.4贝叶斯网络

Alarm问题:Pearl教授家住在洛杉矶,那里地震和盗窃时有发生,教授家里装有警铃 ,发生地震和盗窃都有可能触发警铃,他的两个邻居Mary和John听到警铃响后可能 会打电话给他。一天,Pearl教授接到Mary的电话,说听到他家的警铃响了,Pearl教 授想知道他家遭盗窃的概率有多大? B E A M J Probability 问题包含5个随机变量:盗窃(B)、地震(E)、 y n n y y 1.2E-4 警铃(A)、接到Mary的电话(M)、接到John y n n y n 5.1E-5 的电话(J);假设均为布尔形变量:T or F. y y n n y 5.7E-6 y y y n n 8.5E-5 假设Pearl教授根据自己以往的经验对这5个 y y y y y 7.2E-6 变量的联合概率分布有如下的估计(如右图) n n n y n 9.1E-1 ,从联合概率分布P(B,E,A,M,J)出发,先计 n n n n y 2.6E-4 算边缘分布 P( B, M ) P( B, E, A, J , M )

xD P( x | i ) xD ln P( x | i )

i

贝叶斯估计: θ是随机向量,具有先 验概率分布

6

of

机器学习基础-第五章Bayesian分类器

39

5.2

应用贝叶斯决策时主要的困难是贝叶斯公式 类条件概率P(x|ωi)的估计。因为其是属性变 量的联合概率分布。 朴素贝叶斯分类器的判别准则:

D

P i P x | i P i d j P(i | x) P x | i P x P x j 1

mi P i D m

8

of

Di

机器学习基础-第五章Bayesian分类器

39

5.2

类条件概率分布-离散属性:

j m P x j | i i Di mi

假设空间(H):先验概率分布P(ωi) ,类条件概率分布P(x| ωi) 求判别函数:ω i=h (x)

x1 2 是d维 x x 随机 向量 xd

决策 α1 α2 ⁞ αN

y是随机变量,(xT, y)服从 联合概率分布P(x, y); D是由P(x, y)独立同分部产 生的样例集合

i = arg max xD ln P( x | i )

i

连续属性概率密度函数:

p( x | i )

N (i , i )

1 i = Di 1 Di

2 i

xDi

x

xDi

x x

i i

T

H i i ln li (i ) ln P( Di | i ) ln

P(好|测试)=0.038

P(坏|测试)=6.80X10-5 结论----好瓜

0.46 0.279 2 1 p tiang 0.46 | hao exp 0.788 2 2 0.101 2 0.101

2 0.46 0.154 1 p tiang 0.46 | huai exp 0.066 2 2 0.108 2 0.108

类条件概率分布-连续属性:

Dij

p x j | i

d

N i j , i j 2

h* ( x) arg max P i P x j | i

i

j 1

x j j 2 1 i j p x | i exp 2 i j 2 2 i j

父属性的确定方法: SPODE方法:假设所有属性都依赖于 同一个属性,称为超父属性(Super Parent),通过模型选择的方法确定超 父属性。

y x

1

P(i | x) P i P x | i , px

j j 1

d

j

x

2

x

3

x

4

其中pxj是属性xj的父属性-依赖属性。

机器学习基础-第五章Bayesian分类器

机器学习基础

第五章贝叶斯判别器

智能科学与技术系

刘冀伟

1

1 2 3 4 5

贝叶斯决策论 朴素贝叶斯分类器 半朴素贝叶斯分类器 贝叶斯网络 EM算法

目录 CONTENT

已知-数据集合(D):

D x1 , y1 , x2 , y2 ,

, xm , ym

xi1 2 xi where : xi ; xd i yi Y {1 , 2 , , N }

14

of

39

TAN(Tree Augmented naїve Bayes)则是最大带权生成树算法的基础上通过以下步 骤得出属性的依赖关系。

机器学习基础-第五章Bayesian分类器

15

of

39

AODE(Averaged ODE)方法:将每个属 性作为超父属性来构建SPODE,然后将这 些具有足够训练数据支撑的SPODE集成起 来作为最终结果。

P x | i =P x , x ,

1 2

, x | i

d

h* ( x) arg max P i P x j | i

i

j 1

d

条件独立性假设:对已知类别,假设所有属 性相互独立,即每个属性独立的对分类结果 发生影响。

已知训练数据集D: ω1类-{x11, x12 ,┅,x1m1}=D1 ω2类-{x21,x22 ,┅, x2m2}=D2 ⁞ ⁞ ⁞ ωN类-{xN1,xc2 ,┅,xcmc} =DN 先验概率分布:

Bayes最优分类器的核心问题是求取:P | x 通常已知若干个样本: ω1类-{x11, x12 ,┅,x1m1}=D1 ω2类-{x21,x22 ,┅, x2m2}=D2 D ⁞ ⁞ ⁞ ωN类-{xN1,xc2 ,┅,xcmc} =DN 生成式模型(Generative Models): 先对联合概率P(x,ω)建模,然后再求 取后验概率模型。