linux集群

HP Linux高性能集群解决方案 -1102

前言高性能计算集群(HPCC-High Performance Computing Cluster)是计算机科学的一个分支,以解决复杂的科学计算或数值计算问题为目的,是由多台节点机(服务器)构成的一种松散耦合的计算节点集合。

为用户提供高性能计算、网络请求响应或专业的应用程序(包括并行计算、数据库、Web)等服务。

相比起传统的小型机,集群系统有极强的伸缩性,可通过在集群中增加或删减节点的方式,在不影响原有应用与计算任务的情况下,随时增加和降低系统的处理能力。

还可以通过人为分配的方式,将一个大型集群系统分割为多个小型集群分给多个用户使用,运行不同的业务与应用。

集群系统中的多台节点服务器系统通过相应的硬件及高速网络互连,由软件控制着,将复杂的问题分解开来,分配到各个计算节点上去,每个集群节点独立运行自己的进程,这些进程之间可以彼此通信(通常是利用MPI -消息传递接口),共同读取统一的数据资源,协同完成整个计算任务,以多台计算节点共同运算的模式来换取较小的计算时间。

根据不同的计算模式与规模,构成集群系统的节点数可以从几个到上千个。

对于以国家政府、军方及大型组织机构来讲,节点数目可以达到数千甚至上万。

而随着HPCC 应用的普及,中小规模的高性能计算集群也慢慢走进中小型用户的视野,高性能计算集群系统的部署,极大地满足了此类用户对复杂运算的能力的需求,大大拓展了其业务范围,为中小型用户的成长提供支持。

本次方案研究适合于中小规模用户的典型系统:基于32个计算节点和In finiBand 高速网络的Linux 集群。

惠普Linux 高性能集群方案方案描述此次方案中,高性能计算集群系统的节点由 HP BladeSystem 刀片服务器搭建,节点间通过InfiniBand 高速网络相连,管理、登录和存储节点由HP ProLiant机架式服务器构成,存储节点通过SAN 交换机外挂HPStorageWorks 磁盘阵列来存储大容量数据。

Linux 实战工程师系列 - Linux集群DR模式实

LINUX集群-DR直接路由VS/DR通过改写请求报文的MAC地址,将请求发送到真实服务器上。

而真实服务器将响应直接返回给客户。

VS/DR技术可极大地提高集群系统的伸缩性。

这种方法没有IP隧道的开销,对集群中的真实服务器也没有必须支持的IP隧道协议的要求,但是要去调度器与真实服务器都有一块网卡连在同一物理网段上。

VS/DR,直接路由模式如上图,客户向VIP发送请求,LVS通过改写mac地址,将请求提交到web server(真实的),然后web server将用户的请求直接返回给客户(中间不在经过LVS,这样减少LVS的负担,而VS/NAT模式web server返回给客户的请求也要经过LVS)设置VIP脚本(LVS服务器)Directorserver 222.90.88.30VIP=222.90.88.88Realserver 222.90.88.10Realserver 222.90.88.20gw 222.90.88.1### Directorserver Configure VIP######ifconfig eth0:0 222.90.88.88 broadcast 222.90.88.88 netmask 255.255.255.255 uproute add -host 222.90.88.88 dev eth0:0######setup ipvs######ipvsadm -A -t 222.90.88.88:80 -s rr (rr:轮叫模式)ipvsadm -a -t 222.90.88.88:80 -r 222.90.88.10 -g (-g:dr模式)ipvsadm -a -t 222.90.88.88:80 -r 222.90.88.20 -gipvsadmWeb Server1和2配置脚本######realserver######ifconfig lo:0 222.90.88.88 broadcast 222.90.88.88 netmask 255.255.255.255 uproute add -host 222.90.88.88 dev lo:0 (这边是通过改写MAC地址)echo “1” > /proc/sys/net/ipv4/conf/lo/arp_ignore (关闭arp的发包和广播)echo “2” > /proc/sys/net/ipv4/conf/lo/arp_announceecho “1” > /proc/sys/net/ipv4/conf/all/arp_ignoreecho “2” > /proc/sys/net/ipv4/conf/all/arp_announcesysctl -p操作:设置VIP脚本(LVS服务器)#vim /etc/init.d/vip.shifconfig eth0:0 222.90.88.88 broadcast 222.90.88.88 netmask 255.255.255.255 up(设置虚拟IP)route add -host 222.90.88.88 dev eth0:0 (给IP加上路由)ipvsadm -Cipvsadm -A -t 222.90.88.88:80 -s rripvsadm -a -t 222.90.88.88:80 -r 222.90.88.10 -gipvsadm -a -t 222.90.88.88:80 -r 222.90.88.20 -gipvsadm#chmod 777 /etc/init.d/vip.shWeb Server1和2配置脚本#vim /etc/init.d/lvs.shifconfig lo:0 222.90.88.88 broadcast 222.90.88.88 netmask 255.255.255.255 uproute add -host 222.90.88.88 dev lo:0echo “1” > /proc/sys/net/ipv4/conf/lo/arp_ignoreecho “2” > /proc/sys/net/ipv4/conf/lo/arp_announceecho “1” > /proc/sys/net/ipv4/conf/all/arp_ignoreecho “2” > /proc/sys/net/ipv4/conf/all/arp_announcesysctl -p(注:eth0,eth1,eth2……代表网卡一,网卡二,网卡三……lo代表127.0.0.1,即localhost)#chmod 777 lvs.sh#vim /var/www/html/index.html(Web Server 1)this is sev1#service httpd start#vim /var/www/html/index.html(Web Server 2)this is sev2#service httpd start客户端用http://222.90.88.88访问web服务,间隔产生this is sev1和this is sev2LVS--ipvsadm命令参数ipvsadm的用法和格式如下:ipvsadm -A|E -t|u|f virtual-service-address:port[-s scheduler] [-p timeout] [-M netmask]ipvsadm -D -t|u|f virtual-service-addressipvsadm -Cipvsadm -Ripvsadm -S [-n]ipvsadm -a|e -t|u|f service-address:port -r real-server-address:port [-g|i|m] [-w weight]ipvsadm -d -t|u|f service-address -r server-addressipvsadm -L|I [options]ipvsadm -Z [-t|u|f service-address]ipvsadm --set tcp tcpfin udpipvsadm --start -deamon state [--mcast -interface interface] ipvsadm --stop-deamonipvsadm -h。

Linux集群服务

Linux集群服务摘要:随着信息化的高速发展,很多网络服务因为访问次数爆炸式地增长而不堪重负,不能及时处理用户的请求,导致用户进行长时间的等待,大大降低了服务质量。

为解决这一问题,集群服务应运而生。

介绍了Linux操作系统集群服务的相关概念,并通过实例讲解了Linux操作系统集群服务的实际应用。

关键词:集群;调度;算法1集群的概念伴随着网络日新月异的发展,人们早已适应了拥有各种各样的网络服务的生活。

而提供网络服务的运营商遇到了前所未有的数据流量。

如何建立可伸缩的网络服务来满足不断增长的负载需求已成为迫在眉睫的问题。

大部分网站都需要提供每天24小时、每星期7天的服务,对电子商务等网站尤为突出,任何服务中断和关键性的数据丢失都会造成直接的商业损失。

如何来满足这些需求,如果只是通过不断提升服务器的本身性能,存在以下问题:①升级过程繁琐,更换服务器将使服务暂时中断,并造成原有计算资源的浪费;②越往高端的服务器,所花费的代价越大;③单个服务器是单一故障点,一旦该服务器或应用软件失效,会导致整个服务的中断。

为了解决这个问题,许多用户就采用一组集群来代替单一的机器。

集群可以将多台计算机连接起来协同运作以对外提供各种服务,如Apache、FTP、Mail等。

通过高性能网络或局域网互联的服务器集群正成为实现高可伸缩的、高可用网络服务的有效结构。

这种松耦合结构的服务器集群系统有下列优点:(1)集群都是使用常见的硬件进行构建的,其成本只是向量处理器的很小一部分。

在很多情况中,价格会低一个数量级以上。

(2)集群使用消息传递系统进行通信,程序必须显式地进行编码来使用分布式硬件。

(3)采用集群,您可以根据需要向集群中添加节点。

(4)开放源码软件组件和Linux 降低了软件的成本。

(5)集群的维护成本很低(它们占用的空间较小,耗费的电力较少,对于制冷条件的需求较低)。

2集群系统的分类(1)高可用集群。

一般提升系统可用性时,对构成系统的组件进行冗余化,消除单点故障是重要的。

Linux高性能计算集群

Linux高性能计算集群 -- Beowulf集群1 什么是Beowulf集群Beowulf是现存的最古老的英语史诗:Famed was this Beowulf: far ew the boast of him, son of Scyld, in the Scandian lands. So becomes it a youth to quit him well with his father's friends, by fee and gift, that to aid him, aged, in after days, come warriors willing, should war draw nigh, liegemen loyal: by lauded deeds shall an earl have honor in every clan.它歌颂了一个英雄,他拥有强壮的体魄和无人伦比的勇气。

他最终战胜了魔鬼Grendel. 你可以在/beowulf/index.html找到这首史诗。

我们所说的Beowulf首先是一个象史诗中英雄一样强大的集群系统。

在1994年夏季,Thomas Sterling和Don Becker在CESDIS(The Center of Excellence in SpaceData and Information Sciences)用16个节点和以太网组成了一个计算机集群系统,并将这个系统命名为Beowulf。

Beowulf集群。

Beowulf集群提供了一种使用COTS(Commodity off the shelf)硬件构造集群系统以满足特殊的计算需求的方法。

这里的COTS是指象PC和以太网这种广为应用的标准设备,它们通常可以由多家厂商提供,所以通常有很高的性价比。

Beowulf集群这种方法很快从NASA传遍了整个科研机构和社团。

实际上,Beowulf集群现在已被人们看作高性能计算中的一个分支或流派。

linux minio集群 超时参数

linux minio集群超时参数(原创实用版)目录1.介绍 Linux minio 集群2.解释超时参数3.探讨如何设置超时参数4.设置超时参数的注意事项5.总结正文【1.介绍 Linux minio 集群】Linux minio 集群是一种用于存储和管理大量对象的分布式系统。

它可以将数据分布在多个服务器上,以实现高可用性、可扩展性和容错能力。

在 Linux minio 集群中,超时参数是用于控制客户端与服务器之间通信的重要设置。

【2.解释超时参数】超时参数是用于控制客户端与服务器之间通信的时间限制。

在 Linux minio 集群中,主要有以下几个超时参数:- 连接超时:客户端与服务器建立连接的时间限制。

- 读取超时:客户端从服务器读取数据的时间限制。

- 写入超时:客户端向服务器写入数据的时间限制。

【3.探讨如何设置超时参数】设置 Linux minio 集群中的超时参数可以通过修改配置文件来实现。

以下是具体步骤:1.找到 minio.conf 配置文件。

通常,它位于/etc/minio/目录下。

2.打开配置文件,找到 [general] 部分。

3.在 [general] 部分中,添加以下几行代码:```connection_timeout = <数值>read_timeout = <数值>write_timeout = <数值>```其中,<数值>表示超时时间,单位为秒。

例如,要将连接超时设置为 5 秒,可以写成`connection_timeout = 5`。

【4.设置超时参数的注意事项】在设置超时参数时,需要注意以下几点:- 合理设置超时参数,以避免因为超时而导致的通信中断。

过短的超时时间可能会导致性能下降,过长的超时时间可能会导致通信失败。

- 在修改配置文件后,需要重启 minio 服务,使更改生效。

可以使用以下命令来重启 minio 服务:```sudo systemctl restart minio```【5.总结】在 Linux minio 集群中,合理设置超时参数对于保证系统的正常运行至关重要。

linux系统下安装zookeeper集群

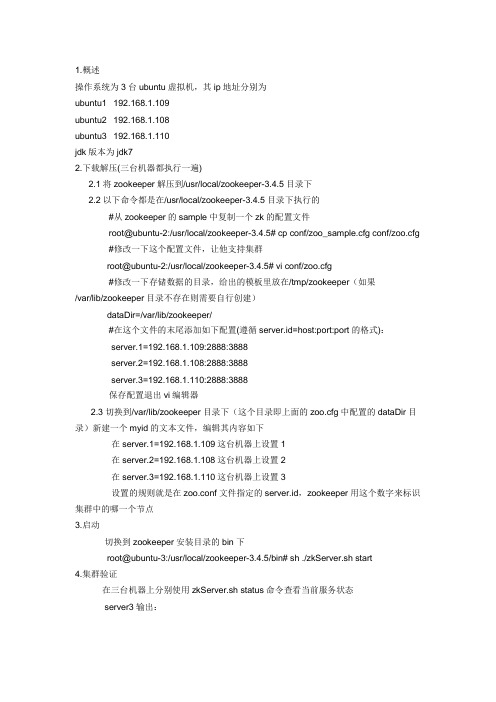

1.概述操作系统为3台ubuntu虚拟机,其ip地址分别为ubuntu1 192.168.1.109ubuntu2 192.168.1.108ubuntu3 192.168.1.110jdk版本为jdk72.下载解压(三台机器都执行一遍)2.1将zookeeper解压到/usr/local/zookeeper-3.4.5目录下2.2以下命令都是在/usr/local/zookeeper-3.4.5目录下执行的#从zookeeper的sample中复制一个zk的配置文件root@ubuntu-2:/usr/local/zookeeper-3.4.5# cp conf/zoo_sample.cfg conf/zoo.cfg #修改一下这个配置文件,让他支持集群root@ubuntu-2:/usr/local/zookeeper-3.4.5# vi conf/zoo.cfg#修改一下存储数据的目录,给出的模板里放在/tmp/zookeeper(如果/var/lib/zookeeper目录不存在则需要自行创建)dataDir=/var/lib/zookeeper/#在这个文件的末尾添加如下配置(遵循server.id=host:port:port的格式):server.1=192.168.1.109:2888:3888server.2=192.168.1.108:2888:3888server.3=192.168.1.110:2888:3888保存配置退出vi编辑器2.3切换到/var/lib/zookeeper目录下(这个目录即上面的zoo.cfg中配置的dataDir目录)新建一个myid的文本文件,编辑其内容如下在server.1=192.168.1.109这台机器上设置1在server.2=192.168.1.108这台机器上设置2在server.3=192.168.1.110这台机器上设置3设置的规则就是在zoo.conf文件指定的server.id,zookeeper用这个数字来标识集群中的哪一个节点3.启动切换到zookeeper安装目录的bin下root@ubuntu-3:/usr/local/zookeeper-3.4.5/bin# sh ./zkServer.sh start4.集群验证在三台机器上分别使用zkServer.sh status命令查看当前服务状态server3输出:root@ubuntu-3:/usr/local/zookeeper-3.4.5/bin# ./zkServer.sh statusJMX enabled by defaultUsing config: /usr/local/zookeeper-3.4.5/bin/../conf/zoo.cfgMode: leaderroot@ubuntu-3:/usr/local/zookeeper-3.4.5/bin#server2输出:root@ubuntu-2:/usr/local/zookeeper-3.4.5/bin# ./zkServer.sh statusJMX enabled by defaultUsing config: /usr/local/zookeeper-3.4.5/bin/../conf/zoo.cfgMode: followerroot@ubuntu-2:/usr/local/zookeeper-3.4.5/bin#server1输出:root@ubuntu-1:/usr/local/zookeeper-3.4.5/bin# sh ./zkServer.sh statusJMX enabled by defaultUsing config: /usr/local/zookeeper-3.4.5/bin/../conf/zoo.cfgMode: followerroot@ubuntu-1:/usr/local/zookeeper-3.4.5/bin#注意:实际的输出结果leader和follower可能会分步的节点不同,但是只会有一个leader,另外两个节点是folower。

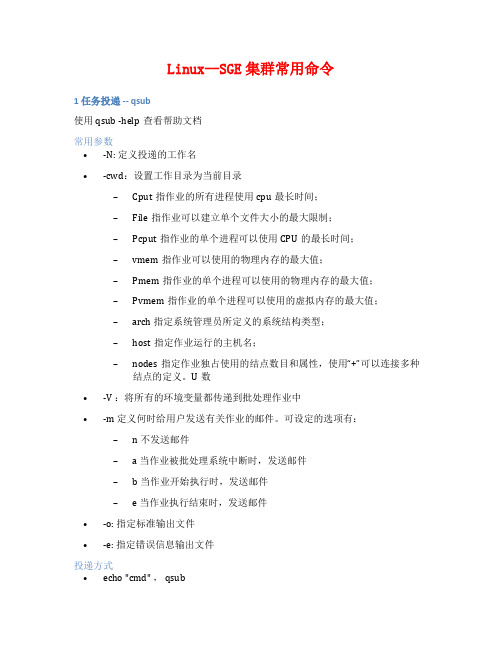

Linux--SGE集群常用命令

Linux--SGE集群常用命令1 任务投递 -- qsub使用qsub -help查看帮助文档常用参数•-N: 定义投递的工作名•-cwd:设置工作目录为当前目录–Cput指作业的所有进程使用cpu最长时间;–File指作业可以建立单个文件大小的最大限制;–Pcput指作业的单个进程可以使用CPU的最长时间;–vmem指作业可以使用的物理内存的最大值;–Pmem指作业的单个进程可以使用的物理内存的最大值;–Pvmem指作业的单个进程可以使用的虚拟内存的最大值;–arch 指定系统管理员所定义的系统结构类型;–host指定作业运行的主机名;–nodes指定作业独占使用的结点数目和属性,使用“+”可以连接多种结点的定义。

U数•-V :将所有的环境变量都传递到批处理作业中•-m 定义何时给用户发送有关作业的邮件。

可设定的选项有:–n 不发送邮件– a 当作业被批处理系统中断时,发送邮件– b 当作业开始执行时,发送邮件– e 当作业执行结束时,发送邮件•-o: 指定标准输出文件•-e: 指定错误信息输出文件投递方式•echo "cmd" , qsub使用echo命令直接将要执行的命令传递给qsub进行任务投递•echo "bash submit.sh" , qsub将要执行的命令写进文件,文件类型只要是可执行文件就行,并在文件前面说明用什么来读取文件,比如bash、Rscript、python等另外``qsub`的参数信息也可以写在要执行的文件里,如:# bin/bash #$ -V #$ -cwd #$ -l vf=25G #$ -m n -cwd -pe smp 8 #$ -N hahaha echo " Hellow world!"2 查看任务状态•qstat: 查看自己的所有任务状态•qstat -u nser_name: 查看用户的所有任务状态3 删除任务•qdel job_ID: 删除指定的任务•qdel -u user_name: 删除用户的所有任务。

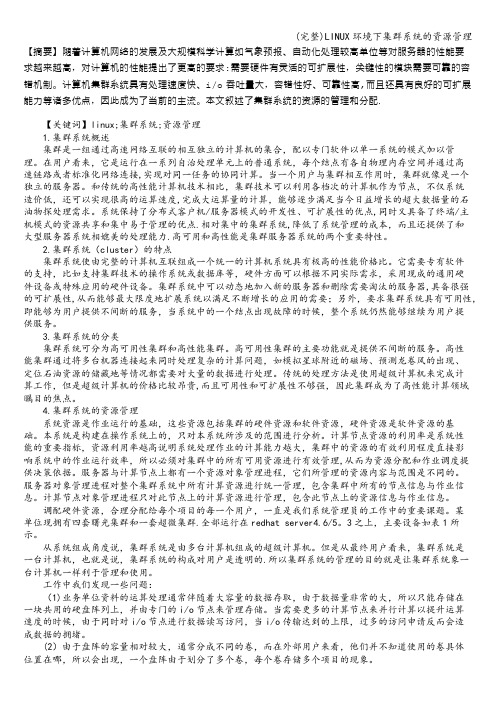

(完整)LINUX环境下集群系统的资源管理

【摘要】随着计算机网络的发展及大规模科学计算如气象预报、自动化处理较高单位等对服务器的性能要求越来越高,对计算机的性能提出了更高的要求:需要硬件有灵活的可扩展性,关键性的模块需要可靠的容错机制。

计算机集群系统具有处理速度快、i/o吞吐量大,容错性好、可靠性高,而且还具有良好的可扩展能力等诸多优点,因此成为了当前的主流。

本文叙述了集群系统的资源的管理和分配.【关键词】linux;集群系统;资源管理1.集群系统概述集群是一组通过高速网络互联的相互独立的计算机的集合,配以专门软件以单一系统的模式加以管理。

在用户看来,它是运行在一系列自治处理单元上的普通系统,每个结点有各自物理内存空间并通过高速链路或者标准化网络连接,实现对同一任务的协同计算。

当一个用户与集群相互作用时,集群就像是一个独立的服务器。

和传统的高性能计算机技术相比,集群技术可以利用各档次的计算机作为节点,不仅系统造价低,还可以实现很高的运算速度,完成大运算量的计算,能够逐步满足当今日益增长的超大数据量的石油物探处理需求。

系统保持了分布式客户机/服务器模式的开发性、可扩展性的优点,同时又具备了终端/主机模式的资源共享和集中易于管理的优点.相对集中的集群系统,降低了系统管理的成本,而且还提供了和大型服务器系统相媲美的处理能力.高可用和高性能是集群服务器系统的两个重要特性。

2.集群系统(cluster)的特点集群系统使由完整的计算机互联组成一个统一的计算机系统具有极高的性能价格比。

它需要专有软件的支持,比如支持集群技术的操作系统或数据库等,硬件方面可以根据不同实际需求,采用现成的通用硬件设备或特殊应用的硬件设备。

集群系统中可以动态地加入新的服务器和删除需要淘汰的服务器,具备很强的可扩展性,从而能够最大限度地扩展系统以满足不断增长的应用的需要;另外,要求集群系统具有可用性,即能够为用户提供不间断的服务,当系统中的一个结点出现故障的时候,整个系统仍然能够继续为用户提供服务。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

RHCS集群配置需要用到的各组件功能:RHCS(Red Hat Cluster Suite):能够提供高可用性、高可靠性、负载均衡、存储共享且经济廉价的集群工具集合。

LUCI:是一个基于web的集群配置方式,通过luci可以轻松的搭建一个功能强大的集群系统。

CLVM:Cluster逻辑卷管理,是LVM的扩展,这种扩展允许cluster中的机器使用LVM来管理共享存储。

CMAN:分布式集群管理器。

GFS(Google File System):以本地文件系统的形式出现。

多个Linux机器通过网络共享存储设备,每一台机器都可以将网络共享磁盘看作是本地磁盘,如果某台机器对某个文件执行了写操作,则后来访问此文件的机器就会读到写以后的结果。

实验需求:集群管理/ISCSI共享存储主机IP:192.168.0.40主机名: 集群节点一IP:192.168.0.41主机名:集群节点二IP:192.168.0.42主机名:一、【准备工作】1、修改管理主机和每个节点的hosts文件,保证三台服务器的hosts文件一样。

注:主机名最好使用域名形式,因为之前只用了gfs1这样的主机名,到后来,配置都顺利结束,但重启节点后,发现共享存储挂不上,看到是clvmd启动超时,估计是主机名的原因,解析不到?有待斟酌。

2、两台节点上分别关闭selinux、iptables和NetworkManager注:两台节点上都得操作,操作完后reboot重启两台节点,使配置生效二、【群集管理主机设置】1、安装并启用luci集群管理这时,你就可以用https://:8084(或https://192.168.0.40:8084)登陆集群web管理界面了,以root登陆即可三、【各节点配置】1、在两台节点分别yum安装ricci、rgmanager、cman启动cman如出现错误:Starting cman... xmlconfig cannot find /etc/cluster/cluster.conf [FAILED]是因为节点还没有加入集群,没有产生配置文件/etc/cluster/cluster.conf2、在两台节点上给ricci用户设置与root相同的密码四、【集群web管理界面配置】1、浏览器打开https://192.168.0.40:8084 输入root和root密码进行登陆2、添加集群点击Manager Clusters---> Create 创建一个集群,如下图,输入集群名称,添加每个节点的主机名、密码,勾选Download Packages、Reboot Nodes Before Jo ining Cluster、Enable Shared Storage Support,最后点击Create Cluster创建集群,耐心等待,创建过程中两台节点会重启...创建成功后显示如下:在到任意一个节点上去查看集群状态,都是Online,说明集群配置成功。

二、iscsi安装与配置1.安装target1 [root@target ~]# yum install -y scsi-target-utils2.配置target12345678910111213 [root@target ~]# vim /etc/tgt/targets.conf#<target .example:server.target2># direct-store /dev/sdd# incomingusersomeuser secretpass12#</target><target .test:teststore.sdb> #配置target名称<backing-store /dev/sdb> #配置共享磁盘vendor_id test #配置发行商(任意)lun 6 #配置LUN号</backing-store>incominguseriscsiuseriscsiuser #配置认证的用户名和密码initiator-address 192.168.18.0/24 #配置允许的网段</target>3.启动target并设置为开机自启动1234 [root@target ~]# service tgtd start[root@target ~]# chkconfigtgtd on[root@target ~]# chkconfigtgtd --listtgtd 0:关闭1:关闭2:启用3:启用4:启用5:启用6:关闭4.查看配置的target1234567891011121314151617181920212223 [root@target ~]# tgtadm --lldiscsi --mode target --op showTarget 1: .test:teststore.sdbSystem information:Driver: iscsiState: readyI_T nexus information:LUN information:LUN: 0Type: controllerSCSI ID: IET 00010000SCSI SN: beaf10Size: 0 MB, Block size: 1Online: YesRemovable media: NoPrevent removal: NoReadonly: NoBacking store type: nullBacking store path: NoneBacking store flags:Account information:iscsiuserACL information:192.168.18.0/245.在各节点上安装initiator1 [root@target ~]# ha sshnode$I 'yum install -y initiator'; done6.配置initiatornode1:1234567 [root@node1 ~]# vim /etc/iscsi/initiatorname.iscsi InitiatorName=.test:node1[root@node1 ~]# vim /etc/iscsi/iscsid.conf#修改下面三项node.session.auth.authmethod = CHAP #开启CHAP认证ername = iscsiuser #配置认证用户名node.session.auth.password = iscsiuser #配置认证密码node2:1234567 [root@node2 ~]# vim /etc/iscsi/initiatorname.iscsi InitiatorName=.test:node2[root@node2~]# vim /etc/iscsi/iscsid.conf#修改下面三项node.session.auth.authmethod = CHAP #开启CHAP认证ername = iscsiuser #配置认证用户名node.session.auth.password = iscsiuser #配置认证密码node3:1234567 [root@node3 ~]# vim /etc/iscsi/initiatorname.iscsiInitiatorName=.test:node3[root@node3 ~]# vim /etc/iscsi/iscsid.conf#修改下面三项node.session.auth.authmethod = CHAP #开启CHAP认证ername = iscsiuser #配置认证用户名node.session.auth.password = iscsiuser #配置认证密码7.各节点启动initiator并设置为开机自启动123456 [root@target ~]# ha sshnode$I 'service iscsi start'; done[root@target ~]# ha sshnode$I 'chkconfigiscsi on'; done[root@target ~]# ha sshnode$I 'chkconfigiscsi --list'; doneiscsi 0:关闭1:关闭2:启用3:启用4:启用5:启用6:关闭iscsi 0:关闭1:关闭2:启用3:启用4:启用5:启用6:关闭iscsi 0:关闭1:关闭2:启用3:启用4:启用5:启用6:关闭8.在各节点上发现一下target1234 [root@target ~]# ha sshnode$I 'iscsiadm -m discovery -t st -p 192.168.18.208:3260'; done192.168.18.208:3260,1 .test:teststore.sdb192.168.18.208:3260,1 .test:teststore.sdb192.168.18.208:3260,1 .test:teststore.sdb9.各节点登录一下target并查看一下磁盘123456789101112131415161718192021222324252627282930313233343536373839404 142434445464748495051525354555657585960616263646566676869707172737475767 778798081 [root@target ~]# ha sshnode$I 'iscsiadm -m node -T .test:teststore.sdb -p 192.168.18.208 -l'; done[root@target ~]# ha sshnode$I 'fdisk -l'; doneDisk /dev/sda: 21.5 GB, 21474836480 bytes255 heads, 63 sectors/track, 2610 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesSector size (logical/physical): 512 bytes / 512 bytesI/O size (minimum/optimal): 512 bytes / 512 bytesDisk identifier: 0x000dfcebDevice Boot Start End Blocks Id System/dev/sda1 * 1 26 204800 83 LinuxPartition 1 does not end on cylinder boundary./dev/sda2 26 1301 10240000 83 Linux/dev/sda3 1301 1938 5120000 83 Linux/dev/sda4 1938 2611 5405696 5 Extended/dev/sda5 1939 2066 1024000 82 Linux swap / Solaris Disk /dev/sdb: 21.5 GB, 21474836480 bytes255 heads, 63 sectors/track, 2610 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesSector size (logical/physical): 512 bytes / 512 bytesI/O size (minimum/optimal): 512 bytes / 512 bytesDisk identifier: 0x5f3b697cDevice Boot Start End Blocks Id SystemDisk /dev/sdd: 21.5 GB, 21474836480 bytes64 heads, 32 sectors/track, 20480 cylindersUnits = cylinders of 2048 * 512 = 1048576 bytesSector size (logical/physical): 512 bytes / 512 bytesI/O size (minimum/optimal): 512 bytes / 512 bytesDisk identifier: 0x0c68b5e3Device Boot Start End Blocks Id SystemDisk /dev/sda: 21.5 GB, 21474836480 bytes255 heads, 63 sectors/track, 2610 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesSector size (logical/physical): 512 bytes / 512 bytesI/O size (minimum/optimal): 512 bytes / 512 bytesDisk identifier: 0x000dfcebDevice Boot Start End Blocks Id System/dev/sda1 * 1 26 204800 83 LinuxPartition 1 does not end on cylinder boundary./dev/sda2 26 1301 10240000 83 Linux/dev/sda3 1301 1938 5120000 83 Linux/dev/sda4 1938 2611 5405696 5 Extended/dev/sda5 1939 2066 1024000 82 Linux swap / Solaris Disk /dev/sdb: 21.5 GB, 21474836480 bytes255 heads, 63 sectors/track, 2610 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesSector size (logical/physical): 512 bytes / 512 bytesI/O size (minimum/optimal): 512 bytes / 512 bytesDisk identifier: 0x00000000Disk /dev/sdd: 21.5 GB, 21474836480 bytes64 heads, 32 sectors/track, 20480 cylindersUnits = cylinders of 2048 * 512 = 1048576 bytesSector size (logical/physical): 512 bytes / 512 bytesI/O size (minimum/optimal): 512 bytes / 512 bytesDisk identifier: 0x0c68b5e3Device Boot Start End Blocks Id SystemDisk /dev/sda: 21.5 GB, 21474836480 bytes255 heads, 63 sectors/track, 2610 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesSector size (logical/physical): 512 bytes / 512 bytesI/O size (minimum/optimal): 512 bytes / 512 bytesDisk identifier: 0x000dfcebDevice Boot Start End Blocks Id System/dev/sda1 * 1 26 204800 83 LinuxPartition 1 does not end on cylinder boundary./dev/sda2 26 1301 10240000 83 Linux/dev/sda3 1301 1938 5120000 83 Linux/dev/sda4 1938 2611 5405696 5 Extended/dev/sda5 1939 2066 1024000 82 Linux swap / Solaris Disk /dev/sdb: 21.5 GB, 21474836480 bytes255 heads, 63 sectors/track, 2610 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesSector size (logical/physical): 512 bytes / 512 bytesI/O size (minimum/optimal): 512 bytes / 512 bytesDisk identifier: 0x00000000Disk /dev/sdd: 21.5 GB, 21474836480 bytes64 heads, 32 sectors/track, 20480 cylindersUnits = cylinders of 2048 * 512 = 1048576 bytesSector size (logical/physical): 512 bytes / 512 bytesI/O size (minimum/optimal): 512 bytes / 512 bytesDisk identifier: 0x0c68b5e3Device Boot Start End Blocks Id System好了,到这里iscsi配置全部完成,下面我们来配置一下,集群。