一类非光滑非凸优化问题的神经网络方法

求解一类奇异非线性凸优化问题的神经网络方法

Ab s t r a c t : I n t h i s pa p e r ,a n o v e l n e ur a l n e t wo r k mo d e l f o r s o l v i ng s i n g ul a r n o n l i n e a r c o n v e x o p t i -

非 线 性 凸 优 化 问 题 的 神 经 网 络 模 型 。X i a和 Wa n g 。 。 成 功地 建 立 了几 个 解 决线 性 及 二 次 凸

t h e e fe c t i v e ne s s o f t h e p r o p o s e d n e ur a l ne t wo r k mo d e 1 .

Ke y wo r d s:n e u r a l n e t wo r k s; s i n g u l a r n o n l i n e a r c o nv e x o p t i mi z a t i o n; i n v a r i a n c e p in r c i p l e;

中 图分 类 号 : O 2 2 1 . 2 文 献标 志码 : A

M o d i ie f d Ne ur a l Ne t wo r k Me t h o d f o r So l v i ng a S i ng u l a r No n l i ne a r Co nv e x Opt i mi z a t i o n Pr o b l e ms

文章 编 号 : 1 0 0 9—3 1 5 X( 2 0 1 3 ) 0 1 — 0 0 0 2— 0 4

求 解一 类奇 异 非 线 性 凸优 化 问题 的 神 经 网络 方 法

葛仁 东 , 刘 力 军

神经网络优化算法的设计和分析

神经网络优化算法的设计和分析神经网络作为一种人工智能技术,已经被广泛应用于各种领域,如图像识别、自然语言处理、机器翻译等等。

神经网络的优化算法是决定其性能的关键因素之一,因此对于神经网络优化算法的设计和分析具有重要的意义。

一、神经网络优化算法的目标和挑战神经网络优化算法的主要目标是寻求网络中权重和偏置的最优解,使得网络的输出与真实值尽可能接近。

然而,由于神经网络具有多个层和大量的连接,其优化过程变得十分困难。

具体挑战包括以下几点:1. 高维度:神经网络的权重和偏置通常是高维的,这就意味着对于优化算法的可行性和效率提出更高的要求。

2. 非凸性:神经网络优化问题是一个非凸的问题,存在多个局部最优解,因此需要设计算法使其能够找到全局最优解。

3. 噪声影响:神经网络优化过程中会存在一定的噪声干扰,如数据噪声、网络结构噪声等,这可能影响优化的效果。

二、常见的神经网络优化算法常见的神经网络优化算法包括梯度下降法、共轭梯度法、牛顿法等。

在实际应用中,这些算法通常会结合其他技术进行改进和优化。

1. 梯度下降法梯度下降法是一种常见的优化算法,在神经网络中被广泛使用。

该算法的基本原理是根据损失函数的梯度方向来更新权重和偏置。

梯度下降法的优点是收敛速度较快,但需要注意的是,该方法容易陷入局部最优解。

2. 共轭梯度法共轭梯度法通过选择共轭的搜索方向,降低了搜索的方向数,从而提高了算法的效率。

由于共轭梯度法考虑了梯度的方向性,因此可以有效地避免梯度下降法的局部最优解问题。

3. 牛顿法牛顿法是一种基于牛顿迭代的优化算法,在神经网络中被广泛使用。

该算法通过二次近似估计函数曲线来更新权重和偏置,因此具有一定的快速性和性能,但对于计算量较大的网络,牛顿法的效率可能较低。

三、深度优化和自适应算法为了有效地解决神经网络优化中的挑战和问题,一些新的深度优化和自适应算法不断涌现。

这些算法具有更加复杂的设计和实现方式,并且包含了更多的在线性和非线性搜索技术。

拉格朗日神经网络解决带等式和不等式约束的非光滑非凸优化问题

拉格朗日神经网络解决带等式和不等式约束的非光滑非凸优化问题喻昕;许治健;陈昭蓉;徐辰华【摘要】Nonconvex nonsmooth optimization problems are related to many fields of science and engineering applications, which are research hotspots. For the lack of neural network based on early penalty function for nonsmooth optimization problems, a recurrent neural network model is proposed using Lagrange multiplier penalty function to solve the nonconvex nonsmooth optimization problems with equality and inequality constrains. Since the penalty factor in this network model is variable, without calculating initial penalty factor value, the network can still guarantee convergence to the optimal solution, which is more convenient for network computing. Compared with the traditional Lagrange method, the network model adds an equality constraint penalty term, which can improve the convergence ability of the network. Through the detailed analysis, it is proved that the trajectory of the network model can reach the feasible region in finite time and finally converge to the critical point set. In the end, numerical experiments are given to verify the effectiveness of the theoretic results.%非凸非光滑优化问题涉及科学与工程应用的诸多领域,是目前国际上的研究热点.该文针对已有基于早期罚函数神经网络解决非光滑优化问题的不足,借鉴Lagrange乘子罚函数的思想提出一种有效解决带等式和不等式约束的非凸非光滑优化问题的递归神经网络模型.由于该网络模型的罚因子是变量,无需计算罚因子的初始值仍能保证神经网络收敛到优化问题的最优解,因此更加便于网络计算.此外,与传统Lagrange方法不同,该网络模型增加了一个等式约束惩罚项,可以提高网络的收敛能力.通过详细的分析证明了该网络模型的轨迹在有限时间内必进入可行域,且最终收敛于关键点集.最后通过数值实验验证了所提出理论的有效性.【期刊名称】《电子与信息学报》【年(卷),期】2017(039)008【总页数】6页(P1950-1955)【关键词】拉格朗日神经网络;收敛;非凸非光滑优化【作者】喻昕;许治健;陈昭蓉;徐辰华【作者单位】广西大学计算机与电子信息学院南宁 530004;广西大学计算机与电子信息学院南宁 530004;广西大学计算机与电子信息学院南宁 530004;广西大学电气工程学院南宁 530004【正文语种】中文【中图分类】TP183作为解决优化问题的并行计算模型,递归神经网络在过去的几十年里受到了极大的关注,不少神经网络模型被提出。

非光滑凸优化问题的二层递归神经网络(英文翻译)

是凸性的,则:

1) 在凸分析的意义上, f 在 x 处的 Clarke 次微分与 f 在 x 处的次微分 同时发生,i.e., f x0

n

: f x0 f x , x0 x , x

n

;

2) f ( ) 是极大单调的, i.e., x x0 , 0 0 f x , 0 f x0 ; 3) f ( ) 是上半连续的; 定义 2.2:f 在已知的 x 处是周期的,对所有的 存在;对所有

n

是周期的并且在任意紧密区间

n

是绝对连续的,,则 x t 和 V x t :[0, )

是可微的,并且

V x t , x t V x t

对于 a.e. t [0, )

不失一般性 ,本文中我们假设非线性规划(1)至少有一个最优解。接下来介绍 非线性规划(1)中非光滑 KKT 条件。根据[28,Th.1],有以下根据: 引理 2.2:令 f 和 g 是凸性的,则 x* 是非线性规划(1)中的最优解,当且 仅当 *

条件, 我们证明了本文提出的神经网络的稳定性。 在本文章我们仅仅假设(1)中的

f 和 g 是凸形的,这是凸优化问题基本的假设。同时,(1)式中的 A 经过初等行变

换可以变成一个行满秩矩阵并且保持等式约束 Ax b 不变。因此不失一般性,我 们假设 A 是一个行满秩矩阵。 文章的其余部分内容如下:第二部分中,我们做了一些预备工作并且为(1) 中的问题给出了 Karush–Kuhn–Tucker(KKT)条件;第三部分,我们将介绍一个 简单的神经网络并证明所提出的神经网络的平衡点集等价于(1)中非光滑凸优化 问题中 KKT 最优集,然后,在第四部分研究了所提出的神经网络的收敛性分析; 第五部分,我们将用两个例子来阐述我们的结果;最后徐,在第六部分为本文的 小结。

拉格朗日神经网络解决非凸优化问题

1 ∽ e c t t o {

了初始条件缺失的的限制 ,易实现 ,同时对于

非 凸 且 非 光 滑 的 情 形 ,给 出 了光 滑 化 的 处 理 方

这里 ,C 是标量 ,1 . I 代表欧几里得范式 。 若x 是优化 问题 的最 小点 ,则 h ( x ) = 0 ,因此

定 点就 是 优 化 问题 局 部 或整 体 最优 解 。基 于 拉

格 朗 日 乘 子 理 论 ,Z h a n g和 C o n s t a n t i n i d e s提 S l

出了拉格 朗 日神经 网络解 决非线性规 划问题 , 这种方法通过把 约束整 合到一个修 正函数 中来 处理约 束,避 免了计 算上的困难。然而应用拉 格 朗 日神经网络解决的优化 问题多为光滑和凸 优 化问题,本文介绍 了拉格朗 日神经网络解决

效性及正确性 。

S =S1 n S 2 。

定义 1 : 设

一 R是 非 光 滑 连 续 函数 ,

若 函 数 ,(・ , ∞ ) 满 足 条件 :对 于 任 意 给定 的

∞ > 0 ,, (・ , ∞ ) 在 连 续 可 微 ,并 且 对 于 任 意

给定的X E R , f ( x , ・ ) 在 ( 即 【 o , + ) ) 可微,

粤: v ( , 五 , ) = ^ ( ( r ) ) . ! } = 工 ( ‘ , ) = g ( ( f ) )

上 述 增 广 拉 格 朗 日神 经 网 络 模 型 中 参 数 C

1预备知识

本 文 考 虑 如下 的优 化 问题 :

作用:凸化 目标函数 ,当参数 c足够大时,可

以使 优 化 问 题 满 足 局 部 凸 性 ; 加 快 网 络 轨 迹 的

一类非凸优化问题的 UV-分解方法

一类非凸优化问题的 UV-分解方法王炜;刘洪莹;王超楠【摘要】对于非光滑优化问题的研究往往从非光滑函数的本身出发,未曾考虑其特有的结构,即函数本身可能包含光滑部分.U V-分解理论是借助于凸函数中的光滑信息得到函数的光滑近似进而解决凸优化问题的一种新的方法,而Bundle方法是处理某些非光滑无约束优化问题的可执行算法.考虑到2种方法的各自特点,将这2种方法相结合,针对由非光滑的凸函数与光滑的非凸函数的和函数构成的一类函数进行研究,并借助于下半连续函数的迫近次微分,得到这类函数的UV-空间分解,U-Lagrange函数的一些性质,给出了结合Bundle方法的UV-分解算法,用于求解所研究函数的极小化问题,并证明了算法的收敛性.%T he currently available algorithms to solve the nonsmooth constrained minimization prob-lems pay mostly more attention to nonsmoothness (nondifferentiability ) in the problems ,without taking the special feature certained structural properties of the problem itself into consideration , which possess a certain smoothness (differentiability) .An effective method for solving convex opti-mization problems is the UV-decomposition theory ,and some nonsmooth unconstrained nonlinear programming problems can be solved by the Bundle method .Combining these two methods ,we can handle a class of functions ,w hich are constituted by a nonsmooth convex function and a smooth non-convex function .Using the proximal subdifferential of lower semi-continuous function and an UV-de-composition method ,some properties will be obtained .Then the UV-decomposition algorithm combi-ning with the Bundle method will be shown ,meanwhile ,the convergence will be solved .【期刊名称】《辽宁师范大学学报(自然科学版)》【年(卷),期】2015(000)004【总页数】6页(P433-438)【关键词】非光滑优化;凸函数;UV-分解理论;Bundle算法【作者】王炜;刘洪莹;王超楠【作者单位】辽宁师范大学数学学院,辽宁大连116029;辽宁师范大学数学学院,辽宁大连 116029;辽宁师范大学数学学院,辽宁大连 116029【正文语种】中文【中图分类】O221.2由C.Lemaréchal,F.Oustry和C.Sagastizábal(2000年)[1]等提出的UV-空间分解理论是一种研究非光滑凸函数二阶近似结构的方法,其主要思想是将空间n分解成2个正交子空间U和V的直和,使函数在空间U上的一阶逼近是线性的,而其不光滑特征集中于V中,借助于一个中间函数——U-Lagrange函数,进而得到函数在切于U的某个光滑轨道上的二阶展式.针对实际问题中某些非凸的约束优化问题,经过适当的变化可以转化为形如的无约束优化问题,但由于函数是非凸的,故不能直接地应用UV-分解理论来得到其二阶近似,笔者借助于迫近次微分,得到这类函数的UV-空间分解,U-Lagrange函数的一些性质,结合Bundle方法给出求解此类优化问题的UV-分解算法.考虑函数其中,h1(x)是有限值非光滑凸函数,h2(x)是有限值光滑函数.由于和函数f(x)往往是非凸函数,因此借助于函数的迫近次微分给出UV-空间分解.定义1.1[2] 向量ξ∈n称为函数f在点x∈domf的一个迫近次梯度(或P-次梯度),如果这里是epif在点(x,f(x))的迫近法锥.所有这样的点ξ∈n所成的集合称为f在点x∈domf的迫近次微分,或P-次微分,记为∂Pf(x).性质1.1[2] 设是下半连续函数,x∈domf,则ξ∈∂Pf(x)当且仅当存在正数σ和η,使得性质1.2 设函数f形如式(1),如果在B(x,η)中h2(x)∈C2,则给出空间如下的UV-分解.定义1.2 设函数形如(1),定义n的子空间V平行于所生成的仿射包,即U:=V⊥,其中是任意的.定理1.1 如上定义的空间U,V有如下等价形式:(i)U是使方向导数为线性函数的子空间,V:=U⊥.由于是次线性的,所以有(ii)定义U和V分别为在点g°处的法锥和切锥(见文献[3]),即其中是任意的.并且U满足如下关系式:定义1.3 (U-Lagrange函数)设⊕是半正定的为子空间U的一个基矩阵定义式(1)中的函数f(x)的U-Lagrange函数如下:在V-空间中相伴的最优解集为定理1.2 设函数f(x)如式(1)定义的,则下列结论成立:(i)式(3)所定义的函数是有限值凸函数;(ii)0∈W(0),且在u=0处是可微的,并且有定理1.3 如果函数⊕在u=0处有一个广义Hessian阵H1,则对u∈U,f有如下的二阶展开式这里,x∈u⊕).2.1 UV-算法在文献[4]中,利用原始对偶轨道、迫近点函数,结合束方法给出了UV-空间分解算法,用来求解凸函数极小化问题.下面将借助于非凸函数的UV-空间分解,给出求解问题(P)的极小化问题的算法.定义2.1[4] 设是f的极小值点,称(χ(u),γ(u))是通向的原始对偶轨道,如果对足够小的u∈dimU,原始轨道:对偶轨道:满足以下条件:(i)v:dimU→dimV是C2函数,且对所有的有v(u)∈W(u);(ii)雅可比矩阵Jχ(u)是V(χ(u))⊥的基矩阵;(iii)U-Lagrange函数LU(u,-g′)是C2函数.定义2.2[5] 函数f的迫近点函数定义如下:命题2.1[6] (i)gμ(x):=μ(x-pμ(x))∈∂Pf(pμ(x));(ii)若是f的极小值点,则且‖‖2≤‖‖2-‖x-pμ(x)‖2.UV-分解算法:初始化:选取参数n是初始点,g0∈∂Pf(p0)是初始的迫近次梯度,U0是近似U 空间的n维列正交的基矩阵,置s0:=g0,k:=0.停止准则:‖sk‖2≤ε.U-Hessian阵:选取一个nk×nk的正定矩阵Hk,其中,nk是Uk的列的个数. 置原始-对偶轨道候选点:选取初始化求解束方法子问题,重复计算:直到满足其中,(ρ/μ-2σB)=(ρk+1/μk+1-2σk+1).令生成新迭代点:若则点是一个好的迭代点,并且令否则在pk与之间执行线搜索来找到xk+1,使其满足f(xk+1)≤f(pk),重新初始化B,令x=xk+1,重新执行上述的束方法子程序,来找到新的然后令).循环:k=k+1,直到满足停止准则.2.2 束(Bundle)方法子问题给定一个偏差迫近参数μ>0,迫近中心x∈n,来寻找pμ(x)的一个σ-近似.束方法子问题的束信息为其中,B是一个指标集,包含一个指标j,使得yj=x.记线性误差记为:由于函数f是非凸的,故ei有可能小于0,但由于求解的是极小化问题,所以对于ei<0的yi舍去不要.由gi∈∂Pf(yi),由性质1.1有,∃σi>0,ηi>0,∀x∈B(yi,ηi)使当σ≥σi时,上式均成立.令同理,∃使假设序列有界,记为σB,结合上面2个式子可以得到:由于x∈B(yi,ηi),z∈B(yi,ηi),所以有‖z-x‖≤2ηi,而当x充分接近yi时,‖x-yi‖就可以充分小,就会得到从而相应的束信息变为定义函数则问题的对偶问题为它们的解分别记为且满足以下关系式:为方便起见,将结果简记为:更新数据.相应的新的指标为i+,让计算同时取).由于是可利用的,因此在点处,能计算出V模型的精确误差通过解决下面的二次规划问题来得到对偶轨道点的近似,记为二次规划问题与如下指标集有关:‖p-x‖2-2εi}∪{i+}.二次规划问题为:它的对偶问题为:它们的解分别记为和满足空间n的基矩阵的构造,要使得的列是正交的因此,定义一个非空的紧的指标集,}.则由式(5),对所有的有故对某个固定的对所有的都有通过选择满足式(6)的最大的指标i来定义一个列满秩的矩阵相应的线性无关的向量gi-gl构成它的列向量.矩阵的列向量是由的零空间的正交基构成的,同时,若V={0},则为了方便,将其结果简记为:若则束方法子问题终止,并称为pμ(x)的一个ρ-近似;否则,上述的B将由所代替,通过解决新的子问题来得到新的迭代数据.2.3 算法的收敛性定义2.3 设ε>0,若∃η>0,使得∀z∈B(x,η),都有f(z)≥f(x)-ε,则称x是函数f 的局部ε-极小值点.引理2.1 上述问题每一步迭代的结果为且则有以下结论成立:(i)对所有的若是空的,则(v)‖‖≤‖‖,其中;除此之外,若对任意的m∈(0,1),满足式(7),可得到定理2.1 对于算法,有如下结果:(i)假设束子问题不终止,即式(7)不成立,则序列并且pμ(x)是函数f的局部ε-极小值点;(ii)若当时,束方法子问题终止,则也是函数f的局部ε-极小值点;(iii)在上述2种情况下均有pμ(x)-x∈V(pμ(x)).定理2.2 假设算法产生的序列都有界,分别取上界记为μ,σ,其中,μ>σ,则下列结论成立:(i)序列{f(pk)}是递减的,并且有f(pk)→-∞,或者都收敛于0;(ii)若f是下有界函数,则的任一聚点是函数f的局部ε-极小值点.定义2.4 若并且相应的U-Lagrange函数LU(u,-g′)在u=0出的Hessian是正定的,则称是f的强极小值点.推论2.1 假设是f的强极小值点,算法产生的序列的上界为则(k→∞).进一步,若有界,则和都收敛到收敛到0.(1)凡是可以使用阿拉伯数字且得体的地方,均应使用阿拉伯数字.(2)日期和时刻的表示方法:a.公历世纪、年代、年、月、日和时刻用阿拉伯数字.年份不能简写,如1993年不能写成93年.b.日期可采用全数字式写法,如1993-02-18或1993 02 18或19930218.c.日的时刻表示可用GB 2809的规定写法,如15时9分38.5秒写作15:09:38.5或150938.5.(3)阿拉伯数字的使用规则:a.多位的阿拉伯数字不能拆开转行.b.计量和计数单位的数字必须用阿拉伯数字.c.小数点前或后若超过4位数(含4位),应从小数点起向左或向右每3位空出1/4个字长,不用千分撇“′”.d.尾数“0”多的5位以上数字,可以改写以万和亿为单位的数.一般情况下不得以十、百、千、十万、百万、千万、十亿、百亿、千亿等作单位(百、千、兆等词头除外),如1 800 000可写成180万.【相关文献】[1] LEMARÉCHAL C,OUSTRY F,SAGASTIZBAL C. The U-Lagrangian of a convexfunction[J].Trans Amer Math Soc,2000,352(2):711-729.[2] CLARKE F H,LEDYAEV Y S,STERN RJ,et al. Nonsmooth analysis and controltheory[M].Berlin,Heidelberg:Springer-Verlag,1998:4-39.[3] ROCKAFELLAR R T,WETS R J-T. Varitional analysis[M].Berlin,Heidelberg:Springer-Verlag,1998.[4] MIFFLIN R,SAGASTIZBALC.A VU-algorithm for convex minimization[J].Math Programming Ser B,2005,104:583-608.[5] CORREA E,LEMARÉCHAL C.Convergence of some algorithms for convex minimization[J].Math Program,1993,62(2):261-275.[6] ROCKAFELLAR R.Monotone operators and the proximal point algorithm[J].SIAM Journal on Control and Optimization,1976,14:877-898.。

非光滑凸情形Adam 型算法的最优个体收敛速率

DOI : 10.11992/tis.202006046非光滑凸情形Adam 型算法的最优个体收敛速率黄鉴之1,丁成诚1,陶蔚2,陶卿1(1. 中国人民解放军陆军炮兵防空兵学院 信息工程系,安徽 合肥 230031; 2. 中国人民解放军陆军工程大学 指挥控制工程学院,江苏 南京 210007)l 1摘 要:Adam 是目前深度神经网络训练中广泛采用的一种优化算法框架,同时使用了自适应步长和动量技巧,克服了SGD 的一些固有缺陷。

但即使对于凸优化问题,目前Adam 也只是在线学习框架下给出了和梯度下降法一样的regret 界,动量的加速特性并没有得到体现。

这里针对非光滑凸优化问题,通过巧妙选取动量和步长参数,证明了Adam 的改进型具有最优的个体收敛速率,从而说明了Adam 同时具有自适应和加速的优点。

通过求解 范数约束下的hinge 损失问题,实验验证了理论分析的正确性和在算法保持稀疏性方面的良好性能。

关键词:机器学习;AdaGrad 算法;RMSProp 算法;动量方法;Adam 算法;AMSGrad 算法;个体收敛速率;稀疏性中图分类号:TP181 文献标志码:A 文章编号:1673−4785(2020)06−1140−07中文引用格式:黄鉴之, 丁成诚, 陶蔚, 等. 非光滑凸情形Adam 型算法的最优个体收敛速率[J]. 智能系统学报, 2020, 15(6):1140–1146.英文引用格式:HUANG Jianzhi, DING Chengcheng, TAO Wei, et al. Optimal individual convergence rate of Adam-type al-gorithms in nonsmooth convex optimization[J]. CAAI transactions on intelligent systems, 2020, 15(6): 1140–1146.Optimal individual convergence rate of Adam-type algorithms innonsmooth convex optimizationHUANG Jianzhi 1,DING Chengcheng 1,TAO Wei 2,TAO Qing 1(1. Department of Information Engineering, Army Academy of Artillery and Air Defense of PLA, Hefei 230031, China; 2. Command and Control Engineering, Army Engineering University of PLA, Nanjing 210007, China)Abstract : Adam is a popular optimization framework for training deep neural networks, which simultaneously employs adaptive step-size and momentum techniques to overcome some inherent disadvantages of SGD. However, even for the convex optimization problem, Adam proves to have the same regret bound as the gradient descent method under online optimization circumstances; moreover, the momentum acceleration property is not revealed. This paper focuses on nonsmooth convex problems. By selecting suitable time-varying step-size and momentum parameters, the improved Adam algorithm exhibits an optimal individual convergence rate, which indicates that Adam has the advantages of both adaptation and acceleration. Experiments conducted on the l 1-norm ball constrained hinge loss function problem verify the correctness of the theoretical analysis and the performance of the proposed algorithms in keeping the sparsity.Keywords : machine learning; AdaGrad algorithm; RMSProp algorithm; momentum methods; Adam algorithm; AMS-Grad algorithm; individual convergence rate; sparsityAdam 是目前深度学习中广泛采用的一种优化算法[1]。

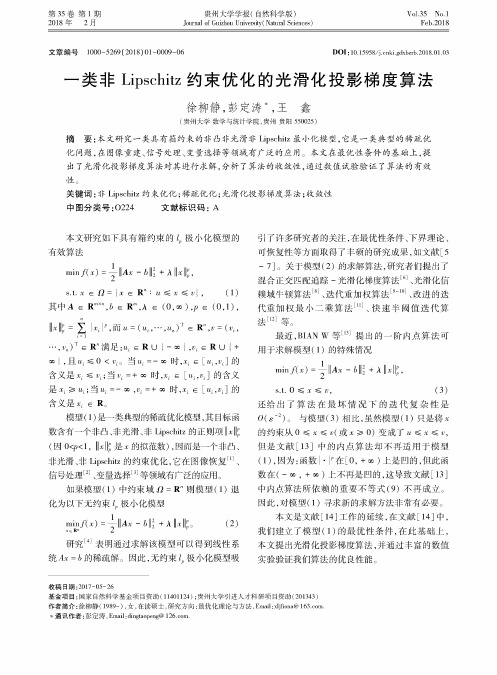

一类非Lipschitz约束优化的光滑化投影梯度算法

第35卷第1期2018年 2月贵州大学学报(自然科学版)J o u r n a l o f G u iz h o u U n iv e r s ity!N a t u r a l S c ie n c e s)Vol.35 No.1Feb.2018文章编号 1000-5269 ( 2018 # 01 -0009-06D O I : 10.15958/ki.gdxbzrl〇.2018.01.03一类非Lipschitz约束优化的光滑化投影梯度算法徐柳静,彭定涛'王鑫(贵州大学数学与统计学院,贵州贵阳550025)摘要:本文研究一类具有箱约束的非凸非光滑非Lipschitz最小化模型,它是一类典型的稀疏优 化问题,在图像重建、信号处理、变量选择等领域有广泛的应用。

本文在最优性条件的基础上,提 出了光滑化投影梯度算法对其进行求解,分析了算法的收敛性,通过数值试验验证了算法的有效 性。

关键词:非Lipschitz约束优化;稀疏优化;光滑化投影梯度算法;收敛性中图分类号:〇224 文献标识码:A本文研究如下具有箱约束的Q极小化模型的 有效算法min/(7) = y l l"7-52 + 入1171<,S.t.X " +# )X "R! • / & 7 &R(# (1)其中"""(0,i),< " (0,1),117< = %k l<,而/ = (/,…,/…)T " R",r = (r,i=1…,r!)t " R!满足" R U ) - i +,R" R U ) + i +,且/ &0 < R&当/ =- i 时,X i " [/,R]的含义是X i &R;当R= + i时,X i " [/,R]的含义 是 X ' /;当/ = - i,R= + i 时,X " [/,R]的含义是X%" R&模型(1)是一类典型的稀疏优化模型,其目标函 数含有一个非凸、非光滑、非Lipschitz的正则项|| (因0 j<1,||7< Z x的拟范数),因而是一个非凸、非光滑、非Z p s h i的约束优化,它在图像恢复[1]、信号处理[2]、变量选择[3]等领域有广泛的应用。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

计算机应用研究 ApplicationResearchofComputers

Vol.36No.9 Sep.2019

ห้องสมุดไป่ตู้

一类非光滑非凸优化问题的神经网络方法

喻 昕,陈昭蓉

(广西大学 计算机与电子信息学院,南宁 530004)

摘 要:提出了解决一类带等式与不等式约束的非光滑非凸优化问题的神经网络模型。证明了当目标函数有 下界时,神经网络的解轨迹在有限时间收敛到可行域。同时,神经网络的平衡点集与优化问题的关键点集一致, 且神经网络最终收敛于优化问题的关键点集。与传统基于罚函数的神经网络模型不同,提出的模型无须计算罚 因子。最后,通过仿真实验验证了所提出模型的有效性。 关键词:神经网络;非凸非光滑优化;有限时间收敛 中图分类号:TP183 文献标志码:A 文章编号:10013695(2019)09003257504 doi:10.19734/j.issn.10013695.2018.03.0150

0 引言

1986年,Tank等人[1]介绍了模拟神经网络方法解决限制 性最优化问题,并在文献[2]中得到更进一步的阐述。其核心 思想是利用动力学神经网络同时模拟目标函数与约束函数,并 利用神经网络的模拟与并行处理能力计算问题的最优解。文 献[1]提出了 递 归 神 经 网 络 解 决 线 性 规 划 问 题,在 此 基 础 上, Kennedy等人[2]对文献[1]中的神经网络进行改进,通过构建 一个有限的惩罚参数的神经网络来解决非线性规划问 题。 Zhang等人[3]在早期惩罚参数研究的基础上,提出了一种基于 Lagrange乘子法 的 递 归 神 经 网 络 以 解 决 非 线 性 凸 优 化 问 题。 Lagrange神经网络模型中有两种神经元,即变量神经元和 La grange神经元。其中,变量神经元负责寻找目标函数的最小点 以及提供解决问题的平衡点;而拉格朗日神经元负责将动态轨 迹快速地引入可行域。有关 Lagrange神经网络的详细研究请 参考文献[4~6]。在 最 优 化 问 题 的 研 究 发 展 中,早 期 的 神 经 网络模型均为光滑非线性规划问题而设计,为了解决非光滑非 线性规划问题,Forti等人[7]提出了一种 GNPC神经网络模型, GNPC是基于 NPC的一个微分包含形式的梯度系统,其目标 函数和约束函数不需要是光滑的而仅仅是正则函数即可。为 了使非光滑规划更具普遍性,文献[8,9]提出了一些基于惩罚 函数和次梯度的递归神经网络解决非光滑凸与非光滑非凸规 划问题。神经网络的收敛行为,包括全局收敛和局部收敛。如 果规划问题的目标函数的定义域中任意的初始点的解轨迹收 敛于最优解(或近似最优解),则该神经网络模型是全局收敛

Neuralnetworkoptimizationmethodforclassof nonconvexnonsmoothoptimizationproblems

YuXin,ChenZhaorong

(SchoolofComputer& ElectronicInformation,GuangxiUniversity,Nanning530004,China)

Abstract:Thispaperproposedanovelneuralnetworktosolvenonsmoothnonconvexoptimizationproblemswithequalityand inequalityconstraints.Itprovedthatwhentheobjectivefunctionhadalowerbound,theneuralnetworkconvergedtoafeasible domaininafinitetime.Meanwhile,thesolutiontrajectoryofneuralnetworkconvergedtooptimalsolutionsetofthecorre spondingoptimizationproblems,whichfinallyconvergedtocriticalpointsetofoptimizationproblems.Comparingwithtradi tionalneuralnetworkwhichbasedonpenaltyfunction,theneuralnetworkmodeldidnotneedtocalculateanypenaltyparame ters.Finally,theeffectivenessoftheproposedmodelisverifiedbysimulationexperiments. Keywords:neuralnetwork;nonconvexnonsmoothoptimization;limitedtimeconvergence

为了降低网络模 型 的 复 杂 度,文 献 [12~16]提 出 了 一 些 一层递归神经网络。Gou等人 提 [14] 出了一种解决线性等式约 束的伪凸优化的一层递归神经网络,并证明了在等式约束条件 下,解轨迹能 在 有 限 时 间 收 敛 到 可 行 域 中。基 于 惩 罚 函 数 方 法,Liu等人[15]提出了一种新的一层递归神经网络来解决线性 等式约束 的 伪 凸 最 优 化 问 题。 为 解 决 线 性 规 划 问 题,Liu等 人[16]早期同样提出一种基于次梯度的神经网络,证明了该神 经网络定义域内是全局收敛的。国内有关神经网络解决最优 化的研究可参考文献[17~19]。传统的神经网络模型解决工 程优问题大多要求求解适当的罚函数,而这个参数在某些目标 函数下是难以计算的,这为网络执行计算带来困难。本文结合 传统的递归神经网络模型,提出新的一种解决带等式约束和不

的,如文献[10]的神经网络模型,在满足一些条件的情况下是 全局收敛。然而,如果限制条件是初始状态的解必须从可行域 中选取,则其收敛是局部的。基于惩罚参数和函数的神经网络 模型,其解集在很大程度上是非全局收敛的,因为此类神经网 络模型,其可行域上发现的一个内部点通常是一个特殊域包含 的可行域的中心,因此,为了保证收敛,初始解集必须在可行域 范围内部选取,并且惩罚参数必须保证足够大。再者,惩罚函 数神经网络模型的有效性依赖于确定的或非确定的惩罚参数, 而确定性惩罚参数在实际应用是很难估算的。为解决这个问 题,Cheng等人 [11]提 出 了 一 种 新 的 解 决 非 光 滑 凸 优 化 的 递 归 神经网络,文献 [11]所 提 出 的 神 经 网 络 在 解 决 带 约 束 的 非 光 滑凸规划问题的同时,不需要任何的 惩 罚 参 数。然 而,文 献 [11]提出的神经网络的结构却异常复杂。