hadoop云计算实验指导书

《云计算与分布式系统》实验指导书_CHS

《云计算与分布式系统》实验指导书《云计算与分布式系统》课程是计算机专业的一门选修课程。

开设云计算与分布式系统实验,目的就是为了学生能够更好的掌握云计算与分布式系统的应用,使课堂教学与实践环节紧密结合。

希望学生能够充分利用实验条件,认真完成实验,从实验中得到应有的锻炼和培养,为今后进一步学习和应用云计算与分布式技术打下坚实的基础。

《云计算与分布式系统》课程实验的目的:是为了使学生在课程学习的同时,通过实验教学验证课堂教学的理论,理解和掌握云计算与分布式系统中最基本、最广泛应用的概念、原理、理论和算法以及基本技术和方法,更好地掌握《云计算与分布式系统》课程教学大纲要求的内容。

《云计算与分布式系统》课程实验的注意事项:在《云计算与分布式系统》的课程实验过程中,要求学生做到:(1)预习实验指导书有关部分,认真做好实验内容的准备,就实验可能出现的情况提前作出思考和分析。

(2)认真书写实验报告。

实验报告包括实验目的和要求,程序设计说明,给出源程序清单。

(3)遵守机房纪律,服从辅导教师指挥,爱护实验设备。

(4)实验课程不迟到。

如有事不能出席,所缺实验一般不补。

《云计算与分布式系统》课程实验的验收:实验的验收将分为两个部分。

第一部分是上机操作,包括检查程序运行和即时提问。

第二部分是提交书面的实验报告。

实验目录实验一构建在虚拟化数据中心上的云平台体系结构一实验目的和要求1) 了解什么是IaaS、PaaS、SaaS平台。

2) 通过一些实际应用了解IaaS、PaaS、SaaS平台的运作模式。

3) 调研分析IaaS、PaaS、SaaS的定义及特征。

二预备知识云计算将基础设施、平台和软件作为服务发布,使得用户能够以即用即付的模式使用基于定阅的服务。

在云上提供的服务通常可以分为三个不同的服务模型,即IaaS、PaaS(平台即服务)和SaaS(软件即服务)。

SaaS由用户或客户使用特殊的接口,用在应用程序端;在PaaS 层,云平台必须进行计费服务,处理作业队列,启动和监视服务;底层是IaaS服务,需要配置数据库、计算实例、文件系统和存储以满足用户需求。

hadoop大数据技术实验指导书

Hadoop大数据技术实验指导书第一章实验概述1.1 实验目的本实验旨在全面了解Hadoop大数据技术的相关概念、架构和使用方法,通过实际操作掌握Hadoop大数据技术的基本应用和管理技能。

1.2 实验内容本实验内容包括Hadoop大数据技术的基本概念、HDFS分布式文件系统的搭建和管理、MapReduce分布式计算框架的使用、Hadoop 生态系统的其他相关工具等。

1.3 实验环境本实验采用Ubuntu 18.04操作系统,Hadoop版本为3.1.3,Java 版本为1.8。

1.4 实验预备知识对Linux操作系统的基本操作有一定了解,对Java编程语言有一定的基础认识,了解分布式系统和大数据概念。

第二章 Hadoop基础概念2.1 Hadoop概述Hadoop是一个开源的分布式计算框架,用于存储和处理大规模数据。

Hadoop项目由Apache软件基金会开发,主要包括Hadoop分布式文件系统(HDFS)和MapReduce分布式计算框架。

2.2 Hadoop架构Hadoop架构包括HDFS、MapReduce和YARN(资源调度和管理),HDFS负责数据的存储和管理,MapReduce负责数据的计算和处理,YARN负责集裙资源的调度和管理。

2.3 Hadoop生态系统除了HDFS和MapReduce,Hadoop生态系统还包括其他相关工具,如HBase(分布式数据库)、Hive(数据仓库)、Pig(数据分析)、Spark(内存计算框架)等。

第三章 HDFS分布式文件系统实验3.1 HDFS搭建1) 准备Hadoop安装包,解压到指定目录2) 配置hadoop-env.sh文件,设置JAVA_HOME环境变量3) 配置core-site.xml和hdfs-site.xml文件,设置Hadoop集裙的基本信息和存储路径3.2 HDFS管理1) 使用命令行工具上传、下载、删除文件2) 查看HDFS存储空间情况3) 监控HDFS集裙状态第四章 MapReduce分布式计算实验4.1 MapReduce程序编写1) 编写Map阶段的程序2) 编写Reduce阶段的程序3) 编译打包MapReduce程序4.2 MapReduce作业提交与监控1) 将MapReduce程序提交到Hadoop集裙2) 查看作业运行状态和日志3) 监控作业的运行情况第五章 Hadoop生态系统实验5.1 HBase实验1) 安装HBase并配置2) 创建HBase表并进行CRUD操作3) 监控HBase集裙状态5.2 Hive实验1) 安装Hive并配置2) 创建Hive表并进行数据查询3) 执行HiveQL语句进行数据分析5.3 Spark实验1) 安装Spark并配置2) 编写Spark应用程序3) 提交Spark应用程序到集裙运行结语通过本实验指导书的学习,相信读者对Hadoop大数据技术有了更深入的了解,掌握了HDFS的搭建与管理、MapReduce的编程与作业监控、Hadoop生态系统的应用等相关技能。

云计算技术与应用:Hadoop实验

Hadoop实践与应用主讲人:金永霞主要内容HDFS基本概念✓主从架构模型系统,一个HDFS集群由一个Master节点和多个Slave节点构成Master节点:称为NameNode,用以管理整个文件系统命名空间和客户端对文件的访问Slave节点:称为DataNode,用于真正存储数据块(Block)✓是文件存储的逻辑单元,默认块大小是64MB✓每个块建立多个副本(备份),这些副本都尽量分布在不同的DataNode节点上启动Hadoop✓在master节点上执行start-all.sh命令启动Hadoop✓分别在各个节点上执行jps命令查看进程✓在master节点上执行jps命令,可以看到有NameNode、JobTracker和SecondaryNameNode三个进程启动✓在slave节点上执行jps命令,可以看到有DataNode和TaskTracker两个进程启动关闭Hadoop✓在master节点上执行stop-all.sh命令关闭Hadoop✓hadoop fs [命令选项]✓hadoop fs [命令选项]✓hadoop fs [命令选项]✓在HDFS文件系统中建立一个目录,将本地文件系统的一个文件上传至该目录。

✓操作步骤(1) hadoop fs -mkdir test //在HDFS创建目录test(2) hadoop fs -ls // 显示HDFS目录结构(3) echo “hello hadoop”>file.txt //在本地创建一个文件(4) hadoop fs -put file.txt <HDFS目的路径> //把本地文件上传到HDFS(5) hadoop fs -ls <HDFS目的路径> //显示HDFS目录结构(6) hadoop fs -cat file.txt //查看HDFS文件内容✓在Eclipse中创建一个Java工程✓打开该工程的属性设置窗口,在左侧选择“Java构建路径”,右侧选择“库”标签栏,单击“添加外部JAR(X)”✓选择需要导入的所有jar包:包括hadoop-1.1.2文件夹下的所有jar包,以及hadoop-1.1.2/lib目录下的所有jar包✓通过.URL对象打开一个数据流✓调用IOUtils类的静态方法copyBytes()将HDFS数据流复制到标准输出流System.out中✓copyBytes(InputStream in,OutputStream out,intbuffSize,boolean close)✓参数in表示输入流,out表示输出流,buffsize表示缓冲区大小,close是布尔变量,表示复制完毕后是否关闭流✓使用URL方式只能读取数据,不能写入数据package hdfs;import .URL;import java.io.InputStream;import org.apache.hadoop.fs.FsUrlStreamHandlerFactory;import org.apache.hadoop.io.IOUtils;public class App1 {public static final String HDFS_PATH="hdfs://192.168.80.100:9000/Download";public static void main(String[] args)throws Exception{URL.setURLStreamHandlerFactory(new FsUrlStreamHandlerFactory());final URL url=new URL(HDFS_PATH);final InputStream in=url.openStream();IOUtils.copyBytes(in, System.out, 1024, true);}}✓FileSystem类封装了几乎所有的文件操作,例如创建目录,显示目录列表,读写HDFS文件,对HDFS文件的上传、下载以及删除等使用FileSystem API操作文件的程序框架operator(){设置Configuration对象;获取FileSystem对象;进行文件操作;}public boolean mkdirs(Path f) throws显示目录文件列表public FileStatus[] listStatus (Path f) throws IOExcertion 创建HDFS文件public FSDataOutputStream create(Path f) throws IOExcertion 上传本地文件到HDFS文件系统public void copyFromLocalFile(Path src, Path dst) throws IOException 把HDFS文件复制到本地文件系统public void copyToLocalFile(Path src, Path dst) throws IOException 删除一个文件或目录public boolean delete(Path f, boolean recursive) throws IOExceptionimport .URI;import org.apache.hadoop.conf.Configuration;import org.apache.hadoop.fs.FileSystem;import org.apache.hadoop.fs.Path;public class App2 {public static final String HDFS_PATH="hdfs://192.168.80.100:9000";public static final String DIR_PATH="/dirtest";public static void main(String[] args)throws Exception{final FileSystem fs=FileSystem.get(new URI(HDFS_PATH) , new Configuration());/*调用mkdirs()方法创建目录 */fs.mkdirs(new Path(DIR_PATH));}}MapReduce计算模型✓一种并行计算模型,计算过程分为两个阶段Map:对输入的原始数据列表的每个元素进行指定的转换,一个输入的键值对<key,value>映射成同样为<key,value>形式的中间结果,并把具有相同key值的value归纳起来形成一个value列表(这个过程称为Shuffle)并传递给reduce函数 Reduce:将Map输出的数据列表按照某种方式进行合并处理,获得输出形式为<key,value>的最终处理结果MapReduce程序结构-Mapper✓典型MapReduce程序包括三个部分:Mapper、Reducer、作业执行✓Mapper:负责数据处理,将输入的一个<key,value>对映射到0个或多个中间格式的<key,value>形式✓map()方法的默认实现protected void map(KEYIN key, VALUEIN value,Context context) throws IOExcepti on, InterruptedExceptio{context.write((KEYOUT) key, (VALUEOUT) value);}MapReduce程序结构-Reducer✓Reducer:接受来自各个Mapper的输出,根据<key,value>对中的key对输入数据排序,把具有相同key的值进行归并,通过迭代处理与指定key相关联的值,生成列表<key, value>✓reduce()函数的默认实现protected void reduce(KEYIN key, Iterable<VALUEIN> values, Context co ntext ) throws IOException, InterruptedException{for(VALUEIN value: values){context.write((KEYOUT) key, (VALUEOUT) value);}}MapReduce程序结构-作业执行✓作业执行:写驱动代码让程序运行起来Configuration conf = new Configuration(); //读取Hadoop配置Job job = new Job(conf, "作业名称"); //创建一个job对象job.setJarByClass(类的名称); //如果要把程序打成jar包运行,需要这条语句job.setMapperClass(Mapper类型); //设置自定义的Mapper类job.setCombinerClass(Combiner类型); //设置Combiner类job.setReducerClass(Reducer类型); //设置自定义的Reducer类job.setOutputKeyClass(输出Key的类型); //设置输出的key类型job.setOutputValueClass(输出value的类型); //设置输出的value类型FileInputFormat.addInputPath(job,输入HDFS路径); //设置job作业执行时输入文件的路径FileOutputFormat.setOutputPath(job,输出HDFS路径); //设置job作业执行时输出文件的路径System.exit(job.waitForCompletion(true) ? 0 : 1); //设置直到作业运行结束,程序退出MapReduce应用程序实现✓分析问题,设计算法✓代码实现✓导出MapReduce程序的jar文件✓在HDFS文件系统准备程序运行所需的目录和输入文件✓使用“hadoop jar”命令运行程序✓程序运行后生成输出目录output,使用“hadoop fs -cat”命令查看运行结果MapReduce应用程序实例-单词计数✓问题描述:单词计数的目标任务是统计给定文件中所有单词的出现次数。

云计算-Hadoop单机及集群配置

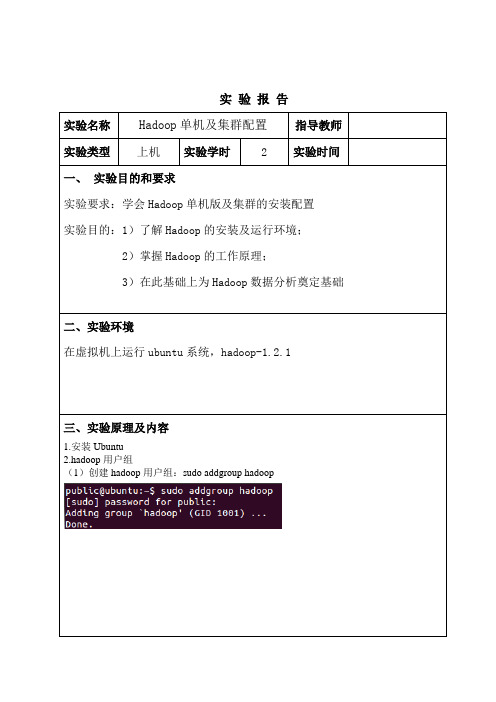

实验报告实验名称Hadoop单机及集群配置指导教师实验类型上机实验学时 2 实验时间一、实验目的和要求实验要求:学会Hadoop单机版及集群的安装配置实验目的:1)了解Hadoop的安装及运行环境;2)掌握Hadoop的工作原理;3)在此基础上为Hadoop数据分析奠定基础二、实验环境在虚拟机上运行ubuntu系统,hadoop-1.2.1三、实验原理及内容1.安装Ubuntu2.hadoop用户组(1)创建hadoop用户组:sudo addgroup hadoop(2)创建hadoop用户:sudo adduser -ingroup hadoop hadoop(3)(3)为hadoop用户添加权限:sudo gedit /etc/sudoers,在打开的文件中添加一句hadoop ALL=(ALL:ALL)ALL,其中hadoop和ALL之间的空格使用TAB键。

(4)使用hadoop用户登录系统重新打开Ubuntu,发现登陆界面多了一个hadoop用户,用hadoop用户登录系统。

3、SSH配置(1)Ubuntu14.04已默认安装ssh的客户端,只需要安装服务器端即可,但在实际操作时,发现由于是刚安装的Ubuntu系统,该系统没有更新,还没有安装ssh,因此先使用系统更新命令sudo apt-get update更新系统。

(2)安装ssh:sudo apt-get install openssh-server。

(3)启动ssh:sudo /etc/init.d/ssh start查看服务是否正确启动:ps -e | grep ssh(4)设置免密码登录,生成私钥和公钥:ssh-keygen -t rsa -P ""(5)将公钥追加到authorized_keys(authorized_keys用于保存所有允许以当前用户身份登录到ssh客户端用户的公钥内容)中:cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys(6)现在即可免密码登录:ssh localhost退出:exit4、JAVA环境配置(1)创建jvm文件夹:sudo mkdir /usr/lib/jvm(2)将下好的jdk文件解压,,并将解压后的文件夹重命名为java-7-sun,:sudo tar xzvf jdk-7u45-linux-i586.tar.gz-C /usr/lib/jvm/(由于安装的Ubuntu系统为64位的,学长提供的jdk7u79为32位的,安装之后无法使用,所以重新下载了一个jdk,由于7u79版本官网下载速度太慢,因此下载了一个7u45版本的jdk)重命名:sudo mv jdk1.7.0_45/ java-7-sun/(3)配置环境变量:sudo gedit ~/.bashrc在最后添加如下四行:export JAVA_HOME=/usr/lib/jvm/java-7-sunexport JRE_HOME=${JAVA_HOME}/jreexport CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/libexport PATH=${JAVA_HOME}/bin:$PATH(4)启用配置:source ~/.bashrc(5)配置默认JDK:sudo update-alternatives --install /usr/lib/jvm/javajava/usr/lib/jvm/java-7-Sun/bin/java 300sudo update-alternatives --install /usr/lib/jvm/javac javac/usr/lib/jvm/java-7-sun/bin/javac 300(6)测试是否已完成:java -version(sudo update-alternatives --config java可查看当前各种JDK的版本和配置)5、安装hadoop(1)将hadoop1.2.1解压至/usr/local下,并将其重命名为hadoop:sudo tar xzvf hadoop-1.2.1.tar.gz -C/usr/local重命名:sudo mv hadoop-1.2.1/ hadoop/(2)授权(读写权限):sudo chmod 777 hadoop/(3)编辑hadoop-env.sh文件:sudo gedit /usr/local/hadoop/conf/hadoop-env.sh,增加如下三行:export JAVA_HOME=/usr/lib/jvm/java-7-sunexport HADOOP_HOME=/usr/local/hadoopexport PATH=$PATH:/usr/local/hadoop/bin如下图所示:(4)执行命令:source hadoop-env.sh(5)输入hadoop,出现如下图所示,说明hadoop命令已经可以使用:6、测试wordcount(1)创建input文件夹:sudo mkdir /usr/local/hadoop/input(2)将hadoop文件夹下的README.txt文件拷贝至input中:sudo cp README.txt input (3)执行:hadoop jar hadoop-examples-1.2.1.jar wordcount input output4.查看结果:cat output/*说明单机版的hadoop已经配置成功。

云计算大数据技术及应用实验指导书

云计算大数据技术及应用实验指导书《云计算,大数据技术及应用》实验指导书《云计算,大数据技术及应用》课程的实验环节意在通过实践使学生对课程内容有更加感性的认识,加深和提高对云计算的理解。

培养学生的实际动手能力,独立解决实际问题的能力,实现“做中学,学中做”的目的。

为帮助学生更好地完成实验考核和实验报告,特作如下说明和要求:(1)做好每个实验的准备工作:需要对每个要做的实验进行预习,了解相关内容、知识点和具体要求,并且复习与课程有关内容和阅读实验指导书,明确实验目的要求、实验内容和实验步骤;(2)认真完成实验的各个环节:每个学生都必须在规定时间到机房做实验,并且遵守实验室的纪律,认真做实验。

在实验中,根据所给的实验内容进行认真的分析和实施,结合课堂知识完成实验,按实验步骤认真完成每步的工作。

实验完成后要做认真的整理和总结,记录重要的结果数据;(3)完成实验报告:做完每个实验后要严格按照实验报告的格式要求,写出实验报告。

实验报告的内容有以下几个部分:实验名称、实验目的、实验内容和要求、以及实验结果。

able "as guiding ideology, conscientiously implement the party's sixteen and the fifth Plenary Session of the 16th CPC Central Committee, the eight plenary session of the two committee, the Communist Youth League XX League in the fourth Plenary Session of the 15th CPC Central Committee, two session of the five plenary meeting spirit, fully implement the实验一:Windows Azure云平台搭建和部署云平台服务一:实验目的1. 通过微软公司提供的验证码激活账号,登录微软公司的Windows Azure云计算平台;2. 把Windows Azure开发环境安装好,为以后的实验作准备;3. 在Windows Azure下开发项目并且发布;二:实验设备1. 安装Windows 7 Professional Edition or higher的计算机,推荐用个人的电脑; 2. 稳定高速的High Speed Internet;三:预习要求:1. 认真预习本实验的要求与实验任务,做好准备。

云计算Hadoop运行环境的配置实验报告

以上操作的目的,是确保每台机器除了都能够使用ip地址访问到对方外,还可以通过主

注意:另外2台也要运行此命令。

)查看证书

hadooptest身份,进入hadooptest家目录的 .ssh文件夹。

(3)新建“认证文件”,在3台机器中运行如下命令,给每台机器新建“认证文件”注意:另外2台也要运行此命令。

其次,虚拟机之间交换证书,有三种拷贝并设置证书方法:

hadoops1机器里的authorized_keys也有三份证书,内容如下:hadoops2机器里的authorized_keys也有三份证书,内容如下:

) Java环境变量配置

继续以root操作,命令行中执行命令”vi m /etc/profile”,在最下面加入以下内容,

.实验体会

通过这次的实验熟悉并了Hadoop运行环境,并学会了如何使用它。

这次实验成功完成了Hadoop 集群,3个节点之间相互ping通,并可以免密码相互登陆,完成了运行环境java安装和配置。

云计算虚拟化hadoop实验报告

云计算虚拟化hadoop实验报告云计算虚拟化Hadoop实验报告1·引言在当前云计算时代,大数据处理成为一项重要的任务,而Hadoop作为开源的大数据处理框架,具有高效、可扩展的特点,被广泛应用于各个领域。

本实验旨在通过云计算虚拟化平台搭建Hadoop实验环境,并对其进行性能测试与分析。

2·实验准备2·1 硬件环境详细描述实验所使用的硬件环境,包括计算机配置、服务器配置等。

2·2 软件环境详细描述实验所使用的软件环境,包括操作系统、虚拟化软件、Hadoop版本等。

3·实验步骤3·1 虚拟化平台搭建详细描述如何搭建云计算虚拟化平台,包括安装虚拟化软件、配置虚拟机网络等。

3·2 Hadoop集群创建详细描述如何创建Hadoop集群,包括配置HDFS、配置MapReduce等。

3·3 实验数据准备详细描述实验所使用的数据集,包括数据集来源、数据集规模等。

3·4 实验任务设计详细描述实验所设计的任务,包括任务类型、任务规模等。

3·5 实验性能测试详细描述实验的性能测试步骤,包括测试工具的选择、测试指标的定义等。

4·实验结果分析4·1 性能测试结果将实验性能测试得到的数据进行展示和分析,包括各项指标的数值、对比分析等。

4·2 结果讨论结合实验结果对Hadoop集群的性能进行讨论,包括性能瓶颈分析、优化建议等。

5·结论在本实验中,通过搭建云计算虚拟化平台并进行Hadoop性能测试,我们得出了如下结论:(根据实验结果进行总结,描述实验的结论和启示)6·附件本文档所涉及的附件包括:(列出附件的名称和描述)7·法律名词及注释7·1 云计算:一种基于互联网的计算方式,通过将大量的计算资源集中在数据中心,并按需求共享给用户,实现高效的计算和存储。

7·2 虚拟化:通过软件仿真技术,将一台物理计算机划分成多个虚拟计算机,使得多个操作系统和应用程序可以在同一台物理计算机上同时运行。

Hadoop云计算综合实训报告

Hadoop安装部署实训报告项目:《hadoop安装部署实训》班级: XXXX 姓名:XXX指导教师: XXX 时间: XXXX年 X 月 X日一. 实训目的实现Hadoop的安装和配置二. 实训中所用设备及材料PC机Vmware15虚拟机Centos6.8镜像jdk-8u111-linux-x64.tarhadoop-2.6.5.targlibc-2.17.tar三. 实训内容(操作方案、实施方法)1、修改主机名Vi /etc/sysconfig/network2、修改ip地址Vi /etc/sysconfig/network-scripts/ifcfg-eth0Service network restart3、关闭防火墙service iptables stop chkconfig iptables off4、添加主机记录Vi /etc/hosts172.16.101.85 Lhw5、关闭selinuxVi /etc/selinux/config 6、上传jdk文件7、解压jdk文件8、查看9、修改环境变量Vi /etc/profile10、重新加载验证jdk11、上传hadoop安装包新建文件夹Mkdir /bigdata解压Hadoop安装包Tar -zxvf hadoop-2.6.5.tar.gz -C/bigdata/配置Hadoop,修改其中5的配置文件进入到/bigdata/hadoop-2.6.5/etc/hadoop1、Vi hadoop-env.sh更改后配置Java环境变量,环境变量路径为jdk安装路径2、在这当中插入文档Vi core-site.xml中间插入:<configuration><property><name>fs.defaultFS</name><value>hdfs://lihongwei:9000</value></property><property><name>hadoop.tmp.dir</name><value>/bigdata/tmp</value></property></configuration>3、修改第三个配置文件Vi hdfs-site.xml中间插入:<configuration><property><name>dfs.replication</name><value>1</value></property></configuration>:4、修改第四个配置文件复制一份模板mapred-site.xml.template(模板文件)Cp -a mapred-site.xml.template ./mapred-site.xmlVi mapred-site.xml<configuration><property><name></name><value>yarn</value></property></configuration>5、修改第五个配置文件Vi yarn-site.xml<configuration><property><name>yarn.resourcemanager.hostname</name><value>lihongwei</value></property><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property></configuration>对HDFS进行初始化(格式化HDFS)Cd /bigdata/hadoop-2.6.5/bin//hdfs namenode -format安装出现下面提示则安装成功20/02/03 01:30:34 INFO common.Storage: Storage directory /bigdata/tmp/dfs/name has been successfully formatted.使用命令验证是否安装成功运行jps命令,显示进程号安装GCCYum install gcc* -yyum install openssh-clients上传安装包解压到当前root目录tar -zxvf glibc-2.17.tar.gzcd glibc-2.17新建文件夹并进入文件夹mkdir build; cd build进行编译../configure --prefix=/usr --disable-profile --enable-add-ons --with-headers=/usr/include --with-binutils=/usr/binmake install验证:strings /lib64/libc.so.6 | grep GLIBC出现下图表示成功启动hadoop相关服务cd /bigdata/hadoop-2.6.5/sbin./start-all.sh./start-dfs.sh通过管理网面确认服务hdfs服务启动是否成功:http://172.16.101.94:50070/注:IP地址为虚拟机地址,服务端口号为:50070启动yarn服务:./start-yarn.sh通过管理网面确认服务yarn服务启动是否成功:http://172.16.101.94:8088/注:IP地址为虚拟机地址,服务端口号为:8088四.实训中的现象及结果分析(理论的应用、方法的选择及发生的问题)使用jps命令但有些进程不存在解决方案引用https:///nszkadrgg/article/details/79809669中安装ssh客户端yum install openssh-clients。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

计算机科学与技术学院网络计算设计与实现实验指导书实验一SOCKET编程【试验环境】计算机、TCP/IP协议、VS2005【实验目的】1.理解基本TCP/IP协议编程原理;2.掌握如何利用SOCKET编写网络程序;3.掌握VS2005编程环境,多线程程序设计等。

【实验要求】1.编写一个服务端的程序,接收来自客户端的访问请求,并返回相关信息;2.编写一个客户端程序,向服务端发送连接请求,并显示返回的结果;3.完善服务端程序,使它能够同时支持多个客户端的请求。

【预备知识】p ublic Socket Accept ():为新建连接创建新的Socket。

public void Bind (EndPoint localEP):使Socket 与一个本地终结点相关联。

public void Close ():关闭Socket 连接并释放所有关联的资源。

public void Connect (EndPoint remoteEP):建立与远程主机的连接。

注意这个方法有重载方法。

public void Disconnect (bool reuseSocket):关闭套接字连接并是否允许重用套接字。

public void Listen (int backlog):将Socket 置于侦听状态。

public int Receive (byte[] buffer):接收来自绑定的Socket 的数据。

注意这个方法有重载方法。

public int ReceiveFrom (byte[] buffer,ref EndPoint remoteEP):接收数据报并存储源终结点。

注意这个方法有重载方法。

public int Send (byte[] buffer):将数据发送到连接的Socket。

注意这个方法有重载方法。

public void SendFile (string fileName):将文件和可选数据异步发送到连接的Socket。

注意这个方法有重载方法。

public int SendTo (byte[] buffer,EndPoint remoteEP):将数据发送到特定终结点。

注意这个方法有重载方法。

public void Shutdown (SocketShutdown how):禁用某Socket 上的发送和接收。

因为在网络传输时传输的数据都是二进制形式的(表现为字节数组),所以如果要传输类似于中文这样的双字节字符就需要在传输之前用合适的编码转换成字节数组,然后接收方按照发送方的编码将接收到字节数组转换成字符串。

另外,注意接收数据的时候是先声明了一个字节数组,然后将接收到的数据保存到字节数组中,这个方法有个返回值表示实际接收了多少字节数据。

【实验内容】实现一个服务器端的面向连接的Socket用于接收客户端的请求的话,有如下步骤:1.首先根据IP地址和端口号实例化一个Socket,注意端口要要大于1024并且不要使用特殊端口号,要大于1024的原因是1024以下的端口号已经被指派了,而1433、3306这样的端口号已经被用作SQL Server和MySQL的默认端口号了,若指定为这些端口号容易发生冲突。

2.接着调用Bind()方法进行绑定,然后再调用Listen()方法用于监听,Listen()方法的参数用于指定监听的队列大小,也就是最多可容纳的等待接受的传入连接数。

3.再调用Accept()方法,调用这个方法之后会是程序处于阻塞状态,直至有客户端连接为止。

当有客户端连接,这个方法将会返回一个新的Socket,使用这个Socket与客户端进行通讯。

4.使用Accept()方法返回的新Socket的Send()方法就可以向客户端发送数据了,还可以使用这个新Socket的Receive()接收客户端的数据。

5.最后终止与客户端会话时,注意使用ShutDown()方法关闭Socket连接,并且使用Close()方法释放所占用的资源。

ServerSocket类代码SocketThread类代码使用Socket类编写客户端的Socket程序步骤如下:1.首先指定远程主机和端口号实例化Socket类,注意连接的端口号一定要与服务器监听的端口号一致。

2.接着调用Connect()方法连接远程主机。

3.连接到远程主机之后就可以调用Send()方法向服务器发送请求了,然后可以调用Receive()方法接收服务器响应数据,注意如果是发送的类似于中文这样的双字节字符串的话,还需要按照服务器响应的字符串编码将字节数组转换成字符串。

Clinet类代码实验二HTML与XML应用【试验环境】配置有windows记事本的计算机设备【实验目的】1.通过本实验,使学生能够了解并掌握XML Schema的定义方法及其用途2.了解并掌握Schema的基本结构3.了解并掌握Schema的数据类型4.了解并掌握Schema的元素声明5.了解并掌握Schema的属性声明【实验要求】1.能参照示例XML文件进行对应的XML Schema定义2.能利用Schema对XML文件进行验证【实验内容】(1)对以下“个人信息.xml”进行Schema定义(设Schema文件名为“个人信息.xsd”)(2)书写XML Schema定义头部<?xml version="1.0" encoding="UTF-8"?><!--W3C Schema generated by XMLSpy v2007 ()--><xs:schema xmlns:xs="/2001/XMLSchema"> <xs:annotation><xs:documentation>JinYanZhong XML File Schema Test</xs:documentation></xs:annotation>[]</xs:schema>(3)定义bookcaseType类型(添加在[]处)<xs:element name="bookcase" type="bookcaseType"/><xs:attribute name="type"><xs:simpleType><xs:restriction base="xs:string"><xs:enumeration value="科技"/><xs:enumeration value="教育"/></xs:restriction></xs:simpleType></xs:attribute>(4)定义bookcase元素(紧随bookcaseType类型定义之后)<xs:complexType name="bookcaseType"><xs:sequence><xs:element name="book" type="bookType"/></xs:sequence></xs:complexType>(5)定义bookType元素类型(里面引用定义authorType, pub-houseType)<xs:complexType name="bookType"><xs:sequence><xs:element name="b-name" type="xs:string"/><xs:element name="author" type="authorType"/><xs:element name="price" type="xs:string"/><xs:element name="publishing-house" type="pub-houseType"/> </xs:sequence></xs:complexType>(6)定义authorType及pub-houseType元素类型<xs:complexType name="authorType"><xs:sequence><xs:element name="name" type="xs:string"/><xs:element name="E-mail" type="xs:string"/></xs:sequence></xs:complexType><xs:complexType name="pub-houseType"><xs:sequence><xs:element name="p-name" type="xs:string"/><xs:element name="address" type="xs:string"/><xs:element name="zipcode" type="xs:string"/><xs:element name="E-mail" type="xs:string"/></xs:sequence></xs:complexType>(7)在XMLSpy中新创建一个基于“个人信息.xsd”的XML文件,体会该方法的方便快捷(8)在IE中打开带有Schema定义的“个人信息.xsd”,观察符合DTD定义及不符合Schema 定义的XML文件显示实验三基于JXTA的P2P程序设计【试验环境】JXTA、Eclipse【实验目的】1.理解JXTA的工作原理;2.掌握如何利用JXTA编写网络程序;3.掌握Eclipse编程环境等。