MPI并行程序设计自学教程

并行数值计算课程设计

《并行数值计算》课程设计题目并行计算平台及并行程序设计学院专业班级姓名实验日期目录建立并行计算平台 (1)1.1 问题的提出 (1)1.2 MPICH for Microsoft Windows 的安装与配置 (1)1.2.1 系统要求 (1)1.2.2 软件下载 (1)1.2.3 软件安装 (1)1.2.4 计算机进行注册和配置 (2)1.2.5 MPICH 与编译环境的整合 (3)1.2.6 并行计算平台测试 (7)并行计算实例——求二维数组所有元素和 (8)2.1 问题分析 (8)2.2 流程图 (10)2.3 源代码.................................................................................................... 错误!未指定书签。

2.4 如何使用MPI 并行化一个已存在的串行程序 (13)心得体会 (14)建立并行计算平台1.1问题的提出MPI是目前一种比较著名的应用于并行环境的消息传递标准,MPICH是MPI1.2标准的一个完全实现,也是应用范围最广的一种并行及分布式环境。

MPICH除包含MPI函数库之外,还包含了一套程序设计以及运行环境。

本报告简要介绍如何应用MPICH的windows版本,建立一个基于windows的并行程序设计及运行环境,并给出一个c+MPI程序设计实例。

1.2MPICH for Microsoft Wind ows 的安装与配置1.2.1 系统要求安装MPICH for Microsoft Windows 对系统有如下要求:Windows NT4/2000/XP 的Professional 或Server 版(不支持Windows 95/98)所有主机必须能够建立TCP/IP 连接MPICH支持的编译器有:MS VC++ 6.x,MS VC++.NET,Compaq Visual Fortran 6.x, Intel Fortran,gcc,以及g77。

CST主从式MPI并行计算

CST主从式MPI并行计算

CST主从式MPI计算是指在计算大问题时,由于剖分的网格较多,单机内存处理不够或太慢,利用CST自带的MPI技术,把网格分配到各个计算节点计算,计算完毕后把部分网格的计算结果汇总到主机进行处理,进而得到总的计算结果,这样可以解决在计算大尺寸问题网格较多时内存不够用的问题,且并行计算还可以提高计算效率。

下面介绍一下具体的技术细节:

首先安装CST自带的MPI service,以便CST能通过该软件访问各个计算节点,其安装包在CST 2009安装完毕后会在其安装目录下,文件名为mpi_,如下图

图12

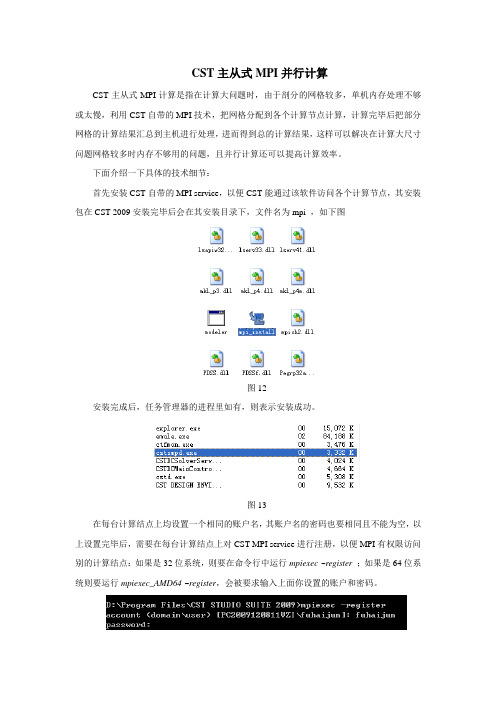

安装完成后,任务管理器的进程里如有,则表示安装成功。

图13

在每台计算结点上均设置一个相同的账户名,其账户名的密码也要相同且不能为空,以上设置完毕后,需要在每台计算结点上对CST MPI service进行注册,以便MPI有权限访问别的计算结点:如果是32位系统,则要在命令行中运行mpiexec -register;如果是64位系统则要运行mpiexec_AMD64 –register,会被要求输入上面你设置的账户和密码。

图14

上述步骤完毕后,在主机的求解器设置中在选项MPI computing前点上勾,点击MPI Properties进行MPI设置

图15

在install folder里输入CST的安装目录,在temp folder里输入CST临时文件的目录,在architecture里选择并行系统,如果32位系统选择IA32,如果64位系统选择AMD64,host name里输入各个计算结点的IP地址,在active里画上叉表示你选择几个计算结点,设置完毕后点ok

图16

以上CST MPI主从式计算就设置完毕,点击求解即可。

并行程序设计导论-第一章PPT

Copyright © 2019, Elsevier Inc. All rights Reserved

4

Now it’s up to the programmers

Adding more processors doesn’t help much if programmers aren’t aware of them…

7

Protein folding

Copyright © 2019, Elsevier Inc. All rights Reserved

8

Drug discovery

Copyright © 2019, Elsevier Inc. All rights Reserved

9

Energy research

More complex problems are still waiting to be solved.

Copyright © 2019, Elsevier Inc. All rights Reserved

6

Climate modeling

Copyright © 2019, Elsevier Inc. All rights Reserved

This is very difficult to do. Success has been limited.

Copyright © 2019, Elsevier Inc. All rights Reserve Some coding constructs can be recognized by an automatic program generator, and converted to a parallel construct.

并行程序设计导论课件

MPI(Message Passing Interface)等。

数据并行编程模型

原理 优点 缺点 常见实现

将数据划分为多个部分,在多个处理单元上并行执行相同的操作。

适用于数据密集型应用,能够充分利用多核、多线程等并行计算 资源。

编程模型较为抽象,需要一定的并行计算经验和技能。

CUDA(Compute Unified Device Architecture)、OpenCL (Open Computing Language)等。

死锁问题及其解决方法

死锁问题

死锁是指两个或两个以上的进程在执行过程中,因争夺资源而造成的一种互相等待的现象,若无外力作用,它们 都将无法向前推进。

死锁解决方法

解决死锁问题可以采用预防、避免、检测和解除四种方法。其中,预防方法通过设置某些限制条件来破坏产生死 锁的四个必要条件;避免方法通过银行家算法等动态分配资源来避免死锁的发生;检测方法通过定时运行检测算 法来判断系统是否发生死锁;解除方法则通过撤销或挂起某些进程来解除已发生的死锁。

CUDA优化技巧

为了提高CUDA程序的性能,需要掌握一些优 化技巧,如内存访问优化、线程同步优化、计 算资源利用优化等。

GPU加速计算在科研领域应用案例

气候模拟与天气预报

GPU加速计算能够显著提高气候模拟和天气预报的准确性和效率,为 气象学领域的研究和应用提供支持。

石油勘探与地震数据处理

GPU加速计算在石油勘探和地震数据处理领域具有广泛应用,能够加 快数据处理速度,提高勘探效率。

生物信息学与基因测序

GPU加速计算在生物信息学和基因测序领域的应用日益增多,能够加 快基因序列比对和分析的速度,促进生物医学研究的发展。

天体物理模拟与宇宙探索

并行程序设计导论(精品)

如服务器集群、负载均衡、分布式数据库等。

并行计算体系结构

共享内存体系结构

多个处理器共享同一物理内存,通过锁或原子操作实现内存 访问同步。

分布式内存体系结构

每个处理器拥有独立的局部内存,处理器之间通过消息传递 进行数据交换。

混合体系结构

结合共享内存和分布式内存的特点,通常在分布式内存系统 中引入共享内存的概念,以提高数据访问效率。

力。

GPU架构

GPU采用众核架构,拥有成千上 万个核心,每个核心都能独立处 理任务,实现高度并行化计算。

GPU内存模型

GPU内存分为全局内存、共享内 存、纹理内存等,不同类型的内 存具有不同的访问速度和用途。

GPU编程模型介绍

01

CUDA编程模型

02

OpenCL编程模型

CUDA(Compute Unified Device Architecture)是NVIDIA推出的并行 计算平台和编程模型,允许开发者使用 C/C语言编写GPU程序。

集群与网格计算

利用高速网络将一组计算机连接起来,共同解决大型计算问 题。集群中的计算机可以是同构或异构的,网格计算则强调 资源的广泛共享和协同工作。

02

并行程序设计基础

并行算法设计思想

分治策略

将大问题分解为多个小问题,分 别求解,最后将结果合并。

平衡负载

将任务均匀分配到各个处理单元, 避免某些处理单元过载。

并行编程模型与语 言

为了降低并行编程的难度,提高 开发效率,未来将会出现更多高 级、易用的并行编程模型和语言。 这些模型和语言将隐藏底层硬件 细节,使程序员能够更专注于问 题本身。

未来研究方向与挑战

并行程序的性能 分析与优化

并行程序设计

并行程序设计并行程序设计并行程序设计是指将一个任务或问题分解成多个子任务,然后同时执行这些子任务,以提高程序的运行效率和响应速度。

本文将介绍并行程序设计的概念、原则和常用的并行编程模型。

概念并行程序设计是一种计算思维方式,通过利用计算机多核心、多处理器或者分布式系统的能力,将一个大的问题分解成多个小的子问题,并且让这些子问题可以同时被处理。

通过同时处理多个子问题,可以大大提高程序的处理速度。

并行程序设计原则并行程序设计有一些基本原则,下面是其中几个重要的原则:1. 任务划分:将一个大的任务划分成多个小的子任务。

划分任务时需要注意任务之间的依赖关系,以保证划分后的任务可以并行执行。

2. 任务分配:将划分后的子任务分配给可用的计算资源,如多核心、多处理器或分布式系统中的节点。

任务分配需要考虑计算资源的负载均衡,以充分利用计算资源的能力。

3. 任务通信:并行程序中的任务之间通常需要进行数据交换或同步操作。

任务通信需要合理选择通信方式,并通过合适的同步机制来确保数据的一致性和正确性。

4. 任务合并:在一些情况下,多个子任务的处理结果需要进行合并。

任务合并需要保证合并操作的正确性和效率,同时还要考虑合并操作可能引入的额外开销。

并行编程模型为了简化并行程序的设计与开发,人们提出了一系列并行编程模型。

下面介绍几种常用的并行编程模型:1. 共享内存模型:多个线程共享同一块内存地质空间,线程之间通过读写共享内存来进行通信和同步。

常见的共享内存模型有OpenMP和Cilk等。

2. 消息传递模型:多个进程或线程通过消息的方式进行通信。

每个进程或线程有独立的内存空间,通过发送和接收消息来实现进程间的通信和同步。

常见的消息传递模型有MPI和PVM等。

3. 数据流模型:任务之间通过数据流进行通信。

任务根据数据的可用性来进行执行,并将处理结果传递给下游任务。

数据流模型可以以图形化的方式表示任务之间的依赖关系。

常见的数据流模型有GPGPU和FPGA等。

并行计算机程序设计导论pdf

CUDA最佳实践

总结CUDA编程的最佳实践, 包括编写高效的CUDA内核函 数、使用异步操作、避免不 必要的内存拷贝等方面的内 容。

43

07

并行计算应用案例分析

BIG DATA EMPOWERS TO CREATE A NEW

ERA

2024/1/25

44

气象模拟应用案例分析

气候模型

使用并行计算模拟大气、海洋和陆地之间的相互作用,以预测气 候变化。

42

CUDA性能优化策略

CUDA性能分析

介绍如何使用CUDA性能分析 工具(如NVIDIA Visual

Profiler和Nsight)来评估和 优化CUDA程序的性能。

CUDA优化技术

详细讲解CUDA优化的关键技 术,包括内存访问优化、线 程同步优化、指令级优化和 算法级优化等。

2024,并行计算的应用前景更加广阔。未来,量子计算等新型计算技术的发展将进一 步推动并行计算的进步,为解决复杂问题提供更加高效的方法。

2024/1/25

6

02

并行计算机体系结构

BIG DATA EMPOWERS TO CREATE A NEW

ERA

2024/1/25

7

并行计算机分类与特点

// 计算点积并汇总结果

03

for (int i = rank; i < n; i += size) {

27

MPI编程实例分析

• dot_product += a[i] * b[i];

2024/1/25

28

MPI编程实例分析

}

// 使用MPI_Reduce函数汇总各个进程的计算结果

2024/1/25

Intel 的MPI 中文版 使用指南

Intel 的MPI 中文版使用指南【正文】章节1:引言1.1 介绍1.2 目的章节2:安装MPI软件包2.1 准备工作2.2 MPI软件包2.3 安装MPI软件包章节3:MPI环境配置3.1 设置环境变量3.2 配置主机名和IP地质3.3 创建MPI主机文件章节4:MPI程序编写4.1 编写并编译MPI程序4.2 运行MPI程序章节5:MPI进程通信5.1 发送与接收消息5.2 广播5.3 分发与收集5.4 归约操作5.5 可靠通信章节6:MPI集群调试6.1 调试工具介绍6.2 使用调试工具调试MPI程序6.3 常见问题解决章节7:MPI性能优化7.1 优化通信7.2 优化计算7.3 优化负载均衡7.4 常见优化技巧【附件】附件1:MPI代码示例附件2:MPI配置文件示例【法律名词及注释】1、MPI:Message Passing Interface,一种并行计算互连协议,用于编写并行计算程序。

2、广播:一台节点向其他节点发送相同的消息。

3、分发与收集:一台节点将消息发送给其他节点,其他节点将消息收集到一台节点上。

4、归约操作:将多个节点的数据进行聚合操作,如求和、求最大值等。

5、可靠通信:保证消息的完整性和可靠性,确保消息能够正确传递。

【结束语】本文档涉及附件:附件1:MPI代码示例附件2:MPI配置文件示例本文所涉及的法律名词及注释:1、MPI:Message Passing Interface,一种并行计算互连协议,用于编写并行计算程序。

2、广播:一台节点向其他节点发送相同的消息。

3、分发与收集:一台节点将消息发送给其他节点,其他节点将消息收集到一台节点上。

4、归约操作:将多个节点的数据进行聚合操作,如求和、求最大值等。

5、可靠通信:保证消息的完整性和可靠性,确保消息能够正确传递。

mpi基本用法 -回复

mpi基本用法-回复「MPI基本用法」是一种用于并行计算的编程模型和库。

MPI是Message Passing Interface的缩写,它提供了一系列的函数和语义,用于在多个进程之间进行通信和同步。

MPI的主要目标是提高并行计算的速度和效率,并使得并行计算程序易于开发和维护。

本文将逐步回答关于MPI基本用法的问题,并介绍如何使用MPI进行并行计算。

1. 什么是MPI?MPI是一种用于并行计算的编程模型和库。

它由一组函数和语义组成,用于在多个进程之间进行通信和同步。

MPI旨在提高并行计算的速度和效率,并使得并行计算程序易于开发和维护。

2. MPI的基本概念是什么?MPI的基本概念是进程和通信。

每个并行计算程序都由多个进程组成,这些进程在不同的处理器上独立运行。

MPI提供了一种机制,使得这些进程能够在执行过程中进行通信和同步,以实现并行计算的目标。

3. MPI的基本通信模式有哪些?MPI提供了多种基本通信模式,包括点对点通信和集体通信。

点对点通信是指两个进程之间的直接通信,例如发送和接收消息。

集体通信是指多个进程之间的协作通信,例如广播和归约操作。

4. 如何在MPI程序中发送和接收消息?MPI提供了一对发送和接收函数,用于在进程之间发送和接收消息。

发送函数将数据从一个进程发送给另一个进程,而接收函数用于接收来自其他进程的数据。

要发送消息,可以使用MPI_Send函数,而要接收消息,可以使用MPI_Recv函数。

5. MPI如何进行同步操作?MPI提供了多种同步操作,包括阻塞和非阻塞操作。

阻塞操作意味着进程将被阻塞,直到某个操作完成。

非阻塞操作允许进程在操作进行的同时执行其他操作。

要进行阻塞同步,可以使用MPI_Barrier函数;而要进行非阻塞同步,可以使用MPI_Ibarrier函数。

6. 如何在MPI程序中使用集体通信?MPI提供了一系列的集体通信函数,用于实现多个进程之间的协作通信。

其中,广播操作将一个进程的数据发送给所有其他进程,而归约操作将多个进程的数据合并为一个结果。

并行程序设计

将不同的任务或函数组织成流水线,使得 任务的执行可以相互重叠,提高整体吞吐 量。

04

常见并行程序设计模型

OpenMP模型

1 2 3

共享内存并行编程

OpenMP是一种支持多平台共享内存并行编程的 API,适用于对称多处理器(SMP)和分布式共 享内存(DSM)系统。

编译器指令和库函数

OpenMP通过编译器指令和库函数来实现并行化 ,程序员可以使用这些指令和函数来标识并行代 码块和同步点。

优化同步机制

选择合适的同步机制,如锁、信号量等, 以减少同步开销并提高并行程序的执行效 率。

减少通信开销

采用高效的通信算法和数据结构,减少通 信次数和数据量,降低通信延迟对性能的 影响。

调试和测试工具介绍

01

调试工具

02

GDB:GNU调试器,支持多线程和并行程序的调试,提 供断点、单步执行、变量查看等功能。

THANKS

感谢观看

可移植性和可扩展性

MPI具有良好的可移植性和可扩展性,可以运行在各种不同的硬件和 操作系统平台上。

CUDA模型

01

GPU加速计算

CUDA(Compute Unified Device Architecture)是NVIDIA推出的一种 GPU加速计算平台,利用GPU的强大 计算能力来加速应用程序。

其他领域

生物信息学、金融工程、网络安全等 。

并行计算挑战与机遇

挑战

并行计算的复杂性、通信开销、负载均衡等问题。

机遇

随着硬件技术的不断发展,并行计算的规模和性能不断提升,为解决大规模计 算问题提供了更多可能性。同时,新兴应用领域如人工智能、大数据等也为并 行计算带来了新的发展机遇。

02