多元线性回归模型的各种检验方法

多元线性回归模型(6)

样本,可表示为

Y1 1 2 X 21 3 X31 ... k X k1 u1 Y2 1 2 X 22 3 X32 ... k X k2 u2

Yn 1 2 X 2n 3 X3n ... k X kn un

11

用矩阵表示

Y1 1

即 X可X逆

假定6:正态性假定 ui ~ N(0,σ2)

15

第二节 多元线性回归模型的估计

本节基本内容:

● 普通最小二乘法(OLS) ● OLS估计式的性质 ● OLS估计的分布性质

● 随机扰动项方差 的估2 计

● 回归系数的区间估计

16

一、普通最小二乘法(OLS)

最小二乘原则

剩余平方和最小: min ei2 (Yi -Yˆi)2

1 X 22

X kiei

X

k1

Xk2

1 e1

0

X

2n

e2

=

XБайду номын сангаас

e

=

0

X

kn

en

0

X

e

因为样本回归函数为 Y = Xβˆ + e

两边乘 X有 :

X Y = X Xβˆ + X e

因为 Xe,= 0则正规方程为:

X Xβˆ = X Y

19

OLS估计式

由正规方程 多元回归中 二元回归中

或取固定值的矩阵

2.无偏特性:

E(βˆk ) βk

21

3. 最小方差特性

在 βk所有的线性无偏估计中,OLS估计 β具ˆk 有

最小方差

结论:在古典假定下,多元线性回归的 OLS估计 式是最佳线性无偏估计式(BLUE)

多元线性回归模型

Cov( X ji , i ) 0

j 1,2, k

假设4,随机项满足正态分布

i ~ N (0, 2 )

上述假设的矩阵符号表示 式:

假设1,n(k+1)维矩阵X是非随机的,且X的秩=k+1,

即X满秩。

回忆线性代数中关于满秩、线性无关!

假设2,

E (μ)

E

1

E (1 )

0

n E( n )

X ki ) ) X 1i ) X 2i

Yi Yi X 1i Yi X 2i

(ˆ0 ˆ1 X 1i ˆ2 X 2i ˆk X ki ) X ki Yi X ki

解该( k+1)个方程组成的线性代数方程组,即

可得到(k+1) 个待估参数的估计值

$ j

,

j

0,1,2, ,

k

。

□正规方程组的矩阵形式

en

二、多元线性回归模型的基本假定

假设1,解释变量是非随机的或固定的,且各X之间互不 相关(无多重共线性)。

假设2,随机误差项具有零均值、同方差及不序列相关 性。

E(i ) 0

i j i, j 1,2,, n

Var

(i

)

E

(

2 i

)

2

Cov(i , j ) E(i j ) 0

假设3,解释变量与随机项不相关

这里利用了假设: E(X’)=0

等于0,因为解释变 量与随机扰动项不相 关。

3、有效性(最小方差性)

ˆ 的方差-协方差矩阵为

Co(v ˆ) E{[ˆ E(ˆ)][ˆ E(ˆ)]}

E[(ˆ )(ˆ )]

E{([ X X)-1X ]([ X X)-1X ]}

多元线性回归模型

第二节 多元线性回归模型的参数估计

一、多元线性回归参数的最小二乘估计

二、最小二乘估计量的数值性质

三、最小二乘估计量的统计性质

四、参数的估计误差与置信区间

二 、最小二乘估计量的数值性质

ˆ ˆ ˆ 1.样本均值点在样本平面上,即Y 0 1 X 1 2 X 2

2.剩余项(残差)ei的均值为零,即 e

另外两个要求 假定8:无设定偏误,模型被正确地设定。

假定9:解释变量之间不存在完全共线性,没有精确的线性

关系。

三、多元线性回归模型的基本假定

无多重共线性假定: 各解释变量之间不存在严格的线性关系,或者说各解

释变量之间线性无关;亦即解释变量之间不存在精确的线

性关系,即是说不存在一列不全为0的数 1 , 2 , , k , 能使下式成立:

其中,残差项ei是随机扰动项ui的估计。

二 、样本线性回归模型

特别地,当K=2时,二元线性样本回归函数为

ˆ ˆ ˆ ˆ Yi 0 1 X 1i 2 X 2i

二元线性样本回归模型为:

ˆ ˆ ˆ Yi 0 1 X 1i 2 X 2i ei

2 ei ˆ X X ) 0 2X 2i Yi ( 0 1 1i 2 2i ˆ 2

e i 0 ei X 1i 0 e i X 2 i 0

2.化简得正规方程

ˆ ˆ ˆ n 0 X 1i X 2i Y i

四、参数的估计误差与置信区间

三、最小二乘估计量的统计性质

在古典线性回归模型的基本假定下,一元线性回 归模型的OLS估计量是最优线性无偏估计量,这个性

线性回归模型的经典假定及检验修正

线性回归模型的经典假定及检验、修正一、线性回归模型的基本假定1、一元线性回归模型一元线性回归模型是最简单的计量经济学模型,在模型中只有一个解释变量,其一般形式是Y =β0+β1X 1+μ其中,Y 为被解释变量,X 为解释变量,β0与β1为待估参数,μ为随机干扰项。

回归分析的主要目的是要通过样本回归函数(模型)尽可能准确地估计总体回归函数(模型)。

为保证函数估计量具有良好的性质,通常对模型提出若干基本假设。

假设1:回归模型是正确设定的。

模型的正确设定主要包括两个方面的内容:(1)模型选择了正确的变量,即未遗漏重要变量,也不含无关变量;(2)模型选择了正确的函数形式,即当被解释变量与解释变量间呈现某种函数形式时,我们所设定的总体回归方程恰为该函数形式。

假设2:解释变量X 是确定性变量,而不是随机变量,在重复抽样中取固定值。

这里假定解释变量为非随机的,可以简化对参数估计性质的讨论。

假设3:解释变量X 在所抽取的样本中具有变异性,而且随着样本容量的无限增加,解释变量X 的样本方差趋于一个非零的有限常数,即∑(X i −X ̅)2n i=1n→Q,n →∞ 在以因果关系为基础的回归分析中,往往就是通过解释变量X 的变化来解释被解释变量Y 的变化的,因此,解释变量X 要有足够的变异性。

对其样本方差的极限为非零有限常数的假设,旨在排除时间序列数据出现持续上升或下降的变量作为解释变量,因为这类数据不仅使大样本统计推断变得无效,而且往往产生伪回归问题。

假设4:随机误差项μ具有给定X 条件下的零均值、同方差以及无序列相关性,即E(μi|X i)=0Var(μi|X i)=σ2Cov(μi,μj|X i,X j)=0, i≠j随机误差项μ的条件零均值假设意味着μ的期望不依赖于X的变化而变化,且总为常数零。

该假设表明μ与X不存在任何形式的相关性,因此该假设成立时也往往称X为外生性解释变量随机误差项μ的条件同方差假设意味着μ的方差不依赖于X的变化而变化,且总为常数σ2。

多元线性回归——模型、估计、检验与预测

多元线性回归——模型、估计、检验与预测⼀、模型假设传统多元线性回归模型最重要的假设的原理为:1. ⾃变量和因变量之间存在多元线性关系,因变量y能够被x1,x2….x{k}完全地线性解释;2.不能被解释的部分则为纯粹的⽆法观测到的误差其它假设主要为:1.模型线性,设定正确;2.⽆多重共线性;3.⽆内⽣性;4.随机误差项具有条件零均值、同⽅差、以及⽆⾃相关;5.随机误差项正态分布具体见另⼀篇⽂章:回归模型的基本假设⼆、估计⽅法⽬标:估计出多元回归模型的参数注:下⽂皆为矩阵表述,X为⾃变量矩阵(n*k维),y为因变量向量(n*1维)OLS(普通最⼩⼆乘估计)思想:多元回归模型的参数应当能够使得,因变量y的样本向量在由⾃变量X的样本所构成的线性空间G(x)的投影(即y’= xb)为向量y 在线性空间G(x)上的正交投影。

直⽩⼀点说,就是要使得(y-y’)’(y-y’)最⼩化,从⽽能够使y的预测值与y的真实值之间的差距最⼩。

使⽤凸优化⽅法,可以求得参数的估计值为:b = (x’x)^(-1)x’y最⼤似然估计既然已经在假设中假设了随机误差项的分布为正态分布,那么⾃变量y的分布也可以由线性模型推算出来(其分布的具体函数包括参数b在内)。

进⼀步的既然已经抽取到了y的样本,那么使得y的样本出现概率(联合概率密度)最⼤的参数即为所求最终结果与OLS估计的结果是⼀致的矩估计思想:通过寻找总体矩条件(模型设定时已经有的假设,即⽆内⽣性),在总体矩条件中有参数的存在,然后⽤样本矩形条件来进⾏推导未知参数的解。

在多元回归中有外⽣性假设:对应的样本矩为:最终估计结果与OLS⽅法也是⼀样的。

三、模型检验1.拟合优度检验(1)因变量y是随机变量,⽽估计出来的y’却不是随机变量;(2)拟合优度表⽰的是模型的估计值y’能够在多⼤程度上解释因变量样本y的变动。

(3)y’的变动解释y的变动能⼒越强,则说明模型拟合的越好y-y’就越接近与假设的随机误差(4)⽽因变量的变动是由其⽅差来描述的。

多元线性回归模型及其参数估计多元线性回归的显著性

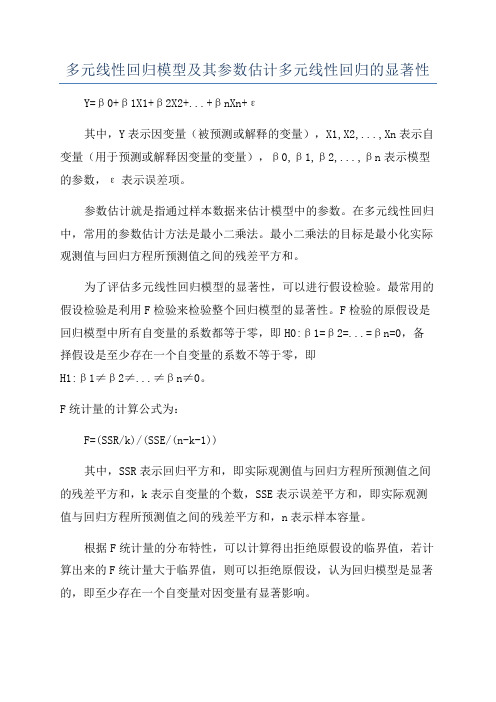

多元线性回归模型及其参数估计多元线性回归的显著性Y=β0+β1X1+β2X2+...+βnXn+ε其中,Y表示因变量(被预测或解释的变量),X1,X2,...,Xn表示自变量(用于预测或解释因变量的变量),β0,β1,β2,...,βn表示模型的参数,ε表示误差项。

参数估计就是指通过样本数据来估计模型中的参数。

在多元线性回归中,常用的参数估计方法是最小二乘法。

最小二乘法的目标是最小化实际观测值与回归方程所预测值之间的残差平方和。

为了评估多元线性回归模型的显著性,可以进行假设检验。

最常用的假设检验是利用F检验来检验整个回归模型的显著性。

F检验的原假设是回归模型中所有自变量的系数都等于零,即H0:β1=β2=...=βn=0,备择假设是至少存在一个自变量的系数不等于零,即H1:β1≠β2≠...≠βn≠0。

F统计量的计算公式为:F=(SSR/k)/(SSE/(n-k-1))其中,SSR表示回归平方和,即实际观测值与回归方程所预测值之间的残差平方和,k表示自变量的个数,SSE表示误差平方和,即实际观测值与回归方程所预测值之间的残差平方和,n表示样本容量。

根据F统计量的分布特性,可以计算得出拒绝原假设的临界值,若计算出来的F统计量大于临界值,则可以拒绝原假设,认为回归模型是显著的,即至少存在一个自变量对因变量有显著影响。

除了整体的回归模型显著性检验,我们还可以进行各个自变量的显著性检验。

每一个自变量的显著性检验都是基于t检验。

t检验的原假设是自变量的系数等于零,即H0:βi=0,备择假设是自变量的系数不等于零,即H1:βi≠0。

t统计量的计算公式为:t = (βi - bi) / (SE(βi))其中,βi表示模型中第i个自变量的系数估计值,bi表示模型中第i个自变量的理论值(一般为零),SE(βi)表示第i个自变量的系数的标准误。

根据t统计量的分布特性,可以计算得出对应自由度和置信水平的临界值,若计算出来的t统计量的绝对值大于临界值,则可以拒绝原假设,认为该自变量是显著的,即对因变量有显著影响。

多元回归分析

模型诊断

• Jackknife 验证法(Jackknife validation)

• 适用于样本量不是很大时 • 利用n-1个样本进行参数估计,并根据所估计的参数

计算剩余1个样本的预测值 • 计算拟和优度,并与利用全部样本时的拟和优度进

行比较。如果拟和优度降低,则说明该拟和优度可 能是更客观的,原本的高拟和可能是“机会”引起 的

• 多元回归分析引入多个自变量. 如果引入的自变量个数较少,则 不能很好的说明因变量的变化;

• 并非自变量引入越多越好.原因: – 有些自变量可能对因变量的解释没有贡献 – 自变量间可能存在较强的线性关系,即:多重共线性. 因而不能 全部引入回归方程.

多元线性回归分析中的自变量筛选

(二)自变量向前筛选法(forward): • 即:自变量不断进入回归方程的过程. • 首先,选择与因变量具有最高相关系数的自变量进入方程,

多元线性回归分析中的自变量筛选

• SPSS操作:options选项:

– stepping method criteria:逐步筛选法参数设置. • use probability of F:以F值相伴概率作为变量进入和剔除方 程的标准.一个变量的F值显著性水平小于entry(0.05)则进 入方程;大于removal(0.1)则剔除出方程.因此:Entry<removal • use F value:以F值作为变量进入(3.84)和剔除(2.71)方程的 标准

U ns tandardi zed Coeff icients

B

Std. Error

10396.060

625.869

539.803

60.961

6840. 963

633.280

一元线性回归模型与多元线性回归模型对比

总离差平方和的分解

TSS=ESS+RSS

, 越接近于1,拟合优度越高。

总离差平方和的分解

TSS=ESS+RSS

,(即总平方和中回归平方和的比例)

对于同一个模型, 越接近于1,拟合优度越高。

(调整的思路是残差平方和RSS和总平方和TSS各自除以它们的自由度)

为什么要对 进行调整?解释变量个数越多,它们对Y所能解释的部分越大(即回归平方和部分越大),残差平方和部分越小, 越高,由增加解释变量引起的 的增大与拟合好坏无关,因此在多元回归模型之间比较拟合优度, 就不是一个合适的指标,必须加以调整。

变量的显著性检验目Fra bibliotek:对模型中被解释变量对每一个解释变量之间的线性关系是否成立作出判断,或者说考察所选择的解释变量对被解释变量是否有显著的线性影响。针对某解释变量 ,

原假设: 备择假设:

最常用的检验方法: t检验

构造统计量:

判断步骤:①计算t统计量的值

②给定显著性水平 ,查t分布的临界值表获得

)

③比较t值与 的值,

(普通最小二乘估计的离差形式)

随机干扰项的方差

最大似然估计(ML)

矩估计(MM)

参数估计值估计结果与OLS方法一致,但随机干扰项的方差的估计量与OLS不同

参数估计值估计结果与OLS方法一致,但随机干扰项的方差的估计量

参数估计量的性质

线性性、无偏性、有效性

线性性、无偏性、有效性

参数估计量的概率分布

---

随机误差项与解释变量不相关。

假设:6:

正态性假设。随机项服从正态分布。

正态性假设。随机项服从正态分布。

参数估计

一元线性回归模型

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1 对多元线性回归模型的各种检验方法

对于形如

uXXXYkk22110 (1) 的回归模型,我们可能需要对其实施如下的检验中的一种或几种检验: 一、 对单个总体参数的假设检验:t检验 在这种检验中,我们需要对模型中的某个(总体)

参数是否满足虚拟假设0H:jja,做出具有统计意义(即带有一定的置信度)的检验,其中ja为某个给定的已知数。特别是,当ja=0时,称为参数的(狭义意义上的)显著性检验。如果拒绝0H,说明解释变量jX对被解释变量Y具有显著的线性影响,估计值jˆ才敢使用;反之,说明解释变量jX对被解释变量Y不具有显著的线性影响,估计值jˆ对我们就没有意义。具体检验方法如下: (1) 给定虚拟假设 0H:jja; 2

(2) 计算统计量 )ˆ(ˆ)ˆ()(ˆjjjjjjSeaSeEt 的数值; 11ˆ)ˆ(jjjjjjjCCSe1TX)(X,其中 (3) 在给定的显著水平下(不能大于1.0即 10%,也即我们不能在置信度小于90%以下的前提下做结

论),查出双尾t(1kn)分布的临界值2/t; (4) 如果出现 2/tt的情况,检验结论为拒绝

0H;反之,无法拒绝0H。

t检验方法的关键是统计量 )ˆ(ˆjjjSet必须服从已

知的t分布函数。什么情况或条件下才会这样呢?这需要我们建立的模型满足如下的条件(或假定): (1) 随机抽样性。我们有一个含n次观测的随机样niYXXXiikii,,2,1:,,,,

21

。这保证了误差u

自身的随机性,即无自相关性, 3

0))())(((jjiiuEuuEuCov。

(2) 条件期望值为0。给定解释变量的任何值,误差 u 的期望值为零。即有

0),,,(21kXXXuE 这也保证了误差u独立于解释变量XXX,,,21,即模型中的解释变量是外生性的,也使得0)(uE。 (3) 不存在完全共线性。在样本因而在总体中,没有一个解释变量是常数,解释变量之间也不存在严格的线性关系。 (4) 同方差性。常数221),,,(kXXXuVar。

(5) 正态性。误差u满足 ),0(~2Normalu。 在以上5个前提下,才可以推导出:

1~)ˆ(/)ˆ()1,0(~)ˆ(/)ˆ()]ˆ(,[~ˆknjjjjjjjjj

tSeNSd

VarN

4

由此可见,t检验方法所要求的条件是极为苛刻的。 二、 对参数的一个线性组合的假设的检验 需要检验的虚拟假设为 0H:21jj。比如21无 法直接检验。设立新参数211。 原虚拟假设等价于0H:01。将211代入原模型后得出新模型: uXXXXYkk)(212110 (2)

在模型(2)中再利用t检验方法检验虚拟假设0H:01。 我们甚至还可以检验这样一个更一般的假设 CHkk11000:λβ

t统计量为

)1(~ˆ2kntSetTλX)λ(Xλββλ1T 三、 对参数多个线性约束的假设检验:F检验 5

需要检验的虚拟假设为 0H: 0,,,021kqkqk。

该假设对模型(1)施加了q个排除性约束。模型(1)在该约束下转变为如下的新模型: uXXXYqkqk22110 (3)

模型(1)称为不受约束(ur)的模型,而模型(3)称为受约束(r)的模型。模型(3)也称为模型(1)的嵌套模型,或子模型。分别用OLS方法估计模型(1)和(2)后,可以计算出如下的统计量:

)1/(/knRSSqRSSRSS

F

ururr

关键在于,不需要满足t检验所需要的假定(3),统计量F就满足:1,~knqFF。利用已知的F分布函数,我们就可以拒绝或接受虚拟假设 0H:0,,,021kqkqk

了。所以,一般来讲,F检验比t检验更先使用,用的更普遍,可信度更高。利用关系式)1(2rrRTSSRSS, 6

)1(2ururRTSSRSS,F统计量还可以写成:

)1/()1(/222knRqRR

F

urrur

四、 对回归模型整体显著性的检验:F检验 需要检验的虚拟假设为 0H:0,,,021k。相当

于前一个检验问题的特例,kq。嵌套模型变为 uY0

。02rR,TSSRSSr,22RRur。F统计量变为:

)1/(/)1/()1(/22knRSSkESSknRkRF 五、 检验一般的线性约束 需要检验的虚拟假设比如为 0H:0,,,121k。受约束模型变为:

uXY10 7

再变形为:uXY01。F统计量只可用: )1/(/knRSSqRSSRSSFururr 其中, 211211)()()()(1XXYYXYXYTSSRSS

iiiiXYr。

六、 检验两个数据集的回归参数是否相等:皱(至庄)检验 虚拟假定是总体回归系数的真值相等。步骤如下: (1) 基于两组样本数据,进行相同设定的回归,将二

者的RSS分别记为1RSS和2RSS。 (2) 将两组样本数据合并,基于合并的样本数据,进行相同设定的回归,将回归的RSS记为TRSS。 (3) 计算下面的F统计量: 8

)22/()()1/()(212121knnRSSRSSkRSSRSSRSSFT (4) 如果FF,拒绝原假定。 七、 非正态假定下多个线性约束的大样本假设检验:LM(拉格郎日乘数)检验 F检验方法需要模型(1)中的u满足正态性假定。 在不满足正态性假定时,在大样本条件下,可以使用LM

统计量。虚拟假设依然是0H:0,,,021kqkqk。LM统计量仅要求对受约束模型的估计。具体步骤如下: (ⅰ)将Y对施加限制后的解释变量进行回归,并保留残差u~。即我们要进行了如下的回归估计 uXXXYqkqk~~~~~22110

(ⅱ)将u~对所有解释变量进行辅助回归,即进行如下回归估计

ˆˆˆˆˆ~22110kkXXXu 9

并得到R-平方,记为2uR。 (ⅲ)计算统计量 2unRLM。 (ⅳ)将LM与2q分布中适当的临界值c比较。如果cLM,就拒绝虚拟假设0H;否则,就不能拒绝虚拟

假设0H。 八、 对模型函数形式误设问题的一般检验:RESET 如果一个多元回归模型没有正确地解释被解释变量与所观察到的解释变量之间的关系,那它就存在函数形式误设的问题。误设可以表现为两种形式:模型中遗漏了对被解释变量有系统性影响的解释变量;错误地设定了一个模型的函数形式。在侦察一般的函数形式误设方面,拉姆齐(Ramsey,1969)的回归设定误差检验(regression specilfication error test , RESET)是一种常用的方法。RESET背后的思想相当简单。如果原模型(1)满足经典假定(3),那么在模型(1)中添加解释变量的非线性关系应该是不显著的。尽管这样做通常能侦察出函数形式误设,但如果原模型中有许多解 10

释变量,它又有使用掉大量自由度的缺陷。另外,非线性关系的形式也是多种多样的。RESET则是在模型(1)中添加模型(1)的OLS拟合值的多项式,以侦察函数形式误设的一般形式。 为了实施RESET,我们必须决定在一个扩大的回归模型中包括多少个拟合值的函数。虽然对这个问题没有正确的答案,但在大多数应用研究中,都表明平方项和三次项很有用。令Yˆ表示从模型(1)所得到的OLS估计值。考虑扩大的模型

322122110ˆˆYYXXXY

kk

(4)

这个模型看起来有些奇怪,因为原估计的拟合值的函数现在却出作为解释变量出现。实际上,我们对模型(4)的参数估计并不感兴趣,我们只是利用这个模型来检验模型(1)是否遗漏掉了重要的非线性关系。记住,2ˆY和

3ˆY

都只是jX的非线性函数。

对模型(4),我们检验虚拟假设0,0:210H。这时,模型(4)是无约束模型,模型(1)是受约束模型。计算F统计量。需要查3,2knF分布表。拒绝0H,模型(1)