BP及RBF神经网络代码及时间序列预测问题

BP神经网络预测的matlab代码

BP神经网络预测的matlab代码附录5:BP神经网络预测的matlab代码: P=[ 00.13860.21970.27730.32190.35840.38920.41590.43940.46050.47960.49700.52780.55450.59910.60890.61820.62710.63560.64380.65160.65920.66640.67350.72220.72750.73270.73780.74270.74750.75220.75680.76130.76570.7700]T=[0.4455 0.323 0.4116 0.3255 0.4486 0.2999 0.4926 0.2249 0.48930.2357 0.4866 0.22490.4819 0.2217 0.4997 0.2269 0.5027 0.217 0.5155 0.1918 0.5058 0.2395 0.4541 0.2408 0.4054 0.2701 0.3942 0.3316 0.2197 0.2963 0.5576 0.1061 0.4956 0.267 0.5126 0.2238 0.5314 0.2083 0.5191 0.208 0.5133 0.18480.5089 0.242 0.4812 0.2129 0.4927 0.287 0.4832 0.2742 0.5969 0.24030.5056 0.2173 0.5364 0.1994 0.5278 0.2015 0.5164 0.2239 0.4489 0.2404 0.4869 0.2963 0.4898 0.1987 0.5075 0.2917 0.4943 0.2902 ]threshold=[0 1]net=newff(threshold,[11,2],{'tansig','logsig'},'trainlm');net.trainParam.epochs=6000net.trainParam.goal=0.01LP.lr=0.1;net=train(net,P',T')P_test=[ 0.77420.77840.78240.78640.79020.7941 ] out=sim(net,P_test')友情提示:以上面0.7742为例0.7742=ln(47+1)/5因为网络输入有一个元素,对应的是测试时间,所以P只有一列,Pi=log(t+1)/10,这样做的目的是使得这些数据的范围处在[0 1]区间之内,但是事实上对于logsin命令而言输入参数是正负区间的任意值,而将输出值限定于0到1之间。

基于RBF神经网络优化的混沌时间序列预测

基于 R B F神 经 网络优化 的混沌 时间序 列预 测

邬开俊 1 9王铁君

( 1 . 兰 州 交通大 学 电子 与信 息工程 学 院 ,兰 州 7 3 0 0 7 0 ;2 .西 北民族 大学 数学 与 计算机 科 学学 院 ,兰州 7 3 0 0 3 0 )

第3 9卷 第 l 0期

V_ o 1 3 9 No. 1 0

计

算

机

工

程

2 0 1 3年 l 0月

Oc t o b e r 2 0l 3

Co mp u t e r En g i n e e r i n g

・

人工智 能及 识别技 术 ・

文章 编号:1 0 0 o _ _ 3 4 2 8 ( 2 o l 3 ) 1 0 . _ _ 0 2 0 8 — _ 0 4 文献标识码: A

2 . S c h o o l o f Ma t h e ma t i c s a n d C o mp u t e r S c i e n c e , No r t h we s t Un i v e r s i t y f o r Na t i o n a l i t i e s , L a n z h o u 7 3 0 0 3 0 , Ch i n a )

p r e d i c t i ve mo d e l ,t h e c e n t e r ,wi dt h ,a n d c o n n e c t i o n we i g ht s o f RBF ne u r a l n e t wo r k s a r e o p t i mi z e d b y t h e g l o ba l s e a r c h a b i l i t y of DE The

BP神经网络进行时间序列预测的不足及改进

0 引 言

时 间 序 列 预 测 是 由历 史 数 据 来 推 测 未 来 某 个 时 刻 的值 ,

关 键 是 获 得 时 间 序 列 某 一 时刻 数 据 与 其 前 面 数 据 之 间 的 自回 归 数 学模 型 。 果 记 一 个 非 线 性 时 间 序 列 为 { , 一 般 形 式 如 ) 其

i i b l y f t g a i t . S a eu e r d c ed v l p n n f i e e aa I r c c l p lc t n a dsmu ai n s mek n s tn i o i C b s d t p e i t h e eo ig be d o me s r sd t、 n p a t a p i a o tn o t t i i a i n i lt , o i d o o p o lms de c p i nwi a p n b c u eo t el tt na dd f i n y o t eag rt m s l s c s b o m a r i a i n l n f r b e x e t l h p e e a s f h mi i e c e c f h l o h i ef u h a n r le n a o l i ao n i i t a tm n t , o g o t i i g t d l w c u a y Ai ig a r vn ep ro ma c , t r u h a ay i gt eag rt d smu ai n c u s , OT — r n n mea a i n o a c rc . m n t mp o i g t e f r n e h o g l zn l o h a i lto o e C 1 e i h n h im n r s o dn a s dp o l m—o v n y i f u d An r u h i r v n esmu a i gc u s ,t e e o a c f i lt g i b t r p n i gc u ea r b e s l i gwa n 、 n so dt o g h mp o i gt i lt o e h r r n eo smu a i et . h n r pf m n s e

RBF网络模型及其预测程序

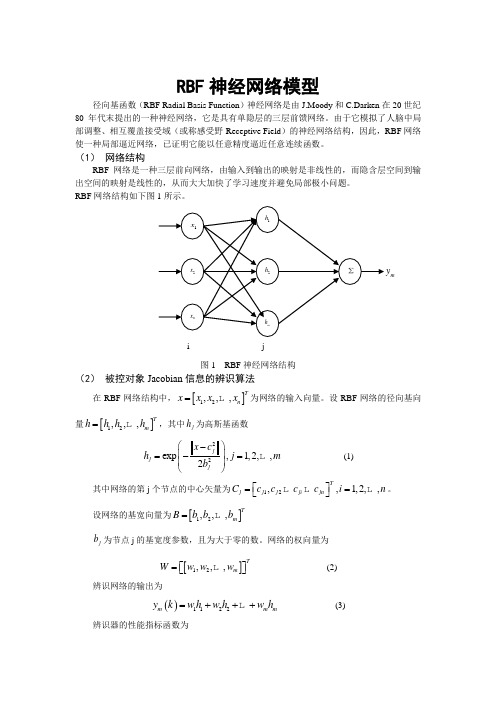

RBF 神经网络模型径向基函数(RBF Radial Basis Function )神经网络是由J.Moody 和C.Darken 在20世纪80年代末提出的一种神经网络,它是具有单隐层的三层前馈网络。

由于它模拟了人脑中局部调整、相互覆盖接受域(或称感受野-Receptive Field )的神经网络结构,因此,RBF 网络使一种局部逼近网络,已证明它能以任意精度逼近任意连续函数。

(1) 网络结构RBF 网络是一种三层前向网络,由输入到输出的映射是非线性的,而隐含层空间到输出空间的映射是线性的,从而大大加快了学习速度并避免局部极小问题。

RBF 网络结构如下图1所示。

图1 RBF 神经网络结构(2) 被控对象Jacobian 信息的辨识算法在RBF 网络结构中,[]12,,,Tn x x x x = 为网络的输入向量。

设RBF 网络的径向基向量[]12,,,Tm h h h h = ,其中j h 为高斯基函数22exp ,1,2,,2jj j x c h j m b ⎛⎫- ⎪=-= ⎪⎝⎭(1) 其中网络的第j 个节点的中心矢量为12,,1,2,,Tj j j ji jn C c c c c i n ⎡⎤==⎣⎦ 。

设网络的基宽向量为[]12,,,Tm B b b b =j b 为节点j 的基宽度参数,且为大于零的数。

网络的权向量为[]12,,,Tm W w w w ⎡⎤=⎣⎦ (2)辨识网络的输出为()1122m m m y k w h w h w h =+++ (3)辨识器的性能指标函数为my()()()212mJ y k y k =- (4)根据梯度下降法,输出权、节点中心及节点基宽参数的迭代算法如下()()()()j m j w k y k y k h η∆=-()()()()()()112j j j j j w k w k w k w k w k α=-+∆+---()()()()23jj m j jjX C b k y k y k w h bη-∆=-()()()()()112j j j j j b k b k b b k b k α=-+∆+---()()()()2j jiji m jjx c c k y k y k w b η-∆=-()()()()()()112ji ji ji ji ji c k c k c k c k c k α=-+∆+---式中,η为学习速率,α为动量因子。

神经网络及BP与RBF比较

一、神经网络概述1.简介人工神经网络是模仿脑细胞结构和功能、脑神经结构以及思维处理问题等脑功能的信息处系统,它从模仿人脑智能的角度出发,探寻新的信息表示、存储和处理方式,这种神经网络依靠系统的复杂程度,通过调整内部大量节点之间相互连接的关系,从而达到处理信息的目的,它采用了与传统人工智能和信息处理技术完全不同的机理,克服了传统的基于逻辑符号的人工智能在处理直觉、非结有针对性化信息方面的缺陷,具有自适应、自组织和实时学习的特点,它通过预先提供的一批相互对应的输入和输出数据,分析掌握两者之间潜在的规律,最终根据这些规律,用新的输入数据来推算输出结果。

人工神经网络(ANN)学习对于训练数据中的错误健壮性很好,且已被成功地应用到很多领域,例如视觉场景分析、语音识别、机器人控制以及医学图像处理等。

人工神经网络2.人工神经网络的特点及功能人工神经网络具有以下几个突出的优点:(1)能充分逼近复杂的非线性关系。

只有当神经元对所有输入信号的综合处理结果超过某一个限值后才能输出一个信号。

(2)所有定量或定性的信息都等势分布贮存于网络内的各神经元,每个神经元及其连线只能表示一部分信息,因此当有节点断裂时也不影响总体运行效果,具有很强的鲁棒性和容错能力。

(3)采用并行分布处理方法,使得快速进行大量运算成为可能。

(4)可学习和自适应不知道或不确定的系统。

人工神经网络的特点和优越性,使其具有以下三个显著的功能:(1)具有自学习功能:这种功能在图像识别和处理以及未来预测方面表现得尤为明显。

自学习功能在未来预测方面也意义重大,随着人工神经网络的发展,未来它将在更多的领域,比如经济预测、市场预测、效益预测等等,发挥更好的作用。

(2)具有联想存储功能:人的大脑能够对一些相关的知识进行归类划分,进而具有联想的功能,当我们遇到一个人或者一件事情的时候,跟此人或者此事相关的一些信息会浮现在你的脑海,而人工神经网络则通过它的反馈网络,实现一些相关事物的联想。

RBF神经网络与BP神经网络比较

Re:【求助】请教BP与RBF的区别我个人目前的资料显示,RBF网络的预测精度要大于BP网络,同时也显示RBF网络的训练时间明显小于BP网络。

在RBF网络中spread参数影响RBF网络最终的预测精度。

理论上讲,spread的值越大,逼近过程就比较平滑,但是逼近误差会比较大。

spread越小,对函数的逼近就越精确,但是逼近的过程就越不平滑。

由于spread的大小对网络最终的逼近精度有着比较大的影响,因此在设计网络时应多调整几个spread的值,直到达到比较好的精度。

下面举一个用RBF进行预测的例子:clear all;close all;y=rands(67,7);%用rand函数随机产生67组7维向量组P=y(:,1:4);%定义输入数据T=y(:,5:7);%定义输出数据for i=1:4net=newrbe(P,T,i+1);y(i,=sim(net,P_test);end说明:i+1为spread的取值(2,3,4,5)共试了4个,你可以自己定,我只是举个例子,P_test 为验证数据。

下面再举一个BP的例子:clear all;close all;y=rands(67,7);%用rand函数随机产生67组7维向量组P=y(:,1:4);%定义输入数据T=y(:,5:7);%定义输出数据n=10 %代表你的隐层神经元数net=newff(minmax(P),[n,3],{'tansig','purelin'},'trainlm');%训练网络net.trainParam.show=50;net.trainParam.lr=0.05;net.trainParam.epochs=2000;net.trainParam.goal=1e-3;net=train(net,P,T);%对BP网络进行仿真A=sim(net,P);E=A-tn;M=sse(E);N=mse(E);说明,可能你的数据处理前需归一化。

基于BP神经网络的预测算法在时间序列分析中的应用

基于BP神经网络的预测算法在时间序列分析中的应用基于BP(Back Propagation)神经网络的预测算法在时间序列分析中具有广泛的应用。

时间序列分析是一种研究时间上的观测值如何随时间变化而变化的特定技术。

通过对过去的时间序列数据进行分析,可以预测未来的趋势和模式。

BP神经网络是一种机器学习算法,可以通过训练将输入和输出之间的关系学习出来,从而可以用于时间序列预测。

BP神经网络的预测算法在时间序列分析中的应用主要有以下几个方面:1.股票市场预测:BP神经网络可以通过学习历史的股票市场数据,来预测未来股票价格的走势。

通过输入历史的股票价格、成交量等指标,可以训练BP神经网络模型,并使用该模型来预测未来的股票价格。

2.经济数据预测:BP神经网络可以通过学习历史的经济数据,来预测未来的经济趋势。

例如,可以使用过去的GDP、消费指数等数据作为输入,来预测未来的经济增长率或通货膨胀率。

3.交通流量预测:BP神经网络可以通过学习历史的交通流量数据,来预测未来的交通状况。

通过输入历史的交通流量、天气状况等数据,可以训练BP神经网络模型,并使用该模型来预测未来的交通流量,从而可以提前采取交通管理措施。

4.气象预测:BP神经网络可以通过学习历史的天气数据,来预测未来的气象变化。

例如,可以使用过去的温度、湿度、风向等数据作为输入,来预测未来的天气情况,从而为农业、旅游等行业提供预测参考。

5.能源需求预测:BP神经网络可以通过学习历史的能源需求数据,来预测未来的能源需求量。

通过输入历史的经济发展状况、人口增长等数据,可以训练BP神经网络模型,并使用该模型来预测未来的能源需求,从而指导能源生产和供应。

总体而言,基于BP神经网络的预测算法在时间序列分析中具有较强的预测能力。

通过学习历史的数据,BP神经网络可以发现数据中的规律和模式,并将其用于预测未来的趋势和变化。

然而,需要注意的是,BP 神经网络也有一些局限性,例如对于较大规模的数据集,训练时间可能较长。

BP神经网络算法的C语言实现代码

BP神经网络算法的C语言实现代码以下是一个BP神经网络的C语言实现代码,代码的详细说明可以帮助理解代码逻辑:```c#include <stdio.h>#include <stdlib.h>#include <math.h>#define INPUT_SIZE 2#define HIDDEN_SIZE 2#define OUTPUT_SIZE 1#define LEARNING_RATE 0.1//定义神经网络结构体typedef structdouble input[INPUT_SIZE];double hidden[HIDDEN_SIZE];double output[OUTPUT_SIZE];double weights_ih[INPUT_SIZE][HIDDEN_SIZE];double weights_ho[HIDDEN_SIZE][OUTPUT_SIZE];} NeuralNetwork;//激活函数double sigmoid(double x)return 1 / (1 + exp(-x));//创建神经网络NeuralNetwork* create_neural_networNeuralNetwork* nn =(NeuralNetwork*)malloc(sizeof(NeuralNetwork));//初始化权重for (int i = 0; i < INPUT_SIZE; i++)for (int j = 0; j < HIDDEN_SIZE; j++)nn->weights_ih[i][j] = (double)rand( / RAND_MAX * 2 - 1;}}for (int i = 0; i < HIDDEN_SIZE; i++)for (int j = 0; j < OUTPUT_SIZE; j++)nn->weights_ho[i][j] = (double)rand( / RAND_MAX * 2 - 1;}}return nn;//前向传播void forward(NeuralNetwork* nn)//计算隐藏层输出for (int i = 0; i < HIDDEN_SIZE; i++)double sum = 0;for (int j = 0; j < INPUT_SIZE; j++)sum += nn->input[j] * nn->weights_ih[j][i];}nn->hidden[i] = sigmoid(sum);}//计算输出层输出for (int i = 0; i < OUTPUT_SIZE; i++)double sum = 0;for (int j = 0; j < HIDDEN_SIZE; j++)sum += nn->hidden[j] * nn->weights_ho[j][i];}nn->output[i] = sigmoid(sum);}void backpropagation(NeuralNetwork* nn, double target)//计算输出层误差double output_error[OUTPUT_SIZE];for (int i = 0; i < OUTPUT_SIZE; i++)double delta = target - nn->output[i];output_error[i] = nn->output[i] * (1 - nn->output[i]) * delta;}//更新隐藏层到输出层权重for (int i = 0; i < HIDDEN_SIZE; i++)for (int j = 0; j < OUTPUT_SIZE; j++)nn->weights_ho[i][j] += LEARNING_RATE * nn->hidden[i] * output_error[j];}}//计算隐藏层误差double hidden_error[HIDDEN_SIZE];for (int i = 0; i < HIDDEN_SIZE; i++)double delta = 0;for (int j = 0; j < OUTPUT_SIZE; j++)delta += output_error[j] * nn->weights_ho[i][j];}hidden_error[i] = nn->hidden[i] * (1 - nn->hidden[i]) * delta;}//更新输入层到隐藏层权重for (int i = 0; i < INPUT_SIZE; i++)for (int j = 0; j < HIDDEN_SIZE; j++)nn->weights_ih[i][j] += LEARNING_RATE * nn->input[i] * hidden_error[j];}}void train(NeuralNetwork* nn, double input[][2], double target[], int num_examples)int iteration = 0;while (iteration < MAX_ITERATIONS)double error = 0;for (int i = 0; i < num_examples; i++)for (int j = 0; j < INPUT_SIZE; j++)nn->input[j] = input[i][j];}forward(nn);backpropagation(nn, target[i]);error += fabs(target[i] - nn->output[0]);}//判断误差是否已达到允许范围if (error < 0.01)break;}iteration++;}if (iteration == MAX_ITERATIONS)printf("Training failed! Error: %.8lf\n", error); }void predict(NeuralNetwork* nn, double input[]) for (int i = 0; i < INPUT_SIZE; i++)nn->input[i] = input[i];}forward(nn);printf("Prediction: %.8lf\n", nn->output[0]); int maiNeuralNetwork* nn = create_neural_network(; double input[4][2] ={0,0},{0,1},{1,0},{1,1}};double target[4] =0,1,1,};train(nn, input, target, 4);predict(nn, input[0]);predict(nn, input[1]);predict(nn, input[2]);predict(nn, input[3]);free(nn);return 0;```以上代码实现了一个简单的BP神经网络,该神经网络包含一个输入层、一个隐藏层和一个输出层。

用于非线性时间序列预测的POD-RBF神经网络

用于非线性时间序列预测的POD-RBF神经网络随着人工智能技术的不断发展,预测模型的研究也越来越成熟。

在非线性时间序列预测领域中,POD-RBF神经网络是一种较为优秀的预测模型。

本文将从什么是POD-RBF神经网络、其工作原理和应用等方面,进行800字的简单介绍。

一、POD-RBF神经网络简介POD-RBF神经网络是基于POD(Proper Orthogonal Decomposition,广泛应用于流体力学中)和RBF(Radial Basis Function,径向基函数)神经网络的预测模型。

其主要用于传统方法难以处理的非线性时间序列预测问题。

二、POD-RBF神经网络工作原理1.数据处理POD-RBF神经网络模型的输入数据通常需要进行处理,常见的处理方式是将其归一化处理。

对于具有多个输入变量的数据,可以对每个输入变量进行单独处理,也可以将其组合成一个总体处理。

2.POD分解POD-RBF神经网络模型采用的是现代数学的快速分解方法POD。

通过POD分解,可以将复杂的空间时间序列分解为多个空间模态,大幅度简化了数据的处理和计算难度。

3.RBF神经网络RBF神经网络是POD-RBF神经网络中的一个重要组成部分,主要用于模型构建和模型预测。

RBF神经网络采用的是径向基函数和线性可分技术,能够很好地处理非线性数据特征,并且具有高度准确性和预测能力。

4.模型预测POD-RBF神经网络通过对历史数据进行学习和预测,得到了一组时间序列预测值。

然后,将这些预测值进行拟合,得到未来时间序列的预测值,并根据实际预测结果进行调整。

三、POD-RBF神经网络应用1.气象预测POD-RBF神经网络可以预测精确的气象变化,使得气象预测更加准确,从而有利于人们做出调整。

2.股票走势预测POD-RBF神经网络可以对股票走势预测,使得投资者能够更好地把握市场,规避风险。

3.环境预测POD-RBF神经网络可以预测污染事件,使环境保护能够提前预警,从而避免环境污染。

RBF神经网络与BP神经网络的比较

RBF神经网络与BP神经网络都是非线性多层前向网络,它们都是通用逼近器。

对于任一个BP神经网络,总存在一个RBF神经网络可以代替它,反之亦然。

但是这两个网络也存在着很多不同点,这里从网络结构、训练算法、网络资源的利用及逼近性能等方面对RBF神经网络和BP神经网络进行比较研究。

(1)从网络结构上看。

BP神经网络实行权连接,而RBF神经网络输入层到隐层单元之间为直接连接,隐层到输出层实行权连接。

BP神经网络隐层单元的转移函数一般选择非线性函数(如反正切函数),RBF神经网络隐层单元的转移函数是关于中心对称的RBF(如高斯函数)。

BP神经网络是三层或三层以上的静态前馈神经网络,其隐层和隐层节点数不容易确定,没有普遍适用的规律可循,一旦网络的结构确定下来,在训练阶段网络结构将不再变化;RBF神经网络是三层静态前馈神经网络,隐层单元数也就是网络的结构可以根据研究的具体问题,在训练阶段自适应地调整,这样网络的适用性就更好了。

(2)从训练算法上看。

BP神经网络需要确定的参数是连接权值和阈值,主要的训练算法为BP算法和改进的BP算法。

但BP算法存在许多不足之处,主要表现为易限于局部极小值,学习过程收敛速度慢,隐层和隐层节点数难以确定;更为重要的是,一个新的BP神经网络能否经过训练达到收敛还与训练样本的容量、选择的算法及事先确定的网络结构(输入节点、隐层节点、输出节点及输出节点的传递函数)、期望误差和训练步数有很大的关系。

RBF神经网络的训练算法在前面已做了论述,目前,很多RBF神经网络的训练算法支持在线和离线训练,可以动态确定网络结构和隐层单元的数据中心和扩展常数,学习速度快,比BP算法表现出更好的性能。

(3)从网络资源的利用上看。

RBF神经网络原理、结构和学习算法的特殊性决定了其隐层单元的分配可以根据训练样本的容量、类别和分布来决定。

如采用最近邻聚类方式训练网络,网络隐层单元的分配就仅与训练样本的分布及隐层单元的宽度有关,与执行的任务无关。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

k1=f(x(n))-b*x(k); k2=f(x(n))-b*(x(k)+h*k1/2); k3=f(x(n))-b*(x(k)+k2*h/2); k4=f(x(n))-b*(x(k)+k3*h); x(k+1)=x(k)+(k1+2*k2+2*k3+k4)*h/6; end end figure hold on grid plot(t,x); SamNum=3000; h=0.1; TestSamNum=500; InDim=4; ClusterNum=88; Overlap=1.0; rand('state',sum(3000*clock)) NoiseVar=0.1; Noise=NoiseVar*rand(1,SamNum); SamIn=rand(InDim,SamNum); SamOutNoNoise=rand(1,SamNum); TestSamIn=rand(InDim,TestSamNum); TestSamOut=rand(1,TestSamNum); for k=201:3200 SamIn(1,k-200)=x((k-18)/h+1); SamIn(2,k-200)=x((k-12)/h+1); SamIn(3,k-200)=x((k-6)/h+1); SamIn(4,k-200)=x((k)/h+1); SamOutNoNoise(k-200)=x((k+85)/h+1); end SamOut=SamOutNoNoise+Noise; for l=5001:5500 TestSamIn(1,l-5000)=x((l-18)/h+1); TestSamIn(2,l-5000)=x((l-12)/h+1); TestSamIn(3,l-5000)=x((l-6)/h+1); TestSamIn(4,l-5000)=x((l)/h+1); TestSamOut(l-5000)=x((l+85)/h+1); end Centers=SamIn(:,1:ClusterNum); NumberInClusters=zeros(ClusterNum,1); IndexInClusters=zeros(ClusterNum,SamNum); while 1, NumberInClusters=zeros(ClusterNum,1);

grid plot(t,x); SamNum=3000; h=0.1; TestSamNum=500; HiddenUnitNum=20; InDim=4; OutDim=1; rand('state',sum(3000*clock)) NoiseVar=0.1; Noise=NoiseVar*rand(OutDim,SamNum); SamIn=rand(InDim,SamNum); SamOutNoNoise=rand(OutDim,SamNum); TestSamIn=rand(InDim,TestSamNum); TestSamOut=rand(OutDim,TestSamNum); for k=201:3200 SamIn(1,k-200)=x((k-18)/h+1); SamIn(2,k-200)=x((k-12)/h+1); SamIn(3,k-200)=x((k-6)/h+1); SamIn(4,k-200)=x((k)/h+1); SamOutNoNoise(k-200)=x((k+85)/h+1); end SamOut=SamOutNoNoise+Noise; for l=5001:5500 TestSamIn(1,l-5000)=x((l-18)/h+1); TestSamIn(2,l-5000)=x((l-12)/h+1); TestSamIn(3,l-5000)=x((l-6)/h+1); TestSamIn(4,l-5000)=x((l)/h+1); TestSamOut(l-5000)=x((l+85)/h+1); end MaxEpochs=20000; Ir=0.00005; E0=0.5; W1=0.1*rand(HiddenUnitNum,InDim); B1=0.1*rand(HiddenUnitNum,1); W2=0.1*rand(OutDim,HiddenUnitNum); B2=0.1*rand(OutDim,1); W1Ex=[W1 B1]; W2Ex=[W2 B2]; SamInEx=[SamIn' ones(SamNum,1)]'; ErrHistory=[]; for i=1:MaxEpochs HiddenOut=logsig(W1Ex*SamInEx); HiddenOutEx=[HiddenOut' ones(SamNum,1)]';

说明:在竞争 BP 算法中,隐层数为 1,单层隐节点数为 20;最大训练次数为 20000, 学习率为 0.0005, 误差要求为 0.5; 在隐层权值修正中, 非最大误差神经元权矢量修正为−δ/4; 采用 RSME 测试误差。 3.2 基于聚类的 RBF 网络 算法流程: (1) 初始化:从样本输入中选取前 88 个样本作为初始聚类中心; (2) 计算所有样本输入与聚类中心的距离; (3) 对输入样本进行分类; (4) 重新计算各类的新的聚类中心; (5) 若该次聚类中心与上次重合则进入下一步;否则返回到步骤 2; (6) 确定各隐节点的扩展常数; (7) 将测试的 500 个样本输入进去,得到测试结果,求出测试误差。 程序代码:

NetworkOut=W2Ex*HiddenOutEx; Error=SamOut-NetworkOut; SSE=sumsqr(Error) ErrHistory=[ErrHistory SSE]; if SSE<E0,break,end Delta2=Error; Delta1=W2'*Delta2.*HiddenOut.*(1-HiddenOut); max1=0; d=1; for j=1:HiddenUnitNum norm(Delta1(j,:),2); if max1<=norm(Delta1(j,:),2) max1=norm(Delta1(j,:),2); d=j; end end for j=1:HiddenUnitNum if j==d Delta1(j,:)=Delta1(d,:); else Delta1(j,:)=-Delta1(d,:)/4; end end dW2Ex=Delta2*HiddenOutEx'; dW1Ex=Delta1*SamInEx'; W1Ex=W1Ex+Ir*dW1Ex; W2Ex=W2Ex+Ir*dW2Ex; W2=W2Ex(:,1:HiddenUnitNum); end W1=W1Ex(:,1:InDim) B1=W1Ex(:,InDim+1) W2 B2=W2Ex(:,1+HiddenUnitNum); TestHiddenOut=logsig(W1*TestSamIn+repmat(B1,1,TestSamNum)); TestNNOut=W2*TestHiddenOut+repmat(B2,1,TestSamNum); figure hold on grid plot(5001:5500,TestNNOut,'k-') plot(5001:5500,TestSamOut,'k--') figure hold on grid [xx,Num]=size(ErrHistory);

二、研究进展

所谓时间序列,又称动态数据,指一组按时间顺序排列的数字序列,数据带有随机性, 相互之间存在某种统计上的联系。 时间序列按照性态可分为有确定规律的、混沌的和完全随机的。 20 多年来,国内外许多学者对时间序列的建模预测做了很多工作。90 年代初以前,在 数学界和工程界许多学者的共同努力下。 国外以 1976 年 George E. P. Box 和 Gwilym M. Jenkins 等的专著《 Time Series Analysis: Forecasting and Control》和 1983 年 S.M.Pandit 和 Shien Ming Wu 的专著《Time Series and System Analysis with Applications》为标志。 国内以 1983 年安鸿志、陈兆国的专著《时间序列的分析与应用》和 1991 年杨叔子等 著的《时间序列分析的工程应用》等为标志。 此外,还有专门的期刊 Journal of Time Series Analysis、国际会议和专题讨论,使时间 序列建模预测技术从理论到应用都已经有了长足的发展。 Padgett 提出神经网络在时间序列预测中几种典型应用; EsparciaAlcazar 提出利用遗传算 法优化多层神经网络结构,并将此神经网络用于时间序列预测;A. S. Pandya 对有噪声的时 间序列预测进行了研究;Francesco Masulli 研究了模糊神经系统,并利用该系统对时间序列 进行预测;Roman Rosipal 利用资源分配型 RBF 神经网络对混沌时间序列进行预测; 吴春国等人基于正规正交分解 ( Proper Orthogonal Decomposition,POD) 提出一种适用 于非线性时间序列预测的径向基函数(RBF) 神经网络模型 - POD-RBF 神经网络模型。该 模型在选取中心时考虑了时间序列数据之间的时序关系,并且使得中心的选取具有并行性。 北京航空航天大学的柳萍等人针对混沌时间序列预测问题, 提出了一种基子小波框架的 小波核函数与最小二乘支持向量机相结合的方法。 该方法不仅能够以较高的精度逼近任意函 数,而且还适用于混沌信号的局部分析,提高了最小二乘支持向量机的模型泛化能力。 南京航空航天大学的张军峰基于一种新型聚类算法的 RBF 神经网络对混沌时间序列进 行预测。 文中提出了一种基于高斯基的距离度量,并联合输入输出聚类的策略。 基于 Fisher 可 分离率设计高斯基距离度量中的惩罚因子, 可以提高聚类的性能。 而输入输出聚类策略的引 入,建立了聚类性能与网络预测性能之间的联系。