多类型分类器融合的文本分类方法研究

结合TFIDF方法与Skip-gram模型的文本分类方法研究

结合TFIDF方法与Skip-gram模型的文本分类方法研究作者:邬明强张奎来源:《电子技术与软件工程》2018年第06期摘要随看时代的发展,各种各秤的数据信息不断涌现,如何正确有效地对各种类别信息加以分类、区分,是一个很有研究价值的问题。

本文在传统的TFIDF模型的基础上,结合了Skip-gram模型,通过对给定语料库的文本进行类别训练,得到了文本的类别向量,接着计算出文档向量和各类别向量的相似度对文本进行分类。

实验证明,该方法在给定的语料库范围内,取得了较好的测试性能,准确率、召回率、F1明显优于余弦定理方法。

【关键词】TFIDF模型 Skip-gram模型文本分类1 引言随着计算机不断普及,因特网进入了大数据时代,海量的各种类型的数据信息不断涌现,给我们提供方便的同时,也带来了一定的挑战:如何有效地组织和管理这些信息,并且快速、准确、全面地从中找到用户所需要的信息是一个亟待解决的问题。

这里就用到了文本分类术。

文本分类是指用电脑对文本集按照一定的分类体系或标准进行自动分类标记,从而为每一个文档确定一个类别。

主要包括预处理、索引、统计、特征抽取、分类器、评价等步骤。

在过去几十年里,国内外学者提出及改进了一系列关于文本分类的算法,其中比较著名的如k近邻分类( k-NN)、朴素贝叶斯分类、支持向量机(SVM)及TFIDF等,现如今仍然被一些学者采用。

传统的方法由于技术不太成熟,所以准确性仍有待提高。

本文结合TFIDF方法和Skip-gram模型的方法实现文本分类,既能考虑到词汇在相应文档的重要性,又能体现词和词之间的语义关系,文本分类效果较好。

2 方法2.1 TFIDF方法简介TFIDF方法是一种基于词频与逆文档频率的统计方法,主要用来评估一个字词对于文件集或语料库中的一份文档或一个类别的重要程度。

它的思想为:如果某个词或者短语在一个类别中出现的频率较高,并且在其他类别中很少出现,则认为此词或者短语具有很好的类别区分能力,这种方法主要用来分类。

文本分类方法总结

文本分类方法总结李荣陆(复旦大学计算机与信息技术系,上海,200433)E-mail: lironglu@一、Swap-1方法1,特点:特征选择:将只在某一类中出现的词或短语作为这一类的特征,词频作为权重。

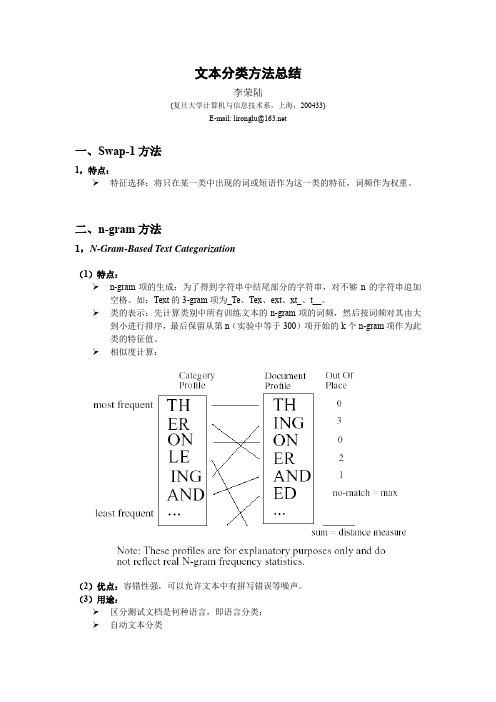

二、n-gram方法1,N-Gram-Based Text Categorization(1)特点:n-gram项的生成:为了得到字符串中结尾部分的字符串,对不够n的字符串追加空格。

如:Text的3-gram项为_Te、Tex、ext、xt_、t__。

类的表示:先计算类别中所有训练文本的n-gram项的词频,然后按词频对其由大到小进行排序,最后保留从第n(实验中等于300)项开始的k个n-gram项作为此类的特征值。

相似度计算:(2)优点:容错性强,可以允许文本中有拼写错误等噪声。

(3)用途:区分测试文档是何种语言,即语言分类;自动文本分类2,CAN Bayes(Chain Augmented Naive Bayes)Bayes 分类器是一个性能很好的线性分类器,但是它假设文档的每个分类特征属性间是相互独立的,这显然是不成立的。

假设d i ={w i1,w i2,…,w in }为一任意文档,它属于文档类C ={c 1, c 2,…, c k }中的某一类c j 。

根据Bayes 分类器有:)()|()()()|()|(j j i i j j i i j c P c d P d P c P c d P d c P ∝=,其中∏==rk j ik j i c w P c d P 1)|()|(。

如果使用Bayes 网络来描述特征属性间的联系,则失去了Bayes 模型的简单性和线性特征。

我们使用了统计语言学中的N-Gram 模型,它假设一个词在文档中某个位置出现的概率仅与它之前的n-1个词有关,即:)|()|(11121--+--=i n i n i i i i w w w w P w w w w P 。

文本分类及其特征提取

文本分类及其特征提取文本分类是指根据文本的内容、主题或语义将文本划分到不同的预定义类别中,是自然语言处理领域的一个重要任务。

文本分类在许多应用中都有着广泛的应用,如垃圾邮件过滤、情感分析、新闻分类、文档归档等。

在进行文本分类任务时,常常需要进行特征提取,提取文本中的关键信息以帮助分类器更好地进行分类。

特征提取是文本分类的关键步骤之一,其目的是将原始的文本数据转化为机器学习算法能够理解和处理的向量表示。

下面将介绍几种常用的文本分类方法及其特征提取方式:1.词袋模型词袋模型是文本分类中最常用的特征表示方法之一、该模型将文本看作是一个由词语组成的无序集合,通过统计文本中每个词语的频率或者权重来表示文本的特征。

常见的词袋模型包括TF-IDF(Term Frequency-Inverse Document Frequency)和词频统计。

- TF-IDF是一个常用的特征表示方法,它考虑了词语在文本中的重要性。

TF(Term Frequency)表示词语在文本中出现的频率,IDF (Inverse Document Frequency)表示词语在整个文本语料库中的重要性。

TF-IDF的值可以通过TF和IDF的乘积来计算。

-词频统计是指直接统计词语在文本中的出现次数。

将文本转化为词频向量后,可以使用机器学习算法(如朴素贝叶斯、支持向量机等)进行分类。

2. Word2VecWord2Vec是一种将词语转化为向量表示的方法,能够将词语的语义信息编码到向量中。

Word2Vec根据词语的上下文关系学习得到词向量空间,通过计算词语之间的距离或者相似性来表示词语的特征。

- CBOW(Continuous Bag-of-Words)模型根据上下文预测中心词,从而学习得到词向量。

- Skip-gram模型则根据中心词预测上下文词,同样可以得到词向量。

Word2Vec的特点是能够很好地捕捉到词语之间的语义关系,例如可以通过词向量的加减法来进行类比推理操作。

文本分类中的特征提取和分类算法综述

文本分类中的特征提取和分类算法综述特征提取和分类算法是文本分类中非常重要的步骤,对于智能化应用和信息检索具有重要的意义。

本文将综述文本分类中常用的特征提取方法和分类算法,并对其优缺点进行分析和比较。

一、特征提取方法特征提取是将文本转化为计算机可识别的特征向量的过程。

下面介绍几种常用的特征提取方法:1. 词袋模型(Bag of Words):词袋模型将文本转换为一个包含词袋(词汇表)中所有单词的向量。

对于每个文档,词袋模型统计每个词在文档中的词频或词重。

这种方法简单有效,但忽略了文本中的语法和顺序信息。

2. N-gram模型:N-gram模型将文本分成N个连续的词组,统计每个词组的出现频率。

该方法考虑了词组的局部关系,能够捕捉文本中的一定的语序信息。

3.TF-IDF:TF-IDF(Term Frequency-Inverse Document Frequency)是一种基于词频和逆文档频率的特征提取方法。

它衡量了一个词在文档中的重要性,高频率出现且在整个语料库中稀有的词被认为具有较高的区分能力。

4.主题模型:主题模型通过对文档进行主题聚类,将文本转化为对应主题的概率分布向量。

主题模型可以提取文本中的语义信息,但参数估计较为困难。

5. Word2Vec:Word2Vec是一种基于神经网络的词嵌入模型,通过学习词的分布式表示。

Word2Vec可以捕捉词之间的语义相似性,提取更加丰富的特征。

二、分类算法分类算法是根据提取的特征向量对文本进行分类。

常用的分类算法包括:1.朴素贝叶斯分类器:朴素贝叶斯分类器基于贝叶斯定理和特征条件独立假设,计算每个类别的概率,并选择概率最大的类别作为分类结果。

朴素贝叶斯分类器简单高效,对于大规模数据集适用。

2.支持向量机:支持向量机通过寻找一个超平面,将不同类别的样本点分开。

它可以处理高维数据,具有较好的泛化性能。

3.决策树:决策树根据特征之间的关系构建一棵树型结构,通过比较特征值进行分类。

基于机器学习的文本自动分类系统设计与实现

基于机器学习的文本自动分类系统设计与实现随着信息技术的快速发展,海量的文本数据产生并积累,如何从这些数据中获取有价值的信息成为一个重要的问题。

文本分类作为信息检索和文本挖掘的一个重要研究方向,能够帮助人们快速准确地对大量文本进行分类和理解,因此备受学术界和工业界的关注。

本文将介绍一种基于机器学习的文本自动分类系统的设计与实现。

一、系统的需求分析文本自动分类系统的主要任务是将一篇给定的文本自动分配到已定义的分类中。

根据需求分析,我们对系统进行以下的功能需求和性能需求的要求。

1. 功能需求- 自动对给定的文本进行分类,无需人工干预。

- 支持多类别的分类,可以将文本分配到多个分类中。

- 系统具有良好的扩展性,可以根据需要增加或修改分类。

2. 性能需求- 系统的分类准确率要高,可以达到业界领先水平。

- 系统的处理速度要快,能够处理大规模的文本数据。

基于上述需求,我们可以采用机器学习的方法来设计和实现文本自动分类系统。

二、系统的设计与实现1. 数据预处理在开始设计系统之前,我们需要对文本数据进行预处理。

预处理的主要任务包括去除文本中的停用词(如“the”、“and”、“is”等),进行词干提取,以及将文本转换成数值型特征。

这些预处理步骤可以帮助减少数据的噪声,提取有效的特征。

2. 特征提取特征提取是文本分类的重要步骤之一。

在本系统中,我们将采用词袋模型(Bag of Words)作为特征提取的方法。

首先,我们需要构建一个词库,包含了所有文本数据中出现的词。

然后,我们可以使用词频或者TF-IDF等方法将每篇文本转换成一个向量表示。

3. 模型选择与训练在特征提取完成后,我们需要选择一个合适的机器学习模型来进行分类任务。

常见的机器学习模型包括朴素贝叶斯、支持向量机(SVM)和深度学习模型等。

根据我们的需求,我们可以选择一个性能较好的分类模型进行训练。

在模型选择后,我们需要为系统进行模型训练。

我们可以使用已经标注好的文本数据进行有监督学习,或者使用无标注数据进行半监督学习。

利用机器学习技术进行文本分类分析

利用机器学习技术进行文本分类分析随着信息技术的飞速发展,大量的文本信息被产生、存储和传播。

但是,这些文本信息的获取和利用带来了一定的挑战。

文本分类分析是一种处理大量文本信息的方法,它可以将文本自动分类并分配到特定的类别中。

这种技术可以提高文本信息的处理效率和准确性,为许多应用领域带来了巨大的价值。

近年来,机器学习技术的进步使得文本分类分析变得更加普遍和有效,下面将具体介绍这种技术的原理、应用和优缺点。

首先,我们需要了解文本分类分析的基本原理。

文本分类分析是将文本自动分成不同的类别,这个过程包括两个主要步骤:训练和测试。

在训练阶段,分类器学习一个分类模型,将训练数据分成多个类别,并根据每个类别的特征来构建模型。

测试阶段是将测试数据输入分类器,并以分类器所学的模型为依据,将测试数据自动分类到不同的类别中。

在这个过程中,分类器需要对数据进行特征提取和处理,以便得出分类结果。

因此,分类器的性能与特征选择和处理方法密切相关。

数学模型是机器学习的核心。

在文本分类分析中,常用的模型包括朴素贝叶斯(Naive Bayes)、支持向量机(SVM)和决策树等。

朴素贝叶斯模型基于贝叶斯定理,将文本的特征分解为独立的假设。

支持向量机模型利用超平面将文本分离到不同的类别中。

决策树是一种可视化分类方法,其主要特征是通过树形结构来表示分类条件和分类结果。

这些模型都有各自的优缺点,我们需要根据具体情况选择合适的模型。

然后,让我们来谈谈文本分类分析的应用。

文本分类分析的应用非常广泛,如情感分析、垃圾邮件过滤、新闻归纳、主题分析和文本挖掘等。

情感分析是一种分类方法,主要用于分析文本中的情感色彩。

例如,我们可以使用情感分析来分析电影评论中的情感,从而预测观众的反应。

垃圾邮件过滤是另一个重要的应用,可以帮助我们过滤掉垃圾邮件并保护我们的邮箱安全。

最近,COVID-19 疫情的爆发导致新闻报道爆发,利用文本分类技术可以将新闻分类,以便公众更快地了解疫情和疫情相关的政策。

融合词语类别特征和语义的短文本分类方法

融合词语类别特征和语义的短文本分类方法马慧芳;周汝南;吉余岗;鲁小勇【期刊名称】《计算机工程与科学》【年(卷),期】2017(039)002【摘要】Classification of short texts is challenging due to their typical characteristics of severe sparseness and high dimension.We propose a novel approach to classify short texts by combining both lexical and semantic features.To construct the term dictionary,we firstly select lexical features of the most distinctive words of a certain category,and then extract the optimal topic distribution from the background knowledge repository based on the Latent Dirichlet Allocation so as to construct the new features of short texts.Experiments on classifying Sohu news titles which are typical short texts via SVM and K-NN show that our method can greatly improve the classification results.%针对短文本内容简短、特征稀疏等特点,提出一种新的融合词语类别特征和语义的短文本分类方法.该方法采用改进的特征选择方法从短文本中选择最能代表类别特征的词语构造特征词典,同时结合利用隐含狄利克雷分布LDA主题模型从背景知识中选择最优主题形成新的短文本特征,在此基础上建立分类器进行分类.采用支持向量机SVM与k近邻法k-NN分类器对搜狗语料库数据集上的搜狐新闻标题内容进行分类,实验结果表明该方法对提高短文本分类的性能是有效的.【总页数】6页(P399-404)【作者】马慧芳;周汝南;吉余岗;鲁小勇【作者单位】西北师范大学计算机科学与工程学院,甘肃兰州730070;西北师范大学计算机科学与工程学院,甘肃兰州730070;西北师范大学计算机科学与工程学院,甘肃兰州730070;西北师范大学计算机科学与工程学院,甘肃兰州730070【正文语种】中文【中图分类】TP391【相关文献】1.基于卡方特征和 BTM 融合的短文本分类方法 [J], 李振兴;王松2.结合语义扩展和卷积神经网络的中文短文本分类方法 [J], 卢玲;杨武;杨有俊;陈梦晗3.融合词语共现距离和类别信息的短文本特征提取方法 [J], 马慧芳;邢玉莹;王双;张旭鹏4.融合词语统计特征和语义信息的文本分类方法研究 [J], 张丽;马静5.一种融合语义知识和BiLSTM-CNN的短文本分类方法 [J], 杨秀璋;李晓峰;袁杰;李坤琪;杨鑫;罗子江因版权原因,仅展示原文概要,查看原文内容请购买。

文本分类方法对比研究

维普资讯

第 6 卷

第 4 期

太 原 师 范 学 院 学 报 ( 自然 科 学 版 )

J OURNAL OF TAI YUAN NORM Al UNI VERS TY ( t r l ce c iin I Nau a in eEdt ) S o

的特 征词 表示 , d一 ( 即 甜 ”, 一, ) m是 d的特 征词个 数 l W 是第 J W W , l d , 个特 征词 . 根据 贝 叶斯定 理 ,

C 类 的后 验概 率为 P( ) Cl

, 一 () 1

因为 P( 对 于所 有类均 为 常数 , ) 朴素 贝 叶斯 分类 器将 未 知样本 归 于类 的依据 , 如下 P( 。 Cl )一 ma { l ) C ) , x P( P( ,}J一 1 2 … , C, ,, k 词, 由特 征独立 性假 设 , 得 则 () 2

文档 d由其包 含 的特征 词表示 , d一 ( 一 W ”, ) m是 d的特征 词个 数 I W, 即 甜 , W , dI 是 第 个特 征 ,

户 C) ( 2 W ) ,一 I 户甜 l ) ( l,一户 甜 , , l ) W …, C I(, C

,一 1

() 3

器, 然后 用训 练好 的分类 器对 未标 识 类别 的文 本 进行 分类 为 分 文 也

类器 ) 并 以此 判 断 样 本所 属 的 类 别空 间. , 目前 , 本分 类 的方 法 有 Naz eB y sKNN、 L F、 o s n 文 a e、 L S B ot g、 i S VM 及 最大 熵算 法 等 . 本文 仅 介绍 贝 叶斯方 法 、 KNN 方 法和 支持 向量 机 方 法等 三 种常 用 的分 类 方法 , 并在 3 0篇语 料 上进行 了对 比实 验 , 0 结果 表明支 持 向量机 是进 行文 本分 类较好 的方法.

基于LSTM-Attention与CNN混合模型的文本分类方法

中文文本自动分类中的关键问题研究共3篇

中文文本自动分类中的关键问题研究共3篇中文文本自动分类中的关键问题研究1随着互联网技术的不断发展,人们产生的文本信息数量也在爆炸式增长,而如何对这些文本信息进行分类和归类成为了迫切需要解决的问题。

中文文本自动分类技术就是专门应对这个问题而开发的一种人工智能技术,它可以根据文本的内容和结构特征,将文本自动归类到相应的类别中。

但是,中文文本自动分类面临的关键问题也同样不容忽视。

本文就来探讨一下中文文本自动分类中的关键问题。

首先,中文文本自动分类的数据预处理阶段是非常重要的。

数据预处理的任务是将原始文本转换成计算机可识别的数值向量,这是文本自动分类的前提条件。

在这个过程中,需解决的问题包括:文本清洗(去除无意义的符号、标点和停词等),文本标准化(将所有文本转为小写字母),特征提取(将文本转化为向量)。

在处理中文文本时,还需要面对词语歧义、词汇量大、自然语言表达方式多样等问题,如何解决这些问题,是完成中文文本自动分类的基础。

其次,分类算法选择是中文文本自动分类的重要一环。

当前,主流的分类算法包括:贝叶斯分类、支持向量机(SVM)、决策树、神经网络等。

每种分类算法都有其适用的情境和优缺点,如何选择最适合的分类算法,需要考虑相关的先验知识和实际应用需求。

此外,算法的参数选择也是一个关键的问题,不同参数的组合对结果有很大的影响,如何确定最优参数,需要通过实验和对比来确定。

第三,负样本的不均衡是中文文本自动分类中常见的问题。

负样本在总体样本中占比较大,这是由于如果所有文本都被标签过,那么要标注的文本数量将会增加。

类别不平衡会影响分类器的性能,使得分类器倾向于将文本归类成比较多的类别,而忽略稀少的类别,这就会导致低召回率现象。

在解决不平衡问题时,可以采用样本平衡技术对样本进行重采样,也可以对分类器进行改进。

第四,语料库的质量是中文文本分类的关键之一。

构建一个高质量的语料库,可以有效提高中文文本自动分类的性能。

语料库中需要包含充分的、具有代表性的数据,这样才能充分反映各类文本的特征。