信息论与编码第二章课后答案

信息论编码与基础课后题(第二章)

第二章习题解答2-1、试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍? 解:四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3}八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则:四进制脉冲的平均信息量symbol bit n X H / 24log log )(1=== 八进制脉冲的平均信息量symbol bit n X H / 38log log )(2=== 二进制脉冲的平均信息量symbol bit n X H / 12log log )(0===所以:四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。

2、 设某班学生在一次考试中获优(A )、良(B )、中(C )、及格(D )和不及格(E )的人数相等。

当教师通知某甲:“你没有不及格”,甲获得了多少比特信息?为确定自己的成绩,甲还需要多少信息? 解:根据题意,“没有不及格”或“pass”的概率为54511pass =-=P 因此当教师通知某甲“没有不及格”后,甲获得信息在已知“pass”后,成绩为“优”(A ),“良”(B ),“中”(C )和“及格”(D ) 的概率相同:41score )pass |()pass |()pass |()pass |(=====D P C P B P A P P 为确定自己的成绩,甲还需信息bits 241loglog score score =-=-=P I 3、中国国家标准局所规定的二级汉字共6763个。

设每字使用的频度相等,求一个汉字所含的信息量。

设每个汉字用一个1616⨯的二元点阵显示,试计算显示方阵所能表示的最大信息。

显示方阵的利用率是多少?解:由于每个汉字的使用频度相同,它们有相同的出现概率,即67631=P 因此每个汉字所含的信息量为bits 7.1267631loglog =-=-=P I 字每个显示方阵能显示256161622=⨯种不同的状态,等概分布时信息墒最大,所以一个显示方阵所能显示的最大信息量是bits322.054log log passpass =-=-=P Ibits 25621loglog =-=-=P I 阵显示方阵的利用率或显示效率为0497.02567.12===阵字I I η 4、两个信源1S 和2S 均有两种输出:1 ,0=X 和1 ,0=Y ,概率分别为2/110==X X P P ,4/10=Y P ,4/31=Y P 。

信息论编码与基础课后题(第二章)

第二章习题解答2-1、试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍? 解:四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3} 八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则:四进制脉冲的平均信息量symbol bit n X H / 24log log )(1=== 八进制脉冲的平均信息量symbol bit n X H / 38log log )(2=== 二进制脉冲的平均信息量symbol bit n X H / 12log log )(0===所以:四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。

2、 设某班学生在一次考试中获优(A )、良(B )、中(C )、及格(D )和不及格(E )的人数相等。

当教师通知某甲:“你没有不及格”,甲获得了多少比特信息?为确定自己的成绩,甲还需要多少信息? 解:根据题意,“没有不及格”或“pass”的概率为54511pass =-=P 因此当教师通知某甲“没有不及格”后,甲获得信息在已知“pass”后,成绩为“优”(A ),“良”(B ),“中”(C )和“及格”(D ) 的概率相同:41score )pass |()pass |()pass |()pass |(=====D P C P B P A P P 为确定自己的成绩,甲还需信息bits 241loglog score score =-=-=P I 3、中国国家标准局所规定的二级汉字共6763个。

设每字使用的频度相等,求一个汉字所含的信息量。

设每个汉字用一个1616⨯的二元点阵显示,试计算显示方阵所能表示的最大信息。

显示方阵的利用率是多少?解:由于每个汉字的使用频度相同,它们有相同的出现概率,即67631=P 因此每个汉字所含的信息量为bits 7.1267631loglog =-=-=P I 字每个显示方阵能显示256161622=⨯种不同的状态,等概分布时信息墒最大,所以一个显示方阵所能显示的最大信息量是bits 322.054loglog passpass =-=-=P Ibits 25621loglog 256=-=-=P I 阵显示方阵的利用率或显示效率为0497.02567.12===阵字I I η 4、两个信源1S 和2S 均有两种输出:1 ,0=X 和1 ,0=Y ,概率分别为2/110==X X P P ,4/10=Y P ,4/31=Y P 。

最新信息论与编码习题参考答案

第二章习题参考答案2-1解:同时掷两个正常的骰子,这两个事件是相互独立的,所以两骰子面朝上点数的状态共有6×6=36种,其中任一状态的分布都是等概的,出现的概率为1/36。

(1)设“3和5同时出现”为事件A ,则A 的发生有两种情况:甲3乙5,甲5乙3。

因此事件A 发生的概率为p(A)=(1/36)*2=1/18 故事件A 的自信息量为I(A)=-log 2p(A)=log 218=4.17 bit(2)设“两个1同时出现”为事件B ,则B 的发生只有一种情况:甲1乙1。

因此事件B 发生的概率为p(B)=1/36 故事件B 的自信息量为I(B)=-log 2p(B)=log 236=5.17 bit (3) 两个点数的排列如下:因为各种组合无序,所以共有21种组合: 其中11,22,33,44,55,66的概率是3616161=⨯其他15个组合的概率是18161612=⨯⨯ symbol bit x p x p X H ii i / 337.4181log 18115361log 3616)(log )()(=⎪⎭⎫ ⎝⎛⨯+⨯-=-=∑(4) 参考上面的两个点数的排列,可以得出两个点数求和的概率分布:symbolbit x p x p X H X P X ii i / 274.3 61log 61365log 365291log 912121log 1212181log 1812361log 3612 )(log )()(36112181111211091936586173656915121418133612)(=⎪⎭⎫ ⎝⎛+⨯+⨯+⨯+⨯+⨯-=-=⎪⎭⎪⎬⎫⎪⎩⎪⎨⎧=⎥⎦⎤⎢⎣⎡∑(5)“两个点数中至少有一个是1”的组合数共有11种。

bit x p x I x p i i i 710.13611log)(log )(3611116161)(=-=-==⨯⨯=2-2解:(1)红色球x 1和白色球x 2的概率分布为⎥⎥⎦⎤⎢⎢⎣⎡=⎥⎦⎤⎢⎣⎡2121)(21x x x p X i 比特 12log *21*2)(log )()(2212==-=∑=i i i x p x p X H(2)红色球x 1和白色球x 2的概率分布为⎥⎥⎦⎤⎢⎢⎣⎡=⎥⎦⎤⎢⎣⎡100110099)(21x x x p X i 比特 08.0100log *100199100log *10099)(log )()(22212=+=-=∑=i i i x p x p X H (3)四种球的概率分布为⎥⎥⎦⎤⎢⎢⎣⎡=⎥⎦⎤⎢⎣⎡41414141)(4321x x x x x p X i ,42211()()log ()4**log 4 2 4i i i H X p x p x ==-==∑比特 2-5解:骰子一共有六面,某一骰子扔得某一点数面朝上的概率是相等的,均为1/6。

信息论与编码理论课后答案

信息论与编码理论课后答案【篇一:《信息论与编码》课后习题答案】式、含义和效用三个方面的因素。

2、 1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

3、按照信息的性质,可以把信息分成语法信息、语义信息和语用信息。

4、按照信息的地位,可以把信息分成客观信息和主观信息。

5、人们研究信息论的目的是为了高效、可靠、安全地交换和利用各种各样的信息。

6、信息的是建立信息论的基础。

7、8、是香农信息论最基本最重要的概念。

9、事物的不确定度是用时间统计发生概率的对数来描述的。

10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用随机矢量描述。

11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为其发生概率对数的负值。

12、自信息量的单位一般有比特、奈特和哈特。

13、必然事件的自信息是。

14、不可能事件的自信息量是15、两个相互独立的随机变量的联合自信息量等于两个自信息量之和。

16、数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量趋于变小。

17、离散平稳无记忆信源x的n次扩展信源的熵等于离散信源x的熵的。

limh(xn/x1x2?xn?1)h?n???18、离散平稳有记忆信源的极限熵,。

19、对于n元m阶马尔可夫信源,其状态空间共有m个不同的状态。

20、一维连续随即变量x在[a,b] 。

1log22?ep21、平均功率为p的高斯分布的连续信源,其信源熵,hc(x)=2。

22、对于限峰值功率的n维连续信源,当概率密度均匀分布时连续信源熵具有最大值。

23、对于限平均功率的一维连续信源,当概率密度24、对于均值为0,平均功率受限的连续信源,信源的冗余度决定于平均功率的限定值p和信源的熵功率p25、若一离散无记忆信源的信源熵h(x)等于2.5,对信源进行等长的无失真二进制编码,则编码长度至少为。

2728、同时掷两个正常的骰子,各面呈现的概率都为1/6,则“3和5同时出现”这件事的自信息量是 ?mn?ki?11?mp(x)?em29、若一维随即变量x的取值区间是[0,∞],其概率密度函数为,其中:x?0,m是x的数学2期望,则x的信源熵c。

(完整版)信息论与编码-曹雪虹-课后习题答案

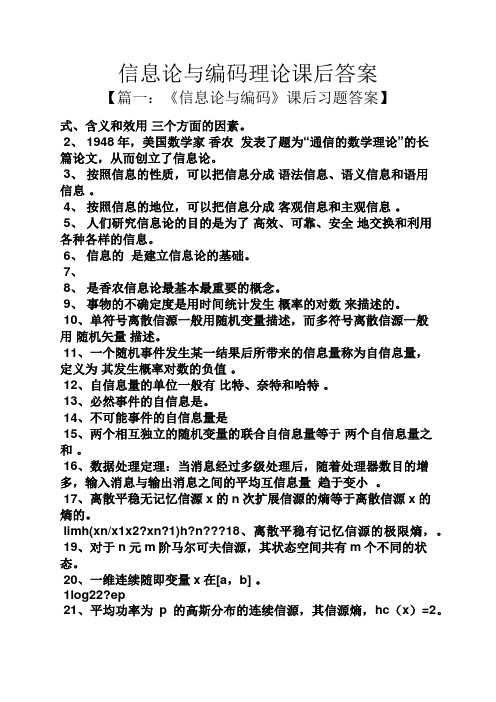

《信息论与编码》-曹雪虹-课后习题答案 第二章2.1一个马尔可夫信源有3个符号{}1,23,u u u ,转移概率为:()11|1/2p u u =,()21|1/2p uu =,()31|0p u u =,()12|1/3p u u =,()22|0p u u =,()32|2/3p u u =,()13|1/3p u u =,()23|2/3p u u =,()33|0p u u =,画出状态图并求出各符号稳态概率。

解:状态图如下状态转移矩阵为:1/21/201/302/31/32/30p ⎛⎫ ⎪= ⎪ ⎪⎝⎭设状态u 1,u 2,u 3稳定后的概率分别为W 1,W 2、W 3由1231WP W W W W =⎧⎨++=⎩得1231132231231112331223231W W W W W W W W W W W W ⎧++=⎪⎪⎪+=⎪⎨⎪=⎪⎪⎪++=⎩计算可得1231025925625W W W ⎧=⎪⎪⎪=⎨⎪⎪=⎪⎩2.2 由符号集{0,1}组成的二阶马尔可夫链,其转移概率为:(0|00)p =0.8,(0|11)p =0.2,(1|00)p =0.2,(1|11)p =0.8,(0|01)p =0.5,(0|10)p =0.5,(1|01)p =0.5,(1|10)p =0.5。

画出状态图,并计算各状态的稳态概率。

解:(0|00)(00|00)0.8p p == (0|01)(10|01)0.5p p ==(0|11)(10|11)0.2p p == (0|10)(00|10)0.5p p == (1|00)(01|00)0.2p p == (1|01)(11|01)0.5p p == (1|11)(11|11)0.8p p == (1|10)(01|10)0.5p p ==于是可以列出转移概率矩阵:0.80.200000.50.50.50.500000.20.8p ⎛⎫ ⎪⎪= ⎪ ⎪⎝⎭状态图为:设各状态00,01,10,11的稳态分布概率为W 1,W 2,W 3,W 4 有411i i WP W W ==⎧⎪⎨=⎪⎩∑ 得 13113224324412340.80.50.20.50.50.20.50.81W W W W W W W W W W W W W W W W +=⎧⎪+=⎪⎪+=⎨⎪+=⎪+++=⎪⎩ 计算得到12345141717514W W W W ⎧=⎪⎪⎪=⎪⎨⎪=⎪⎪⎪=⎩2.3 同时掷出两个正常的骰子,也就是各面呈现的概率都为1/6,求:(1) “3和5同时出现”这事件的自信息; (2) “两个1同时出现”这事件的自信息; (3) 两个点数的各种组合(无序)对的熵和平均信息量;(4) 两个点数之和(即2, 3, … , 12构成的子集)的熵;(5) 两个点数中至少有一个是1的自信息量。

信息论和编码理论第二章习题集答案解析(王育民)

部分答案,仅供参考。

2.1信息速率是指平均每秒传输的信息量点和划出现的信息量分别为3log ,23log ,一秒钟点和划出现的次数平均为415314.0322.01=⨯+⨯一秒钟点和划分别出现的次数平均为45.410那么根据两者出现的次数,可以计算一秒钟其信息量平均为253log 4153log 4523log 410-=+2.3 解:(a)骰子A 和B ,掷出7点有以下6种可能:A=1,B=6; A=2,B=5; A=3,B=4; A=4,B=3; A=5,B=2; A=6,B=1 概率为6/36=1/6,所以信息量-log(1/6)=1+log3≈2.58 bit(b) 骰子A 和B ,掷出12点只有1种可能: A=6,B=6概率为1/36,所以信息量-log(1/36)=2+log9≈5.17 bit 2.5解:出现各点数的概率和信息量:1点:1/21,log21≈4.39 bit ; 2点:2/21,log21-1≈3.39 bit ; 3点:1/7,log7≈2.81bit ; 4点:4/21,log21-2≈2.39bit ; 5点:5/21,log (21/5)≈2.07bit ; 6点:2/7,log(7/2)≈1.81bit平均信息量:(1/21)×4.39+(2/21)×3.39+(1/7)×2.81+(4/21)×2.39+(5/21)×2.07+(2/7)×1.81≈2.4bit 2.7解:X=1:考生被录取; X=0:考生未被录取; Y=1:考生来自本市;Y=0:考生来自外地; Z=1: 考生学过英语;Z=0:考生未学过英语P(X=1)=1/4, P(X=0)=3/4; P(Y=1/ X=1)=1/2; P(Y=1/ X=0)=1/10; P(Z=1/ Y=1)=1, P(Z=1 / X=0, Y=0)=0.4, P(Z=1/ X=1, Y=0)=0.4, P(Z=1/Y=0)=0.4 (a) P(X=0,Y=1)=P(Y=1/X=0)P(X=0)=0.075, P(X=1,Y=1)= P(Y=1/X=1)P(X=1)=0.125P(Y=1)= P(X=0,Y=1)+ P(X=1,Y=1)=0.2P(X=0/Y=1)=P(X=0,Y=1)/P(Y=1)=0.375, P(X=1/Y=1)=P(X=1,Y=1)/P(Y=1)=0.625I (X ;Y=1)=∑∑=====xx)P()1Y /(P log)1Y /(P )1Y (I )1Y /(P x x x x;x=1)P(X )1Y /1X (P log)1Y /1X (P 0)P(X )1Y /0X (P log)1Y /0X (P =====+===== =0.375log(0.375/0.75)+0.625log(0.625/0.25)=(5/8)log5-1≈0.45bit (b) 由于P(Z=1/ Y=1)=1, 所以 P (Y=1,Z=1/X=1)= P (Y=1/X=1)=0.5 P (Y=1,Z=1/X=0)= P (Y=1/X=0)=0.1那么P (Z=1/X=1)= P (Z=1,Y=1/X=1)+ P (Z=1,Y=0/X=1)=0.5+ P (Z=1/Y=0,X=1)P (Y=0/X=1)=0.5+0.5*0.4=0.7P(Z=1/X=0)= P (Z=1,Y=1/X=0)+ P (Z=1,Y=0/X=0)=0.1+P(Z=1/Y=0,X=0)P(Y=0/X=0)=0.1+0.9*0.4=0.46P (Z=1,X=1)= P (Z=1/X=1)*P(X=1)=0.7*0.25=0.175P (Z=1,X=0)= P (Z=1/X=0)*P(X=0)= 0.46*0.75=0.345 P(Z=1) = P(Z=1,X=1)+ P(Z=1,X=0) = 0.52 P(X=0/Z=1)=0.345/0.52=69/104 P(X=1/Z=1)=35/104I (X ;Z=1)=∑∑=====x x )P()1Z /(P log )1Z /(P )1Z (I )1Z /(P x x x x;x=1)P(X )1Z /1X (P log )1Z /1X (P 0)P(X )1Z /0X (P log )1Z /0X (P =====+======(69/104)log(23/26)+( 35/104)log(35/26) ≈0.027bit(c)H (X )=0.25*log(1/0.25)+0.75*log(1/0.75)=2-(3/4)log3=0.811bit H(Y/X)=-P(X=1,Y=1)logP(Y=1/X=1) -P(X=1,Y=0)logP(Y=0/X=1)-P(X=0,Y=1)logP(Y=1/X=0) -P(X=0,Y=0)logP(Y=0/X=0)=-0.125*log0.5-0.125*log0.5-0.075*log0.1-0.675*log0.9=1/4+(3/40)log10-(27/40)log(9/10)≈0.603bitH(XY)=H(X)+H(Y/X)=9/4+(3/4)log10-(21/10)log3=1.414bitP(X=0,Y=0,Z=0)= P(Z=0 / X=0, Y=0)* P( X=0, Y=0)=(1-0.4)*(0.75-0.075)=0.405 P(X=0,Y=0,Z=1)= P(Z=1 / X=0, Y=0)* P( X=0, Y=0)=0.4*0.675=0.27 P(X=1,Y=0,Z=1)= P(Z=1/ X=1,Y=0)* P(X=1,Y=0)=0.4*(0.25-0.125)=0.05 P(X=1,Y=0,Z=0)= P(Z=0/ X=1,Y=0)* P(X=1,Y=0)=0.6*0.125=0.075 P(X=1,Y=1,Z=1)=P(X=1,Z=1)- P(X=1,Y=0,Z=1)=0.175-0.05=0.125 P(X=1,Y=1,Z=0)=0 P(X=0,Y=1,Z=0)=0P(X=0,Y=1,Z=1)= P(X=0,Z=1)- P(X=0,Y=0,Z=1)= 0.345-0.27=0.075H(XYZ)=-0.405*log0.405-0.27*log0.27-0.05*log0.05-0.075*log0.075-0.125*log0.125-0.07 5*log0.075=(113/100)+(31/20)log10-(129/50)log3=0.528+0.51+0.216+0.28+0.375+0.28=2.189 bitH(Z/XY)=H(XYZ)-H(XY)= -28/25+(4/5)log10-12/25log3 =0.775bit2.9 解:A,B,C分别表示三个筛子掷的点数。

信息论与编码的课程第二章作业答案

2.1一个马尔可夫信源有3个符号{}1,23,u u u ,转移概率为:()11|1/2p u u =,()21|1/2p u u =,()31|0p u u =,()12|1/3p u u =,()22|0p u u =,()32|2/3p u u =,()13|1/3p u u =,()23|2/3p u u =,()33|0p u u =,画出状态图并求出各符号稳态概率。

解:状态图如下状态转移矩阵为:1/21/201/302/31/32/30p ⎛⎫ ⎪= ⎪ ⎪⎝⎭设状态u 1,u 2,u 3稳定后的概率分别为W 1,W 2、W 3由1231WP W W W W =⎧⎨++=⎩得1231132231231112331223231W W W W W W W W W W W W ⎧++=⎪⎪⎪+=⎪⎨⎪=⎪⎪⎪++=⎩计算可得1231025925625W W W ⎧=⎪⎪⎪=⎨⎪⎪=⎪⎩2.2 由符号集{0,1}组成的二阶马尔可夫链,其转移概率为:(0|00)p =0.8,(0|11)p =0.2,(1|00)p =0.2,(1|11)p =0.8,(0|01)p =0.5,(0|10)p =0.5,(1|01)p =0.5,(1|10)p =0.5。

画出状态图,并计算各状态的稳态概率。

解:(0|00)(00|00)0.8p p == (0|01)(10|01)0.5p p == (0|11)(10|11)0.2p p == (0|10)(00|10)0.5p p == (1|00)(01|00)0.2p p == (1|01)(11|01)0.p p ==(1|11)(11|11)0.8p p == (1|10)(01|10)0.5p p ==于是可以列出转移概率矩阵:0.80.200000.50.50.50.500000.20.8p ⎛⎫ ⎪⎪= ⎪ ⎪⎝⎭状态图为:设各状态00,01,10,11的稳态分布概率为W 1,W 2,W 3,W 4 有411i i WP W W ==⎧⎪⎨=⎪⎩∑ 得 13113224324412340.80.50.20.50.50.20.50.81W W W W W W W W W W W W W W W W +=⎧⎪+=⎪⎪+=⎨⎪+=⎪+++=⎪⎩ 计算得到12345141717514W W W W ⎧=⎪⎪⎪=⎪⎨⎪=⎪⎪⎪=⎩2.7 设有一离散无记忆信源,其概率空间为123401233/81/41/41/8X x x x x P ====⎛⎫⎛⎫= ⎪ ⎪⎝⎭⎝⎭(1)求每个符号的自信息量(2)信源发出一消息符号序列为{202 120 130 213 001 203 210 110 321 010 021 032 011 223 210},求该序列的自信息量和平均每个符号携带的信息量解:122118()log log 1.415()3I x bit p x ===同理可以求得233()2,()2,()3I x bit I x bit I x bit ===因为信源无记忆,所以此消息序列的信息量就等于该序列中各个符号的信息量之和就有:123414()13()12()6()87.81I I x I x I x I x bit =+++=平均每个符号携带的信息量为87.811.9545=bit/符号2.11 有一个可以旋转的圆盘,盘面上被均匀的分成38份,用1,…,38的数字标示,其中有两份涂绿色,18份涂红色,18份涂黑色,圆盘停转后,盘面上的指针指向某一数字和颜色。

信息论与编码习题答案-曹雪虹

3-14

信源 符号 xi x1 x2 x3 x4 x5 x6 x7

符号概 率 pi 1/3 1/3 1/9 1/9 1/27 1/27 1/27 1/3 1/3 1/9 1/9 2/27 1/27 1/3 1/3 1/9 1/9 1/9

编码过程

编码 1/3 1/3 1/3 2/3 1/3 00 01 100 101 111 1100 1101

得p0p1p223当p0或p1时信源熵为0第三章无失真信源编码31321因为abcd四个字母每个字母用两个码每个码为05ms所以每个字母用10ms当信源等概率分布时信源熵为hxlog42平均信息传递速率为2信源熵为hx0198bitms198bitsbitms200bits33与上题相同351hu12log2?14log4?18log8?116log16?132log32?164log64?1128log128?1128log128?1984111111112481632641281282每个信源使用3个二进制符号出现0的次数为出现1的次数为p0p134相应的香农编码信源符号xix1x2x3x4x5x6x7x8符号概率pi12141811613216411281128累加概率pi00507508750938096909840992logpxi12345677码长ki12345677码字010110111011110111110111111011111110相应的费诺码信源符号概符号xi率pix1x2x3x4x5x6x7x812141811613216411281128111第一次分组0第二次分组0第三次分组0第四次分组0第五次分组011第六次分组01第七次分组01二元码0101101110111101111101111110111111105香农码和费诺码相同平均码长为编码效率为

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

信息论与编码第二章课后答案在信息科学领域中,信息论和编码是两个息息相关的概念。

信息论主要研究信息的传输和处理,包括信息的压缩、传输的准确性以及信息的安全性等方面。

而编码则是将信息进行转换和压缩的过程,常用的编码方式包括霍夫曼编码、香农-费诺编码等。

在《信息论与编码》这本书的第二章中,涉及了信息的熵、条件熵、熵的连锁法则等概念。

这些概念对于信息理解和编码实现有着重要的意义。

首先是信息的熵。

熵可以简单理解为信息的不确定性。

当信息的发生概率越大,它的熵就越小。

比如说,一枚硬币的正反面各有50%的概率,那么它的熵就是1bit。

而如果硬币只有正面,那么它的熵就是0bit,因为我们已经知道了结果,不再有任何不确定性。

其次是条件熵。

条件熵是在已知某些信息(即条件)的前提下,对信息的不确定性进行量化。

它的定义为已知条件下,信息的熵的期望值。

比如说,在猜词游戏中,我们手中已经有一些字母的信息,那么此时猜测单词的不确定性就会下降,条件熵也就会减少。

除了熵和条件熵之外,连锁法则也是信息理解和编码实现中的

重要概念。

连锁法则指的是一个信息在不同时刻被传输的情况下,熵的变化情况。

在信息传输的过程中,信息的熵可能会发生改变。

这是因为在传输过程中,可能会发生噪声或者数据重复等情况。

而连锁法则就是用来描述这种情况下信息熵的变化情况的。

最后,霍夫曼编码和香农-费诺编码是两种比较常用的编码方式。

霍夫曼编码是一种无损压缩编码方式,它可以将出现频率高的字

符用较短的二进制编码表示,出现频率较低的字符用较长的二进

制编码表示。

香农-费诺编码则是一种用于无失真信源编码的方法,可以把每个符号用尽可能短的二进制串来表示,使得平均码长最

小化。

总的来说,信息论和编码是信息科学中非常重要的两个概念。

通过对信息熵、条件熵、连锁法则等的探讨和了解,可以更好地

理解信息及其传输过程中的不确定性和数据处理的方法。

而霍夫

曼编码和香农-费诺编码则是实现数据压缩和传输的常用编码方式。