市场调查_数据分析工具一览表

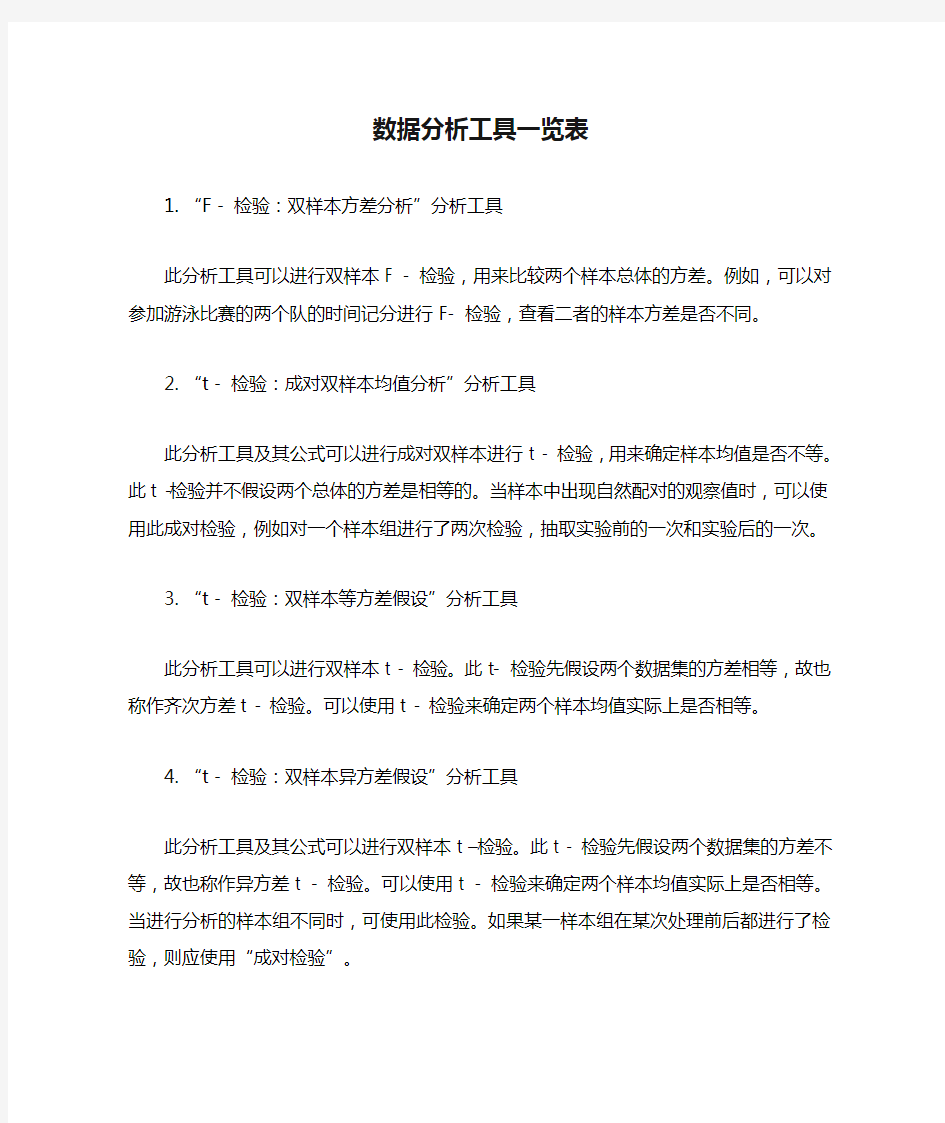

数据分析工具一览表

1.“F - 检验:双样本方差分析”分析工具

此分析工具可以进行双样本 F - 检验,用来比较两个样本总体的方差。例如,可以对参加游泳比赛的两个队的时间记分进行F- 检验,查看二者的样本方差是否不同。

2.“t - 检验:成对双样本均值分析”分析工具

此分析工具及其公式可以进行成对双样本进行t - 检验,用来确定样本均值是否不等。此t -检验并不假设两个总体的方差是相等的。当样本中出现自然配对的观察值时,可以使用此成对检验,例如对一个样本组进行了两次检验,抽取实验前的一次和实验后的一次。3.“t - 检验:双样本等方差假设”分析工具

此分析工具可以进行双样本t - 检验。此t- 检验先假设两个数据集的方差相等,故也称作齐次方差t - 检验。可以使用t - 检验来确定两个样本均值实际上是否相等。

4.“t - 检验:双样本异方差假设”分析工具

此分析工具及其公式可以进行双样本t –检验。此t - 检验先假设两个数据集的方差不等,故也称作异方差t - 检验。可以使用t - 检验来确定两个样本均值实际上是否相等。当进行分析的样本组不同时,可使用此检验。如果某一样本组在某次处理前后都进行了检验,则应使用“成对检验”。

5.“z - 检验:双样本均值分析”分析工具

此分析工具可以进行方差已知的双样本均值z-检验。此工具用于检验两个总体均值之间存在差异的假设。例如,可以使用此检验来确定两种汽车模型性能之间的差异情况。

6.“抽样分析”分析工具

此分析工具以输入区域为总体构造总体的一个样本。当总体太大而不能进行处理或绘制时,可以选用具有代表性的样本。如果确认输入区域中的数据是周期性的,还可以对一个周期中特定时间段中的数值进行采样。例如,如果输入区域包含季度销售量数据,以四为周期进行取样,将在输出区域中生成某个季度的样本。

7.“傅立叶分析”分析工具

此分析工具可以解决线性系统问题,并能通过快速傅立叶变换(FFT)分析周期性的数据。此工具也支持逆变换,即通过对变换后的数据的逆变换返回初始数据。

8.“回归分析”分析工具

此工具通过对一组观察值使用“最小二乘法”直线拟合,进行线形回归分析。本工具可用来分析单个因变量是如何受一个或几个自变量影响的。例如,观察某个运动员的运动成绩与一系列统计因素的关系,如年龄、身高和体重等。在操作时,可以基于一组已知的体能统计数据,并辅以适当加权,对尚未进行过测试的运动员的表现作出预测。

9.“描述统计”分析工具

此分析工具用于生成对输入区域中数据的单变值分析,提供有关数据趋中性和易变性的信息。

10.“排位和百分比排位”分析工具

此分析工具可以产生一个数据列表,在其中罗列给定数据集中各个数值的大小次序排位和相应的百分比排位。用来分析数据集中各数值间的相互位置关系。

11.“ 随机数发生器”分析工具

此分析工具可以按照用户选定的分布类型,在工作表的特定区域中生成一系列独立随机数字。可以通过概率分布来表示主体的总体特征。例如,可以使用正态分布来表示人体身高的总体特征,或者使用双值输出的伯努利分布来表示掷币实验结果的总体特征。

12.“相关系数”分析工具

此分析工具及其公式可用于判断两组数据集(可以使用不同的度量单位)之间的关系。

可以使用“相关系数”分析工具来确定两个区域中数据的变化是否相关,即,一个集合的较大数据是否与另一个集合的较大数据相对应(正相关);或者一个集合的较小数据是否与另一个集合的较小数据相对应(负相关);还是两个集合中的数据互不相关(相关性为零)。13.“协方差”分析工具

此分析工具及其公式用于返回各数据点的一对均值偏差之间的乘积的平均值。协方差是测量两组数据相关性的量度。可以使用协方差工具来确定两个区域中数据的变化是否相关,即,一个集合的较大数据是否与另一个集合的较大数据相对应(正协方差);或者一个集合的较小数据是否与另一个集合的较小数据相对应(负协方差);还是两个集合中的数据互不相关(协方差为零)。

14.“移动平均”分析工具

此分析工具及其公式可以基于特定的过去某段时期中变量的均值,对未来值进行预测。移动平均值提供了由所有历史数据的简单的平均值所代表的趋势信息。使用此工具可以预测销售量、库存或其它趋势。

15.“直方图”分析工具

在给定工作表中数据单元格区域和接收区间的情况下,计算数据的个别和累积频率,用于统计有限集中某个数值元素的出现次数。例如,在一个有20名学生的班级里,可以确定以字母打分(如A、B-等)所得分数的分布情况。直方图表会给出字母得分的边界,以及在最低边界与当前边界之间某一得分出现的次数。出现频率最多的某个得分即为数据组中的众数。

16.“指数平滑”分析工具

此分析工具及其公式基于前期预测值导出相应的新预测值,并修正前期预测值的误差。此工具将使用平滑常数a,其大小决定了本次预测对前期预测误差的修正程度。

17.“Anova:单因素方差分析”分析工具

此分析工具通过简单的方差分析(anova),对两个以上样本均值进行相等性假设检验(抽样取自具有相同均值的样本空间)。此方法是对双均值检验(如t-检验)的扩充。

18.“Anova:可重复双因素分析”分析工具

此分析工具是对单因素anova 分析的扩展,即每一组数据包含不止一个样本。

19.“Anova:无重复双因素分析”分析工具

此分析工具通过双因素anova 分析(但每组数据只包含一个样本),对两个以上样本均值进行相等性假设检验(抽样取自具有相同均值的样本空间)。此方法是对双均值检验(如t-检验)的扩充。

大数据分析的六大工具介绍

大数据分析的六大工具介绍 2016年12月 一、概述 来自传感器、购买交易记录、网络日志等的大量数据,通常是万亿或EB的大小,如此庞大的数据,寻找一个合适处理工具非常必要,今天我们为大家分学在大数据处理分析过程中六大最好用的工具。 我们的数据来自各个方面,在面对庞大而复杂的大数据,选择一个合适的处理工具显得很有必要,工欲善其事,必须利其器,一个好的工具不仅可以使我们的工作事半功倍,也可以让我们在竞争日益激烈的云计算时代,挖掘大数据价值,及时调整战略方向。 大数据是一个含义广泛的术语,是指数据集,如此庞大而复杂的,他们需要专门设il?的硬件和软件工具进行处理。该数据集通常是万亿或EB的大小。这些数据集收集自各种各样的来源:传感器、气候信息、公开的信息、如杂志、报纸、文章。大数据产生的其他例子包括购买交易记录、网络日志、病历、事监控、视频和图像档案、及大型电子商务。大数据分析是在研究大量的数据的过程中寻找模式, 相关性和其他有用的信息,可以帮助企业更好地适应变化,并做出更明智的决策。 二.第一种工具:Hadoop Hadoop是一个能够对大量数据进行分布式处理的软件框架。但是Hadoop是 以一种可黑、高效、可伸缩的方式进行处理的。Hadoop是可靠的,因为它假设计算元素和存储会失败,因此它维护多个工作数据副本,确保能够针对失败的节点重新分布处理。Hadoop 是高效的,因为它以并行的方式工作,通过并行处理加快处理速度。Hadoop还是可伸缩的,能够处理PB级数据。此外,Hadoop依赖于社区服务器,因此它的成本比较低,任何人都可以使用。

Hadoop是一个能够让用户轻松架构和使用的分布式计算平台。用户可以轻松地 在Hadoop上开发和运行处理海量数据的应用程序。它主要有以下儿个优点: ,高可黑性。Hadoop按位存储和处理数据的能力值得人们信赖。,高扩展性。Hadoop是 在可用的计?算机集簇间分配数据并完成讣算任务 的,这些集簇可以方便地扩展到数以千计的节点中。 ,高效性。Hadoop能够在节点之间动态地移动数据,并保证各个节点的动 态平衡,因此处理速度非常快。 ,高容错性。Hadoop能够自动保存数据的多个副本,并且能够自动将失败 的任务重新分配。 ,Hadoop带有用Java语言编写的框架,因此运行在Linux生产平台上是非 常理想的。Hadoop上的应用程序也可以使用其他语言编写,比如C++。 第二种工具:HPCC HPCC, High Performance Computing and Communications(高性能计?算与通信)的缩写° 1993年,山美国科学、工程、技术联邦协调理事会向国会提交了“重大挑战项 U:高性能计算与通信”的报告,也就是被称为HPCC计划的报告,即美国总统科学战略项U ,其U的是通过加强研究与开发解决一批重要的科学与技术挑战 问题。HPCC是美国实施信息高速公路而上实施的计?划,该计划的实施将耗资百亿 美元,其主要U标要达到:开发可扩展的计算系统及相关软件,以支持太位级网络 传输性能,开发千兆比特网络技术,扩展研究和教育机构及网络连接能力。

数据分析工具选择

数据存储 我们必须能够存储数据,对个人来讲至少应该掌握一种数据库技术,当然也不一定要熟练操作,但至少要能够理解数据的存储和数据的基本结构和数据类型,比如数据的安全性、唯一性、冗余性,表的关系,粒度,容量等,最好能够理解SQL查询语言的基本结构和读取等等! · Access2003、Access07等:这是最基本的个人数据库,经常用于个人或部分基本的数据存储; · MySQL数据库,这个对于部门级或者互联网的数据库应用是必要的,这个时候关键掌握数据库的库结构和SQL语言的数据查询能力; · SQL Server 2005或更高版本,对中小企业,一些大型企业也可以采用SQL Server数据库,其实这个时候本身除了数据存储,也包括了数据报表和数据分析了,甚至数据挖掘工具都在其中了; · DB2,Oracle数据库都是大型数据库了,主要是企业级,特别是大型企业或者对数据海量存储需求的就是必须的了,一般大型数据库公司都提供非常好的数据整合应用平台;· BI级,实际上这个不是数据库,而是建立在前面数据库基础上的,这个主要是数据库的企业应用级了,一般这个时候的数据库都叫数据仓库了,Data Warehouse,建立在DW级上的数据存储基本上都是商业智能平台,或许整合了各种数据分析,报表、分析和展现! 数据处理 数据挖掘与数据分析 这个层其实有很多分析工具,当然我们最常用的就是Excel,我经常用的就是统计分析和数据挖掘工具; · Excel软件,首先版本越高越好用这是肯定的;当然对Excel来讲很多人只是掌握了5%Excel功能,Excel功能非常强大,甚至可以完成所有的统计分析工作!但是我也常说,有能力把Excel玩成统计工具不如专门学会统计软件; · SPSS软件:当前版本是18,名字也改成了PASW Statistics;我从3.0开始Dos环境下编程分析,到现在版本的变迁也可以看出SPSS社会科学统计软件包的变化,从重视医学、化学等开始越来越重视商业分析,现在已经成为了预测分析软件。 · Clementine软件:当前版本13.0,数据挖掘工具,我从6.0开始用,到了13版,已经越来越多的提高了更多有好的建模工具,现在改名叫PASW Modeler 13建模器了。而且与SPSS统计功能有了更多的整合,数据处理也更加灵活和好用。 · SAS软件:SAS相对SPSS其实功能更强大,SAS是平台化的,EM挖掘模块平台整合,相对来讲,SAS比较难学些,但如果掌握了SAS会更有价值,比如离散选择模型,抽样问题,正交实验设计等还是SAS比较好用,另外,SAS的学习材料比较多,也公开,会有收获的!

常用数据分析方法详细讲解

常用数据分析方法详解 目录 1、历史分析法 2、全店框架分析法 3、价格带分析法 4、三维分析法 5、增长率分析法 6、销售预测方法 1、历史分析法的概念及分类 历史分析法指将与分析期间相对应的历史同期或上期数据进行收集并对比,目的是通过数据的共性查找目前问题并确定将来变化的趋势。 *同期比较法:月度比较、季度比较、年度比较 *上期比较法:时段比较、日别对比、周间比较、 月度比较、季度比较、年度比较 历史分析法的指标 *指标名称: 销售数量、销售额、销售毛利、毛利率、贡献度、交叉比率、销售占比、客单价、客流量、经营品数动销率、无销售单品数、库存数量、库存金额、人效、坪效 *指标分类: 时间分类 ——时段、单日、周间、月度、季度、年度、任意 多个时段期间 性质分类 ——大类、中类、小类、单品 图例 2框架分析法 又叫全店诊断分析法 销量排序后,如出现50/50、40/60等情况,就是什么都能卖一点但什么都不 好卖的状况,这个时候就要对品类设置进行增加或删减,因为你的门店缺少 重点,缺少吸引顾客的东西。 如果达到10/90,也是品类出了问题。 如果是20/80或30/70、30/80,则需要改变的是商品的单品。 *单品ABC分析(PSI值的概念) 销售额权重(0.4)×单品销售额占类别比+销售数量权重(0.3) × 单品销售数量占类别比+毛利额权重(0.3)单品毛利额占类别比 *类别占比分析(大类、中类、小类) 类别销售额占比、类别毛利额占比、 类别库存数量占比、类别库存金额占比、

类别来客数占比、类别货架列占比 表格例 3价格带及销售二维分析法 首先对分析的商品按价格由低到高进行排序,然后 *指标类型:单品价格、销售额、销售数量、毛利额 *价格带曲线分布图 *价格带与销售对数图 价格带及销售数据表格 价格带分析法 4商品结构三维分析法 *一种分析商品结构是否健康、平衡的方法叫做三维分析图。在三维空间坐标上以X、Y、Z 三个坐标轴分别表示品类销售占有率、销售成长率及利润率,每个坐标又分为高、低两段,这样就得到了8种可能的位置。 *如果卖场大多数商品处于1、2、3、4的位置上,就可以认为商品结构已经达到最佳状态。以为任何一个商品的品类销售占比率、销售成长率及利润率随着其商品生命周期的变化都会有一个由低到高又转低的过程,不可能要求所有的商品同时达到最好的状态,即使达到也不可能持久。因此卖场要求的商品结构必然包括:目前虽不能获利但具有发展潜力以后将成为销售主力的新商品、目前已经达到高占有率、高成长率及高利润率的商品、目前虽保持较高利润率但成长率、占有率趋于下降的维持性商品,以及已经决定淘汰、逐步收缩的衰退型商品。 *指标值高低的分界可以用平均值或者计划值。 图例 5商品周期增长率分析法 就是将一段时期的销售增长率与时间增长率的比值来判断商品所处生命周期阶段的方法。不同比值下商品所处的生命周期阶段(表示) 如何利用商品生命周期理论指导营运(图示) 6销售预测方法[/hide] 1.jpg (67.5 KB) 1、历史分析法

数据分析必备|你不得不知道的11款数据分析工具

数据分析必备|你不得不知道的11款数据分析工具 毋庸置疑,大数据市场是一座待挖掘的金矿。随着数据使用量的增长,将有更多的人通过数据来寻求专业问题的答案。可视化数据分析工具的出现让人们可以通过将数据可视化来探讨问题、揭示洞见,用数据分享故事。甚至于不懂挖掘算法的人员,也能够为用户进行画像。 BI(BusinessIntelligence)即商业智能,越来越多的智能软件供应商推出可视化数据分析工具,应对企业业务人员的大数据分析需求。然而如果你觉得不是数据分析专业、没有挖掘算法基础就无法使用BI工具?NO,自助式分析工具已经让数据产品链条变得大众化,。为了更好地帮助读者选择分析工具,本文将为介绍数说立方、数据观、魔镜等11款BI-商业智能产品,排名不分先后! 功能列表

详细介绍 数说立方 数说立方是数说故事新推出的一款面向数据分析师的在线商业智能产品。最重要的特点是配备百亿级社交数据库,同时支持全网公开数据实时抓取,从数据源端解决分析师难点;另外数说立方搭载了分布式搜索、语义分析、数据可视化三大引擎系统的海量计算平台,实现数据处理“探索式 分析”和“秒级响应”的两个核心功能。同时数说立方是数说故事三大主打产品之一,并与其他两大产品数说聚合和数说雷达实现从数据源、数据分析、到数据展示完整的数据解决方案。 优点: 即便是个人免费版,体验和功能仍然非常好; 与自家产品“数说聚合”的无缝接入,支持定向抓取微信、微博等数据; 功能完善,集数据处理、特征工程、建模、文本挖掘为一体的机器学习平台; 可视化视图展现、友好的客户感知页面; 支持SAAS,私有化部署,有权限管理; 缺点: 产品新上市,操作指导页不太完善; 体验过程中有一些小bug;

数据分析软件和工具

以下是我在近三年做各类计量和统计分析过程中感受最深的东西,或能对大家有所帮助。当然,它不是ABC的教程,也不是细致的数据分析方法介绍,它只是“总结”和“体会”。由于我所学所做均甚杂,我也不是学统计、数学出身的,故本文没有主线,只有碎片,且文中内容仅为个人观点,许多论断没有数学证明,望统计、计量大牛轻拍。 于我个人而言,所用的数据分析软件包括EXCEL、SPSS、STATA、EVIEWS。在分析前期可以使用EXCEL进行数据清洗、数据结构调整、复杂的新变量计算(包括逻辑计算);在后期呈现美观的图表时,它的制图制表功能更是无可取代的利器;但需要说明的是,EXCEL毕竟只是办公软件,它的作用大多局限在对数据本身进行的操作,而非复杂的统计和计量分析,而且,当样本量达到“万”以上级别时,EXCEL的运行速度有时会让人抓狂。 SPSS是擅长于处理截面数据的傻瓜统计软件。首先,它是专业的统计软件,对“万”甚至“十万”样本量级别的数据集都能应付自如;其次,它是统计软件而非专业的计量软件,因此它的强项在于数据清洗、描述统计、假设检验(T、F、卡方、方差齐性、正态性、信效度等检验)、多元统计分析(因子、聚类、判别、偏相关等)和一些常用的计量分析(初、中级计量教科书里提到的计量分析基本都能实现),对于复杂的、前沿的计量分析无能为力;第三,SPSS主要用于分析截面数据,在时序和面板数据处理方面功能了了;最后,SPSS兼容菜单化和编程化操作,是名副其实的傻瓜软件。 STATA与EVIEWS都是我偏好的计量软件。前者完全编程化操作,后者兼容菜单化和编程化操作;虽然两款软件都能做简单的描述统计,但是较之 SPSS差了许多;STATA与EVIEWS都是计量软件,高级的计量分析能够在这两个软件里得到实现;STATA的扩展性较好,我们可以上网找自己需要的命令文件(.ado文件),不断扩展其应用,但EVIEWS 就只能等着软件升级了;另外,对于时序数据的处理,EVIEWS较强。 综上,各款软件有自己的强项和弱项,用什么软件取决于数据本身的属性及分析方法。EXCEL适用于处理小样本数据,SPSS、 STATA、EVIEWS可以处理较大的样本;EXCEL、SPSS适合做数据清洗、新变量计算等分析前准备性工作,而STATA、EVIEWS在这方面较差;制图制表用EXCEL;对截面数据进行统计分析用SPSS,简单的计量分析SPSS、STATA、EVIEWS可以实现,高级的计量分析用 STATA、EVIEWS,时序分析用EVIEWS。 关于因果性 做统计或计量,我认为最难也最头疼的就是进行因果性判断。假如你有A、B两个变量的数据,你怎么知道哪个变量是因(自变量),哪个变量是果(因变量)? 早期,人们通过观察原因和结果之间的表面联系进行因果推论,比如恒常会合、时间顺序。但是,人们渐渐认识到多次的共同出现和共同缺失可能是因果关系,也可能是由共同的原因或其他因素造成的。从归纳法的角度来说,如果在有A的情形下出现B,没有A的情形下就没有B,那么A很可能是B的原因,但也可能是其他未能预料到的因素在起作用,所以,在进行因果判断时应对大量的事例进行比较,以便提高判断的可靠性。 有两种解决因果问题的方案:统计的解决方案和科学的解决方案。统计的解决方案主要指运用统计和计量回归的方法对微观数据进行分析,比较受干预样本与未接受干预样本在效果指标(因变量)上的差异。需要强调的是,利用截面数据进行统计分析,不论是进行均值比较、频数分析,还是方差分析、相关分析,其结果只是干预与影响效果之间因果关系成立的必要条件而非充分条件。类似的,利用截面数据进行计量回归,所能得到的最多也只是变量间的数量关系;计量模型中哪个变量为因变量哪个变量为自变量,完全出于分析者根据其他考虑进行的预设,与计量分析结果没有关系。总之,回归并不意味着因果关系的成立,因果关系的判定或推断必须依据经过实践检验的相关理论。虽然利用截面数据进行因果判断显得勉强,但如果研究者掌握了时间序列数据,因果判断仍有可为,其

(完整版)常用数据分析方法论

常用数据分析方法论 ——摘自《谁说菜鸟不会数据分析》 数据分析方法论主要用来指导数据分析师进行一次完整的数据分析,它更多的是指数据分析思路,比如主要从哪几方面开展数据分析?各方面包含什么内容和指标? 数据分析方法论主要有以下几个作用: ●理顺分析思路,确保数据分析结构体系化 ●把问题分解成相关联的部分,并显示它们之间的关系 ●为后续数据分析的开展指引方向 ●确保分析结果的有效性及正确性 常用的数据分析理论模型 用户使用行为STP理论 SWOT …… 5W2H 时间管理生命周期 逻辑树 金字塔SMART原则 …… PEST分析法 PEST分析理论主要用于行业分析 PEST分析法用于对宏观环境的分析。宏观环境又称一般环境,是指影响一切行业和企业的各种宏观力量。 对宏观环境因素作分析时,由于不同行业和企业有其自身特点和经营需要,分析的具体内容会有差异,但一般都应对政治、经济、技术、社会,这四大类影响企业的主要外部环境因素进行分析。

以下以中国互联网行业分析为例。此处仅为方法是用实力,并不代表互联网行业分析只需要作这几方面的分析,还可根据实际情况进一步调整和细化相关分析指标:

5W2H分析法 5W2H分析理论的用途广泛,可用于用户行为分析、业务问题专题分析等。 利用5W2H分析法列出对用户购买行为的分析:(这里的例子并不代表用户购买行为只有以下所示,要做到具体问题具体分析)

逻辑树分析法 逻辑树分析理论课用于业务问题专题分析 逻辑树又称问题树、演绎树或分解树等。逻辑树是分析问题最常使用的工具之一,它将问题的所有子问题分层罗列,从最高层开始,并逐步向下扩展。 把一个已知问题当成树干,然后开始考虑这个问题和哪些相关问题有关。 (缺点:逻辑树分析法涉及的相关问题可能有遗漏。)

数据挖掘工具应用及前景分析

数据挖掘工具应用及前景

介绍以下数据挖掘工具分别为: 1、 Intelligent Miner 2、 SAS Enterpreise Miner 3、SPSS Clementine 4、马克威分析系统 5、GDM Intelligent Miner 一、综述:IBM的Exterprise Miner简单易用,是理解数据挖掘的好的开始。能处理大数据量的挖掘,功能一般,可能仅满足要求.没有数据探索功能。与其他软件接口差,只能用DB2,连接DB2以外的数据库时,如Oracle, SAS, SPSS需要安装DataJoiner作为中间软件。难以发布。结果美观,但同样不好理解。 二、基本内容:一个挖掘项目可有多个发掘库组成;每个发掘库包含多个对象和函数对象: 数据:由函数使用的输入数据的名称和位置。 离散化:将记录分至明显可识别的组中的分发操作。 名称映射:映射至类别字段名的值的规范。 结果:由函数创建的结果的名称和位置。 分类:在一个项目的不同类别之间的关联层次或点阵。 值映射:映射至其它值的规范。 函数: 发掘:单个发掘函数的参数。 预处理:单个预处理函数的参数。 序列:可以在指定序列中启动的几个函数的规范。 统计:单个统计函数的参数。 统计方法和挖掘算法:单变量曲线,双变量统计,线性回归,因子分析,主变量分析,分类,分群,关联,相似序列,序列模式,预测等。 处理的数据类型:结构化数据(如:数据库表,数据库视图,平面文件) 和半结构化或非结构化数据(如:顾客信件,在线服务,传真,电子邮件,网页等) 。 架构:它采取客户/服务器(C/S)架构,并且它的API提供了C++类和方法 Intelligent Miner通过其独有的世界领先技术,例如自动生成典型数据集、发现关联、发现序列规律、概念性分类和可视化呈现,可以自动实现数据选择、数据转换、数据挖掘和结果呈现这一整套数据挖掘操作。若有必要,对结果数据集还可以重复这一过程,直至得到满意结果为止。 三、现状:现在,IBM的Intelligent Miner已形成系列,它帮助用户从企业数据资产中 识别和提炼有价值的信息。它包括分析软件工具——Intelligent Miner for Data和IBM Intelligent Miner forText ,帮助企业选取以前未知的、有效的、可行的业务知识——

数据分析过程中各个步骤中使用的工具

数据分析过程中各个步骤使用的工具 数据分析也好,也好,也好、商业智能也好,都需要在学习的时候掌握各种分析手段和技能,特别是要掌握分析软件工具!学习数据分析,一般是先学软件开始,再去应用,再学会理论和原理!没有软件的方法就不去学了,因为学了也不能做,除非你自己会编程序。 下图是一个顶级的分析工具场, 依次从X和Y轴看: 第一维度:数据存储层——>数据报表层——>数据分析层——>数据展现层

第二维度:用户级——>部门级——>企业级——>BI级 我结合上图和其他资料统计了我们可能用到的软件信息。具体的软件效果还需要进一步研究分析和实践。 1第一步:设计方案 可以考虑的软件工具:mind manager。 Mind manager(又叫),是表达发射性思维的有效的图形思维工具,它简单却又极其有效,是一种革命性的思维工具。思维导图运用图文并重的技巧,把各级主题的关系用相互隶属与相关的层级图表现出来,把主题关键词与图像、颜色等建立记忆链接。思维导图充分运用左右脑的机能,利用记忆、阅读、思维的规律,协助人们在与、与想象之间平衡发展,从而开启人类的无限潜能。思维导图因此具有人类思维的强大功能。 是一种将思考具体化的方法。我们知道思考是人类大脑的自然思考方式,每一种进入大脑的资料,不论是感觉、或是想法——包括、、符码、香气、食物、线条、颜色、意象、、音符等,都可以成为一个中心,并由此中心向外发散出成千上万的关节点,每一个关节点代表与中心的一个连结,而每一个连结又可以成为另一个中心主题,再向外发散出成千上万的关节点,呈现出放射性立体结构,而这些关节的连结可以视为您的,也就是您的个人。

常用统计软件介绍

常用统计软件介绍

常用统计软件介绍 《概率论与数理统计》是一门实践性很强的课程。但是,目前在国内,大多侧重基本方法的介绍,而忽视了统计实验的教学。这样既不利于提高学生创新精神和实践能力,也使得这门课程的教学显得枯燥无味。为此,我们介绍一些常用的统计软件,以使学生对统计软件有初步的认识,为以后应用统计方法解决实际问题奠定初步的基础。 一、统计软件的种类 1.SAS 是目前国际上最为流行的一种大型统计分析系统,被誉为统计分析的标准软件。尽管价格不菲,SAS已被广泛应用于政府行政管理,科研,教育,生产和金融等不同领域,并且发挥着愈来愈重要的作用。目前SAS已在全球100多个国家和地区拥有29000多个客户群,直接用户超过300万人。在我国,国家信息中心,国家统计局,卫生部,中国科学院等都是SAS系统的大用户。尽管现在已经尽量“傻瓜化”,但是仍然需要一定的训练才可以使用。因此,该统计软件主要适合于统计工作者和科研工作者使用。 2.SPSS SPSS作为仅次于SAS的统计软件工具包,在社会科学领域有着广泛的应用。SPSS是世界上最早的统计分析软件,由美国斯坦福大学的三位研究生于20世纪60年代末研制。由于SPSS容易操作,输出漂亮,功能齐全,价格合理,所以很快地应用于自然科学、技术科学、社会科学的各个领域,世界上许多有影响的报刊杂志纷纷就SPSS 的自动统计绘图、数据的深入分析、使用方便、功能齐全等方面给予了高度的评价与称赞。迄今SPSS软件已有30余年的成长历史。全球

约有25万家产品用户,它们分布于通讯、医疗、银行、证券、保险、制造、商业、市场研究、科研教育等多个领域和行业,是世界上应用最广泛的专业统计软件。在国际学术界有条不成文的规定,即在国际学术交流中,凡是用SPSS软件完成的计算和统计分析,可以不必说明算法,由此可见其影响之大和信誉之高。因此,对于非统计工作者是很好的选择。 3.Excel 它严格说来并不是统计软件,但作为数据表格软件,必然有一定统计计算功能。而且凡是有Microsoft Office的计算机,基本上都装有Excel。但要注意,有时在装 Office时没有装数据分析的功能,那就必须装了才行。当然,画图功能是都具备的。对于简单分析,Excel 还算方便,但随着问题的深入,Excel就不那么“傻瓜”,需要使用函数,甚至根本没有相应的方法了。多数专门一些的统计推断问题还需要其他专门的统计软件来处理。 4.S-plus 这是统计学家喜爱的软件。不仅由于其功能齐全,而且由于其强大的编程功能,使得研究人员可以编制自己的程序来实现自己的理论和方法。它也在进行“傻瓜化”,以争取顾客。但仍然以编程方便为顾客所青睐。 5.Minitab 这个软件是很方便的功能强大而又齐全的软件,也已经“傻瓜化”,在我国用的不如SPSS与SAS那么普遍。

大数据处理分析的六大最好工具

大数据处理分析的六大最好工具 来自传感器、购买交易记录、网络日志等的大量数据,通常是万亿或EB的大小,如此庞大的数据,寻找一个合适处理工具非常必要,今天我们为大家分享在大数据处理分析过程中六大最好用的工具。 【编者按】我们的数据来自各个方面,在面对庞大而复杂的大数据,选择一个合适的处理工具显得很有必要,工欲善其事,必须利其器,一个好的工具不仅可以使我们的工作事半功倍,也可以让我们在竞争日益激烈的云计算时代,挖掘大数据价值,及时调整战略方向。本文转载自中国大数据网。 CSDN推荐:欢迎免费订阅《Hadoop与大数据周刊》获取更多Hadoop技术文献、大数据技术分析、企业实战经验,生态圈发展趋势。 以下为原文: 大数据是一个含义广泛的术语,是指数据集,如此庞大而复杂的,他们需要专门设计的硬件和软件工具进行处理。该数据集通常是万亿或EB的大小。这些数据集收集自各种各样的来源:传感器、气候信息、公开的信息、如杂志、报纸、文章。大数据产生的其他例子包括购买交易记录、网络日志、病历、事监控、视频和图像档案、及大型电子商务。大数据分析是在研究大量的数据的过程中寻找模式,相关性和其他有用的信息,可以帮助企业更好地适应变化,并做出更明智的决策。 Hadoop Hadoop 是一个能够对大量数据进行分布式处理的软件框架。但是Hadoop 是以一种可靠、高效、可伸缩的方式进行处理的。Hadoop 是可靠的,因为它假设计算元素和存储会失败,因此它维护多个工作数据副本,确保能够针对失败的节点重新分布处理。Hadoop 是高效的,因为它以并行的方式工作,通过并行处理加快处理速度。Hadoop 还是可伸缩的,能够处理PB 级数据。此外,Hadoop 依赖于社区服务器,因此它的成本比较低,任何人都可以使用。

数据处理软件介绍.

Chapter4 Introduction to Analysis-of-Variance Procedures Chapter T able of Contents 52Chapter4.Introduction to Analysis-of-Variance Procedures SAS OnlineDoc?:Version8 Chapter4 Introduction to Analysis-of-Variance Procedures 54Chapter4.Introduction to Analysis-of-Variance Procedures The following section presents an overview of some of the fundamental features of analysis of variance.Subsequent sections describe how this analysis is performed with procedures in SAS/STAT software.For more detail,see the chapters for the individual procedures.Additional sources are described in the“References”section on page61. De?nitions Analysis of variance(ANOV Ais a technique for analyzing experimental data in which one or more response(or dependent or simply Yvariables are measured un-der various conditions identi?ed by one or more classi?cation variables.The com-binations of levels for the classi?cation variables form the cells of the experimental design for the data.For example,an experiment may measure weight change(the dependent variablefor men and women who participated in three different weight-loss programs.The six cells of the design are formed by the six combinations of sex (men,womenand program(A,B,C.

几种常用大数据分析工具

几种常用大数据分析工具 大数据可以概括4个V,数据量大,速度快,类型多,价值密度低。大数据作为时下最火热的IT行业的词汇,随之而来的数据仓库,数据安全,数据分析,数据挖掘等等围绕大数据的商业价值的利用逐渐成为行业人士争相追捧的利润焦点。今天我们北大青鸟贵州大数据学院为大家分享的就是大数据分析工具。 Hadoop Hadoop是一个能够让用户轻松架构和使用的分布式计算平台。用户可以轻松地在Hadoop上开发和运行处理海量数据的应用程序。它主要有以下几个优点:高可靠性:Hadoop按位存储和处理数据的能力值得人们信赖。高扩展性:Hadoop是在可用的计算机集簇间分配数据并完成计算任务的,这些集簇可以方便地扩展到数以千计的节点中。高效性:Hadoop能够在节点之间动态地移动数据,并保证各个节点的动态平衡,因此处理速度非常快。高容错性:Hadoop能够自动保存数据的多个副本,并且能够自动将失败的任务重新分配。了解详情 1、HPCC HPCC,High Performance Computing and Communications(高性能计算与通信)的缩写。HPCC是美国实施信息高速公路而上实施的计划,该计划的实施将耗资百亿美元,其主要目标要达到:开发可扩展的计算系统及相关软件,以支持太位级网络传输性能,开发千兆比特网络技术,扩展研究和教育机构及网络连接能力。点击咨询

2、Storm Storm是自由的开源软件,一个分布式的、容错的实时计算系统,可以非常可靠的处理庞大的数据流,用于处理Hadoop的批量数据。Storm很简单,支持许多种编程语言,使用起来非常有趣。Storm有许多应用领域:实时分析、在线机器学习、不停顿的计算、分布式RPC(远过程调用协议,一种通过网络从远程计算机程序上请求服务)、 3、Pentaho BI Pentaho BI 平台不同于传统的BI 产品,它是一个以流程为中心的,面向解决方案(Solution)的框架。其目的在于将一系列企业级BI产品、开源软件、API等等组件集成起来,方便商务智能应用的开发。以上就是北大青鸟贵州大数据学院大数据分析工具的简单介绍,更多大数据学习详情,大家可以到北大青鸟贵州大数据学院大数据咨询了解。

大数据可视化分析平台介绍

大数据可视化分析平台 一、背景与目标 基于邳州市电子政务建设的基础支撑环境,以基础信息资源库(人口库、法人库、宏观经济、地理库)为基础,建设融合业务展示系统,提供综合信息查询展示、信息简报呈现、数据分析、数据开放等资源服务应用。实现市府领导及相关委办的融合数据资源视角,实现数据信息资源融合服务与创新服务,通过系统达到及时了解本市发展的综合情况,及时掌握发展动态,为政策拟定提供依据。 充分运用云计算、大数据等信息技术,建设融合分析平台、展示平台,整合现有数据资源,结合政务大数据的分析能力与业务编排展示能力,以人口、法人、地理,人口与地理,法人与地理,实现基础展示与分析,融合公安、交通、工业、教育、旅游等重点行业的数据综合分析,为城市管理、产业升级、民生保障提供有效支撑。 二、政务大数据平台 1、数据采集和交换需求:通过对各个委办局的指定业务数据进行汇聚,将分散的数据进行物理集中和整合管理,为实现对数据的分析提供数据支撑。将为跨机构的各类业务系统之间的业务协同,提供统一和集中的数据交互共享服务。包括数据交换、共享和ETL等功能。 2、海量数据存储管理需求:大数据平台从各个委办局的业务系统里抽取的数据量巨大,数据类型繁杂,数据需要持久化的存储和访问。不论是结构化数据、半结构化数据,还是非结构化数据,经过数据存储引擎进行建模后,持久化保存在存储系统上。存储系统要具备

高可靠性、快速查询能力。 3、数据计算分析需求:包括海量数据的离线计算能力、高效即席数据查询需求和低时延的实时计算能力。随着数据量的不断增加,需要数据平台具备线性扩展能力和强大的分析能力,支撑不断增长的数据量,满足未来政务各类业务工作的发展需要,确保业务系统的不间断且有效地工作。 4、数据关联集中需求:对集中存储在数据管理平台的数据,通过正确的技术手段将这些离散的数据进行数据关联,即:通过分析数据间的业务关系,建立关键数据之间的关联关系,将离散的数据串联起来形成能表达更多含义信息集合,以形成基础库、业务库、知识库等数据集。 5、应用开发需求:依靠集中数据集,快速开发创新应用,支撑实际分析业务需要。 6、大数据分析挖掘需求:通过对海量的政务业务大数据进行分析与挖掘,辅助政务决策,提供资源配置分析优化等辅助决策功能, 促进民生的发展。

常用数据挖掘工具介绍

常用数据挖掘工具介绍 1.SAS统计分析软件 SAS统计分析软件是用于数据分析与决策支持的大型集成式模块化软件包。它由数十个专用模块构成,功能包括数据访问、数据储存及管理、应用开发、图形处理、数据分析、报告编制、运筹学方法、计量经济学与预测等。 SAS统计分析软件特点如下: 信息存储简便灵活 语言编程能力强 丰富的统计分析方法 较强的统计报表与绘图功能 友好的用户界面 宏功能 支持分布式处理 采用输出分发系统 功能强大的系统阅读器 SAS统计分析软件界面如下: SAS分析案例如下:

2.Clementine数据挖掘软件 Clementine是ISL(Integral Solutions Limited)公司开发的数据挖掘工具平台。Clementine基于图形化的界面提供了大量的人工智能、统计分析的模型(神经网络,关联分析,聚类分析、因子分析等)。 Clementine软件特点如下: 支持图形化界面、菜单驱动、拖拉式的操作 提供丰富的数据挖掘模型和灵活算法 具有多模型的整合能力,使得生成的模型稳定和高效 数据挖掘流程易于管理、可再利用、可充分共享 提供模型评估方法 数据挖掘的结果可以集成于其他的应用中 满足大数据量的处理要求 能够对挖掘的过程进行监控,及时处理异常情况 具有并行处理能力 支持访问异构数据库 提供丰富的接口函数,便于二次开发 挖掘结果可以转化为主流格式的适当图形 Clementine软件界面如下:

Clementine分析案例如下: 3.R统计软件 R是属于GNU系统的一个自由、免费、开放源代码的软件,是一个用于统计计算、数据分析和统计制图的优秀工具。作为一个免费的统计软件,它有UNIX、 LINUX、MacOS和WINDOWS 等版本,均可免费下载使用。 R是一套完整的数据处理、计算和制图软件系统。其功能包括:

大数据分析的六大工具介绍

云计算大数据处理分析六大最好工具 2016年12月

一、概述 来自传感器、购买交易记录、网络日志等的大量数据,通常是万亿或EB的大小,如此庞大的数据,寻找一个合适处理工具非常必要,今天我们为大家分享在大数据处理分析过程中六大最好用的工具。 我们的数据来自各个方面,在面对庞大而复杂的大数据,选择一个合适的处理工具显得很有必要,工欲善其事,必须利其器,一个好的工具不仅可以使我们的工作事半功倍,也可以让我们在竞争日益激烈的云计算时代,挖掘大数据价值,及时调整战略方向。 大数据是一个含义广泛的术语,是指数据集,如此庞大而复杂的,他们需要专门设计的硬件和软件工具进行处理。该数据集通常是万亿或EB的大小。这些数据集收集自各种各样的来源:传感器、气候信息、公开的信息、如杂志、报纸、文章。大数据产生的其他例子包括购买交易记录、网络日志、病历、事监控、视频和图像档案、及大型电子商务。大数据分析是在研究大量的数据的过程中寻找模式,相关性和其他有用的信息,可以帮助企业更好地适应变化,并做出更明智的决策。 二、第一种工具:Hadoop Hadoop 是一个能够对大量数据进行分布式处理的软件框架。但是 Hadoop 是以一种可靠、高效、可伸缩的方式进行处理的。Hadoop 是可靠的,因为它假设计算元素和存储会失败,因此它维护多个工作数据副本,确保能够针对失败的节点重新分布处理。Hadoop 是高效的,因为它以并行的方式工作,通过并行处理加快处理速度。Hadoop 还是可伸缩的,能够处理 PB 级数据。此外,Hadoop 依赖于社区服务器,因此它的成本比较低,任何人都可以使用。 Hadoop是一个能够让用户轻松架构和使用的分布式计算平台。用户可以轻松地在Hadoop上开发和运行处理海量数据的应用程序。它主要有以下几个优点:●高可靠性。Hadoop按位存储和处理数据的能力值得人们信赖。 ●高扩展性。Hadoop是在可用的计算机集簇间分配数据并完成计算任务的, 这些集簇可以方便地扩展到数以千计的节点中。

50个大数据可视化分析工具

50个大数据可视化分析工具 在大数据时代,数据可视化工具必须具有以下特性: (1)实时性:数据可视化工具必须适应大数据时代数据量的爆炸式增长需求,必须快速的收集分析数据、并对数据信息进行实时更新; (2)简单操作:数据可视化工具满足快速开发、易于操作的特性,能满足互联网时代信息多变的特点; (3)更丰富的展现:数据可视化工具需具有更丰富的展现方式,能充分满足数据展现的多维度要求; (4)多种数据集成支持方式:数据的来源不仅仅局限于数据库,数据可视化工具将支持团队协作数据、数据仓库、文本等多种方式,并能够通过互联网进行展现。 Excel 是快速分析数据的理想工具,也能创建供内部使用的数据图,但在颜色、线条和样式上可选择的范围有限。 Google Charts 提供了大量现成的图表类型,从简单的线图表到复杂的分层树地图等,还内置了动画和用户交互控制。 D3 能够提供大量线性图和条形图之外的复杂图表样式,例如V oronoi图、树形图、圆形集群和单词云等。 R语言 是主要用于统计分析、绘图的语言和操作环境。 Visual.ly 如果你需要制作信息图而不仅仅是数据可视化,Visual.ly是最流行的一个选择。

Processing 是数据可视化的招牌工具,只需要编写一些简单的代码,然后编译成Java,可在几乎所有平台上运行。 Leaflet 用来开发移动友好地交互地图。 OpenLayers 对于一些特定的任务来说,能够提供一些其他地图库都没有的特殊工具。 Polymaps 是一个地图库,主要面向数据可视化用户。可以将符号字体与字体整合,创建出漂亮的矢量化图标。 Gephi 是一个可视化的网络探索平台,用于构建动态的、分层的数据图表。 可以用CartoDB很轻易就把表格数据和地图关联起来。 Weka是数据分析的强大工具,还能生成一些简单的图表。 NodeBox是OS X上创建二维图形和可视化的应用程序。 Kartograph不需要任何地图提供者像Google Maps,用来建立互动式地图。 Modest Maps在一些扩展库的配合下,例如Wax,Modest Maps立刻会变成一个强大的地图工具。 Tangle是个用来探索、Play和查看文档更新的交互式库。既是图表,又是互动图形用户界面的小程序。当你调整一个图表中的输入范围时,其他关联图表的数据也会随之改变。 Rapha憀与其他库最大的不同是输出格式仅限SVG和VML。 jsDraw2DX用来创建任意类型的SVG交互式图形,可生成包括线、举行、多边形、椭圆、弧线等等图形。 Pizza Pie Charts是个响应式饼图图表。 FusionCharts XT是一款跨平台、跨浏览器的JavaScript图表组件,可提供令人愉悦的JavaScript图表体验。 iCharts有交互元素,可以从Google Doc、Excel 表单和其他来源中获取数据。

数据分析中常用的10种图表

数据分析中常用的10 种图表 1 折线图 折线图可以显示随时间(根据常用比例设置)而变化的连续数据,因此非常适用于显示在相等时间间隔下数据的趋 势。 表 1 家用电器前半年销售量 月份冰箱电视电脑平均销售量合计 1 月68 45 139 84 252 2 月3 3 66 166 88 265 3 月43 79 160 9 4 282 4 月61 18 11 5 65 194 5 月29 19 78 42 126 6 月22 49 118 63 189 200 150冰 箱 100 79 电视 66 50 45 49 电脑 18 19 1月2月3月4月5 月6月 图 1数点折线图 300 160 250139 166 200115 118 电脑 150 78 电视 100冰 箱50 1月2月3月4月5月6月 图 2 堆积折线图 100% 80% 60%电脑

40%电视 20%冰箱 0% 1月2月3月4月5月6月 图 3 百分比堆积折线图 2柱型图

柱状图主要用来表示各组数据之间的差别 。主要有二维柱形图、 三维柱形图、圆柱图、圆锥图和棱锥图。 200 150 冰箱 100 电视 50 电脑 1月 2月 3月 4月 5月 6月 图 4 二维圆柱图 3 堆积柱形图 堆积柱形图不仅可以显示同类别中每种数据的大小还可以显示总量的大小。 300 250 200 电脑 150 电视 100 冰箱 50 1月 2月 3月 4月 5月 6月 图 5 堆积柱形图 100% 80% 139 160 115 60% 166 78 118 电脑 40% 45 18 电视 19 66 79 49 冰箱 20% 68 61 29 0% 33 43 22 1月 2月 3月 4月 5月 6月 图 6 百分比堆积柱形图 百分比堆积柱形图主要用于比较类别柱上每个数值占总数的百分比,该图的目的

云计算大数据的55个可视化分析工具介绍

云计算大数据的55个最实用 可视化分析工具 近年来,随着云和大数据时代的来临,数据可视化产品已经不再满足于使用传统的数据可视化工具来对数据仓库中的数据抽取、归纳并简单的展现。传统的数据可视化工具仅仅将数据加以组合,通过不同的展现方式提供给用户,用于发现数据之间的关联信息。新型的数据可视化产品必须满足互联网爆发的大数据需求,必须快速的收集、筛选、分析、归纳、展现决策者所需要的信息,并根据新增的数据进行实时更新。因此,在大数据时代,数据可视化工具必须具有以下特性: (1)实时性:数据可视化工具必须适应大数据时代数据量的爆炸式增长需求,必须快速的收集分析数据、并对数据信息进行实时更新; (2)简单操作:数据可视化工具满足快速开发、易于操作的特性,能满足互联网时代信息多变的特点; (3)更丰富的展现:数据可视化工具需具有更丰富的展现方式,能充分满足数据展现的多维度要求; (4)多种数据集成支持方式:数据的来源不仅仅局限于数据库,数据可视化工具将支持团队协作数据、数据仓库、文本等多种方式,并能够通过互联网进行展现。

为了进一步让大家了解如何选择适合的数据可视化产品,本文将围绕这一话题展开,希望能对正在选型中的企业有所帮助。下面就来看看全球备受欢迎的的可视化工具都有哪些吧! 1.Excel Excel作为一个入门级工具,是快速分析数据的理想工具,也能创建供内部使用的数据图,但是Excel在颜色、线条和样式上课选择的范围有限,这也意味着用Excel很难制作出能符合专业出版物和网站需要的数据图。 2.Google Chart API Google Chart提供了一种非常完美的方式来可视化数据,提供了大量现成的图标类型,从简单的线图表到复杂的分层树地图等。它还内置了动画和用户交互控制。 3.D3 D3(Data Driven Documents)是支持SVG渲染的另一种JavaScript库。但是D3能够提供大量线性图和条形图之外的复杂图表样式,例如Voronoi图、树形图、圆形集群和单词云等。 4.R