CNN

CNN的层级结构

CNN的层级结构CNN的层级结构1、CNN的层级结构包括:数据输⼊层/ Input layer卷积计算层/ CONV layerReLU激励层 / ReLU layer池化层 / Pooling layer全连接层 / FC layerBatch Normalization层(可能有)2、⼀般 CNN 结构依次为:INPUT[[CONVà RELU]*N àPOOL]*M[FC àRELU]*KFC数据输⼊层/ Input layer有3种常见的数据处理⽅式:1)去均值2)把输⼊数据各个维度都中⼼化到03)归⼀化幅度归⼀化到同样的范围4)PCA/⽩化⽤PCA降维⽩化是对数据每个特征轴上的幅度归⼀化卷积层1)涉及概念:深度(depth) : 顾名思义,它控制输出单元的深度,也就是filter的个数,连接同⼀块区域的神经元个数。

步幅(stride):它控制在同⼀深度的相邻两个隐含单元,与他们相连接的输⼊区域的距离。

如果步幅很⼩(⽐如 stride = 1)的话,相邻隐含单元的输⼊区域的重叠部分会很多; 步幅很⼤则重叠区域变少。

补零(zero-padding) :我们可以通过在输⼊单元周围补零来改变输⼊单元整体⼤⼩,从⽽控制输出单元的空间⼤⼩。

2)参数共享机制每个卷积核连接数据窗的权重是固定的,这样需要估算的权重个数减少可以把卷积核看做模板,每个卷积核只关注⼀个特性⼀组固定的权重和不同窗⼝内数据做内积: 卷积激励层激励层的作⽤是把卷积层输出结果做⾮线性映射实际经验① CNN尽量不要⽤sigmoid② ⾸先试RELU,因为快,但要⼩⼼点③ 如果2失效,请⽤Leaky ReLU④ 某些情况下tanh倒是有不错的结果,但是很少池化层夹在连续的卷积层中间压缩数据和参数的量,减⼩过拟合类别:Max poolingaverage pooling全连接层两层之间所有神经元都有权重连接通常全连接层在卷积神经⽹络尾部批规范化(Batch normalization)批规范化(Batch normalization)是深度学习中经常见到的⼀种训练trick,指在采⽤梯度下降法训练DNN时,对⽹络层中每个mini-batch的数据进⾏归⼀化,使其均值变为0,⽅差变为1,其主要作⽤是缓解DNN训练中的梯度消失/爆炸现象,加快模型的训练速度。

(完整版)卷积神经网络CNN原理、改进及应用

卷积神经网络(CNN)一、简介卷积神经网络(Convolutional Neural Networks,简称CNN)是近年发展起来,并引起广泛重视的一种高效的识别方法。

1962年,Hubel和Wiesel在研究猫脑皮层中用于局部敏感和方向选择的神经元时发现其独特的局部互连网络结构可以有效地降低反馈神经网络的复杂性,继而提出了卷积神经网络[1](Convolutional Neural Networks-简称CNN)7863。

现在,CNN已经成为众多科学领域的研究热点之一,特别是在模式分类领域,由于该网络避免了对图像的复杂前期预处理,可以直接输入原始图像,因而得到了更为广泛的应用。

Fukushima在1980年基于神经元间的局部连通性和图像的层次组织转换,为解决模式识别问题,提出的新识别机(Neocognitron)是卷积神经网络的第一个实现网络[2]。

他指出,当在不同位置应用具有相同参数的神经元作为前一层的patches时,能够实现平移不变性1296。

随着1986年BP算法以及T-C问题[3](即权值共享和池化)9508的提出,LeCun和其合作者遵循这一想法,使用误差梯度(the error gradient)设计和训练卷积神经网络,在一些模式识别任务中获得了最先进的性能[4][5]。

在1998年,他们建立了一个多层人工神经网络,被称为LeNet-5[5],用于手写数字分类,这是第一个正式的卷积神经网络模型3579。

类似于一般的神经网络,LeNet-5有多层,利用BP算法来训练参数。

它可以获得原始图像的有效表示,使得直接从原始像素(几乎不经过预处理)中识别视觉模式成为可能。

然而,由于当时大型训练数据和计算能力的缺乏,使得LeNet-5在面对更复杂的问题时,如大规模图像和视频分类,不能表现出良好的性能。

因此,在接下来近十年的时间里,卷积神经网络的相关研究趋于停滞,原因有两个:一是研究人员意识到多层神经网络在进行BP训练时的计算量极其之大,当时的硬件计算能力完全不可能实现;二是包括SVM在内的浅层机器学习算法也渐渐开始暂露头脚。

深度学习基础(CNN详解以及训练过程1)

深度学习基础(CNN详解以及训练过程1)深度学习是⼀个框架,包含多个重要算法:Convolutional Neural Networks(CNN)卷积神经⽹络AutoEncoder⾃动编码器Sparse Coding稀疏编码Restricted Boltzmann Machine(RBM)限制波尔兹曼机Deep Belief Networks(DBN)深信度⽹络Recurrent neural Network(RNN)多层反馈循环神经⽹络神经⽹络对于不同问题(图像,语⾳,⽂本),需要选⽤不同⽹络模型⽐如CNN RESNET等才能达到更好效果。

今天来讲最基础的CNN⽹络。

可以不可以模仿⼈类⼤脑的这个特点,构造多层的神经⽹络,较低层的识别初级的图像特征,若⼲底层特征组成更上⼀层特征,最终通过多个层级的组合,最终在顶层做出分类呢?答案是肯定的,这也是许多深度学习算法(包括CNN)的灵感来源。

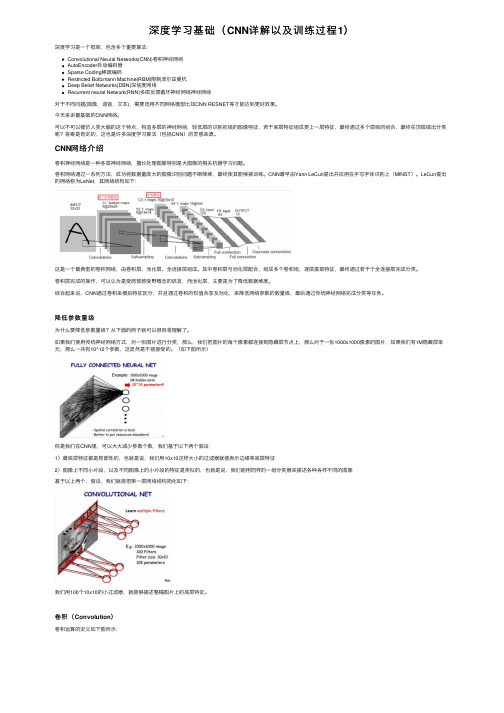

CNN⽹络介绍卷积神经⽹络是⼀种多层神经⽹络,擅长处理图像特别是⼤图像的相关机器学习问题。

卷积⽹络通过⼀系列⽅法,成功将数据量庞⼤的图像识别问题不断降维,最终使其能够被训练。

CNN最早由Yann LeCun提出并应⽤在⼿写字体识别上(MINST)。

LeCun提出的⽹络称为LeNet,其⽹络结构如下:这是⼀个最典型的卷积⽹络,由卷积层、池化层、全连接层组成。

其中卷积层与池化层配合,组成多个卷积组,逐层提取特征,最终通过若⼲个全连接层完成分类。

卷积层完成的操作,可以认为是受局部感受野概念的启发,⽽池化层,主要是为了降低数据维度。

综合起来说,CNN通过卷积来模拟特征区分,并且通过卷积的权值共享及池化,来降低⽹络参数的数量级,最后通过传统神经⽹络完成分类等任务。

降低参数量级为什么要降低参数量级?从下⾯的例⼦就可以很容易理解了。

如果我们使⽤传统神经⽹络⽅式,对⼀张图⽚进⾏分类,那么,我们把图⽚的每个像素都连接到隐藏层节点上,那么对于⼀张1000x1000像素的图⽚,如果我们有1M隐藏层单元,那么⼀共有10^12个参数,这显然是不能接受的。

全卷积网络FCN是什么?CNN与FCN有什么关系?

全卷积网络FCN是什么?CNN与FCN有什么关系?CNN能够对图片进行分类,可是怎么样才能识别图片中特定部分的物体,在2015年之前还是一个世界难题。

神经网络大神Jonathan Long发表了《Fully Convolutional Networks for Semantic Segmentation》在图像语义分割挖了一个坑,于是无穷无尽的人往坑里面跳。

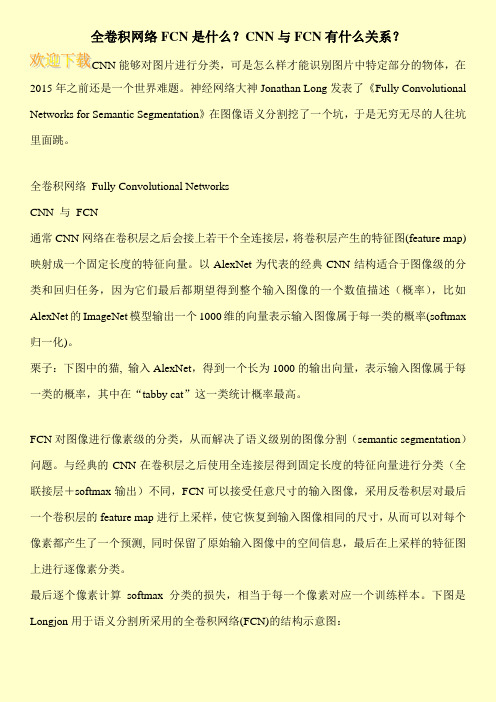

全卷积网络Fully Convolutional NetworksCNN 与FCN通常CNN网络在卷积层之后会接上若干个全连接层,将卷积层产生的特征图(feature map)映射成一个固定长度的特征向量。

以AlexNet为代表的经典CNN结构适合于图像级的分类和回归任务,因为它们最后都期望得到整个输入图像的一个数值描述(概率),比如AlexNet的ImageNet模型输出一个1000维的向量表示输入图像属于每一类的概率(softmax 归一化)。

栗子:下图中的猫, 输入AlexNet,得到一个长为1000的输出向量,表示输入图像属于每一类的概率,其中在“tabby cat”这一类统计概率最高。

FCN对图像进行像素级的分类,从而解决了语义级别的图像分割(semantic segmentation)问题。

与经典的CNN在卷积层之后使用全连接层得到固定长度的特征向量进行分类(全联接层+softmax输出)不同,FCN可以接受任意尺寸的输入图像,采用反卷积层对最后一个卷积层的feature map进行上采样,使它恢复到输入图像相同的尺寸,从而可以对每个像素都产生了一个预测, 同时保留了原始输入图像中的空间信息,最后在上采样的特征图上进行逐像素分类。

最后逐个像素计算softmax分类的损失,相当于每一个像素对应一个训练样本。

下图是Longjon用于语义分割所采用的全卷积网络(FCN)的结构示意图:。

一文看懂卷积神经网络-CNN(基本原理独特价值实际应用)

⼀⽂看懂卷积神经⽹络-CNN(基本原理独特价值实际应⽤)卷积神经⽹络 – CNN 最擅长的就是图⽚的处理。

它受到⼈类视觉神经系统的启发。

CNN 有2⼤特点:能够有效的将⼤数据量的图⽚降维成⼩数据量能够有效的保留图⽚特征,符合图⽚处理的原则⽬前 CNN 已经得到了⼴泛的应⽤,⽐如:⼈脸识别、⾃动驾驶、美图秀秀、安防等很多领域。

CNN 解决了什么问题?在 CNN 出现之前,图像对于⼈⼯智能来说是⼀个难题,有2个原因:图像需要处理的数据量太⼤,导致成本很⾼,效率很低图像在数字化的过程中很难保留原有的特征,导致图像处理的准确率不⾼下⾯就详细说明⼀下这2个问题:需要处理的数据量太⼤图像是由像素构成的,每个像素⼜是由颜⾊构成的。

现在随随便便⼀张图⽚都是 1000×1000 像素以上的,每个像素都有RGB 3个参数来表⽰颜⾊信息。

假如我们处理⼀张 1000×1000 像素的图⽚,我们就需要处理3百万个参数!1000×1000×3=3,000,000这么⼤量的数据处理起来是⾮常消耗资源的,⽽且这只是⼀张不算太⼤的图⽚!卷积神经⽹络 – CNN 解决的第⼀个问题就是「将复杂问题简化」,把⼤量参数降维成少量参数,再做处理。

更重要的是:我们在⼤部分场景下,降维并不会影响结果。

⽐如1000像素的图⽚缩⼩成200像素,并不影响⾁眼认出来图⽚中是⼀只猫还是⼀只狗,机器也是如此。

保留图像特征图⽚数字化的传统⽅式我们简化⼀下,就类似下图的过程:图像简单数字化⽆法保留图像特征图像的内容假如有圆形是1,没有圆形是0,那么圆形的位置不同就会产⽣完全不同的数据表达。

但是从视觉的⾓度来看,图像的内容(本质)并没有发⽣变化,只是位置发⽣了变化。

(本质)并没有发⽣变化,只是位置发⽣了变化所以当我们移动图像中的物体,⽤传统的⽅式的得出来的参数会差异很⼤!这是不符合图像处理的要求的。

⽽ CNN 解决了这个问题,他⽤类似视觉的⽅式保留了图像的特征,当图像做翻转,旋转或者变换位置时,它也能有效的识别出来是类似的图像。

cnn

本周主要内容:一、ABC的发展简史1942年联邦通讯委员会上诉最高法院,要求拆分NBC。

1943年NBC篮网被迫卖给保险大王诺布尔()。

为了生存,ABC与迪斯尼和好莱坞合作,播出大量的动画和电影,并且把主要观众群确定为17-49岁之间的青年人。

50年代,派拉蒙影业公司兼并ABC。

1976年ABC播出了电视连续剧《根》,收视率直线上升。

此后,又从NBC那里挖来了巴巴拉·沃尔特斯主持新闻。

经过一番努力,ABC的收视率终于跃居三大无线商业电视之首。

1985年,大都会上演“蛇吞象”兼并ABC。

1995年,迪斯尼集团购并大都会/ABC。

1999年,真人秀节目《谁想成为百万富翁》播出,引发收视率高潮。

2002年停播。

二、CNN的创立与发展1、泰德·特纳与特纳广播公司父亲自杀后,他成为特纳广告公司的老板。

第一件怪诞的事情:1970年收购赖斯广播公司。

随后买进了两个亏损的超高频电视台。

第二件怪诞的事情:1975年,美国无线电公司发射了通讯卫星二号,特纳看到了其中的商机。

第三件怪诞的事情:1980年6月1日cnn开播。

刚创办时,cnn每个月亏损二百万美元,全美国的行家对此做法嗤之以鼻,但特纳一意孤行,同行称其为“怪诞船长”和“南方老鼠”。

2、CNN的新闻理念和崛起原因理念:全天候、全球、现场崛起:里根遇刺、挑战者号升空爆炸、美军入侵巴拿马、拆除柏林墙、海湾战争一系列新闻事件中的全天候现场新闻让cnn声名鹊起。

实例:CNN开播的第一天就赶上黑人运动领袖乔丹遇刺,舍恩菲尔德立即“腰斩”了CNN历史上的第一个广告,插播卡特总统的记者招待会。

当他得知三大网要把这个新闻留作晚间节目时,便无限感慨地说:“这就是我们做现场报道的意义。

” CNN提出了一个口号:“做第一个知道的人”(Be the First One to Know)。

从一开始,舍恩菲尔德就决定创建一个开放式的新闻工作室,以便及时地把新闻和画面同时呈现给观众。

Python中的CNN网络实现方法

Python中的CNN网络实现方法卷积神经网络(Convolutional Neural Network,CNN)是一种深度学习算法,已经在图像识别、自然语言处理、语音识别等领域取得了非常好的效果。

本文将介绍Python中CNN网络的实现方法,并且通过实例展示如何构建CNN网络。

1.卷积神经网络的基本概念卷积神经网络主要由卷积层、池化层、全连接层组成,其中卷积层是最关键的部分。

卷积层的主要作用是提取特征,输入数据经过多次卷积和池化操作后,最终得到的是一个特征图。

卷积神经网络是通过多组卷积核来提取输入数据的特征的。

卷积核是一个小型的矩阵,用于和输入的数据进行卷积。

卷积的结果是一个特征图,这个特征图不仅仅是输入数据的副本,而是提取了输入数据的各种特征,可以用这个特征图来进行下一步的处理。

池化层是在卷积层之后添加的,主要作用是为了进一步降维,减少神经网络的计算量,同时不影响特征图的特征信息。

全连接层是将池化层的输出进行展开,然后进行前向传递和反向传播。

在反向传播时,每一个全连接层的节点将会计算出其对下一层中所有节点的误差,并将其向前传递。

2. Python中实现卷积神经网络的步骤在Python中实现CNN网络的具体步骤如下:1)数据预处理:将数据准备好作为CNN网络的模型输入。

这个步骤通常包括数据归一化、数据增强、数据划分等操作。

2)构建CNN模型:CNN模型主要由卷积层、池化层、全连接层等模块组成。

在Python中,可以使用Keras或TensorFlow等框架来构建CNN模型,这些框架提供了许多预定义的卷积层、池化层等模块,大大简化了模型搭建的流程。

3)编译CNN模型:在构建CNN模型后,需要使用compile方法对模型进行编译,需要指定损失函数、优化函数和评估指标等。

4)训练CNN模型:训练CNN模型需要调用fit方法,传入训练数据和标签进行训练。

在训练过程中,需要指定批次大小、训练次数等参数。

【机器学习基础】卷积神经网络(CNN)基础

【机器学习基础】卷积神经⽹络(CNN)基础最近⼏天陆续补充了⼀些“线性回归”部分内容,这节继续机器学习基础部分,这节主要对CNN的基础进⾏整理,仅限于基础原理的了解,更复杂的内容和实践放在以后再进⾏总结。

卷积神经⽹络的基本原理 前⾯对全连接神经⽹络和深度学习进⾏了简要的介绍,这⼀节主要对卷积神经⽹络的基本原理进⾏学习和总结。

所谓卷积,就是通过⼀种数学变换的⽅式来对特征进⾏提取,通常⽤于图⽚识别中。

既然全连接的神经⽹络可以⽤于图⽚识别,那么为什么还要⽤卷积神经⽹络呢?(1)⾸先来看下⾯⼀张图⽚: 在这个图⽚当中,鸟嘴是⼀个很明显的特征,当我们做图像识别时,当识别到有“鸟嘴”这样的特征时,可以具有很⾼的确定性认为图⽚是⼀个鸟类。

那么,在提取特征的过程中,有时就没有必要去看完整张图⽚,只需要⼀⼩部分就能识别出⼀定具有代表的特征。

因此,使⽤卷积就可以使某⼀个特定的神经元(在这⾥,这个神经元可能就是⽤来识别“鸟嘴”的)仅仅处理带有该特征的部分图⽚就可以了,⽽不必去看整张图⽚。

那么这样就会使得这个神经元具有更少的参数(因为不⽤再跟图⽚的每⼀维输⼊都连接起来)。

(2)再来看下⾯⼀组图⽚:上⾯两张图⽚都是鸟类,⽽不同的是,两只鸟的“鸟嘴”的位置不同,但在普通的神经⽹络中,需要有两个神经元,⼀个去识别左上⾓的“鸟嘴”,另⼀个去识别中间的“鸟嘴”: 但其实这两个“鸟嘴”的形状是⼀样的,这样相当于上⾯两个神经元是在做同⼀件事情。

⽽在卷积神经⽹络中,这两个神经元可以共⽤⼀套参数,⽤来做同⼀件事情。

(3)对样本进⾏⼦采样,往往不会影响图⽚的识别。

如下⾯⼀张图: 假设把⼀张图⽚当做⼀个矩阵的话,取矩阵的奇数⾏和奇数列,可看做是对图⽚的⼀种缩放,⽽这种缩放往往不会影响识别效果。

卷积神经⽹络中就可以对图⽚进⾏缩放,是图⽚变⼩,从⽽减少模型的参数。

卷积神经⽹络的基本结构如图所⽰: 从右到左,输⼊⼀张图⽚→卷积层→max pooling(池化层)→卷积层→max pooling(池化层)→......→展开→全连接神经⽹络→输出。

cnn激活函数

- 1 - cnn激活函数 CNN激活函数是一种非常重要的神经网络,它为计算机提供了一种有效的方法来处理复杂的数据。激活函数是将输入信号转换为输出信号的函数,也就是说,它可以表达一种函数变换:输入信号通过激活函数经过一个过程,转化成输出信号。 CNN激活函数是深度学习中一个重要的组成部分,它可以帮助深度学习模型更好的训练参数和学习模型。首先,我们来看一下CNN模型中激活函数的设计。 CNN激活函数有很多种,常见的有ReLU,sigmoid,tanh等等。ReLU是一个非线性函数,它可以提供非线性和非单调性,这种特性使得它成为CNN激活函数的最佳选择。它有很多优点,比如它能够解决梯度消失问题,它可以有效地减少计算量,而且它的训练过程比较简单,不需要过多的超参数。 另一种常见的CNN激活函数是sigmoid函数,它可以将输入值转换为0到1之间的数,可以处理多分类之间的关系,但它的求导比较慢,可能会导致梯度消失问题。 最后,tanh函数也是一种常用的CNN激活函数,tanh函数和sigmoid函数类似,都可以将输入值转换为介于-1和1之间的输出值,但tanh函数的导数比sigmoid函数大,可以更好的处理输入值的细微变化。 CNN激活函数可以有效地转换输入信号,使得深度学习模型更容易训练出有效的参数和模型。不同的激活函数有不同的特性,因此, - 2 -

我们必须根据自己的需求来选择合适的激活函数。 激活函数可以让神经网络拥有更强大的计算能力,让其能够处理越来越复杂的数据。在构建模型时,正确的利用激活函数,能够帮助研究者更好的构建出更加有效的模型,而且具有更高的准确率。 CNN激活函数不仅仅可以用在CNN模型中,它也可以应用在深度学习的其他模型中,比如RNN,LSTM,GAN等等。不同的模型可能有不同的激活函数,因此,在选择激活函数时,必须注意激活函数的特性,否则容易出现错误。 总的来说,CNN激活函数是一种非常重要的神经网络,它为深度学习模型提供了有效的方法,来处理复杂的数据。正确选择和使用激活函数,能够有效地减少计算量,让深度学习模型更加有效可靠。

CNN的一些基本的概念解读

CNN的一些基本的概念解读终于要开CNN(卷积神经网络)这个神坑了。

不过之所以说它神坑,是因为这里面牵扯到的数学概念相当相当多、导致如果只用Numpy、从头来实现的话会非常繁琐。

然而,如果只是理解它的直观并且单纯地实现它的话,由于有伟大的tensorflow 框架、CNN 被极大地简化成了一个平凡的东西我打算在不带星号的章节中说明如何运用tensorflow 框架将CNN 整合进我们之前实现的神经网络框架中、并在带星号的章节中说明如何使用纯Numpy 从头实现一个CNN 框架。

CNN 坑就坑在带星号的章节,所以观众老爷们大可带着轻松愉悦的心情食用不带星号的章节( σω)σ这一章主要讲CNN 的一些非常基本的概念。

首先我想指出的是:从结构上来说,朴素的CNN 和朴素的NN 没有任何区别(当然,复杂的CNN 会和NN 有着比较大的区别)。

这意味着朴素的CNN 包含且只包含下列两个东西:单独的层级结构Layer将Layer 整合在一起的网络结构所以在实现算法时我们要做的、无非就是把之前实现的NN 相应的部分进行分情况讨论知道了结构后,我们就要来看CNN 的思想了。

总的来说可以把它概括成以下两点:局部连接(Sparse Connectivity)权值共享(Shared Weights)它们有很好直观。

举个栗子,我们平时四处看风景时,都是“一块一块”来看的、信息也都是“一块一块”地接收的(所谓的【局部感受野】)。

在这个过程中,我们的思想在看的过程中通常是不怎么变的、而在看完后可能会发出“啊这风景好美”的感慨、然后可能会根据这个感慨来调整我们的思想。

在这个栗子中,那“一块一块”的风景就是局部连接,我们的思想就是权值。

我们在看风景时用的都是自己的思想,这就是权值共享的生物学意义(注:这个栗子是我开脑洞开出来的、完全不能保证其学术严谨性、还请各位观众老爷们带着批判的眼光去看待它……如果有这方面专长的观众老爷发现我完全就在瞎扯淡、还。