(完整版)延迟渲染的一些思考

前端性能优化的页面渲染时间分析

前端性能优化的页面渲染时间分析随着互联网技术的不断发展,Web页面的性能优化变得越来越重要。

其中,页面渲染时间是评估页面性能的重要指标之一。

本文将介绍前端性能优化的页面渲染时间分析,并提供一些关键技巧和策略来提高页面的渲染性能。

一、页面渲染时间的重要性页面渲染时间是指浏览器加载和渲染页面所需的时间。

对于用户来说,页面渲染时间直接影响其体验和满意度。

长时间的页面加载和渲染会导致用户的不耐烦和流失,影响网站的转化率和用户留存率。

因此,优化页面的渲染时间对于提高用户体验和网站业务的成功至关重要。

二、页面渲染时间分析了解页面的渲染时间是进行性能优化的第一步。

以下是一些常用的页面渲染时间分析工具和技术:1. 浏览器开发者工具现代浏览器都提供了强大的开发者工具,可以帮助开发人员分析页面的渲染时间。

通过浏览器开发者工具中的Network和Performance选项,可以监测页面的加载和渲染时间,并获取其他详细的性能指标和数据。

2. Performance APIPerformance API是HTML5新增的API,它提供了一组用于测量页面性能的接口。

通过Performance API,开发人员可以获取页面加载、DOM构建、资源加载和用户交互等各个阶段的性能指标和时间。

3. WebPagetestWebPagetest是一个第三方的页面性能分析工具,它可以模拟不同网络环境和设备,提供详细的性能报告和分析。

通过WebPagetest,开发人员可以了解页面的加载时间、渲染时间、资源优化等方面的性能问题。

三、页面渲染时间优化的关键技巧与策略针对页面渲染时间的优化,可以从以下几个方面入手:1. 优化网络请求减少网络请求是提高页面渲染时间的关键策略之一。

通过合并、压缩和缓存静态资源,减少页面的HTTP请求次数和资源大小,可以显著减少页面加载和渲染的时间。

2. 优化HTML结构合理优化HTML结构可以改善页面的渲染时间。

渲染时间的计算公式

渲染时间的计算公式

渲染时间 = (场景复杂度 + 光线追踪次数) × 渲染分辨率 / 硬件性能。

其中,场景复杂度指的是场景中物体的数量和复杂程度,光线追踪次数表示每个像素需要追踪的光线数量,渲染分辨率是输出图像的像素数量,硬件性能包括处理器性能、显卡性能和内存带宽等因素。

除了上述公式,还有一些其他因素也会影响渲染时间,比如渲染器的优化程度、使用的渲染算法、光照模型等。

因此,要准确计算渲染时间,需要综合考虑以上因素,并根据具体情况进行调整和优化。

总的来说,渲染时间的计算公式是一个复杂的问题,需要综合考虑多个因素,并且在实际应用中需要不断调整和优化以达到更好的渲染效果和效率。

采样(mental ray 渲染器)

对采样和采样率的理解_mentalray_3dmax (2010-03-24 19:19:51)转载▼标签: 电脑采样值过滤器采样率高斯杂谈分类: 网络资源 采样(mental ray 渲染器)采样是一种抗锯齿技术。

它可以为每种渲染像素提供“最有可能”的颜色。

mental ray 渲染器首先在像素内或沿着像素边缘采取不同位置处的场景颜色,然后使用过滤器将各个采样合并为一种像素颜色。

(在 3ds max 中,这种技术称作“超级采样”。

因为 mental ray渲染器是根据场景进行采样的,所以,使用“材质编辑器”时,无需为使用 mental ray 渲染的材质打开超级采样功能。

)如果使用的采样值不高,则渲染场景时,会出现锯齿和不准确问题。

采样范围:1/64 到 1/4如果使用的采样值较高,则渲染相同场景时,会生成平滑的边缘。

采样范围:1 到16mental ray 渲染器提供了五种过滤方法,即Box、Gauss、Triangle、Mitchell 或Lanczos 过滤器。

默认情况下,Box 过滤器还是最为快速的过滤方法。

通常,Mitchell 过滤器是最为准确的过滤方法。

在无需求得采样权重的情况下,Box 过滤器即可将各个采样进行均匀地合并。

其它三种过滤器可以使用特殊的曲线求得采样的权重,然后将其合并在一起。

求得采样权重时所用的曲线(它们是近似值)选择采样过滤器,然后设置其它采样选项,方法是在“渲染场景”对话框>“渲染器”面板中,打开“采样质量”卷展栏。

注意:区域灯光(区域泛光灯和区域聚光灯)都有各自的采样控制。

它们只能影响区域灯光投射的阴影。

它们与全面渲染场景时所用的采样无关。

渲染采样率为了便于选择采样过滤器,渲染场景时,可以在“渲染场景”对话框>“处理”面板>“诊断”卷展栏中启用诊断程序并选择采样率。

采样率诊断工具提供了一种图解渲染方法,用于说明如何在场景中使用采样方法。

渲染时使用启用采样率的诊断显示采样范围:1 到16每种像素的密度均指出内部及其左右边缘收集的采样数。

Arnold室内渲染解决方案

先上图渲染优化,视乎是每个渲染人员都应该了解的事情,不同的渲染器有不同的优化方案,懂的优化,他在你手里就是神器,不懂得优化,再好的渲染器也会显得暗淡无光。

Arnold渲染室内场景,一直是让大家头疼的事情,开了diffuse,gloss这些,慢的要死,而且噪点奇多,今天我们就来说说如何减少计算量,让场景的渲染时间控制在我们的可接受范围内。

减少计算量,最直接的方式无疑的降低采样sampling,减少采样深度Ray Depth,可如何做到在降低了采样的前提下,让我们的画面仍然在可接受范围内。

减少计算量第一个办法,合理的给出采样,这是我这个场景的采样,AA 5 ,diffuse 3,glossy 2,refraction 0 。

(关于采样《arnold采样的秘密》一文中有详细说明)Ray Depth tolal总值给了5,基本上也就是每个采样射线只反弹一次。

减少计算量第二个办法,选择性的关闭物体的二次照明(在不太影响整体效果的前提下)如下:Arnold给我们提供了一个选择,在物体的shape节点arnold属性里边,我们可以选择关闭物体的diffuse(漫射间接照明)Glossy(反射间接照明)备注:关闭物体的diffuse或者Glossy只是关闭了自身的二次照明,不让他对别的体产生照明,别的物体还是可以对他产生二次照明的。

减少计算量第三个办法,Low Light Threshold(低光阈值)Arnold渲染设置Lights栏下提高这个数值可以减少计算量,凡是比这个数值小的灯光阴影强度,Arnold都不会去采样计算。

这个值的大小根据场景亮度而定。

减少计算量,还有一个办法,也是最应该懂得掌握的办法,那就是使用arnold的aiRaySwitch 材质球,aiRaySwitch材质球可以自定义物体的阴影,反射,漫射这些属性,arnold采样的时候直接采样这些自定义属性而不去采样场景里边的,从而减少计算量。

VR游戏中常见的网络延迟问题和解决方案(五)

VR游戏中常见的网络延迟问题和解决方案在当今的科技发展中,虚拟现实(Virtual Reality,简称VR)技术已经崭露头角,为人们带来了无限的想象和乐趣。

然而,在VR游戏中,常常会遇到网络延迟问题,这对于玩家来说是一种令人沮丧的体验。

本文将讨论VR游戏中常见的网络延迟问题,并提供解决方案。

首先,网络延迟是指在网络传输过程中出现的延迟或延时。

在VR游戏中,网络延迟会导致游戏画面卡顿、动作迟滞以及交互性变差。

这对于玩家来说是非常糟糕的,因为他们期望能够流畅地在虚拟环境中行动和参与。

网络延迟的主要原因之一是网络连接质量不佳。

如果网络连接不稳定或者带宽不足,玩家就会经常遇到延迟问题。

在VR游戏中,这可能导致画面卡顿或者延迟的交互效果,使得游戏体验大打折扣。

因此,玩家应该确保选择稳定的网络连接,并尽可能增加带宽以减少网络延迟。

另一个导致网络延迟的原因是服务器负载过重。

在许多多人在线VR游戏中,数百甚至数千名玩家将同时连接到同一个服务器上。

如果服务器没有足够的处理能力来应对这种负载,就会导致网络延迟问题。

为了解决这个问题,游戏开发者可以增加服务器容量或者优化游戏代码,以提高服务器的性能和响应能力。

此外,VR游戏中的网络延迟问题还可能与玩家所在地理位置有关。

对于全球多人在线VR游戏来说,玩家可能来自不同的国家和地区,他们之间的物理距离可能很远。

这就意味着网络数据需要在长距离传输,从而增加了网络延迟的可能性。

为了解决这个问题,游戏开发者可以使用内容分发网络(Content Delivery Network,简称CDN),将游戏数据存储在靠近玩家的服务器上,从而减少物理距离,并降低网络延迟。

除了以上提到的解决方案,还有一些技术可以用来缓解VR游戏中的网络延迟问题。

例如,预测性渲染技术可以根据玩家的操作和动作预测下一帧的画面,从而减少显示时间的延迟。

此外,游戏引擎的优化和数据压缩技术也可以减少网络传输的延迟。

综上所述,网络延迟是VR游戏中常见的问题,但可以采取一些措施来解决。

Mental ray的基础介绍

1 Mental ray的基础介绍1)要了解Mental ray的原理首先我们要知道以下几种渲染器算法:常见的软件渲染算法有扫描线,光线跟踪,光能传递3种扫描线算法scan-line:扫描线算法很简单,它的基本思路是把三维场景根据摄像机的设置进行二位投影,然后把投影分割成小块,逐步进行计算的方式。

这种算法最大的好处就是速度快,几乎所有渲染器都支持扫描线算法。

首先,将三维场景中的物体沿摄像机矢量方向的反方向进行投影,并计算z通道,和采样点的颜色信息。

然后利用这些信息最终求出渲染图像中每一个像素的颜色值。

代表软件renderman光线跟踪算法raytracing:光线跟踪的计算方法与现实生活中的成像原理十分相似,它是计算由光源发射的光线,把它看作是无限长的射线,当遇到反射或折射时改变方向,遇到漫反射面或无物体阻挡时结束,在真正计算实则是逆向求解。

这种算法的好处就是能真实地再现物体之间的折射和反射,可以很容易的渲染出照片质量的图片。

代表软件mentalray.光能传递算法Radiosity:是基于真实的热辐射传递公式的算法,它将场景分为许多大小不同的面,逐个计算光线在每个面上辐射的值,经衰减后,再传递到对应的方向的面,如此下去,直到光线的能量低于我们设定的值。

由于这种算法完全以物理学原理为模型,所以效果非常真实,但是速度非常慢,一般只用于静桢。

代表软件maxwell硬件渲染:完全由显卡计算出的画面,多用于粒子的渲染,游戏画面的制作和wed3d。

渲染效果取决于显卡。

代表软件CgFX对渲染算法和渲染器的了解,对工作效率的提高至关重要。

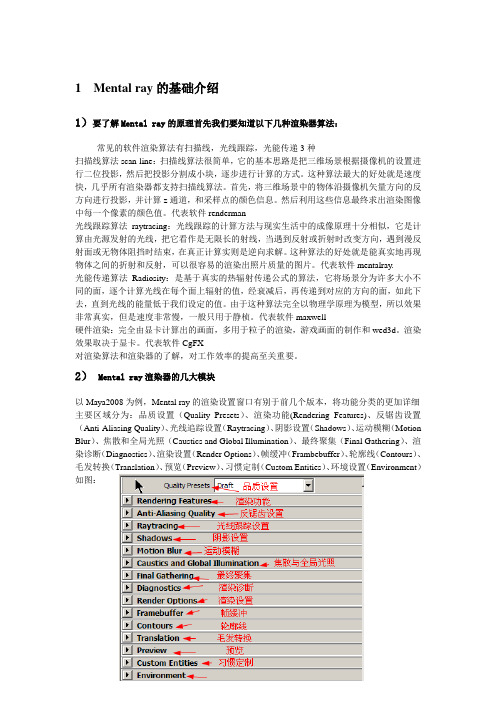

2)Mental ray渲染器的几大模块以Maya2008为例,Mental ray的渲染设置窗口有别于前几个版本,将功能分类的更加详细主要区域分为:品质设置(Quality Presets)、渲染功能(Rendering Features)、反锯齿设置(Anti-Aliasing Quality)、光线追踪设置(Raytracing)、阴影设置(Shadows)、运动模糊(Motion Blur)、焦散和全局光照(Caustics and Global Illumination)、最终聚集(Final Gathering)、渲染诊断(Diagnostics)、渲染设置(Render Options)、帧缓冲(Frambebuffer)、轮廓线(Contours)、毛发转换(Translation)、预览(Preview)、习惯定制(Custom Entities)、环境设置(Environment)如图:图8.1.1-01Mental ray 设置窗口3)其中我们主要学习:焦散和全局光照(Caustics and Global Illumination)、最终聚集(Final Gathering)两个部分。

神奇的深度图:复杂的效果,不复杂的原理

神奇的深度图:复杂的效果,不复杂的原理0x00 前⾔本⽂是《有趣的深度图》的第⼆篇⽂章,上⼀篇⽂章《有趣的深度图:可见性问题的解法》中已经和⼤家介绍了深度图在解决可见性问题中的应⽤。

其实,利⽤深度信息我们可以实现很多有趣⽽⼜显得“⾼⼤上”的效果。

不过这些效果虽然看上去⾼⼤上,但是⼀旦了解了原理就会发现实现这种效果其实是⼗分简单的。

那么本⽂会包括以下四个有趣的效果在Unity中的实现:有点科幻的扫描⽹透过墙壁绘制背后的“⼈影”护盾/能量场效果边缘检测0x01 获取深度信息为了利⽤深度信息来实现若⼲效果,我们⾸先需要获取场景的深度信息。

在移动游戏开发中常⽤的前向渲染路径(Forward Rendering)下,我们需要⼿动设置相机,让它提供场景的深度信息。

camera.depthTextureMode = DepthTextureMode.Depth;如果在延迟渲染路径(Deferred Lighting)下,由于延迟渲染需要场景的深度信息和法线信息来做光照计算,所以并不需要我们⼿动设置相机。

这样我们就可以在shader中访问_CameraDepthTexture来获取保存的场景的深度信息,之后再利⽤UNITY_SAMPLE_DEPTH这个宏来处理_CameraDepthTexture的值,这样我们就获取了某个像素的深度值。

float depth = UNITY_SAMPLE_DEPTH(tex2D(_CameraDepthTexture, uv));但是正如上⼀篇⽂章中所说,此时的深度值并⾮是线性的,因此我们常常需要利⽤另⼀个内建的⽅法Linear01Depth将结果转化为线性的。

这样,我们就能将场景的深度信息渲染为⼀张灰度图。

float linear01Depth = Linear01Depth(depth);0x02 有点科幻的扫描⽹不知道有没有⼩伙伴玩过《⽆⼈深空》这款游戏,当初ps4版预售时我就⽤⾏动⽀持了这款看上去很有吸引⼒的沙盒游戏,当然第⼆天挂闲鱼就是后话了。

前端开发知识:如何使用Canvas和GPU加速来提高渲染性能

前端开发知识:如何使用Canvas和GPU加速来提高渲染性能Canvas是HTML5提供的一个重要的图形绘制API,被广泛应用于图形、动画和游戏开发等领域。

它具有跨浏览器、跨设备、高度可定制等特性,同时也具备一定的图形处理能力。

但是,随着图形、动画和游戏的复杂度越来越高,Canvas的性能问题也越来越凸显。

因此,本文将探讨如何使用Canvas和GPU加速来提高渲染性能。

一、Canvas渲染原理Canvas是HTML5提供的一种绘图API,它可以在Web页面上绘制2D图形,也可以实现一些复杂的动画效果,同时也有WebGL支持,可以在Canvas上实现3D图形的绘制。

Canvas的核心是canvas元素,使用JavaScript编写绘图指令,将其绘制到canvas元素上。

简单来说,canvas是一块画布,开发者通过JavaScript绘图指令将一些图形绘制到画布上,最终呈现在Web页面上。

Canvas有一些内置的API,如:绘制直线、绘制文本、填充颜色、绘制图像等,也支持开发者扩展其他的API。

二、Canvas性能瓶颈虽然Canvas具有很多优点,但是它也存在一些性能问题。

这些问题主要来自于以下三个方面:1、CPU计算量大:由于Canvas是基于JavaScript编写的,在绘制图形时需要进行大量的计算和处理。

因此,当Canvas中的元素变得越来越多时,CPU的计算量也会越来越大,导致渲染速度变慢。

2、内存消耗高:由于Canvas是基于像素绘制的,每一个像素点都需要一个内存单元来储存,因此,在绘制图形时占用的内存也会随着图形的复杂度而增加。

3、绘制效率低:由于Canvas需要通过JavaScript代码实现图形的绘制,而JavaScript在性能上相对较弱,因此,Canvas的绘制效率也相对低下。

三、GPU加速原理GPU(Graphics Processing Unit)是专门负责图形计算的处理器,相比于CPU具备更强的并行计算能力和更高的浮点运算效率。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

延迟渲染的一些思考最近一直在准备开题,打算做延迟渲染(Deferred Shading)相关的实现。

Deferred Shading 是目前实现多动态光源实时渲染的最主流的技术了。

其实Deferred Shading后面还有Deferred Lighting和Inferred Lighting这两种更先进一点的改进技术,可师兄师姐们的经验告诉我,开题不能开太难了。

如果开题太难了,最后实现的时候实现不出来,那就是给自己找麻烦了。

其实Deferred Shading技术在国外已经提出近20年了,在游戏中实际应用也有近10年了,近几年出的几个好的游戏引擎中几乎都用到了它。

在国外,DS应该说是相当成熟了,可国内运用这种技术的引擎好像还没有听说过。

我想并不是国内没有人会这种技术,网上很多博客都提到DS了,也有人自己实现了DS效果。

只是这种技术对硬件的要求比较高,国内的游戏要照顾大多数的玩家。

国外的玩家有可能因为想玩某个很酷的新游戏而升级硬件,国内几乎没有哪一款游戏有这种魅力。

我想这也是为什么国内的游戏技术水平与国外的相差的不止一个级别的原因之一。

国内有些研究过DS的朋友在网上公布了他们的研究结果,不过好像并没有想像中那么好。

他们的实现中要么就没有考虑阴影(比如燕良的博客中的他实现的源代码和效果图,我还没有认真研究他的源码,不过从他的效果图中看不到有阴影的迹象。

但光源数量达不到DS算法研究者声称的几十上百个动态光源的效果(吕希鸣的博客中有他实现的效果,他用的是Shadowmap实现的阴影,但他自己都坦言:“在GeForce-7300GT 上,最多画4个光源,再多就变幻灯片了,而且模型数量不能太多。

”/lv_ximing/archive/2010/07/27/5766569.aspx)。

因为这个问题,我纠结了很长时间,DS算法说起来是比较简单,空间换时间。

可为什么大部分相关文章在谈到DS的优点的时候,都说可以实现多动态光源,去很少提到阴影的具体实现方法,好像阴影是理所当然的事。

《GPU精粹2》中有一篇文章《S.T.A.L.K.E.R.中的延期着色(Deferred Shading inS.T.A.L.K.E.R.)》,其中介绍的阴影也是用shadowmap来实现的。

《GPU精粹3》中有一篇专门的介绍延迟渲染的,《Tabula Rasa中的延迟着色技术》,其实网上就有这篇文章的翻译:(“天堂里的死神”童鞋很给力,《GPU精粹3》的中文版是10年6月才出版的,他09年就翻译了这篇文章。

)阴影也是用shadowmap实现的。

他还有一篇相关的博客《“杀戮地带2”中的延迟渲染》是用的shadowmap来实现的。

这么多的经典游戏中都是用的shadowmap,看来shadowmap是比较好的选择了。

不过也有文章提到用DS实现阴影体渲染的,最后将会附上原文,但没有使用多个光源,如果真的有多个动态光源,估计计数量也够呛。

好了,开题的事就基本定下来了,题目就定为“多光源动态光照的实时渲染”之类的吧,反正是基于延迟渲染的,即使实现了延迟渲染之后,想进一步做Deferred Lighting和Inferred Lighting,也在题目范围之内。

也算了了一大心事了,开题报告就好说了。

此事告一段落,等导师让我们准备开题答辩时,再写开题报告吧。

从此可以全心地准备找实习了,腾讯5月8来来汉笔试,期待中。

希望能去游戏开发岗位实习。

这是《OpenGL Shading Language(2nd Edition)》第13章的一节,讲的是用延迟渲染实现阴影体。

(最近比较忙,时间有限,我只把这篇文章中基本关键部分翻译出来了的,水平有限,仅供参考。

)13.3. Deferred Shading for Volume ShadowsWith contributions by Hugh Malan and Mike WeiblenOne of the disadvantages of shadow mapping as discussed in the previous section is that the performance depends on the number of lights in the scene that are capable of casting shadows. With shadow mapping, a rendering pass must be performed for each of these light sources. These shadow maps are utilized in a final rendering pass. All these rendering passes can reduce performance, particularly if a great many polygons are to be rendered.It is possible to do higher-performance shadow generation with a rendering technique that is part of a general class of techniques known as DEFERRED SHADING. With deferred shading, the idea is to first quickly determine the surfaces that will be visible in the final scene and apply complex and time-consuming shader effects only to the pixels that make up those visible surfaces. In this sense, the shading operations are deferred until it can be established just which pixels contribute to the final image. A very simple and fast shader can render the scene into an offscreen buffer with depth buffering enabled. During this initial pass, the shader stores whatever information is needed to perform the necessary rendering operations in subsequent passes. Subsequent rendering operations are applied only to pixels that are determined to be visible in the high-performance initial pass. This technique ensures that no hardware cycles are wasted performing shading calculations on pixels that will ultimately be hidden.To render soft shadows with this technique, we need to make two passes. In the first pass, we do two things:1. We use a shader to render the geometry of the scene without shadows or lighting into the frame buffer. 用一个着色器把场景中除了阴影和光照之外的几何形状信息到渲染到帧缓存中。

2. We use the same shader to store a normalized camera depth value for each pixel ina separate buffer. (This separate buffer is accessed as a texture in the second pass for the shadow computations.) 用同一个着色器把每个像素点的规一化照相机深度值存到一个单独的缓存中。

(在阴影计算的第二个Pass中,这个单独缓存将会当作一张纹理。

)In the second pass, the shadows are composited with the existing contents of the frame buffer. To do this compositing operation, we render the shadow volume (i.e., the region in which the light source is occluded) for each shadow casting object. In the case of a sphere, computing the shadow volume is relatively easy. The sphere's shadow is in the shape of a truncated cone, where the apex of the cone is at the light source. One end of the truncated cone is at the center of the sphere (see Figure 13.2). (It is somewhat more complex to compute the shadow volume for an object defined by polygons, but the same principle applies.)Figure 13.2. The shadow volume for a sphereWe composite shadows with the existing geometry by rendering the polygons that define the shadow volume. This allows our second pass shader to be applied only to regions of the image that might be in shadow. 通过渲染定义阴影体的多边形,我们把阴影与现有的几何信息合成。