GPT简介及使用方法

GPT-3简介与chatGPT的发展历程

GPT-3简介与chatGPT的发展历程GPT-3是目前公认的自然语言处理领域最先进的模型之一,它采用了深度学习技术和大规模训练数据集,可以生成自然流畅的文本,并且可以完成多种任务,如文本分类、问题回答和文本生成等。

chatGPT则是在GPT-3的基础上发展出来的一种聊天机器人,其特点是可以进行智能对话,与人类用户交互,处理自然语言输入并以自然流畅的文本回答用户提出的问题。

chatGPT的发展历程可以追溯到2015年,当时科研人员使用RNN模型构建了一个聊天机器人,但是该模型存在一些问题,如生成的文本不够流畅,回答不够准确等。

随着GPT系列模型的出现和不断改进,chatGPT也逐渐发展成为了当前较为优秀的聊天机器人之一。

除了应用于个人聊天的场景外,chatGPT还被广泛应用于商业和服务领域,为客户提供支持和服务。

同时,chatGPT也受到了一些争议和批评,主要是因为它可能存在造成偏见和歧视的风险,因为其训练数据集可能存在不平衡和偏见。

因此,在应用chatGPT时需要注意这些问题,并尽可能采取措施进行改善。

总的来说,GPT-3和chatGPT的发展历程是自然语言处理领域的一次重大突破,它们可以极大地提升人们的日常沟通和交流效率,同时也带来了一些挑战和风险,需要我们认真思考和应对。

一、引言自然语言生成是人工智能中最有挑战性的任务之一。

随着深度学习技术的发展,越来越多的基于深度学习的模型被提出来用于自然语言处理任务。

其中,GPT(Generative Pre-trained Transformer)模型就是一个颇具代表性的自然语言生成模型。

近年来,GPT模型的不断升级和改进,特别是chatGPT的问答任务表现优异,受到了广泛的关注和研究。

(一)GPT模型1、GPT模型的历程GPT模型的历程可以追溯到2017年的Transformer模型。

2019年,OpenAI提出了GPT模型,其使用大规模预训练的方式,将海量的文本数据输入到Transformer模型中进行预训练,并在此基础上完成下游自然语言任务。

如何使用ChatGPT进行用户对话建模和生成

如何使用ChatGPT进行用户对话建模和生成导言对话是人类社交交流的重要形式,而对话建模和生成是人工智能领域的重要研究方向之一。

近年来,由OpenAI发布的ChatGPT模型在对话生成方面取得了突破性进展。

本文将介绍如何使用ChatGPT进行用户对话建模和生成,以及一些相关的应用和注意事项。

一、ChatGPT的基本原理1.1 ChatGPT简介ChatGPT是一种基于自回归传统的语言模型的对话生成模型。

它的基本原理是通过训练大量的对话数据来学习对话的结构和语义,然后根据给定的上下文生成合适的回复。

与其他模型相比,ChatGPT具有更好的语言理解和生成能力,能够生成流畅、连贯、具有一定逻辑性的对话。

1.2 ChatGPT的训练方法ChatGPT的训练方法主要依赖于预训练和微调两个阶段。

在预训练阶段,模型通过大规模的无监督语料库进行自我对话生成,从而学习语言的表达和逻辑。

在微调阶段,模型使用特定的对话数据集进行有监督的微调,以使其更好地适应具体的对话任务。

二、使用ChatGPT进行对话建模2.1 数据准备在使用ChatGPT进行对话建模之前,首先需要准备一定量的对话数据。

对话数据可以来自于各种渠道,比如社交媒体、客服记录、论坛或聊天记录等。

数据的质量和多样性对模型的表现有重要影响,因此在准备数据时应尽量包含不同主题、不同风格和不同对话场景的对话。

2.2 模型训练模型训练是使用ChatGPT进行对话建模的关键步骤。

在训练过程中,需要将准备好的对话数据输入到模型中进行预处理和训练。

预处理过程可以包括分词、去除噪声、标记化等操作。

训练时可以采用批量训练的方式,每次输入一定数量的对话数据,根据模型的输出进行参数优化。

2.3 模型评估在模型训练完成后,需要对模型进行评估以判断其性能和效果。

评估可以采用人工评估和自动评估相结合的方式。

人工评估可以从语义准确性、流畅度、连贯性等方面对模型进行打分和判断。

自动评估可以使用一些指标,如BLEU、ROUGE等来评估生成结果的质量和相似度。

chatgpt高端用法

ChatGPT高端用法简介ChatGPT是OpenAI推出的一种基于GPT(生成式预训练模型)的聊天机器人。

它通过大量的文本数据进行训练,可以生成与用户进行自然语言对话的回复。

ChatGPT可以应用于各种场景,包括客服、教育、娱乐等。

本文将介绍ChatGPT的高端用法,包括如何提升回复质量、控制回复风格、添加特定功能等。

提升回复质量1. 数据清洗在使用ChatGPT之前,我们可以对训练数据进行清洗,去除噪声和不必要的信息。

这可以提高ChatGPT的回复质量。

可以使用一些文本处理工具来清洗数据,例如去除HTML标签、特殊字符等。

2. Fine-tuningFine-tuning是一种在预训练模型上进行微调的方法,可以使ChatGPT更适应特定的任务或领域。

我们可以使用自己的数据集进行Fine-tuning,或者使用OpenAI提供的Fine-tuning API。

通过Fine-tuning,ChatGPT可以更好地理解特定领域的问题,并给出更准确的回复。

3. 上下文重要性ChatGPT是基于上下文进行回复的,因此上下文的重要性对回复质量至关重要。

我们可以通过调整模型的temperature参数来控制生成回复的随机性。

较高的temperature值会导致更随机的回复,而较低的值会使回复更加确定和一致。

控制回复风格1. 设置回复长度为了控制回复的长度,我们可以通过设置模型的max_tokens参数来限制生成回复的最大长度。

这样可以避免生成过长的回复,保持回复的简洁性。

2. 添加回复模板为了确保回复的一致性和准确性,我们可以为ChatGPT提供一些回复模板。

这些模板可以是预定义的,也可以根据具体情况动态生成。

通过使用回复模板,我们可以更好地控制回复的风格和内容。

3. 过滤敏感主题为了避免生成敏感内容,我们可以对输入进行过滤,将与敏感主题相关的问题或关键词进行屏蔽或替换。

这有助于确保ChatGPT生成的回复符合规范和道德要求。

使用ChatGPT进行语义分析的方法

使用ChatGPT进行语义分析的方法随着人工智能技术的发展,自然语言处理领域取得了长足的进步。

ChatGPT作为一种基于深度学习的模型,能够进行对话生成和理解,包括语义分析。

本文将介绍使用ChatGPT进行语义分析的方法,以及其在实际应用中的一些挑战和限制。

一、ChatGPT简介ChatGPT是由OpenAI开发的一种基于Transformer架构的语言模型。

它通过对大规模文本数据进行预训练,并通过生成式对话任务进行微调,从而能够生成连贯的对话内容。

ChatGPT的优势在于能够理解上下文,并生成与之相关的回复。

二、语义分析的定义语义分析是指对文本进行深入理解,从而抽取出其中的含义和语义关系。

它可以帮助我们更好地理解用户的意图和情感,进而进行相应的回复或决策。

ChatGPT 作为一种强大的自然语言处理模型,可以用于实现语义分析的任务。

三、ChatGPT的语义分析方法1. 文本分类ChatGPT可以用于文本分类任务,通过训练一个分类器来判断文本属于哪个类别。

例如,可以使用ChatGPT来判断一封邮件是垃圾邮件还是正常邮件,或者对用户输入的问题进行分类,以便提供相应的答案。

2. 情感分析ChatGPT可以用于情感分析任务,通过分析文本中的情感色彩来判断其情感倾向。

例如,可以使用ChatGPT来判断一篇文章是正面的还是负面的,或者对用户的评论进行情感分析,以便了解用户对某个产品或服务的态度。

3. 实体识别ChatGPT可以用于实体识别任务,通过识别文本中的特定实体来提取有用的信息。

例如,可以使用ChatGPT来识别一篇新闻文章中的人名、地名或组织名,以便进行进一步的分析和处理。

4. 关系抽取ChatGPT可以用于关系抽取任务,通过分析文本中的语义关系来提取实体之间的关联。

例如,可以使用ChatGPT来判断一句话中的主谓关系或者动宾关系,以便更好地理解句子的含义。

四、挑战和限制尽管ChatGPT在语义分析方面有着广泛的应用前景,但也存在一些挑战和限制。

GPT

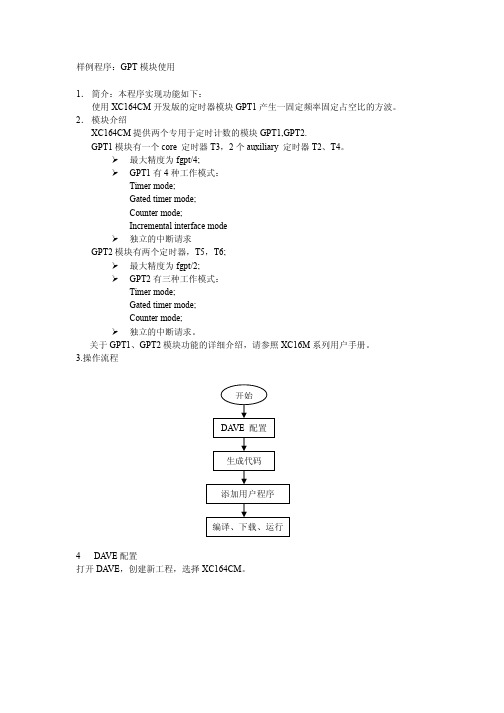

样例程序:GPT模块使用1.简介:本程序实现功能如下:使用XC164CM开发版的定时器模块GPT1产生一固定频率固定占空比的方波。

2.模块介绍XC164CM提供两个专用于定时计数的模块GPT1,GPT2.GPT1模块有一个core 定时器T3,2个auxiliary 定时器T2、T4。

¾最大精度为fgpt/4;¾GPT1有4种工作模式:Timermode;mode;timerGatedmode;CounterinterfacemodeIncremental¾独立的中断请求GPT2模块有两个定时器,T5,T6;¾最大精度为fgpt/2;¾GPT2有三种工作模式:mode;Timermode;timerGatedmode;Counter¾独立的中断请求。

关于GPT1、GPT2模块功能的详细介绍,请参照XC16M系列用户手册。

3.操作流程打开DA VE,创建新工程,选择XC164CM。

工程设置如下所示:点击GPT1模块,进行如下设置:5.利用DA VE生成代码点击, DA VE自动生成代码,生成的代码即包括前面所选择的函数。

6.修改用户代码6.1 生成uVsion 工程文件。

做完以上步骤之后工程文件夹中会出现keil图标的dpt文件,双击进入keil环境。

第一次进入keil环境需要设置:project-options for target ‘target 1’。

如下所示:6.2 添加用户代码在main函数中添加下列代码(在main函数的末尾处)// USER CODE BEGIN (Main,4)while(1) {};// USER CODE END// USER CODE BEGIN (GT1_viTmr3,2)DP9_P4 = !DP9_P4; // invert state of LED// USER CODE END7.编译点击图标进行编译连接。

bloomberggpt参数

Bloomberg GPT参数简介在自然语言处理领域中,GPT(Generative Pre-trained Transformer)是一种基于Transformer模型的预训练语言模型。

GPT以无监督的方式通过大规模文本数据进行预训练,然后可以通过微调适应各种特定的下游任务。

Bloomberg GPT是由Bloomberg公司开发的一个特定领域的GPT模型,针对金融和经济领域的文本数据进行预训练和微调,具有较高的领域专业性和语义理解能力。

GPT模型架构GPT模型的核心组成部分是Transformer模型,它由多个编码器和解码器构成。

编码器将输入序列转换为上下文感知的特征表示,而解码器则根据上下文生成下一个词。

Transformer模型的核心是自注意力机制,它可以捕捉序列中各个位置之间的依赖关系。

Bloomberg GPT预训练Bloomberg GPT使用了大量的金融和经济领域的文本数据进行预训练。

这些数据包括新闻报道、分析师报告、公司财务报表等。

预训练时,Bloomberg GPT可以学习到金融领域的特定知识和术语,具有较强的语义理解能力和专业性。

Bloomberg GPT微调将预训练模型应用到具体的下游任务时,需要进行微调。

微调过程包括两个步骤:输入表示的微调和特定任务训练。

输入表示的微调是指根据具体任务的特点,调整模型对输入序列的表示能力。

例如,在金融领域的问答任务中,可以将问题和答案进行拼接作为输入,以提高问答的准确性。

特定任务训练是指使用具体任务的标注数据对模型进行有监督的训练,以优化模型在该任务上的性能。

Bloomberg GPT在金融领域的应用Bloomberg GPT在金融领域有着广泛的应用。

以下是几个具体的应用场景:1. 金融文本生成Bloomberg GPT可以用于自动化生成金融报告、市场评论等文本。

通过对历史数据的学习,模型可以提供对未来市场走势的预测和分析。

2. 金融问答系统通过微调Bloomberg GPT,可以构建金融问答系统,帮助用户回答金融投资、理财等方面的问题。

ChatGPT技术在智能电视中的远程语音控制应用

ChatGPT技术在智能电视中的远程语音控制应用

一、简介

GPT(Global Position Tracking)技术是一种测量并跟踪运动物体

的位置或路径的技术。

它可以识别物体的各种运动参数,包括位置、方向、速度、加速度等,进而可以使得智能电视在不同地点及不同情况下被远程

语音控制。

GPT技术不仅可以应用于智能家居,比如实现远程控制电视、机顶盒、家用电器等,而且也可以应用于智能电视,从而实现远程语音控制。

1.应用原理

GPT技术应用于智能电视,可以实现远程语音控制。

智能电视具有专

用的定位硬件,可以实时获取电视的位置信息。

根据电视的实时位置信息,远程用户可以发出遥控命令,将其传输至电视,电视根据遥控命令,实现

对频道、音量、亮度、屏幕尺寸等远程控制。

2.应用优势

(1)具有良好的安全性。

GPT技术采用精确定位技术,可以准确识

别电视的位置,从而达到有效防止恶意攻击或发射遥控命令的目的,从而

提高安全性能。

(2)可以有效避免用户控制干扰。

由于GPT技术可以识别电视的移动,因此可以实现针对多个电视的定向遥控,有效抑制用户控制干扰,从

而提高远程控制的准确性和可靠性。

(3)准确的位置定位。

用户可以在不同位。

gpt2 encode 编码

GPT2 Encode 编码在自然语言处理领域中,编码是将文本转换为机器能够理解和处理的形式的过程。

GPT2 Encode 是一种编码方法,它使用了GPT-2(Generative Pre-trained Transformer 2)模型,该模型是OpenAI于2019年发布的一种基于Transformer架构的语言模型。

GPT-2简介GPT-2是一种以无监督学习方式训练的语言模型,它通过大量的文本数据进行预训练,然后可以用于各种自然语言处理任务,如文本生成、摘要生成、问题回答等。

GPT-2模型的核心是Transformer架构,它使用了自注意力机制(Self-Attention)来捕捉句子中的上下文关系。

自注意力机制可以计算每个单词与其他单词的相关性,并根据相关性对单词进行加权。

这种机制使得GPT-2能够更好地理解句子的语义和结构。

GPT2 Encode 编码过程GPT2 Encode 编码过程可以分为以下几个步骤:1.预处理文本:在进行编码之前,需要对文本进行一些预处理操作,如去除标点符号、转换为小写等。

这样可以减少噪音对编码结果的影响。

2.分词:将文本分割成单词或子词的序列。

分词是将连续的文本转换为离散的符号,使得计算机可以更好地处理文本。

常用的分词方法有基于规则的分词和基于统计的分词。

3.编码:使用GPT-2模型对分词后的文本进行编码。

编码过程中,GPT-2模型会将每个单词转换为向量表示,这些向量表示可以捕捉到单词的语义信息。

4.输出编码结果:将编码后的文本输出为向量序列。

这些向量序列可以用于后续的文本处理任务,如文本生成、情感分析等。

GPT2 Encode 编码的应用GPT2 Encode 编码可以应用于各种自然语言处理任务中,例如:1.文本生成:通过GPT2 Encode 编码将输入文本转换为向量表示后,可以使用解码器将向量序列转换为新的文本。

这样可以实现文本的自动生成,如文章摘要生成、对话系统等。

java 调用chatgpt3.5的案例

一、介绍随着人工智能技术的不断发展,自然语言处理领域也迎来了许多创新。

GPT-3.5是由Open本人开发的最新一代自然语言处理模型,具有极强的语言理解和生成能力。

而Java作为一种广受欢迎的编程语言,在业界被广泛应用于各种软件开发和系统集成。

本文将介绍如何使用Java编程语言调用GPT-3.5模型,并结合实际案例进行详细说明。

二、GPT-3.5模型简介GPT-3.5是Open本人研发的一款自然语言处理模型,它具有1750亿个参数,比前一代模型GPT-3的1000亿个参数更加强大。

GPT-3.5能够对输入的文本进行语义理解,并生成具有逻辑、连贯和合乎语境的文本输出。

这一模型在文本生成、语言理解和对话系统等领域具有广泛的应用前景。

三、Java调用GPT-3.5的基本原理1. GPT-3.5的API接口Open本人提供了GPT-3.5的API接口,开发者可以通过向该接口发送HTTP请求来调用模型的功能。

API接口支持多种编程语言,包括Java,使得开发者能够方便地集成GPT-3.5模型到其应用程序中。

2. Java中的HTTP请求Java语言本身提供了丰富的网络编程功能,可以通过Java的网络编程库来发送HTTP请求,并获取API接口返回的结果。

这使得在Java中调用GPT-3.5模型变得简单和高效。

四、Java调用GPT-3.5的实现步骤1. 获取Open本人的API密钥开发者需要在Open本人全球信息湾注册账号,并获取API密钥。

API 密钥是调用GPT-3.5模型的凭证,具有很高的安全性和保密性。

在获取API密钥后,开发者可以在Java程序中使用该密钥来进行HTTP请求。

2. 编写Java代码在Java程序中,开发者可以使用Java的网络编程库或第三方的HTTP 客户端库来发送HTTP请求。

还需要在代码中设置请求头、请求体等参数,以及处理返回的结果。

通过这些步骤,开发者就能够实现在Java中调用GPT-3.5模型的功能。

gpt2参数规模

gpt2参数规模GPT-2是一种自然语言处理模型,由OpenAI公司开发。

它在自然语言处理任务中表现出色,尤其是在生成文本方面。

GPT-2的参数规模非常大,这使得它能够处理更复杂的任务和生成更自然的文本。

一、GPT-2简介GPT-2是一种基于神经网络的自然语言处理模型,它使用了Transformer架构。

该模型由OpenAI公司开发,旨在生成高质量的自然语言文本。

GPT-2可以用于多种任务,例如问答、摘要、翻译和对话等。

二、GPT-2参数规模GPT-2的参数规模非常大,这使得它能够处理更复杂的任务和生成更自然的文本。

以下是GPT-2不同版本的参数数量:1. GPT-2 Small:117M个参数2. GPT-2 Medium:345M个参数3. GPT-2 Large:774M个参数4. GPT-2 XL:1.5B个参数5. GPT-3 175B:175B个参数三、不同版本之间的区别1. GPT-2 Small:该版本适用于轻量级任务和研究目的。

虽然它只有117M个参数,但已经可以生成相当不错的文本。

2. GPT-2 Medium:该版本比Small版本多了228M个参数,可以处理更复杂的任务。

它的生成文本质量也更高。

3. GPT-2 Large:该版本比Medium版本多了429M个参数,可以处理更大规模的任务和生成更自然的文本。

它在生成长篇文章方面表现出色。

4. GPT-2 XL:该版本比Large版本多了725M个参数,是GPT-2中最大的版本。

它可以处理非常复杂的任务和生成非常自然的文本,但需要大量的计算资源。

5. GPT-3 175B:该版本是目前最大的GPT-3模型,拥有175B个参数。

它可以生成极其自然和逼真的语言,并且在各种自然语言处理任务中表现出色。

四、应用场景GPT-2广泛应用于各种自然语言处理任务中,例如:1. 问答系统:GPT-2可以根据问题自动生成答案。

2. 摘要:GPT-2可以将长篇文章压缩为简短、精确的摘要。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

GPT简介及使用方法

1. GPT是什么?

GPT全称为Generative Pre-trained Transformer,是由OpenAI

公司发明的一种自然语言处理系统。

它可以根据输入文本自动生成相

关的文本并提供丰富的内容。

GPT是基于深度学习技术,采用了Transformer结构作为核心,预先通过大量文本进行训练,从而可以生成各种类型的文本,如:新闻报道、小说、对话等。

2. GPT的应用场景

GPT的应用场景十分广泛,它可以用于自动写作、机器翻译、对话生成、语义分析、情感识别等各种任务,并且可以用于各种领域,如

金融、医疗、人工智能、教育等。

3. GPT的优点

GPT的优点在于其可以通过预训练的方式极大地减少了学习的时间和成本,减少了代码复杂度,同时还可以使用大量的数据集进行训练,提升了模型的性能和稳定性。

另外,GPT还可以通过对数据集的多次重新训练来提高模型的效果,从而可以逐渐适应新的领域。

4. GPT的使用方法

GPT的使用方法也比较简单,我们只需要在特定的平台上(如OpenAI平台)使用预训练好的模型,输入相应的文本,就可以自动生

成相关的文本。

当然,对于那些需要更高度定制和训练的模型,我们

可以使用TensorFlow等深度学习框架进行模型搭建和训练,以满足不同的需求。

总之,GPT作为一种自然语言处理技术,已经得到广泛的应用,它的应用不仅能够帮助人们节省大量的时间和成本,还可以满足日益增长的信息需求,提高人们的生产力和创造力,助力人类走向更光明的未来。