香农信息论的基本理论探究

香农和信息论

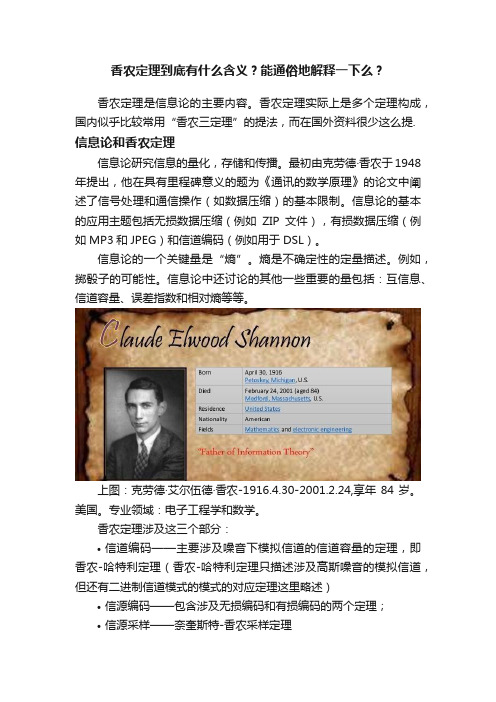

香农和信息论克劳德·香农(Claude Elwood Shannon)1916年4月30日诞生于美国密执安州,他生长在一个有良好教育的环境,香农的祖父是一位农场主兼发明家,发明过洗衣机和许多农业机械,祖父的发明创造对香农影响很大。

此外,香农的家庭与大发明家爱迪生还有远亲关系。

在童年时代,香农还喜欢组装无线电收音机、练习莫尔斯电报码、研究密码学等等。

他有许多爱好,另人难以置信是香农可以熟练地玩一套杂技,他能骑着独轮车手里来回抛着三个球在贝尔实验室的大厅里骑来骑去。

他发明过有两个座位的独轮车,并使该独轮车好象偏离地心似的,骑在上面忽高忽低,像鸭子行走一样。

香农的一生都迷恋于平衡与控制稳定性。

他设计并建造了下棋机器、迷宫老鼠、杂耍器械以及智力阅读机等,下国际象棋的机器包括用3个指头能抓起棋子的手臂、蜂鸣器以及简单的记录装置。

这些活动表明香农有十分的好奇心和探索精神。

香农有一句名言是:“我感到奇妙的是事物何以集成一体。

”1936年香农在密执安大学获得数学与电气工程学士学位;1938年香农写出论文《继电器与开关电路的符号分析》,当时他就发现电话交换电路与布尔代数之间具有类似性,即把布尔代数的“真”与“假”和电路系统的“开”与“关”对应起来,并可用1和0表示。

随后又证明布尔代数的逻辑运算,可以通过继电器电路来实现,明确地给出了实现加、减、乘、除等运算的电子电路的设计方法,他在实践中进一步证明,可以采用能实现布尔代数运算的继电器或电子元件来制造计算机。

他奠定了数字电路的理论基础,并使计算机具有逻辑功能,从而使计算机既能用于数值计算,又具有各种非数值应用功能,使得以后的计算机在几乎任何领域中都得到了广泛的应用。

1941年他加入贝尔实验室数学部,工作到1972年。

1956年他成为MIT(麻省理工学院)客座教授,并于1958年成为终生教授,1978年成为名誉教授。

香农博士于2001年2月26日去世,享年84岁。

香农通信的数学原理

香农通信的数学原理

信息的传递是人类社会发展的重要标志之一,而香农通信的数学原理则是信息传递的基础。

香农通信的数学原理是指在信息传递过程中,通过对信息的编码、传输和解码,使得信息能够在不同的媒介中进行传递和处理,从而实现信息的可靠传输和高效利用。

香农通信的数学原理主要包括信息熵、信道容量和编码理论。

信息熵是指信息的不确定性度量,它反映了信息的随机性和复杂性。

在信息传递过程中,信息熵越大,信息的传输和处理就越困难。

因此,信息熵的降低是实现信息传递的关键。

信道容量是指在给定的信道条件下,能够传输的最大信息速率。

它是衡量信道质量的重要指标,也是实现高效信息传输的基础。

编码理论则是研究如何将信息进行编码和解码的理论,它包括信源编码、信道编码和纠错编码等方面。

在实际应用中,香农通信的数学原理被广泛应用于通信、计算机、信息处理等领域。

例如,在通信领域中,通过对信息进行压缩编码和差错校正等处理,可以实现高效的数据传输和可靠的通信连接。

在计算机领域中,通过对数据进行压缩和加密等处理,可以实现数据的安全传输和存储。

在信息处理领域中,通过对信息进行分类、聚类和挖掘等处理,可以实现对信息的高效利用和分析。

香农通信的数学原理是信息传递的基础,它为实现信息的可靠传输和高效利用提供了重要的理论基础和技术支持。

在信息时代,我们需要不断地探索和应用香农通信的数学原理,以推动信息技术的发

展和应用,为人类社会的进步和发展做出更大的贡献。

香农定理到底有什么含义?能通俗地解释一下么?

香农定理到底有什么含义?能通俗地解释一下么?香农定理是信息论的主要内容。

香农定理实际上是多个定理构成,国内似乎比较常用“香农三定理”的提法,而在国外资料很少这么提. 信息论和香农定理信息论研究信息的量化,存储和传播。

最初由克劳德·香农于1948年提出,他在具有里程碑意义的题为《通讯的数学原理》的论文中阐述了信号处理和通信操作(如数据压缩)的基本限制。

信息论的基本的应用主题包括无损数据压缩(例如ZIP文件),有损数据压缩(例如MP3和JPEG)和信道编码(例如用于DSL)。

信息论的一个关键量是“熵”。

熵是不确定性的定量描述。

例如,掷骰子的可能性。

信息论中还讨论的其他一些重要的量包括:互信息、信道容量、误差指数和相对熵等等。

上图:克劳德·艾尔伍德·香农-1916.4.30-2001.2.24,享年84岁。

美国。

专业领域:电子工程学和数学。

香农定理涉及这三个部分:•信道编码——主要涉及噪音下模拟信道的信道容量的定理,即香农-哈特利定理(香农-哈特利定理只描述涉及高斯噪音的模拟信道,但还有二进制信道模式的模式的对应定理这里略述)•信源编码——包含涉及无损编码和有损编码的两个定理;•信源采样——奈奎斯特-香农采样定理但国内资料常说的“香农三定理”是指前两个部分所涉及的的三个定理,下面主要详述这三个定理:有噪音的模拟信道编码定理(国外资料一般称“香农-哈特利定理”)注意:这个定理在国外资料中才通常被简称为“香农定理”这个定理通俗地说,就是首先表明了如果传输信息的信道存在噪音,但是也可以实现信息的传递,然后可以根据带宽等参数计算出信息传递的最大的有效速率。

这可以通俗地类比我们熟悉的语音通话,虽然在电话里面有很多电流噪音或者环境噪音,但是我们仍然可以听懂对方讲的话。

因为我们用语音和语言对信息进行了双重的编码,“语音”这种编码可以在大量噪音干扰的情况下仍然能够工作,那是因为我们的声音通常有一个带宽,但噪音往往只是某一个频率的声音,不一定能够覆盖我们嗓音的全频段。

信息论之父—香农

信息论之父—香农20世纪中叶,信息论、控制论、系统论等标新立异的新理论相继问世,有力地“晃动”着传统的科学框架。

克劳德·香农是一位美国数学工程师,作为信息论的创始人,人们认为他是20世纪最伟大的科学家之一。

他在通信技术与工程方面的创造性工作,为计算机与远程通信奠定了坚实的理论基础。

人们尊崇香农为信息论及数字通信时代的奠基之父。

确实,他对人类的贡献超过了一般的诺贝尔获奖者。

回顾20世纪的信息革命风暴,经他阐明的信息概念、连同“比特”这个单位已经深入人心,成为今天日常生活都离不开的词汇。

家庭背景克劳德·香农(Claude Elwood Shannon,1916-2001)1916年4月30日诞生于美国密西根州的Petoskey。

在Gaylord小镇长大,当时镇里只有三千居民。

父亲是该镇的法官,他们父子的姓名完全相同,都是Claude Elwood Shannon。

母亲是镇里的中学校长,姓名是Mabel Wolf Shannon。

他生长在一个有良好教育的环境,不过父母给他的科学影响好像还不如祖父的影响大。

香农的祖父是一位农场主兼发明家,发明过洗衣机和许多农业机械,这对香农的影响比较直接。

此外,香农的家庭与大发明家爱迪生(Thomas Alva Edison,1847-1931)还有远亲关系。

香农的大部分时间是在贝尔实验室和MIT(麻省理工学院)度过的。

在“功成名就”后,香农与玛丽(Mary Elizabeth Moore)1949年3月27日结婚,他们是在贝尔实验室相识的,玛丽当时是数据分析员。

他们共有四个孩子:三个儿子Robert、James、Andrew Moore和一个女儿Margarita Catherine。

后来身边还有两个可爱的孙女。

年2月24日,香农在马萨诸塞州Medford辞世,享年85岁。

贝尔实验室和MIT发表的讣告都尊崇香农为信息论及数字通信时代的奠基之父。

攻读学位年香农在密西根大学获得数学与电气工程学士学位,然后进入MIT念研究生。

香农的信息论的局限性与推广研究

扩展信息论模型

为了克服香农信息论的局限性,需要进 一步发展和完善信息论模型,以适应更 广泛的应用场景。

VS

结合其他理论

可以尝试将香农信息论与其他理论进行结 合,例如统计学习理论、复杂系统理论等 ,以实现更有效的信息处理和分析。

04

香农信论的应用场景

密码学中的应用

密码学基础

01

香农信息论为密码学提供了理论基础,包括对称加密、非对称

香农信息论的主要内容

• 香农信息论主要包括信息的度量、信息的传递和信息的压缩三个方面。其中, 信息的度量是指如何评估信息的不确定性,信息的传递是指如何在信道中传输 信息,信息的压缩则是指如何有效地存储和传输信息。

香农信息论的发展历程

• 香农信息论自提出以来,经历了多个发展阶段。在早期,香农信息论主要关注于通信领域中的一些基本问题, 如信道的容量、噪声和失真等。随着计算机科学和人工智能的不断发展,香农信息论逐渐被应用于这些领域, 以解决一些与信息和知识处理相关的问题。

缺乏对信息来源和传播方式的研究

香农信息论主要关注信息的量和质量,但并未涉及信息的来 源和传播方式。在现实生活中,信息的来源和传播方式对信 息的价值和影响力有着重要影响。

对于信息的来源,需要考虑信息的产生背景、可信度、权威 性等因素;对于信息的传播方式,需要考虑信息的传播途径 、受众群体、传播效果等因素。这些因素在香农信息论中并 未涉及,需要进一步拓展研究领域。

02

香农信息论的局限性

只能处理离散信息,难以处理连续信息

香农信息论主要针对离散信息进行建模和分析,例如二进制或有限字符集等。然而,在现实世界中, 连续信息更为普遍,如语音、图像和视频等。香农信息论难以直接应用于这些连续信息领域,需要进 一步的研究和扩展。

数学中的信息论与编码理论

数学中的信息论与编码理论在没有信息论和编码理论的帮助下,我们现代社会的通信系统几乎无法存在。

信息论和编码理论是数学中一个重要的分支,它们的发展不仅深刻影响了通信技术的进步,也在其他领域起到了重要的作用。

本文将探讨数学中的信息论与编码理论的基本概念和应用。

一、信息论信息论是由美国数学家克劳德·香农在20世纪40年代提出的一门学科。

它的研究对象是信息,旨在衡量信息的传输效率和极限。

那么,什么是信息?信息是我们从一个消息中获得的知识或内容。

在信息论中,信息量的单位被称为“比特”(bit),它表示信息的最基本单位。

例如,当我们投掷一枚公平的硬币,出现正面的概率为50%,我们可以用1比特来表示这个消息,因为它提供了一个二进制的选择(正面或反面)。

在信息论中,还有一个重要的概念是“信息熵”。

信息熵用来衡量一个随机变量的不确定性。

一个有序的事件具有较低的信息熵,而一个随机的事件具有较高的信息熵。

例如,当我们已知一个硬币是公平的时候,投掷获得的信息熵最高,因为我们无法预测结果。

二、编码理论编码理论是信息论的一个重要组成部分。

它研究如何将信息转化为机器能够识别和处理的形式。

编码理论可以分为源编码和信道编码两个方面。

1. 源编码源编码是将源数据(比如文本、图像、声音等)进行压缩和表示的过程。

它的目标是将数据表示为更紧凑的形式,以便于存储和传输。

最著名的源编码算法之一是赫夫曼编码,它利用不同符号出现的频率进行编码,将出现频率较高的符号用较短的编码表示,从而实现数据的压缩。

2. 信道编码信道编码是为了在噪声干扰的信道中可靠地传输信息而设计的编码方法。

它通过引入冗余来纠正或检测传输过程中的错误。

最常见的信道编码方法是奇偶校验码和循环冗余检验码(CRC)。

这些编码方法能够检测和校正一定数量的错误,从而提高传输的可靠性。

三、信息论与编码理论的应用信息论和编码理论不仅在通信领域中发挥着重要作用,也在其他领域有广泛的应用。

香农定理

谈香农定理克劳德.香农,1916年4月30日出生于美国密歇根州的加洛德,他是信息时代的奠基人。

他这一生的两大贡献之一便就是信息论,信息熵的概念提出和香农公式。

信息传输给出基本数学模型的核心人物是香农。

1948年香农长达数十页的论文“通信的数学理论”成了信息论正式诞生的里程碑。

在他的通信数学模型中,清楚地提出信息的度量问题,他把哈特利的公式扩大到概率pi不同的情况,得到了著名的计算信息熵H的公式:H=∑-pi log pi如果计算中的对数log是以2为底的,那么计算出来的信息熵就以比特(bit)为单位。

今天在计算机和通信中广泛使用的字节 (Byte)、KB、MB、GB等词都是从比特演化而来。

“比特”的出现标志着人类知道了如何计量信息量。

香农的信息论为明确什么是信息量概念作出决定性的贡献。

香农在进行信息的定量计算的时候,明确地把信息量定义为随机不定性程度的减少。

这就表明了他对信息的理解:信息是用来减少随机不定性的东西。

或香农逆定义:信息是确定性的增加。

事实上,香农最初的动机是把电话中的噪音除掉,他给出通信速率的上限,这个结论首先用在电话上,后来用到光纤,现在又用在无线通信上。

我们今天能够清晰地打越洋电话或卫星电话,都与通信信道质量的改善密切相关。

香农定理:香农定理描述了有限带宽、有随机热噪声信道的最大传输速率与信道带宽、信号噪声功率比之间的关系.在有随机热噪声的信道上传输数据信号时,数据传输率Rmax与信道带宽B,信噪比S/N关系为: Rmax=B*Log2(1+S/N)。

在信号处理和信息理论的相关领域中,通过研究信号在经过一段距离后如何衰减以及一个给定信号能加载多少数据后得到了一个著名的公式,叫做香农(Shannon)定理。

它以比特每秒(bps)的形式给出一个链路速度的上限,表示为链路信噪比的一个函数,链路信噪比用分贝(dB)衡量。

因此我们可以用香农定理来检测电话线的数据速率。

香农定理由如下的公式给出: C=B*log2(1+S/N) 其中C是可得到的链路速度也就是信道容量,B是链路的带宽,S是平均信号功率,N是平均噪声功率,信噪比(S/N)通常用分贝(dB)表示,分贝数=10×log10(S/N)。

第六章 香农理论

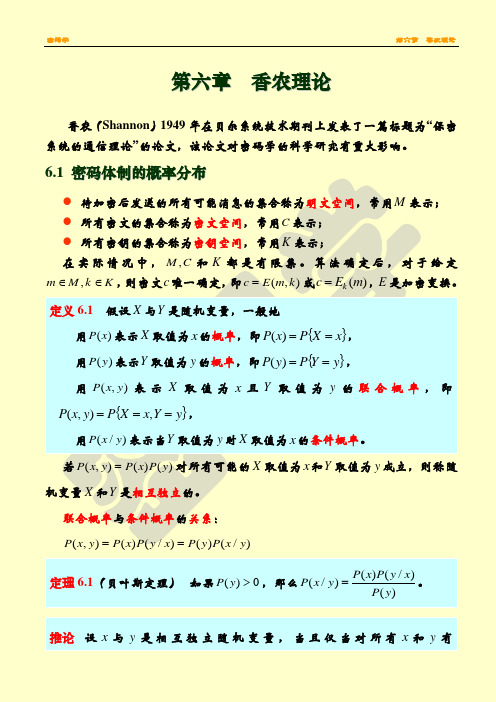

第六章 香农理论香农(Shannon )1949年在贝尔系统技术期刊上发表了一篇标题为“保密系统的通信理论”的论文,该论文对密码学的科学研究有重大影响。

6.1 密码体制的概率分布● 待加密后发送的所有可能消息的集合称为明文空间,常用M 表示; ● 所有密文的集合称为密文空间,常用C 表示; ● 所有密钥的集合称为密钥空间,常用K 表示;在实际情况中,C M ,和K 都是有限集。

算法确定后,对于给定K k M m ∈∈,,则密文c 唯一确定,即),(k m E c =或)(m E c k =,E 是加密变换。

定义6.1 假设X 与Y 是随机变量,一般地用)(x P 表示X 取值为x 的概率,即{}x X P x P ==)(, 用)(y P 表示Y 取值为y 的概率,即{}y Y P y P ==)(,用),(y x P 表示X 取值为x 且Y 取值为y 的联合概率,即{}y Y x X P y x P ===,),(,用)/(y x P 表示当Y 取值为y 时X 取值为x 的条件概率。

若)()(),(y P x P y x P =对所有可能的X 取值为x 和Y 取值为y 成立,则称随机变量X 和Y 是相互独立的。

联合概率与条件概率的关系:)/()()/()(),(y x P y P x y P x P y x P ==定理6.1(贝叶斯定理) 如果0)(>y P ,那么)()/()()/(y P x y P x P y x P =。

推论 设x 与y 是相互独立随机变量,当且仅当对所有x 和y 有)()/(x P y x P =。

如果给定一个密码体制,则关于它的明文、密文与密钥的联合概率分布为),,(k c m P 。

由给定密码体制的联合概率分布可以确定该体制的各种边际分布与条件分布,并由此确定一系列信息的度量。

常用边际分布与条件分布如下:●明文与密钥的联合概率分布为K k M m k c m P k m P Cc ∈∈=∑∈,,),,(),(●明文与密文的联合概率分布为C c M m k c m P c m P Kk ∈∈=∑∈,,),,(),(●明文的概率分布为M m k m P m P Kk ∈=∑∈,),()(●密钥的概率分布为K k k m P k P Mm ∈=∑∈,),()(●密文的概率分布为C c c m P c P Mm ∈=∑∈,),()(由联合概率分布与边际分布产生的条件概率分布为●密文关于明文和密钥的条件概率分布为),(),,(),/(k m P c k m P k m c P =●密文关于明文的条件概率分布为)(),()/(m P c m P m c P =●明文关于密文的条件概率分布为)(),()/(c P c m P c m P =●密钥关于密文的条件概率分布为)(),()/(c P c k P c k P =上述分布反映了密码体制中的数据结构关系。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

l

时间信源输出什么符号,不但与前一(

l

-1

)时刻信源所处的状态和所输

出的符号有关,

而且一直延续到与信源初始所处的状态和所输出的符号有关。

一般马尔可夫

信源的信息熵是其平均符号熵的极限值,它的表达式就是:

1

2

1

(

)

lim

(

)

N

N

H

H

X

H

X

X

X

N

.

二.平均互信息

信道的任务是以信号方式传输信息和存储信息的。我们知道信源输出的是携带着信息

来,

在通信系统的传输过程当中,

收信者在收到消息以前是不知道消息的具体内容的。

在收

到消息以前,

收信者无法判断发送者将会发来描述何种事物运动状态的的具体消息,

它也无

法判断是描述这种状态还是那种状态。

或者,

由于干扰的存在,

它也不能断定所得到的消息

是否正确和可靠。这样,收信者存在“不知”

,

“不确定性”

。那么通过消息的传递,收信者

连续信源的熵的定义与离散信源熵的定义方式一样,

只不过离散情况下

是每个信源符号的信值。

连续信源也可以称之为差熵。

接下来由两种特殊连续信源的差熵需要计算。

均匀分布连

续信源的熵值,和高斯信源的熵值。

连续信源的差熵具有以下的一些基本性质:

可加性,

即描述信源

X

输出长度为

2

的序列的平均不确定性,或者说所含有的信息量。可以用

1

1

2

2

(

)

H

X

X

作为二维离散平稳信

源

X

的信息熵的近视值。

除了平稳离散信源之外,还存在着非平稳离散信源。在非平稳离散信源中有一类特殊

的信源。

这种信源输出的符号序列中符号之间的依赖关系是有限的,

这种关系满足我们在随

机过程中讲到的马尔可夫链的性质,

对于串接信道

X

、

Y

、

Z

有

(

;

)

(

;

)

I

XY

Z

I

Y

Z

当且仅当

P(z|xy)=P(z|y)

时,等式成立。

串联信道的信道容量与串接的信道数有关,

串接的无源数据处理信道越多,

其信道容量

可能会越小,当串接信道数无限大时,信道容量就有可能接近零。

三.连续信道

前面讲到的离散信道其输出的消息是属于时间离散、

取值有限或可数的随机序列,

对于不同的连续信道和波形信道,

它们存

在的噪声形式不同,

信道带宽及对信号的各种限制不同,

所以具有不同的信道容量。

我们先

来讨论单符号高斯加性信道的信道容量,

单符号高斯加性信道是指信道的输入和输出都是取

值连续的一维随机变量,而加入信道的噪声是一维高斯加性噪声。它的信道容量表达式为:

1

log(1

)

2

s

n

P

C

第二项是信道矩阵分布行矢量的熵

函数。比方说,前面提到的,二元对称信道的信道容量就是

1

(

)(

/

)

C

H

p

比

特

符

号

除了前面论述到得单符号离散信道之外,

还有独立并联信道和串联信道。

一般的独立并

联信道如下:

图

1

独立并联信道的信道容量不大于各个信道的信道容量之和,只有当输入符号

i

X

相互独

立,且输入符号

i

X

的概率分布达到各信道容量的最佳输入分布时,独立并联信道的信道容

知道了消息的具体内容,原先的不确定性就部分的或者全部消除了。因此,信息传输之后,

接收到一定的信息。

除非信道输入和

输出是统计独立时,

才接收不到任何信息。

因为在这样的统计独立信道中,

传输的信息全部

损失在信道中,

以致没有任何信息传输到终端,

但也不会失去已经知道了的信息。

第二,

平

均互信息量的大小不大于输入输出任一者的信息熵。即从一事件提取关于另一事件的信息

量,

最多只有另一事件的信息熵那么多,

因此可用马尔可夫链来处理。

马尔可夫信源是一种非常

重要的非平稳离散信源。那么马尔可夫信源需要满足一下两个条件:

(

1

)

某一时刻信源符号的输出只与此刻信源所出的状态有关,而与以前的状态及以

前的输出符号都无关。

(

2

)

信源某

l

时刻所处的状态由当前的输出符号和前一时刻(

l

-1

)信源的状态唯一

决定。

马尔可夫信源的输出的符号是非平稳的随机序列,它们的各维概率分布随时间的推移

为离散信道,连续信道,半离散或半连续信道和波形信道。

为了能够引入平均互信息量的定义,

首先要看一下单符号离散信道的数学模型,

在这种

信道中,输出变量和输入变量的传递概率关系:

(

|

)

(

|

)

(

|

)(

1,

2,

,

;

1,

2,

,

)

j

i

j

i

P

y

x

P

y

b

x

a

P

b

a

i

r

j

s

传递概率所表达的意思是,在信道当输入符号为

a

,信道的输出端收到

它不会仅仅只发出一个消息,

这个消息发生的概率也不是

1

。

必然会有别的可能的情况发生。那么对于一个信源来讲,它所包含的信息量是什么样子的,

我们可以用平均自信息量来度量,

即对每个事件各自所携带的信息量做一个加权平均。

即可

以得到信源的平均自信息量。

信息熵的定义如下:

)

(

log

)

(

)

(

1

log

)

(

1

1

i

q

i

i

离散随机信源是一类最基本的信源,

信源输出是单个的符

号的消息,

并且消息之间是两两互不相容的。

假设有个一维离散无记忆信源,

它的概率分布

函数决定了他所携带的信息。该信源空间中共有

q

个符号,每个符号发生的概率是

Pi,

那么

发出某个符号所携带的信息量是

-logPi

,

由于概率是在

0

和

1

之间的,

使得每一事件的信息

量是非负的。如果该事件发生的概率是

P

其中,

i

n

P

是输入信号

X

的平均功率,

n

P

是高斯噪声的平均功率。只有当信道的输入信

号是均值为零,平均功率为

s

P

高斯分布的随机变量时。信息传输率才能达到这个最大值。

注水定理是对于多维无记忆高斯加性连续信道的个信道功率分配问题而提出来的,

对于

多维的情况,

因为输入的是平稳随机序列,

输出的也是平稳随机序列,

香农信息论的基本理论探究

摘要:信息是自从人类出现以来就存在于这个世界上了,天地万物,飞禽走兽,以

及人类的生存方式都离不开信息的产生和传播。

人类每时每刻都在不停的接受信息,

传播信

息,以及利用信息。从原来的西汉时期的造纸,到近代西方的印刷术,以及现在的计算机,

信息技术在人类历史的进程当中随着生产力的进步而发展。

我们可以将它等价为

N

个独立并联加性信道。假如各单元时刻上的噪声仍是均值为零,方差为不同的

i

n

P

的高斯

5

噪声,

单输入信号的总体平均功率受限,

此时我们可以使用拉格朗日乘子法莱确定平均功率

的分配。

当

N

个独立并联的组合高斯加性信道,

各分信道的噪声平均功率不相等时,

为了达

到最大的信息传输率,

要对输入信号的总能量适当地进行分配。

Y

的

符号后,对于输入端的变量

X

尚存在的平均不确定性。即信道疑义度:

,

1

(

|

)

(

)

lo

g

(

|

)

X

Y

H

X

Y

P

x

y

P

x

y

这个信道的疑义度是由于干扰噪声引起的。

前面我们看到了输出端接收到输出符号前关

于变量

X

的先验熵,以及接收到输出符号后关于输入变量

X

的平均不确定性,通过信道传

输消除了一定的不确定性,获得了一定的信息。那么定义单符号信道的平均互信息量

的消息。

消息必须要转换成能在信道中传输或存储的信号,

然后通过信道传送到收信者。

并

且认为噪声或干扰主要从信道中引入。

信道根据用户的多少,

可以分为两端信道,

多端信道。

根据信道输入端和输出端的关联,

可以分为无反馈信道,

反馈信道。

根据信道的参数与时间

的关系信道可以分为固定参数信道,

时变参数信道。

根据输入和输出信号的统计特性可以分

其统

计特性可以用联合概率分布来描述。

但是语音信号,

电视信号都是连续波形信号。

在某一固

定的时刻,

这样的可能输出即是连续的又是随机的,

我们称之为随机波形信源。

它是用随机

过程描述输出消息的信源。用连续随机变量描述输出消息的信源就是连续信源。