robots.txt规则

robots.xt文件存在限制指令

利用站长工具对修改后的robots文件迚行再次检查, 从而保证书写的内容正确无误,可以用站长工具中 的抓取测试一下全站抓取情况,如果抓取失败继续 修改。 步骤4。等待 Robots文件生效时需要时间的,一般生效时间在一周 左右,如果网站蜘蛛抓取频繁的话会提前生效。

Robots.txt文件书写的常见错误

解决方案一下, 看看是不是存在哪些内容被限制了,并且找到被限制 的语句是哪一句。 步骤2、修改。 对于错误的语句迚行修改。一般都是在Disallow中出现 错误才会导致这样的结果产生的。因此在寻找的时候 主要在Disallow中查找需要修改的内容在哪里。

Robots.txt存在限制指令

原因

在站长工具中对于网站robots检测的时候有的时候会

出现这样的一句提示。 引起这个的主要原因就是网站的robots文件中有些内 容写的不正确从而导致网站的某些路径不能正常抓取。 产生这样的错误,对于网站有一定的影响,虽然说 robots文件搜索引擎不一定完全遵守,但是一般情况 下还是遵守的。

1、书写的时候忽略大小写,在书写Robots文件的时

候一定要注意,第一个字母是大写的。 2、书写的时候一定要注意空格,很多时候忽略掉空 格的话会造成网站整站不能被蜘蛛正常抓取。 3、对于不太熟悉的符号尽量少用或者不用。 4、如果自己不会书写的话可以借助站长工具后台迚 行生成。 5、一般情况下网站的robots文件是在网站的根目录下 存放,并且是txt格式的,不能出现其他格式。

6、robots文件中的网站地图能够很好的指引蜘蛛迚行

抓取,因此在书写的时候一定要把网站地图写到网站 中去。 7、robots书写的时候不是用的绝对地址而是相对地址, 即/来代替网站的地址,一般不会出现绝对的URL的

robots.txt的语法和写法详解

robots.txt的语法和写法详解robots.txt是⼀个纯⽂本⽂件,是搜索引擎蜘蛛爬⾏⽹站的时候要访问的第⼀个⽂件,当蜘蛛访问⼀个站点时,它会⾸先检查该站点根⽬录下是否存在robots.txt,如果存在,搜索机器⼈就会按照该⽂件中的内容来确定访问的范围,相当于⽹站与搜索引蜘蛛遵循协议,如果该⽂件不存在,所有的搜索蜘蛛将能够访问⽹站上所有没有被屏蔽的⽹页,作为站长,我们就可以通过robots.txt⽂件屏蔽掉错误的页⾯和⼀些不想让蜘蛛爬取和收录的页⾯,那么robots.txt该怎么样写呢? robots的语法: 1、User-agent 定义搜索引擎。

⼀般情况下,⽹站⾥⾯都是:User-agent: *,这⾥*的意思是所有,表⽰定义所有的搜索引擎。

⽐如,我想定义百度,那么就是User-agent: Baiduspider;定义google,User-agent: Googlebot。

2、Disallow 禁⽌爬取。

如,我想禁⽌爬取我的admin⽂件夹,那就是Disallow: /admin/。

禁⽌爬取admin⽂件夹下的login.html, Disallow: /admin/login.html。

3、Allow 允许。

我们都知道,在默认情况下,都是允许的。

那为什么还要允许这个语法呢?举个例⼦:我想禁⽌admin⽂件夹下的所有⽂件,除了.html的⽹页,那怎么写呢?我们知道可以⽤Disallow⼀个⼀个禁⽌,但那样太费时间很精⼒了。

这时候运⽤Allow就解决了复杂的问题,就这样写: Allow: /admin/.html$ Disallow: /admin/。

4、$ 结束符。

例:Disallow: .php$ 这句话的意思是,屏蔽所有的以.php结尾的⽂件,不管前⾯有多长的URL,如abc/aa/bb//index.php 也是屏蔽的。

5、* 通配符符号0或多个任意字符。

例:Disallow: *?* 这⾥的意思是屏蔽所有带“?”⽂件,也是屏蔽所有的动态URL。

Robots协议(爬虫协议、机器人协议)

Robots协议(爬⾍协议、机器⼈协议)Robots协议(也称为爬⾍协议、机器⼈协议等)的全称是“⽹络爬⾍排除标准”(Robots Exclusion Protocol),⽹站通过Robots协议告诉搜索引擎哪些页⾯可以抓取,哪些页⾯不能抓取。

____________________________________Robots协议也称为爬⾍协议、爬⾍规则、机器⼈协议,是⽹站国际互联⽹界通⾏的道德规范,其⽬的是保护⽹站数据和敏感信息、确保⽤户个⼈信息和隐私不被侵犯。

“规则”中将搜索引擎抓取⽹站内容的范围做了约定,包括⽹站是否希望被搜索引擎抓取,哪些内容不允许被抓取,⽽⽹络爬⾍可以据此⾃动抓取或者不抓取该⽹页内容。

如果将⽹站视为酒店⾥的⼀个房间,robots.txt就是主⼈在房间门⼝悬挂的“请勿打扰”或“欢迎打扫”的提⽰牌。

这个⽂件告诉来访的搜索引擎哪些房间可以进⼊和参观,哪些不对搜索引擎开放。

____________________________________robots.txt(统⼀⼩写)是⼀种存放于⽹站根⽬录下的ASCII编码的⽂本⽂件,它通常告诉⽹络搜索引擎的漫游器(⼜称⽹络蜘蛛),此⽹站中的哪些内容是不应被搜索引擎的漫游器获取的,哪些是可以被漫游器获取的。

因为⼀些系统中的URL是⼤⼩写敏感的,所以robots.txt的⽂件名应统⼀为⼩写。

robots.txt应放置于⽹站的根⽬录下。

如果想单独定义搜索引擎的漫游器访问⼦⽬录时的⾏为,那么可以将⾃定的设置合并到根⽬录下的robots.txt,或者使⽤robots元数据(Metadata,⼜稱元資料)。

robots.txt协议并不是⼀个规范,⽽只是约定俗成的,所以并不能保证⽹站的隐私。

注意robots.txt是⽤字符串⽐较来确定是否获取URL,所以⽬录末尾有与没有斜杠“/”表⽰的是不同的URL。

robots.txt允许使⽤类似"Disallow: *.gif"这样的通配符[1][2]。

robots.txt文件的作用以及写法

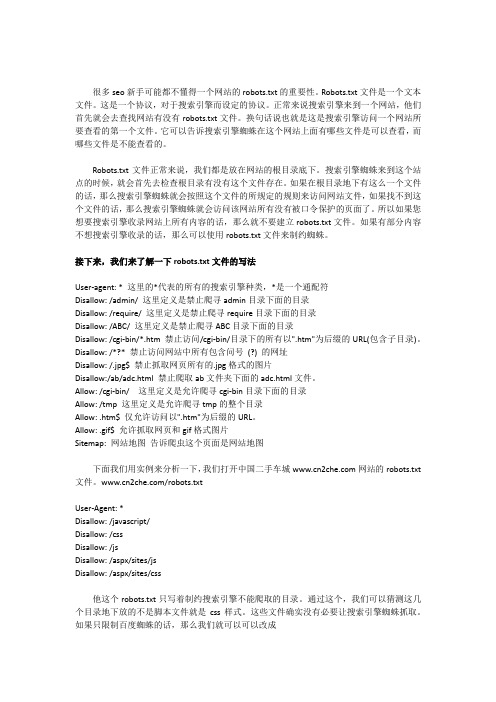

很多seo新手可能都不懂得一个网站的robots.txt的重要性。

Robots.txt文件是一个文本文件。

这是一个协议,对于搜索引擎而设定的协议。

正常来说搜索引擎来到一个网站,他们首先就会去查找网站有没有robots.txt文件。

换句话说也就是这是搜索引擎访问一个网站所要查看的第一个文件。

它可以告诉搜索引擎蜘蛛在这个网站上面有哪些文件是可以查看,而哪些文件是不能查看的。

Robots.txt文件正常来说,我们都是放在网站的根目录底下。

搜索引擎蜘蛛来到这个站点的时候,就会首先去检查根目录有没有这个文件存在。

如果在根目录地下有这么一个文件的话,那么搜索引擎蜘蛛就会按照这个文件的所规定的规则来访问网站文件,如果找不到这个文件的话,那么搜索引擎蜘蛛就会访问该网站所有没有被口令保护的页面了。

所以如果您想要搜索引擎收录网站上所有内容的话,那么就不要建立robots.txt文件。

如果有部分内容不想搜索引擎收录的话,那么可以使用robots.txt文件来制约蜘蛛。

接下来,我们来了解一下robots.txt文件的写法User-agent: * 这里的*代表的所有的搜索引擎种类,*是一个通配符Disallow: /admin/ 这里定义是禁止爬寻admin目录下面的目录Disallow: /require/ 这里定义是禁止爬寻require目录下面的目录Disallow: /ABC/ 这里定义是禁止爬寻ABC目录下面的目录Disallow: /cgi-bin/*.htm 禁止访问/cgi-bin/目录下的所有以".htm"为后缀的URL(包含子目录)。

Disallow: /*?* 禁止访问网站中所有包含问号(?) 的网址Disallow: /.jpg$ 禁止抓取网页所有的.jpg格式的图片Disallow:/ab/adc.html 禁止爬取ab文件夹下面的adc.html文件。

Allow: /cgi-bin/这里定义是允许爬寻cgi-bin目录下面的目录Allow: /tmp 这里定义是允许爬寻tmp的整个目录Allow: .htm$ 仅允许访问以".htm"为后缀的URL。

zblogrobots写法

zblogrobots写法

在Z-BlogPHP 中,robots.txt 是用于搜索引擎爬虫控制网站爬取行为的文本文件。

Z-BlogPHP 提供了一个插件`ZC_ROBOTS`,该插件使你可以方便地编辑和生成robots.txt 文件。

以下是使用`ZC_ROBOTS` 插件的简单写法:

1. 下载和安装插件:

-将插件文件解压缩,并将文件夹放置在Z-BlogPHP 的`zb_users/plugin` 目录下。

-在Z-BlogPHP 后台的插件管理页面启用`ZC_ROBOTS` 插件。

2. 编辑robots.txt:

-在Z-BlogPHP 后台,进入"插件" -> "ZC_ROBOTS" 配置页面。

-在配置页面中,你可以直接编辑robots.txt 内容。

3. 设置robots.txt 规则:

-使用合适的robots.txt 规则,例如禁止爬虫访问某些页面或目录。

```plaintext

User-agent: *

Disallow: /private/

Allow: /public/

```

上述规则表示允许所有爬虫访问`/public/` 目录,但禁止访问`/private/` 目录。

4. 保存配置:

-在编辑完成robots.txt 后,记得保存配置。

5. 生效检查:

-访问你的网站的robots.txt 文件路径,确保配置生效。

robots.txt文件中应该屏蔽哪些目录

robots.txt文件中应该屏蔽哪些目录一个合格的网站,必须在根目录下包含一下robots.txt文件,这个文件的作用对所有运营网站的朋友来说并不陌生,网上也提供了很多制作robots.txt 文件的方法和软件,可谓相当方便。

但是,你真的知道网站的robots.txt文件设置是否合理,哪些文件或者目录需要屏蔽、哪些设置方法对网站运营有好处?那下面带着这些疑问,笔者会进行详细的解答,希望对新手站长朋友们有所帮助,老鸟勿喷。

一、什么是robots.txt笔者引用百度站长工具中后段话来解释。

搜索引擎使用spider程序自动访问互联网上的网页并获取网页信息。

spider在访问一个网站时,会首先会检查该网站的根域下是否有一个叫做 robots.txt的纯文本文件,这个文件用于指定spider在您网站上的抓取范围。

您可以在您的网站中创建一个robots.txt,在文件中声明该网站中不想被搜索引擎收录的部分或者指定搜索引擎只收录特定的部分。

二、robots.txt文件对网站有什么好处1、快速增加网站权重和访问量;2、禁止某些文件被搜索引擎索引,可以节省服务器带宽和网站访问速度;3、为搜索引擎提供一个简洁明了的索引环境三、哪些网站的目录需要使用robots.txt文件禁止抓取1)、图片目录图片是构成网站的主要组成元素。

随着现在建站越来越方便,大量CMS的出现,真正做到了会打字就会建网站,而正是因为如此方便,网上出现了大量的同质化模板网站,被反复使用,这样的网站搜索引擎是肯定不喜欢的,就算是你的网站被收录了,那你的效果也是很差的。

如果你非要用这种网站的话,建议你应该在robots.txt文件中进行屏蔽,通常的网站图片目录是:imags 或者 img;2)、网站模板目录如上面图片目录中所说,CMS的强大和灵活,也导致了很多同质化的网站模板的出现和滥用,高度的重复性模板在搜索引擎中形成了一种冗余,且模板文件常常与生成文件高度相似,同样易造成雷同内容的出现。

robots 写法 教程

robots.txt一、什么是robots.txt? (1)二、robots.txt文件的格式 (1)三、robots.txt写法教程 (2)四、常见Robots名字 (4)附一: (4)附二: (4)一、什么是robots.txt?robots(又称spider),在这个文件中可声明该网站不想被搜索引擎访问、收录的部分,或指定搜索引擎只收录指定的内容。

robotx.txt是一种存放于网站目录下的ASCII编码的文本文件,因为一些系统中的URL 是大小写敏感的,所以robots.txt的文件名应统一为小写。

robotx.txt协议并不是一个规范,而只是约定俗成的,所以并不能保证网站的隐私。

二、robots.txt文件的格式User-agent:该项的值用于描述搜索引擎robot的名字,在"robots.txt"文件中,如果有多条User-agent 记录说明有多个robot会受到该协议的限制,对该文件来说,至少要有一条User-agent记录。

如果该项的值设为*,则该协议对任何机器人均有效,在"robots.txt"文件中,"User-agent:*"这样的记录只能有一条。

Disallow:该项的值用于描述不希望被访问到的一个URL,这个URL可以是一条完整的路径,也可以是部分的,任何以Disallow开头的URL均不会被robot访问到。

例如"Disallow:/help"对/help.html 和/help/index.html都不允许搜索引擎访问,而"Disallow:/help/"则允许robot访问/help.html,而不能访问/help/index.html。

任何一条Disallow记录为空,说明该网站的所有部分都允许被访问,在"/robots.txt"文件中,至少要有一条Disallow记录。

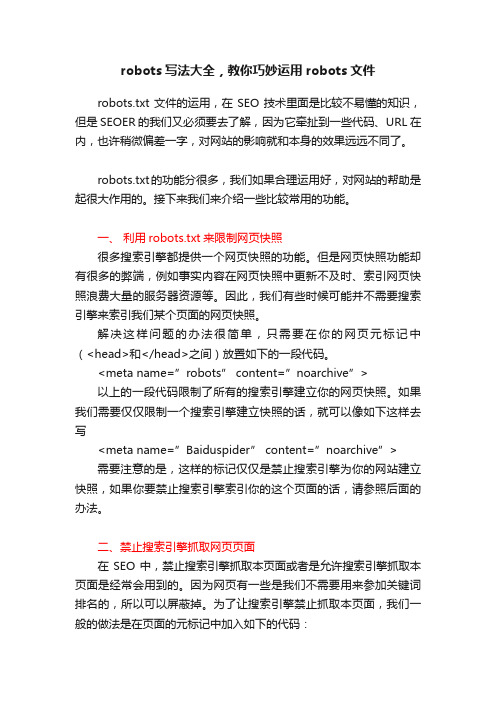

robots写法大全,教你巧妙运用robots文件

robots写法大全,教你巧妙运用robots文件robots.txt文件的运用,在SEO技术里面是比较不易懂的知识,但是SEOER的我们又必须要去了解,因为它牵扯到一些代码、URL在内,也许稍微偏差一字,对网站的影响就和本身的效果远远不同了。

robots.txt的功能分很多,我们如果合理运用好,对网站的帮助是起很大作用的。

接下来我们来介绍一些比较常用的功能。

一、利用robots.txt来限制网页快照很多搜索引擎都提供一个网页快照的功能。

但是网页快照功能却有很多的弊端,例如事实内容在网页快照中更新不及时、索引网页快照浪费大量的服务器资源等。

因此,我们有些时候可能并不需要搜索引擎来索引我们某个页面的网页快照。

解决这样问题的办法很简单,只需要在你的网页元标记中(<head>和</head>之间)放置如下的一段代码。

<meta name=”robots”content=”noarchive”>以上的一段代码限制了所有的搜索引擎建立你的网页快照。

如果我们需要仅仅限制一个搜索引擎建立快照的话,就可以像如下这样去写<meta name=”Baiduspider”content=”noarchive”>需要注意的是,这样的标记仅仅是禁止搜索引擎为你的网站建立快照,如果你要禁止搜索引擎索引你的这个页面的话,请参照后面的办法。

二、禁止搜索引擎抓取网页页面在SEO中,禁止搜索引擎抓取本页面或者是允许搜索引擎抓取本页面是经常会用到的。

因为网页有一些是我们不需要用来参加关键词排名的,所以可以屏蔽掉。

为了让搜索引擎禁止抓取本页面,我们一般的做法是在页面的元标记中加入如下的代码:<META NAME=”ROBOTS”CONTENT=”NOINDEX,FOLLO W”><meta content=’***************’ name=description>在这里,META NAME=”ROBOTS”是泛指所有的搜索引擎的,在这里我们也可以特指某个搜索引擎,例如META NAME=”Googlebot”、META NAME=”Baiduspide”、META NAME=”www.********.com” 等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

robots.txt规则

robots.txt是一种文件,用于告诉搜索引擎爬虫哪些页面可以被访问,哪些不可以被访问。

它通常放置于网站的根目录下,即域名后面的第一个文件。

网站管理员可以通过修改robots.txt来控制搜索引擎爬虫的行为,从而保证网站内容的安全和正确性。

下面是robots.txt规则及其解释。

User-agent:

Disallow:

这是robots.txt文件中最基本的规则,意思是所有的搜索引擎爬虫都不可以访问网站的任何页面。

这个规则的意思是所有的搜索引擎爬虫都不可以访问网站的任何页面。

这个规则通常比较危险,应该只在特殊情况下使用,比如网站被黑或者正在进行重大维护升级等。

这个规则的意思是只限制Google爬虫(googlebot)不能访问网站的/private/目录下的页面。

其他的搜索引擎爬虫依然可以访问这些页面。

User-agent: *

Disallow: /admin/

Disallow: /cgi-bin/

Disallow: /db/

Disallow: /includes/

Disallow: /modules/

Disallow: /tmp/

Disallow: /web_services/

Disallow: /xmlrpc/

这个规则禁止搜索引擎爬虫访问网站的管理员目录、cgi-bin目录、数据库目录、代码包含目录、模块目录、临时文件目录、Web服务目录和XML-RPC目录。

这些目录通常包含的是网站的敏感信息和业务数据,所以要严格控制访问权限。

这个规则是WordPress网站的标准robots.txt规则。

它禁止了Google爬虫访问网站

的说明文件、许可证文件、登录页面、XML-RPC文件以及WordPress的后台目录和核心文

件目录。

其他的搜索引擎爬虫也可以根据这个规则进行访问控制。

这个规则禁止搜索引擎爬虫访问网站的压缩文件、PDF文件、Word文件、Excel文件、PPT文件和Flash文件。

这些文件通常比较大,访问也会减缓网站内部的流程和用户体验。

如果网站需要公开这些文件,可以使用单独的文件夹来存储它们,并在robots.txt文件中进行具体指定。

Disallow: /search$

Disallow: /*?s=

这个规则禁止搜索引擎爬虫访问网站的搜索页面。

搜索页面通常不包含实际的内容,

而是一些带有搜索参数的页面,通过这些页面搜索引擎爬虫可以访问到网站内部的一些敏

感信息。

这个规则能够保护搜索页面和搜索参数的安全性。

总结一句话:robots.txt规则能够保护网站的数据安全和隐私保护,同时也可以提高搜索引擎爬虫的效率和精准度。