【上海交通大学】【神经网络原理与应用】作业3

【最新精选】神经网络习题

神经网络习题1.由单神经元构成的感知器网络,如下图所示:已知:x0 = 1 w0 = -1 w1= w2 = w3= w4 = 0.5假设:神经元的变换函数为符号函数:即:11y⎧=⎨-⎩ss≥<若该网络输入端有十种不同的输入模式:即: x1 x2 x3 x4 = 0 0 0 0 - 1 0 0 1 试分析该感知器网络对以上输入的分类结果。

2、对于图1所示的多层前馈神经网络,试利用BP算法训练该神经网络,使其能实现如下异或逻辑关系,即(0)(0)(2)x x x120 0 00 1 11 0 11 1 0 Array图1要求:(1)提交编写的程序;(2)对已训练的BP网络进行测试,并画出相应的学习曲线。

3、设有如下的二维非线性函数)cos()sin(),(2121x x x x f ππ=其中]1,1[1 x -∈,]1,1[2 x -∈。

试利用多层前馈神经网络实现该非线性映射。

建议按10.021==x x ∆∆的间隔均匀取点,利用上述解析式进行理论计算,将其结果用以构造输入输出训练样本集。

为了构造输入输出测试样本集,建议按12.021==x x ∆∆的均匀间隔进行采样。

要求:(1)提交编写的程序;(2)给出对网络进行测试后的精度分析结果,并画出相应的学习曲线;(3)分别画出按解析式计算的输出结果及已训练BP 神经网络输出结果的三维图形。

【附加总结类文档一篇,不需要的朋友可以下载后编辑删除,谢谢】2015年文化馆个人工作总结在XXXX年X月,本人从XXXX学院毕业,来到了实现我梦想的舞台--XX区文化馆工作。

在这里我用艰辛的努力,勤劳的付出,真诚而认真地工作态度认真的做好自身的每一项文化馆相关工作,取得了较为良好的工作业绩。

随着一场场活动的成功举办、一台台戏剧的成功出演,在这个带有着梦想和希望的舞台上,转眼之间我已在这里渡过了XX年的青春事业,我亦与舞台共同成长,逐步由一名青涩的毕业生,历练成为了今天的XXX。

神经网络理论及应用

神经网络理论及应用神经网络(neural network)是一种模仿人类神经系统工作方式而建立的数学模型,用于刻画输入、处理与输出间的复杂映射关系。

神经网络被广泛应用于机器学习、人工智能、数据挖掘、图像处理等领域,是目前深度学习技术的核心之一。

神经网络的基本原理是模仿人脑神经细胞——神经元。

神经元接收来自其他神经元的输入信号,并通过一个激活函数对所有输入信号进行加权求和,再传递到下一个神经元。

神经元之间的连接权重是神经网络的关键参数,决定了不同输入组合对输出结果的影响。

神经网络的分类可分为多层感知机、卷积神经网络、循环神经网络等等。

其中多层感知机(Multi-Layer Perceptron,MLP)是最基本的神经网络结构。

MLP由输入层、若干个隐藏层和输出层组成,每层包括多个神经元,各层之间被完全连接,每个神经元都接收来自上一层的输入信号并输出给下一层。

通过不断地训练神经网络,即对连接权重进行优化,神经网络能够准确地对所学习的模式进行分类、回归、识别、聚类等任务。

神经网络的应用非常广泛,涉及到各个领域。

在图像处理领域中,卷积神经网络(Convolutional Neural Network,CNN)是一种特殊的神经网络,主要应用于图像识别、图像分割等任务。

比如,在医疗领域中,CNN被用于对医学影像进行诊断,对疾病进行分类、定位和治疗建议的制定。

在语音处理领域中,循环神经网络(Recurrent Neural Network,RNN)因其能够处理序列数据而备受推崇,常用于文本生成、机器翻译等任务。

在自然语言处理领域中,基于预训练的语言模型(Pre-trained Language Models,PLM)在语言模型微调、文本分类和情感分析等方面表现出色。

尽管神经网络有诸多优点,但它也存在一些缺点。

其中最为突出的是过度拟合(overfitting),即模型过于复杂,为了适应训练集数据而使得泛化能力下降,遇到未知数据时准确率不高。

神经网络试卷

神经网络试卷一、填空题(30分)1、人工神经元网络是由大量的神经元网络通过极其丰富和完善的联接而构成的自适应非线性动力系统。

研究神经网络可以分为两个过程,即快过程,指神经网络的计算过程;慢过程,指神经网络的学习过程。

2、神经元(即神经细胞)是由细胞体、树突、轴突、和突触四个部分组成。

3、神经元的膜电位是指以外部电位作为参考电位的内部电位;静止膜电位是指没有输入时的膜电位,通常为-70mv;动作过程是指外界有输入时,受其影响膜电位的变化过程。

4、神经元的兴奋是指神经元产生膜电位约为100mv,时宽约为1ms的脉冲过程,膜电位的阈值为-55mv,大于-55mv则兴奋。

5、自组织过程就是一种非监督学习,这种学习的目的是从一组数据中提取有意义的特征或某种内在的规律性,它所遵循的规则一般是局部性的,即联接权的改变只与近邻单元的状态有关。

6、人工神经元网络按网络结构可分为前馈型和反馈型;按网络的性能分为连续性和离散性、确定性和随机性网络;按学习的方式可分为有导师和无导师学习;按照突触联接的性质分为一阶线性关联与高阶线性关联。

7、 D.D.Hebb学习规则是由Hebb D D提出来的,是最早、最著名的训练算法,Hebb规则假定:当两个神经细胞同时兴奋时,它们之间的联接强度应该加强。

在ANN中Hebb算法最简单的描述为:如果一个处理单元从另一个处理单元接收输入激励信号,而且两者都处于高激励电平,那么处理单元间的加权就应当增强。

8、误差反传算法的主要思想是把学习过程分为两个阶段:第一阶段(正向传播过程)给出输入信息通过输入层经隐含层逐层处理并计算每个单元的实际输出值;第二阶段(反向过程),若在输出层未能得到期望输出值,则逐层递归的计算实际输出与期望输出之差值(误差)以便根据此差值调节权值,具体些说,就是可对每一个权重计算出接收单元的误差值与发送单元的激活值积。

9、在统计模式识别和回归分析中,降低输入变量的维数是很重要得。

《人工神经网络:模型、算法及应用》习题参考答案

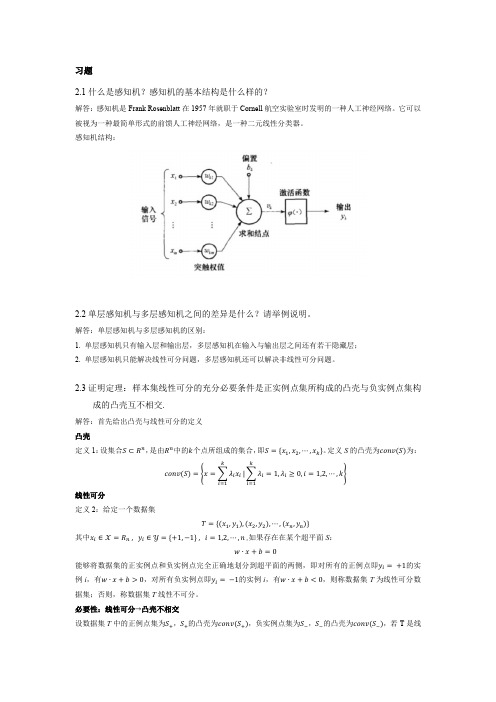

习题2.1什么是感知机?感知机的基本结构是什么样的?解答:感知机是Frank Rosenblatt在1957年就职于Cornell航空实验室时发明的一种人工神经网络。

它可以被视为一种最简单形式的前馈人工神经网络,是一种二元线性分类器。

感知机结构:2.2单层感知机与多层感知机之间的差异是什么?请举例说明。

解答:单层感知机与多层感知机的区别:1. 单层感知机只有输入层和输出层,多层感知机在输入与输出层之间还有若干隐藏层;2. 单层感知机只能解决线性可分问题,多层感知机还可以解决非线性可分问题。

2.3证明定理:样本集线性可分的充分必要条件是正实例点集所构成的凸壳与负实例点集构成的凸壳互不相交.解答:首先给出凸壳与线性可分的定义凸壳定义1:设集合S⊂R n,是由R n中的k个点所组成的集合,即S={x1,x2,⋯,x k}。

定义S的凸壳为conv(S)为:conv(S)={x=∑λi x iki=1|∑λi=1,λi≥0,i=1,2,⋯,k ki=1}线性可分定义2:给定一个数据集T={(x1,y1),(x2,y2),⋯,(x n,y n)}其中x i∈X=R n , y i∈Y={+1,−1} , i=1,2,⋯,n ,如果存在在某个超平面S:w∙x+b=0能够将数据集的正实例点和负实例点完全正确地划分到超平面的两侧,即对所有的正例点即y i=+1的实例i,有w∙x+b>0,对所有负实例点即y i=−1的实例i,有w∙x+b<0,则称数据集T为线性可分数据集;否则,称数据集T线性不可分。

必要性:线性可分→凸壳不相交设数据集T中的正例点集为S+,S+的凸壳为conv(S+),负实例点集为S−,S−的凸壳为conv(S−),若T是线性可分的,则存在一个超平面:w ∙x +b =0能够将S +和S −完全分离。

假设对于所有的正例点x i ,有:w ∙x i +b =εi易知εi >0,i =1,2,⋯,|S +|。

上海交大_计算机组成与系统结构第3次作业最新最完整

上海交大_计算机组成与系统结构第3次作业最新最完整计算机组成与系统结构第三次作业第4章P112习题13:某微机的指令格式如下所示:解:15 10 9 8 7 0OP X DOP:操作码;D:位移量;X:寻址特征位,X=00:直接寻址;X=01:用变址寄存器X1进行变址;X=10:用变址寄存器X2进行变址;X=11:相对寻址。

设(PC)=1234H,(X1)=0037H,(X2)=1122H,请确定下列指令的有效地址。

(1)6723H (2)4444H (3)1282H (4)4321H解:(1)6223H=0110011100100011B,X=11,相对寻址,有效地址=PC+D=1234H+23H=1257H(2)4444H=0100010001000100B,X=00,直接寻址,有效地址=D=44H(3)1282H=0001001010000010B,X=10,变址寻址,有效地址=X2+D=1122H+82H=11A24H(4)4321H=0100001100100001B,X=11,相对寻址,有效地址=PC+D=1234H+21H=1255H第5章P159习题22、23、24、2522、参见如图所示的数据通路,IR为指令寄存器,PC为程序计数器(具有自增功能),M为主存(受R/W信号控制),AR为地址寄存器,DR为数据缓冲寄存器,ALU由+、-控制信号决定完成何种操作,控制信号G控制的是一个门电路。

另外,线上标注有控制信号,例如Yi表示Y寄存器的输入控制信号,R1o为寄存器R1的输出控制信号,未标字符的线为直通线,不受控制。

存数指令“STA R1, (R2)”的含义是将寄存器R1的内容传送至(R2)为地址的主存单元中,请画出其指令周期流程图,并列出相应微操作控制信号序列。

IRPCARMDRXYA L UR0R1R2R3G+-IR iPC iAR iR/WDR iR0iR3iX iY iIR o PC oDR o R0oR3oA 总线B 总线解:STA R1, (R2)(R1) → (R2)23、参见习题22的数据通路。

神经网络原理与应用

循环神经网络与自然语言处理

神经网络

在人工智能领域中占据了重要的地位,其原理和应用也备受关注。除了常见的前馈,还有循环、卷积等不 同类型,每种类型都有其独特的应用领域和特点。此外,在图像识别、语音识别、自然语言处理等多个领域中 都取得了不俗的成果,并且随着技术的不断发展,其应用前景也变得越来越广泛。

Logo/Company

Contact Timing

循环神经网络

能够处理序列数据,如语音、文本等,其主要应用包括语音识别、自然 语言处理、机器翻译、时间序列预测等领域。其独特的结构允许信息在 网络内进行自我反馈和传递,使得网络能够记忆前面的输入信息,从而 更好地处理后续的输入。在实践中,经常被用于处理长序列数据和不定 长序列数据。

强化学习与深度强化学习

强化学习与深度强化学习

神经网络基础知识

内容包括神经元结构与功能、激活函数、权重与偏置、前向传播与反向传播等内容。其中神经元是神经网络的基本组成单元, 激活函数用于计算神经元的输出值,权重与偏置则用于调整神经元间的连接强度,前向传播用于计算神经网络的输出,反向 传播则用于更新网络中的参数以优化网络性能。

前馈神经网络的训练方法

前馈神经网络的训练方法主要包括误差反向传播算法、基于梯度下降的优化算法和 牛顿法等。其中,误差反向传播算法是最为常用的一种,并且具有较强的适应性和 泛化能力。该算法通过计算网络的输出误差,并将误差反向传播更新每个神经元的 权值,以最小化网络的总误差。

概念及基本原理

1. 神经网络的基本概念:神经网络是模仿人脑神经元和神经元之间的相互作 用来进行信息处理的一种计算模型。它由多个相互连接的简单处理单元组成, 在学习过程中自适应地调整各神经元之间的连接权值,以达到完成某个特定 任务的目的。

第2、3章 神经网络与深度学习课后题参考答案

2-1 分析为什么平方损失函数不适用于分类问题?损失函数是一个非负实数,用来量化模型预测和真实标签之间的差异。

我们一般会用损失函数来进行参数的优化,当构建了不连续离散导数为0的函数时,这对模型不能很好地评估。

直观上,对特定的分类问题,平方差的损失有上限(所有标签都错,损失值是一个有效值),但交叉熵则可以用整个非负域来反映优化程度的程度。

从本质上看,平方差的意义和交叉熵的意义不一样。

概率理解上,平方损失函数意味着模型的输出是以预测值为均值的高斯分布,损失函数是在这个预测分布下真实值的似然度,softmax 损失意味着真实标签的似然度。

在二分类问题中y = { + 1 , − 1 }在C 分类问题中y = { 1 , 2 , 3 , ⋅ ⋅ ⋅ , C }。

可以看出分类问题输出的结果为离散的值。

分类问题中的标签,是没有连续的概念的。

每个标签之间的距离也是没有实际意义的,所以预测值和标签两个向量之间的平方差这个值不能反应分类这个问题的优化程度。

比如分类 1,2,3, 真实分类是1, 而被分类到2和3错误程度应该是一样的,但是明显当我们预测到2的时候是损失函数的值为1/2而预测到3的时候损失函数为2,这里再相同的结果下却给出了不同的值,这对我们优化参数产生了误导。

至于分类问题我们一般采取交叉熵损失函数(Cross-Entropy Loss Function )来进行评估。

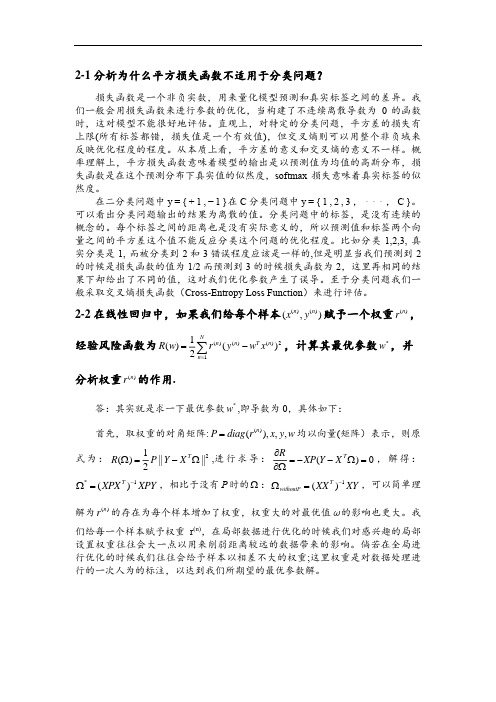

2-2 在线性回归中,如果我们给每个样本()()(,)n n x y 赋予一个权重()n r ,经验风险函数为()()()211()()2N n n T n n R w r y w x ==−∑,计算其最优参数*w ,并分析权重()n r 的作用.答:其实就是求一下最优参数*w ,即导数为0,具体如下:首先,取权重的对角矩阵:()(),,,n P diag r x y w =均以向量(矩阵)表示,则原式为:21()||||2T R P Y X Ω=−Ω ,进行求导:()0T R XP Y X ∂=−−Ω=∂Ω,解得:*1()T XPX XPY −Ω=,相比于没有P 时的Ω:1()T withoutP XX XY −Ω=,可以简单理解为()n r 的存在为每个样本增加了权重,权重大的对最优值ω的影响也更大。

神经网络原理与应用第1讲:基础知识PPT课件

1957年,心理学家Frank Rosenblatt提出了感知机模 型,它可以识别一些简单的

模式,但无法处理异或 (XOR)问题。

1974年,Paul Werbos提出 了反向传播算法,解决了感 知机模型无法学习异或问题

的问题。

2006年,加拿大多伦多大学 的Geoffrey Hinton等人提出 了深度学习的概念,开启了

权重更新是根据损失函数的梯度调整权重的过程,通过不断 地迭代优化,使神经网络逐渐接近最优解。权重更新的过程 通常使用梯度下降法或其变种进行。

03

神经网络的类型

前馈神经网络

总结词

前馈神经网络是最基本的神经网络类型,信息从输入层开始,逐层向前传递,直 至输出层。

详细描述

前馈神经网络中,每一层的神经元只接收来自前一层的输入,并输出到下一层。 这种网络结构简单,易于训练和实现,常用于模式识别、分类和回归等任务。

利用神经网络进行游戏AI的决 策和策略制定,如AlphaGo

等。

02

神经网络的基本概念

神经元模型

总结词

神经元是神经网络的基本单元,模拟 生物神经元的行为。

详细描述

神经元模型通常包括输入信号、权重 、激活函数和输出信号等部分。输入 信号通过权重进行加权求和,经过激 活函数处理后得到输出信号。

激活函数

06

神经网络的应用实例

图像识别

总结词

图像识别是神经网络应用的重要领域之一, 通过训练神经网络识别图像中的物体、人脸 等特征,可以实现高效的图像分类、目标检 测等功能。

详细描述

神经网络在图像识别领域的应用已经取得了 显著的成果。例如,卷积神经网络(CNN) 被广泛用于图像分类、目标检测和人脸识别 等任务。通过训练神经网络,可以自动提取 图像中的特征,并基于这些特征进行分类或 检测目标。这大大提高了图像识别的准确性

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Neural Network Theory and ApplicationsHomework Assignment3oxstar@SJTUJanuary19,20121Data PreprocessingFirst we used‘svm-scale’of LibSVM to scale the data.There are two main advantages of scaling:one is to avoid attributes in greater numeric ranges dominating those in smaller numeric ranges,another one is to avoid numerical difficulties during the calculation[1].We linearly scaled each attribute to the range[-1,+1].2Model SelectionWe tried three different kernel functions,namely linear,polynomial and RBF.•liner:K(x i,x j)=x T i x j•polynomial:K(x i,x j)=(γx T i x j+r)d,γ>0•radial basis function(RBF):K(x i,x j)=exp(−γ x i−x j 2),γ>0The penalty parameter C and kernel parameters(γ,r,d)should be chosen.We used the ‘grid-search’[1]on C andγwhile r and d are set to their default values:0and3.In Figure1,we presents the contour maps for choosing the proper attributes.We just searched for some maxima while the global maximum is usually difficult tofind and with the values of attributes increasing,the running time increasing dramatically.Note that‘ovr’stands for one-versus-rest task decomposition methods while‘ovo’is short for one-versus-one and‘pvp’is short for part-versus-part.The liner kernel doesn’t have private attributes,so we should just search for the penalty parameter C.The results are shown in Figure2.Thefinal selection for each attributes are presented in Table1.Table1:A Selection for Each AttributesDecomposition Kernel CγRBF10 1.0one-versus-rest Polynomial0.10.7Liner1RBF1 1.5one-versus-one Polynomial0.010.2Liner0.1RBF10.1part-versus-part Polynomial0.010.4Liner1Gammal g (c o s t )3840424446485052(a)RBF Kernel(ovr)Gammal g (c o s t )3132333435363738394041(b)Polynomial Kernel (ovr)Gammal g (c o s t )52535455565758(c)RBF Kernel(ovo)Gammal g (c o s t )38404244464850525456(d)Polynomial Kernel (ovo)Gammal g (c o s t )20253035404550(e)RBF Kernel (pvp)Gammalg (c o s t )15202530354045(f)Polynomial Kernel (pvp)Figure 1:Grid Search for RBF and Polynomial Kernellg(cost)A c c u r a c y(a)ovr lg(cost)A c c u r a c y(b)ovolg(cost)A c c u r a c y(c)pvpFigure 2:Attributes Search for Liner Kernel3Experiments3.1Task Decomposition MethodsThere are several multi-class classification techniques have been proposed for SVM models.The most typical approach for decomposing tasks is the so called one-versus-rest method which classifies one class from the other class.Assume that we construct N two-class clas-sifiers,a test datum is classified to C i iff.the i th classifier recognizes this datum.However,probably more than one classifiers recognize it.In this case,we set it belonging to C i if the i th classifier gives the largest decision value.On the other side,if no classifier recognizes it,we would set it belonging to C i if the i th classifier gives the smallest decision value for classifying it to the ‘rest’class.One-versus-one combining all possible two-class classifier is another methodology for dealing with multi-class problems[3].The size of classifier grows super-linearly with the number of classes but the running time may not because each divided problem is much smaller.We used a election strategy to make the final decisions:if the number of i -relative classifiers that classifying a datum to the i th class is the largest,we would say that this datum belongs to C i .Part-versus-part method is another choice[4].Any two-class problem can be further de-composed into a number of two-class sub-problems as small as needed.It is good at dealing with unbalance classification problems.As shown in Table 2,number of training data in each class from our dataset is just unbalance.Table 2:Number of Training Data in Each ClassClass Number of Training Data Class Number of Training Data 05376741994758423281545391910046891013385381143We used MAX-MIN strategy to make the final decisions.We also have to determine the size of minimum parts,which affects the performance of classification a lot.From Figure 3,we chose 200as the number of each sub-class because the accuracy reach a local maximum and it would make no sense if 1600is chosen.3.2ResultsIn our experiments,we used the Java version of LibSVM[2].25501002004008001600102030405060N per partA c c u r a c yFigure 3:Relationship between Sun-class Size and AccuracyTask Decomposition MethodsA c c u r a c y (%)(a)Accuracy Task Decomposition MethodsT i m e (s )(b)Running TimeFigure 4:Performance of Each Task Decomposition Method and Each Kernel The running time and accuracy are shown in Figure 4a and Figure 4b.3.3DiscussionComparing with ovo and pvp,one-versus-one decomposition method always has the worst accuracy no mater which kernel is used.However,due to the simple procedure,only N classifiers are required for a N-class problem.So the scalability of this method is better than the others.The one-versus-one decomposition method performed the best in our experiments.De-spite it need N(N-1)/2classifiers for a N-class problem,each sub-problem is really small and the running time is even the smallest.However,with the increasing of class number,the size of classifier would be growing super-linearly.The last one,part-versus-part decomposition method,did not perform well in our exper-iments because its running time is too long comparing with others.Its accuracy is between the one of ovr and the one of ovo.Massively parallel learning can be easily implemented by using this method;however,this advantage is depressed here.RBF kernel is the best choice if we just take accuracy into account but it cost the longest time mostly.The accuracy of polynomial and liner kernel is very close while the running time of liner kernel are more satisfying.References[1]Chih-Wei Hsu,Chih-Chung Chang,and Chih-Jen Lin:A Practical Guide to SupportVector Classiffication,2003.[2]C.-C.Chang and C.-J.Lin:LIBSVM:a library for support vector machines,2001.[3]Johannes F¨u rnkranz:Round Robin Classification,2002.[4]Bao-Liang Lu,Kai-An Wang,Masao Utiyama,and Hitoshi Isahara:A Part-Versus-PartMethod for Massively Parallel Training of Support Vector Machines,2004.。