一种基于大数据的网络日志分析模型构建研究

基于大数据的ELK日志分析系统研究及应用

基于大数据的ELK日志分析系统研究及应用作者:李志民孙林檀吴建军张新征来源:《科学与信息化》2019年第28期摘要基于ELK的日志分析系统研究分析是为了有效的解决当下物联网应用日志处理效率低的问题。

因此,本文首先阐述了基于ELK的日志分析平台,然后总结了对系统日记群集优化大方法,从而提高日志分析系统的运行效率和排查异常的速度。

关键词 ELK;日志分析系统;Elasticsearch日志设计信息系统的重要组成部分,是系统运行、性能分析以及故障诊断的重要来源。

随着科学技术的不断发展和互联网技术的广泛应用,不断增加了系统的日志量,随着日志的应用范围的扩大和复杂程度的增加,传统日志的分析方式和效率已经不能适信息系统对日志的需求。

为了满足信息时代的发展需要,下面就基于ELK的日志分析系统进行相关的研究分析工作。

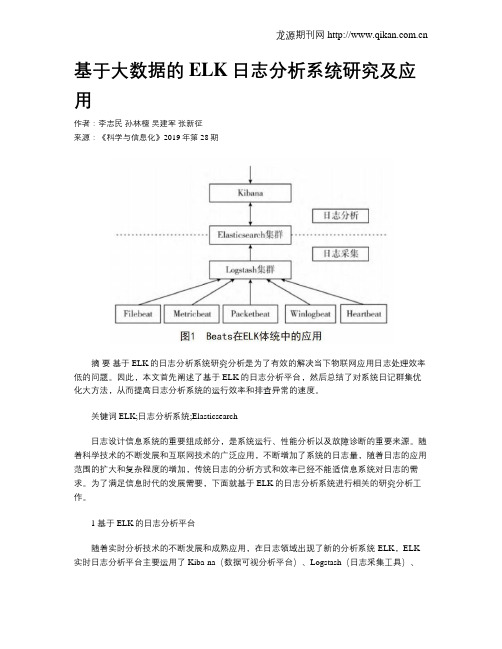

1 基于ELK的日志分析平台随着实时分析技术的不断发展和成熟应用,在日志领域出现了新的分析系统-ELK,ELK 实时日志分析平台主要运用了Kiba-na(数据可视分析平台)、Logstash(日志采集工具)、Elasticsearch(分布式搜索引擎)[1]。

这些技术的应用可以让系统的运行维护人员在庞大的日志信息量中及时找到所需要管理和维护的信息,从而实现了对日志系统的分析。

1.1 日志分析系统整体架构完整的日志系统是有日志的储存系统、采集系统、解析系统化以及可视化分析系统共同组成的。

日志采集工具是日志的主要采集器,在多台机器当中都有分布,它可以对非结构的日志进行解析,然后把解析的结果传输到分布式搜索引擎中;分布式搜索引擎可以完成全文检索的功能,属于储存日志的中央系统;而Kibana组件的存在不仅可以对分布式搜索引擎中的日志进行可视化操作[2],还可以进行统计分析和高级搜索。

但是日记采集工具及要完成对日志的采集工作又要完成解析工作,这样不仅会致系统的性能下降,严重的时候还会影响工作的进展。

而Beats的推广和应用有效解决了这一问题,图1为Beatsde在系统框架中的应用:Beats在进行信息采集和解析工作的时候可以针对不同的日志格式和来源使用不同的采集器,Beats采集器包括了5中不同种类和功能的日志采集器,分别为:Filebeat、Metricbest、Packetbeat、Winlogbeat、Heartbeat。

基于大数据分析的网络安全威胁检测与预防模型构建

基于大数据分析的网络安全威胁检测与预防模型构建网络安全威胁是当前互联网时代中一种不可忽视的问题。

随着互联网的快速发展,网络攻击手段不断进化,给个人用户、企业组织以及国家的信息系统都带来了巨大的威胁。

为了保护网络安全,基于大数据分析的网络安全威胁检测与预防模型的构建变得非常关键。

在构建基于大数据分析的网络安全威胁检测与预防模型之前,我们需要明确以下几个方面的内容:威胁检测的目标、所需的数据和技术手段以及模型的构建和评估。

首先,威胁检测的目标应该是及时发现网络中可能存在的安全威胁并采取相应的预防措施。

这包括检测网络攻击、恶意软件、数据泄露以及其他潜在的威胁行为。

而大数据分析则提供了强大的工具和技术来实现这一目标。

其次,构建基于大数据分析的网络安全威胁检测与预防模型需要大量的数据支持。

这些数据可以包括网络日志、流量数据、操作记录、设备指标等等。

通过收集和分析这些数据,可以发现潜在的威胁行为的模式和特征,进而进行检测和预测。

在技术手段方面,大数据分析技术包括数据采集、数据处理、数据挖掘和数据可视化等环节。

在数据采集方面,可以利用网络安全设备、传感器和日志监控等手段收集网络流量和行为数据。

数据处理阶段包括数据清洗、数据转换和数据集成等过程,以保证数据的完整性和准确性。

数据挖掘技术可以应用于网络威胁检测中,通过分析数据中的模式、异常和关联规则来识别威胁行为。

最后,数据可视化技术将分析结果以直观的方式展示,便于分析人员进行决策。

基于以上要求和技术手段,我们可以建立一个基于大数据分析的网络安全威胁检测与预防模型。

该模型可以包括以下几个主要环节:数据采集、数据处理、模型训练和模型应用。

首先,通过网络安全设备、传感器等手段收集网络流量、日志信息等数据。

这些数据应该包括网络的基本信息、用户行为和设备状态等方面的数据。

收集到的数据需要经过数据清洗、转换和集成等处理过程,以保证数据的准确性和完整性。

在数据处理之后,可以利用数据挖掘技术来构建威胁检测模型。

基于Hadoop的大数据分析与处理研究

基于Hadoop的大数据分析与处理研究随着互联网的发展,数据量也随之呈现爆炸式的增长。

如何有效的处理这些海量数据是目前亟待解决的问题。

Hadoop作为开源的分布式计算框架,已经成为了大数据处理的主要选择。

本文将着重讲解基于Hadoop的大数据分析与处理研究。

一、Hadoop简介Hadoop是一个开源的分布式计算框架,主要解决的是海量数据的存储和处理问题。

它由Apache基金会开发,拥有自己的文件系统HDFS(Hadoop Distributed File System)和分布式数据处理框架MapReduce。

其中,HDFS主要负责海量数据的分布式存储,而MapReduce则是处理和计算数据的核心模块。

目前,Hadoop已经成为了数据科学家和工程师的标配技能之一。

二、Hadoop的优点1. 可扩展性Hadoop的分布式架构使其可以轻松地扩展到数百个节点。

只要增加更多的服务器,Hadoop就可以根据需要添加更多的计算和存储资源,以满足不断增长的数据需求。

2. 高可靠性Hadoop采用了多个复制副本来存储数据,数据能够在不同的节点上复制多份,一旦出现部分节点宕机的情况,仍可以从其他节点中读取数据,确保数据的高可靠性。

3. 高效性Hadoop通过MapReduce操作,可以非常高效地处理大量的数据。

MapReduce采用了并行计算的方式,将数据划分成多个小任务,并分布到不同的节点上进行计算。

这种方式可以最大限度地利用硬件资源,使计算效率得到了极大的提升。

三、基于Hadoop的大数据分析与处理基于Hadoop的大数据分析主要分为四个步骤:数据采集、数据清洗、数据挖掘和数据可视化。

1. 数据采集在大数据分析过程中,需要先获取海量的数据。

数据的来源可以是开放API、爬虫程序、传感器、日志文件等多种渠道。

2. 数据清洗在数据采集后,需要进行数据清洗。

数据清洗主要是为了提高数据的质量,并去除无用的信息。

数据清洗包括去重、删除错误数据、填补缺失值等操作。

基于大数据分析的网络犯罪侦查系统研究

基于大数据分析的网络犯罪侦查系统研究随着互联网的广泛应用,网络犯罪问题也日益严重。

为了打击网络犯罪,提高犯罪侦查的效率,大数据分析技术逐渐应用于网络犯罪侦查系统中。

本文将探讨基于大数据分析的网络犯罪侦查系统的研究。

1. 引言网络犯罪是指利用计算机网络进行违法犯罪活动的行为,包括网络诈骗、网络入侵、网络盗窃等。

随着互联网的快速发展,网络犯罪已经成为一个全球性的问题。

传统的侦查方法已经无法满足复杂的网络犯罪情况下的侦查需求,因此需要引入大数据分析技术来提高侦查效率和准确性。

2. 大数据分析技术在网络犯罪侦查中的应用大数据分析技术可以通过对大量的数据进行自动化的处理和分析,从而提取有价值的信息。

在网络犯罪侦查中,大数据分析技术可以帮助警方快速发现和识别潜在的网络犯罪嫌疑人,并追踪犯罪活动的蛛丝马迹。

2.1 数据采集和存储网络犯罪侦查系统需要收集和存储大量的网络数据,包括网络日志、用户行为记录、通信记录等。

大数据分析技术可以帮助警方快速采集和存储这些数据,并保证数据的完整性和安全性。

2.2 数据清洗和预处理网络犯罪数据通常包含大量的噪声和冗余信息,需要进行清洗和预处理才能得到有效的数据。

大数据分析技术可以通过自动化的方式对数据进行清洗和预处理,并提取出有意义的信息。

2.3 数据挖掘和分析数据挖掘是大数据分析的核心环节之一,可以帮助警方发现隐藏在网络数据中的规律和模式。

在网络犯罪侦查中,数据挖掘技术可以用于识别异常行为、关联不同的网络犯罪事件以及构建网络犯罪嫌疑人的模型等。

2.4 可视化分析和决策支持大数据分析技术可以通过可视化的方式展示分析结果,帮助警方更直观地理解网络犯罪的情况。

同时,大数据分析技术还可以为警方提供决策支持,协助他们制定相应的打击网络犯罪的策略和行动计划。

3. 大数据分析的挑战与改进尽管大数据分析技术在网络犯罪侦查中有很多潜力,但仍面临一些挑战。

首先,网络犯罪数据的规模和复杂性对数据处理和分析提出了很高的要求。

数据库中的日志分析与查询优化技术研究在大数据环境中的应用在物联网安全中的应用

数据库中的日志分析与查询优化技术研究在大数据环境中的应用在物联网安全中的应用随着物联网(IoT)技术的快速发展,大数据环境下的数据库日志分析与查询优化技术对于物联网安全的应用变得越来越重要。

数据库中的日志分析技术能够帮助我们实时监控、审计和预测数据库操作的行为,而查询优化技术则能够提高数据库查询性能和效率。

本文将重点探讨这些技术在大数据环境下的应用,以提高物联网安全性。

一、数据库中的日志分析技术在大数据环境中的应用在大数据环境中,物联网系统生成的数据量巨大,许多数据库管理系统需要记录和存储大量的操作日志。

数据库中的日志记录了所有的数据库操作,包括用户登录、查询、更新等。

通过对这些日志进行分析,我们可以及时发现和阻止潜在的威胁。

以下是数据库中的日志分析技术在大数据环境中的应用场景:1. 安全监控和入侵检测:通过对数据库操作日志的实时监控和分析,可以发现异常行为,例如未经授权的访问、恶意代码注入等。

采用机器学习和人工智能技术,可以实现数据库操作行为的动态模型构建和异常检测,从而保护数据库的安全。

2. 数据合规性和审计:物联网系统产生的数据通常需要遵守法律法规的合规性要求,比如GDPR。

数据库中的日志可以帮助我们跟踪记录用户和管理员的操作行为,确保数据的合规性。

审计通过日志的存档和分析,有助于及时发现违规行为并采取相应的措施。

3. 故障诊断和故障恢复:在大数据环境中,数据库系统可能会遭受各种故障,如硬件故障、软件故障等。

通过对数据库操作日志的分析,可以追踪故障的根本原因,并进行相应的故障诊断和修复工作,减少故障对物联网系统的影响。

二、数据库查询优化技术在大数据环境中的应用数据库查询优化技术是提高数据库查询性能和效率的重要手段,尤其在大数据环境下更为重要。

以下是数据库查询优化技术在大数据环境中的应用场景:1. 查询性能提升:大数据环境下,查询性能优化是至关重要的,因为传统的查询方式可能无法在大数据量下提供高效的查询结果。

基于大数据时代计算机网络安全技术应用探究

基于大数据时代计算机网络安全技术应用探究1. 引言1.1 背景介绍在当今信息化社会,计算机网络已经成为人们生活和工作中不可或缺的一部分。

随着大数据时代的到来,网络安全问题也变得日益严峻和复杂。

传统的网络安全技术已经无法满足当前大规模数据处理和安全防御的需求,因此基于大数据的计算机网络安全技术应运而生。

随着互联网和物联网的快速发展,网络安全问题日益凸显。

大规模数据的传输、存储和处理给网络安全带来了挑战,传统的手段已经不能满足对网络安全的保护需求。

网络威胁的种类和攻击手段也日益多样化和复杂化,使得网络安全形势更加严峻。

大数据时代对计算机网络安全提出了新的要求,需要利用大数据分析技术来实现对海量数据的有效分析和挖掘,提高网络安全防御和应对能力。

基于大数据的网络安全技术成为了当前研究的热点和趋势,通过大数据技术的应用,可以更好地发现网络中的异常行为、及时响应安全事件,提高网络安全防御的水平。

本文旨在探究基于大数据时代的计算机网络安全技术应用,分析大数据对网络安全的影响,探讨大数据分析在网络安全中的应用及未来发展趋势。

1.2 研究意义网络安全技术在大数据时代的应用意义,主要体现在以下几个方面:随着互联网的快速发展和普及,人们的生活和工作已经越来越依赖于计算机网络。

而随之而来的网络安全问题也日益严峻,不仅仅是个人信息泄露和财产损失,更可能导致国家甚至全球的重大安全事件。

研究和应用大数据技术在网络安全中的意义就显得尤为重要。

随着云计算、物联网和移动互联网的快速发展,传统的网络安全技术已经不能满足当今复杂多变的网络环境。

而大数据技术强大的数据处理和分析能力,为网络安全领域带来了全新的技术手段和方法。

通过对海量数据的挖掘和分析,可以发现网络安全事件的规律和特征,从而及时预警和应对潜在的安全威胁。

大数据时代的网络安全技术应用不仅可以提高网络安全防御的效率和精度,还可以为提升网络安全运营和管理水平提供有力支撑。

通过大数据技术,可以实现网络安全事件的实时监测和分析,加强对网络异常行为和威胁情报的监控和分析,提高安全事件响应的效率和及时性,从而保障网络环境的安全和稳定。

基于大数据技术的网络安全风险评估模型研究

基于大数据技术的网络安全风险评估模型研究近年来,随着大数据技术的快速发展,其在各行各业中的应用越来越广泛。

尤其在网络安全领域,大数据技术发挥了不可替代的作用。

基于大数据技术的网络安全风险评估模型也随之应运而生,成为当前网络安全领域的热点研究方向。

一. 大数据技术在网络安全中的应用作为一种利用互联网、云计算等信息加工和集成技术分析、处理、管理大规模数据集的技术,大数据技术在网络安全中可以用于快速发现恶意攻击、准确识别网络安全威胁、发现安全隐患等。

具体来说,大数据技术在网络安全中的应用主要集中在以下几个方面:1. 威胁情报分析:通过对大量网络数据进行收集、存储和分析,可以快速发现威胁情报,并及时采取相应的安全防范措施,提高网络安全防护能力。

2. 异常行为检测:通过对网络中的数据流、通信记录等进行分析比对,可以发现异常行为并进行实时监控和处理,及时发现和防范网络攻击行为。

3. 安全事件响应:基于大数据技术的安全事件响应系统可以实现快速的安全事件分析和响应决策,提高应对网络安全事件的能力。

二. 基于大数据技术的网络安全风险评估模型研究网络安全风险评估是网络安全重要的一环,通过对网络安全风险进行评估,可以及时发现网络安全漏洞和威胁,提高网络安全防护能力。

而基于大数据技术的网络安全风险评估模型,能够更加准确地评估网络安全风险,提高网络安全防护能力。

在大数据技术的支持下,基于大数据技术的网络安全风险评估模型可以拓宽分析数据来源和处理能力,实现多维度、多源的数据收集和分析,并进一步优化风险因素的抽象模型。

具体来说,基于大数据技术的网络安全风险评估模型主要包括以下几个方面:1. 数据收集:通过网络流量监测、威胁情报收集、日志审计等手段获取大量网络数据,构建网络安全分析数据平台。

2. 数据处理:将收集到的数据进行数据挖掘、数据分析等处理,提取出其中的安全威胁信息,进行数据聚类、数据关联等处理。

3. 风险评估:通过对整体网络环境的评估和针对性的分析,利用大数据技术进行综合性的风险评估,识别出网络安全威胁,为安全决策提供科学依据。

基于大数据的网络安全威胁情报收集与分析模型研究

基于大数据的网络安全威胁情报收集与分析模型研究随着网络技术的不断发展,网络安全问题也越来越受到人们的关注。

网络攻击手段不断升级,尤其是近年来,随着大数据和人工智能技术的应用,网络安全威胁情报收集与分析也面临着新的挑战。

因此,研究基于大数据的网络安全威胁情报收集与分析模型,对于提高网络安全水平、保护国家和个人的网络安全具有重要意义。

一、基于大数据的网络安全威胁情报收集在网络安全威胁情报收集方面,传统的方法主要是使用代理服务器、防火墙、IDS/IPS和蜜罐等技术。

但这些技术往往存在着漏洞,不能完全保障网络的安全。

基于大数据的网络安全威胁情报收集方法,则是利用云计算、人工智能和大数据等技术,实现对网络的全方位监控和分析,从而预测和发现网络威胁,及时采取措施保障网络的安全。

具体来说,基于大数据的网络安全威胁情报收集,主要包括以下几个方面:1.网络流量分析:通过对网络流量的实时监控和分析,可以发现网络异常流量和攻击行为,及时进行防范和处置。

2.日志分析:通过对网络访问日志、设备日志和安全事件日志的分析,可以快速发现异常行为和攻击事件,防止网络被攻击。

3.行为分析:通过对用户行为、登录情况、文件操作等方面的分析,可以及时发现并应对内部信息泄露行为。

4.漏洞扫描:通过对网络系统和应用的漏洞扫描,可以发现网络中的漏洞,并及时修复,从而提高网络的安全性。

以上几种基于大数据的网络安全威胁情报收集方法,都是通过对网络数据的全面监控和分析,进行预测和预防网络威胁,保障网络的安全。

二、基于大数据的网络安全威胁情报分析在网络安全威胁情报分析方面,传统的方法主要是使用静态规则和签名等技术,但这些方法往往无法应对新型网络攻击。

而基于大数据的网络安全威胁情报分析,能够对海量数据进行全面分析,发现潜在威胁并及时采取应对措施。

具体来说,基于大数据的网络安全威胁情报分析,主要包括以下几个方面:1.威胁情报收集:通过网络情报收集系统,可以获取各类网络威胁情报,实现对网络威胁的实时感知和防范。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第25卷第23期电子设计工程2017年12月Vol.25 No.23 Electronic Design Engineering Dec. 2017一种基于大数据的网格日志分祈模型构建研究邓小盾(西安外事学院陕西西安710077)摘要:针对海量w eb日志数据在存储和计算方面存在的问题,结合当前的大数据技术,提出一种基于Hadoop与聚类分析的网络日志分析模型。

利用Hadoop中的MapReduce编程模型对海量W eb日志进行处理;利用HDFS结合的方式对数据进行存储;利用聚类分析算法构建w e b日志分析模型,对用户行为进行分析。

最后通过搭建Hadoop测试环境对日志分析系统功能进行测试,并与单机系统比较,验证了该设计方案的优势。

关键词:大数据;w eb日志;MapReducc编程模型;HDFS;聚类分析中图分类号:TN0 文献标识码:A文章编号:1674-6236(2017)23-0097-04Research on the construction of a network log analysis model based on large dataDENG Xiao-dun(Xi'n International University,Xi'n710077 ,China)Abstract:I n view of the problems existing in the storage and computation of massive web log data,a newnetwork log analysis model based on Hadoop and cluster analysis is proposed.To deal with Web log using MapReduce programming model in Hadoop;using the combination of HDFS f or da age;model Web log analysis algorithm based on clustering,user behavior analysis.Finally,the functionof the log analysis system is tested by building the Hadoop test environment,and the advan design scheme are verified by comparing with the single machine system.Key words:big data;web log;mapReduce programming model;HDFS;cluster analysis随着我国信息技术的不断发展,在各个企业、公 共部门等结构内部网络中,积累了大量的软件和硬 件资源,如交换机、路由器、防火墙PC服务器、Unx 小型机、各类业务应用系统、中间件、数据库等。

这 些设备每天持续不断产生大量日志,并对这些曰志 进行记录。

对于日志文件,作为不同软硬件资源运 行中对故障问题和用户行为记录的一个重要工具,受到广泛的关注。

通过日志可监控系统运行,查看 不同硬件的故障,并保护系统的安全等,从而发现其 中的异常行为,为及时处置网络安全事件提供参 考。

而随着大量日志的产生,日志的存储开始由原 来的GB开始往TB或PB级别发展。

同时,传统日志 分析中采用的单机技术对海量数据进行处理,这给数据存储和分析带来很大的技术瓶颈。

对此,针对 这些问题,大数据技术开始被人们关注,并应用到对 海量数据的处理中,典型的代表则是谷歌Hadoop平 台下的Google MapReduce和GFS等存储工具。

在 H ad o p平台下,集成了对数据存储、数据处理和数 据管理等全部功能,并成为了当前大数据应用的标 准,特别是在对海量数据的搜索、挖掘和分析。

对此,本文针对传统日志分析的缺陷,从w eb日志分析角度出发,在Hadoop平台下,提出一种基于 MapReduce编程模型和聚类分析的行为日志模型,并对其进行了详细的实现。

1系统功能分析本文提出的基于Hadoop平台下的w eb日志分析收稿日期:2016-10-11 稿件编号:201610039基金项目:2015—2016年度陕西省高教学会高水平民办大学建设研究项目(15GJ044);2016年度西安市社会科 学规划基金项目(16IN13);2016年度陕西省教育厅科学研究项目(16JK2178)作者简介:邓小盾(1979—),女,陕西泾阳人,硕士,讲师。

研究方向:大数据、人工智能。

《电子设计工程》2017年第23期系统主要包含以下几个功能模块:日志预处理模块、日志存储模块、日志挖掘模块。

其中,日志预处理是 数据挖掘的前提,对数据处理的好坏直接决定系统 的运行;数据存储包含系统数据存储架构,是系统运 行的保障;日志挖掘主要负责对预处理的文件进行 挖掘分析,从而挖掘出有用的信息。

具体功能见如 图1所示。

图1系统功能需求分析2日志分析系统整体架构设计通过图2看出,Hadoop集群层是整个日志行为 分析系统的基础,为整个提供软硬件和网络支撑。

在该层中由1个主服务器和N个从服务器组成;HDFS分布式文件处理系统主要负责对数据进行存 储,并提供与MapReduce层调用的接口;MapReduce 计算层主要负责对海量数据采用映射/规约等方式 进行并行运算,从而将任务分配给下属的各个节点,在通过处理后,将信息整合进行整合得到最终结果;业务逻辑层主要利用H a d o p的集群环境对日志数 据进行存储,并运用MapReduce的计算来分析日志 用户的行为偏好。

3系统详细设计针对图1所示的功能,设计出一款主要针对海 量日志数据的用户行为系统,从而旨在改变传统单 机技术在海量数据分析方面存在的局限,提高数据 分析和挖掘的效率。

架构具体见如图2所示。

图2系统整体架构设计3.1数据预处理数据预处理作为该系统的一个重要模块,是数据挖掘的基础。

本系统则将数据直接存入到HDFS文件系统中,默认切分为每块为64 MB大小的文件,保存在各个DataNode上。

而为了加快对原始数据的清理和识别,引入MapReduce编程模型,其具体原理如图3所示。

1) Map阶段在Map阶段,主要输入w eb日志中的每条记录,输出格式为<key,value〉键值对,其中key表示用户ID,value表示<链接地址、上一跳链接地址、时间>。

对于Map阶段来看,其主要实现对数据的清理。

具体步骤为:① 对w eb日志进行切分处理,并分割不同数据 的属性;② 判断数据请求方式是否为“GET”,如不是,删 除该数据,如是,继续处理;—98 —图3 MapReduce工作原理邓小盾一种基于大数据的网络日志分析模型构建研究图6250002000015000100005000通过图7可以看出,采用基于H a d o p 的集群其 数据处理的大小要远远大于传统的单机处理方式。

同时通过引入K -means 算法对web 文本日志进彳了分 析,得到总共5类不同的活跃用户,其中每一类的数 据都是通过I 解析得到,并得到第三类、第五类的访问最多,最值得我们关注。

5结束语针对传统单机处理基础存在的弊端,引入基于-99-③ 判断文件格式是否在要求的文件格式中,如没有,删除;④ 判断该日志返回的标识码是否在200〜299之 间,如不在,删除,如在则按照标准格式输出。

2)Reduce 阶段Reduce 阶段主要完成对对应的Map 处理数据的 合并。

在该阶段引入Combiner 函数。

具体步骤为:① 使用迭代器遍历每个记录的v l u e ,取出其中 的ip ,并将其放入到USIt 容器中。

②遍历USIt 容器,判断ip 是否相同,如不同则视作新用户。

3.2数据存储设计对存储模块的设计则采用HDFS 文件处理系统 与Mysql 组合的方式,其中HDFS 主要负责存储全部 数据,Mysql 负责存储从HDFS 系统中导出的数据, 从而为数据挖掘奠定基础。

为了将HDFS 系统中的 文件导入到Mysql 中,引入s q o p 工具,从而将HDFF 中的数导入到Mysql 中。

具体实现架构如图4所示。

图4存储架构3.3挖掘模块设计在对大数据的挖掘中,常用的方法包括关联规 贝^、回归分析、聚类等,其中K -means 聚类是最为简 单,也是最为高效的算法。

其核心思想是以样本空 间中的个点作为中心点,通过迭代,对其周围的样本 进行归类并重新计算中心点的值,直到收敛。

虽然 该方法简单,但是在该算法中最为关键的K 值往往 是根据经验来确定。

为解决该问题,通常会通过反 复的实验,从而取一个较好的聚类K 值。

对此本文 结合以往的研究,提出一种最小最大距离算法对K 值进行确定。

该方法的核心思想是在对w eb 日志进 行聚类的过程中,选取原点作为初始点的参照点,选 择一个最远和最近的点作为初始点,计算数据集合 中点到这两点的距离。

将K -means 放到MapReducc 中,具体算法则可以描述为如图5所示。

4实验验证搭建基于Hadoop 的平台,总共5台计算机,其中一台为主服务器,其他的4台为从服务器。

安装 Java 6版本,Mysql 数据库米用5.5版本,Hadoop 米用图5基于K -means 的MapReduce 并行化处理2.版本。

通过上述环境的搭建,可以得到如图6所示的 数据处理对比结果。

分布式和单机式数据处理结果对比图图7日志聚类结果《电子设计工程》2017年第23期H a d o p的平台,从而大大提提高了数据处理的效率,同时引人K-means算法对日志进行挖掘分析,取得良好的效果,可有效地根据用户I得到其行为特征,从而为大数据技术的进一步利用提供了参考,也奠定了未来应用的基础。

参考文献:[]嚳岩龙,罗壮,杨説,等.基于h a d o p的高性能海 量数据处理平台研究[J计算机科学,2013,40(3):100-103.[2] 周诗慧,殷建.Hadoop平台下的并行W eb日志挖掘算法J计算机工程,2013(6:43-4.[3] 马汉达,郝晓宇,马仁庆.基于Hadoop的并行PSO-kmeans算法实现W eb日志挖掘J计算机科学,2015(S1):470-473.[4] 任凯,邓武,俞琰.基于大数据技术的网络日志分析系统研究J现代电子技术,201(2)39-41,44.[5] 于兆良,张文涛,葛慧,等.基于Hadoop平台的日志分析模型[J计算机工程与设计,201(2):338-344,428.[]张春生,郭长杰,尹兆涛.基于大数据技术的I 基础设施日志分析系统设计与实现J微型电脑应用,201(6:49-52.[7]陈洁,于永刚,刘明恒,等.安全管理平台中基于云计算的日志分析系统设计[J计算机工程,(上接第9页)[11] 杨帆.基于FPGA的SDI接口的研究与开发[D].天津:天津理工大学,2010.[12] 黄隶凡,郑学仁.基于FPGA的三速SDI设计J电视技术,2011,35(3): 13-18.[13] 岳元,彭量节.SD I红外图像在火炮光电跟踪系统中的应用[J].激光与红外201,4(8):10241027.[14] 杨洋.基于FPGA的4路HD-SDI光纤传输系统[J].光通信技术,2015,39(5):97-103.[15] 苏建,林水生.基于FPGA的SDI接口设计[J].中国有线电视,2015(24) :62-68.2015(2)21-25.[8]江小平,李成华,向文,等.k-m ea n s聚类算法的M a pR e du c e并行化实现[J].华中科技大学学报:自然科学版,2011(S1):120-124.[9]周好,张君琪,罗成.基于H a d oo p的K-m ea n s聚类算法的实现[J].计算机技术与发展,2013 (7):18-21.[10] 李洪成,吴晓平,陈燕.M a pR e du c c框架下支持差分隐私保护的k-m ea n聚类方法[J].通信学报,2016(2)124-130.[11] 李欢,刘锋,朱二周.基于改进K-m ea n s算法的海量数据分析技术研究[J].微电子学与计算机,2016(5)52-57.[12] 杨勇,任淑霞,冉娟,李春青.基于粒子群优化的k-m ea n s改进算法实现W e b日志挖掘J计算机应用,2016(S1):29-32,36.[13] 衣治安,王月.基于M a pR e du c c的K_m e en s并行算法及改进[J].计算机系统应用,2015(6)188-192.[14] 谢雪莲,李兰友.基于云计算的并行K-m ea n s聚类算法研究J计算机测量与控制,2014(5):1510-1512.[15] 何佩佩,谢颖华.云环境下K-m ea n s算法的并行化[J].微型机与应用,2015(24):25-27,31.[16] 李彦迪,金伟正,王丹.基于FPGA的HD-SDI编解码技术的研究与开发[J].电子技术应用,2012(12)16-21.[17] 党俊博,李哲,李雅俊.基于FPGA的串口通信电路设计与实现[J].电子科技,2016(7):106-109.[18] 罗帅,徐进,夏杰,等.一种光纤数据采集系统的设计[J].西安工程大学学报,2016(3):312-315. [19] 严明,李斌康,郭明安,等.高速光电探测器阵列实时信号处理系统[J].现代应用物理,2014(4):316-321.-100-。