hadoop集群完整配置过程详细笔记

Hadoop家族以及环境搭建(附图解)

Hadoop家族以及环境搭建(附图解)来源:ITSTAR回顾上次课内容,上一次课首先我们就给大家介绍了项目如何去安装Linuxp环境,这个步骤我们写得非常的清楚和详细,建议大家下来以后一定要按照我们的文档一步一步的进行操作,所以我们提供了一个word的文档,这个文档大家可以从我们这个实验介质当中可以找到这个文档,那这里实际上就列出来了你在安装这个Linux的时候需要注意哪些具体的问题。

前面的这些步骤都比较简单,咱们就看一看就可以了。

前面的这些都是比较简单,我们把重点的几个步骤给大家再说一下,我们往下看其中一个非常重要的步骤就是,你要选择你的网卡类型,我们在这里推荐大家去选择这个仅主机模式的这X网卡,它就能够保证我们的本机和虚拟机能够进行通信,这样我们在本机上通过Putty就能连接到虚拟机Linux上,但是你选择仅主机模式的时候,在安装Linux的时候就需要设置它的ip地址,而这个ip地址咱们的笔记上面是写得很清楚的,那么我们可以看到当你设置ip地址的时候,你需要跟你本机上VMware net1的这个网卡在同一个网段上,这个咱们可以来确定下,因为我们抓好了这个VMware以后我们可以打开我们的这个命令行的窗口,我们可以执行ip这个config -all列出来所有的ip的地址,我们应该看这个就是VMware net1的这个网卡,他锁定的ip地址是192.168.157注意,这个地址是网关地址,网关就是windows,然后在安Linux的时候,你指的ip地址需要跟这个ip地址在一个网段也就是说在这个157的这个上所以呢我们一共会安装5台的Linux,那么ip地址大家设置的时候要设是192.168.157.111,192.168.157.112,192.168.157.113和192.168.157.114和192.168.157.115这样,通过这些ip地址就可以从windows 上连接到Linux上,这个问题大家一定不要设置错了。

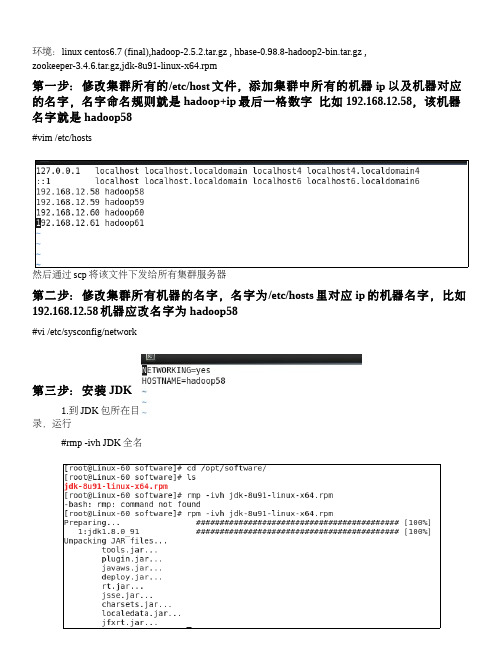

Hadoop集群配置详细

Linux系统配置

7安装JDK 将JDK文件解压,放到/usr/java目录下 cd /home/dhx/software/jdk mkdir /usr/java mv jdk1.6.0_45.zip /usr/java/

cd /usr/java

unzip jdk1.6.0_45.zip

从当前用户切换root用户的命令如下: 编辑主机名列表的命令

从当前用户切换root用户的命令如下:

Linux系统配置

操作步骤需要在HadoopMaster和HadoopSlave节点

上分别完整操作,都是用root用户。 从当前用户切换root用户的命令如下:

su root

从当前用户切换root用户的命令如下:

Linux系统配置

1拷贝软件包和数据包 mv ~/Desktop/software ~/

环境变量文件中,只需要配置JDK的路径

gedit conf/hadoop-env.sh

从当前用户切换root用户的命令如下: 编辑主机名列表的命令

Hadoop配置部署

3配置核心组件core-site.xml

gedit conf/core-site.xml

<configuration> <property> <name></name> /*2.0后用 fs.defaultFS代替*/ <value>hdfs://master:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/home/dhx/hadoopdata</value> </property> </configuration>

Hadoop集群配置详细解读

从当前用户切换root用户的命令如下:

Linux系统配置

操作步骤需要在HadoopMaster和HadoopSlave节点

上分别完整操作,都是用root用户。 从当前用户切换root用户的命令如下:

su root

从当前用户切换root用户的命令如下:

Linux系统配置

1拷贝软件包和数据包 mv ~/Desktop/software ~/

所有的操作都是用自定义用户(dhx)

su dhx

Hadoop安装包解压

cp hadoop-1.2.1.tar.gz ~/

cd

tar -zxvf hadoop-1.2.1.tar.gz

cd hadoop-1.2.1

从当前用户切换root用户的命令如下: 编辑主机名列表的命令

Hadoop集群配置手册(详细) 太原理工大学 邓红霞

提 纲

启动两台虚拟客户机

Linux系统配置 Hadoop配置部署 启动Hadoop集群 HDFS下的文件操作 Eclipse在Hadoop中的使用及配置

启动两台虚拟客户机

打开VMware Workstation10,打开已经安装好 的虚拟机HadoopMaster和HadoopSlave 。 如果之前没有打开过两个虚拟机,请使用文件 ->打开选项,选择之前的虚拟安装包。

Linux系统配置

6配置hosts列表 编辑主机名列表的命令,并添加如下两行到文件 gedit /etc/hosts 192.168.58.128 master 192.168.58.129 slave ping master ping slave

从当前用户切换root用户的命令如下: 编辑主机名列表的命令

hadoop集群搭建流程

包所在目有的话删除连接的java文件夹,没有直接创建一个连接文件夹java #java -version#ssh-keygen -t rsaauthorized_keys,将~/.ssh/id_rsa.pub里的内容复制到authorized_keys 桌面上的authorized_keys文件将~/.ssh/id_rsa.pub里的内容复制到authorized_keys文件里3.其他机器重复上述步骤4.将authorized_keys文件分别放到~/.ssh/下到此ssh免密码登录完成2.#ln -s hadoop-2.5.2 hadoop1.2.namenode节点,hdfs-site.xml配置需如下3.默认情况下是没有mapred-site.xml文件的,但是有mapred-site.xml.template文件,需要将mapred-site.xml.template复制一份并改名为mapred-site.xml#cp mapred-site.xml.template mapred-site.xml添加以下内容4.5.在其他机器上重复上述步骤,注意core-site.xml和yarn-site.xml都不变服务器上格式化datanode9.启动好后先运行start-dfs.sh,并测试10.启动start-yarn.sh第七步:配置zookeeper2.使用scp命令将改好的文件分发给其他的服务器文件:4.5.A_HOME和HBASE_MANAGES_ZK2.这两个文件分发到集群的其他服务器上3.修改datanode机器中/opt/software/hbase/conf/下的regionservers#cd /opt/software/hbase/conf/#vim regionserversSystem.out.println( "row Name:" + new String( CellUtil.cloneQualifier( cell ) ) + " " );System.out.println( "value:" + new String( CellUtil.cloneValue( cell ) ) + " " ); }}} finally {t.close();}System.out.println( "Done!" );注意,java测试程序所在机器的hosts文件,注意必须有全FDQN(fully qualified domain name, 参见上面linux中的hosts文件),否则有java访问时会提示找不到第九步:修该/etc/security/limits.conf#vim /etc/security/limits.conf添加:。

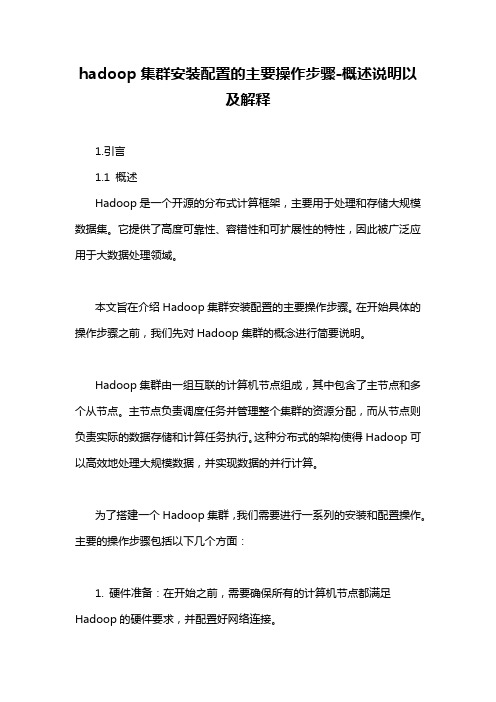

hadoop集群安装配置的主要操作步骤-概述说明以及解释

hadoop集群安装配置的主要操作步骤-概述说明以及解释1.引言1.1 概述Hadoop是一个开源的分布式计算框架,主要用于处理和存储大规模数据集。

它提供了高度可靠性、容错性和可扩展性的特性,因此被广泛应用于大数据处理领域。

本文旨在介绍Hadoop集群安装配置的主要操作步骤。

在开始具体的操作步骤之前,我们先对Hadoop集群的概念进行简要说明。

Hadoop集群由一组互联的计算机节点组成,其中包含了主节点和多个从节点。

主节点负责调度任务并管理整个集群的资源分配,而从节点则负责实际的数据存储和计算任务执行。

这种分布式的架构使得Hadoop可以高效地处理大规模数据,并实现数据的并行计算。

为了搭建一个Hadoop集群,我们需要进行一系列的安装和配置操作。

主要的操作步骤包括以下几个方面:1. 硬件准备:在开始之前,需要确保所有的计算机节点都满足Hadoop的硬件要求,并配置好网络连接。

2. 软件安装:首先,我们需要下载Hadoop的安装包,并解压到指定的目录。

然后,我们需要安装Java开发环境,因为Hadoop是基于Java 开发的。

3. 配置主节点:在主节点上,我们需要编辑Hadoop的配置文件,包括核心配置文件、HDFS配置文件和YARN配置文件等。

这些配置文件会影响到集群的整体运行方式和资源分配策略。

4. 配置从节点:与配置主节点类似,我们也需要在每个从节点上进行相应的配置。

从节点的配置主要包括核心配置和数据节点配置。

5. 启动集群:在所有节点的配置完成后,我们可以通过启动Hadoop 集群来进行测试和验证。

启动过程中,我们需要确保各个节点之间的通信正常,并且集群的各个组件都能够正常启动和工作。

通过完成以上这些操作步骤,我们就可以成功搭建一个Hadoop集群,并开始进行大数据的处理和分析工作了。

当然,在实际应用中,还会存在更多的细节和需要注意的地方,我们需要根据具体的场景和需求进行相应的调整和扩展。

Hadoop集群配置心得(低配置集群+自动同步配置)

Hadoop集群配置⼼得(低配置集群+⾃动同步配置)本⽂为本⼈原创,⾸发到炼数成⾦。

情况是这样的,我没有⼀个⾮常强劲的电脑来搞出⼀个性能⾮常NB的服务器集群,相信很多⼈也跟我差不多,所以现在把我的低配置集群经验拿出来写⼀下好了。

我的配备:1)五六年前的赛扬单核处理器2G内存笔记本 2)公司给配的ThinkpadT420,i5双核处理器4G内存(可⽤内存只有3.4G,是因为装的是32位系统的缘故吧。

)就算是⽤公司配置的电脑,做出来三台1G内存的虚拟机也显然是不现实的。

企业笔记本运⾏的软件多啊,什么都不做空余内存也才不到3G。

所以呢,我的想法就是:⽤我⾃⼰的笔记本(简称PC1)做Master节点,⽤来跑Jobtracker,Namenode 和SecondaryNamenode;⽤公司的笔记本跑两个虚拟机(简称VM1和VM2),⽤来做Slave节点,跑Tasktracker和Datanode。

这么做的话,就需要让PC1,VM1和VM2处于同⼀个⽹段⾥,保证他们之间可以互相连通。

⽹络环境:我的两台电脑都是通过⼀个⽆线路由上⽹。

构建跟外部的电脑同⼀⽹段的虚拟机配置过程:准备⼯作:构建⼀个集群,⾸先前提条件是每台服务器都要有⼀个固定的IP地址,然后才可能进⾏后续的操作。

所以呢,先把我的两台笔记本电脑全部设置成固定IP(注意,如果像我⼀样使⽤⽆线路由上⽹,那就要把⽆线⽹卡的IP设置成固定IP)。

⽤来做Master节点的PC1:192.168.33.150,⽤来跑虚拟机的宿主笔记本:192.168.33.157。

⽬标:VM1和VM2的IP地址分别设置成192.168.33.151和152。

步骤:1)新建VM1虚拟机。

2)打开VM1的⽹卡设置界⾯,连接⽅式选Bridge。

(桥接)关于桥接的具体信息,可以百度⼀下。

我们需要知道的,就是⽤桥接的⽅式,可以让虚拟机通过本机的⽹关来上⽹,所以就可以跟本机处于同⼀个⽹段,互相之间可以进⾏通信。

《hadoop基础》课件——第三章 Hadoop集群的搭建及配置

19

Hadoop集群—文件监控

http://master:50070

20

Hadoop集群—文件监控

http://master:50070

21

Hadoop集群—文件监控

http://master:50070

22

Hadoop集群—任务监控

http://master:8088

23

Hadoop集群—日志监控

http://master:19888

24

Hadoop集群—问题 1.集群节点相关服务没有启动?

1. 检查对应机器防火墙状态; 2. 检查对应机器的时间是否与主节点同步;

25

Hadoop集群—问题

2.集群状态不一致,clusterID不一致? 1. 删除/data.dir配置的目录; 2. 重新执行hadoop格式化;

准备工作:

1.Linux操作系统搭建完好。 2.PC机、服务器、环境正常。 3.搭建Hadoop需要的软件包(hadoop-2.7.6、jdk1.8.0_171)。 4.搭建三台虚拟机。(master、node1、node2)

存储采用分布式文件系统 HDFS,而且,HDFS的名称 节点和数据节点位于不同机 器上。

2、vim编辑core-site.xml,修改以下配置: <property>

<name>fs.defaultFS</name> <value>hdfs://master:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/opt/soft/hadoop-2.7.6/tmp</value> </property> <property> <name>fs.trash.interval</name> <value>1440</value> </property>

hadoop.集群搭建详解

hadoop2.2.0集群搭建PS:apache提供的hadoop-2.2.0的安装包是在32位操作系统编译的,因为hadoop依赖一些C++的本地库,所以如果在64位的操作上安装hadoop-2.2.0就需要重新在64操作系统上重新编译1.准备工作:(参考伪分布式搭建)1.1修改Linux主机名1.2修改IP1.3修改主机名和IP的映射关系1.4关闭防火墙1.5ssh免登陆1.6.安装JDK,配置环境变量等2.集群规划:PS:在hadoop2.0中通常由两个NameNode组成,一个处于active 状态,另一个处于standby状态。

Active NameNode对外提供服务,而Standby NameNode则不对外提供服务,仅同步active namenode的状态,以便能够在它失败时快速进行切换。

hadoop2.0官方提供了两种HDFS HA的解决方案,一种是NFS,另一种是QJM。

这里我们使用简单的QJM。

在该方案中,主备NameNode之间通过一组JournalNode同步元数据信息,一条数据只要成功写入多数JournalNode即认为写入成功。

通常配置奇数个JournalNode这里还配置了一个zookeeper集群,用于ZKFC(DFSZKFailoverController)故障转移,当Active NameNode挂掉了,会自动切换Standby NameNode为standby状态3.安装步骤:3.1.安装配置zooekeeper集群3.1.1解压tar -zxvf zookeeper-3.4.5.tar.gz -C /cloud/3.1.2修改配置cd /cloud/zookeeper-3.4.5/conf/cp zoo_sample.cfg zoo.cfgvim zoo.cfg修改:dataDir=/cloud/zookeeper-3.4.5/tmp在最后添加:server.1=hadoop01:2888:3888server.2=hadoop02:2888:3888server.3=hadoop03:2888:3888保存退出然后创建一个tmp文件夹mkdir /cloud/zookeeper-3.4.5/tmp再创建一个空文件touch /cloud/zookeeper-3.4.5/tmp/myid最后向该文件写入IDecho 1 > /cloud/zookeeper-3.4.5/tmp/myid3.1.3将配置好的zookeeper拷贝到其他节点(首先分别在hadoop02、hadoop03根目录下创建一个cloud目录:mkdir /cloud)scp -r /cloud/zookeeper-3.4.5/ hadoop02:/cloud/scp -r /cloud/zookeeper-3.4.5/ hadoop03:/cloud/注意:修改hadoop02、hadoop03对应/cloud/zookeeper-3.4.5/tmp/myid内容hadoop02:echo 2 > /cloud/zookeeper-3.4.5/tmp/myidhadoop03:echo 3 > /cloud/zookeeper-3.4.5/tmp/myid3.2.安装配置hadoop集群3.2.1解压tar -zxvf hadoop-2.2.0.tar.gz -C /cloud/3.2.2配置HDFS(hadoop2.0所有的配置文件都在$HADOOP_HOME/etc/hadoop目录下)将hadoop添加到环境变量中vim /etc/profileexport JAVA_HOME=/usr/java/jdk1.6.0_45export HADOOP_HOME=/cloud/hadoop-2.2.0export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin cd /cloud/hadoop-2.2.0/etc/hadoop3.2.2.1修改hadoo-env.shexport JAVA_HOME=/usr/java/jdk1.6.0_453,2.2.2修改core-site.xml<configuration><!-- 指定hdfs的nameservice为ns1 --><property><name>fs.defaultFS</name><value>hdfs://ns1</value></property><!-- 指定hadoop临时目录--><property><name>hadoop.tmp.dir</name><value>/cloud/hadoop-2.2.0/tmp</value></property><!-- 指定zookeeper地址--><property><name>ha.zookeeper.quorum</name><value>hadoop01:2181,hadoop02:2181,hadoop03:2181</value></property></configuration>3,2.2.3修改hdfs-site.xml<configuration><!--指定hdfs的nameservice为ns1,需要和core-site.xml中的保持一致--><property><name>services</name><value>ns1</value></property><!-- ns1下面有两个NameNode,分别是nn1,nn2 --> <property><name>nodes.ns1</name><value>nn1,nn2</value></property><!-- nn1的RPC通信地址--><property><name>node.rpc-address.ns1.nn1</name><value>hadoop01:9000</value></property><!-- nn1的http通信地址--><property><name>node.http-address.ns1.nn1</name><value>hadoop01:50070</value></property><!-- nn2的RPC通信地址--><property><name>node.rpc-address.ns1.nn2 </name><value>hadoop02:9000</value></property><!-- nn2的http通信地址--><property><name>node.http-address.ns1.nn2 </name><value>hadoop02:50070</value></property><!-- 指定NameNode的元数据在JournalNode上的存放位置--><property><name>node.shared.edits.dir<value>qjournal://hadoop01:8485;hadoop02:8485;hadoop03:8485 /ns1</value></property><!-- 指定JournalNode在本地磁盘存放数据的位置--><property><name>dfs.journalnode.edits.dir</name><value>/cloud/hadoop-2.2.0/journal</value></property><!-- 开启NameNode失败自动切换--><property><name>dfs.ha.automatic-failover.enabled</name><value>true</value></property><!-- 配置失败自动切换实现方式--><name>dfs.client.failover.proxy.provider.ns1</name><value>node.ha. ConfiguredFailoverProxyProvider</value></property><!-- 配置隔离机制--><property><name>dfs.ha.fencing.methods</name><value>sshfence</value></property><!-- 使用隔离机制时需要ssh免登陆--><property><name>dfs.ha.fencing.ssh.private-key-files</name><value>/root/.ssh/id_rsa</value> </property></configuration>3.2.2.4修改slaveshadoop01hadoop02hadoop033.2.3配置YARN3.2.3.1修改yarn-site.xml<configuration><!-- 指定resourcemanager地址--> <property><name>yarn.resourcemanager.hostname</name><value>hadoop01</value></property><!-- 指定nodemanager启动时加载server的方式为shuffle server --><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property></configuration>3.2.3.2修改mapred-site.xml<configuration><!-- 指定mr框架为yarn方式--><property><name></name><value>yarn</value></property></configuration>3.2.4将配置好的hadoop拷贝到其他节点scp -r /cloud/hadoop-2.2.0/ hadoo02:/cloud/scp -r /cloud/hadoop-2.2.0/ hadoo03:/cloud/3.2.5启动zookeeper集群(分别在hadoop01、hadoop02、hadoop03上启动zk)cd /cloud/zookeeper-3.4.5/bin/./zkServer.sh start查看状态:./zkServer.sh status(一个leader,两个follower)3.2.6启动journalnode(在hadoop01上启动所有journalnode)cd /cloud/hadoop-2.2.0sbin/hadoop-daemons.sh start journalnode(运行jps命令检验,多了JournalNode进程)3.2.7格式化HDFS在hadoop01上执行命令:hadoop namenode -format格式化后会在根据core-site.xml中的hadoop.tmp.dir配置生成个文件,这里我配置的是/cloud/hadoop-2.2.0/tmp,然后将/cloud/hadoop-2.2.0/tmp拷贝到hadoop02的/cloud/hadoop-2.2.0/下。

hadoop学习笔记(一、hadoop集群环境搭建)

Hadoop集群环境搭建1、准备资料虚拟机、Redhat6.5、hadoop-1.0.3、jdk1.62、基础环境设置2.1配置机器时间同步#配置时间自动同步crontab -e#手动同步时间/usr/sbin/ntpdate 1、安装JDK安装cd /home/wzq/dev./jdk-*****.bin设置环境变量Vi /etc/profile/java.sh2.2配置机器网络环境#配置主机名(hostname)vi /etc/sysconfig/network#修第一台hostname 为masterhostname master#检测hostname#使用setup 命令配置系统环境setup#检查ip配置cat /etc/sysconfig/network-scripts/ifcfg-eth0#重新启动网络服务/sbin/service network restart#检查网络ip配置/sbin/ifconfig2.3关闭防火墙2.4配置集群hosts列表vi /etc/hosts#添加一下内容到vi 中2.5创建用户账号和Hadoop部署目录和数据目录#创建hadoop 用户/usr/sbin/groupadd hadoop#分配hadoop 到hadoop 组中/usr/sbin/useradd hadoop -g hadoop#修改hadoop用户密码Passwd hadoop#创建hadoop 代码目录结构mkdir -p /opt/modules/hadoop/#修改目录结构权限拥有者为为hadoopchown -R hadoop:hadoop /opt/modules/hadoop/2.6生成登陆密钥#切换到Hadoop 用户下su hadoopcd /home/hadoop/#在master、node1、node2三台机器上都执行下面命令,生成公钥和私钥ssh-keygen -q -t rsa -N "" -f /home/hadoop/.ssh/id_rsacd /home/hadoop/.ssh#把node1、node2上的公钥拷贝到master上scp /home/hadoop/.ssh/ id_rsa.pub hadoop@master:/home/hadoop/.ssh/node1_pubkey scp /home/hadoop/.ssh/ id_rsa.pub hadoop@master:/home/hadoop/.ssh/node2_pubkey#在master上生成三台机器的共钥cp id_rsa.pub authorized_keyscat node1_pubkey >> authorized_keyscat node2_pubkey >> authorized_keysrm node1_pubkey node2_pubkey#吧master上的共钥拷贝到其他两个节点上scp authorized_keys node1: /home/hadoop/.ssh/scp authorized_keys node1: /home/hadoop/.ssh/#验证ssh masterssh node1ssh node2没有要求输入密码登陆,表示免密码登陆成功3、伪分布式环境搭建3.1下载并安装JAVA JDK系统软件#下载jdkwget http://60.28.110.228/source/package/jdk-6u21-linux-i586-rpm.bin#安装jdkchmod +x jdk-6u21-linux-i586-rpm.bin./jdk-6u21-linux-i586-rpm.bin#配置环境变量vi /etc/profile.d/java.sh#手动立即生效source /etc/profile3.2 Hadoop 文件下载和安装#切到hadoop 安装路径下cd /opt/modules/hadoop/#从 下载Hadoop 安装文件wget /apache-mirror/hadoop/common/hadoop-1.0.3/hadoop-1.0.3.tar.gz#如果已经下载,请复制文件到安装hadoop 文件夹cp hadoop-1.0.3.tar.gz /opt/modules/hadoop/#解压hadoop-1.0.3.tar.gzcd /opt/modules/hadoop/tar -xvf hadoop-1.0.3.tar.gz#配置环境变量vi /etc/profile.d/java.sh#手动立即生效source /etc/profile3.3配置hadoop-env.sh 环境变量#配置jdk。

hadoop完全分布模式Hadoop集群安装配置

hadoop 完全分布模式Hadoop 集群安装配置本来这篇⽂章该在去年11⽉底写出来的,被各种繁杂的事情所烦扰,再者⽹络上也有⾮常多⽐较完善的配置的⽂章,但是依旧是表述不太清晰。

依旧写个Step By Step 的教程,留待⼰⽤。

Hadoop 的部署环境是经过虚拟化之后的四台主机,OS 是Ubuntu Server10.04。

(XenServer5.6兼容的OS 并不包括Ubuntu ,将Ubuntu 转成PV 也是⼀个折腾的过程,另⽂介绍)。

Hadoop 的版本号依旧是:0.20.2.安装Java 环境如上⼀讲所⽰。

主机名及其IP 地址对应如下:Slave&TaskTracker:dm1,IP:192.168.0.17;(datanode)Slave&TaskTracker:dm2,IP:192.168.0.18;(datanode)Slave&TaskTracker:dm3,IP:192.168.0.9;(datanode)Master&JobTracker:dm4,IP:192.168.0.10;(namenode)Master 是Hadoop 集群的管理节点,重要的配置⼯作都在它上⾯,⾄于它的功能和作⽤请参考。

具体配置步骤如下:⼀.修改各个节点(dm1-dm4)的HostName ,命令如下:如下图所⽰例:⼆.在host 中添加机器的hostname 和IP ,⽤以通讯。

Master 需要知道所有的slave 的信息。

对应的slave 只需要知道Master 和⾃⾝的信息即可。

命令如下:Master(dm4)的hosts 配置应该如下图所⽰:其它的slave(dm3……)的hosts 配置应该如下图所⽰:三.Hadoop 核⼼代码需要配置conf ⽂件夹⾥⾯的core-site.xml,hdfs-site.xml,mapread-site.xml,mapred-site.xml ,hadoop-env.sh 这⼏个⽂件。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

本文为笔者安装配置过程中详细记录的笔记1.下载hadoophadoop-2.7.1.tar.gzhadoop-2.7.1-src.tar.gz 64位linux需要重新编译本地库2.准备环境Centos6.4 64位,3台hadoop0 192.168.1.151 namenodehadoop1 192.168.1.152 datanode1Hadoop2 192.168.1.153 datanode21)安装虚拟机:vmware WorkStation 10,创建三台虚拟机,创建时,直接建立用户ha,密码111111.同时为root密码。

网卡使用桥接方式。

安装盘、2). 配置IP.创建完成后,设置IP,可以直接进入桌面,在如下菜单下配置IP,配置好后,PING确认好用。

3)更改三台机器主机名切换到root用户,更改主机名。

[ha@hadoop0 ~]$ su - rootPassword:[root@hadoop0 ~]# hostname hadoop0[root@hadoop0 ~]# vi /etc/sysconfig/networkNETWORKING=yesHOSTNAME=hadoop0以上两步后重启服务器。

三台机器都需要修改。

4)创建hadoop用户由于在创建虚拟机时,已自动创建,可以省略。

否则用命令创建。

5)修改hosts文件[root@hadoop0 ~]# vi /etc/hosts127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4::1 localhost localhost.localdomain localhost6 localhost6.localdomain6192.168.1.151 hadoop0192.168.1.152 hadoop1192.168.1.153 hadoop2此步骤需要三台机器都修改。

3.建立三台机器间,无密码SSH登录。

1)三台机器生成密钥,使用hadoop用户操作[root@hadoop0 ~]# su – ha[ha@hadoop0 ~]$ ssh -keygen -t rsa所有选项直接回车,完成。

以上步骤三台机器上都做。

2)在namenode机器上,导入公钥到本机认证文件[ha@hadoop0 ~]$ cat ~/.ssh/id_rsa.pub>>~/.ssh/authorized_keys3)将hadoop1和hadoop2打开/home/ha/.ssh/ id_rsa.pub文件中的内容都拷贝到hadoop0的/home/ha /.ssh/authorized_keys文件中。

如下:4)将namenode上的/home/ha /.ssh/authorized_keys文件拷贝到hadoop1和hadoop2的/home/ha/.ssh文件夹下。

同时在三台机器上将authorized_keys授予600权限。

[**************]$chmod600authorized_keys5)验证任意两台机器是否可以无密码登录,如下状态说明成功,第一次访问时需要输入密码。

此后即不再需要。

[ha@hadoop0 ~]$ ssh hadoop1Last login: Tue Aug 11 00:58:10 2015 from hadoop24.安装JDK1.71)下载JDK(32或64位),解压[ha@hadoop0 tools]$ tar -zxvf jdk-7u67-linux-x64.tar.gz2)设置环境变量(修改/etx/profile文件),export JAVA_HOME=/usr/jdk1.7.0_67export CLASSPATH=:$CLASSPATH:$JAVA_HOME/lib:$JAVA_HOME/jre/libexport PATH=$PATH:$JAVA_HOME/bin:$JAVA_HOME/jre/bin3)使环境变量生效,然后验证JDK是否安装成功。

[ha@hadoop1 ~]$ source /etc/profile[ha@hadoop1 ~]$ java -versionjava version "1.7.0_67"Java(TM) SE Runtime Environment (build 1.7.0_67-b01)Java HotSpot(TM) 64-Bit Server VM (build 24.65-b04, mixed mode)5.关闭防火墙[root@hadoop0 ~]# chkconfig iptables off //关闭开机启动[root@hadoop0 ~]# service iptables stop //停止防火墙关闭selinux[root@hadoop0 ~]# vi /etc/selinux/configSELINUX=disable6.编译hadoop本地库,如果是64位linux,需要通过hadoop源代码重新编译本地库。

32位的不用编译。

1.)编译相关包下载下载重新编译需要的软件包apache-ant-1.9.6-bin.tar.gzfindbugs-3.0.1.tar.gzprotobuf-2.5.0.tar.gzapache-maven-3.3.3-bin.tar.gz下载hadoop2.7.1 的源码包hadoop-2.7.1-src.tar.gz2)安装相关包[root@hadoop0 ~]# tar -zxvf hadoop-2.7.1-src.tar.gz[root@hadoop0 ~]# tar -zxvf apache-maven-3.3.3-bin.tar.gz -C /opt/[root@hadoop0 ~]# tar -zxvf apache-ant-1.9.6-bin.tar.gz -C /opt/[root@hadoop0 ~]# tar -zxvf findbugs-3.0.1.tar.gz -C /opt/[root@hadoop0 ~]# tar -zxvf protobuf-2.5.0.tar.gz3)修改/etc/profile[root@hadoop0 ~]# vi /etc/profileexport MAVEN_HOME=/home/ha/maven-3.3.3export ANT_HOME=/home/ha/ant-1.9.6export FINDBUGS_HOME=/home/ha/findbugs-3.0.1export PATH=$PATH:$FINDBUGS_HOME/bin:$MAVEN_HOME/bin:$ANT_HOME/bin[root@hadoop0 ~]# source /etc/profile4) 安装PROTOBUF[root@hadoop0 ~]# cd protobuf-2.5.0[root@hadoop0 ~]# ./configure[root@hadoop0 ~]# make[root@hadoop0 ~]# make check[root@hadoop0 ~]# make install5)验证各软件是否安装成功。

[root@hadoop0 ~]# mvn –v[root@hadoop0 ~]# ant –version[root@hadoop0 ~]# findbugs –version[root@hadoop0 ~]# protoc –version6)安装依赖包[root@hadoop0 ~]# yum -y install svn ncurses-devel gcc*[root@hadoop0 ~]# yum -y lzo-devel zlib-devel autoconf automake libtool cmake openssl-devel7)编译hadoop[**********************.1-src]#cd/home/ha/hadoop-2.7.1-src[**********************.1-src]#mvncleaninstall–DskipTests[**********************.1-src]#mvnpackage-Pdist,native-DskipTests–Dtar执行过程中,会从互联网下载许多东西,由于网络原因,可能会失败,多执行几次就会成功。

编译成功后,会出现/home/ha/hadoop-2.7.1-src/hadoop-dist/target/hadoop-2.7.1/lib/native文件夹。

7.安装hadoop1)解压hadoop[ha@hadoop0 ~]$ tar –zxvf hadoop-2.7.1.tar.gz并将上一步编译好的native的内容替换/home/ha/hadoop-2.7.1/lib/native内容2)修改/home/ha/hadoop-2.7.1/etc/hadoop下配置文件。

hadoop-env.sh hdfs-site.xml core-site.xml mapred-site.xml slaves yarn-env.sh yarn-site.xml 略,详见配置文件.需要建立/home/ha/tmp,/home/ha/dfs/name,/home/ha/dfs/data三个文件夹。

在core-site.xml中配置<configuration><property><name>fs.defaultFS</name><value>hdfs://hadoop0:9000</value></property><property><name>io.file.buffer.size</name><value>131072</value></property><property><name>hadoop.tmp.dir</name><value>file:/home/ha/tmp</value><description>Abase for other temporary directories.</description></property></configuration>在hdfs-site.xml中配置<configuration><property><name>node.secondary.http-address</name><value>hadoop0:9001</value></property><property><name>.dir</name><value>file:/home/ha/dfs/name</value></property><property><name>dfs.datanode.data.dir</name><value>file:/home/ha/dfs/data</value></property><property><name>dfs.replication</name><value>3</value></property><property><name>dfs.webhdfs.enabled</name><value>true</value></property></configuration>配置mapred-site.xml文件<configuration><property><name></name><value>yarn</value></property><property><name>mapreduce.jobhistory.address</name><value>hadoop0:10020</value></property><property><name>mapreduce.jobhistory.webapp.address</name><value>hadoop0:19888</value></property></configuration>配置slaveshadoop1hadoop2配置yarn-site.xml<configuration><!-- Site specific YARN configuration properties --><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><property><name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name><value>org.apache.hadoop.mapred.ShuffleHandler</value></property><property><name>yarn.resourcemanager.address</name><value>hadoop0:8032</value></property><property><name>yarn.resourcemanager.scheduler.address</name><value>hadoop0:8030</value></property><property><name>yarn.resourcemanager.resource-tracker.address</name><value>hadoop0:8031</value></property><property><name>yarn.resourcemanager.admin.address</name><value>hadoop0:8033</value></property><property><name>yarn.resourcemanager.webapp.address</name><value>hadoop0:8088</value></property></configuration>确保hadoop-env.sh和yarn-env.sh中的JAVA_HOME是正确的。