基于Spark的机器学习资料29、Spark以及生态圈介绍

Spark技术及应用

总结词

高效、快速、可扩展

VS

详细描述

Spark是处理大规模数据的利器,尤其在处 理日志数据方面表现出色。通过Spark,可 以快速地读取、清洗、分析和处理大规模 的日志数据,提供实时的洞察和反馈。

案例二:使用Spark进行推荐系统构建

总结词

实时、准确、灵活

详细描述

Spark的MLlib库提供了丰富的机器学习算法,可以用于构建推荐系统。通过Spark,可 以实时地处理用户行为数据,快速地生成准确的推荐结果,并且可以根据业务需求灵活

数据分区优化

合理设置RDD和DataFrame的分区数,以 减少通信开销,提高并行度。

缓存优化

合理使用缓存,对于频繁访问的数据进行持 久化,减少重复计算。

序列化优化

选择高效序列化框架如Kryo,减少序列化和 反序列化开销。

任务调度优化

合理配置任务调度策略,如使用公平调度器, 避免资源竞争和长时间等待。

处理框架的集成,以应对不断变化的大数据处理需求。

Spark将探索更多的大数据应用场景,如物联网、社交媒体分析、

03

金融大数据等领域,以满足不断增长的大数据需求。

THANKS

感谢观看

Spark Streaming提供了DStream API,它是一个高层次 的抽象,使得流处理更加方便和直观。用户可以使用 DStream API来执行各种操作,如过滤、转换、聚合等。

Spark Streaming还支持流数据与批处理数据的结合,用 户可以将流数据与批处理数据结合起来进行实时分析。

Spark MLlib

03

Spark将探索与其他AI技术的结合,如与TensorFlow、PyTorch等深度学习框 架的集成,以提供更加全面和强大的AI解决方案。

Spark介绍

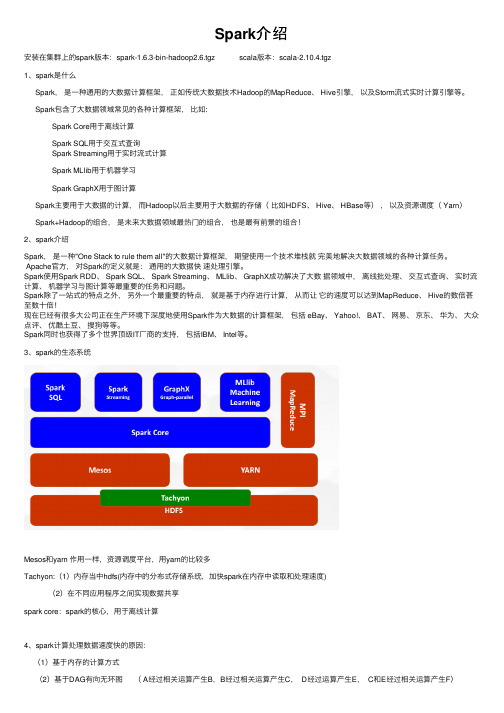

Spark介绍安装在集群上的spark版本:spark-1.6.3-bin-hadoop2.6.tgz scala版本:scala-2.10.4.tgz1、spark是什么Spark,是⼀种通⽤的⼤数据计算框架,正如传统⼤数据技术Hadoop的MapReduce、 Hive引擎,以及Storm流式实时计算引擎等。

Spark包含了⼤数据领域常见的各种计算框架,⽐如:Spark Core⽤于离线计算Spark SQL⽤于交互式查询Spark Streaming⽤于实时流式计算Spark MLlib⽤于机器学习Spark GraphX⽤于图计算Spark主要⽤于⼤数据的计算,⽽Hadoop以后主要⽤于⼤数据的存储(⽐如HDFS、 Hive、 HBase等),以及资源调度( Yarn)Spark+Hadoop的组合,是未来⼤数据领域最热门的组合,也是最有前景的组合!2、spark介绍Spark,是⼀种"One Stack to rule them all"的⼤数据计算框架,期望使⽤⼀个技术堆栈就完美地解决⼤数据领域的各种计算任务。

Apache官⽅,对Spark的定义就是:通⽤的⼤数据快速处理引擎。

Spark使⽤Spark RDD、 Spark SQL、 Spark Streaming、 MLlib、 GraphX成功解决了⼤数据领域中,离线批处理、交互式查询、实时流计算、机器学习与图计算等最重要的任务和问题。

Spark除了⼀站式的特点之外,另外⼀个最重要的特点,就是基于内存进⾏计算,从⽽让它的速度可以达到MapReduce、 Hive的数倍甚⾄数⼗倍!现在已经有很多⼤公司正在⽣产环境下深度地使⽤Spark作为⼤数据的计算框架,包括 eBay、 Yahoo!、 BAT、⽹易、京东、华为、⼤众点评、优酷⼟⾖、搜狗等等。

Spark同时也获得了多个世界顶级IT⼚商的⽀持,包括IBM、 Intel等。

Spark生态圈——大数据领跑者

Spark生态圈——大数据领跑者报告人:岳灵茜•Spark •GraphX(重点)•SparkStreaming时代的需要——spark家族•随着人们对计算速度和规模的要求不断扩大,以及数据挖掘,机器学习,大规模图算法等的兴起,当前单机的计算能力已经远远不能满足人们的需求。

•传统的分布式计算的复杂的编程接口,困难的调试,无法容错•无法“一栈式”处理Hadoop磁盘IO开销大!Spark——内存计算!快!还有Cache机制!Spark API•粗粒度——RDD(Resilient Distributed Datasets )上的操作•支持三种语言:–Scala(主要的)–Python–JavaSpark编程接口(举例说明)Transformations•map(func)•filter(func)•union(otherDataset)•reduceByKey(func,[numTasks])•repartitionAndSortWithinP artitions(partitioner)Action •reduce(func)•collect()•count()•foreach(func)“一栈式”搞定一切!良好的容错•基于Lineage的容错•每个RDD都会记录自己依赖于哪个(哪些)RDD,万一某个RDD的某些partition挂了,可以通过其它RDD并行计算迅速恢复出来。

每一个都看成RDD到底什么是RDD?•Resilient Distributed Dataset弹性分布式数据集•每个RDD对象包含如下信息:–分区–依赖–函数–最佳位置(可选)–分区策略(可选)Spark任务调度将一个job分解成多个stage(TaskSet)将一个stage分解成多个task交给各个计算单元如何将job分解成stage?再划分为Task?Spark组件•GraphX——图计算•SparkStreaming——流式处理•SparkSQL——Hive on spark •MLlab——机器学习GraphX——图数据的并行计算•GraphX是一个新的sparkAPI为图和图的并行计算而准备的•其前身为Bagel——即为spark能支持pregel而提供的一套API如何构造图?核心抽象——Triplets(三元组)•The EdgeTriplet类继承了Edge类,通过给它加上源顶点和目的顶点的属性对图的操作•GraphX提供了多种类型的操作:–Information about the Graph–Views of the graph as collections–Functions for caching graphs–Change the partitioning heuristic–Transform vertex and edge attributes–Modify the graph structure–Join RDDs with the graph–Aggregate information about adjacent triplets –Iterative graph-parallel computation–Basic graph algorithms对传统计算框架的支持•为了便于编程,GraphX提供了对传统框架编程接口的支持•例如Map-Reduce和PregelSpark对Pregel的支持•Pregel是Google提出的一个用于分布式图计算的计算框架•从高层次看Pregel是BSP模型,就是“计算”-“通信”-“计算”模式–作用于每个顶点的处理逻辑vertexProgram–消息发送,用于相邻节点间的通讯sendMessage –消息合并逻辑messageCombining•Spark对pregel的支持——GraphOps.pregel方法例子•以下是计算单源最短路径程序的片段Spark对MapReduce的支持•对图的每一个triplets执行传入的map函数和reduce函数•GraphOps类的aggregateMessages方法例子流式计算——SparkStreaming •将流式计算分解成一系列确定并且较小的批处理作业内部是如何做的?DStream •Discretized Stream or Dstream是SparkStreaming的主要抽象•它代表着一系列数据流•在内部,表示为一系列连续的RDDWindow操作•实际上,sparkstreaming也提供了基于window的操作。

Spark大数据技术简介与应用场景分析

Spark大数据技术简介与应用场景分析Spark是一种开源的大数据处理框架,被广泛应用于各种大数据处理场景中。

它的出现弥补了Hadoop MapReduce模型的不足,并且在性能方面有了极大的提升。

本文将对Spark大数据技术进行简介,并分析其在不同应用场景下的具体应用。

首先,让我们简要介绍一下Spark的基本概念和特点。

Spark是基于内存计算的大数据处理框架,它具有以下几个重要特点:速度快、易于使用、支持多种编程语言、可扩展性强以及丰富的库支持。

Spark的速度快是其最大的优势之一。

相比于Hadoop MapReduce模型,Spark将数据存储在内存中进行处理,大大减少了磁盘读写操作,从而提升了处理速度。

同时,Spark还使用了弹性分布式数据集(Resilient Distributed Datasets,简称RDD)的概念,使得数据可以在内存中快速分布式处理。

除了速度快之外,Spark还非常易于使用。

它提供了丰富的API和内置的机器学习、图计算等库,使得开发者可以很方便地进行大数据处理和分析。

同时,Spark支持多种编程语言,如Java、Scala、Python和R,使得开发者可以选择自己最擅长的语言进行开发。

Spark的可扩展性也是其重要特点之一。

它可以轻松地在集群中添加和移除节点,实现资源的动态分配和调度。

这使得Spark可以应对不同规模和需求的大数据场景,保持良好的性能。

接下来,让我们来分析一些Spark在不同应用场景下的具体应用。

1. 批处理:Spark可以用于大规模批处理任务,如ETL(Extract, Transform, Load)任务、离线数据分析和数据仓库构建等。

通过Spark的并行计算和内存处理,可以更快地完成这些任务,并且可以直接使用SQL语言进行数据查询和分析。

2. 流式处理:Spark提供了流式处理库Spark Streaming,可以处理实时数据流。

它使用微批处理的方式对数据进行处理,支持高容错性和低延迟。

Spark大数据技术原理与实践

HDFS

HDFS

read iter. 1 write

Input

HDFS read

Input

DataSharinginSpark

太慢,冗余读写、序列化、磁盘IO

HDFS

HDFS

read iter. 2 write

.. .

query 1

result 1

query 2

result 2

query 3 .. .

result 3

10-100x快于网络和磁盘

iter. 1

iter. 2

.. .

Input

one-time processing

Input

Distributed memory

query 1 query 2 query 3

.. .

Spark 核心概念-- RDDs

7

• 弹性分布式数据集(ResilientDistributed Datasets)

重复使用。

– A distributed memory abstraction that letsprogrammers perform

in-memory computations on large clusters – 只读的,可分区的分布式数据集 – 只能直接通过操作符来创建和处理 – 支持容错处理

• R D D 操作:

据栈的基础组件;

• 做什么

– 数据处理( Data Processing): 可以用来快速处理数 据,兼具容错性和可扩展性。

– 迭代计算( Iterative Computation):支持迭代计算, 有效应对多步的数据处理逻辑。

– 数据挖掘( Data Mining):在海量数据基础上进行复 杂的挖掘分析,可支持各种数据挖掘和机器学习算法。

Spark介绍(1)

Spark Stre作类似,主要有:flatMap、map、groupByKey等

窗口转换操作

Streaming特有,主要有window,countByWindow、reduceByWindow、 countByKeyAndWindow、reduceByKeyAndWindow

When called on datasets of types T and U, returns a dataset of (T, U) pairs (all pairs of elements).

RDD操作--action

函数

action

count

collect reduce

save foreach saveAsTextFile countByKey first take takeSample

Return a new dataset formed by selecting those elements of the source on which func returns true.

Similar to map, but each input item can be mapped to 0 or more output items (so func should return a Seq rather than a single item).

Spark 批处理

弹性分布数据集RDD

➢ Spark中对数据和计算的抽象,它表示已被分片(partition)、不可 变的、并能被并行执行的数据集合

➢ 每个RDD包含5个主要的特性: a、一组分片(partitions) b、一个计算分片的函数 c、依赖(lineage,谱系,怎么来的) d、位置偏好(可选,如何就近拉数据)

Spark之spark简介、生态圈详解

Spark之spark简介、⽣态圈详解1、简介1.1 Spark简介Spark是加州⼤学伯克利分校AMP实验室(Algorithms, Machines, and People Lab)开发通⽤内存并⾏计算框架。

Spark在2013年6⽉进⼊Apache成为孵化项⽬,8个⽉后成为Apache顶级项⽬,速度之快⾜见过⼈之处,Spark以其先进的设计理念,迅速成为社区的热门项⽬,围绕着Spark推出了Spark SQL、Spark Streaming、MLLib和GraphX等组件,也就是BDAS(伯克利数据分析栈),这些组件逐渐形成⼤数据处理⼀站式解决平台。

从各⽅⾯报道来看Spark抱负并⾮池鱼,⽽是希望替代Hadoop在⼤数据中的地位,成为⼤数据处理的主流标准,不过Spark还没有太多⼤项⽬的检验,离这个⽬标还有很⼤路要⾛。

Spark使⽤Scala语⾔进⾏实现,它是⼀种⾯向对象、函数式编程语⾔,能够像操作本地集合对象⼀样轻松地操作分布式数据集(Scala 提供⼀个称为 Actor 的并⾏模型,其中Actor通过它的收件箱来发送和接收⾮同步信息⽽不是共享数据,该⽅式被称为:Shared Nothing 模型)。

在Spark官⽹上介绍,它具有运⾏速度快、易⽤性好、通⽤性强和随处运⾏等特点。

l运⾏速度快Spark拥有DAG执⾏引擎,⽀持在内存中对数据进⾏迭代计算。

官⽅提供的数据表明,如果数据由磁盘读取,速度是Hadoop MapReduce的10倍以上,如果数据从内存中读取,速度可以⾼达100多倍。

l易⽤性好Spark不仅⽀持Scala编写应⽤程序,⽽且⽀持Java和Python等语⾔进⾏编写,特别是Scala是⼀种⾼效、可拓展的语⾔,能够⽤简洁的代码处理较为复杂的处理⼯作。

l通⽤性强Spark⽣态圈即BDAS(伯克利数据分析栈)包含了Spark Core、Spark SQL、Spark Streaming、MLLib和GraphX等组件,这些组件分别处理Spark Core提供内存计算框架、SparkStreaming的实时处理应⽤、Spark SQL的即席查询、MLlib或MLbase的机器学习和GraphX的图处理,它们都是由AMP实验室提供,能够⽆缝的集成并提供⼀站式解决平台。

Spark核心技术原理透视一Spark运行原理

Spark关键技术原理透视一(Spark运行原理)-加米谷大数据在大数据领域,只有深挖数据科学领域,走在学术前沿,才能在底层算法和模型方面走在前面,从而占据领先地位。

Spark旳这种学术基因,使得它从一开始就在大数据领域建立了一定优势。

无论是性能,还是方案旳统一性,对比老式旳Hadoop,优势都非常明显。

Spark提供旳基于RDD旳一体化处理方案,将MapReduce、Streaming、SQL、Machine Learning、Graph Processing 等模型统一到一种平台下,并以一致旳API公开,并提供相似旳布署方案,使得Spark旳工程应用领域变得愈加广泛。

本文重要分如下章节:一、Spark专业术语定义二、Spark运行基本流程三、Spark运行架构特点四、Spark关键原理透视一、Spark专业术语定义1、Application:Spark应用程序指旳是顾客编写旳Spark应用程序,包括了Driver功能代码和分布在集群中多种节点上运行旳Executor代码。

Spark应用程序,由一种或多种作业JOB构成,如下图所示:2、Driver:驱动程序Spark中旳Driver即运行上述Application旳Main()函数并且创立SparkContext,其中创立SparkContext旳目旳是为了准备Spark应用程序旳运行环境。

在Spark中由SparkContext负责和ClusterManager通信,进行资源旳申请、任务旳分派和监控等;当Executor部分运行完毕后,Driver负责将SparkContext关闭。

一般SparkContext代表Driver,如下图所示:3、Cluster Manager:资源管理器指旳是在集群上获取资源旳外部服务,常用旳有:Standalone,Spark原生旳资源管理器,由Master负责资源旳分派;Haddop Yarn,由Yarn中旳ResearchManager负责资源旳分派;Messos,由Messos中旳Messos Master负责资源管理,如下图所示:4、Executor:执行器Application运行在Worker节点上旳一种进程,该进程负责运行Task,并且负责将数据存在内存或者磁盘上,每个Application均有各自独立旳一批Executor,如下图所示:5、Worker:计算节点集群中任何可以运行Application代码旳节点,类似于Yarn中旳NodeManager节点。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Spark以及生态圈介绍

一、Spark简介

官方解释:Apache Spark™ is a fast and general engine for large-scale data processing.

打开官网网站解释一下。

三、Spark生态系统

•Spark Core:包含Spark的基本功能;尤其是定义RDD的API、操作以及这两者上的动作。

其他Spark的库都是构建在RDD和Spark Core之上的

•Spark SQL:提供通过Apache Hive的SQL变体Hive查询语言(HiveQL)与Spark进行交互的API。

每个数据库表被当做一个RDD,Spark SQL查询被转换为Spark操作。

•Spark Streaming:对实时数据流进行处理和控制。

Spark Streaming允许程序能够像普通RDD一样处理实时数据

•MLlib:一个常用机器学习算法库,算法被实现为对RDD的Spark操作。

这个库包含可扩展的学习算法,比如分类、回归等需要对大量数据集进行迭代的操作。

•GraphX:控制图、并行图操作和计算的一组算法和工具的集合。

GraphX扩展了RDD API,包含控制图、创建子图、访问路径上所有顶点的操作

Spark Core:

提供了有向无环图(DAG)的分布式并行计算框架,并提供Cache机制来支持多次迭代计算或者数据共享,大大减少迭代计算之间读取数据局的开销,这对于需要进行多次迭代的数据挖掘和分析性能有很大提升

l 在Spark中引入了RDD (Resilient Distributed Dataset) 的抽象,它是分布在一组节点中的只读对象集合,这些集

合是弹性的,如果数据集一部分丢失,则可以根据“血统”对它们进行重建,保证了数据的高容错性;

l 移动计算而非移动数据,RDD Partition可以就近读取分布式文件系统中的数据块到各个节点内存中进行计算

l 使用多线程池模型来减少task启动开稍

l 采用容错的、高可伸缩性的akka作为通讯框架

SparkStreaming:

SparkStreaming是一个对实时数据流进行高通量、容错处理的流式处理系统,可以对多种数据源(如Kdfka、Flume、Twitter、Zero和TCP 套接字)进行类似Map、Reduce和Join等复杂操作,并将结果保存到外部文件系统、数据库或应用到实时仪表盘。

计算流程:Spark Streaming是将流式计算分解成一系列短小的批处理作业。

这里的批处理引擎是Spark Core,也就是把Spark Streaming的输入数据按照batch size(如1秒)分成一段一段的数据(Discretized Stream),每一段数据都转换成Spark中的RDD(Resilient Distributed Dataset),然后将Spark Streaming中对DStream的Transformation 操作变为针对Spark中对RDD的Transformation操作,将RDD经过操作变成中间结果保存在内存中。

整个流式计算根据业务的需求可以对中间的结果进行叠加或者存储到外部设备。

下图显示了Spark Streaming的整个流程。

l容错性:对于流式计算来说,容错性至关重要。

首先我们要明确一下Spark中RDD的容错机制。

每一个RDD都是一个不可变的分布式可重算的数据集,其记录着确定性的操作继承关系(lineage),所以只要输入数据是可容错的,那么任意一个RDD的分区(Partition)出错或不可用,都是可以利用原始输入数据通过转换操作而重新算出的。

对于Spark Streaming来说,其RDD的传承关系如下图所示,图中的每一个椭圆形表示一个RDD,椭圆形中的每个圆形代表一个RDD中的一个Partition,图中的每一列的多个RDD表示一个DStream(图中有三个DStream),而每一行最后一个RDD则表示每一个Batch Size所产生的中间结果RDD。

我们可以看到图中的每一个RDD都是通过lineage相连接的,由于Spark Streaming输入数据可以来自于磁盘,例如HDFS(多份拷贝)或是来自于网络的数据流(Spark Streaming会将网络输入数据的每一个数据流拷贝两份到其他的机器)都能保证容错性,所以RDD中任意的Partition出错,都可以并行地在其他机器上将缺失的Partition计算出来。

这个容错恢复方式比连续计算模型(如Storm)的效率更高。

l实时性:对于实时性的讨论,会牵涉到流式处理框架的应用场景。

Spark Streaming将流式计算分解成多个Spark Job,对于每一段数据的处理都会经过Spark DAG图分解以及Spark的任务集的调度过程。

对于目前版本的Spark Streaming而言,其最小的Batch Size的选取在0.5~2秒钟之间(Storm目前最小的延迟是100ms左右),所以Spark Streaming能够满足除对实时性要求非常高(如高频实时交易)之外的所有流式准实时计算场景。

l扩展性与吞吐量:Spark目前在EC2上已能够线性扩展到100个节点(每个节点4Core),可以以数秒的延迟处理6GB/s的数据量(60M records/s),其吞吐量也比流行的Storm高2~5倍,图4是Berkeley利用WordCount和Grep 两个用例所做的测试,在Grep这个测试中,Spark Streaming中的每个节点的吞吐量是670k records/s,而Storm

是115k records/s。

Spark SQL:

Spark SQL允许开发人员直接处理RDD,同时也可查询例如在Apache Hive上存在的外部数据。

Spark SQL的一个重要特点是其能够统一处理关系表和RDD,使得开发人员可以轻松地使用SQL命令进行外部查询,同时进行更复杂的数据分析。

MLlib:

MLlib是Spark实现一些常见的机器学习算法和实用程序,包括分类、回归、聚类、协同过滤、降维以及底层优化,该算法可以进行可扩充; MLRuntime基于Spark计算框架,将Spark的分布式计算应用到机器学习领域。

GraphX:

GraphX是Spark中用于图(e.g., Web-Graphs and Social Networks)和图并行计算(e.g., PageRank and Collaborative Filtering)的API,可以认为是GraphLab(C++)和Pregel(C++)在Spark(Scala)上的重写及优化,跟其他分布式图计算框架

相比,GraphX最大的贡献是,在Spark之上提供一栈式数据解决方案,可以方便且高效地完成图计算的一整套流水作业。

GraphX最先是伯克利AMPLAB的一个分布式图计算框架项目,后来整合到Spark中成为一个核心组件。