Hadoop安装部署手册

Hadoop安装手册

Hadoop目录1Centos ··········································· 错误!未定义书签。

1.1安装环境 (3)1.2初始环境配置 (3)1.2.1设置centos开机自启动网络 (3)1.2.2关闭防火墙 (4)1.2.3关闭selinux (5)1.2.4修改hosts (5)1.3安装JDK (6)1.3.1安装 (6)1.3.2设置环境变量 (7)1.4添加用户 (8)1.5复制虚拟机 (8)1Hadoop1.1.2安装1.1安装环境操作系统:Centos6.5 64位Hadoop:hadoop-1.1.2Jdk:jdk-7u511.2初始环境配置1.2.1设置centos开机自启动网络[root@localhost network-scripts]# cd /etc/sysconfig/network-scripts[root@localhost network-scripts]# lsifcfg-eth0 ifdown-bnep ifdown-ipv6 ifdown-ppp ifdown-tunnel ifup-bnep ifup-ipv6 ifup-plusb ifup-routes ifup-wireless network-functionsifcfg-lo ifdown-eth ifdown-isdn ifdown-routes ifup ifup-eth ifup-isdn ifup-post ifup-sit init.ipv6-global network-functions-ipv6ifdown ifdown-ippp ifdown-post ifdown-sit ifup-aliases ifup-ippp ifup-plip ifup-ppp ifup-tunnel net.hotplug第3页/共53页[root@localhost network-scripts]# vi ifcfg-eth0DEVICE=eth0HWADDR=00:0C:29:09:8B:B0TYPE=EthernetUUID=3192d1fe-8ff3-411f-81b7-8270e86f5959ONBOOT=yesNM_CONTROLLED=yesBOOTPROTO=dhcp1.2.2关闭防火墙关闭防火墙[root@master01 /]# service iptables stopiptables:将链设置为政策 ACCEPT:filter [确定]iptables:清除防火墙规则: [确定]iptables:正在卸载模块: [确定]设置开机不启用[root@master01 /]# chkconfig iptables off第4页/共53页1.2.3关闭selinux[root@master01 /]# vi /etc/selinux/config# This file controls the state of SELinux on the system.# SELINUX= can take one of these three values:# enforcing - SELinux security policy is enforced.# permissive - SELinux prints warnings instead of enforcing.# disabled - No SELinux policy is loaded.SELINUX=disabled# SELINUXTYPE= can take one of these two values:# targeted - Targeted processes are protected,# mls - Multi Level Security protection.#SELINUXTYPE=targeted1.2.4修改hosts[root@master01 etc]# vi /etc/hosts127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4 ::1 localhost localhost.localdomain localhost6 localhost6.localdomain6 192.168.239.100 master01第5页/共53页192.168.239.101 slave01192.168.239.102 slave021.3安装JDK1.3.1安装cd /home/nunchakus[root@localhost nunchakus]# lsjdk-7u51-linux-x64.rpm[root@localhost nunchakus]# rpm -ivh jdk-7u51-linux-x64.rpmPreparing... ########################################### [100%] 1:jdk ########################################### [100%] Unpacking JAR files...rt.jar...jsse.jar...charsets.jar...tools.jar...localedata.jar...jfxrt.jar...[root@localhost nunchakus]# lsjdk-7u51-linux-x64.rpm[root@localhost nunchakus]# cd /usr[root@localhost usr]# lsbin etc games include java lib lib64 libexec local sbin share src tmp [root@localhost usr]# cd java[root@localhost java]# lsdefault jdk1.7.0_51 latest第6页/共53页1.3.2设置环境变量[root@localhost ~]# vi /etc/profile末尾加入export JAVA_HOME=/usr/java/jdk1.7.0_51export JAVA_BIN=/usr/java/jdk1.7.0_51/binexport PATH=$PATH:$JAVA_HOME/binexport CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar export JAVA_HOME JAVA_BIN PATH CLASSPATH让/etc/profile文件修改后立即生效,可以使用如下命令:# . /etc/profile注意: . 和/etc/profile 有空格.重启测试[root@localhost ~]# java -version第7页/共53页java version "1.7.0_45"OpenJDK Runtime Environment (rhel-2.4.3.3.el6-x86_64 u45-b15)OpenJDK 64-Bit Server VM (build 24.45-b08, mixed mode)1.4添加用户[root@master01 /]# useradd hadoop[root@master01 /]# passwd hadoop更改用户hadoop 的密码。

HADOOP2.2安装部署手册

HA D O O P2.2安装部署手册XXXXX公司2014年5月版本号更新人更新日期V1.0Box2014-5-15目录目录 (I)第1章基础环境 (1)1.1集群规划 (1)1.1.1.修改主机名 (1)1.1.2.职责划分 (1)第2章软件版本 (2)2.1软件 (2)2.2文件目录规划 (2)第3章基础配置 (3)3.1集群SSH无密码互信 (3)3.2配置系统环境变量 (3)第4章HADOOP安装 (4)4.1配置文件修改 (4)4.1.1修改$HADOOP_HOME/etc/Hadoop/hadoop-env.sh (4)4.1.2修改$HADOOP_HOME/etc/Hadoop/slaves (4)4.1.3修改$HADOOP_HOME/etc/Hadoop/core-site.xml (4)4.1.4修改$HADOOP_HOME/etc/Hadoop/hdfs-site.xml (5)4.1.5修改$HADOOP_HOME/etc/Hadoop/mapred-site.xml (6)4.1.6修改$HADOOP_HOME/etc/Hadoop/yarn-site.xml (7)4.1.7分发到各结点 (9)4.2格式化HDFS (9)4.3启动HDFS、YARN (9)4.4检查集群运行状态 (9)第5章ZOOKEEPER安装 (9)5.1修改配置 (9)5.2分发到各结点 (10)5.3启动ZOOKEEPER (10)第6章HBASE安装 (10)6.1修改配置 (10)6.1.1修改$HBASE_HOME/conf/hbase-env.sh (10)6.1.2修改$HBASE_HOME/conf/RegionServer (10)6.1.3修改$HBASE_HOME/conf/hbase-site.xml (11)6.2分发到各结点 (12)6.3启动HBASE (12)第7章安装HIVE (12)7.1安装MYSQL (12)7.1.1检查是否已经安装过MYSQL (12)7.1.2安装MYSQL (13)7.1.3配置MYSQL (13)7.1.4修改root密码 (14)7.1.5创建hive元数据数据库 (14)7.2修改HIVE配置 (15)7.2.1修改$HIVE_HOME/conf/hive-site.xml (15)7.3开启HIVE服务 (16)第8章安装SPARK (17)8.1修改配置 (17)8.1.1修改$SPARK_HOME/spark-env.sh (17)8.1.2修改slaves (17)8.2分发到各结点 (17)8.3启动spark (17)第9章安装SHARK (18)9.1修改配置 (18)9.2进入SHARK控制台 (18)附录A:HADOOP-HBASE兼容表 (18)附录B:问题清单 (19)第1章基础环境[root@ip-172-167-15-226~]#lsb_release-aLSBVersion::core-4.0-amd64:core-4.0-noarch:graphics-4.0-amd64:graphics-4.0-noarch:printing-4.0-amd6 4:printing-4.0-noarchDistributor ID:RedHatEnterpriseServerDescription:Red Hat Enterprise Linux Server release6.2(Santiago)Release: 6.2Codename:Santiago1.1集群规划1.1.1.修改主机名vi/etc/sysconfig/networkHOSTNAME=hadoo201vi/etc/hosts#for hadoop2cluster#pengyq2014.5.13172.167.15.226hadoop201172.167.15.227hadoop202172.167.15.228hadoop203172.167.15.230hadoop204172.167.15.231hadoop2051.1.2.职责划分hadoop201作为namenode、seconderynamenode、HMaster、Spark Masterhadoop202,hadoop203,hadoop204,hadoop205为DataNode、RegionServer、Spark Slaver五台机器都作为Zookeeper节点第2章软件版本2.1软件版本兼容请参照附录A[hadoop@hadoop201hadoop2_cluster]$lsjdk1.7.0_55#JAVA运行基础环境hadoop-2.2.0Zookeeper-3.4.6#hbase依赖(使用hbase0.98.2自带zk安装遇到了问题,所以独立安装zk群)hbase-0.98.2apache-hive-0.13.0-binscala-2.11.0#spark依赖spark-0.9.1-bin-hadoop2shark-0.9.1-bin-hadoop22.2文件目录规划/Hadoop/home/hadoop2_cluster/jdk1.7.0_55/hadoop-2.2.0/Zookeeper-3.4.6/hbase-0.98.2/apache-hive-0.13.0-bin/scala-2.11.0/spark-0.9.1-bin-hadoop2/shark-0.9.1-bin-hadoop2/workspace/dfs/data/#hdfs数据name/#namenode数据hive/#hive querylogmapred/#mapreduce日志tmp/zookeeper/#zookeeper datadir/opt/mysql_data/mysql#mysql数据存放目录第3章基础配置3.1集群SSH无密码互信生成SSH密钥ssh-keygen#分发公钥到受控节点ssh-copy-id-i~/.ssh/id_rsa.pub hadoop@hadoop202ssh-copy-id-i~/.ssh/id_rsa.pub hadoop@hadoop203ssh-copy-id-i~/.ssh/id_rsa.pub hadoop@hadoop204ssh-copy-id-i~/.ssh/id_rsa.pub hadoop@hadoop205出现的问题:Permission denied(publickey,gssapi-with-mic).修改了/etc/ssh/sshd_config中的"PasswordAuthentication"参数值为"no",修改回"yes",重启sshd服务即可。

大数据Hadoop集群安装部署文档

大数据Hadoop集群安装部署文档一、背景介绍大数据时代下,海量数据的处理和分析成为了一个重要的课题。

Hadoop是一个开源的分布式计算框架,能够高效地处理海量数据。

本文将介绍如何安装和部署Hadoop集群。

二、环境准备1.集群规模:本文以3台服务器组成一个简单的Hadoop集群。

2.操作系统:本文以Linux作为操作系统。

三、安装过程1.安装JavaHadoop是基于Java开发的,因此需要先安装Java。

可以通过以下命令安装:```sudo apt-get updatesudo apt-get install openjdk-8-jdk```2.安装Hadoop```export HADOOP_HOME=/opt/hadoopexport PATH=$PATH:$HADOOP_HOME/bin```保存文件后,执行`source ~/.bashrc`使配置生效。

3.配置Hadoop集群在Hadoop安装目录中的`etc/hadoop`目录下,有一些配置文件需要进行修改。

a.修改`hadoop-env.sh`文件该文件定义了一些环境变量。

可以找到JAVA_HOME这一行,将其指向Java的安装目录:```export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64```b.修改`core-site.xml`文件```<property><name>fs.defaultFS</name><value>hdfs://localhost:9000</value></property>```c.修改`hdfs-site.xml`文件```<property><name>dfs.replication</name><value>3</value></property>```其中,`dfs.replication`定义了数据的副本数,这里设置为34.配置SSH免密码登录在Hadoop集群中,各个节点之间需要进行通信。

hadoop安装指南及基本命令

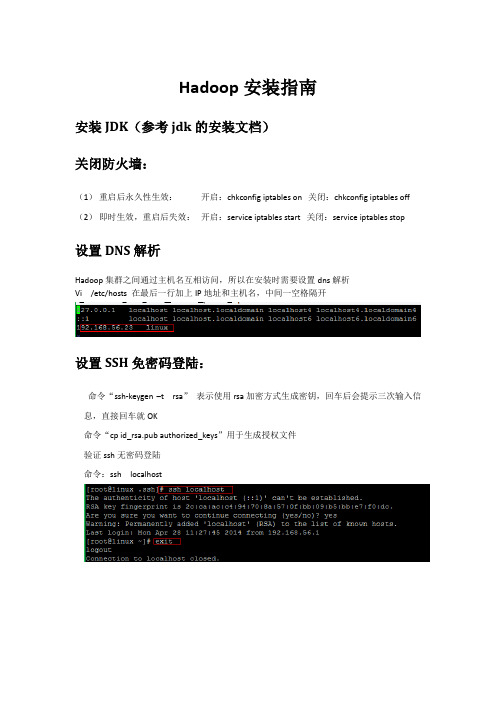

Hadoop安装指南安装JDK(参考jdk的安装文档)关闭防火墙:(1)重启后永久性生效:开启:chkconfig iptables on 关闭:chkconfig iptables off (2)即时生效,重启后失效:开启:service iptables start 关闭:service iptables stop设置DNS解析Hadoop集群之间通过主机名互相访问,所以在安装时需要设置dns解析Vi /etc/hosts 在最后一行加上IP地址和主机名,中间一空格隔开设置SSH免密码登陆:命令“ssh-keygen –t rsa”表示使用rsa加密方式生成密钥,回车后会提示三次输入信息,直接回车就OK命令“cp id_rsa.pub authorized_keys”用于生成授权文件验证ssh无密码登陆命令:ssh localhost安装hadoop安装程序包将hadoop-1.1.2.tar.gz 放在usr/hadopp目录下命令: tar –xzvf Hadoop-1.1.2.tar.gz设置环境变量Vi /etc/profile 在最后面输入:Export HADOOP_HOME=/usr/Hadoop/Hadoop-1.1.2Export PATH=$PATH:$HADOOP_HOME/bin修改hadoop配置文件1.hadoop-env.shexport JAVA_HOME=/usr/local/jdk/2.core-site.xml<configuration><property><name></name><value>hdfs://hadoop0:9000</value><description>change your own hostname</description> </property><property><name>hadoop.tmp.dir</name><value>/usr/local/hadoop/tmp</value></property></configuration>3.hdfs-site.xml<configuration><property><name>dfs.replication</name><value>1</value></property><property><name>dfs.permissions</name><value>false</value></property></configuration>4.mapred-site.xml<configuration><property><name>mapred.job.tracker</name><value>hadoop0:9001</value><description>change your own hostname</description></property></configuration>Hadoop集群环境的搭建1、准备机器一台master,若干台slave,配置每台机器的/etc/hosts保证各台机器之间通过机器名可以互访,当前准备三台机器:对三台机器分别安装hadoop环境,SSH秘密登陆和DNS 解析。

Hadoop安装部署文档

1.系统版本2.环境规划3.分别使用root用户,设置两台机器的主机名保存设置,并检查:然后,设置主机名和IP对应关系:保存设置,并检查:然后,设置主机名和IP对应关系:4.分别创建用户Hmaster、Hslave5.设置两台机器ssh无密码登录一般系统是默认安装了ssh命令的,如果没有,自行安装。

在Hmaster,切换到Hadoop用户第一步:产生密钥第二步:导入authorized_keys第三步:ssh无密码连接测试☆如果出现提示第四步:设置Hmaster与Hslave机器相互无密访问6.安装jdk7.安装hadoop-2.5.21.解压在Hmaser机器,解压hadoop-2.5.2.tar.gz,并创建以下文件夹(Hadoop用户)2.修改配置文件2.1.修改core-site.xml2.2.修改hdfs-site.xml2.3.修改mapred-site.xml2.4.修改yarn-site.xml2.5.修改slaves2.6.修改hadoop-env.sh2.7.修改yarn-env.sh3.将hadoop-2.5.2文件夹传输到Hslave8.格式化文件系统hdfs-site.xml的.dir和dfs.datanode.data.dir目录做相应的清理工作。

9.启动hdfs:platform则上传hadoop-native-64-2.5.2所以文件覆盖至/home/Hadoop/hadoop-2.5.2/lib/native/下载地址(/sequenceiq/sequenceiq-bin/)10.启动yarn:11.查看进程信息在Hmaster在Hslave12.查看HDFS集群状态http://Hmaster:50070/http://Hmaster:8088/13.关闭hdfs:14.关闭yarn:。

Hadoop的安装及配置

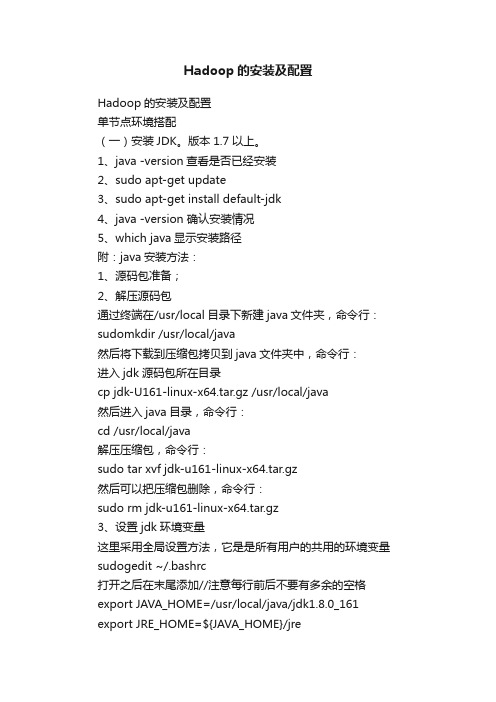

Hadoop的安装及配置Hadoop的安装及配置单节点环境搭配(一)安装JDK。

版本1.7以上。

1、java -version查看是否已经安装2、sudo apt-get update3、sudo apt-get install default-jdk4、java -version 确认安装情况5、which java显示安装路径附:java安装方法:1、源码包准备;2、解压源码包通过终端在/usr/local目录下新建java文件夹,命令行:sudomkdir /usr/local/java然后将下载到压缩包拷贝到java文件夹中,命令行:进入jdk源码包所在目录cp jdk-U161-linux-x64.tar.gz /usr/local/java然后进入java目录,命令行:cd /usr/local/java解压压缩包,命令行:sudo tar xvf jdk-u161-linux-x64.tar.gz然后可以把压缩包删除,命令行:sudo rm jdk-u161-linux-x64.tar.gz3、设置jdk环境变量这里采用全局设置方法,它是是所有用户的共用的环境变量sudogedit ~/.bashrc打开之后在末尾添加//注意每行前后不要有多余的空格export JAVA_HOME=/usr/local/java/jdk1.8.0_161 export JRE_HOME=${JAVA_HOME}/jreexport CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib export PATH=${JAVA_HOME}/bin:$PATH4、java -version看看是否安装成功(二)设置SSH无密码登录1、sudo apt-get install ssh2、sudo apt-get install rsync3、ssh-keygen -t rsa4、ll ~/.ssh 查看生成的密钥(三)hadoop下载安装1、在apache官方网站下载hadoop2、解压tar -zxvf hadoop-2.6.5.tar.gz3、sudo mv hadoop-2.6.5 /usr/local/hadoop4、ll /usr/local/hadoop 查看安装情况(四)hadoop环境变量的设置1、sudogedit ~/.bashrc2、添加下列设置设置HADOOP_HOME为Hadoop的安装路径export HADOOP_HOME=/usr/local/hadoop设置PATHexport PATH=$PATH:$HADOOP_HOME/binexport PATH=$PATH:$HADOOP_HOME/sbin3、Hadoop其他环境变量设置export HADOOP_MAPRED_HOME=$HADOOP_HOMEexport HADOOP_COMMON_HOME=$HADOOP_HOMEexport HADOOP_HDFS_HOME=$HADOOP_HOMEexport YARN_HOME=$HADOOP_HOMEexportHADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/na tiveexport HADOOP_OPTS="-DJava.library.path=$HADOOP_HOME/lib"exportJAVA_LIBRARY_PATH=$HADOOP_HOME/lib/native:$JAVA_LIBRA RY_PATH4、source ~/.bashrc(五)修改Hadoop配置文件1、设置hadoop-env.sh配置文件sudogedit /usr/local/hadoop/etc/hadoop/hadoop-env.sh修改export JAVA_HOME=/usr/local/java/jdk1.8.0_1612、修改core-site.xmlsudo vim /usr/local/hadoop/etc/hadoop/core-site.xml/doc/eb13635280.html,hdfs://localhost:9000。

Hadoop2.4、Hbase0.98、Hive集群安装配置手册

Hadoop、Zookeeper、Hbase、Hive集群安装配置手册运行环境机器配置虚机CPU E5504*2 (4核心)、内存 4G、硬盘25G进程说明QuorumPeerMain ZooKeeper ensemble member DFSZKFailoverController Hadoop HA进程,维持NameNode高可用 JournalNode Hadoop HA进程,JournalNode存储EditLog,每次写数据操作有大多数(>=N+1)返回成功时即认为该次写成功,保证数据高可用 NameNode Hadoop HDFS进程,名字节点DataNode HadoopHDFS进程, serves blocks NodeManager Hadoop YARN进程,负责 Container 状态的维护,并向 RM 保持心跳。

ResourceManager Hadoop YARN进程,资源管理 JobTracker Hadoop MR1进程,管理哪些程序应该跑在哪些机器上,需要管理所有 job 失败、重启等操作。

TaskTracker Hadoop MR1进程,manages the local Childs RunJar Hive进程HMaster HBase主节点HRegionServer HBase RegionServer, serves regions JobHistoryServer 可以通过该服务查看已经运行完的mapreduce作业记录应用 服务进程 主机/hostname 系统版本mysql mysqld10.12.34.14/ Centos5.810.12.34.15/h15 Centos5.8 HadoopZookeeperHbaseHiveQuorumPeerMainDFSZKFailoverControllerNameNodeNodeManagerRunJarHMasterJournalNodeJobHistoryServerResourceManagerDataNodeHRegionServer10.12.34.16/h16 Centos5.8 HadoopZookeeperHbaseHiveDFSZKFailoverControllerQuorumPeerMainHMasterJournalNodeNameNodeResourceManagerDataNodeHRegionServerNodeManager10.12.34.17/h17 Centos5.8 HadoopZookeeperHbaseHiveNodeManagerDataNodeQuorumPeerMainJournalNodeHRegionServer环境准备1.关闭防火墙15、16、17主机:# service iptables stop2.配置主机名a) 15、16、17主机:# vi /etc/hosts添加如下内容:10.12.34.15 h1510.12.34.16 h1610.12.34.17 h17b) 立即生效15主机:# /bin/hostname h1516主机:# /bin/hostname h1617主机:# /bin/hostname h173. 创建用户15、16、17主机:# useraddhduser密码为hduser# chown -R hduser:hduser /usr/local/4.配置SSH无密码登录a)修改SSH配置文件15、16、17主机:# vi /etc/ssh/sshd_config打开以下注释内容:#RSAAuthentication yes#PubkeyAuthentication yes#AuthorizedKeysFile .ssh/authorized_keysb)重启SSHD服务15、16、17主机:# service sshd restartc)切换用户15、16、17主机:# su hduserd)生成证书公私钥15、16、17主机:$ ssh‐keygen ‐t rsae)拷贝公钥到文件(先把各主机上生成的SSHD公钥拷贝到15上的authorized_keys文件,再把包含所有主机的SSHD公钥文件authorized_keys拷贝到其它主机上)15主机:$cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys16主机:$cat ~/.ssh/id_rsa.pub | ssh hduser@h15 'cat >> ~/.ssh/authorized_keys'17主机:$cat ~/.ssh/id_rsa.pub | ssh hduser@h15 'cat >> ~/.ssh/authorized_keys'15主机:# cat ~/.ssh/authorized_keys | ssh hduser@h16 'cat >> ~/.ssh/authorized_keys'# cat ~/.ssh/authorized_keys | ssh hduser@h17 'cat >> ~/.ssh/authorized_keys'5.Mysqla) Host10.12.34.14:3306b) username、passwordhduser@hduserZookeeper使用hduser用户# su hduser安装(在15主机上)1.下载/apache/zookeeper/2.解压缩$ tar ‐zxvf /zookeeper‐3.4.6.tar.gz ‐C /usr/local/配置(在15主机上)1.将zoo_sample.cfg重命名为zoo.cfg$ mv /usr/local/zookeeper‐3.4.6/conf/zoo_sample.cfg /usr/local/zookeeper‐3.4.6/conf/zoo.cfg2.编辑配置文件$ vi /usr/local/zookeeper‐3.4.6/conf/zoo.cfga)修改数据目录dataDir=/tmp/zookeeper修改为dataDir=/usr/local/zookeeper‐3.4.6/datab)配置server添加如下内容:server.1=h15:2888:3888server.2=h16:2888:3888server.3=h17:2888:3888server.X=A:B:C说明:X:表示这是第几号serverA:该server hostname/所在IP地址B:该server和集群中的leader交换消息时所使用的端口C:配置选举leader时所使用的端口3.创建数据目录$ mkdir /usr/local/zookeeper‐3.4.6/data4.创建、编辑文件$ vi /usr/local/zookeeper‐3.4.6/data/myid添加内容(与zoo.cfg中server号码对应):1在16、17主机上安装、配置1.拷贝目录$ scp ‐r /usr/local/zookeeper‐3.4.6/ hduser@10.12.34.16:/usr/local/$ scp ‐r /usr/local/zookeeper‐3.4.6/ hduser@10.12.34.17:/usr/local/2.修改myida)16主机$ vi /usr/local/zookeeper‐3.4.6/data/myid1 修改为2b)17主机$ vi /usr/local/zookeeper‐3.4.6/data/myid1修改为3启动$ cd /usr/local/zookeeper‐3.4.6/$./bin/zkServer.sh start查看状态:$./bin/zkServer.sh statusHadoop使用hduser用户# su hduser安装(在15主机上)一、安装Hadoop1.下载/apache/hadoop/common/2.解压缩$ tar ‐zxvf /hadoop‐2.4.0.tar.gz ‐C /usr/local/二、 编译本地库,主机必须可以访问internet。

1 Hadoop安装手册Hadoop2.0

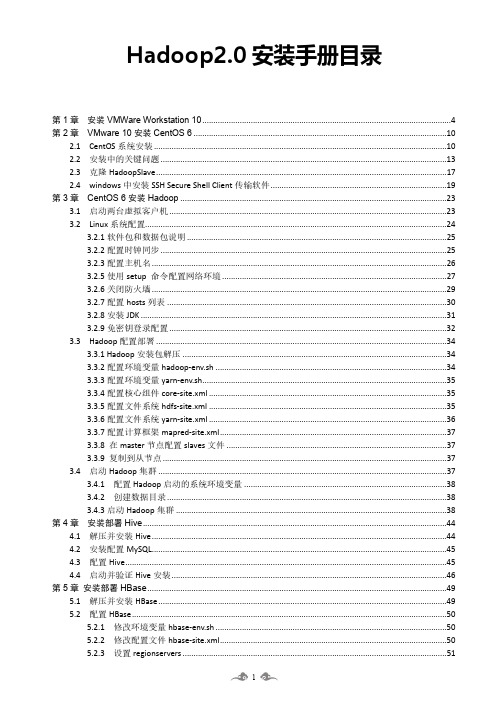

Hadoop2.0安装手册目录第1章安装VMWare Workstation 10 (4)第2章VMware 10安装CentOS 6 (10)2.1 CentOS系统安装 (10)2.2 安装中的关键问题 (13)2.3 克隆HadoopSlave (17)2.4 windows中安装SSH Secure Shell Client传输软件 (19)第3章CentOS 6安装Hadoop (23)3.1 启动两台虚拟客户机 (23)3.2 Linux系统配置 (24)3.2.1软件包和数据包说明 (25)3.2.2配置时钟同步 (25)3.2.3配置主机名 (26)3.2.5使用setup 命令配置网络环境 (27)3.2.6关闭防火墙 (29)3.2.7配置hosts列表 (30)3.2.8安装JDK (31)3.2.9免密钥登录配置 (32)3.3 Hadoop配置部署 (34)3.3.1 Hadoop安装包解压 (34)3.3.2配置环境变量hadoop-env.sh (34)3.3.3配置环境变量yarn-env.sh (35)3.3.4配置核心组件core-site.xml (35)3.3.5配置文件系统hdfs-site.xml (35)3.3.6配置文件系统yarn-site.xml (36)3.3.7配置计算框架mapred-site.xml (37)3.3.8 在master节点配置slaves文件 (37)3.3.9 复制到从节点 (37)3.4 启动Hadoop集群 (37)3.4.1 配置Hadoop启动的系统环境变量 (38)3.4.2 创建数据目录 (38)3.4.3启动Hadoop集群 (38)第4章安装部署Hive (44)4.1 解压并安装Hive (44)4.2 安装配置MySQL (45)4.3 配置Hive (45)4.4 启动并验证Hive安装 (46)第5章安装部署HBase (49)5.1 解压并安装HBase (49)5.2 配置HBase (50)5.2.1 修改环境变量hbase-env.sh (50)5.2.2 修改配置文件hbase-site.xml (50)5.2.3 设置regionservers (51)第1章安装VMWare Workstation 105.2.4 设置环境变量 (51)5.2.5 将HBase安装文件复制到HadoopSlave节点 (51)5.3 启动并验证HBase (51)第6章安装部署Mahout (54)6.1 解压并安装Mahout (54)6.2 启动并验证Mahout (55)第7章安装部署Sqoop (57)7.1 解压并安装Sqoop (57)7.2 配置Sqoop (58)7.2.1 配置MySQL连接器 (58)7.2.2配置环境变量 (58)7.3 启动并验证Sqoop (59)第8章安装部署Spark (61)8.1 解压并安装Spark (61)8.2 配置Hadoop环境变量 (62)8.3 验证Spark安装 (62)第9章安装部署Storm (66)安装Storm依赖包 (66)9.1安装ZooKeeper集群 (66)9.1.1解压安装 (66)9.1.2配置ZooKeeper属性文件 (67)9.1.3 将Zookeeper安装文件复制到HadoopSlave节点 (68)9.1.3启动ZooKeeper集群 (68)9.2安装Storm (69)9.2.1 解压安装 (69)9.2.2修改storm.yaml配置文件 (70)9.2.3 将Storm安装文件复制到HadoopSlave节点 (70)9.2.4启动Storm集群 (70)9.2.5向Storm集群提交任务 (71)第10章安装部署Kafka (73)10.1. 安装Kafka (73)10.1.1下载Kafka安装文件 (73)10.2. 配置Kafka (73)10.3. 启动Kafka (74)第1章安装VMWare Workstation 10第1章安装VMWare 10主要内容安装VMWare Workstation 10第1章安装VMWare Workstation 10 在软件包中找到“software\vmware”目录并进入该目录,如下所示:点击“VMware-workstation-full-10.0.0-1295980.exe”安装2等待安装软件检测和解压以后,出现如下界面,直接单击下一步即可。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1.1软件环境

1)CentOS6.5x64

2)Jdk1.7x64

3)Hadoop2.6.2x64

4)Hbase-0.98.9

5)Zookeeper-3.4.6

1.2集群环境

集群中包括 3个节点:1个Master, 2个Slave

2安装前的准备

2.1下载JDK

2.2下载Hadoop

2.3下载Zookeeper

2.4下载Hbase

3开始安装

3.1 CentOS安装配置

1)安装3台CentOS6.5x64 (使用BasicServer模式,其他使用默认配置,安装过程略)

2)Master.Hadoop 配置

a)配置网络

修改为:

保存,退出(esc+:wq+enter ),使配置生效

b) 配置主机名

修改为:

c)配置 hosts

修改为:

修改为:

在最后增加如下内容

以上调整,需要重启系统才能生效

g) 配置用户

新建hadoop用户和组,设置 hadoop用户密码

id_rsa.pub ,默认存储在"/home/hadoop/.ssh" 目录下。

a) 把id_rsa.pub 追加到授权的 key 里面去

b) 修改.ssh 目录的权限以及 authorized_keys 的权限

c) 用root 用户登录服务器修改

SSH 配置文件"/etc/ssh/sshd_config"的下列内容

3) Slavel.Hadoop 、Slavel.Hadoop 配置

及用户密码等等操作

3.2

无密码登陆配置

1)

配置

Master 无密码登录所有 Slave a)使用 hadoop 用户登陆 Master.Hadoop

b)把公钥复制所有的 Slave 机器上。

使用下面的命令格式进行复制公钥

2) 配置Slave 无密码登录Master

a) 使用hadoop 用户登陆Slave

b)把公钥复制Master 机器上。

使用下面的命令格式进行复制公钥

id_rsa 和

相同的方式配置 Slavel 和Slave2的IP 地址,主机名和 hosts 文件,新建hadoop 用户和组

c) 在Master机器上将公钥追加到authorized_keys 中

3.3安装JDK

所有的机器上都要安装 JDK ,先在Master服务器安装,然后其他服务器按照步骤重复进行即可。

安装JDK以及配置环境变量,需要以 "root"的身份进行。

1)解压缩文件

增加如下内容:

因为官网,以下使用root身份进行安装。

1)将hadoop安装包上传到服务器/usr/local/目录下

2)解压缩文件

4)编辑 <HADOOP_HOME>/etc/hadoop/hadoop-env.sh

修改JAVA_HOME 的配置:

5)编辑 <HADOOP_HOME>/etc/hadoop/core-site.xml

修改为:

增加如下内容:

13) 在Slave上重复以上步骤,安装 Hadoop (以下为从 Master复制hadoop至U Slave)

在Slave上进行如上配置后,使用使用hadoop用户启动服务

第一次启动需要在 Master.Hadoop 执行

再启动yarn

在Master验证启动进程

在Slave验证启动进程

15)网页查看集群

3.5 安装Zookeeper

解压缩文件

根据zoo_sample.cfg 创建zoo.cfg并修改

配置环境变量

1)

2)

3)

4)

增加如下内容:

以root 身份将上传到服务器/usr/local/目录下6) 7)

把该文件夹的读权限分配给普通用户 hadoop

用hadoop 用户启动 ZooKeeper 集群

8) 3.6 安

9) 10)

1) 2)

4) 解压缩文件

3)

修改为:

不使用默认

编辑 <HBASE HOME>/conf/hbase-site.xml

在 configuration 里添力

口:

5)

6)

7)删除安装包

:60030

:60030

4集群的启动和查看

4.1启动

1)启动顺序为:HDFS->ZooKeeper->Hbase

以下操作都是使用 hadoop用户

Master节点启动Hadoop集群:

Master节点启动Hbase集群

4.2命令查看

Master节点上执行

:60030

4.4停止

停止顺序为:Hbase->ZooKeeper->HDFS

以下操作都是使用 hadoop用户

Master节点彳^止Hbase集群

每个节点停止ZooKeeper集群:

Master节点彳^止 Hadoop集群:。