开启esxi并做共享磁盘

vmware_esxi 虚拟机集群共享磁盘

跨ESXi主机的裸磁盘映射(RDM)搭建MSCS群集2011-11-30 23:26:11标签:ESXiRDM裸磁盘映射MSCS跨主机原创作品,允许转载,转载时请务必以超链接形式标明文章原始出处、作者信息和本声明。

否则将追究法律责任。

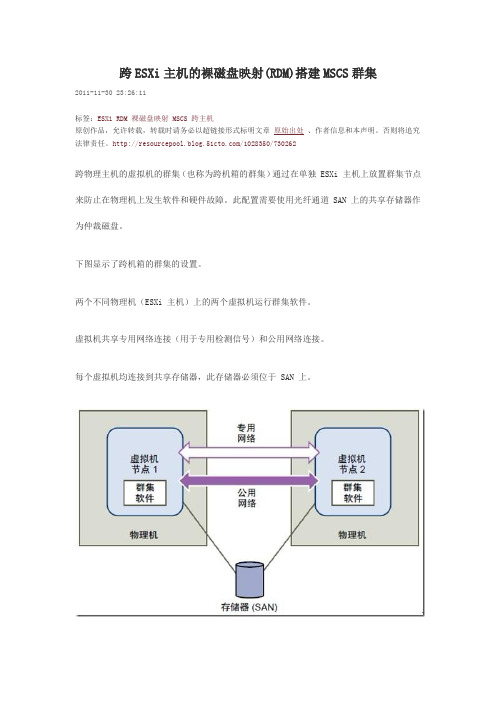

/1028350/730262跨物理主机的虚拟机的群集(也称为跨机箱的群集)通过在单独 ESXi 主机上放置群集节点来防止在物理机上发生软件和硬件故障。

此配置需要使用光纤通道 SAN 上的共享存储器作为仲裁磁盘。

下图显示了跨机箱的群集的设置。

两个不同物理机(ESXi 主机)上的两个虚拟机运行群集软件。

虚拟机共享专用网络连接(用于专用检测信号)和公用网络连接。

每个虚拟机均连接到共享存储器,此存储器必须位于 SAN 上。

此设置可以显著降低硬件成本可以扩展跨机箱的群集模型,并在多个物理机上放置多个虚拟机。

例如,可以将四个各包含两个物理机的群集与两个各具有四个虚拟机的物理机相整合。

下图显示如何将四个双节点群集从八个物理机移动到两个物理机。

言归正传,下面开始我们的测试两个节点分别在两台不同的ESXi上,使用iSCSI存储,两台ESXi都能访问到。

Node01所在ESXi的网络配置如图:Node02所在ESXi的网络配置如图:Node01两块网卡配置和IP如图:Node02的两块网卡的配置和IP,如图:在Node01上添加硬盘,选择“裸机映射”选择存放指针文件的存储位置(一定要共享的)选择“物理”兼容性节点不能使用SCSI0 ,必须使用SCSI 1 ,这里选择SCSI (1:0)两块盘添加后,注意选择SCSI 1适配器,更改SCSI总线共享类型为“物理”随后在Node02上添加硬盘,选择“使用现有虚拟磁盘”( 关闭虚拟机上面物理才可选 )))))))找到Node01做RDM时生成的指针文件的路径节点同样要使用SCSI 1同样的方式添加两块硬盘后,记住要该SCSI 1控制器的总线共享为“物理”随后在Node01上初始化两块盘并分配盘符,然后将硬盘“脱机”启动Node02,发现自动挂上了那两块盘。

vmware ESXI5.1中配置虚拟共享磁盘

ESXI 5.1中创建windows clust共享磁盘MSCS故障转移群集是一组独立的计算机,这些计算机相互协作以提高应用程序和服务的可用性。

多台群集服务器(称为节点)通过物理电缆和软件连接。

如果其中一个群集节点出现故障,另外一个节点就会开始提供服务(该过程称为故障转移)。

从而使用户遭遇服务中断的次数降至最低。

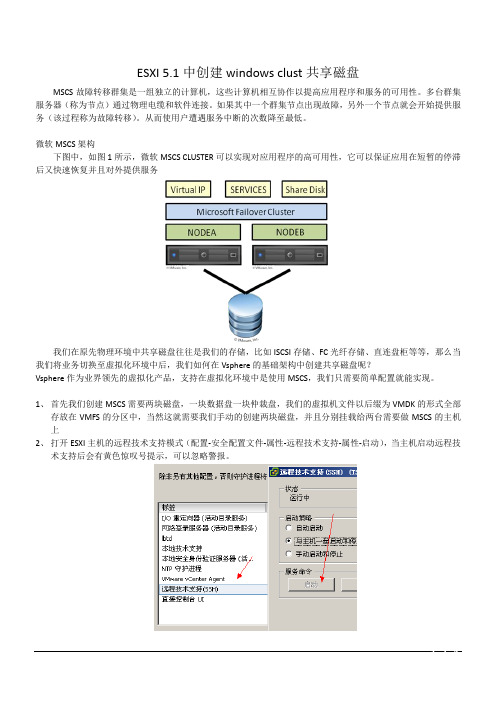

微软MSCS架构下图中,如图1所示,微软MSCS CLUSTER可以实现对应用程序的高可用性,它可以保证应用在短暂的停滞后又快速恢复并且对外提供服务我们在原先物理环境中共享磁盘往往是我们的存储,比如ISCSI存储、FC光纤存储、直连盘柜等等,那么当我们将业务切换至虚拟化环境中后,我们如何在Vsphere的基础架构中创建共享磁盘呢?Vsphere作为业界领先的虚拟化产品,支持在虚拟化环境中是使用MSCS,我们只需要简单配置就能实现。

1、首先我们创建MSCS需要两块磁盘,一块数据盘一块仲裁盘,我们的虚拟机文件以后缀为VMDK的形式全部存放在VMFS的分区中,当然这就需要我们手动的创建两块磁盘,并且分别挂载给两台需要做MSCS的主机上2、打开ESXI主机的远程技术支持模式(配置-安全配置文件-属性-远程技术支持-属性-启动),当主机启动远程技术支持后会有黄色惊叹号提示,可以忽略警报。

3、使用Putty工具以Root身份登录到打开远程技术支持的主机上。

4、进入共享磁盘所在的路径。

(例:cd /vmfs/volumes/datastore1)请将datastore1替换成对应的共享VMFS卷名称5、创建共享磁盘。

(例:vmkfstools -c 10000m -d eagerzeroedthick -a lsilogic /vmfs/volumes/datastore1/data.vmdk)(例:vmkfstools -c 1024m -d eagerzeroedthick -a lsilogic /vmfs/volumes/datastore1/quorum.vmdk)(例:vmkfstools -c 1024m -d eagerzeroedthick -a lsilogic /vmfs/volumes/datastore1/msdtc.vmdk)创建好后如下图所示一般仲裁盘和MSDTC盘为1G即1024MB,数据盘根据业务大小自由分配。

虚拟机与主机互相共享文件的几种方法

虚拟机与主机互相共享文件的几种方法嘿,朋友们!今天咱就来聊聊虚拟机与主机互相共享文件的那些事儿。

你说这虚拟机和主机啊,就像是两个好伙伴,它们有时候也需要互相分享点东西呢!先来说说第一种方法,那就是通过网络共享呀!就好像两个好朋友在一个网络大家庭里,互相把自己的宝贝拿出来给对方看看。

设置好共享文件夹,让虚拟机和主机都能找到对方的宝贝,这多方便呀!你想想,就像你和你的朋友在家里分享各自的玩具一样。

还有一种方法呢,是利用专门的共享软件。

这就好比给虚拟机和主机之间搭了一座特别的桥,让它们能更轻松地把文件送过去接过来。

这种软件就像是个小魔法师,让共享变得轻而易举。

再讲讲虚拟磁盘共享。

这就好像给虚拟机和主机准备了一个共同的秘密宝藏地,它们可以在里面放东西,也可以从里面拿东西。

是不是很有意思呀?哎呀,你说要是没有这些方法,那虚拟机和主机之间得多无聊呀!它们就没办法这么愉快地交流和分享了。

这就好比两个人明明住得很近,却没有办法互相串门一样。

你想想,要是你在虚拟机里做了个超级棒的文档,却没办法一下子拿到主机上给别人看,那多可惜呀!或者主机上有个超好用的软件,也想让虚拟机也用上,没有共享可怎么行呢?所以呀,这些方法可太重要啦!它们让虚拟机和主机的关系更加亲密,让我们的使用也更加方便。

就像你和你的好朋友,互相分享快乐和成果,那感觉多好呀!不管是通过网络共享,还是借助共享软件,或者利用虚拟磁盘,都是为了让我们能更高效地利用虚拟机和主机。

让它们更好地为我们服务,给我们带来更多的便利和乐趣。

总之呢,学会这些方法,就能让虚拟机和主机像好兄弟一样互相帮助、互相分享啦!别再犹豫啦,赶紧去试试吧,你一定会惊叹它们的神奇和好用的!。

vsphere-esxi-vcenter-server-672-storage-说明书

《vSphere 存储》Update 2修改日期:2022 年 4 月 19 日VMware vSphere 6.7VMware ESXi 6.7vCenter Server 6.7您可以从 VMware 网站下载最新的技术文档:https:///cn/。

VMware, Inc.3401 Hillview Ave. Palo Alto, CA 94304 威睿信息技术(中国)有限公司北京办公室北京市朝阳区新源南路 8 号启皓北京东塔 8 层 801/cn上海办公室上海市淮海中路 333 号瑞安大厦 804-809 室/cn广州办公室广州市天河路 385 号太古汇一座 3502 室/cn版权所有© 2009-2022 VMware, Inc. 保留所有权利。

版权和商标信息《vSphere 存储》目录关于 vSphere 存储14更新信息151存储简介16传统存储虚拟化型号16软件定义的存储型号17vSphere Storage API182传统存储型号入门20物理存储的类型20本地存储20联网的存储21目标和设备表示形式25虚拟机如何访问存储25存储设备特性26比较存储类型29支持的存储适配器30查看存储适配器信息30数据存储特性31显示数据存储信息33使用永久内存34监控 PMem 数据存储统计信息353将 ESXi 与 SAN 配合使用概览37ESXi 和 SAN 用例38将 SAN 存储与 ESXi配合使用的细节38ESXi 主机和多个存储阵列39决定 LUN 的大小和数目39使用预测性方案来决定 LUN 的大小和数目40使用自适应性方案来决定 LUN 的大小和数目40选择虚拟机位置40第三方管理应用程序41SAN 存储备份注意事项41使用第三方备份软件包424将 ESXi 与光纤通道 SAN 配合使用43光纤通道 SAN 概念43光纤通道 SAN 中的端口44光纤通道存储阵列类型44将区域分配与光纤通道 SAN 配合使用44虚拟机如何访问光纤通道 SAN 上的数据455配置光纤通道存储器46ESXi 光纤通道 SAN 要求46ESXi 光纤通道 SAN 限制46设置 LUN 分配47设置光纤通道 HBA47安装和设置步骤47N-Port ID 虚拟化48基于 NPIV 的 LUN 访问如何运作48使用 NPIV 的要求48NPIV 功能和限制49配置或修改 WWN 分配496配置以太网光纤通道51以太网光纤通道适配器51软件 FCoE 配置准则52设置软件 FCoE 的网络连接53添加软件 FCoE 适配器537从光纤通道 SAN 引导 ESXi55从 SAN 引导的优点55从光纤通道 SAN 引导时的要求和注意事项56准备从 SAN 引导56配置 SAN 组件和存储系统56将存储适配器配置为从 SAN 引导57将系统设置为从安装介质引导57将 Emulex HBA 配置为从 SAN 引导58启用 BootBIOS 提示58启用 BIOS58将 QLogic HBA 配置为从 SAN 引导598通过软件 FCoE 引导 ESXi61软件 FCoE 引导的要求和注意事项61设置软件 FCoE 引导62配置软件 FCoE 引导参数62从软件 FCoE LUN 安装并引导 ESXi63针对从软件 FCoE 引导 ESXi 主机进行故障排除639光纤通道存储最佳做法65防止出现光纤通道 SAN 问题65禁用自动主机注册66优化光纤通道 SAN 存储器性能66存储阵列性能66光纤通道的服务器性能6710将 ESXi与 iSCSI SAN 配合使用68关于 iSCSI SAN68iSCSI 多路径69iSCSI SAN 节点和端口69iSCSI 命名约定70iSCSI 启动器71关于 VMware iSER 适配器71建立 iSCSI 连接72iSCSI 存储系统类型72发现、身份验证和访问控制73错误纠正74虚拟机如何访问 iSCSI SAN 上的数据7411配置 iSCSI 适配器和存储76ESXiiSCSI SAN 建议和限制77配置适配器的 iSCSI 参数77设置独立硬件 iSCSI 适配器78查看独立硬件 iSCSI 适配器79编辑硬件 iSCSI 的网络设置79配置从属硬件 iSCSI 适配器80从属硬件 iSCSI 注意事项81查看从属硬件 iSCSI 适配器81确定 iSCSI 与网络适配器之间的关联82配置软件 iSCSI 适配器82激活或禁用软件 iSCSI 适配器83配置 iSER 适配器84启用 VMware iSER 适配器85修改 iSCSI 或 iSER 适配器的常规属性85为 iSCSI 和 iSER 设置网络86iSCSI 或 iSER 配置中的多个网络适配器87使用软件 iSCSI 配置网络连接的最佳做法88配置 iSCSI 或 iSER 端口绑定91管理 iSCSI 网络96iSCSI 网络故障排除96将巨帧与 iSCSI 配合使用96为网络连接启用巨帧97为独立硬件 iSCSI 启用巨帧97配置 iSCSI 适配器的发现地址98配置 iSCSI 和 iSER 的动态或静态发现98移除动态或静态 iSCSI 目标99配置 iSCSI 适配器的 CHAP 参数99选择 CHAP 身份验证方法100设置 iSCSI 或 iSER 适配器的 CHAP101设置目标的 CHAP102配置 iSCSI 的高级参数103配置 iSCSI 的高级参数104iSCSI 会话管理104查看 iSCSI 会话105添加 iSCSI 会话105移除 iSCSI 会话10612从 iSCSI SAN 引导107关于从 iSCSI SAN 引导的常规建议107准备 iSCSI SAN108配置独立硬件 iSCSI 适配器进行 SAN 引导108配置 iSCSI 引导设置109iBFT iSCSI 引导概览110iBFT iSCSI 引导注意事项110配置从 SAN 进行的 iBFT 引导111网络最佳做法113更改 iBFT iSCSI 引导设置113对 iBFT iSCSI 引导进行故障排除11413iSCSI 存储的最佳做法115防止出现 iSCSI SAN 问题115优化 iSCSI SAN 存储器性能116存储系统性能116iSCSI 服务器性能116网络性能117检查以太网交换机统计信息11914管理存储设备120存储设备特性120显示主机的存储设备121显示适配器的存储设备122设备扇区格式123存储设备名称和标识符124具有 NGUID 设备标识符的 NVMe 设备126将具有唯一 NGUID 的 NVMe 设备的无状态 ESXi 主机升级到 6.7 Update 2127重命名存储设备128存储重新扫描操作129执行存储重新扫描129执行适配器重新扫描130更改扫描的存储设备的数量130确定设备连接问题130检测 PDL 情况131执行计划的存储设备移除132从 PDL 情况中恢复133处理暂时性 APD 情况133验证存储设备的连接状态135设备连接问题和 High Availability136启用或禁用存储设备上的定位符 LED136擦除存储设备13615使用闪存设备137对 ESXi使用闪存设备138标识闪存虚拟磁盘138标记存储设备138将存储设备标记为闪存设备139将存储设备标记为本地139监控闪存设备140闪存设备的最佳做法140估算闪存设备的生命周期140关于虚拟闪存资源141虚拟闪存资源的注意事项141设置虚拟闪存资源142移除虚拟闪存资源142虚拟闪存高级设置143配置主机交换缓存143使用 VMFS 数据存储配置主机缓存143使用虚拟闪存资源配置主机交换缓存14416关于 VMware vSphere Flash Read Cache145针对闪存读取缓存的 DRS 支持145vSphere High Availability 支持 Flash Read Cache146为虚拟机配置 Flash Read Cache146迁移虚拟机和 Flash Read Cache14717使用数据存储148数据存储的类型148了解 VMFS 数据存储149VMFS 数据存储的版本150作为存储库的 VMFS 数据存储151在主机间共享 VMFS 数据存储152VMFS 元数据更新152VMFS 锁定机制153VMFS 上的快照格式157升级 VMFS 数据存储158解决 VMFS3 升级故障158将 VMFS3 数据存储升级到 VMFS5159了解网络文件系统数据存储159NFS 协议和 ESXi159NFS 存储准则和要求161NFS 存储的防火墙配置164使用第 3 层路由连接访问 NFS 存储165对 NFS 4.1 使用 Kerberos165设置 NFS 存储环境166配置 ESXi 主机进行 Kerberos 身份验证167创建数据存储169创建 VMFS 数据存储170创建 NFS 数据存储171创建 Virtual Volumes 数据存储172管理重复 VMFS 数据存储173挂载 VMFS 数据存储副本173增加 VMFS 数据存储容量174数据存储的管理操作175更改数据存储名称176卸载数据存储177挂载数据存储177移除 VMFS 数据存储178使用数据存储浏览器178关闭存储筛选器182设置动态磁盘镜像183在存储设备上收集 ESXi 主机的诊断信息184将设备分区设置为核心转储位置185将文件设置为核心转储位置186使用 VOMA 检查元数据一致性188使用 VOMA 检查元数据一致性191配置 VMFS 指针块缓存191获取 VMFS 指针块缓存的信息192更改指针块缓存的大小19318了解多路径和故障切换194光纤通道故障切换194基于主机的 iSCSI 故障切换195基于阵列的 iSCSI 故障切换197路径故障切换和虚拟机198在 Windows 客户机操作系统上设置超时198可插入存储架构和路径管理199关于可插入存储架构200VMware 本机多路径插件201路径选择插件和策略203VMware SATP204VMware 高性能插件206查看和管理路径209查看存储设备路径209查看数据存储路径210更改路径选择策略211更改延迟循环的默认参数211禁用存储路径212使用声明规则213多路径注意事项213列出主机的多路径声明规则214添加多路径声明规则215删除多路径声明规则218屏蔽路径219取消路径屏蔽220定义 NMP SATP 规则221虚拟机 I/O 的调度队列222编辑按文件 I/O 调度222使用 esxcli 命令启用或禁用按文件 I/O 调度22319裸设备映射224关于裸设备映射224裸设备映射的优点225RDM 注意事项和限制227裸设备映射特性227RDM 虚拟兼容模式和物理兼容模式227动态名称解析228虚拟机集群的裸设备映射228比较可用的 SCSI 设备访问模式228使用 RDM 创建虚拟机229管理映射的 LUN 的路径230具有 RDM 的虚拟机必须忽略 SCSI INQUIRY 缓存23120基于存储策略的管理233虚拟机存储策略234虚拟机存储策略的工作流234填充“虚拟机存储策略”界面235使用存储提供程序填充“虚拟机存储策略”界面236向数据存储分配标记236关于规则和规则集238创建和管理虚拟机存储策略239在 vSphere Web Client 中定义虚拟机存储策略240为基于主机的数据服务创建虚拟机存储策略243为 Virtual Volumes 创建虚拟机存储策略244为基于标记的放置创建虚拟机存储策略246编辑或克隆虚拟机存储策略247关于存储策略组件248创建存储策略组件249编辑或克隆存储策略组件250存储策略和虚拟机250将存储策略分配给虚拟机251更改虚拟机文件和磁盘的存储策略分配252检查虚拟机存储策略的合规性253为不合规虚拟机查找兼容存储资源253重新应用虚拟机存储策略254默认存储策略255更改数据存储的默认存储策略25521使用存储提供程序257关于存储提供程序257存储提供程序和数据呈现形式258存储提供程序要求和注意事项259注册存储提供程序259查看存储提供程序信息260管理存储提供程序26022使用 Virtual Volumes262有关 Virtual Volumes262Virtual Volumes 概念263Virtual Volumes264Virtual Volumes 和存储提供程序265存储容器265协议端点266将 Virtual Volumes 绑定到协议端点和解除绑定266Virtual Volumes 数据存储267Virtual Volumes 和虚拟机存储策略267Virtual Volumes 和存储协议267Virtual Volumes 架构269Virtual Volumes 和 VMware Certificate Authority270快照和 Virtual Volumes270启用 Virtual Volumes 之前271将 vSphere Storage 环境与网络时间服务器同步272配置 Virtual Volumes272注册 Virtual Volumes 的存储提供程序273创建 Virtual Volumes 数据存储274查看和管理协议端点274更改协议端点的路径选择策略275在 Virtual Volumes 数据存储中置备虚拟机275Virtual Volumes 和复制276Virtual Volumes 复制的要求277Virtual Volumes 和复制组277Virtual Volumes 和故障域278Virtual Volumes 复制工作流279复制准则和注意事项279使用 vSphere Virtual Volumes 的最佳做法280使用 vSphere Virtual Volumes 的准则和限制280存储容器置备最佳做法281实现 vSphere Virtual Volumes 最佳性能的最佳做法282Virtual Volumes 故障排除283Virtual Volumes 和 esxcli 命令283虚拟数据存储无法访问284将虚拟机迁移到虚拟卷数据存储或将 VM OVF 部署到虚拟卷数据存储时的故障284尝试向/从虚拟数据存储迁移具有内存快照的虚拟机失败28523筛选虚拟机 I/O287关于 I/O 筛选器287I/O 筛选器的类型288I/O 筛选组件288I/O 筛选器的存储提供程序289使用闪存设备与缓存 I/O 筛选器290I/O 筛选器系统要求291在 vSphere 环境中配置 I/O 筛选器291在集群中安装 I/O 筛选器291查看 I/O 筛选器和存储提供程序292配置用于缓存 I/O 筛选器的虚拟闪存资源292在虚拟磁盘上启用 I/O 筛选器数据服务293将 I/O 筛选器策略分配给虚拟机294管理 I/O 筛选器295从集群卸载 I/O 筛选器295升级集群中的 I/O 筛选器295I/O 筛选器准则和最佳实践296通过 I/O 筛选器迁移虚拟机296处理 I/O 筛选器安装故障297在单个 ESXi 主机中安装 I/O 筛选器29724存储硬件加速299硬件加速的优点299硬件加速要求300硬件加速支持状态300块存储设备的硬件加速300禁用块存储设备的硬件加速301管理块存储设备上的硬件加速301NAS 设备上的硬件加速306安装 NAS 插件307卸载 NAS 插件307更新 NAS 插件308验证 NAS 的硬件加速状态308硬件加速注意事项30925存储置备和空间回收310虚拟磁盘精简置备310关于虚拟磁盘置备策略311创建精简置备虚拟磁盘312查看虚拟机存储资源312确定虚拟机的磁盘格式313扩充精简虚拟磁盘313处理数据存储超额订购314ESXi 和阵列精简置备314监控空间使用情况315识别精简置备的存储设备315存储空间回收316VMFS 数据存储的空间回收请求317来自客户机操作系统的空间回收请求32126使用 vmkfstools323vmkfstools 命令语法323vmkfstools 命令选项324-v 子选项324文件系统选项325虚拟磁盘选项327存储设备选项333关于 vSphere 存储《vSphere 存储》介绍 VMware ESXi™和 VMware vCenter Server®提供的虚拟化和软件定义的存储技术,并说明如何配置和使用这些技术。

esxi使用方法

esxi使用方法ESXi是一款VMware开发的虚拟化操作系统,它将物理服务器转化为虚拟化的资源,这样就能够让一个服务器同时运行多个虚拟机,从而提高服务器资源的利用率。

本文将为大家介绍ESXi的使用方法。

一、安装ESXi1. 下载ESXi首先需要从VMware官网下载ESXi的ISO文件并制作启动盘。

将制作好的启动盘插入服务器,开机后按照提示进入ESXi安装界面,在安装界面中需要输入一些基本配置信息,例如:网络配置、管理账户等。

在安装过程结束后,重启服务器。

二、添加虚拟机1. 创建虚拟机进入ESXi的Web管理页面,单击“虚拟机”,进入虚拟机管理界面。

单击“创建虚拟机”按钮,按照提示步骤完成创建虚拟机的操作。

在这个过程中需要为虚拟机分配虚拟硬件(CPU、内存、硬盘等),并选择操作系统。

2. 安装操作系统创建虚拟机后,需要为虚拟机安装操作系统。

在虚拟机管理界面,选择相应的虚拟机,右键单击并选择“电源”,再单击“开机”。

选择安装介质并进行操作系统安装。

三、快照、备份与恢复在虚拟机管理界面中选择相应的虚拟机,右键单击并选择“创建快照”。

在创建快照过程中需要为快照命名。

创建好的快照可以用于备份和恢复数据。

在虚拟机管理界面中选择相应的虚拟机,右键单击并选择“导出OVF模板”。

将导出的文件备份至其他的存储介质,以保留虚拟机的核心设置数据。

3. 恢复快照四、扩展磁盘空间在虚拟机管理界面中选择相应的虚拟机,右键单击并选择“编辑设置”,进入虚拟机配置界面,选择“硬盘”选项卡,单击“扩大”按钮,按照提示进行扩容磁盘的操作。

五、创建虚拟网络ESXi支持创建多种类型的虚拟网络,比如:VMKernel网络、标准交换机网络、分布式交换机网络等。

具体操作1. 登录到ESXi管理页面,进入“网络与安全”→“虚拟交换机”界面。

2. 单击“创建新虚拟交换机”。

3. 在创建虚拟交换机向导中,选择“标准交换机”或“分布式交换机”,按照提示完成虚拟网络的创建。

Esxi下虚拟机共享磁盘

技术文档

Vmware ESXi4.1 共享磁盘

一. 二. 三.

3.3 编辑虚拟机的 VMX 文件.............................................................................................................. 4

3.4 给虚拟机添加硬盘......................................................................................................................... 5

3.1 开户主机的 SSH 服务 ................................................................................................................... 2

3.2 配置共享磁盘................................................................................................................................. 4

使用 Vsphere Client 登录到主机,选中主机,选择右侧配置标签中的“配置”标签,再选择“安全配置文 件”,然后点击右上角的“属性”按钮,如图一。

手把手教你从NAS拿点空间当电脑硬盘使用iSCSI开启网络硬盘共享

手把手教你从NAS拿点空间当电脑硬盘使用iSCSI开启网络硬盘共享前言家里的Synology DS218Play 已经用了几年了,当时买的两盘位DS 218PLAY,一直使用状况良好。

跟路由器一样,只需要默默地工作在角落就好。

天线是最近刚买的华硕RT-ACRH17路由器.但是由于之前我装电脑时只考虑速度没有考虑空间,机械硬盘直接换成了ssd,造成储存空间的严重不足。

游戏区也只分了区区几百GB,导致现在在Steam上面不敢乱买游戏了。

我买的一些游戏,有兴趣可以朋友,大家可以分享讨论一下。

不扯远了,此篇文章就是让我们把黑手伸向拥有超大空间的NAS 里去拿。

开启iSCSI服务,各品牌的NAS开启的方式和Windows的后续操作都基本差不多,本篇以群晖Nas以及Win10为例。

Tips:关于iSCSI服务,简单讲就是开启一种网络硬盘储存共享的协议,让电脑可以自由读取储存在NAS中的文件。

问题:这样操作电脑读取虚拟NAS的硬盘会不会很慢?根据我的操作和实际使用感受来看,由于现在都是千兆路由器加网线,虽然储存基于网络,但是其实读写速度跟普通机械硬盘差别不会太大,文章后边我会专门进行对比测试。

操作步骤:NAS部分1. 登陆你的Nas主界面,右上角搜索iSCSI,进入iSCSI Manager或者在左上角安装程序里面找 iSCSI Manager2. 设置LUN以及Target进入iSCSI Manager主界面选择第二个target,点击新增~点击下一步,设置新的LUN, 如果要设置传输协议密码可以启用CHAP。

新增一个LUN,完成创建LUN。

这一步很重要是选择从NAS中哪个盘划出空间,总容量的数字按GB算,输入多少就是划出多少GB供电脑使用。

以我为例,我选择了从2号盘划出850GB给电脑使用,点击应用,则NAS端的设置已经完成。

Windows部分接下来的操作就是将创建好的iSCSI挂载到我们的Windows里面。

esxi使用方法

esxi使用方法

ESXi是一种虚拟化技术,它可以将一台物理服务器分割成多个虚拟机,在每个虚拟机中运行不同的操作系统和应用程序。

以下是ESXi的使用方法:

1.下载并安装ESXi软件

首先需要从VMware官网下载ESXi软件。

安装时需要一些基本信息,如主机名、IP地址、管理员密码等。

2.创建虚拟机

在ESXi中,虚拟机被称为“虚拟机”,可以通过vSphere客户端来创建虚拟机。

在创建虚拟机时需要指定CPU、内存、磁盘空间等资源。

3.安装操作系统

在创建完虚拟机后,需要为其安装操作系统。

可以通过将安装介质挂载到虚拟机或通过网络安装来进行操作系统的安装。

4.管理虚拟机

在vSphere客户端中,可以管理虚拟机的启动、停止、暂停、重启等操作。

还可以对虚拟机进行快照、克隆、迁移等操作。

5.维护ESXi

ESXi需要定期进行维护,包括升级、打补丁、备份等操作。

可以通过vSphere客户端或命令行工具来进行维护。

总之,ESXi是一种非常强大的虚拟化技术,可以帮助企业降低成本、提高效率。

掌握ESXi的使用方法可以为企业带来更多的好处。

使用iSER协议在ESXi主机上挂载存储的方法

使用iSER协议在ESXi主机上挂载存储的方法随着数据存储需求的不断增长和技术的不断发展,企业对于存储解决方案的需求也越来越多样化。

iSER(iSCSI Extensions for RDMA)协议是一种适用于存储网络的高性能传输协议,结合了RDMA(Remote Direct Memory Access)技术和iSCSI协议,可以提供更高的传输速度和更低的延迟。

在ESXi主机上使用iSER协议挂载存储,可以大幅度提升存储性能和响应时间。

本文将介绍使用iSER协议在ESXi主机上挂载存储的详细步骤。

1. 确认硬件和软件支持在开始配置之前,首先需要确保ESXi主机的硬件和软件都支持iSER协议。

硬件方面,ESXi主机的网络适配器需要支持RDMA技术,通常使用的是以太网适配器,并且需要支持iSCSI功能。

对于软件支持,ESXi主机的版本需要是6.5或更高版本,因为iSER协议在ESXi 6.5中得到了原生支持。

2. 配置存储设备和iSCSI Target在ESXi主机上挂载存储之前,需要先配置存储设备和iSCSI Target,确保它们之间可以正常通信。

首先,在存储设备上启用iSCSI服务,并创建一个LUN(Logical Unit Number)作为存储空间。

然后,在iSCSI Target上创建一个iSCSI目标,将该LUN添加到目标中。

确保在配置过程中设置了正确的接入控制列表(ACL)以及授权用户,以确保ESXi主机可以通过iSCSI协议访问存储设备。

3. 配置ESXi主机在ESXi主机上进行如下配置:3.1 进入ESXi主机的管理界面,选择"Configuration",然后选择"Storage Adapters"。

在适配器列表中找到主机上的网络适配器,点击相应的适配器。

3.2 在网络适配器的属性页面,选择"Configure iSCSI",然后点击"Enabled"来启用iSCSI协议。

ESXi5+VM+RHCS环境构筑时遇到的问题及解决方法

系统环境VMware ESXi 5.0,两台虚拟机,Redhat 5.8,集群2013-11-31关键词:Expansion ROM not initialized、ping time out1、先插入SDR Update Tool的光盘,加电,进行SDR update。

结束时会提示 remove the media,按任意键重启2、按 CTRL+H,进入raid配置界面 WebBIOS□ mklabel gpt需要使用dvd引导到rescue模式下,用parted进行分区通过parted查看其它分区是hidden,legacy_bootset 4 hidden off一、1、配置RAID服务器上架,加电,启动,按Ctrl+H进入WebBIOS界面,提示ERRORB000:Expansion ROM not initialized解决办法:通过开机按F2进入setup界面,advanced→PCI setting→将PCI2、PCI3 disabled,保存退出2、重启,按Ctrl+H进入WebBIOS,配置RAID,成功,保存退出3、插入VMware vPhere 5.0安装光盘,按照提示继续二、ESXi 主机双网卡负载均衡然后在IP configuration里面配置一个ip即可,但是测试时,拔掉一根网线会出现一个ping time out,过了几天我又进行测试,发现拔掉任意一根网线都不会出现ping time out2013-12-03关键词:Network boot from Intel E1000、PXE-MOF、PXE-E53:No boot filename received、客户端设备一、创建虚拟机后,准备安装操作系统时,通过读客户端的ISO文件启动时一直报下面的错误Network boot from Intel E1000PXE-MOFPXE-E53:No boot filename received解决方法如下:you need to click the "connected" and "connect at power on" in the right top corner in order to make the iso to mount properly.After you click "connect at power on", reboot the VM and it should boot from the iso.如果还出现上面提示时,点击回车,就会进入安装界面第二种解决方法,启动虚拟机后按F2进入BIOS设置,删除掉network boot选项,通过按+/-号将选项移到如下图位置如果还不行就把网卡全删了,等安装完之后再添加二、安装系统选择安装包后,会有一个Transferring的过程这种方式安装需要更久的时间,200分钟左右2013-12-04关键词:ESXi Shell、linux resuce模式分区、put: failed to upload ***.iso. Operation unsupported、Operating System not found一、开启ESXi Shell访问,将ISO文件先上传至ESXi 服务器,参考文档《[精]打开VMware ESXi 5.0 上的SSH 支持.org.htm》二、使用VMware Client端的ISO文件安装OS好慢啊啊啊啊三、先通过iso文件引导到linux resuce模式下进行硬盘分区,但是分完后exit,重新启动虚拟机,一直黑屏,没动静,如下图,试了两遍都是这样用这种读取ISO的方式也不行,最后把分区删了,重新安装,在安装过程中再进行分区四、通过sftp向ESXi服务器上传iso文件报错,其实已经上传成功sftp> cd /vmfs/volumes/datastore1sftp> lcd D:\03_software\01worksoft\linux_isosftp> put RRedhat.Enterprise.Linux.v5.UPDATE.8.X86_64.DVD-HOTiSO.isorhel-server-5.7-i386-dvd.iso rhel-server-5.7-x86_64-dvd.isorhel-server-6.2-x86_64-dvd.isosftp> put Redhat.Enterprise.Linux.v5.UPDATE.8.X86_64.DVD-HOTiSO.isoUploading Redhat.Enterprise.Linux.v5.UPDATE.8.X86_64.DVD-HOTiSO.iso to /vmfs/volumes/529ca399-d0838ebe-bd5c-94de80e79249/Redhat.Enterprise.Linux.v5.UPDATE.8.X86_64.DVD-HOTiSO.iso 100% 4028944KB 8777KB/s 00:07:39 put: failed to upload D:/03_software/01worksoft/linux_iso/Redhat.Enterprise.Linux.v5.UPDATE.8.X86_64.DVD-HOTiSO.iso. Operation unsupported.sftp>sftp>五、通过编辑虚拟机设置,指定ISO路径,好像没有,在启动时仍然提示Operating System not found,需要在控制台重新指定,然后回车2013-12-05关键词:文件被锁定,无法访问、Unable to establish an SSL connection to TESTDB1:11111:ClientSocket(homename,port,timeout):connect()failed、Proposed updated config file does not have greate version number.、Error locking on node TESTDB2: Volume group for uuid not found、/boot: UNEXPECTED INCONSISTENCY一、TESTDB2新增了一块硬盘,使用已有的,指向TESTDB1的100GB硬盘,保存设置,启动TESTDB2时,提示如下正确的设置方法如下1、新增共享硬盘,命令如下cd /vmfs/volumes/datastore1/TESTDB-SHAREvmkfstools -c 102400m -a lsilogic -d eagerzeroedthick TESTDB_SHARE.vmdk2、将共享硬盘添加到2台虚拟机,按照文件《Esxi下虚拟机共享磁盘.pdf》添加3、修改TESTDB1.vmx和TESTDB2.vmx文件,追加以下内容sched.scsi1:0.shares="normal"disk.EnanbleUUID="true"disk.locking="false"diskLib.datacacheMaxSize="0"diskLib.datacacheMaxReadAheadSize="0"diskLib.datacacheMinReadAheadSize="0"diskLib.datacachePageSize="4096"diskLib.MaxUnsynceWrites="0"4、启动2台虚拟机,均可以正常启动二、节点与luci通信异常通过https://192.168.144.201:8084访问节点1,添加cluster时报错Unable to establish an SSL connection to TESTDB1:11111:ClientSocket(homename,port,timeout):connect()failed 原因分析This error occurs when the luci server cannot communicate with the ricci agent. Verify that ricci is installed and started on each node. Ensure that the firewall has been configured correctly, and that Security-Enhanced Linux (SELinux) is not the issue. Check /var/log/audit/audit.log for details on SELinux issues.安装了ricci后问题解决,前提是需要安装其他依赖包[root@TESTDB2 Server]# rpm -ivh oddjob*Preparing... ########################################### [100%]1:oddjob ########################################### [ 20%]2:oddjob-libs ########################################### [ 40%]3:oddjob-libs ########################################### [ 60%]4:oddjob-devel ########################################### [ 80%]5:oddjob-devel ########################################### [100%][root@TESTDB2 Server]#[root@TESTDB2 Server]#[root@TESTDB2 Server]# cd -/var/ftp/pub/Cluster[root@TESTDB2 Cluster]# rpm -ivh modcluster-0.12.1-7.el5.x86_64.rpmPreparing... ########################################### [100%]1:modcluster ########################################### [100%][root@TESTDB2 Cluster]#[root@TESTDB2 Cluster]#[root@TESTDB2 Cluster]# rpm -ivh ricci-0.12.2-51.el5.x86_64.rpmPreparing... ########################################### [100%]1:ricci ########################################### [100%][root@TESTDB2 Cluster]#[root@TESTDB2 Cluster]#[root@TESTDB2 Cluster]# service ricci statusricci is stopped[root@TESTDB2 Cluster]# service ricci startStarting oddjobd: [ OK ]generating SSL certificates... doneStarting ricci: [ OK ][root@TESTDB2 Cluster]#三、创建failover域时报错Proposed updated config file does not have greate version number.报错原因:之前通过system-config-cluster工具配置了cluster,并做了变更,导致cluster.conf文件中的version变成2,后来是把conf文件手工删除,通过luci的web界面进行配置的,导致报错,解决方法:手工将conf文件中的version由1改为2,在submi,正常结束四、在节点1,pvcreate,vgcreate正常,在lvcreate时报错[root@TESTDB1 23:20:29 by-id]# lvcreate -l +100%FREE -n lvdbdata vgdbdataError locking on node TESTDB2: Volume group for uuid not found: nbSOLD3XdROA1d08hvwvFOpNCFTywRyOnqSZpwxAQQ1N41PtxsjOLJ35Lye5NEGgFailed to activate new LV.原因待查五、重启服务器,在启动时TESTDB1报错:/boot: UNEXPECTED INCONSISTENCY用fsck /dev/sdb修复时报错后来改用fsck直接修复,按照提示输入y,一路回车,修复完毕,重启正常,但是shutdown后在startup时仍然报同样的错误,fsck修复后又能重启,再shutdown后在startup时还报错,删了/dev/sdb的其他分区,shutdown后在startup时正常,估计和分区有关系六、TESTDB2启动时有如下报错Scsi_reserve failed原因待查,未解决2013-12-06关键词:0x80070570、createrepo cannot access parent directories: No such file or directory安装windows报错,错误代码0x80070570、原因未知,换了一个iso文件,问题解决0x80070570使用windows2008自带的工具进行硬盘分区,均没有解决该报错问题,重新新建了一个虚拟机,换了一个英文版的iso文件,正常安装又换了一个中文版的介质,也能正常安装,有问题的介质是重新构筑DB服务器,从testap拷贝2个虚拟机一、建立分组文件[root@TEST-DB1 15:52:28 repodata]# createrepo -g /var/ftp/pub/Cluster/repodata/comps-rhel5-cluster.xml /var/ftp/pub/Clustershell-init: error retrieving current directory: getcwd: cannot access parent directories: No such file or directory Traceback (most recent call last):File "/usr/share/createrepo/genpkgmetadata.py", line 722, in ?main(sys.argv[1:])File "/usr/share/createrepo/genpkgmetadata.py", line 592, in maincmds, directories = parseArgs(args)File "/usr/share/createrepo/genpkgmetadata.py", line 431, in parseArgscmds['basedir'] = os.getcwd()OSError: [Errno 2] No such file or directory[root@TEST-DB1 15:53:47 repodata]#重新再执行一遍就没问题了二、rhcs组件安装完毕后,启动报错可以先无视,等创建完cluster后,报错消失,据说是少了cluster.conf文件三、需要先停止luci服务,执行luci_admin init,创建用户后,才能登陆https://192.168.144.201:8084/,luci只用在主节点配就可以了在luci界面create a cluster后,/etc/cluster下面会产生一个cluster.conf文件2013-12-09关键词:starting killall、在节点1上可以看到qdisk信息,在节点2上就看不到、WARNING: Falling back to local file-based lockingclurgmgrd: [6279]: <err> startFilesystem: Could not match /dev/mapper/vg_db-lv_db with a real device一、是系统关机时 hang在starting killall这里不动,只能强制关机原因:系统有一些服务器需要停止,解决办法,在脚本/etc/init.d/killall中添加红色字体三行,重新关机定位需要停止的服务[root@TEST-DB1 ~]# cat /etc/init.d/killall#! /bin/bash# Bring down all unneeded services that are still running (there shouldn't# be any, so this is just a sanity check)echo "Starting /etc/init.d/killall" > /var/log/killall.logcase "$1" in*start);;*)echo $"Usage: $0 {start}"exit 1;;esacfor i in /var/lock/subsys/* ; doecho "Found $i" >> /var/log/killall.log# Check if the script is there.[ -f "$i" ] || continue# Get the subsystem name.subsys=${i#/var/lock/subsys/}# Networking could be needed for NFS root.[ $subsys = network ] && continue# Bring the subsystem down.if [ -f /etc/init.d/$subsys.init ]; then/etc/init.d/$subsys.init stopelif [ -f /etc/init.d/$subsys ]; then/etc/init.d/$subsys stopelserm -f "$i"fidoneecho "Finished /etc/init.d/killall script" >> /var/log/killall.log在killall.log中记录了如下信息[root@TEST-DB1 log]# more killall.logStarting /etc/init.d/killallFound /var/lock/subsys/clvmd继续检查发现clvmd服务是开机启动,并且已经启动,由于此时还没有配置lvm,所以猜测是该原因导致,于是手工停止clvmd 服务,重新关机,可以正常关闭,问题解决[root@TEST-DB1 subsys]# /etc/init.d/clvmd statusclvmd (pid 2836) is running...Clustered Volume Groups: (none)Active clustered Logical Volumes: (none)二、之前添加qdisk,是从一块共享硬盘上分区出来的一块,在节点1上执行mkqdisk -c /dev/sdb1 -l myqdisk后,在节点1上可以看到qdisk信息,在节点2上就看不到解决办法:单独创建一块共享磁盘给2个节点作为qdisk使用节点1执行:mkqdisk -c /dev/sdc -l myqdisk节点1和2执行: mkqdisk -L三、创建共享文件系统Pvcreate时告警[root@TEST-DB1 16:30:29 ~]# pvcreate /dev/sdbconnect() failed on local socket: No such file or directoryInternal cluster locking initialisation failed.WARNING: Falling back to local file-based locking.Volume Groups with the clustered attribute will be inaccessible.Writing physical volume data to disk "/dev/sdb"Physical volume "/dev/sdb" successfully created[root@TEST-DB1 16:30:37 ~]#执行service clvmd start后,在重新创建,告警消失四、第一次创建gfs的资源,把device写成/dev/mapper/vg_db-lv_db,然后启动service时报错,Dec 9 17:51:17 TEST-DB1 kernel: dlm: connecting to 2Dec 9 17:51:17 TEST-DB1 kernel: dlm: got connection from 2Dec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <notice> Starting stopped service service:DB-ServiceDec 9 17:51:23 TEST-DB1 clurgmgrd: [6279]: <err> startFilesystem: Could not match /dev/mapper/vg_db-lv_db with a real deviceDec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <notice> start on fs "FS-DATA" returned 2 (invalid argument(s)) Dec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <warning> #68: Failed to start service:DB-Service; return value: 1 Dec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <notice> Stopping service service:DB-ServiceDec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <notice> Service service:DB-Service is recoveringDec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <warning> #71: Relocating failed service service:DB-ServiceDec 9 17:51:24 TEST-DB1 clurgmgrd[6279]: <notice> Service service:DB-Service is stopped解决办法:改成/dev/vg_db/lv_db,问题解决2013-12-10关键词:cluster资源组切换时共享文件系统不能自动umount、db2数据库状态Operable、一、clusvcadm -r DB-Service切换测试,资源组中的ip和nfs服务都能从一个节点切换到另一个节点,共享文件系统/dbdata从一个节点切到另一个节点后,原节点上不会自动umount,导致文档系统在2个节点上都mount原因分析:创建共享文件系统时只在节点1上执行了gfs_mkfs -p lock_dlm -t DB_Cluster:dbdata -j 2 /dev/vg_db/lv_db,在节点2上也执行了一些,但是问题没有解决补充一下,文件系统是GFS,在网上找的的资料《/uid-26931379-id-3558604.html》GFS是RHCS为集群系统提供的一个存储解决方案,它允许集群多个节点在块级别上共享存储,每个节点通过共享一个存储空间,保证了访问数据的一致性,更切实的说,GFS是RHCS提供的一个集群文件系统,多个节点同时挂载一个文件系统分区,而文件系统数据不受破坏,这是单一的文件系统,例如EXT3、EXT2所不能做到的。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

You have to have direct access to console1.) While you are at the console hit ALT + F12.) Type in ” unsupported ” and hit Enter3.) Go ahead and type the root password4.) Go and edit the /etc/inetd.conf file5.) Uncoment the line where you can see “#ssh” (line 32). Remove the “#” mark at the begining.6.) Type “ps -a |grep inetd”7.) Kill the process8.) start inetd共享磁盘的设置ssh://root:*********@ESX_Server:22[root@m1k3 ~]# cd /vmfs/volumes/Storage_m1k3[root@m1k3 Storage_m1k3]# mkdir diskshare[root@m1k3 Storage_m1k3]# cd diskshare[root@m1k3 diskshare]# pwd/vmfs/volumes/Storage_m1k3/diskshare[root@m1k3 diskshare]# vmkfstools -c 30G /vmfs/volumes/Storage_m1k3/diskshare/diskshare.vmdk -d eagerzeroedthickCreating disk '/vmfs/volumes/Storage_m1k3/diskshare/diskshare.vmdk' and zeroing it out...Create: 100% done.[root@m1k3 diskshare]#2 打开cluster01的edit setting... ,选择新增harddisk, 然后选择use an existing virtual disk使用现有的虚拟硬盘diskshare.vmdk3 这一步设置非常关键:虚拟硬盘的 virtual device node 选项要选为: SCSI (1:0),模式选"独立"中的"持久",新增的SCSI控制器总线共享方式选"虚拟"(如果当时虚拟机处于打开状态,可以先操作完成,然后将虚拟机关闭后再进行修改。

)4 设置完后,虚拟机设置会多出一个硬盘和一个SCSI 控制器 15.在虚拟机关机状态下,编辑虚拟机的配置文件(.vmx), 添加以下内容:disk.locking = "false"diskLib.dataCacheMaxSize = "0"scsi1:0.shareBus = "virtual"scsi1:0.deviceType = "disk" ##默认为"scsi-hardDisk",不清楚是否必须改成disk##5 Cluster02照着2-5步同样做一次.附:Vmware官方关于群集中共享磁盘的设置方法及说明Enabling SCSI ReservationSCSI reservation must be enabled in a virtual machine before you can share its disks. To enable it, make sure the virtual machine is powered off. Open the configuration file (.vmx file on Windows hosts, .cfg file on Linux hosts) in a text editor and add the line scsi[n].sharedBus = "virtual" anywhere in the file, where [n] is the SCSI bus being shared.VMware recommends you set up the shared disks on their own SCSI bus, which is a different bus than the one the guest operating system uses. For example, if your guest operating system is on scsi0:0, you should set up disks to share on scsi1 bus.For example, to enable SCSI reservation for devices on the scsi1 bus, add the following line to the virtual machine's configuration file:scsi1.sharedBus = "virtual"This gives the whole bus the ability to be shared. However, if you would rather not share the whole bus, you can selectively enable SCSI reservation for a specific SCSI disk on the shared bus. This prevents the locking of this specific disk. Add the following line to the configuration file:scsi1:1.shared = "true"If SCSI reservation is enabled (that is, scsi1.sharedBus is set to "virtual"), then this setting is ignored.In addition to enabling SCSI reservation on the bus, you need to allow virtual machines to access the shared disk concurrently. Add the following line to the virtual machine's configuration file:disk.locking = "false"This setting permits multiple virtual machines to access a disk concurrently. Be careful though; if any virtual machine not configured for SCSI reservation tries to access this disk concurrently, then the shared disk is vulnerable to corruption or data loss.When SCSI reservation is enabled, a reservation lock file that contains the shared state of the reservation for the given disk is created. The name of this file consists of the filename of the SCSI disk appended with .RESLCK.For example, if the disk scsi1:0.filename is defined in the configuration file asscsi1:0.fileName = "//vmSCSI.pln"then the reservation lock file for this disk is given the default name"//vmSCSI.pln.RESLCK"However, you can provide your own lock file name. Add a definition for scsi1:0.reslckname to the configuration file. For example, ifscsi1:0.reslckname = "/tmp/scsi1-0.reslock"is added to the configuration file, it overrides the default lock file name.Selecting the DiskOnce SCSI reservation is enabled for a disk — that is, the scsi[n].sharedBus = "virtual" and disk.locking = "false" settings are added to the configuration file for each virtual machine wanting to share this disk, you need to point to this disk for each virtual machine that wants to access it.Sharing a Disk on the scsi0 BusVMware does not recommend sharing a disk on SCSI bus 0./s?wd=esx%20%BD%A8%C1%A2%20%B9%B2%CF%ED%B4%C5%C5%CC&pn=0&tn= max2_cb/1388509/324682。