联合概率分布:离散与连续随机变量

高等教育自学考试 概率论与数理统计期末自学 复习重要知识点

概率论与数理统计期末复习重要知识点第二章知识点:1.离散型随机变量:设X 是一个随机变量,如果它全部可能的取值只有有限个或可数无穷个,则称X 为一个离散随机变量。

2.常用离散型分布:(1)两点分布(0-1分布): 若一个随机变量X 只有两个可能取值,且其分布为12{},{}1(01)P X x p P X x p p ====-<<,则称X 服从12,x x 处参数为p 的两点分布。

两点分布的概率分布:12{},{}1(01)P X x p P X x pp ====-<<两点分布的期望:()E X p =;两点分布的方差:()(1)D X p p =-(2)二项分布:若一个随机变量X 的概率分布由式{}(1),0,1,...,.k kn k n P x k C p p k n -==-=给出,则称X 服从参数为n,p 的二项分布。

记为X~b(n,p)(或B(n,p)).两点分布的概率分布:{}(1),0,1,...,.k k n kn P x k C p p k n -==-= 二项分布的期望:()E X np =;二项分布的方差:()(1)D X np p =-(3)泊松分布:若一个随机变量X 的概率分布为{},0,0,1,2,...!kP X k ek k λλλ-==>=,则称X 服从参数为λ的泊松分布,记为X~P (λ)泊松分布的概率分布:{},0,0,1,2,...!kP X k ek k λλλ-==>=泊松分布的期望:()E X λ=;泊松分布的方差:()D X λ=4.连续型随机变量:如果对随机变量X 的分布函数F(x),存在非负可积函数()f x ,使得对于任意实数x ,有(){}()xF x P X x f t dt-∞=≤=⎰,则称X 为连续型随机变量,称()f x 为X 的概率密度函数,简称为概率密度函数。

5.常用的连续型分布: (1)均匀分布:若连续型随机变量X 的概率密度为⎪⎩⎪⎨⎧<<-=其它,0,1)(bx a a b x f ,则称X 在区间(a,b )上服从均匀分布,记为X~U(a,b)均匀分布的概率密度:⎪⎩⎪⎨⎧<<-=其它,0,1)(b x a a b x f 均匀分布的期望:()2a bE X +=;均匀分布的方差:2()()12b a D X -= (2)指数分布:若连续型随机变量X 的概率密度为00()0xe xf x λλλ-⎧>>=⎨⎩,则称X 服从参数为λ的指数分布,记为X~e (λ)指数分布的概率密度:00()0xe xf x λλλ-⎧>>=⎨⎩指数分布的期望:1()E X λ=;指数分布的方差:21()D X λ=(3)正态分布:若连续型随机变量X的概率密度为22()2()x f x x μσ--=-∞<<+∞则称X 服从参数为μ和2σ的正态分布,记为X~N(μ,2σ)正态分布的概率密度:22()2()x f x x μσ--=-∞<<+∞正态分布的期望:()E X μ=;正态分布的方差:2()D X σ=(4)标准正态分布:20,1μσ==,2222()()x t xx x e dtϕφ---∞=标准正态分布表的使用: (1)()1()x x x φφ<=--(2)~(0,1){}{}{}{}()()X N P a x b P a x b P a x b P a x b b a φφ<≤=≤≤=≤<=<<=-(3)2~(,),~(0,1),X X N Y N μμσσ-=故(){}{}()X x x F x P X x P μμμφσσσ---=≤=≤={}{}()()a b b a P a X b P Y μμμμφφσσσσ----<≤=≤≤=-定理1: 设X~N(μ,2σ),则~(0,1)X Y N μσ-=6.随机变量的分布函数: 设X 是一个随机变量,称(){}F x P X x =≤为X 的分布函数。

多维随机变量函数的分布

i ,k : g ( x i , y j ) = z k

∑

p ij

=pk ,

(x1,y1) (x1,y2) … p11 p12

(xi,yj) pij g(xi,yj)

…

Z=g(X,Y)

g(x1,y1) g(x1,y2)

例1 设(X,Y)的联合分布列如下所列: 试求(1)Z1=X+Y (2)Z2=X-Y (3)Z3=max{X,Y}的分布列

练习:设随机变量X与Y独立,且均服从0-1 分布,其分布律均为

X P 0 q 1 p

(1) 求W=X+Y的分布律; (2) 求V=max(X, Y)的分布律; (3) 求U=min(X, Y)的分布律。 (4)求w与V的联合分布律。

(X,Y) pij

W=X+Y

V=max(X, Y) U=min(X, Y)

−∞ 或 ∞ −∞

−∞

∫f

X

( z − y ) f Y ( y )dy = ∫ f X ( x) f Y ( z − x)dx.

例2 设X和Y相互独立,并且服从[-1,1]上的均匀分 布,求Z=X+Y的密度函数。

解:

1 f Y ( x) = 2 0

+∞

当 −1 ≤ x ≤ 1 其他

其中α>0,β>0,试分别就以上两 种联结方式写出L的寿命Z的概率 密度.

αe − αx , x > 0, f X ( x) = x ≤ 0, 0,

βe − βy , y > 0, fY ( y ) = y ≤ 0, 0,

其中 α > 0, β > 0 且 α ≠ β . 试分别就以上三种联 接方式写出 L 的寿命 Z 的概率密度 .

概率论公式大全二维随机变量多项分布与独立同分布

概率论公式大全二维随机变量多项分布与独立同分布概率论是数学中的一个重要分支,它研究随机事件以及其概率性质。

其中,随机变量是概率论中的一个基本概念,它可以用来描述随机现象和随机试验的结果。

本文将介绍概率论中与二维随机变量、多项分布以及独立同分布相关的公式。

一、二维随机变量在概率论中,随机变量可以分为一维和多维两种情况。

一维随机变量描述的是具有一个取值的随机事件,而二维随机变量则描述的是具有两个取值的随机事件。

常见的二维随机变量包括离散型和连续型两种。

1. 离散型二维随机变量离散型二维随机变量的概率分布可以通过联合概率质量函数(Joint Probability Mass Function,简称JPMS)来描述。

对于二维离散型随机变量(X, Y),其概率分布可以用如下公式表示:P(X = x, Y = y) = P(X, Y)其中,P(X = x, Y = y)表示随机变量X取值为x,随机变量Y取值为y的概率,P(X, Y)表示联合概率质量函数。

2. 连续型二维随机变量对于连续型二维随机变量,其概率分布则可以通过联合概率密度函数(Joint Probability Density Function,简称JPDS)来描述。

对于二维连续型随机变量(X, Y),其概率分布可以用如下公式表示:P(a ≤ X ≤ b, c ≤ Y ≤ d) = ∬f(x, y)dxdy其中,f(x, y)表示联合概率密度函数,∬表示对整个平面积分,a、b、c、d为常数。

二、多项分布多项分布是二项分布的推广,它适用于具有多个离散可能结果的试验。

假设有n个独立的试验,每个试验有k种可能的结果,且每种结果出现的概率是固定的。

那么多项分布描述了试验结果中每种可能出现的次数的概率分布。

多项分布的概率质量函数可以表示为:P(X₁ = x₁, X₂ = x₂, ..., Xk = xk) = (n! / (x₁! * x₂! * ... * xk!)) *(p₁^x₁ * p₂^x₂ * ... * pk^xk)其中,n为试验次数,xi表示结果i出现的次数,pi表示结果i出现的概率。

边缘分布律怎么求

边缘分布律怎么求在概率论与数理统计中,边缘分布律(marginal distribution)是指在多维随机变量中,将其中几个变量固定,得到的某一个变量的概率分布。

对于一个具有两个或多个随机变量的概率分布,我们通常关注某一个或几个变量的概率分布情况。

而边缘分布律可以帮助我们实现这一点。

边缘分布律的求解方法取决于问题的具体情况。

下面我们将介绍两种常见的方法:离散型变量和连续型变量的求解方法。

1. 离散型变量的边缘分布律的求解方法:假设有两个离散型随机变量X和Y,它们的联合概率分布律为P(X=x, Y=y)。

要求X的边缘分布律,我们需要将Y变量固定,然后对所有可能取值求和,即:P(X=x) = Σ P(X=x, Y=y)其中Σ 表示对Y的所有可能取值求和。

2. 连续型变量的边缘分布律的求解方法:假设有两个连续型随机变量X和Y,它们的联合概率密度函数为f(x, y)。

要求X的边缘分布律,我们需要将Y变量固定,然后对X进行积分,即:fX(x) = ∫ f(x, y) dy其中∫ 表示对Y的所有取值进行积分。

需要注意的是,在求解边缘分布律时,我们需要考虑变量的范围。

如果X和Y的范围是有限的,那么在将变量固定时,需要限定积分或求和的范围。

此外,边缘分布律还可以通过累积分布函数(CDF)求得。

对于离散型变量,边缘分布律可以通过对联合分布函数求偏导得到。

对于连续型变量,边缘分布律可以通过对联合概率密度函数求偏导得到。

总之,边缘分布律是概率论与数理统计中的一个重要概念,可以帮助我们研究多维随机变量的概率分布。

根据变量的类型(离散型或连续型),我们可以选择不同的方法来求解边缘分布律。

无论是离散型还是连续型变量,求解边缘分布律都需要将其他变量固定,然后对概率分布进行求和或积分。

掌握求解边缘分布律的方法,对于我们研究随机变量的概率分布具有重要的意义。

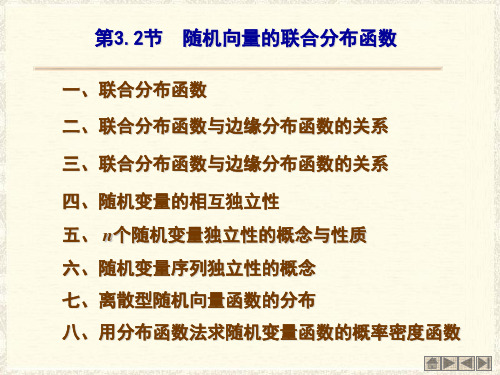

随机向量的联合分布函数

相互独立的二项分布、泊松分布、正态分布具有可加性 以上三个结论均可推广到三项及有限项

若Xi~N(μi,σi2), (i=1,2 ···,n), X1,X2, ···, Xn相互独立,实数

(1) 离散型随机变量X1 ,X2 , ···,Xn相互独立等价于联合概率

分布等于边缘概率分布的乘积.

(2) 连续型随机变量X1 ,X2 , ···, Xn相互独立等价于联合概率 密度函数等于边缘概率密度函数的乘积.

可统一为联合概率分布等于边缘概率分布的乘积.

六、随机变量序列独立性的概念

若n个随机变量X1 , X2, ···,Xn相互独立,则它们中的任意 m(1<m≤n)个随机变量也相互独立.

设随机向量(X,Y)的联合密度函数为f(x,y),记Z=g(X,Y). (1) 求Z的分布函数

F(z) P(Z z) P(g(X ,Y ) z)

f (x, y)dxdy

g( x,y)z

(2) 对F(z)求导即得Z的概率密度函数f(z).

例2 设随机向量(X,Y)服从区域

定义 二元实函数F( x , y )=P{ X ≤ x , Y ≤ y} (x,y)∈R2 称为二维随机向量(X,Y)的联合分布函数. (1)(X,Y)为离散型随机向量,且联合概率分布为

P( X xi ,Y y j ) pij

则相应的联合分布函数 F( x, y) pij xi x y j y

(2)(X,Y)为连续型随机向量,且联合概率密度为 f ( x, y)

xy

联合概率密度函数

反变换

X1=h1(y1, y2,…, yn),…, Xn=hn(y1, y2,…, yn) 具有连续的一阶偏导数,则Y1, Y2,…, Yn 的联合密度函数为

1.1 概率分布与分布的特征

1.1.1 联合分布(Joint Distribution) 离散型:联合概率函数

p(x1, x2,…, xn)=P (X1= x1, X2=x2,…, Xn = xn)

连续型:联合概率密度函数 如果存在n维非负可积函数f (x1, x2,…, xn ),使得

F (x1, x2, , xn )

本章大纲

1.1 概率分布与分布的特征 1.2 常见的统计分布 1.3 样本与抽样分布

1.1 概率分布与分布的特征

(Probability distributions and distribution characteristics)

1.1.1 联合分布 1.1.2 随机变量函数的分布 1.1.3 条件数学期望 1.1.4 矩母函数

可以改记为

p(n1, n2 , , nr1)

P(N1 n1, N2 n2 , , Nr1 nr1, )

n!

n1!n2!

nr !

p n1 1

p n2 2

p nr r

显然二项分布是多项分布的边缘分布

1.1.1 联合分布(Joint Distribution)

【例1.2】 Farlie-Morgenstern Family (P77-79) 设F(x)和G(x)都是一维连续型分布函数(cdf),可以

随机变量的独立性及联合分布的定义及计算方法

随机变量的独立性及联合分布的定义及计算方法随机变量是统计学中一个重要的概念,指的是随机试验中可能取到的数值。

对于多个随机变量之间的关系,独立性和联合分布是常用的概念和方法。

本文将依次介绍随机变量独立性的定义和判定方法、随机变量的联合分布的定义和常见计算方法。

一、随机变量的独立性随机变量的独立性是指在给定条件下,多个随机变量之间不存在相关性,即一个随机变量的取值不会对其他随机变量的取值产生影响。

常用的判定方法包括:1. 互不影响如果两个随机变量之间互不影响,则这两个变量是独立的。

例如,投掷两个骰子,其中一个骰子的点数不会影响另一个骰子的点数,因此两个骰子的点数是独立的随机变量。

2. 相互独立如果多个随机变量之间的任意两个变量都是独立的,则这些随机变量是相互独立的。

例如,投掷三个骰子,每个骰子的点数都是独立的随机变量,因此三个骰子的点数是相互独立的随机变量。

3. 独立性定义下的概率乘法公式对于两个独立的随机变量X和Y,它们同时取到某个值的概率等于它们各自取到这个值的概率的乘积。

即P(X=x,Y=y)=P(X=x)P(Y=y)。

该公式也适用于多个独立的随机变量。

二、随机变量的联合分布多个随机变量的联合分布是指这些随机变量取值组合所对应的概率分布函数。

常用的计算方法包括:1. 联合分布函数对于两个随机变量X和Y,它们的联合分布函数定义为F(x,y)=P(X<=x,Y<=y)。

该函数可以用来计算任意两个随机变量的联合分布。

对于多个随机变量,联合分布函数的定义相应地拓展。

2. 联合概率密度函数对于连续型随机变量,它们的联合概率密度函数可以通过对应的联合分布函数求导得到。

即f(x,y)=∂^2 F(x,y)/∂x∂y。

该函数可以用来计算任意两个连续型随机变量的联合分布。

对于多个连续型随机变量,联合概率密度函数的定义相应地拓展。

3. 边缘分布和条件分布对于联合分布中的任意一个随机变量,我们都可以将它的概率分布函数单独计算出来,称为边缘分布。

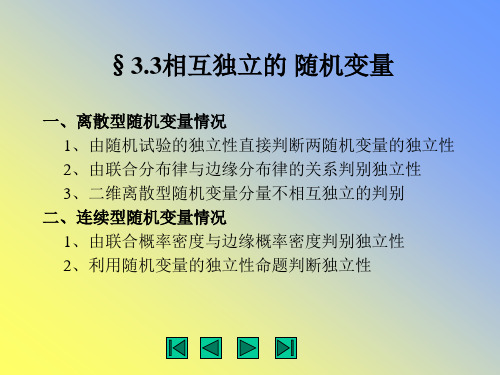

概率与统计3。3-0

2、利用随机变量的独立性命题 判断独立性

命题3.2 若(X , Y )为连续型随机变量,其概率密度 为f ( x, y ),则X与Y相互独立的充要条件为: 存在连续函数h( x), g ( y ), 使 h( x) g ( y ) a ≤ x ≤ b, c ≤ y ≤ d f ( x, y ) = (3.5) 0 其它 其中a, b, c, d均为与x, y无关的常数(可为∞)。

+∞ 解 : (1) f X ( x) = ∫−∞ f ( x, y ) dy

y

y=1/x

x ln x 1 1 x ∫1 2 dy = 2 ln y 1 = 2 = 2x y 2x x x x 0 +∞ f Y ( y ) = ∫−∞ f ( x, y )dx 1 +∞ 1 ∫1 2 x 2 y dx = 2 y 1 +∞ 1 = ∫y dx = 2 2 2y 2x y 0

x >1 x ≤1

1 0 1 x

0 < y <1 1 ≤ y < +∞ y≤0

1 2 x 2 ln x 1 (2) f X ( x) ⋅ f Y ( y ) = 2 2 ln x 2x y 0 故此X与Y不相互独立。

x > 1,0 < y < 1 x > 1, y ≥ 1 ≠ f ( x, y ) 其它

3、二维离散型随机变量 分量不相互独立的判别 : 若X和Y相互独立,则对于所有 的i, j,均该满足 pij = pi. p. j 也即意味着,只要存在 一对(i, j ),满足pij ≠ pi. p. j 则X与Y必不相互独立。

命题 3.1 若二维离散型随机变量 ( X , Y )的联合概率 分布表中存在某个 p i0 j0 = 0, 则X与Y必不相互独立。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Joint Distributions,Discrete CaseIn the following,X and Y are discrete random variables.1.Joint distribution(joint p.m.f.):•Definition:f(x,y)=P(X=x,Y=y)•Properties:(1)f(x,y)≥0,(2)x,yf(x,y)=1•Representation:The most natural representation of a joint discrete distribution is asa distribution matrix,with rows and columns indexed by x and y,and the xy-entrybeing f(x,y).This is analogous to the representation of ordinary discrete distributionsas a single-row table.As in the one-dimensional case,the entries in a distribution matrixmust be nonnegative and add up to1.2.Marginal distributions:The distributions of X and Y,when considered separately.•Definition:•f X(x)=P(X=x)=yf(x,y)•f Y(y)=P(Y=y)=xf(x,y)•Connection with distribution matrix:The marginal distributions f X(x)and f Y(y)can be obtained from the distribution matrix as the row sums and column sums of theentries.These sums can be entered in the“margins”of the matrix as an additionalcolumn and row.•Expectation and variance:µX,µY,σ2X ,σ2Ydenote the(ordinary)expectations andvariances of X and Y,computed as usual:µX=xxf X(x),etc.putations with joint distributions:•Probabilities:Probabilities involving X and Y(e.g.,P(X+Y=3)or P(X≥Y)can be computed by adding up the corresponding entries in the distribution matrix:More formally,for any set R of points in the xy-plane,P((X,Y)∈R))=(x,y)∈Rf(x,y).•Expectation of a function of X and Y(e.g.,u(x,y)=xy):E(u(X,Y))=x,yu(x,y)f(x,y).This formula can also be used to compute expectation and variance of the marginal distributions directly from the joint distribution,withoutfirst computing the marginal distribution.For example,E(X)=x,yxf(x,y).4.Covariance and correlation:•Definitions:Cov(X,Y)=E(XY)−E(X)E(Y)=E((X−µX)(Y−µY))(Covarianceof X and Y),ρ=ρ(X,Y)=Cov(X,Y)σXσY(Correlation of X and Y)•Properties:|Cov(X,Y)|≤σXσY,−1≤ρ(X,Y)≤1•Relation to variance:Var(X)=Cov(X,X)•Variance of a sum:Var(X+Y)=Var(X)+Var(Y)+2Cov(X,Y)(Note the analogy of the latter formula to the identity(a+b)2=a2+b2+2ab;the covariance acts like a “mixed term”in the expansion of Var(X+Y).)15.Independence of random variables:•Definition:X and Y are called independent if the joint p.m.f.is the product of the individual p.m.f.’s:i.e.,if f(x,y)=f X(x)f Y(y)for all values of x and y.•Properties of independent random variables:If X and Y are independent,then:–The expectation of the product of X and Y is the product of the individual expectations:E(XY)=E(X)E(Y).More generally,this product formula holdsfor any expectation of a function X times a function of Y.For example,E(X2Y3)=E(X2)E(Y3).–The product formula holds for probabilities of the form P(some condi-tion on X,some condition on Y)(where the comma denotes“and”):Forexample,P(X≤2,Y≤3)=P(X≤2)P(Y≤3).–The covariance and correlation of X and Y are0:Cov(X,Y)=0,ρ(X,Y)=0.–The variance of the sum of X and Y is the sum of the individual variances: Var(X+Y)=Var(X)+Var(Y)–The moment-generating function of the sum of X and Y is the product of the individual moment-generating functions:M X+Y(t)=M X(t)M Y(t).(Note that it is the sum X+Y,not the product XY,which has this property.) 6.Conditional distributions:•Definitions:–conditional distribution(p.m.f.)of X given that Y=y:g(x|y)=P(X=x|Y=y)=f(x,y)f Y(y)–conditional distribution(p.m.f.)of Y given that X=x:h(y|x)=P(Y=y|X=x)=f(x,y)f X(x)•Connection with distribution matrix:Conditional distributions are the distribu-tions obtained byfixing a row or column in the matrix and rescaling the entries in that row or column so that they again add up to1.For example,h(y|2),the conditional dis-tribution of Y given that X=2,is the distribution given by the entries in row2of the matrix,rescaled by dividing by the row sum(namely,f X(2)):h(y|2)=f(2,y)/f X(2).•Conditional expectations and variance:Conditional expectations,variances,etc., are defined and computed as usual,but with conditional distributions in place of ordinary distributions:•E(X|y)=E(X|Y=y)=xg(x|y)xx2g(x|y)•E(X2|y)=E(X2|Y=y)=x•Var(X|y)=Var(X|Y=y)=E(X2|y)−E(X|y)2More generally,for any condition(such as Y>0),the expectation of X given this condition is defined as•E(X|condition)=xP(X=x|condition)xand can be computed by starting out with the usual formula for the expectation,but restricting to those terms that satisfy the condition.2Joint Distributions,Continuous CaseIn the following,X and Y are continuous random variables.Most of the concepts and formulas below are analogous to those for the discrete case,with integrals replacing sums.The principal difference between continuous lies in the definition of the p.d.f./p.m.f.f (x,y ):The formula f (x,y )=P (X =x,Y =y )is no longer valid,and there is no simple and direct way to obtain f (x,y )from X and Y .1.Joint continuous distributions:•Joint density (joint p.d.f.):A function f (x,y )satisfying (i)f (x,y )≥0,(ii) f (x,y )dxdy =ually,f (x,y )will be given by an explicit formula,along with a range (a region in the xy -plane)on which this formula holds.In the general formulas below,if a range of integration is not explicitly given,the integrals are to be taken over the range in which the density function is defined.•Uniform joint distribution:An important special type of joint density is one that is constant over a given range (a region in the xy -plane),and 0outside outside this range,the constant being the reciprocal of the area of of the range.This is analogous to the concept of an ordinary (one-variable)uniform density f (x )over an interval I ,which is constant (and equal to the reciprocal of the length of I )inside the interval,and 0outside it.2.Marginal distributions:The ordinary distributions of X and Y ,when considered sepa-rately.The corresponding (one-variable)densities are denoted by f X (or f 1)and f Y (or f 2),and obtained by integrating the joint density f (x,y )over the “other”variable:f X (x )= f (x,y )dy,f Y (y )= f (x,y )dx.putations with joint distributions:•Probabilities:Given a region R in the xy -plane the probability that (X,Y )falls into this region is given by the double integral of f (x,y )over this region.For example,P (X +Y ≤1)is given by an integral of the form R f (x,y )dxdy ,where R consists of the part of the range of f in which x +y ≤1.•Expectation of a function of X and Y (e.g.,u (x,y )=xy ):E (u (X,Y ))= u (x,y )f (x,y )dxdy4.Covariance and correlation:The formulas and definitions are the same as in the discrete case.•Definitions:Cov(X,Y )=E (XY )−E (X )E (Y )=E ((X −µX )(Y −µY ))(Covarianceof X and Y ),ρ=ρ(X,Y )=Cov(X,Y )σX σY(Correlation of X and Y )•Properties:|Cov(X,Y )|≤σX σY ,−1≤ρ(X,Y )≤1•Relation to variance:Var(X )=Cov(X,X )•Variance of a sum:Var(X +Y )=Var(X )+Var(Y )+2Cov(X,Y )5.Independence of random variables:Same as in the discrete case:•Definition:X and Y are called independent if the joint p.d.f.is the product of the individual p.d.f.’s:i.e.,if f (x,y )=f X (x )f Y (y )for all x ,y .3•Properties of independent random variables:If X and Y are independent,then:–The expectation of the product of X and Y is the product of the individual expectations:E(XY)=E(X)E(Y).More generally,this product formula holdsfor any expectation of a function X times a function of Y.For example,E(X2Y3)=E(X2)E(Y3).–The product formula holds for probabilities of the form P(some condi-tion on X,some condition on Y)(where the comma denotes“and”):Forexample,P(X≤2,Y≤3)=P(X≤2)P(Y≤3).–The covariance and correlation of X and Y are0:Cov(X,Y)=0,ρ(X,Y)=0.–The variance of the sum of X and Y is the sum of the individual variances: Var(X+Y)=Var(X)+Var(Y)–The moment-generating function of the sum of X and Y is the product of the individual moment-generating functions:M X+Y(t)=M X(t)M Y(t).6.Conditional distributions:Same as in the discrete case,with integrals in place of sums:•Definitions:–conditional density of X given that Y=y:g(x|y)=f(x,y)f Y(y)–conditional density of Y given that X=x:h(y|x)=f(x,y)f X(x)•Conditional expectations and variance:Conditional expectations,variances,etc., are defined and computed as usual,but with conditional distributions in place of ordinarydistributions.For example:•E(X|Y=1)=E(X|Y=1)=xg(x|1)dx•E(X2|Y=1)=E(X2|Y=1)=x2g(x|1)dx 4。