粒子群优化算法的性能分析和参数选择

Matlab中的粒子群优化算法详解

Matlab中的粒子群优化算法详解引言:粒子群优化算法(Particle Swarm Optimization, PSO)是一种模拟鸟群觅食行为的优化算法,具有简单易实现、无需求导和全局搜索能力强等特点。

该算法在解决多种问题中得到广泛应用,特别是在机器学习、智能优化等领域。

本文将详细介绍Matlab中粒子群优化算法的实现过程及应用。

一、粒子群优化算法原理粒子群优化算法源自于对鸟群觅食行为的模拟。

假设一个鸟群中的每个个体被称为粒子,所有粒子共同组成了一个搜索空间,每个粒子会根据自身的当前位置和历史最佳位置进行搜索,并且受到其邻近粒子的信息影响。

通过不断的迭代运算,粒子们逐渐收敛到全局最优解或局部最优解。

具体算法流程如下:1. 初始化粒子群的位置和速度。

2. 计算每个粒子的适应度值,并更新个体最优位置。

3. 根据全局最优位置调整粒子的速度和位置。

4. 重复执行第2步和第3步,直到满足终止条件。

二、Matlab中粒子群优化算法实现步骤在Matlab中,可以通过以下步骤来实现粒子群优化算法:1. 初始化粒子群的位置和速度。

首先需要确定粒子群的大小,即粒子的个数。

对于每个粒子,需要随机生成一个初始位置和速度。

可以使用Matlab中的rand函数来生成指定范围内的随机数。

问题优劣的指标,因此需要根据具体问题来确定。

对于更新个体最优位置,可以通过比较当前适应度值和历史最佳适应度值的大小,选择适应度更优的位置进行更新。

3. 根据全局最优位置调整粒子的速度和位置。

粒子的速度和位置的更新是通过以下公式实现的:V(i,j) = w * V(i,j) + c1 * rand() * (P(i,j) - X(i,j)) + c2 * rand() * (G(j) - X(i,j))X(i,j) = X(i,j) + V(i,j)其中,V(i,j)表示第i个粒子在第j个维度上的速度,X(i,j)表示第i个粒子在第j个维度上的位置,P(i,j)表示第i个粒子的历史最佳位置,G(j)表示全局最佳位置,w、c1和c2分别表示惯性权重、个体学习因子和社会学习因子。

粒子群优化算法在电力系统调度中的应用教程

粒子群优化算法在电力系统调度中的应用教程1. 引言电力系统调度是指对电力系统内发电机组和负荷的调度控制,以实现电力系统的安全、稳定、经济运行。

针对电力系统调度问题,粒子群优化算法(Particle Swarm Optimization, PSO)被广泛应用于寻找最优解。

本文将介绍粒子群优化算法的基本原理,并详细阐述其在电力系统调度中的具体应用。

2. 粒子群优化算法基本原理粒子群优化算法是一种基于群体智能的优化算法,其核心思想来源于生物的群体行为,如鸟群觅食等。

算法通过模拟鸟群觅食行为,利用每个粒子的位置和速度来寻找最优解。

其基本步骤如下:(1)初始化粒子位置和速度;(2)根据位置和速度更新粒子的移动方向;(3)计算粒子的适应度值;(4)根据适应度值更新全局最优解和个体最优解;(5)重复步骤(2)至(4)直至满足终止条件。

3. 粒子群优化算法在电力系统调度中的应用3.1 发电机组调度电力系统发电机组调度是指在满足电力需求和调度约束条件下,合理分配发电机组的出力。

粒子群优化算法可以用于确定发电机组的最优出力分配方案,以实现电力系统的经济运行。

具体步骤如下:(1)初始化粒子群的位置和速度,表示发电机组的出力;(2)根据位置和速度更新粒子的移动方向,即调整发电机组的出力;(3)计算粒子的适应度值,即计算电力系统的运行成本;(4)根据适应度值更新全局最优解和个体最优解;(5)重复步骤(2)至(4),直至满足调度约束条件。

3.2 负荷调度电力系统负荷调度是指合理安排电力系统的负荷分配,以实现负荷平衡和供需平衡。

粒子群优化算法可应用于负荷调度问题,以优化电力系统的能源利用效率。

具体步骤如下:(1)初始化粒子群的位置和速度,表示负荷的分配;(2)根据位置和速度更新粒子的移动方向,即调整负荷的分配;(3)计算粒子的适应度值,即计算电力系统的供需平衡度;(4)根据适应度值更新全局最优解和个体最优解;(5)重复步骤(2)至(4),直至满足供需平衡的要求。

粒子群算法的参数及选择

粒子群算法的参数及选择粒子群算法,听上去是不是有点高深莫测?其实这玩意儿就像我们生活中的寻宝游戏,参与者在一片“宝藏”中飞来飞去,试图找到最闪亮的那颗。

说到这里,可能有人会问:这个算法里到底有哪些参数呀?咱们今天就来聊聊这些参数,以及怎么选择它们,让大家在“寻宝”过程中不至于迷了路。

我们得了解粒子群算法的基本组成部分。

想象一下,算法里的每一个粒子就像一个小小的探险家,它们在一个多维空间里飞来飞去,试图找到最好的解决方案。

这个时候,粒子的“速度”和“位置”就显得特别重要。

速度决定了粒子在空间中的移动速度,而位置则是它目前在“寻宝”中的位置。

想要找到最优解,得调整这两个参数,听上去是不是像在开车?控制好油门和方向,才能不至于迷失在路上。

咱们再说说“个体学习因子”和“社会学习因子”。

这个俩家伙就是粒子群的灵魂。

个体学习因子就像你身边那个爱分享经验的朋友,他总是愿意告诉你自己找宝藏的心得;而社会学习因子则是大家一起讨论的氛围,越热烈,越能激发每个人的灵感。

选择这两个因子的时候,得根据具体情况来定。

团队合作显得特别重要;个人独立思考又不能少。

可以说,这就是个“平衡”的艺术了。

再聊聊“惯性权重”。

哎呀,这个词听起来有点拗口,其实说白了就是粒子在前进过程中对自己前进方向的依赖程度。

如果惯性权重设置得高,粒子就像开着车的老司机,能保持原有的方向;如果设置得低,那就像新手司机,左右摇摆不定,容易迷路。

所以,设置这个参数的时候,得谨慎点,不能一味追求速度,要有稳定性才行。

说完这些参数,咱们得讨论一下怎么选择它们了。

就像打麻将,手里有一副好牌,但怎么玩才是关键。

得考虑问题的复杂程度。

有些问题就像是小儿科,简单明了;而有些问题则复杂得像天上的星星,让人眼花缭乱。

根据问题的复杂程度来选择参数,才能事半功倍。

数据的性质也得考虑。

有些数据分布得很均匀,有些则像一团乱麻。

这时候,参数的选择得灵活变通,适应不同的数据特点。

就像做饭一样,材料不同,调料的配比也得随之调整。

粒子群算法的参数分析_杨韬.caj

粒子群算法的参数分析辽宁工程技术大学工商管理学院杨韬[摘要]粒子群算法是一类基于迭代的随机全局优化技术,因思想简单而应用广泛,但在参数选择及理论分析方面的研究成果比较分散。

本文通过对粒子群算法的主要参数进行分析和总结,给出了阶段性的综述。

[关键词]粒子群算法惯性权重加速系数收缩因子1.引言粒子群优化算法(ParticleSwarmOptimization,简称PSO)是Kennedy和Eberhart于1995年提出,源于对鸟类觅食过程中的迁徙和群集行为的模仿[1]。

PSO通过粒子间的相互作用搜索复杂空间中的最优区域,是一类基于迭代的随机全局优化算法[2]。

因其思想简单、操作易行等优点而广泛应用于函数优化、模式分类、机器学习、神经网络训练、信号处理、模糊系统控制和自适应控制等领域。

本文从标准粒子群算法入手,对PSO的参数选择进行了分析;接着归纳了PSO的演变;最后进行了总结。

2.PSO的参数选择2.1标准粒子群算法在PSO中,先初始化为一群随机粒子,每个粒子的位置代表一个候选解,解的优劣程度由适应度函数所决定。

每一次迭代中,粒子们追随当前的最优粒子在解空间中搜索,通过跟踪两个“极值”来更新自己。

一个是粒子本身所找到的最优解,即个体极值pbest,另一个极值是整个种群目前找到的最优解,即全局极值gbest,或由粒子的邻居组成的一部分局部极值lbest[3]。

设在一个N维目标搜索空间中,有m个粒子组成的群体,则第i个粒子在N维空间中的位置可表示为Xi=(xi1,xi2,…,xiN)r,i=1,2,…,m;在N维空间中的“飞行”速度可表示为Vi=(vi1,vi2,…,viN)r,i=1,2,…,m。

设pbesti表示第i个粒子迄今为止搜索到的最优位置,gbesti表示整个粒子群迄今为止搜索到的最优位置。

对于每一代粒子,其进化方程可描述为:Vi=wVi+c1r1(pbesti-Xi)+c2r2(gbesti-Xi)(1)Xi=Xi+Vi(2)pbesti=pbesti,iff(Xi)≥pbestiXi,iff(Xi)<pbesti"(3)公式中,w是惯性权重(w>0),r1、r2是[0,1]之间的随机数。

免疫粒子群优化算法

免疫粒子群优化算法一、本文概述随着和计算智能的飞速发展,优化算法在众多领域,如机器学习、数据挖掘、控制工程等,都展现出了巨大的潜力和应用价值。

作为优化算法中的一种重要分支,粒子群优化(Particle Swarm Optimization, PSO)算法因其简单易实现、全局搜索能力强等特点,受到了广泛的关注和研究。

然而,随着问题复杂度的增加和实际应用需求的提升,传统的PSO算法在求解一些高维、多模态或非线性优化问题时,常常陷入局部最优解,难以找到全局最优解。

为了解决这些问题,本文提出了一种免疫粒子群优化算法(Immune Particle Swarm Optimization, IPSO)。

该算法结合了生物免疫系统的自学习、自适应和自组织等特性,通过引入免疫机制来增强PSO算法的全局搜索能力和收敛速度。

免疫粒子群优化算法的核心思想是将免疫算法中的抗体种群与粒子群优化算法中的粒子种群相结合,通过模拟生物免疫系统的多样性和记忆机制,实现粒子种群在搜索过程中的自我更新和优化。

本文首先介绍了粒子群优化算法的基本原理和发展现状,然后详细阐述了免疫粒子群优化算法的基本框架和实现过程。

在此基础上,通过一系列实验验证了免疫粒子群优化算法在求解高维、多模态和非线性优化问题上的有效性和优越性。

本文还对免疫粒子群优化算法的未来发展方向和应用前景进行了展望。

通过本文的研究,旨在为优化算法领域提供一种新颖、高效的算法工具,为解决复杂优化问题提供新的思路和方法。

也希望本文的研究能为相关领域的研究人员和工程师提供有益的参考和借鉴。

二、优化算法概述优化算法是一种寻找问题最优解的数学方法,广泛应用于工程、经济、管理等多个领域。

随着科技的发展,优化算法的种类和复杂性也在不断增加,其中粒子群优化算法(Particle Swarm Optimization, PSO)作为一种群体智能优化算法,因其简洁性和有效性,受到了广泛关注。

然而,传统的粒子群优化算法在面对复杂优化问题时,往往会出现早熟收敛、陷入局部最优等问题,限制了其在实际应用中的性能。

粒子群算法评价指标

粒子群算法评价指标

粒子群算法是一种优化算法,常用于解决参数优化或函数最优化问题。

评价指标用于评估粒子群算法的性能和效果。

以下是几个常用的评价指标:

1. 收敛性:评估算法是否能够收敛到最优解。

常见的评价方法是观察目标函数值的收敛曲线,如果曲线趋于稳定且接近最优解,则说明算法具有较好的收敛性能。

2. 收敛速度:评估算法收敛到最优解所需的迭代次数。

一般情况下,收敛速度越快越好,可以通过比较不同算法的迭代次数来评估其收敛速度。

3. 精确性:评估算法得到的解与真实最优解之间的差距。

可以通过计算目标函数值的误差或比较解的相似度来评估算法的精确性。

4. 多样性:评估算法生成的解的多样性,即解的分布是否均匀,是否能够覆盖整个搜索空间。

多样性较好的算法可以更全面地搜索解空间,有助于找到更好的解。

5. 鲁棒性:评估算法对初始参数设置的敏感程度。

鲁棒性较好的算法对初始参数的选择不敏感,能够在不同的问题和数据集上表现良好。

以上是一些常用的评价指标,根据具体问题和需求,可以选择合适的评价指标来评估粒子群算法的性能和效果。

粒子群算法重要参数

粒子群算法重要参数粒子群算法(Particle Swarm Optimization, PSO)是一种基于群体智能的优化算法,通过模拟鸟群或鱼群等集体行为,寻找最优解。

在使用粒子群算法时,需要设置一些重要的参数,这些参数会影响算法的收敛速度和搜索性能。

本文将介绍粒子群算法的重要参数及其作用。

1. 粒子数量(Number of Particles)粒子数量是指参与搜索的粒子个数。

粒子数量的选择直接影响算法的搜索范围和搜索速度。

一般来说,粒子数量越多,搜索范围越广,但同时也会增加算法的计算复杂度。

因此,选择合适的粒子数量是很重要的。

2. 迭代次数(Number of Iterations)迭代次数是指算法执行的次数。

每一次迭代中,粒子根据自身的速度和经验进行位置更新。

迭代次数的选择会影响算法的搜索精度和计算时间。

一般来说,迭代次数越多,算法收敛的可能性越大,但同时也会增加计算时间。

3. 速度权重参数(Inertia Weight)速度权重参数控制粒子速度的更新。

它的作用是平衡粒子的历史速度和当前速度对位置更新的影响。

较大的权重值能够增加粒子的探索能力,但可能导致粒子在搜索空间中震荡;较小的权重值能够增加粒子的局部搜索能力,但可能导致陷入局部最优解。

因此,选择合适的速度权重参数是很重要的。

4. 个体学习因子(Cognitive Learning Factor)个体学习因子用于调整粒子根据个体经验更新速度的权重。

它决定了粒子在搜索过程中对个体最优解的关注程度。

较大的个体学习因子能够增加粒子的全局搜索能力,但可能导致粒子在搜索空间中震荡;较小的个体学习因子能够增加粒子的局部搜索能力,但可能导致陷入局部最优解。

因此,选择合适的个体学习因子是很重要的。

5. 社会学习因子(Social Learning Factor)社会学习因子用于调整粒子根据群体经验更新速度的权重。

它决定了粒子在搜索过程中对群体最优解的关注程度。

粒子群算法参数设置

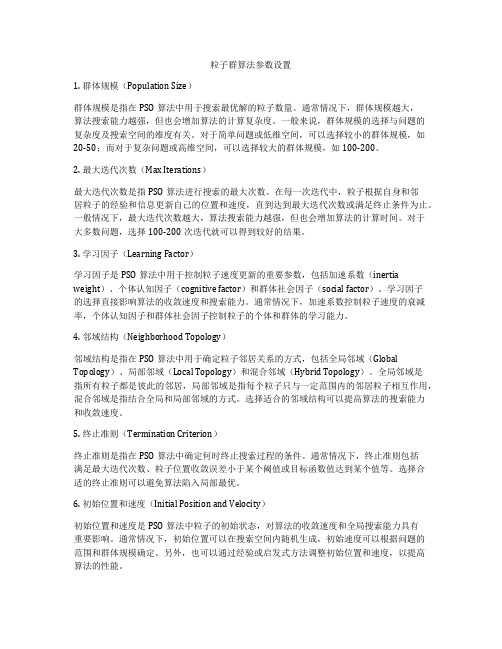

粒子群算法参数设置1. 群体规模(Population Size)群体规模是指在PSO算法中用于搜索最优解的粒子数量。

通常情况下,群体规模越大,算法搜索能力越强,但也会增加算法的计算复杂度。

一般来说,群体规模的选择与问题的复杂度及搜索空间的维度有关。

对于简单问题或低维空间,可以选择较小的群体规模,如20-50;而对于复杂问题或高维空间,可以选择较大的群体规模,如100-200。

2. 最大迭代次数(Max Iterations)最大迭代次数是指PSO算法进行搜索的最大次数。

在每一次迭代中,粒子根据自身和邻居粒子的经验和信息更新自己的位置和速度,直到达到最大迭代次数或满足终止条件为止。

一般情况下,最大迭代次数越大,算法搜索能力越强,但也会增加算法的计算时间。

对于大多数问题,选择100-200次迭代就可以得到较好的结果。

3. 学习因子(Learning Factor)学习因子是PSO算法中用于控制粒子速度更新的重要参数,包括加速系数(inertia weight)、个体认知因子(cognitive factor)和群体社会因子(social factor)。

学习因子的选择直接影响算法的收敛速度和搜索能力。

通常情况下,加速系数控制粒子速度的衰减率,个体认知因子和群体社会因子控制粒子的个体和群体的学习能力。

4. 邻域结构(Neighborhood Topology)邻域结构是指在PSO算法中用于确定粒子邻居关系的方式,包括全局邻域(Global Topology)、局部邻域(Local Topology)和混合邻域(Hybrid Topology)。

全局邻域是指所有粒子都是彼此的邻居,局部邻域是指每个粒子只与一定范围内的邻居粒子相互作用,混合邻域是指结合全局和局部邻域的方式。

选择适合的邻域结构可以提高算法的搜索能力和收敛速度。

5. 终止准则(Termination Criterion)终止准则是指在PSO算法中确定何时终止搜索过程的条件。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

3 粒子群算法的性能分析

下面我们将通过实验来说明粒子的探索能力 和算法的性能与参数之间的关系. 我们感兴趣的 参数区域为是 w ∈ [−1, 1], c1 + c2 ∈ [0, 8], 这也 是绝大多数的文献所研究的区域. 所有的实验都基 于以下 12 个常用的基准函数, 由于这些基准函数 被普遍应用, 在此只给出函数的名称, 即: Fun1: Sphere; Fun2: Rosenbrock; Fun3: Schwefel’ s P2.21; Fun4: Schwefel’s P2.22; Fun5: Schwefel’s P1.2; Fun6: Rastrigin; Fun7: Griewank; Fun8: Ackley; Fun9: Schwefel; Fun10: Weierstrass; Fun11: Penalized1; Fun12: Penalized2.

2 标准粒子群算法 (SPSO)

在粒子群算法中, 每个粒子代表寻优空间中一 个潜在的解, 有一个由被优化的函数决定的适应值. 在每一次迭代进化中, 粒子通过自身和群体的历史 最优位置更新当前的速度和位置. 在任意 t + 1 时 刻, 粒子群算法中第 i 个粒子第 d 维的速度和位置 更新公式为:

vid (t + 1) = wvid (t) + c1 r1d (t)(pid (t)− xid (t)) + c2 r2d (t)(pg d (t) − xid (t)) xid (t + 1) = xid (t) + vid (t + 1) (1) (2)

2

自

动

化

学

报

XX 卷

荐了一组固定和时变的参数值. 本文其余部分安排如下: 第 2 节先给出了标准 粒子群算法的形式; 第 3 节通过仿真实验研究了不 同参数对粒子探索能力、算法成功率和算法性能的 影响, 推荐了一组固定参数值; 第 4 节研究了算法中 的认知参数 c1 和社会参数 c2 的变化策略对算法性 能的影响, 并推荐了一组变参数的组合设定方式; 第 5 节基于 CEC2015 发布的 15 个基准函数进一步验 证了本文推荐的参数选取方法的有效性; 第 6 节讨 论了 PSO 算法在连续优化和离散优化方面的应用 问题; 第 7 节对全文进行了总结.

1 引言

粒 子 群 优 化 算 法 (Particle swarm optimization, PSO) 是由 Kennedy 和 Eberhart 于 1995 年 提出的一种群智能优化算法[1] , 源于对鸟群捕食行 为的研究.1998 年, Shi 和 Eberhart 在原始 PSO 中引入了惯性权重[2] , 后来被称为标准 PSO. 由于 PSO 结构简单, 易于实现, 且不需要借助问题的特 征信息, 已受到众多学者的关注, 在算法的性能改进 和分析方面不断取得新的成果[3,4] , 在多个领域得到 广泛应用[5] . 在 PSO 中, 有一些需要调节的参数: 种群规

3.1 参数对粒子探索能力的影响

粒 子 群算法 参数 w 和 c1 、c2 的 选 取 对算 法 的优化性能有很大的影响. 不同的参数组合下, 粒

子的轨迹形式是不同的, 决定了粒子探索能力的 大小. 在种群进化过程中的第 t 代, 若粒子能够 找到比 t − 1 代的全局最优解更好的解, 那么则 认为粒子具有一定的探索能力. 我们通过以下的 实 验 来 观 察 不 同 的 参 数 对 粒 子 探 索 能 力 的 影 响, 设 种 群 规 模 为 N , 为 每 个 粒 子 设 置 不 同 的 参 数, 设置变量 P numi 记录具有不同参数的粒子 i 在 进 化 的 过 程 中 超 越 上 一 代 的 全 局 最 优 解 的 次 数: P numi (t − 1) + 1, if f (p (t)) < f (p (t − 1)); i g 其 P numi (t) = P num ( t − 1) , i if f (p (t)) ≥ f (p (t − 1)). i g 中, t = 2, 3, ..., tmax . 我们将上面定义的 P numi 称为粒子 i 的第 t 代最优解超越次数, 它表征了粒子探索能力的大小. 显然, 探索能力大的粒子更有可能找到全局最优解. 对于所有的粒子设置相同参数的粒子群算法, 则所有的粒子在统计意义上具有相同的探索能力; 随着算法进化进程的推进, 拥有不同的状态的粒子 在当前迭代步则具有不同的探索能力; 被设置不同 参数的粒子, 一般则具有不同的探索能力. 这已得到 了作者们进行的大量仿真优化计算实例的证实. 图 1 为 4 组不同的 PSO 种群在优化函数 Sphere 时每 个粒子的 P num 值: 种群大小均为 50, 函数设置为 10 维, 最大迭代次数为 500, 每组种群运行 50 次, 记 录每个粒子 P num 值的平均值. 图 1(a) 为种群中粒 子设置为相同的参数时 (w = 0.6, c1 = c2 = 1.7) 每 个粒子的 P num 值; 图 1(b)、图 1(c) 和图 1(d) 为 种群中粒子设置不同参数时每个粒子的 P num 值, 其中图 1(b) 中, 第 1 个到第 50 个粒子的 w 值均为 0.6, c1 = c2 为 0.04:0.04:2; 图 1(c) 中, 第 1 个到第 50 个粒子的 c1 = c2 值均为 1.7, w = 0.6 分别为 0.02:0.02:1, 图 1(d) 中, 第 1 到第 10 个粒子的 w 均 为 0.2, c1 = c2 分别为 0.2:0.2:2, 第 11 到第 20 个粒 子的 w 均为 0.4, c1 = c2 分别为 0.2:0.2:2, 依此类 推, 第 41 到第 50 个粒子的 w 均为 1.0, c1 = c2 分 别为 0.2:0.2:2. 在 w ∈ [−1, 1], c1 + c2 ∈ [0, 8] 的参数区域上 对所用的 12 个基准函数进行蒙特卡罗实验. 每个 函数进行两组实验:(I): 种群中的个体取相同的 w, c1 = c2 则取不同的数值: 本组实验中, 根据种群参 数 w 的值分为 51 组子实验, w 的取值按 0.04 的 间隔从 -1 到 1, 每个子实验中, 种群大小均为 81, c1 = c2 按 0.05 的间隔从 0 到 4 取 81 个值分配给 不同的粒子, 函数运行 50 次, 记录不同粒子在 50 次 运行中的 P num 的平均值;(II): 种群中的个体取不 同的 w, 而 c1 = c2 取相同的固定值: 本组实验中, 根

其中, vid 和 xid 分别为粒子的速度和位置, w 为惯 性权值, c1 和 c2 称为加速因子, 分别为认知参数和 社会参数, pid 和 pgd 分别为个体和群体的历史最优 位置.r1d 和 r2d 为两个相互独立的服从 [0, 1] 之间 均匀分布的随机数, 正是这两个随机数的引入, 使得 算法的进化过程具有一定的不确定性, 也因此赋予 了算法一定的空间探索能力, 从而有利于找到问题 的最优解.

模 (种群的个体数目)N , 速度限值 Vmax , 位置限值 Xmax , 惯性权重 w, 加速因子 c1 和 c2 . 其中, w 、c1 和 c2 对算法性能的影响较大, 目前有很多学者对其 设定和调节方式进行了研究. 在参数选取方面, 文献 [6 − 9] 通过实验或理论分析, 推荐了一组固定参数 值. 在时变参数的调节方面, 对于惯性权重的调整, [2, 10] 提出了随迭代次数减小惯性权重, [11, 12] 给 出了随机惯性权重策略, [13 − 15] 根据种群的信息 自适应地调节惯性权重; 对于加速因子的调整, [16] 提出在迭代的过程中, c1 和 c2 线性递减, [17] 则提出 c1 线性递减、c2 线性递增, 18] 基于个体的更新信息 给出了一种 c1 和 c2 的自适应调整策略. 以上这些 参数的调整方法, 都在一定程度上提高了算法的性 能, 但是, 当涉及到时变参数时, 并没有考虑到惯性 权重和加速因子之间的配合作用. 单独依靠调整惯 性权重或加速因子, 并不能在种群的局部开发能力 (exploitation ability) 和全局探索能力 (exploration ability) 之间进行平衡. 事实上, 各个参数之间需要 相互配合, 才能够达到预定的效果. 本文考虑了各个 参数之间的配合, 基于在感兴趣的参数范围内进行 的优化测试实验数据, 通过定义最优解超越次数, 推

WANG Dong-feng1 MENG Li1 Abstract Inertia weight and acceleration factors have significant impact on performance of particle swarm optimization (PSO) algorithm. Through simulation experiments on twelve classical benchmark functions, this paper studies the exploitation ability and optimization performance with different parameters. Based on the experimental results, we recommend a setting for fixed parameters. Furthermore, we study the situation when inertia weight remains unchanged and acceleration factors change with iterations. Then a setting for varying parameter is recommended. The recommended parameters setting methods are verified through 15 benchmark functions that were published in CEC2015. At the end of the paper, the discussion of the PSO appilcation issue on continuous optimization problems and discrete optimization problems. Key words Particle swarm optimization, exploitation ability, optimization performance, parameter selection Citation Wang Dongfeng, Meng Li. Performance analysis and parameter selection of PSO algorithm. Acta Automatica Sinica, 2016, XX(X): X−X