距离度量学习

浅谈度量学习

浅谈度量学习本文主要介绍了一种常用的机器学习方法——度量学习。

度量学习旨在学得一个合适的距离来优化分类器的性能,提高分类器的效率。

本文對度量学习的基本概念做简介,并分析5E38见的度量学习形式和方法,最后讨论了一些度量学习研究中的前沿问题。

标签:度量学习一、度量学习简介在机器学习任务中,样本之间的距离是一个十分重要的因素,绝大多数机器学习模型和算法都直接或间接地使用了样本之间的距离。

比如,在常见的“K近邻”分类器中,样本间的距离很大程度上影响了最终分类效果的好坏[1]。

实际上,几乎所有分类算法都可以在某个特定的距离下等价于“近邻分类器”。

在机器学习任务中,我们也常常通过特征选择、特征提取等手段来对寻找数据更好的表示,或是达到降维的目的,而寻求数据更好的表示或降维最终是为了在得到的子空间中学习,这本质上就是基于子空间中的距离进行学习。

既然如此,我们完全可以直接寻找一个合适的距离,并利用这个学到的距离来完成各种任务。

可以说,各种特征选择、特征提取和表示学习方法都相当于是在做度量学习。

总而言之,度量学习的目的就是寻找一个合适的距离定义,使得在这种距离定义下,相似样本离得较近,而不相似样本离得较远,进而来优化某个机器学习任务。

距离往往用来衡量对象之间的相关性。

常见的距离有欧几里得距离、马氏距离[2]、余弦距离、曼哈顿距离等。

一般来讲,距离度量是一个二元函数,它需要满足四个条件:非负性、自反性、对称性和三角不等式。

若某个二元函数d 满足非负性、对称性和三角不等式,且,则称d为一个“伪距离度量”,它具有距离度量的大部分性质,也常用于机器学习任务。

二、基于马氏距离的度量学习为了能够学得一个合适的距离,首先必须将距离”参数化”,即使用某些参数来定义一个距离函数。

最常用的选择是“马氏距离”,它相当于考虑样本各个特征权重和特征间相关性的欧式距离,定义为:其中我们要求矩阵是一个半正定矩阵,即学到的马氏距离实际上是一个“伪度量”。

特征抽取中的度量学习方法介绍

特征抽取中的度量学习方法介绍特征抽取是机器学习中的重要环节,它能够从原始数据中提取出具有代表性的特征,为后续的分类、聚类等任务提供有力的支持。

而度量学习方法则是特征抽取中的一种重要技术,它通过学习一个度量函数,将原始数据映射到一个更加有意义的特征空间中,从而提高特征的判别能力和鲁棒性。

在度量学习方法中,最简单直观的方法是欧氏距离度量。

它假设特征空间中的每个维度都是独立、均匀分布的,通过计算样本之间的欧氏距离来度量它们之间的相似性。

然而,在实际应用中,欧氏距离度量往往难以满足复杂数据的分布特征,因此需要引入更加灵活的度量学习方法。

一种常用的度量学习方法是基于对比学习的方法。

对比学习是通过比较样本对之间的相似性来学习度量函数的方法。

其中,孪生网络是一种常用的对比学习模型。

它通过将两个相同结构的神经网络分别作用于两个样本,学习它们之间的相似性。

通过最小化同类样本对之间的距离,最大化异类样本对之间的距离,孪生网络能够学习到一个判别性的度量函数。

除了对比学习,还有一类度量学习方法是基于流形学习的方法。

流形学习是一种通过学习数据的低维流形结构来进行度量学习的方法。

它认为高维数据往往存在于一个低维流形上,通过学习流形的结构,可以更好地度量数据之间的相似性。

流形学习方法的典型代表是局部线性嵌入(Locally Linear Embedding,简称LLE)。

LLE通过保持样本之间的局部线性关系,学习到一个能够保持数据流形结构的度量函数。

此外,还有一类度量学习方法是基于核函数的方法。

核函数是一种能够将数据映射到一个高维特征空间中的函数。

通过学习一个核函数,可以将原始数据映射到一个更加有判别性的特征空间中,从而提高特征的判别能力。

支持向量机(Support Vector Machine,简称SVM)是一种常用的基于核函数的度量学习方法。

SVM通过最大化样本之间的间隔,学习到一个能够将样本分开的超平面,从而实现数据的分类。

基于余弦距离度量学习的伪K近邻文本分类算法

中 图 法 分 类 号 :TP 3 9 1 . 1 文 献 标 识 号 :A 文 章 编 号 :1 0 0 0 — 7 0 2 4( 2 0 1 3 )0 6 — 2 2 0 0 — 0 4

Ps e u d o — - K— — n e a r e s t n e i g h b o r t e x t c l a s s i f i c a t i o n a l g o r i t h m b a s e d

o n c o s i n e d i s t a n c e me t r i c l e a r n i n g

P ENG Ka i 。W ANG We i 。YANG YU — p u

( De p a r t me n t o f Au t o ma t i o n,S h a n g h a i J i a o t o n g Un i v e r s i t y,Ke y La b o r a t o r y o f S y s t e m Co n t r o l a n d

( 上 海 交通大 学 自动化 系 系统控 制 与信 息处理教 育部 重点 实验 室,上 海 2 1 0 0 Nhomakorabea0 0 )

摘 要 :距 离度量学 习在分类领域 有着广泛 的应 用,将其应用到文本分类时,由于一般采用的 向量 空间模 型 ( VS M)中的 T F*I D F算法在 对文本 向量表达 时向量均是维度相 同并且归一化 的,这就导致传统距 离度 量学习过 程 中采用 的欧式距 离作 为相似度判别标准在文本分类领域往往 无法取得预期 的效果 ,在距 离度量 学习 中的 L MNN算 法的启发 下提 出一种余 弦距

机器学习中距离和相似性度量方法

机器学习中距离和相似性度量方法距离和相似性度量是机器学习中一种重要的数学工具,用于衡量数据集中样本之间的相似性或差异。

在许多机器学习算法中,距离和相似性度量方法被广泛应用于分类、聚类、降维等任务中,帮助机器学习模型更好地理解和处理数据。

下面将介绍一些常见的距离和相似性度量方法。

1. 欧几里得距离(Euclidean distance):欧几里得距离是最常用的距离度量方法之一,用于计算两个向量之间的直线距离。

对于两个n维向量x和y,欧几里得距离可以表示为:d(x, y) = sqrt((x1-y1)^2 + (x2-y2)^2 + ... + (xn-yn)^2)2. 曼哈顿距离(Manhattan distance):曼哈顿距离是另一种常见的距离度量方法,用于计算两个向量之间的路径距离。

对于两个n维向量x和y,曼哈顿距离可以表示为:d(x, y) = ,x1-y1, + ,x2-y2, + ... + ,xn-yn3. 闵可夫斯基距离(Minkowski distance):闵可夫斯基距离是欧几里得距离和曼哈顿距离的推广,可以根据参数p的不同取值决定使用欧几里得距离还是曼哈顿距离。

对于两个n维向量x和y,闵可夫斯基距离可以表示为:d(x, y) = ((,x1-y1,^p) + (,x2-y2,^p) + ... + (,xn-yn,^p))^1/p4. 切比雪夫距离(Chebyshev distance):切比雪夫距离是曼哈顿距离的推广,用于计算两个向量之间的最大绝对差距。

对于两个n维向量x和y,切比雪夫距离可以表示为:d(x, y) = max(,x1-y1,, ,x2-y2,, ..., ,xn-yn,)5. 余弦相似度(Cosine similarity):余弦相似度是一种广泛用于文本和稀疏数据的相似性度量方法。

对于两个n维向量x和y,余弦相似度可以表示为:sim(x, y) = (x·y) / (,x,*,y,)其中,x·y表示向量x和y的点积,x,和,y,表示向量x和y的范数。

聚类算法中的距离度量方法

聚类算法中的距离度量方法聚类算法是一种将数据点分成不同集合的无监督学习方法。

在聚类过程中,其中一个最为重要的环节就是距离度量方法。

距离度量方法根据数据点之间的距离来衡量它们之间的相似程度,并根据此将它们分成不同的类别。

1. 欧式距离欧式距离,也称为L2范数,是最常用的距离度量方法之一。

欧式距离的计算公式为:$d(\boldsymbol{x},\boldsymbol{y})=\sqrt{\sum\limits_{i=1}^{n}( x_i-y_i)^2}$其中,$\boldsymbol{x}$和$\boldsymbol{y}$是两个点的n维特征向量。

欧式距离常常用于连续数据的聚类,如图像处理和数据挖掘中的图像和文本数据降维。

2. 曼哈顿距离曼哈顿距离也称为L1范数,它是指两个点在坐标系中沿着网格线移动所需的距离。

曼哈顿距离的计算公式为:$d(\boldsymbol{x},\boldsymbol{y})=\sum\limits_{i=1}^{n}\mid x_i-y_i\mid$曼哈顿距离常用于聚类分析中对分类特征的距离计算。

3. 余弦相似度余弦相似度是根据两个向量的夹角来测量它们的相似程度。

余弦相似度的计算公式为:$cos\theta=\frac{\boldsymbol{x}\cdot\boldsymbol{y}}{||\boldsymbol{x}||\cdot ||\boldsymbol{y}||}$其中,$\boldsymbol{x}$和$\boldsymbol{y}$是两个向量,$\boldsymbol{x}\cdot \boldsymbol{y}$是它们的点积。

余弦相似度通常用于文本聚类,因为在文本聚类中,每个文档可以表示为一个向量,使得在向量空间中,文档之间的夹角越小,它们之间越相似。

4. 编辑距离编辑距离是指从一个字符串转换成另一个字符串所需的最少操作次数。

编辑距离通常用于对字符串数据进行分类,例如对DNA序列进行分类。

机器学习中距离和相似度度量专业知识讲座

马式距离 本文档所提供的信息仅供参考之用,不能作为科学依据,请勿模仿。文档如有不 当之处,请联系本人或网站删除。

若协方差矩阵是单位矩阵(各个样本向量之间独立同分布), 则公式就成了:

则Xi与Xj之间的马氏距离等于他们的欧氏距离。 即:若协方差矩阵是对角矩阵,公式变成了标准化欧氏距离。

标准化欧氏距离是在假设数据各 个维度不相关的情况下,利用数 据分布的特性计算出不同的距离。 如果维度相互之间数据相关(例 如:身高较高的信息很有可能会 带来体重较重的信息,因为两者 是有关联的),就要用到马氏距 离

补本文充档:所欧提式供距的信离息和仅余供弦参相考之似用度,不能作为科学依据,请勿模仿。文档如有不

当之处,请联系本人或网站删除。

(1)欧氏距离从向量间的绝对距离区分差异,计算得到的相似度 值对向量各个维度内的数值特征非常敏感,而余弦夹角从向量间 的方向夹角区分差异,对向量各个维度内的数值特征不敏感,所 以同时修正了用户间可能存在的度量标准不统一的问题。 (2)余弦夹角的值域区间为[-1,1],相对于欧式距离的值域范围 [0,正无穷大],能够很好的对向量间的相似度值进行了量化。

(Adjusted Cosine Similarity)

虽然余弦相似度对个体间存在的偏见可以进行一定的修正,但 是因为只能分辨个体在维之间的差异,没法衡量每个维数值的 差异,会导致这样一个情况: 比如用户对内容评分,5分制。(此处是两个内容) X评分为(1,2),Y评分为(4,5),使用余弦相似度得出的结果是 0.98。两者极为相似,但从评 分上看X似乎不喜欢这2个内容, 而Y比较喜欢,余弦相似度对数值的不敏感导致了结果的误差。

Jaccard相似当系之处数,(请J联a系c本c人a或r网d站C删除o。efficient)

机器学习中的度量学习理论与方法研究

机器学习中的度量学习理论与方法研究机器学习是当今信息时代的重要领域之一,它涉及到大量的算法和模型。

在机器学习领域中,度量学习是一种非常重要的理论和方法,它为我们提供了一种有效的方式来评估和比较不同的数据。

本文将简要介绍度量学习在机器学习中的作用及其研究现状。

一、度量学习的定义与意义度量学习(metric learning)是一种机器学习方法,它致力于通过学习距离或相似度度量(metric或distance)来使数据具有更好的分类性能、聚类性能、回归性能等等。

度量学习的重要性在于它可以将不同特征之间的距离(或相似度)转化为可操作的数据。

具体来说,度量学习通过学习对距离度量矩阵的优化,为不同的数据提供了精细的度量方式。

而且,度量学习还可以结合监督和无监督学习技术来提高模型的泛化性能,同时降低模型的复杂性。

二、度量学习的分类在机器学习中,度量学习可以分为多种。

以下是度量学习的几种典型分类。

1、基于实例的度量学习基于实例的度量学习(instance-based distance metric learning)是一种无监督学习方法,它通过学习数据实例之间的距离来支持分类等任务。

在这种方法中,每个数据实例都被看作是一个独立的元素,而且它们之间的距离可以被用来解释不同的数据。

这种方法可以允许我们通过考虑不同实例之间的相似性来实现迁移学习和多任务学习等任务。

2、度量学习流形度量学习流形(metric learning on manifolds)是一种拓扑方法,它被用来捕获数据的内在结构和减少维度。

这种方法既可以通过监督学习来生成标记数据,也可以通过学习无标记数据来构造几何流形。

这种方法特别适用于处理图像、语音以及自然语言处理等任务。

3、核度量学习核度量学习(kernel metric learning)是一种数据驱动方法,它根据核函数的性质构建度量矩阵,并对不同的数据点进行距离计算。

这种方法优点在于它能够灵活地选择核函数,同时避免了数据高维度问题,从而具有较好的性能和效率。

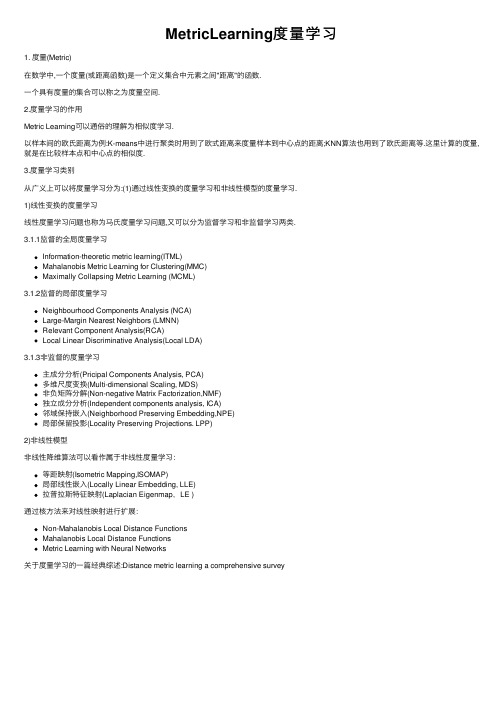

MetricLearning度量学习

MetricLearning度量学习1. 度量(Metric)在数学中,⼀个度量(或距离函数)是⼀个定义集合中元素之间"距离"的函数.⼀个具有度量的集合可以称之为度量空间.2.度量学习的作⽤Metric Learning可以通俗的理解为相似度学习.以样本间的欧⽒距离为例:K-means中进⾏聚类时⽤到了欧式距离来度量样本到中⼼点的距离;KNN算法也⽤到了欧⽒距离等.这⾥计算的度量,就是在⽐较样本点和中⼼点的相似度.3.度量学习类别从⼴义上可以将度量学习分为:(1)通过线性变换的度量学习和⾮线性模型的度量学习.1)线性变换的度量学习线性度量学习问题也称为马⽒度量学习问题,⼜可以分为监督学习和⾮监督学习两类.3.1.1监督的全局度量学习Information-theoretic metric learning(ITML)Mahalanobis Metric Learning for Clustering(MMC)Maximally Collapsing Metric Learning (MCML)3.1.2监督的局部度量学习Neighbourhood Components Analysis (NCA)Large-Margin Nearest Neighbors (LMNN)Relevant Component Analysis(RCA)Local Linear Discriminative Analysis(Local LDA)3.1.3⾮监督的度量学习主成分分析(Pricipal Components Analysis, PCA)多维尺度变换(Multi-dimensional Scaling, MDS)⾮负矩阵分解(Non-negative Matrix Factorization,NMF)独⽴成分分析(Independent components analysis, ICA)邻域保持嵌⼊(Neighborhood Preserving Embedding,NPE)局部保留投影(Locality Preserving Projections. LPP)2)⾮线性模型⾮线性降维算法可以看作属于⾮线性度量学习:等距映射(Isometric Mapping,ISOMAP)局部线性嵌⼊(Locally Linear Embedding, LLE)拉普拉斯特征映射(Laplacian Eigenmap,LE )通过核⽅法来对线性映射进⾏扩展:Non-Mahalanobis Local Distance FunctionsMahalanobis Local Distance FunctionsMetric Learning with Neural Networks关于度量学习的⼀篇经典综述:Distance metric learning a comprehensive survey。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2

常见度量

1.欧式距离

2 ( x y ) i i i 1 n

d 2 ( x, y )

以向量表示:

d 2 ( x, y ) ( x y )T ( x y )

பைடு நூலகம்

2.余弦距离

cos

x y x 2 y

2

3

马氏距离(Mahalanobis Distance)

d M ( x) ( x )T 1 ( x )

对于变量x和y之间的马氏距离:

d M ( x, y ) ( x y )T M( x y )

M是半正定矩阵

d M ( x, y ) ( x y )T 1 ( x y )

当协方差矩阵为单位矩阵时,马氏距离就简化为欧氏距离

4

度量学习

d M ( x, y ) ( x y )T M( x y )

转换后

示例2 1

6

Probablistic Global Distance Metric Learning

PGDM:《Distance metric learning, with application to clustering with side-information》 监督距离度量学习

问题定义为:

min ( x , x

M

i

j )S

xi x j

2 M

2 M

s.t. ( x , x

i

j )D

xi x j

c

带条件的凸优化问题

求解的是全局距离度量

M 半正定

7

PGDM

等价问题:

g ( M ) max ( x , x

M

i i

j

)D

xi x j xi x j

2 M 2 M

s.t.(1)C1 : f ( M ) ( x , x

j

)S

c

(2)C2 : M 半正定

缺点: 时间复杂度高

8

PGDM

Frobenius范数

C1 : f (M ) ( x , x )S xi x j

i j

2 M

c

M

F

i

2 M ij j

解决:带线性条件的二次方程式优化问题

C2 : M 半正定

解决:先对M进行对角化, M X T X

得到 '

M ' XT' X

9

谢谢!

10

Distance Metric Learning

学院:网研院 姓名:陈刚 学号:2015010285

1

度量

定义在集合的元素之间的距离的函数,称为距离函数,简称“距离”

基于对象之间的相似度的应用: 聚类分析(k-means) 多维缩放(multidimensional scaling) 局部敏感哈希(Locality-Sensitive Hashing) 需要样本间的相似性度量,即距离度量

d 2 ( x, y) f ( y) f ( x) ( y x)T f ( x) ( y x)T 2 f ( x)( y x)

f ( x) d ( x, x)2 0

d 2 ( x, y) ( y x)T 2 f ( x)( y x)

5

举例说明

原始数据