非线性回归预测法——高斯牛顿法(詹学朋)

梯度下降 高斯牛顿

梯度下降和高斯牛顿是机器学习和优化领域常用的两种优化方法。

梯度下降是一种常用的一阶优化算法,可以用于求解目标函数的最小值。

它通过计算目标函数在当前参数下的梯度(即指向最大增长方向的向量)并沿着梯度的反方向迭代更新参数,直到收敛达到最小值。

高斯牛顿法是一种基于牛顿法的优化算法,利用目标函数的一阶和二阶导数信息来更快地寻找最小值。

它通过计算目标函数在当前参数下的梯度和海森矩阵(即二阶导数)来更新参数,直到收敛达到最小值。

相比于梯度下降,高斯牛顿法通常更快地收敛,但要求目标函数的二阶导数可计算和海森矩阵可逆。

在实际应用中,梯度下降通常适用于目标函数的梯度容易计算的场合,而高斯牛顿法则适用于目标函数参数较少、目标函数相对平滑、并且具有较快的收敛速度的场合。

高斯牛顿法

高斯牛顿法编程及实践报告班级:地物11101成员:王云鹤吴迪杨寒张林涛一.小组简介本组成员:王云鹤,吴迪,杨寒,张林涛杨寒,张林涛负责讨论方法原理及编程思路王云鹤负责编程吴迪负责整理并编写报告二.方法原理曲线拟合的目标函数自动反演的主要方法是曲线拟合,即寻找一个模型的理论曲线,使其与实测曲线现在均方差极小意义下重合得最好。

在大地电磁测深资料一维解释中,研究的对象时水平层状地电模型。

设有k 层,就有n=2k-1个参数,即各层的电阻率和厚度,记为列向量形式: λ⃑ =[λ1,λ2,…λn ]T 实际观测数为m 个,是对应不同周期的视电阻率值,也记为列向量形式:ρa ⃑⃑⃑⃑ =[ρa1,ρa2,…ρam ]T一般情况下m>n 。

各周期的理论视电阻率值是模型参数的 λ⃑ 函数,记为:ρc ⃑⃑⃑ =[ρc1(λ⃑ ),ρc2(λ⃑ ),…ρcm (λ⃑ )]T 层状模型理论值与观测值之间拟合的判断依据一般是取目标函数:F( λ⃑ )= ∑(ρai −ρci )2m i=1=∑f i z ( λ⃑ )=‖ f ( λ⃑ )‖2=极小m i=1 (3-1)设 λ0⃑⃑⃑ 为初始参数列向量,f i ( λ⃑ )= f i (λ0⃑⃑⃑ )+[∇f i (λ0⃑⃑⃑ )]ς·Δλ⃑⃑⃑⃑ ,其中:Δλ⃑⃑⃑⃑ = λ⃑ −λ0⃑⃑⃑ ; ∇f i (λ0⃑⃑⃑ )=[∂f 1( λ⃑ )∂λ1,…,∂f i ( λ⃑ )∂λi ]λ⃑ =λ0⃑⃑⃑⃑ T , i=1,2,…,m将上式写成矩阵形式为f ( λ⃑ )=f 0⃑⃑ −A 0△λ⃑ (3-2) 式中 f 0⃑⃑ =f (λ0⃑⃑⃑ )=ρ0⃑⃑⃑⃑ −ρ⃑ (λ0⃑⃑⃑ )=∆ρ0⃑⃑⃑⃑A0=[a ij]=[−∂f i( λ⃑)∂λi]λ⃑=λ0⃑⃑⃑⃑=[−∂ρi( λ⃑)∂λi]λ⃑=λ0⃑⃑⃑⃑i = 1,2,…,m; j=1,2,…,n这样,利用式(3-2)将式(3-1)化为:‖∆ρ0⃑⃑⃑⃑ −A0Δλ⃑⃑⃑⃑ ‖2=极小 (3-3)根据函数的极值条件,可得如下方程组:A0T A0Δλ⃑⃑⃑⃑ −A0T∆ρ0⃑⃑⃑⃑ =0 (3-4)如果矩阵A0T A0满秩,则方程组(3-4)有唯一解Δλ⃑⃑⃑⃑ =(A0T A0)−1A0T∆ρ0⃑⃑⃑⃑ 令λ1⃑⃑⃑ =λ0⃑⃑⃑ +Δλ⃑⃑⃑⃑ ,λ1⃑⃑⃑ 便是解的首次近似,然后重复迭代,知道符合要求为止。

非线性最小二乘数据拟合高斯-牛顿法ppt课件.ppt

程序及做法:

function y=xzz(x); y(1)=x(1)+2 * x(2)+x(3); y(2)=2 * x(1)+2 * x(2)+3 * x(3)-3; y(3)=-x(1)-3 * x(2)-2; y=[y(1) y(2) y(3)]; x0=[1 1 1]; [x,fva1,exitflag,output]=fsolve(′xzz′,x0)

篮球比赛是根据运动队在规定的比赛 时间里 得分多 少来决 定胜负 的,因 此,篮 球比赛 的计时 计分系 统是一 种得分 类型的 系统Fra bibliotek2 解线性方程组

• MATLAB用函数linsolve求解线性方程组 Ax=b,要求A的列数等于b的行数;也可用 矩阵除等方法求解。linsolve的语法格式为

• x=linsolve(A,b)

篮球比赛是根据运动队在规定的比赛 时间里 得分多 少来决 定胜负 的,因 此,篮 球比赛 的计时 计分系 统是一 种得分 类型的 系统

[1/2/a * (-g+(g ^ 2-4 * 2 * c) ^ (1/2))]

[1/2/a * (-g+(g ^ 2+4 * 2 * c) ^ (1/2))] 类似地,solve (′2 * x ^ 2+6 * x+4′)

得 ans=[-2][-1]

g=a * x

篮球比赛是根据运动队在规定的比赛 时间里 得分多 少来决 定胜负 的,因 此,篮 球比赛 的计时 计分系 统是一 种得分 类型的 系统

补充知识 :解方程或方程组

用solve 符号解代数方程 solve (′eq1′,′eq2′, ′eqn′, ′var1,var2,…,varn′) eqn为符与方程,varn为符号变量。

非线性回归 方法

非线性回归方法非线性回归是机器学习中的一种重要方法,用于建立输入和输出之间的非线性关系模型。

线性回归假设输入和输出之间存在线性关系,而非线性回归则允许更复杂的模型形式,可以更好地适应现实世界中的复杂数据。

下面将介绍几种常见的非线性回归方法,并说明它们的原理、应用场景和优缺点。

1. 多项式回归多项式回归通过引入高次多项式来拟合数据。

例如,在一元情况下,一阶多项式即为线性回归,二阶多项式即为二次曲线拟合,三阶多项式即为三次曲线拟合,依此类推。

多项式回归在数据不规则变化的情况下能够提供相对灵活的拟合能力,但随着多项式次数的增加,模型的复杂度也会增加,容易出现过拟合问题。

2. 非参数回归非参数回归方法直接从数据中学习模型的形式,并不对模型的形式做出先验假设。

常见的非参数回归方法包括局部加权回归(LWLR)、核回归(Kernel Regression)等。

局部加权回归通过给予离目标点较近的样本更大的权重来进行回归,从而更注重对于特定区域的拟合能力。

核回归使用核函数对每个样本进行加权,相当于在每个样本周围放置一个核函数,并将它们叠加起来作为最终的拟合函数。

非参数回归方法的优点是具有较强的灵活性,可以适应各种不同形状的数据分布,但计算复杂度较高。

3. 支持向量回归(SVR)支持向量回归是一种基于支持向量机的非线性回归方法。

它通过寻找一个超平面,使得样本点离该超平面的距离最小,并且在一定的松弛度下允许一些样本点离超平面的距离在一定范围内。

SVR通过引入核函数,能够有效地处理高维特征空间和非线性关系。

SVR的优点是对异常点的鲁棒性较好,并且可以很好地处理小样本问题,但在处理大规模数据集时计算开销较大。

4. 决策树回归决策树回归使用决策树来进行回归问题的建模。

决策树将输入空间划分为多个子空间,并在每个子空间上拟合一个线性模型。

决策树能够处理离散特征和连续特征,并且对异常点相对较鲁棒。

决策树回归的缺点是容易过拟合,因此需要采取剪枝等策略进行降低模型复杂度。

非线性方程的数值求法牛顿迭代法和弦截法PPT课件

26

Newton下山法

原理:若由 xk 得到的 xk+1 不能使 | f | 减小,则在 xk 和 xk+1 之 间找一个更好的点 xk1,使得 f ( xk1) f ( xk ) 。

xk

xk+1

xk1 (1 )xk , [0, 1]

xk 1

[xk

)g( xn

)

n1

n

mng(xn ) mg( xn ) n g(

xn

)

n2 g( xn )

mg( xn ) n g( xn )

n1

2 n

g( xn )

mg( xn ) n g( xn )

若 xn 收敛,即

n 0 (n ),

没有具体的描述,而且若x0 的值没有取好,有可 能得不到收敛的结果。

以下定理,给出了 f x 满足一定的条件时,要使得牛顿

迭代法收敛,x0 应满足什么条件。

又 f ( ) 0

( ) 0 1,

牛顿迭代法局部收敛于

又 ( ) 0

即有:牛顿迭代法具有二阶(平方)收敛速度。

注. 定理要求 x0 充分接近 (局部收敛),充分的程度

没有具体的描述,而且若x0 的值没有取好,有可 能得不到收敛的结果。

以下定理,给出了 f x 满足一定的条件时,要使得牛顿

迭代法收敛,x0 应满足什么条件。

定理 设 f x 在区间 a,b 上的二阶导数存在,且满足: ① f (a) f (b) 0; (保证 a, b中至少存在一个根)

若 xn 收敛,即 n 0 (n )

lim n1 lim[1

非线性回归预测法——高斯牛顿法(詹学朋)

非线性回归预测法前面所研究的回归模型,我们假定自变量与因变量之间的关系是线性的,但社会经济现象是极其复杂的,有时各因素之间的关系不一定是线性的,而可能存在某种非线性关系,这时,就必须建立非线性回归模型。

一、非线性回归模型的概念及其分类非线性回归模型,是指用于经济预测的模型是曲线型的。

常见的非线性回归模型有下列几种: (1)双曲线模型:i ii x y εββ++=121 (3-59) (2)二次曲线模型:i i i i x x y εβββ+++=2321 (3-60)(3)对数模型:i i i x y εββ++=ln 21 (3-61)(4)三角函数模型:i i i x y εββ++=sin 21 (3-62)(5)指数模型:i x i i ab y ε+= (3-63)i i i x x i e y εβββ+++=221110 (3-64)(6)幂函数模型:i b i i ax y ε+= (3-65)(7)罗吉斯曲线:i x x i iie e y εββββ++=++1101101 (3-66)(8)修正指数增长曲线:i x i i br a y ε++= (3-67)根据非线性回归模型线性化的不同性质,上述模型一般可细分成三种类型。

第一类:直接换元型。

这类非线性回归模型通过简单的变量换元可直接化为线性回归模型,如:(3-59)、(3-60)、(3-61)、(3-62)式。

由于这类模型的因变量没有变形,所以可以直接采用最小平方法估计回归系数并进行检验和预测。

第二类:间接代换型。

这类非线性回归模型经常通过对数变形的代换间接地化为线性回归模型,如:(3-63)、(3-64)、(3-65)式。

由于这类模型在对数变形代换过程中改变了因变量的形态,使得变形后模型的最小平方估计失去了原模型的残差平方和为最小的意义,从而估计不到原模型的最佳回归系数,造成回归模型与原数列之间的较大偏差。

第三类:非线性型。

高斯—牛顿迭代法

高斯牛顿法高斯—牛顿迭代法的基本思想是使用泰勒级数展开式去近似地代替非线性回归模型,然后通过多次迭代,多次修正回归系数,使回归系数不断逼近非线性回归模型的最佳回归系数,最后使原模型的残差平方和达到最小。

高斯—牛顿法的一般步骤为:(1)初始值的选择。

其方法有三种,一是根据以往的经验选定初始值;二是用分段法求出初始值;三是对于可线性化的非线性回归模型,通过线性变换,然后施行最小平方法求出初始值。

(2)泰勒级数展开式。

设非线性回归模型为:i=1,2,…,n (3-68)其中r为待估回归系数,误差项~N(0, ),设:,为待估回归系数的初始值,将(3-68)式在g点附近作泰勒展开,并略去非线性回归模型的二阶及二阶以上的偏导数项,得(3-69)将(3-69)式代入(3-68)式,则移项:令:则:i=1,2,…,n用矩阵形式表示,上式则为:(3-70)其中:(3)估计修正因子。

用最小平方法对(3-70)式估计修正因子B,则:(3-71)设g为第一次迭代值,则:(4)精确度的检验。

设残差平方和为:,S为重复迭代次数,对于给定的允许误差率K,当时,则停止迭代;否则,对(3-71)式作下一次迭代。

(5)重复迭代。

重复(3-71)式,当重复迭代S次时,则有:修正因子:第(S+1)次迭代值:四、应用举例设12个同类企业的月产量与单位成本的资料如下表:表3-9 间接代换法计算表企业编号单位产品成本(元)月产量1 2 3 4 5 6 7 8 91011121601511141288591757666606160101620253136404551566065(注:资料来源《社会经济统计学原理教科书》第435页)试配合适当的回归模型分析月产量与单位产品成本之间的关系。

解:(1)回归模型与初始值的选择。

根据资料散点图的识别,本数据应配合指数模型:对指数模型两边取对数,化指数模型为线性回归模型,然后施行最小平方法求出初始值。

即:则上述指数模型变为:对分别求反对数,得,带入原模型,得回归模型:高斯—牛顿迭代法初始回归模型:残差平方和:(2)泰勒级数展开式。

非线性回归模型的优化算法

非线性回归模型的优化算法随着机器学习算法的广泛应用,非线性回归模型的优化算法也越来越受到研究者们的关注。

非线性回归模型是机器学习中常用的一种模型,例如神经网络、支持向量回归、决策树等模型都属于非线性回归模型。

而优化算法则是对这些模型进行求解的关键。

这篇文章将从非线性回归模型的定义、应用及优化算法的进展和现状等方面进行探讨。

一、非线性回归模型的定义及应用非线性回归模型是指因变量和自变量之间的关系不是线性的回归模型。

与线性回归模型不同的是,非线性回归模型不能使用最小二乘法进行拟合,需要使用其他的优化算法,例如牛顿法、拟牛顿法、共轭梯度法、遗传算法等。

非线性回归模型在很多领域都有广泛的应用,例如金融行业中的股价预测、医学领域中的疾病诊断、自然语言处理领域中的语音识别等。

二、非线性回归模型优化算法的进展和现状1. 牛顿法牛顿法是求解非线性方程组的一种方法。

在非线性回归模型中,利用牛顿法求解参数的方法称为牛顿法拟合。

牛顿法的优点在于收敛速度快,但它需要计算海森矩阵,计算量较大。

此外,当海森矩阵不可逆或者为负定矩阵时,牛顿法可能出现无法收敛的问题。

因此,在实际应用中,牛顿法需要根据具体情况进行选择。

2. 拟牛顿法拟牛顿法是指用数值求导或解析求导的方式来代替海森矩阵,从而减少计算量的方法。

拟牛顿法常用的算法包括DFP算法和BFGS算法。

拟牛顿法方法具有快速收敛,适用于大规模数据集,但是它的计算量也较大,需要进行多次迭代。

3. 共轭梯度法共轭梯度法是求解线性方程组的一种方法,也可以用来求解非线性回归模型中的参数。

共轭梯度法对计算机内存的需求较小,算法针对对称矩阵,迭代次数比牛顿法少。

但是,共轭梯度法的缺点在于对非对称矩阵的处理较差。

4. 遗传算法遗传算法是借鉴生物遗传进化的原理,使用基因编码和遗传操作进行搜索和优化的一种算法。

在非线性回归模型中,遗传算法可以用来搜索参数空间,从而得到最优解。

遗传算法的优点在于搜素范围广,具有较好的全局优化能力,但是计算量较大,需要进行多次迭代。

非线性方程的求解和分析

非线性方程的求解和分析近年来,随着科技的飞速发展,各个领域中越来越多的问题需要用到求解非线性方程的方法。

这些非线性方程指的是方程中包含有一个或多个未知数的嵌套函数的方程。

解非线性方程是现代数学、物理和工程等领域中获得解析解的一个重要问题。

本文将讨论非线性方程的求解和分析方法。

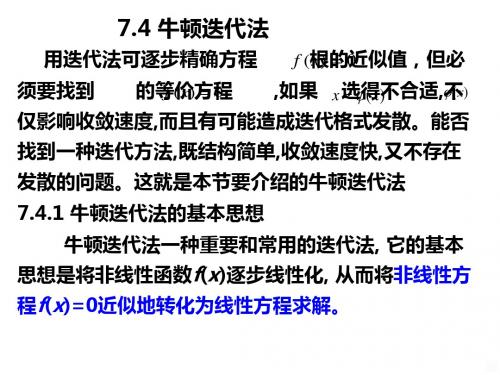

一、牛顿迭代法牛顿迭代法是一种求解非线性方程的基本方法。

它的原理是利用函数的导数逼近函数的根。

其算法如下:(1) 选一个初始值 $x_0$(2) 迭代公式: $x_{n+1} = x_n-\dfrac{f(x_n)}{f'(x_n)}$其中,$f(x)$ 为非线性方程, $f'(x)$ 表示 $f(x)$ 在 $x$ 处的导数。

(3) 若 $|f(x_{n+1})|<\epsilon$($\epsilon$ 为给定的精度),则停止计算,$x_{n+1}$ 为 $f(x)=0$ 的一个近似解。

否则,令$n=n+1$,返回第(2)步进行迭代。

值得注意的是,在实际计算中,可能存在导数 $f'(x_n)$ 为零,或者非线性函数的导数求解过于复杂的情况。

对于这些问题,可以使用牛顿迭代法的改进方法来解决。

二、牛顿-拉夫逊法牛顿-拉夫逊法是一种解决在牛顿迭代法中遇到的问题的改良方法之一。

它通过在公式中引入一个阻尼系数 $\lambda$ 来避免除以零和产生振荡。

公式如下:$x_{n+1}=x_n-\dfrac{f(x_n)}{f'(x_n)+\lambda f''(x_n)}$其中,$f''(x)$ 表示 $f(x)$ 的二阶导数。

通过引入阻尼系数,可以避免迭代过程中 $f'(x)$ 零点附近的振荡,并且当 $f'(x)$ 接近零时,阻尼系数会变得更大,以减小振荡的影响。

三、拟牛顿法拟牛顿法(Quasi-Newton Method)是一种利用 Broyden-Fletcher-Goldfarb-Shanno(BFGS)公式来近似牛顿法中的 Hessian 矩阵的方法。

GaussNewton

李智迅

1

1.1 牛顿迭代法

预备知识

牛顿法是一种求解方程f (x) = 0的方法。 多数方程不存在求根公式,从而求精确根非常困难,甚 至不可能,从而寻找方程的近似根就显得特别重要。 迭代法是用某个固定公式反复地计算,用以校正 方程所得根的近似值,使之逐步精确化,最后得到的精度要求的结果。 牛顿迭代法是用切线来逼近零点的,收敛的速度很快,但要求的条件也高。 首先要有一个区间, 在这个区间的端点函数值反向,其次第一次迭代点不能随意取,否则第一次迭代后的点可能跑出原先 的区间,收敛性就不一定能保证了(即有的情况也能有收敛性,有的情况就没有收敛性了,全看函数 的性能) 。 比如:设r是f (x) = 0的根,选取x0 作为r初始近似值,过点(x0 , f (x0 ))做曲线y = f (x)的切线L, L的方程为y = f (x0 ) + f ′ (x0 )(x − x0 ),求出L与x轴交点的横坐标x1 = x0 − f (x0 )/f ′ (x0 ), 称x1 为r的一次 近似值,过点(x1 , f (x1 ))做曲线y = f (x)的切线,并求该切线与x轴的横坐标x2 = x1 − f (x1 )/f ′ (x1 )称x2 为r的二次近似值,重复以上过程,得r 的近似值序列Xn ,其中Xn+1 =Xn −f (Xn )/f ′ (Xn ),称为r的n+1次 近似值。上式称为牛顿迭代公式。以f (x) = 2x3 − 4x2 + 3x − 6为例: #include<stdio.h> #include <math.h> //包含这个头文件,后面使用fabs void main() { double x=1.5,y,y1; do { y=2*x*x*x-4*x*x+3*x-6; y1=6*x*x-8*x+3; x=x-y/y1; } while(fabs(y/y1)>1e-6);// 是y/y1,不是y printf("%f",x); }

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

非线性回归预测法前面所研究的回归模型,我们假定自变量与因变量之间的关系是线性的,但社会经济现象是极其复杂的,有时各因素之间的关系不一定是线性的,而可能存在某种非线性关系,这时,就必须建立非线性回归模型。

一、非线性回归模型的概念及其分类非线性回归模型,是指用于经济预测的模型是曲线型的。

常见的非线性回归模型有下列几种: (1)双曲线模型:i ii x y εββ++=121 (3-59) (2)二次曲线模型:i i i i x x y εβββ+++=2321 (3-60)(3)对数模型:i i i x y εββ++=ln 21 (3-61)(4)三角函数模型:i i i x y εββ++=sin 21 (3-62)(5)指数模型:i x i i ab y ε+= (3-63)i i i x x i e y εβββ+++=221110 (3-64)(6)幂函数模型:i b i i ax y ε+= (3-65)(7)罗吉斯曲线:i x x i iie e y εββββ++=++1101101 (3-66)(8)修正指数增长曲线:i x i i br a y ε++= (3-67)根据非线性回归模型线性化的不同性质,上述模型一般可细分成三种类型。

第一类:直接换元型。

这类非线性回归模型通过简单的变量换元可直接化为线性回归模型,如:(3-59)、(3-60)、(3-61)、(3-62)式。

由于这类模型的因变量没有变形,所以可以直接采用最小平方法估计回归系数并进行检验和预测。

第二类:间接代换型。

这类非线性回归模型经常通过对数变形的代换间接地化为线性回归模型,如:(3-63)、(3-64)、(3-65)式。

由于这类模型在对数变形代换过程中改变了因变量的形态,使得变形后模型的最小平方估计失去了原模型的残差平方和为最小的意义,从而估计不到原模型的最佳回归系数,造成回归模型与原数列之间的较大偏差。

第三类:非线性型。

这类非线性回归模型属于不可线性化的非线性回归模型,如:(3-66)和(3-67)式。

第一类和第二类非线性回归模型相对于第三类,又称为可线性化的非线性回归模型。

本节重点研究第一类和第二类即可线性化的非线性回归模型。

二、可线性化的非线性回归模型的模型变换及参数估计 1.直接换元法换元过程和参数估计方法,如表3-6所示。

例设某商店1991~2000年的商品流通费用率和商品零售额资料如下表:表3-7 直接换元法计算表根据上述资料,配合适当的回归模型分析商品零售额与流通费用率的关系,若2001年该商店商品零售额将为36.33万元,对2001年的商品流通费用额作出预测。

解:(1)绘制散点图(图略)。

从图中可清楚看到:随着商品零售额的增加,流通费用率有不断下降的趋势,呈双曲线形状。

(2)建立双曲线模型。

i ii x y εββ++=121 令 i i x x 1'=得 i i i x y εββ++='21(3)估计参数。

Eviews4.0 软件,hzz -暴P92表3-7得回归模型为:ii x y 17610.425680.2+=∧2.间接代换法代换过程和参数估计方法如(暴经济预测P96)表3-8所示。

三、高斯—牛顿迭代法高斯—牛顿迭代法的基本思想是使用泰勒级数展开式去近似地代替非线性回归模型,然后通过多次迭代,多次修正回归系数,使回归系数不断逼近非线性回归模型的最佳回归系数,最后使原模型的残差平方和达到最小。

高斯—牛顿法的一般步骤为: (1)初始值的选择。

其方法有三种,一是根据以往的经验选定初始值;二是用分段法求出初始值;三是对于可线性化的非线性回归模型,通过线性变换,然后施行最小平方法求出初始值。

(2)泰勒级数展开式。

设非线性回归模型为:i i i r x f y ε+=),( i=1,2,…,n (3-68)其中r 为待估回归系数,误差项 i ε~N(0, 2σ),设:')0(1)0(1)0(00),,(-=p g g g g Λ,为待估回归系数'110),,(-=p r r r r Λ的初始值,将(3-68)式),(r x f i 在g 0点附近作泰勒展开,并略去非线性回归模型的二阶及二阶以上的偏导数项,得())0(10)0()0(),(),(),(kkgr p k k i i i g rr r x f g x f r x f -⎥⎦⎤⎢⎣⎡∂∂+≈=-=∑ (3-69) 将(3-69)式代入(3-68)式,则()i k kgr p k k i i i g r r r x f g x f y ε+-⎥⎦⎤⎢⎣⎡∂∂+≈=-=∑)0(10)0()0(),(),(移项:()i k kgr p k k i i i g rr r x f g x f y ε+-⎥⎦⎤⎢⎣⎡∂∂≈-=-=∑)0(10)0()0(),(),(令:)0()0()0()0()0()0(),(),(kk k g r k i ik i i i g r r r x f D g x f y y -=⎥⎦⎤⎢⎣⎡∂∂=-==β 则:i k p k ik iD yεβ+≈∑-=)0(1)0()0( i=1,2,…,n 用矩阵形式表示,上式则为:ε+≈)0()0()0(B D Y (3-70)其中:⎪⎪⎪⎪⎭⎫ ⎝⎛=⎪⎪⎪⎪⎭⎫ ⎝⎛=⎪⎪⎪⎭⎫⎝⎛--=-⨯--⨯⨯)0(1)0(0)0(1)0(1)0(0)0(11)0(10)0()0()0(11)0(1),(),(p p npn p p n n n n B D D D D D g x f y g x f y Y ββM ΛMΛM(3)估计修正因子。

用最小平方法对(3-70)式估计修正因子B (0),则:())0()0(1)0()0()0(''Y D D D b-= (3-71)设g (1)为第一次迭代值,则:)0()0()1(b g g+=(4)精确度的检验。

设残差平方和为:[]21)()0(),(∑=-=ni s i i g x f y SSR ,S 为重复迭代次数,对于给定的允许误差率K ,当k SSR SSR SSR s s s ≤--)()1()(时,则停止迭代;否则,对(3-71)式作下一次迭代。

(5)重复迭代。

重复(3-71)式,当重复迭代S 次时,则有: 修正因子:())()(1)()()(''s s s s s Y D D D b -=第(S+1)次迭代值:)()()1(s s s b g g +=+四、应用举例设12个同类企业的月产量与单位成本的资料如下表:表3-9 间接代换法计算表(注:资料来源《社会经济统计学原理教科书》第435页)试配合适当的回归模型分析月产量与单位产品成本之间的关系。

解:(1)回归模型与初始值的选择。

根据资料散点图的识别,本数据应配合指数模型:i x i ab y =∧对指数模型两边取对数,化指数模型为线性回归模型,然后施行最小平方法求出初始值。

即:b b a a y y bx a y i ii i lg ,lg ,lg lg lg lg '''===+=∧∧∧令:则上述指数模型变为:i ix b a y '''+=∧ i i x y 00831.026109.2'-=∧ 对'',b a 分别求反对数,得182.43,0.981a b ==,带入原模型, 得回归模型:i xi y 981.043.182⨯=∧高斯—牛顿迭代法初始回归模型:(0)(,)182.430.981i xi f x g =⨯残差平方和:(0)(0)2((,))1124.1526i i SSRy f x g =-=∑(2)泰勒级数展开式。

先对指数模型 i xi ab y =∧中的a 和b 分别求偏导数。

0000.981ii a a b b x x i a a b b y b a ==∧==∂==∂11000182.43**0.981i i a a b b x x i a a i i b b y ax b x b--==∧==∂==∂然后用泰勒级数展开指数模型,移项整理得(注:参见(3-69)、(3-70)式):(0)Y(0)D(0)B160-150.5866 0.82545 1535.0316 151-134.2148 0.73571 2189.0282 114-124.3015 0.68137 2534.1796 128-112.9332 0.61905 2878.011085-100.6550 0.55175 3180.7400 a (0)91- 91.4493 = 0.50128 3355.9387 75- 84.6948 0.46246 3453.405276- 76.9488 0.42180 3529.7593 b (0) 66- 68.5829 0.37594 3565.4701 60- 62.3104 0.34156 3556.9658 61- 57.7081 0.31633 3529.5468 60- 52.4302 0.28740 3473.9702(3-72)(3)估计修正因子。

解(3-72)式矩阵,得:a (0)12.09660288=b (0)-0.00180342第一次迭代值:a 1 a 0 a (0)194.5266= + =b 1 b 0 b (0)0.9792第一次迭代回归模型:(1)(,)194.52660.9792i xi f x g =⨯(4)精确度的检验。

残差平方和:(1)(1)2((,))999.4077i i SSR y f x g =-=∑给定误差率K=10-3,则:(1)(0)(1)1124.152610.12482999.4077SSR SSR k SSR -=-=>作下一次迭代。

(5)重复迭代。

将 a 1 代入(3-71)式作第二次迭代。

得估计修正因子:b 1a (1)0.647654043=b (1)-0.000066948第二次迭代值:a 2 a 1 a (1)195.1743= + =b 2 b 1 b (1)0.9791第二次迭代回归模型:(2)(,)195.17430.9791i xi f x g =⨯残差平方和:(2)(2)2((,))999.1241i iSSR yf xg =-=∑ 误差率:(2)(1)(2)999.407710.00028999.1241SSR SSR k SSR -=-=<误差率达到要求,停止迭代。

表3-10计算结果比较从上表可看出:高斯—牛顿迭代法具有收敛快,精确度高的优点,二次迭代就使精确度高达99.97%,相关指数也明显提高。