小波神经网络

神经网络小波分析技术的研究

神经网络小波分析技术的研究神经网络小波分析技术是近年来发展迅速的一种分析技术。

它是基于小波分析的基础上,利用人工神经网络模型进行数据分析和模型建立的一种方法。

它的应用范围非常广泛,可以用于时间序列分析、图像处理、语音识别、金融风险评估等领域。

下面将从理论和应用两个方面探讨神经网络小波分析技术的研究。

一、理论研究神经网络小波分析技术是一种新的数据处理方法,它的理论基础是小波变换和人工神经网络模型。

在小波分析中,小波函数用于对信号进行分解,将信号分解成不同尺度和频率的小波系数,然后根据小波系数进行重构。

小波分析的优势在于可以同时分析信号的时域和频域信息,适用于处理具有局部特征的非平稳信号。

而在人工神经网络模型中,神经元利用类似于神经系统的方式处理信息,具有分布式处理、全局优化等优势。

神经网络小波分析技术将小波分析和神经网络模型有机地结合起来,用于数据分析和模型建立。

在神经网络小波分析中,先利用小波变换对原始数据进行分解,然后将小波系数作为输入信号传入神经网络中进行处理。

通过不断地迭代训练网络,最终获得满足误差要求的最优网络结构和权值,从而实现数据分析和模型建立。

神经网络小波分析技术在理论方面的研究主要包括网络结构的设计、学习算法的改进、模型评价等方面。

二、应用研究神经网络小波分析技术的应用范围非常广泛,可以应用于时间序列分析、图像处理、语音识别、金融风险评估等众多领域。

以下分别介绍一下神经网络小波分析技术在不同领域的应用。

1、时间序列分析时间序列分析是指对一系列按时间顺序排列的数据进行分析和预测的技术。

神经网络小波分析技术可以利用小波分解提取序列中不同频率成分,然后利用神经网络模型对时间序列进行建模和预测。

神经网络小波分析技术在金融、电力、医学等领域中都得到了广泛的应用。

2、图像处理图像处理是指对数字图像进行处理和分析的技术。

神经网络小波分析技术可用于数字图像压缩、边缘检测、纹理分析等方面。

利用小波变换可以提取图像中的局部特征,利用神经网络模型可以对图像进行分类识别,实现图像处理和分析。

小波神经网络简介

(2) 小波变换与神经网络的融合 小波变换与神经网络的融合,也称紧致型结合

小波的发展过程

小波变换的发展的历史过程 Fourier变换

Gobor变换(加窗Fourier变换)

小波变换

小波变换的时间窗和频率窗

给出了信号在时间窗

内的局部信息

给出了信号在频率窗

内的局部信息

时频窗的面积始终不变, 对于检测 高频信号时a 自适应变为(a>0,a较小的时候)使时间窗变窄,对于检测 低频信号时使时间窗变宽即可,这样可以更有效的获取 局部信息

小波神经网络的仿真

wavenet( ),可以很方便地得到网络的仿真结果。

指令格式: g = wavenet(x, THETA)

谢谢观赏

小波神经网络的优点

(1)小波变换通过尺度伸缩和平移对信号进行多尺度分析,

能有效提取信号的局部信息 (2)神经网络具有自学习、自适应和容错性等特点,并且 是一类通用函数逼近器。 (3)小波神经网络的基元和整个结构是依据小波分析理论 确定的,可以避免BP神经网络等结构设计上的盲目性 (4)小波神经网络有更强的学习能力,精度更高对同样的 学习任务,小波神经网络结构更简单,收敛速度更快

小波神经网络简介

什么是小波神经网络?

小波神经网络(Wavelet Neural Network, WNN) Zhang Qinghua等1992年正式提出小波神经网络的概念 小波变换:一种数学分析的工具 小波变换+人工神经网络=小波神经网络

小波网络的结构形式

(1) 小波变换与神经网络的结合 小波变换与神经网络的结合,也称松散型结合 应用举例:基于小波分析的多RBF神经网络轧制力设定模型 由于轧制力信号影响因素多,关联复杂,难以建立精确 的机理模型,所以应用小波多分辨率方法,将原信号 分解重构成不同影响因素的子信号。

小波型神经网络WTNN的设计

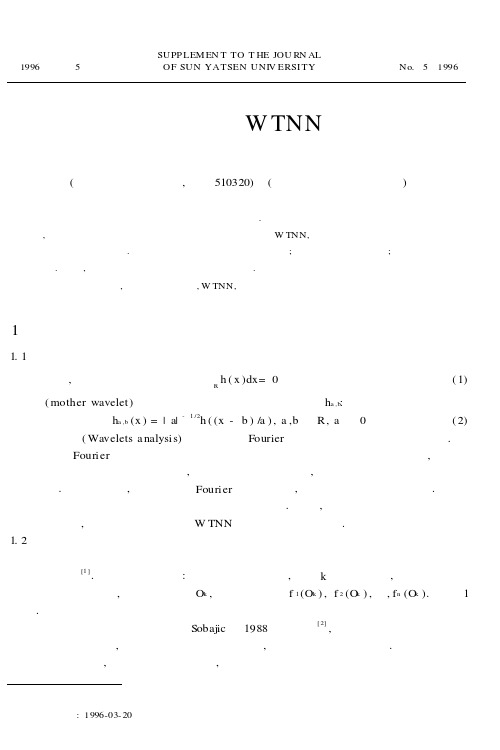

1996年 第5期中山大学学报论丛SUPP LEM EN T TO T HE JOU RN ALOF SUN YATSEN UNIV ERSI TYNo.5 1996 小波型神经网络W TNN的设计毛光喜郑咸义(广东商学院计算中心,广州510320) (华南理工大学应用数学系)摘 要 小波分析已成为众多领域中的有力工具.本文采用调制的小波基对输入模式预处理,在函数链神经网络的基础上设计了小波型神经网络W TNN,从而把小波变换与函数链神经网络有机地结合起来.这样设计的模型有惊人的学习速度;体系结构的通用性好;适应性强等特点.最后,通过实例用计算机模拟验证上述特点.关键词 小波变换,函数链神经网络,W TNN,软件模拟1 引 言1.1 小波分析 简言之,小波是由一个满足条件 Rh(x)dx=0(1)的函数(mother wavelet)通过平移和放缩而产生的一个函数族h a,b:h a,b(x)=|a|-1/2h((x-b)/a),a,b∈R,a≠0(2) 小波分析(Wavelets a nalysis)可以认为是Fourier分析发展史上里程碑式的进展.小波分析优于Fourier分析的地方在于它在时域和频域同时具有良好的局部化性质,从而可以把分析的重点聚焦到任意的细节,被人们誉为数学显微镜,成为近年来在工具和方法上的重大突破.从理论上讲,传统上使用Fourier分析的地方,均可以用小波分析来代替.小波几乎可以构成所有常用函数空间的无条件基.因此,我们把小波变换应用到函数链神经网络中,构造了一个新的模型W TNN——小波型神经网络.1.2 函数链神经网络函数链神经网络是对输入模式作非线性变换预处理、利用高阶效应而获得惊人学习速度的单层网络[1].它的基本思想是:一旦一节点被激励,例如k节点被激励,就会有许多附加函数功能也被激励,即不仅能得到O k,而且还能得到f1(O k),f2(O k),…,f n(O k).如图1所示.函数链神经网络的理论基础是Sobajic于1988年奠定的[2],他证明了函数展开模型总能产生一个单层网络,而且在他的理论分析指导下,可以得到形式简单的解.函数链神经网络的不足之处在于,该系统的适应性较差,该系统总是就具体问题而必须事先设计好一组恰国家自然科学基金资助项目收稿日期63:199-0-20当的函数型增强表达式f 1,f 2,…,f n .换句话说,该系统不能自动地获取对输入模式“好”的增强表达,这种“好”的增强表达是指输入模式的增强表达有利于网络的学习.因此,函数链神经网络的应用受到了限制.图1 函数链神经网络2 W TNN 的构造2.1 引入两个工具2.1.1 小波正交基库 这个库是由足够多的小波正交基以及其它许多正交基所组成的基函数集合,集合中的元素均为一组组基函数.2.1.2 选择“好”基的标准 对于原始输入模式,在小波正交基库中按此标准选择一个“好”基,从而对输入模式进行增强表达,即由O k 得到f 1(O k ),f 2(O k ),…,f n (O k ).Wickerharuse 与Coifman 引进了Shannon 熵的概念作为挑选基的标准[3].定义如下:定义 设H 是Hilbert 空间,令v ∈H ,‖v ‖=1,又假设H=⊕Hi 是H 的一个正交直和,则X (v ,{Hi })=(-∑‖v i ‖2ln ‖v i ‖2)1/2(3)称为向量V 关于直和分解{Hi}的Shannon 熵.其中{v i }是v 在此基{Hi}下的坐标.按照使Shannon 熵为最小的标准来挑选“最好”的基,用以展开H 中的元素.2.2 W TNN 模型的构造小波型神经网络W TNN 模型的结构如图2所示.图2 W TNN 模型的结构2.2.1 小波正交基库 也称为正交基馆或函数馆.例如,Coifman 及其合作者就构作了这样的一个正交基馆,其中收藏了大量的小波正交基以及其它许多正交基.2.2.2 调制器 也称为选基器或排基器.其功能是对给定的原始输入模式,在小波正交基库中调制出一个“最好”的基.从而按这个基对输入模式增强表达,进而作为神经网络的输入用于神经网络的训练控制机制是由选基标准实现的例如,我们按照使S 熵为最小的标准来设计调制器3 单层神经网络 网络学习算法采用最简单的W 规则①任取一组随机数初始化数值172中山大学学报论丛 1996年..hannon .2.2.:向量w 1;②对第k 次递归,有w k +1=w k +Z(b k -w f k x k )X k ,其中Z 称为学习年(0<Z <0.5).省去脚标,②式记为Δw=Z W X ,其中,W =b-w fX 为误差.2.2.4 目标系统 存放着具体目标的领域专家的知识.这些知识是粗糙零散的,以输入—输出关联对的形式表达.2.2.5 用户界面 W TNN 网络系统与用户(例如,领域专家)之间的接口,一般它包括输入/输出两大部分.2.3 W TNN 的工作原理(1)根据实际目标的领域专家的以输入—输出关联对形式表达的知识,确定目标系统.(2)从目标系统的传感器取得数据V (即原始输入模式)通过用户界面输入到小波正交基库中,从而对基库中每一个基元{Hi (k )}n i =1,V 都有其坐标展开,即V =∑ni=1V i (k)H i (k ).其中k 为基元素在库内的编号,V i (k )是第i 个坐标分量.(3)调制器在小波正交基库中取得各组{V i (k)}ni=1,根据选基标准,求出一组最优的坐标{V i (k 0)}n i=1,从而调制出一个“最好”的基{H i (k 0)}ni =1.(4)用{H k (k 0)(V )}对单层神经网络进行训练,以提高目标系统的准确性.3 W TNN 的特点W TNN 不仅完全继承了函数链神经网络的优点,而且还具有更强的功能.它有特点:(1)适应性强.WTNN 网络系统中的调制器子系统能自动调制小波基,实现对输入模式按有利于网络训练的方式增强表达.因此,W TNN 的适应性很强,弥补了函数链神经网络的不足.(2)小波变换与神经网络的有机结合.W TNN 网络模型采用小波变换对原始输入模式预处理,通过自动调制有利于网络训练的小波基,实现了小波变换与神经网络的成功结合.(3)继承了函数链神经网络的全部优点,模型结构简单,功能更加强大,网络对学习算法的依赖性很低,体系结构的通用性好.4 实例分析通过两个例子,在微机上运行了W TNN 模拟程序和相应的BP 网络模拟程序.通过对比,证实了WTNN 具有快速学习速度,进一步以函数链神经网络对比,显示了W TNN 网络系统具有很强的适应性.例1 二值异域问题在二值异域XOR 问题中,输入—输出关联对如表1所示.表2显示了系统误差随迭代次数下降的情况.表1 XOR 问题学习模式模式序号x 1x 2关联输出Y100120103173第5期 毛光喜等:小波型神经网络W TNN 的设计1004111表2 学习结果对比迭代次数W TNN 网络系统误差BP 网络系统误差500.050.86251000.002510.8551500.001260.852000.010.8252500.008750.7迭代次数W TNN 网络系统误差BP 网络系统误差3000.00750.553500.006250.34000.0050.054500.003750.0055000.00250.003例2 一元函数的学习向网络提供曲线的20个采样点,表3是输入—输出关联对,表4显示了系统误差随迭代次数下降的情况.表3 学习模式自变量x i函数值y i 自变量x i函数值y i 0.10.24350.60.24350.20.16750.70.75010.30.45490.80.11500.40.45490.90.66190.50.66191.00.0697自变量x i函数值y i 自变量x i函数值y i 1.10.3312 1.60.04111.20.5719 1.70.17181.30.4910 1.80.26521.40.4512 1.90.03321.50.01322.00.1177表4 学习结果对比迭代次数W TNN 网络系统误差BP 网络系统误差5000.0076920.23076910000.0007690.03076915000.0003850.023*******×0.019231迭代次数W TNN 网络系统误差BP 网络系统误差2500×0.0153853000×0.0076923500×0.0038464000××本文构造的W TNN 网络模型,只是初步探讨了小波变换与神经网络的结合.实际上,小波型神经网络W TNN 还需做更深入的研究.例如,神经网络与模糊系统的集成技术已引起了人们的普遍关注;遗传算法作为一种随机搜索的全局优化算法,它在模糊规则的自动获取与神经网络的学习过程中扮演了一个十分令人注目的角色.因此,探讨将W TNN 、遗传算法及模糊系统进行有机结合,将是我们进一步研究工作的重大课题.参考文献1 Klassen M S,Pao Y H .Cha racte ristics of the functional-link net :A higher order delta r ule net.IEEE Proc .of 2nd Aunua l Inte rnationa l Confe rence on Nea ral Networ ks ,1988,I ,507~513 S j D N N f f Sy ,D T ,S D ,W K U y ,,3 f R,W M V y f ,3174中山大学学报论丛 1996年2oba ic .ewral ets or Control o Power stems Ph ..h esis Computer cience ept Case este rn eserve niversit Cleveland 1988Coi ma n ickerha user .Eutrop -based a lgorithms or best basis selection.19928I EEE Tr ans.27,713~7184 周继成等编著.人工神经网络——第六代计算机的实现.北京:科学普及出版社,19935 庄镇泉,王煦法等编著.神经网络与神经计算机.北京:科学出版社,1994Wa velets Neura l Network Mode l -WTNN ’sDes ign a nd Rea liza tion Mao Guangxi Zheng Xianyi(Gua ngdong Commercia l College Com puter Center,Guangzhou 510320) (South China Univer sity ofTech Math D ept,)Abstr act Wavelets a nalysis have become powerful tools in lots of fields.This paper takes modulation wave-lets coordinate to pre-transform the lear n ing specimen.On the basis ofthe functional -link nevral network ,we design the wavelets neural network model -W TNN and combine wavelets transform with the functional-link neural network successfully .This new model has distinguishing feature as following :(1)surprising learning speed;(2)commonly used structure in erea of neural networks ;(3)strong adaptability .Lastly ,we give some examples to prove WTNN model has distinguishing learning speed .Keywor ds Wavelets transforms,W TNN ,functional-link neural network,softwa re imitative175第5期 毛光喜等:小波型神经网络W TNN 的设计。

小波变换与神经网络技术的滋养特征提取及识别应用

小波变换与神经网络技术的滋养特征提取及识别应用近年来,小波变换与神经网络技术已经在图像、音频、信号等领域广泛应用,特别是在特征提取和识别方面取得了许多重要进展。

本文将介绍小波变换和神经网络技术的原理及其在特征提取和识别中的应用。

一、小波变换原理小波变换是一种时间-频率分析方法,它将时域信号分解成不同尺度和不同频率的子信号,可以帮助我们更好地理解信号的局部特征。

在小波分析中,小波函数是一种长度有限的函数,它具有自相似性、局部化和可变性等特点。

小波变换的基本过程是将原始信号分解成一组小波系数,这些系数包含了信号在不同尺度上的特征信息,包括低频和高频成分。

其中,低频成分代表信号的整体趋势,高频成分反映了信号的局部细节。

二、神经网络技术原理神经网络是一种模拟人类神经系统运作的计算模型。

它由大量简单的单元组成,这些单元相互连接并通过学习来实现特定任务。

神经网络可以通过多次迭代来优化网络连接权重以及神经元的激活函数,从而得到更好的分类和识别效果。

在神经网络中,网络的输入层接收原始数据,隐含层和输出层则通过多层非线性变换将输入数据映射到具有特定意义的特征空间中。

神经网络的输出层通常表示分类或者识别结果。

三、小波变换与神经网络技术在特征提取中的应用小波变换和神经网络技术已经被广泛应用于图像、音频、信号等领域,特别是在特征提取和识别方面。

以下是一些典型应用案例:1.图像特征提取在图像处理中,小波变换可以将图像分解为不同的频率和尺度。

通过选取合适的小波函数和分解层数,可以提取出图像的不同特征,如边缘、纹理等。

这些特征可以被用于分类、识别和双目视觉等应用中。

神经网络可以通过卷积层和全连接层等深度学习结构学习这些特征,并将其映射到更高层次的特征空间中。

这些特征被广泛应用于计算机视觉任务,如图像分类、目标检测和物体识别等。

2.音频特征提取在音频处理中,小波变换可以将音频信号分解为不同频率的子信号。

这些子信号可以用于声音识别、语音合成、语音分析等应用。

小波神经网络(WNN)

⼩波神经⽹络(WNN)⼈⼯神经⽹络(ANN)是对⼈脑若⼲基本特性通过数学⽅法进⾏的抽象和模拟,是⼀种模仿⼈脑结构及其功能的⾮线性信息处理系统。

具有较强的⾮线性逼近功能和⾃学习、⾃适应、并⾏处理的特点,具有良好的容错能⼒。

⼈⼯神经元神经元是构成神经⽹络的最基本单元。

要想构造⼀个⼈⼯神经⽹络系统,⾸要任务是构造⼈⼯神经元模型。

⼀个⼈⼯神经⽹络的神经元模型和结构描述了⼀个⽹络如何将它的输⼊⽮量转换为输出⽮量的过程。

⼀个神经元有两个输⼊:输⼊向量p,阈值b,也叫偏差。

输⼊向量p通过与它相连的权值分量w相乘,求和后,形成激活函数f(.)的输⼊。

激活函数的另⼀个输⼊是神经元的阈值b。

权值w和输⼊p的矩阵形式可以由w的⾏⽮量以及p的列⽮量来表⽰:神经元模型的输出⽮量可以表⽰为:激活函数是⼀个神经元及⽹络的核⼼。

激活函数的基本作⽤是:1、控制输⼊对输出的激活作⽤;2、对输⼊、输出进⾏函数转换;3、将可能⽆限域的输⼊变换成指定的有限范围内的输出。

激活函数的常⽤类型:⼩波(wave/let):波-震荡,⼩-衰减速度⽐较快。

⼩波分析具有多分辨分析的特点,是⼀种窗⼝⼤⼩固定不变但其形状可以改变的分析⽅法,被称为信号的显微镜。

⼩波分析的种类:Haar⼩波规范正交基、Morlet⼩波、Mallat算法、多分辨分析、多尺度分析、紧⽀撑⼩波基、时频分析等。

⼩波神经⽹络(WNN)集⼈⼯神经⽹络和⼩波分析优点于⼀⾝,即使⽹络收敛速度快、避免陷⼊局部最优,⼜有时频局部分析的特点。

WNN是将神经⽹络隐结点的S函数由⼩波函数来代替,相应的输⼊层到隐含层的权值及隐含层的阈值分别由⼩波函数的尺度伸缩因⼦和时间平移因⼦所代替。

小波变换与神经网络的结合研究进展

小波变换与神经网络的结合研究进展近年来,小波变换和神经网络作为两种重要的信号处理和模式识别技术,受到了广泛的关注和研究。

它们分别具有独特的优势和应用领域,但也存在一些局限性。

因此,将小波变换和神经网络相结合,可以充分发挥它们各自的优势,提高信号处理和模式识别的性能。

小波变换是一种时频分析方法,可以将信号分解成不同频率的子信号,并提取出信号的时频特征。

小波变换具有多分辨率分析的特点,可以在不同尺度上对信号进行分析,从而更好地捕捉信号的局部特征。

然而,小波变换在处理非平稳信号时存在一些问题,如边界效应和选择合适的小波基函数等。

神经网络是一种模拟人类神经系统的计算模型,具有自适应学习和自适应处理能力。

神经网络通过训练样本来学习输入和输出之间的映射关系,并通过调整网络的权值和阈值来提高模型的性能。

然而,传统的神经网络在处理复杂的非线性问题时存在一些困难,如训练时间长、易陷入局部最优等。

将小波变换和神经网络相结合,可以克服它们各自的局限性,提高信号处理和模式识别的准确性和鲁棒性。

一种常见的方法是使用小波变换作为神经网络的输入,将信号的时频特征作为神经网络的输入特征,从而提高神经网络的性能。

另一种方法是将小波变换作为神经网络的激活函数,利用小波函数的多尺度分析能力来提取信号的局部特征,并通过神经网络来学习和优化小波函数的参数。

除了将小波变换作为神经网络的输入或激活函数,还可以利用神经网络来优化小波变换的参数和阈值,从而提高小波变换的性能。

例如,可以使用神经网络来学习和优化小波基函数的参数,使其更好地适应信号的特征。

还可以使用神经网络来学习和优化小波变换的阈值,从而实现自适应的信号分解和重构。

此外,小波变换和神经网络的结合还可以应用于图像处理、语音识别、生物医学信号处理等领域。

例如,在图像处理中,可以利用小波变换提取图像的纹理特征,然后使用神经网络进行图像分类和识别。

在语音识别中,可以利用小波变换提取语音的频谱特征,然后使用神经网络进行语音识别和语音合成。

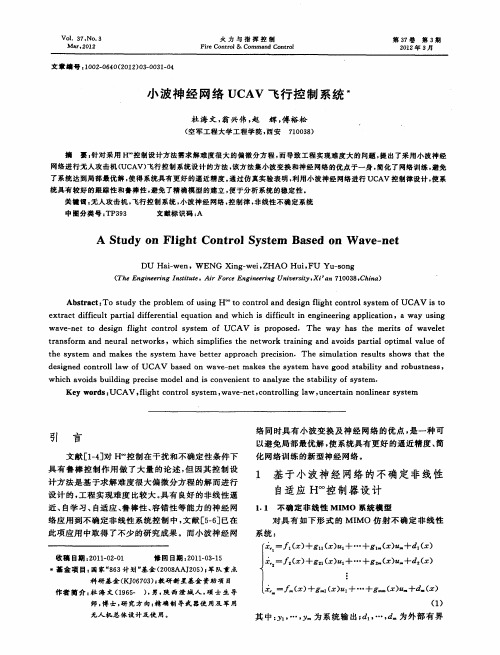

小波神经网络UCAV飞行控制系统

l+ ,一 ; .= l曩1 ’r +…+ 1 J I

-

:

一

B P,e T e ,

(O 1)

其中: r为非 负设 计参 数 , 参数 自适应 律 为 : 取

t  ̄ ( ) (I ‘I ) z PB磊 十 I i e I 一

啦 f: :

一

西 I ) 竺 Pi + 堡 B

网络 进 行 无 人 攻 击 机 ( AV) UC 飞行 控 制 系统 设 计 的 方 法 , 方 法 集 小 波 变 换 和 神 经 网络 的优 点 于 一 身 , 该 简化 了 网络 训 练 , 免 避 了 系统 达 到 局 部 最 优 解 , 得 系 统 具 有 更 好 的 逼 近 精 度 。 过 仿 真 实 验 表 明 , 用 小 波 神 经 网 络 进 行 UC 使 通 利 AV 控制 律 设 计 , 系 使 统 具 有 较 好 的 跟 踪 性 和鲁 棒 性 , 免 了精 确 模 型 的建 立 , 于 分 析 系统 的稳 定 性 。 避 便 关 键 词 : 人 攻 击 机 , 行 控 制 系 统 , 波 神 经 网络 , 制 律 , 线 性 不 确定 系 统 无 飞 小 控 非

[ , , () 则有 式 () ()… ] , 9成立 :

+ . -’ r ( - 一 | 一 _ + … + ( 一 ) 1 1)

e = Af , p e B t + (‘ + 矗 ( + )

( l )‘ + ) ( ) 9

其 中: 一 ( ( Z) zI 一 ( +△ ) ) G, 一 , =

1 基 于 小 波 神经 网络 的不 确 定 非 线 性 自适 应 H。 制 器设 计 。 控

1 1 不确 定 非线性 MI . MO 系统 模型

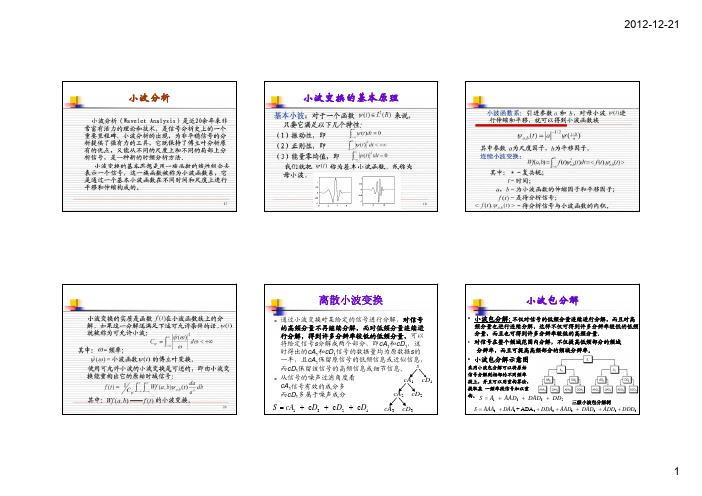

小波EMD神经网络信号处理

小波分析小波变换的基本原理离散小波变换z通过小波变换对某给定的信号进行分解,对信号小波包分解•小波包分解:不仅对信号的低频分量连续进行分解,而且对高频分量也进行连续分解,这样不仅可得到许多分辨率较低的低频分量,而且也可得到许多分辨率较低的高频分量.•对信号在整个频域范围内分解,不仅提高低频部分的频域分辨率,而且可提高高频部分的频域分辨率。

•小波包分解示意图采用小波包分解可以将原始信号分解到相邻的不同频率段上,并且可以用重构算法,提取某一频率段信号加以重构。

三级小波包分解树1332S A AAD DAD DD=+++33333333+ADAS AAA DAA DDA AAD DAD ADD DDD =++++++频域分析方法比较:–傅立叶分析小波分析具体步骤•小波分析技术在时域和频域均具有局部分析功能,所以适合•②确定小波基的阶数小波变换问题所在例:对白噪声信号noissin进行3层小波分解,所用小波函数为‘db4’。

load noissin; 读入白噪声信号s=noissin(1:1000); 取信号的前1000个采样点[c,l]=wavedec(s,3,’db4’); 对信号做3层多尺度分解[cd1,cd2,cd3]=detcoef(c,l,[1,2,3]);[cd1,cd2,cd3]detcoef(c,l,[1,2,3]);得到三个尺度的细节系数ca3=appcoef(c,l,’db4’,3); 得到尺度3的近似系数figure;subplot(511);plot(1:1000,s);title(‘s’); 绘制原始信号subplot(512);plot(ca3);title(‘ca3’); 绘制尺度3的近似系数subplot(513);plot(cd3);title(‘cd3’); 绘制尺度3的细节系数subplot(514);plot(cd2);title('cd2'); 绘制尺度2的细节系数subplot(515);plot(cd1);title('cd1'); 绘制尺度1的细节系数中,各层分解后的长度存到数组l中;[nc,nl]=upwlev(c,l,‘sym1’);通过第四层小波系数重建第三层小波近似系数,把三层的系数存放在数组nc中,三层分解的长度存放到数组nl中figure;subplot(311);plot(s);title(‘原始信号’); 绘制原始信号subplot(312);p();plot(c);title('做4层wavedec得到的结果');subplot(313);plot(nc);title('做3层wavedec得到的结果');lev=5;lev5;[c,l]=wavedec(x,lev,wname); 用sym6小波对信号x做5层分解sigma=wnoisest(c,l,1); 通过第1层的细节系数估算信号的噪声强度σ;alpha=2; 选择参数α=2thr1=wbmpen(c,l,sigma,alpha); %使用penalty策略确定降噪的阈值xd1=wdencmp(‘gbl’,c,l,wname,lev,thr1,’s’,1);%重建降噪信figure;subplot(411);plot(x);title(‘原始信号’);subplot(412);plot(xd1);title(‘使用penalty阈值降噪后信号’);小波工具箱的在前面的介绍中,都是用命令行的方式来利用小波工具箱菜单提供如下的功能:一维小波分析工具类,包括:一维小波变换、一维小波包变换等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

clc

clear

%% 训练数据预测数据提取及归一化

%下载四类语音信号

load data1 c1

load data2 c2

load data3 c3

load data4 c4

%四个特征信号矩阵合成一个矩阵

data(1:250,:)=c1(251:500,:);

data(251:500,:)=c2(251:500,:);

data(501:750,:)=c3(251:500,:);

data(751:1000,:)=c4(251:500,:);

%从1到2000间随机排序

% k=rand(1,1000);

% [m,n]=sort(k);

%输入输出数据

input=data(:,2:11);

output1 =data(:,1);

%把输出从1维变成4维

output=zeros(1000,4);

for i=1:1000

switch output1(i)

case 1

output(i,:)=[1 0 0 0];

case 2

output(i,:)=[0 1 0 0];

case 3

output(i,:)=[0 0 1 0];

case 4

output(i,:)=[0 0 0 1];

end

end

%随机提取1500个样本为训练样本,500个样本为预测样本% input_train=input(n(1:250),:)';

% output_train=output(n(1:250),:)';

input=input(1:250,:);

output=output(1:250,:);

% input_test=input(1501:2000,:)';

% output_test=output(1501:2000,:)';

M=size(input,2); %输入节点个数

N=size(output,2); %输出节点个数

n=10; %隐形节点个数

lr1=0.0001; %学习概率

lr2=0.0001; %学习概率

maxgen=1000; %迭代次数

%权值初始化

Wjk=randn(n,M);Wjk_1=Wjk;Wjk_2=Wjk_1; Wij=randn(N,n);Wij_1=Wij;Wij_2=Wij_1; a=randn(1,n);a_1=a;a_2=a_1;

b=randn(1,n);b_1=b;b_2=b_1;

%节点初始化

y=zeros(1,N);

net=zeros(1,n);

net_ab=zeros(1,n);

%权值学习增量初始化

d_Wjk=zeros(n,M);

d_Wij=zeros(N,n);

d_a=zeros(1,n);

d_b=zeros(1,n);

%% 输入输出数据归一化

[inputn,inputps]=mapminmax(input'); [outputn,outputps]=mapminmax(output'); inputn=inputn';

outputn=outputn';

error=zeros(1,maxgen);

%% 网络训练

for i=1:maxgen

%误差累计

error(i)=0;

% 循环训练

for kk=1:size(input,1)

x=inputn(kk,:);

yqw=outputn(kk,:);

for j=1:n

for k=1:M

net(j)=net(j)+Wjk(j,k)*x(k);

net_ab(j)=(net(j)-b(j))/a(j);

end

temp=mymorlet(net_ab(j));

for k=1:N

y=y+Wij(k,j)*temp; %小波函数

end

end

%计算误差和

error(i)=error(i)+sum(abs(yqw-y));

%权值调整

for j=1:n

%计算d_Wij

temp=mymorlet(net_ab(j));

for k=1:N

d_Wij(k,j)=d_Wij(k,j)-(yqw(k)-y(k))*temp;

end

%计算d_Wjk

temp=d_mymorlet(net_ab(j));

for k=1:M

for l=1:N

d_Wjk(j,k)=d_Wjk(j,k)+(yqw(l)-y(l))*Wij(l,j) ;

end

d_Wjk(j,k)=-d_Wjk(j,k)*temp*x(k)/a(j);

end

%计算d_b

for k=1:N

d_b(j)=d_b(j)+(yqw(k)-y(k))*Wij(k,j);

end

d_b(j)=d_b(j)*temp/a(j);

%计算d_a

for k=1:N

d_a(j)=d_a(j)+(yqw(k)-y(k))*Wij(k,j);

end

d_a(j)=d_a(j)*temp*((net(j)-b(j))/b(j))/a(j);

end

%权值参数更新

Wij=Wij-lr1*d_Wij;

Wjk=Wjk-lr1*d_Wjk;

b=b-lr2*d_b;

a=a-lr2*d_a;

d_Wjk=zeros(n,M);

d_Wij=zeros(N,n);

d_a=zeros(1,n);

d_b=zeros(1,n);

y=zeros(1,N);

net=zeros(1,n);

net_ab=zeros(1,n);

Wjk_1=Wjk;Wjk_2=Wjk_1;

Wij_1=Wij;Wij_2=Wij_1;

a_1=a;a_2=a_1;

b_1=b;b_2=b_1;

end

end

plot(error);

semilogy(error);。