多元线性回归模型:假设检验

统计学中的线性回归模型与假设检验

统计学中的线性回归模型与假设检验统计学作为一门研究数据收集、分析和解释的学科,扮演着重要的角色。

其中,线性回归模型和假设检验是统计学中常用的方法。

本文将介绍线性回归模型的基本概念和应用,以及假设检验的原理和实际意义。

一、线性回归模型线性回归模型是一种用于描述两个或多个变量之间关系的统计模型。

它假设自变量和因变量之间存在线性关系,并通过最小化因变量与预测值之间的差异来估计回归系数。

在线性回归模型中,自变量通常表示为X,因变量表示为Y。

模型的基本形式可以表示为Y = β0 + β1X + ε,其中β0和β1是回归系数,ε是误差项。

回归系数表示自变量对因变量的影响程度,误差项表示模型无法解释的随机变动。

线性回归模型的应用非常广泛。

例如,在经济学中,可以使用线性回归模型来研究收入与消费之间的关系;在医学研究中,可以使用线性回归模型来分析药物剂量与治疗效果之间的关系。

通过对数据进行拟合和分析,线性回归模型可以帮助我们理解变量之间的关系,并进行预测和决策。

二、假设检验假设检验是一种统计推断方法,用于判断样本数据与某个假设之间是否存在显著差异。

在假设检验中,我们首先提出一个原假设(H0)和一个备择假设(H1),然后根据样本数据进行统计推断,判断是否拒绝原假设。

在假设检验中,我们通常使用一个统计量来衡量样本数据与原假设之间的差异。

常见的统计量包括t值、F值和卡方值等。

通过计算统计量的概率值(p值),我们可以判断样本数据是否支持原假设。

假设检验在科学研究和实际应用中具有重要意义。

例如,在药物研发中,可以使用假设检验来判断新药物是否比现有药物更有效;在市场营销中,可以使用假设检验来评估不同广告策略的效果。

通过假设检验,我们可以基于数据进行科学决策,提高研究和实践的可靠性。

三、线性回归模型与假设检验的关系线性回归模型和假设检验是统计学中紧密相关的方法。

在线性回归分析中,我们可以使用假设检验来评估回归系数的显著性。

在线性回归模型中,我们通常对回归系数进行假设检验,以确定自变量对因变量的影响是否显著。

计量经济学-多元线性回归模型

Y=β0+β1X1+β2X2+...+βkXk+ε,其中Y为因变 量,X1, X2,..., Xk为自变量,β0, β1,..., βk为回归 系数,ε为随机误差项。

多元线性回归模型的假设条件

包括线性关系假设、误差项独立同分布假设、无 多重共线性假设等。

研究目的与意义

研究目的

政策与其他因素的交互作用

多元线性回归模型可以引入交互项,分析政策与其他因素(如技 术进步、国际贸易等)的交互作用,更全面地评估政策效应。

实例分析:基于多元线性回归模型的实证分析

实例一

预测某国GDP增长率:收集该国历史数据,包括GDP、投资、消费、出口等变量,建立 多元线性回归模型进行预测,并根据预测结果提出政策建议。

最小二乘法原理

最小二乘法是一种数学优化技术,用 于找到最佳函数匹配数据。

残差是观测值与预测值之间的差,即 e=y−(β0+β1x1+⋯+βkxk)e = y (beta_0 + beta_1 x_1 + cdots + beta_k x_k)e=y−(β0+β1x1+⋯+βkxk)。

在多元线性回归中,最小二乘法的目 标是使残差平方和最小。

t检验

用于检验单个解释变量对被解释变量的影响 是否显著。

F检验

用于检验所有解释变量对被解释变量的联合 影响是否显著。

拟合优度检验

通过计算可决系数(R-squared)等指标, 评估模型对数据的拟合程度。

残差诊断

检查残差是否满足独立同分布等假设,以验 证模型的合理性。

04

多元线性回归模型的检验与 诊断

中级计量经济学讲义_第六章带有线性约束的多元线性回归模型及其假设检验

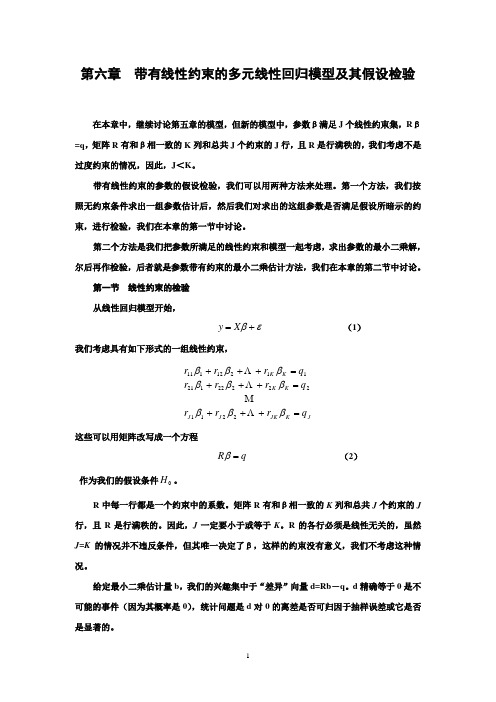

第六章 带有线性约束的多元线性回归模型及其假设检验在本章中,继续讨论第五章的模型,但新的模型中,参数β满足J 个线性约束集,R β=q ,矩阵R 有和β相一致的K 列和总共J 个约束的J 行,且R 是行满秩的,我们考虑不是过度约束的情况,因此,J <K 。

带有线性约束的参数的假设检验,我们可以用两种方法来处理。

第一个方法,我们按照无约束条件求出一组参数估计后,然后我们对求出的这组参数是否满足假设所暗示的约束,进行检验,我们在本章的第一节中讨论。

第二个方法是我们把参数所满足的线性约束和模型一起考虑,求出参数的最小二乘解,尔后再作检验,后者就是参数带有约束的最小二乘估计方法,我们在本章的第二节中讨论。

第一节 线性约束的检验 从线性回归模型开始,εβ+=X y (1)我们考虑具有如下形式的一组线性约束,JK JK J J K K K K q r r r q r r r q r r r =+++=+++=+++βββββββββ22112222212*********这些可以用矩阵改写成一个方程q R =β (2)作为我们的假设条件0H 。

R 中每一行都是一个约束中的系数。

矩阵R 有和β相一致的K 列和总共J 个约束的J 行,且R 是行满秩的。

因此,J 一定要小于或等于K 。

R 的各行必须是线性无关的,虽然J =K 的情况并不违反条件,但其唯一决定了β,这样的约束没有意义,我们不考虑这种情况。

给定最小二乘估计量b ,我们的兴趣集中于“差异”向量d=Rb -q 。

d 精确等于0是不可能的事件(因为其概率是0),统计问题是d 对0的离差是否可归因于抽样误差或它是否是显著的。

由于b 是多元正态分布的,且d 是b 的一个线性函数,所以d 也是多元正态分布的,若原假设为真,d 的均值为0,方差为R X X R R b Var R q Rb Var d Var ''='=-=-12)(])[(][][σ (3)对H 0的检验我们可以将其基于沃尔德(Wald )准则:d d Var d J W 12])[()(-'==χ=)(])([)(112q Rb R X X R q Rb -'''---σ (4)在假设正确时将服从自由度为J 的2χ分布(为什么?)。

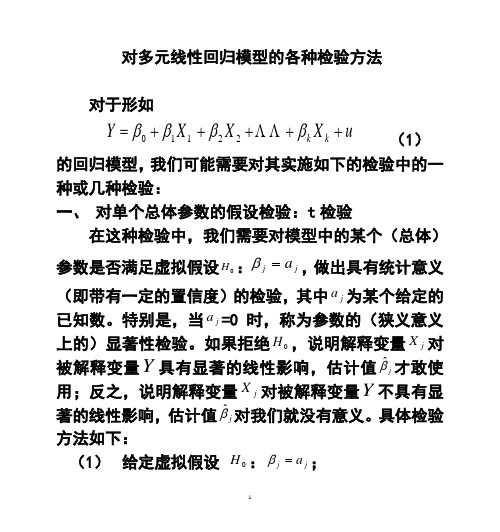

多元线性回归模型的各种检验方法

对多元线性回归模型的各种检验方法对于形如u X X X Y k k +++++=ββββ 22110 (1) 的回归模型,我们可能需要对其实施如下的检验中的一种或几种检验:一、 对单个总体参数的假设检验:t 检验在这种检验中,我们需要对模型中的某个(总体)参数是否满足虚拟假设0H :j j a =β,做出具有统计意义(即带有一定的置信度)的检验,其中j a 为某个给定的已知数。

特别是,当j a =0时,称为参数的(狭义意义上的)显著性检验。

如果拒绝0H ,说明解释变量j X 对被解释变量Y 具有显著的线性影响,估计值j βˆ才敢使用;反之,说明解释变量j X 对被解释变量Y 不具有显著的线性影响,估计值j βˆ对我们就没有意义。

具体检验方法如下:(1) 给定虚拟假设 0H :j j a =β;(2) 计算统计量 )ˆ(ˆ)ˆ()(ˆjj j j j j Se a Se E t βββββ-=-= 的数值; 11ˆ)ˆ(++-==j j jj jj j C C Se 1T X)(X ,其中σβ(3) 在给定的显著水平α下(α不能大于1.0即 10%,也即我们不能在置信度小于90%以下的前提下做结论),查出双尾t (1--k n )分布的临界值2/αt ;(4) 如果出现 2/αt t >的情况,检验结论为拒绝0H ;反之,无法拒绝0H 。

t 检验方法的关键是统计量 )ˆ(ˆj jj Se t βββ-=必须服从已知的t 分布函数。

什么情况或条件下才会这样呢?这需要我们建立的模型满足如下的条件(或假定):(1) 随机抽样性。

我们有一个含n 次观测的随机样(){}n i Y X X X i ik i i ,,2,1:,,,,21 =。

这保证了误差u 自身的随机性,即无自相关性,0))())(((=--j j i i u E u u E u Cov 。

(2) 条件期望值为0。

给定解释变量的任何值,误差u 的期望值为零。

线性回归模型检验方法拓展-三大检验

线性回归模型检验⽅法拓展-三⼤检验第四章线性回归模型检验⽅法拓展——三⼤检验作为统计推断的核⼼内容,除了估计未知参数以外,对参数的假设检验是实证分析中的⼀个重要⽅⾯。

对模型进⾏各种检验的⽬的是,改善模型的设定以确保基本假设和估计⽅法⽐较适合于数据,同时也是对有关理论有效性的验证。

⼀、假设检验的基本理论及准则假设检验的理论依据是“⼩概率事件原理”,它的⼀般步骤是(1)建⽴两个相对(互相排斥)的假设(零假设和备择假设)。

(2)在零假设条件下,寻求⽤于检验的统计量及其分布。

(3)得出拒绝或接受零假设的判别规则。

另⼀⽅⾯,对于任何的检验过程,都有可能犯错误,即所谓的第⼀类错误P(拒绝H|H0为真)=α和第⼆类错误P(接受H|H0不真)=β在下图,粉红⾊部分表⽰P(拒绝H0|H0为真)=α。

黄⾊部分表⽰P(接受H0|H0不真)=β。

⽽犯这两类错误的概率是⼀种此消彼长的情况,于是如何控制这两个概率,使它们尽可能的都⼩,就成了寻找优良的检验⽅法的关键。

下⾯简要介绍假设检验的有关基本理论。

参数显著性检验的思路是,已知总体的分布(,)F X θ,其中θ是未知参数。

总体真实分布完全由未知参数θ的取值所决定。

对θ提出某种假设001000:(:,)H H θθθθθθθθ=≠><或,从总体中抽取⼀个容量为n 的样本,确定⼀个统计量及其分布,决定⼀个拒绝域W ,使得0()P W θα=,或者对样本观测数据X ,0()P X W θα∈≤。

α是显著性⽔平,即犯第⼀类错误的概率。

既然犯两类错误的概率不能同时被控制,所以通常的做法是,限制犯第⼀类错误的概率,使犯第⼆类错误的概率尽可能的⼩,即在0()P X W θα∈≤ 0θ∈Θ的条件下,使得()P X W θ∈,0θ∈Θ-Θ达到最⼤,或1()P X W θ-∈,0θ∈Θ-Θ达到最⼩。

其中()P X W θ∈表⽰总体分布为(,)F X θ时,事件W ∈{X }的概率,0Θ为零假设集合(0Θ只含⼀个点时成为简单原假设,否则称为复杂原假设)。

多元线性回归模型检验

多元线性回归模型检验引言多元线性回归是一种常用的统计分析方法,用于研究两个或多个自变量对目标变量的影响。

在应用多元线性回归前,我们需要确保所建立的模型符合一定的假设,并进行模型检验,以保证结果的可靠性和准确性。

本文将介绍多元线性回归模型的几个常见检验方法,并通过实例进行说明。

一、多元线性回归模型多元线性回归模型的一般形式可以表示为:$$Y = \\beta_0 + \\beta_1X_1 + \\beta_2X_2 + \\ldots + \\beta_pX_p +\\varepsilon$$其中,Y为目标变量,$X_1,X_2,\\ldots,X_p$为自变量,$\\beta_0,\\beta_1,\\beta_2,\\ldots,\\beta_p$为模型的回归系数,$\\varepsilon$为误差项。

多元线性回归模型的目标是通过调整回归系数,使得模型预测值和实际观测值之间的误差最小化。

二、多元线性回归模型检验在进行多元线性回归分析时,我们需要对所建立的模型进行检验,以验证假设是否成立。

常用的多元线性回归模型检验方法包括:1. 假设检验多元线性回归模型的假设包括:线性关系假设、误差项独立同分布假设、误差项方差齐性假设和误差项正态分布假设。

我们可以通过假设检验来验证这些假设的成立情况。

•线性关系假设检验:通过F检验或t检验对回归系数的显著性进行检验,以确定自变量与目标变量之间是否存在线性关系。

•误差项独立同分布假设检验:通过Durbin-Watson检验、Ljung-Box 检验等统计检验,判断误差项是否具有自相关性。

•误差项方差齐性假设检验:通过Cochrane-Orcutt检验、White检验等统计检验,判断误差项的方差是否齐性。

•误差项正态分布假设检验:通过残差的正态概率图和Shapiro-Wilk 检验等方法,检验误差项是否满足正态分布假设。

2. 多重共线性检验多重共线性是指在多元线性回归模型中,自变量之间存在高度相关性的情况。

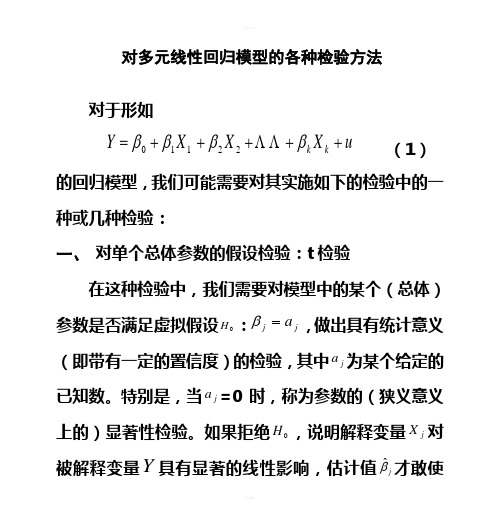

多元线性回归模型的各种检验方法

对多元线性回归模型的各种检验方法对于形如u X X X Y k k +++++=ββββΛΛ22110 (1)的回归模型,我们可能需要对其实施如下的检验中的一种或几种检验:一、 对单个总体参数的假设检验:t 检验在这种检验中,我们需要对模型中的某个(总体)参数是否满足虚拟假设0H :j j a =β,做出具有统计意义(即带有一定的置信度)的检验,其中j a 为某个给定的已知数。

特别是,当j a =0时,称为参数的(狭义意义上的)显著性检验。

如果拒绝0H ,说明解释变量j X 对被解释变量Y 具有显著的线性影响,估计值j βˆ才敢使用;反之,说明解释变量j X 对被解释变量Y 不具有显著的线性影响,估计值j βˆ对我们就没有意义。

具体检验方法如下:(1) 给定虚拟假设 0H :j j a =β;(2) 计算统计量 )ˆ(ˆ)ˆ()(ˆjj j j j j Se a Se E t βββββ-=-= 的数值; 11ˆ)ˆ(++-==j j jj jj j C C Se 1T X)(X ,其中σβ(3) 在给定的显著水平α下(α不能大于1.0即10%,也即我们不能在置信度小于90%以下的前提下做结论),查出双尾t (1--k n )分布的临界值2/αt ;(4) 如果出现 2/αt t >的情况,检验结论为拒绝0H ;反之,无法拒绝0H 。

t 检验方法的关键是统计量 )ˆ(ˆj jj Se t βββ-=必须服从已知的t 分布函数。

什么情况或条件下才会这样呢?这需要我们建立的模型满足如下的条件(或假定):(1) 随机抽样性。

我们有一个含n 次观测的随机样(){}n i Y X X X i ik i i ,,2,1:,,,,21ΛΛ=。

这保证了误差u 自身的随机性,即无自相关性,0))())(((=--j j i i u E u u E u Cov 。

(2) 条件期望值为0。

给定解释变量的任何值,误差u 的期望值为零。

多元线性回归模型的各种检验方法

多元线性回归模型的各种检验方法多元线性回归模型是常用于数据分析和预测的方法,它可以用于研究多个自变量与因变量之间的关系。

然而,仅仅使用多元线性回归模型进行参数估计是不够的,我们还需要对模型进行各种检验以确保模型的可靠性和有效性。

下面将介绍一些常用的多元线性回归模型的检验方法。

首先是模型的整体显著性检验。

在多元线性回归模型中,我们希望知道所构建的模型是否能够显著解释因变量的变异。

常见的整体显著性检验方法有F检验和显著性检查表。

F检验是通过比较回归模型的回归平方和和残差平方和的比值来对模型的整体显著性进行检验。

若F值大于一定的临界值,则可以拒绝原假设,即模型具有整体显著性。

通常,临界值是根据置信水平和自由度来确定的。

显著性检查表是一种常用的汇总表格,它可以提供关于回归模型的显著性水平、标准误差、置信区间和显著性因素的信息。

通过查找显著性检查表,我们可以评估模型的显著性。

其次是模型的参数估计检验。

在多元线性回归模型中,我们希望知道每个自变量对因变量的影响是否显著。

通常使用t检验来对模型的参数估计进行检验。

t检验是通过对模型的回归系数进行检验来评估自变量的影响是否显著。

与F检验类似,t检验也是基于假设检验原理,通过比较t值和临界值来决定是否拒绝原假设。

通常,临界值可以通过t分布表或计算机软件来获取。

另外,我们还可以使用相关系数来评估模型的拟合程度。

相关系数可以用来衡量自变量与因变量之间的线性关系强度,常见的相关系数包括Pearson相关系数和Spearman相关系数。

Pearson相关系数适用于自变量和因变量都是连续变量的情况,它衡量的是两个变量之间的线性关系强度。

取值范围为-1到1,绝对值越接近1表示关系越强。

Spearman相关系数适用于自变量和因变量至少有一个是有序变量或者都是有序变量的情况,它衡量的是两个变量之间的单调关系强度。

取值范围也是-1到1,绝对值越接近1表示关系越强。

最后,我们还可以使用残差分析来评估模型的拟合程度和误差分布。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Note the degrees of freedom: n k 1

6

The t Test (cont)

Knowing the sampling distribution for the standardized estimator allows us to carry out hypothesis tests Start with a null hypothesis

10

One-Sided Alternatives (cont)

bˆj is distributed normally becauseit

is a linear combination of the errors

5

The t Test

Under theCLM assumptions

bˆj b j se bˆ j ~ tnk1

Note this is a t distribution (vs normal)

H1: bj > 0 and H1: bj < 0 are one-sided H1: bj 0 is a two-sided alternative

If we want to have only a 5% probability of rejecting H0 if it is really true, then we say our significance level is 5%

y|x ~ Normal(b0 + b1x1 +…+ bkxk, s2)

While for now we just assume normality, clear that sometimes not the case Large samples will let us drop normality

3

The homoskedastic normal distribution with a single explanatory variable

y

f(y|x)

.

.

E(y|x) = b0 + b1x

Normal distributions

x1

x2

4

Normal Sampling Distributions

mean and variance s2: u ~ Normal(0,s2)

2

CLM Assumptions (cont)

Under CLM, OLS is not only BLUE, but is the minimum variance unbiased estimator We can summarize the population assumptions of CLM as follows

Under theCLM assumptions, conditional on the sample values of theindependent variables

bˆ j ~ Normal b j ,源自ar bˆ j , so that

bˆ j b j sd bˆ j ~ Normal0,1

9

One-Sided Alternatives (cont)

Having picked a significance level, a, we look up the (1 – a)th percentile in a t distribution with n – k – 1 df and call this c, the critical value We can reject the null hypothesis if the t statistic is greater than the critical value If the t statistic is less than the critical value then we fail to reject the null

"the"t statistic for bˆj : tbˆ j bˆ j se bˆ j

We will then use our t statistic along with a rejection rule to determine whether to accept thenull hypothesis, H0

For example, H0: bj=0

If accept null, then accept that xj has no effect on y, controlling for other x’s

7

The t Test (cont)

To performour test we first need to form

8

t Test: One-Sided Alternatives

Besides our null, H0, we need an alternative hypothesis, H1, and a significance level H1 may be one-sided, or two-sided

Multiple Regression Analysis

y = b0 + b1x1 + b2x2 + . . . bkxk + u

2. Inference

1

Assumptions of the Classical Linear Model (CLM)

So far, we know that given the GaussMarkov assumptions, OLS is BLUE, In order to do classical hypothesis testing, we need to add another assumption (beyond the Gauss-Markov assumptions) Assume that u is independent of x1, x2,…, xk and u is normally distributed with zero