Apriori算法例子

apriori算法例题python实现

apriori算法例题python实现1. 引言1.1 概述在数据挖掘领域中,关联规则挖掘是一项重要的任务,它能够发现数据集中不同项之间的相互关系。

Apriori算法作为关联规则挖掘中最常用的算法之一,能够有效地找出频繁项集和关联规则。

1.2 文章结构本文将详细介绍Apriori算法的原理和步骤,并使用Python语言实现了该算法。

文章分为五个主要部分,分别是引言、Apriori算法介绍、Python实现Apriori 算法、算法性能优化与应用场景探讨以及结论与总结。

1.3 目的本文旨在通过对Apriori算法的深入介绍和实践演示,帮助读者更好地理解和掌握该算法。

通过学习本文,读者将能够了解该算法的原理、运行流程和核心函数实现方法,并能够在实际应用中灵活运用Apriori算法来进行关联规则挖掘任务。

接下来将进入“2. Apriori算法介绍”部分,对关联规则挖掘概述、Apriori算法原理以及Apriori算法步骤进行详细讲解。

2. Apriori算法介绍2.1 关联规则挖掘概述关联规则挖掘是数据挖掘领域的一个重要任务,它可以发现数据集中的项集之间的关联关系。

在一个事务数据库中,项集由多个项目组成,而关联规则描述了这些项集之间的关联性。

通过关联规则挖掘,我们可以发现某个商品组合出现时,其他的商品也经常同时被购买的情况。

这对于市场营销、推荐系统以及交叉销售等领域具有重要意义。

2.2 Apriori算法原理Apriori算法是一种经典且高效的关联规则挖掘算法。

它基于一种称为"频繁项集"的概念进行工作。

频繁项集指在给定事务数据库中经常共同出现的项集。

Apriori算法由于其简洁明了和广泛应用而备受青睐。

其核心思想是利用先验信息来剪枝搜索空间。

2.3 Apriori算法步骤Apriori算法主要分为两个步骤:生成候选项集和计算频繁项集。

生成候选项集的过程可以通过迭代生成来实现。

首先,将事务数据库中的每个项作为1-项集。

apriori算法做题实例

apriori算法做题实例Apriori算法是一种用于发现数据集中频繁出现项集的方法。

它基于一种称为“Apriori原则”的假设,该原则认为如果一个项集是频繁的,那么它的所有子集也必须是频繁的。

这种原则允许我们使用底层的子集来快速确定更高层次的频繁项集。

下面以一个简单的实例来说明Apriori算法的应用。

假设我们有一个包含多个交易记录的超市数据集,每条记录包括不同种类的商品。

我们想要找出哪些商品最常一起被购买。

首先,我们需要确定最小支持度阈值,即在数据集中频繁出现项集的最小数量。

我们可以尝试几个不同的阈值,最终选择产生最有用结果的那个。

假设我们选择最小支持度为2,也就是说,项集需要在至少两个交易记录中出现才能被认为是频繁的。

接下来,我们执行第一次扫描数据集,统计每种商品在多少个交易记录中出现。

对于那些出现次数大于等于最小支持度的商品,我们将其作为长度为1的频繁项集。

假设有以下频繁项集:{牛奶}、{面包}、{啤酒}、{尿布}。

接着,我们执行第二次扫描数据集。

针对每个长度为2的项集,我们统计它出现在多少个交易记录中。

对于那些出现次数大于等于最小支持度的项集,我们将其作为长度为2的频繁项集。

假设有以下频繁项集:{牛奶,啤酒}、{牛奶,面包}、{面包,啤酒}、{面包,尿布}、{啤酒,尿布}。

接下来,我们可以继续执行这个过程,找到更长的频繁项集。

最终,我们可得到所有频繁项集,以及它们在多少个交易记录中出现。

最后,我们可以使用这些频繁项集来推断出哪些商品最常一起被购买。

例如,由于{牛奶,啤酒}是一个频繁项集,我们可以推断出有很多人会在一次购物中同时购买牛奶和啤酒。

总之,Apriori算法是一种有效的方法,用于在大型数据集中发现频繁项集。

该算法可以帮助我们理解哪些元素经常一起出现,并且可以用于许多领域,如市场营销、推荐系统等。

apriori 代码例子

apriori 代码例子Apriori是一种用于关联规则学习的算法,主要用于挖掘频繁项集和关联规则。

下面是一个简单的Python代码示例,演示如何使用Apriori算法进行关联规则学习。

# 导入相关库import pandas as pdfrom mlxtend.preprocessing import TransactionEncoderfrom mlxtend.frequent_patterns import apriorifrom mlxtend.frequent_patterns import association_rules# 加载数据集dataset = [['牛奶', '面包', '黄油'],['面包', '黄油', '花生酱'],['牛奶', '面包', '黄油', '花生酱'],['面包', '黄油'],['牛奶', '面包', '黄油', '鸡蛋']]# 数据预处理te = TransactionEncoder()te_ary = te.fit(dataset).transform(dataset)df = pd.DataFrame(te_ary, columns=te.columns_)# 使用Apriori算法找出频繁项集frequent_itemsets = apriori(df, min_support=0.6, use_colnames=True)# 生成关联规则rules = association_rules(frequent_itemsets, metric="confidence", min_threshold=0.7)# 输出结果print(frequent_itemsets)print(rules)在上面的代码中,我们首先使用Pandas库加载了一个简单的数据集,该数据集包含了5个交易的购物清单。

Apriori算法的改进及实例

Apriori算法的改进及实例Apriori算法是一种用于挖掘频繁项集的经典算法,它通过生成候选项集和剪枝的方式来减少搜索空间,从而高效地找到频繁项集。

随着数据规模的不断增大,Apriori算法的效率和性能也受到了挑战。

研究人员们提出了许多改进的方法,以提高Apriori算法的效率和性能。

本文将介绍一些Apriori算法的改进和实例。

1. Apriori算法改进之一:FP-growth算法FP-growth算法是一种基于树结构的频繁项集挖掘算法,它通过构建一棵FP树(频繁模式树)来表示数据集,从而避免了生成候选项集和多次扫描数据集的过程。

FP-growth算法的思想是先构建出数据集的FP树,然后利用FP树来挖掘频繁项集,从而避免了Apriori算法中生成候选项集的过程,大大提高了算法的效率。

下面是一个简单的FP-growth算法的实例:假设有如下的数据集:{1, 2, 3, 4},{1, 2, 4},{1, 2},{2, 3, 4},{2, 3},{3, 4},{2, 4}首先构建数据集的FP树:1) 第一次扫描数据集,统计每个项的支持度,得到频繁1项集{1, 2, 3, 4}和支持度{4, 7, 4, 6};2) 对频繁1项集根据支持度进行排序{4, 7, 6, 4},得到频繁1项集的顺序{3, 1, 4, 2};3) 第二次扫描数据集,创建FP树;4) 根据数据集创建FP树如下图所示:2/| \1 3 4| |4 4FP树的根节点是空集,根据第一次扫描数据集得到频繁1项集的顺序,依次插入树中。

接下来利用FP树来挖掘频繁项集:1) 首先从FP树的叶子节点开始,对于每一个项头表(item header table)中的项,按照条件模式基的方式来获取频繁项集;2) 对于每一个项头表中的项,从叶子节点到根节点回溯,得到条件模式基;3) 对于每一个条件模式基,利用条件FP树来获取频繁项集;4) 依次获取频繁项集{1, 2, 3, 4}、{2, 3, 4}、{2, 4}。

Apriori算法的改进及实例

Apriori算法的改进及实例

Apriori算法是一种数据挖掘中经典的关联规则挖掘方法。

它被广泛用于挖掘大量数据中的隐式关联,从而发现购物篮(market basket)分析中的频繁项集和关联规则。

随着数据处理能力和分析能力的不断提升,Apriori算法也不断出现改进版本,使其在实际的商业领域中有更好的应用和发挥。

1. 算法模型的改进

Apriori算法在计算复杂度方面有一定的缺陷。

若数据集是大量的,则计算费时会变得很长。

而如何加快Apriori算法的运算,也成为学习者所探讨的问题之一。

改进的Apriori算法通过层次划分处理数据,来加快其处理速度,从而增强其在实际应用中的可行性。

2. Apriori算法的改进实例

例如,若采用层次划分的Apriori算法来挖掘购物篮(market basket)分析中的频繁项集和关联规则,首先可以将数据集根据项数进行划分。

具体而言,若某个项集有n个项,则可以将其划分为n个子集,每个子集的项数均小于n。

然后,用Apriori算法计算每个子集中的支持度,再综合其结果,用Apriori算法得出最终的结果。

这样,可以大大提高Apriori算法的运算效率,从而加快关联规则的挖掘过程。

此外,其他对Apriori算法的改进还包括增加处理噪声数据等方法。

比如,人们可以使用深度学习和模式发现方法在做Apriori算法改进时,来处理杂讯和非结构型数据,以便找出更准确的频繁项集和关联规则。

如果能够成功地完成这项改进,将更加方便地挖掘大规模的市场数据,使得购买者与销售者之间的贴合度更加接近,以便更有效地挖掘出商业价值。

apriori算法例题详解

apriori算法例题详解Apriori算法是数据挖掘中比较常用的一种关联规则挖掘方法。

它的原理是通过一系列的频繁项集发现和剪枝来发现数据集中的规律关联性。

今天,我们来看一下Apriori算法的一个例题。

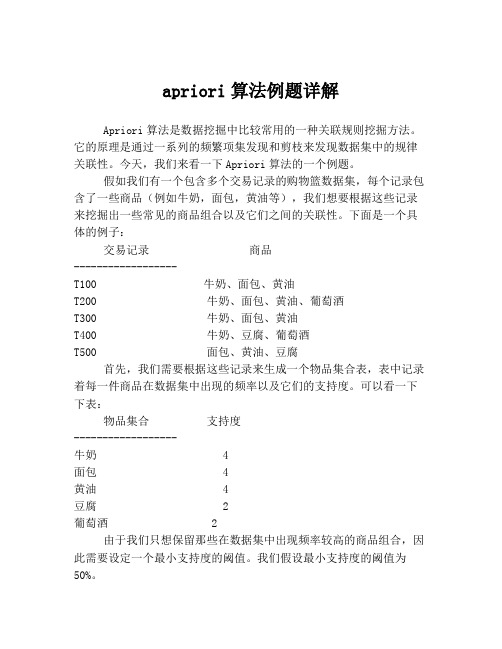

假如我们有一个包含多个交易记录的购物篮数据集,每个记录包含了一些商品(例如牛奶,面包,黄油等),我们想要根据这些记录来挖掘出一些常见的商品组合以及它们之间的关联性。

下面是一个具体的例子:交易记录商品------------------T100 牛奶、面包、黄油T200 牛奶、面包、黄油、葡萄酒T300 牛奶、面包、黄油T400 牛奶、豆腐、葡萄酒T500 面包、黄油、豆腐首先,我们需要根据这些记录来生成一个物品集合表,表中记录着每一件商品在数据集中出现的频率以及它们的支持度。

可以看一下下表:物品集合支持度------------------牛奶 4面包 4黄油 4豆腐 2葡萄酒 2由于我们只想保留那些在数据集中出现频率较高的商品组合,因此需要设定一个最小支持度的阈值。

我们假设最小支持度的阈值为50%。

接下来,我们可以使用Apriori算法来发现频繁项集。

Apriori算法的基本思路是,首先找出所有的频繁1项集(即单独的商品),然后通过组合形成频繁2项集,接着通过组合频繁2项集来形成频繁3项集,以此类推。

根据Apriori算法的原理,不可能存在一个k项集是不频繁的,同时它的所有子集都是频繁的。

因此,在生成候选k+1项集的时候,我们只需要保留那些所有k项子集都是频繁的候选项集,这样就避免了无意义的计算。

假设我们首先要找出频繁2项集。

根据上述物品集合表,我们可以获得所有的频繁1项集:{牛奶},{面包},{黄油},{豆腐},{葡萄酒}。

然后我们可以通过这些频繁1项集来生成候选2项集,如下表所示:候选2项集支持度------------------{牛奶,面包} 3{牛奶,黄油} 3{牛奶,豆腐} 1{牛奶,葡萄酒} 1{面包,黄油} 3{面包,豆腐} 1{面包,葡萄酒} 1{黄油,豆腐} 1{黄油,葡萄酒} 1{豆腐,葡萄酒} 0由于最小支持度的阈值为 50%,因此我们只需要保留那些支持度值大于等于 2 的候选2项集,如下表所示:频繁2项集支持度------------------{牛奶,面包} 3{牛奶,黄油} 3{面包,黄油} 3接下来,我们需要根据这些频繁2项集来找出频繁3项集。

关联规则apriori算法例题

关联规则apriori算法例题当谈到关联规则算法的例题时,Apriori算法是一个常见的选择。

这种算法用于从大规模数据集中挖掘频繁项集和关联规则。

下面是一个使用Apriori算法的例题:假设你是一家超市的数据分析师,你希望了解顾客购买商品之间的关联规则,以便为促销和产品摆放做出更明智的决策。

你有一份顾客购买商品的交易记录,如下所示:交易记录:Transaction 1: 面包, 牛奶Transaction 2: 面包, 薯片, 啤酒Transaction 3: 面包, 牛奶, 薯片, 可乐Transaction 4: 牛奶, 可乐Transaction 5: 面包, 薯片, 啤酒现在,你希望使用Apriori算法来挖掘频繁项集和关联规则。

假设最小支持度阈值为3(即一个项集在所有交易记录中至少出现3次),最小置信度阈值为0.5(即关联规则的置信度至少为50%)。

首先,我们需要找出频繁项集。

根据最小支持度阈值,项集在所有交易记录中至少出现3次才被认为是频繁项集。

以下是在此例中找出的频繁项集:频繁1-项集:{面包}: 4次{牛奶}: 3次{薯片}: 3次{可乐}: 2次{啤酒}: 2次频繁2-项集:{面包, 牛奶}: 3次{面包, 薯片}: 3次{面包, 可乐}: 2次{薯片, 可乐}: 2次根据频繁项集,我们可以生成关联规则,并根据最小置信度阈值筛选出符合要求的规则。

以下是在此例中找出的关联规则及其置信度:关联规则:{面包} => {牛奶} (置信度: 3/4 = 0.75){面包} => {薯片} (置信度: 3/4 = 0.75){面包} => {可乐} (置信度: 2/4 = 0.5){薯片} => {面包} (置信度: 3/3 = 1.0){薯片} => {可乐} (置信度: 2/3 ≈0.67){可乐} => {面包} (置信度: 2/2 = 1.0){可乐} => {薯片} (置信度: 2/2 = 1.0)通过Apriori算法,我们找到了一些频繁项集和关联规则。

apriori算法实例

apriori算法实例Apriori算法是数据挖掘领域中的一种经典算法,它用于频繁项集的挖掘。

该算法的核心思想是利用频繁项集的性质,通过逐层扫描事务数据库来产生候选项集和频繁项集。

我们来看一个简单的实例,假设我们有一个超市的销售数据,里面存储了顾客购买的商品信息,如下表所示:| 顾客ID | 购买的商品 ||--------|------------|| 1 | A, B, C || 2 | A, C, D || 3 | B, E || 4 | A, C, E |我们要利用Apriori算法来挖掘这个数据集中的频繁项集。

首先,我们需要设定一个最小支持度的阈值,以确定哪些项集是频繁的。

假设我们设置阈值为2,即一个项集在数据集中出现的次数必须不少于2次,才被认为是频繁的。

第一步,我们需要扫描整个数据集,统计每个项集出现的次数,并得到所有的频繁1项集。

在上面的数据集中,所有的1项集为{A}、{B}、{C}、{D}和{E},其中{A}、{B}和{C}的出现次数都不少于2次,因此它们是频繁的。

第二步,基于频繁1项集,我们可以产生所有的候选2项集。

具体来说,我们需要找到所有的大小为2的子集,来组成新的2项集。

在上面的数据集中,所有的候选2项集为{A,B}、{A,C}、{A,D}、{A,E}、{B,C}、{B,E}和{C,E}。

然后,我们需要扫描整个数据集,统计每个候选2项集出现的次数,并得到所有的频繁2项集。

在上面的数据集中,所有的频繁2项集为{A,C}和{C,E}。

第三步,基于频繁2项集,我们可以产生所有的候选3项集。

具体来说,我们需要找到所有的大小为3的子集,来组成新的3项集。

在上面的数据集中,所有的候选3项集为{A,C,E}。

然后,我们需要扫描整个数据集,统计每个候选3项集出现的次数,并得到所有的频繁3项集。

在上面的数据集中,所有的频繁3项集为{A,C,E}。

最终,我们得到了该数据集中的所有频繁项集,它们分别为{A}、{B}、{C}、{E}、{A,C}、{C,E}和{A,C,E}。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Apriori算法例子

Apriori算法例子

算法integerstringeach数据库c

1 Apriori介绍

Apriori算法使用频繁项集的先验知识,使用一种称作逐层搜索的迭代方法,k项集用于探索(k+1)项集。

首先,通过扫描事务(交易)记录,找出所有的频繁1项集,该集合记做L1,然后利用L1找频繁2项集的集合L2,L2找L3,如此下去,直到不能再找到任何频繁k项集。

最后再在所有的频繁集中找出强规则,即产生用户感兴趣的关联规则。

其中,Apriori算法具有这样一条性质:任一频繁项集的所有非空子集也必须是频繁的。

因为假如P(I)< 最小支持度阈值,当有元素A添加到I中时,结果项集(A∩I)不可能比I 出现次数更多。

因此A∩I也不是频繁的。

2 连接步和剪枝步

在上述的关联规则挖掘过程的两个步骤中,第一步往往是总体性能的瓶颈。

Apriori算法采用连接步和剪枝步两种方式来找出所有的频繁项集。

1)连接步

为找出Lk(所有的频繁k项集的集合),通过将Lk-1(所有的频繁k-1项集的集合)与自身连接产生候选k项集的集合。

候选集合记作Ck。

设l1和l2是Lk-1中的成员。

记li[j]表示li中的第j项。

假设Apriori算法对事务或项集中的项按字典次序排序,即对于(k-1)项集li,

li[1]<li[2]<……….<li[k-1]。

将Lk-1与自身连接,如果(l1[1]=l2[1])&&( l1[2]=l2[2])&&……..&a mp;& (l1[k-2]=l2[k-2])&&(l1[k-1]<l2[k-1]),那认为l1和l2是可连接。

连接l1和l2 产生的结果是

{l1[1],l1[2],……,l1[k-1],l2[k-1]}。

2)剪枝步

CK是LK的超集,也就是说,CK的成员可能是也可能不是频繁的。

通过扫描所有的事务(交易),确定CK中每个候选的计数,判断是否小于最小支持度计数,如果不是,则认为该候选是频繁的。

为了压缩Ck,可以利用Apriori性质:任一频繁项集的所有非空子集也必须是频繁的,反之,如果某个候选的非空子集不是频繁的,那么该候选肯定不是频繁的,从而可以将其从CK中删除。

(Tip:为什么要压缩CK呢?因为实际情况下事务记录往往是保存在外存储上,比如数据库或者其他格式的文件上,在每次计算候选计数时都需要将候选与所有事务进行比对,众所周知,访问外存的效率往往都比较低,因此Apriori加入了

所谓的剪枝步,事先对候选集进行过滤,以减少访问外存的次数。

)

3 Apriori算法实例交易ID

商品ID列表

T100

I1,I2,I5

T200

I2,I4

T300

I2,I3

T400

I1,I2,I4 T500

I1,I3

T600

I2,I3

T700

I1,I3

T800

I1,I2,I3,I5 T900

I1,I2,I3。