曙光高性能集群系统使用及管理-201408

高性能计算机和曙光GHPC1000集群系统.

系统整体配置

节点:

计算节点1(A620r-T): 43×2=86台 GPU显卡:GTX295

计算节点2(A620r-T): 16×2=32台 GPU显卡:C1060

IO节点(A620-H):1台

存储:

DS6310EE 容量:

1台 16TB

网络:

计算网:

Infiniband 36口IB交换机

集成ES1000图形控制器 32MB显存

600W 电源

可选IPMI管理卡

说明:均为Low Profile扩展卡。 可选1+1冗余电源

核心架构图

DS6310EE/DS6312EE

• SAS-SAS磁盘阵列,单控/双控; • 处理器:Intel IOP 341,主频1.2GHz • 接口 :每控制器 4个SAS 4×主机端口,1个SAS 4×扩展接口 • 驱动器接口 :SAS ,支持SAS/SATA硬盘 • Raid级别:0、1、1E、5、6、50、60 • 热插拔控制器;DS6310EE单控,DS6312EE冗余双控; 每控制器512

内存:16GB DDR2-667 硬盘:1×146GB SAS 热插拔 HBA:1×12Gb/s SAS 4x HBA卡 网络:2×千兆 IB:20Gb IB HCA

磁盘阵列

曙光DS6310EE盘阵(16T):

企业级存储系统,热插拔Raid控 制器

性能:4个SAS 4x主机通道 扩展性:最大扩展至80个驱动器 可靠性:Cache镜像及掉电保护 容量:16块1TB SATA磁盘

详见配置表

系统整体拓扑图

计算结点1:A620r-T

曙光GPU计算节点A620r-T:43台

GPU处理单元:1×Nvidia GTX295 GPU卡

云南大学高性能计算中心曙光集群系统使用指南

云南大学高性能计算中心曙光集群系统使用指南1、使用SSH客户端软件用在高性能计算中心申请的用户名和密码登录到集群系统(Windows系统可使用SSHSecureShellClient-3.2.9软件包,下载地址/structure/download Linux系统可直接使用ssh命令登录)。

登录成功后你所在的节点是登录节点,系统会有一些通知信息显示,操作提示符是[username@node34 ~]$。

这个节点是作用户帐号管理,不要在上面运行程序。

2、编译与调试程序请用rsh转到相关作业区节点。

本集群系统共有32个计算节点(每个节点有4个CPU 8G 内存),分为4个作业区。

小作业区small包含4个节点(node1..node4),中型作业区medium包含8个节点(node5..node13),专用作业区long包含8个节点(node13..node20),大作业区large包含12个节点(node21..node32)。

每一个作业区的第一个节点该作业区的服务节点,small为node1,medium为node5,long为node13,large为node21。

例如从登录节点转到一号节点:[hbli@node34 ~]$rsh node1Last login: Mon Aug 28 15:33:16 from node34[hbli@node1 ~]$3、编译链接、运行用户程序串行程序可使用GCC或PGI编译器,并行程序可使用mpicc, mpiCC, mpif77,mpif90进行编译。

以下是一个c使用mpi的例子:/* hello.c *//* MPI sample c program *//* compile "with mpicc -o hello hello" *//* run with "mpirun -np 8 hello" *//* or submit with pbs script "qsub hello.pbs" *//* you can use "qstat" to dislay your job statusa */#include <stdio.h>#include "mpi.h"int main( argc, argv )int argc;char **argv;{int rank, size;MPI_Init( &argc, &argv );MPI_Comm_size( MPI_COMM_WORLD, &size );MPI_Comm_rank( MPI_COMM_WORLD, &rank );printf( "Hello world from process %d of %d\n", rank, size );MPI_Finalize();return 0;}可以用如下命令对上面的程序进行编译:$ [hbli@node1 sample]mpicc –o hello hello.c生成可运行的文件hello,用ls –l 命令可以看到生成的可执行文件:$ [hbli@node1 sample]ls –l-rwxrwxr-x 1 hbli hbli 507375 Oct 10 10:39 hello-rw-r--r-- 1 hbli hbli 532 Jun 20 08:01 hello.c这样就可运行hello 这个程序了。

曙光航空航天高性能计算方案

曙光航空航天高性能计算方案摘要CFD-FASTRAN软件是由CFDRC公司与美国NASA联合开发的专门用于航空航天领域空气动力学计算的CFD软件,该软件可广泛应用于飞行器的亚、跨、超和高超音速的气动力学计算和一些特殊气体动力学问题如直升机旋翼、导弹发射、座舱弹射、投弹、机动和气动弹性等。

本文针对航空航天高性能计算提出了一套完整的集群解决方案,并在此平台上对FASTRAN并行性能进行了详细的测试。

测试结果表明,FASTRAN软件可以方便的部署和运行于曙光集群系统,并能够获得令人满意的加速比。

关键字CFD,FASTRAN,并行,航空航天1.FASTRAN介绍CFD-FASTRAN是CFDRC公司与美国NASA联合开发的专门用于航空航天领域空气动力学计算的CFD软件,在当前所有为航空航天设计的计算流体力学软件中位于前列,被广泛应用于飞行器的亚、跨、超和高超音速的气动力学计算和一些特殊气体动力学问题如直升机旋翼、导弹发射、座舱弹射、投弹、机动和气动弹性等。

CFD-FASTRAN 具有挑战性的功能是将基于密度的可压缩欧拉方程和N-S方程同多体运动力学、有限反应率化学和非平衡传热学耦合起来,解决一系列极为复杂的航空航天问题。

CFD-FASTRAN具有强大的技术优势,它体现在:@多年同美国国家航空和宇宙航行局(NASA),美国能源部(DOE),美国国家科学基金会(NSF)等机构的合作,使CFD-FASTRAN不断得到完善和发展。

@CFD-FASTRAN专门针对航空航天设计,可以计算包括超高速流动,移动体,气动热化学和气弹等复杂艰辛的课题。

@CFD-FASTRAN充分考虑了行业的需要,开发出航空航天工程师所需要的前处理、后处理程序。

正是基于上述原因,使得FASTRAN在全球拥有巨大的用户数量并获得了广泛的认可。

在美国军方,CFD-FASTRAN软件一直用于先进战斗机的设计,其中著名的应用案例包括F-16战斗机翼身气动弹性分析、Martin Baker MK16座椅弹射设计、F/A18杰达姆投弹模拟设计以及X34机高超音速激波模拟设计等,如下图所示。

曙光集群用户使用手册

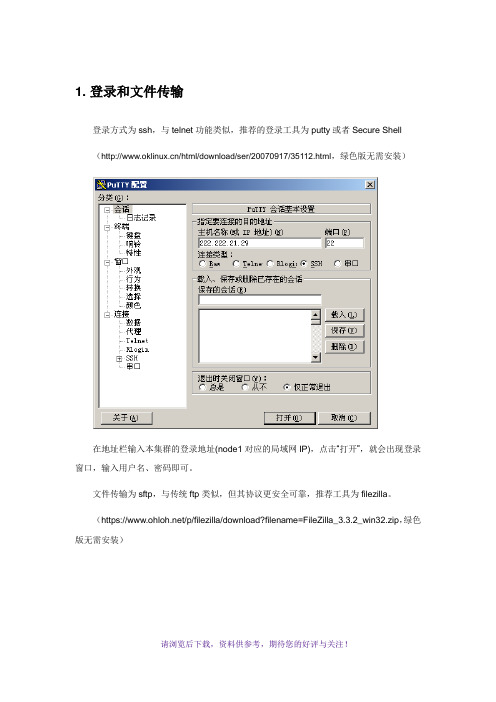

1. 登录和文件传输登录方式为ssh,与telnet功能类似,推荐的登录工具为putty或者Secure Shell (/html/download/ser/20070917/35112.html,绿色版无需安装)在地址栏输入本集群的登录地址(node1对应的局域网IP),点击“打开”,就会出现登录窗口,输入用户名、密码即可。

文件传输为sftp,与传统ftp类似,但其协议更安全可靠,推荐工具为filezilla。

(https:///p/filezilla/download?filename=FileZilla_3.3.2_win32.zip,绿色版无需安装)输入登录地址222.222.21.29,输入用户名和密码,端口填22(本软件支持ftp,端口为21),点击快速连接,即可使用,操作办法与常用ftp工具类似。

2. 图形窗口支持Linux推荐使用vnc。

vnc可以将用户的操作状态保持在服务器端,即使断开连接也不会影响到正在进行的操作、计算等。

登录到linux服务器中,在命令行运行vncserver。

第一次运行时需要输入VNC登陆用的密码:根据提示输入新的vnc密码。

此密码与用户登录密码无关,将在登录vnc时需要。

此处提示的node1:2即为vnc成功打开的端口。

运行vncclient,输入登录服务器地址和端口号,点确定,输入前面设置的密码,即进入了图形窗口。

注意:1、在第一次启动了vncserver之后,vnc的连接一直可用,全部图形窗口保持在Linux 服务器上。

因此,只在每次服务器重新启动后运行一次vncserver即可,由于用户较多,请勿启动多个。

2、如果需要使用node2的图形界面,可执行ssh -X node2。

3. 作业提交3.1. Fluent3.1.1. 图形方式运行首先通过VNC登陆到图形界面,如果没有Terminal的话在桌面点击左键选择Xterm,输入以下命令即可运行:此处myhosts为用户指定的host文件,内容如下所示:node1node1node1node1node2node2node2node2-t8即指定8个核心参与计算,分别为node1上的4个核心和node2上的4个核心。

曙光集群简明使用手册ppt课件

2020/2/20

曙光集群系统使用和管理

8/56

集群系统的体系结构

2020/2/20

曙光集群系统使用和管理

9/56

集群系统的物理架构

(InfiniBand)

2020/2/20

曙光集群系统使用和管理

10/56

曙光集群的计算系统

计算节点

一般为双路或四路 刀片或机架式服务 器,为计算系统的 主力。

SMP 胖节点 一般用于一些有大 内 多存核内、处容高理I的O需或求单,机 满足一些特殊应用 的需求。

计算 系统

2020/2/20

曙光集群系统使用和管理

GPGPU节点

GPU即图形处理单元, GPGPU的意思为使用显 卡做通用计算,由于 GPU卡具有更多计算核 心数,更高的能效比和 更强的浮点计算能力, 所以对于适合GPU,并 在GPU上移植成功的应 用软件提供更高的性能

14/56

曙光集群网络拓扑图(示例)

2020/2/20

曙光集群系统使用和管理

15/56

曙光集群用户视图(示例)

2020/2/20

曙光集群系统使用和管理

16/56

三、曙光集群的使用

• 远程登录系统 • 上传下载数据 • Linux常用命令 • 安装和运行程序 • 使用作业调度

2020/2/20

曙光集群系统使用和管理

VNC是一款优秀的远程控制工具软件,由AT&T的欧洲研究实验室开 发,是基于UNIX和Linux操作系统的免费开放源码软件,远程控制能 力强大,高效实用。

11/56

曙光集群功能节点

管理节点

•用于运行系统级的管 理软件,性能要求不 高,但可靠性要求高, 数量少

高性能集群系统并行环境配置手册

高性能集群系统并行环境配置手册前提:1.在本文中,举例集群中的控制节点的名字为:mu01,计算节点的名字为:cu01、cu02……2.实施之前,需要把selinux关掉,把kerberos的rsh屏蔽掉,方法:关闭selinux:cd /etc/selinuxvi config 改为:SELINUX=disabled屏蔽rshcd /usr/kerberos/binmv rsh rsh.original以上操作需要在所有机器上执行,完成以上操作后需要把机器重起一下。

一、配置rsh开启root用户对所有节点的rsh权限1、编辑/etc/hosts,加入所有(包括本机的)节点的ip地址和对应的计算机名;此文件在一台机器上编辑完毕可以拷贝到别的节点上使用;注意127.0.0.1这一行不要动,否则会影响到nis的正常使用。

例如:192.168.0.100 mu01192.168.0.1 cu01192.168.0.2 cu022、编辑/root/.rhosts和/etc/hosts.equiv,加入所有节点的计算机名例如:mu01cu01cu023、开启rsh服务:setup→system services→[*]rsh[*]rlogin[*]rexec去掉sendmail(影响OS启动速度,并非必需)。

4、编辑/etc/securetty,加入rsh,rexec,rlogin(在文件后面添加就可以)5、重起服务service xinetd restartrsh的配置需要在所有节点上进行。

二、ssh的配置方法1、在mu01上以root登录,然后运行ssh-keygen –t dsa,目的是简单的在/root下创建目录.ssh,当提示输入passphase时打入两次回车。

这将生成/root/.ssh/id_dsa和/root/.ssh/id_dsa.pub2、在cu01上以root登录,运行ssh-keygen –t dsa,然后在mu01上运行scp/root/.ssh/ id_dsa.pub cu01:/root/.ssh/authorized_keys2,在cu01的/root/.ssh/目录下运行cat id_dsa.pub 〉〉authorized_keys2,再运行scp authorized_keys2 cu02:/root/.ssh/3、在cu02的/root/.ssh/目录下运行cat id_dsa.pub 〉〉authorized_keys2,再运行scp authorized_keys2 cu03:/root/.ssh/4、重复以上步骤在后面结点上,在最后的计算节点上将生成一个完整的authorized_keys2文件,然后把authorized_keys2文件用scp命令拷贝到其余所有节点的/root/.ssh/目录下,ssh配置完成。

曙光服务器典型配置

曙光服务器典型配置曙光服务器是一种高性能、稳定可靠的服务器,广泛应用于各个行业领域。

在进行服务器配置的过程中,合理选择和搭配不同的硬件和软件是非常重要的。

本文将介绍曙光服务器的典型配置,包括硬件和软件方面的内容。

一、硬件配置1. 处理器曙光服务器采用Intel Xeon系列处理器,这是一款专为服务器设计的高性能处理器。

其拥有强大的计算能力和多核心技术,能够满足大规模计算和数据处理的需求。

处理器的选择应根据服务器用途和预算来决定,不同型号的处理器有着不同的性能和价格。

2. 内存内存是服务器性能的关键因素之一。

曙光服务器通常配备大容量的内存,以确保服务器能够高效地处理大量的数据和请求。

一般来说,服务器内存的容量应该根据实际需求来选择,同时考虑到扩展性和可靠性。

3. 存储曙光服务器常采用固态硬盘(SSD)作为主要存储介质,以提供更高的读写速度和更好的稳定性。

此外,还可以配置多个硬盘进行数据冗余备份,以保证数据的安全性。

存储容量的大小应根据实际需求来确定,同时要考虑到性能和可靠性。

4. 网卡曙光服务器通常配备高速网卡,以提供快速的网络连接和高效的数据传输。

网卡的选择应根据服务器应用场景和网络需求来确定,例如千兆以太网、万兆以太网等。

5. 电源供应曙光服务器应配备稳定可靠的电源供应系统,以提供持续稳定的电力支持。

同时,应考虑到能源效率和电力管理等方面的要求,以提高服务器的整体性能。

二、软件配置1. 操作系统曙光服务器可以选择不同的操作系统,如Windows Server、Linux 等。

操作系统的选择应根据实际需求和个人偏好来确定,其中Linux是一种常用的选择,具有高度的稳定性和安全性。

2. 数据库管理系统曙光服务器的配置还需要考虑数据库管理系统(DBMS),如MySQL、Oracle等。

DBMS负责管理和存储大量的数据,并提供对数据的高效访问和查询功能。

根据具体需求选择适合的DBMS版本和配置参数,以提升数据库性能和可靠性。

高性能计算机和曙光集群系统

什么是高性能计算?

计算科学与传统的两种科学,即理论科学和实 验科学,并立被认为是人类认识自然的三大支 柱,他们彼此相辅相成地推动科学发展与社会 进步。在许多情况下,或者是理论模型复杂甚 至理论尚未建立,或者实验费用昂贵甚至无法 进行时,计算就成了求解问题的唯一或主要的 手段。

为什么要做高性能计算 ——应用需求

高性能计算机和曙光机群系统

提纲

什么是高性能计算 什么是高性能计算机 集群系统

什么是高性能计算?

高性能计算

HPC:High Performance Compute

高性能计算---并行计算

并行计算(Parallel Computing) 高端计算(High-end Parallel Computing) 高性能计算(High Performance Computing) 超级计算(Super Computing)

分布式共享存储系统(DSM) 分布式共享存储系统

• DSM

– 分布共享存储: 内存模块物理上局 部于各个处理器内部,但逻辑上(用 户)是共享存储的; 这种结构也称 为基于Cache目录的非一致内存访 问(CC-NUMA)结构;局部与远程内存 访问的延迟和带宽不一致,3-10倍 高性能并行程序设计注意; – 与SMP的主要区别:DSM在物理上有 分布在各个节点的局部内存从而形 成一个共享的存储器; – 微处理器: 16-128个,几百到千亿 次; – 代表: SGI Origin 2000, Cray T3D;

机群系统(Cluster) 机群系统

• Cluster

– 每个节点都是一个完整的计算 机 – 各个节点通过高性能网络相互 连接 – 网络接口和I/O总线松耦合连 接 – 每个节点有完整的操作系统 – 曙光2000、 3000、4000, ASCI Blue Mountain

曙光集群用户使用手册样本

1. 登录和文件传输登录方式为ssh, 与telnet功能类似, 推荐的登录工具为putty或者Secure Shell( , 绿色版无需安装)在地址栏输入本集群的登录地址(node1对应的局域网IP), 点击”打开”, 就会出现登录窗口, 输入用户名、密码即可。

文件传输为sftp, 与传统ftp类似, 但其协议更安全可靠, 推荐工具为filezilla。

( , 绿色版无需安装)输入登录地址222.222.21.29, 输入用户名和密码, 端口填22( 本软件支持ftp, 端口为21) , 点击快速连接, 即可使用, 操作办法与常见ftp工具类似。

2. 图形窗口支持Linux推荐使用vnc。

vnc能够将用户的操作状态保持在服务器端, 即使断开连接也不会影响到正在进行的操作、计算等。

登录到linux服务器中, 在命令行运行vncserver。

第一次运行时需要输入VNC登陆用的密码:根据提示输入新的vnc密码。

此密码与用户登录密码无关, 将在登录vnc时需要。

此处提示的node1:2即为vnc成功打开的端口。

运行vncclient, 输入登录服务器地址和端口号, 点确定, 输入前面设置的密码, 即进入了图形窗口。

注意:1、在第一次启动了vncserver之后, vnc的连接一直可用, 全部图形窗口保持在Linux服务器上。

因此, 只在每次服务器重新启动后运行一次vncserver即可, 由于用户较多, 请勿启动多个。

2、如果需要使用node2的图形界面, 可执行ssh -X node2。

3. 作业提交3.1. Fluent3.1.1. 图形方式运行首先经过VNC登陆到图形界面, 如果没有Terminal的话在桌面点击左键选择Xterm, 输入以下命令即可运行:此处myhosts为用户指定的host文件, 内容如下所示:node1node1node1node1node2node2node2node2-t8即指定8个核心参与计算, 分别为node1上的4个核心和node2上的4个核心。

clusconf-1.5.1用户手册

1. 测试全网是否完全通过 (--test-net|-tn) 2. 显示集群信息 (--sys-info|-si) 3. 显示整个集群的 cpu 负载(负载大于 5%的进程) (--disp-cpu|-dc) 4. 同步整个集群的用户 (--sync-user|-yu) 5. 添加一个用户到整个集群 (--useradd|--adduser|-au|-ua username) 6. 删除一个用户到整个集群 (--deluser|--uerdel|-du|-ud username) 7. 同步整个集群的时间 (--sync-time|-yt)

8. 同步整个集群的某个文件 (--sync-file|-yf file|files|path|paths) 9. 在整个集群上执行相同的命令 (--sync-do|-yd command)

2.3 IPMI 配置及管理功能

1. 配置 ipmi IP 地址(--set-ipmi|-si) 2. 显示 ipmi 的 IP 地址及显示电源状态(--ipmi-info|-ii) 3. IPMI 远程开机(--ipmi-poweron|-in) 4. IPMI 远程关机(--ipmi-poweroff|-if) 5. IPMI 远程智能开机,可根据集群的角色自动规划开机顺序(--ipmi-ipoweron|-iin) 6. IPMI 远程智能关机,可根据集群的角色自动规划开机顺序(--ipmi-ipoweroff|-iif)

4.3配置 nfs.cfg 文件

如果需要给集群配置 nfs,使用(--set-nfs) 或一键配置集群(--set-all)中调用配置 nfs 的功 能(详情查看 5.2),需要编辑<installdir>/etc/nfs.cfg 文件,默认为/opt /clusconf/etc/nfs.cfg,配置 如下:

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

目录

使用 Gridview和ClusPortal 提交和管理作业

集群系统的管理与维护 集群系统的登录方式 程序编译与作业提交

使用 Gridview 和 Clusportal

应用模板

队列管理

策略管理 作业提交

用户记账

作业管理

调度器管理 用户管理 节点管理

使用 Gridview 和 Clusportal

cd $PBS_O_WORKDIR LOGFILE=openmpi.log NP=`cat $PBS_NODEFILE|wc -l`

echo my job id is $PBS_JOBID | tee $LOGFILE echo run nodes is following: | tee -a $LOGFILE cat $PBS_NODEFILE | tee -a $LOGFILE

#PBS -l nodes=1:ppn=1 表示申请1个节点上的1颗CPU。

#PBS -q serial 表示提交到集群上的serial队列。

并行脚本示例(openmpi for cpi)

#PBS #PBS #PBS #PBS -N -l -j -l openmpi nodes=1:ppn=8 oe walltime=2:00:00

$ ssh username@登录节点IP地址

Linux 用户可直接在命令行终端中执行ssh命令登录

文件上传下载

Windows 用户可使用SSH Secure Shell Client,Xftp, WinScp 等软件实现文件的上传下载 推荐使用SSH Secure Shell Client

简单脚本提交示例:

$ vim test.pbs $ qsub test.pbs

PBS 作业提交步骤

准备:编写描述改作业的脚本,包括作业名,需要的资源等。 提交:使用qsub命令将该作业提交给PBS服务器

排队:服务器将该任务排入适当的队列

调度:服务器检查各工作节点的状态是否符合该作业的要求,并进 行调度。 执行:当条件满足时,作业被发给相应的执行服务器执行。程序运 行时执行服务器会收集程序的标准输出和标准错误流,等程序结束 时,将这些信息返回给用户。 查询和调整:当作业在运行时,用户可以使用qstat进行状态查询。 用户发现作业提交错误时,可以使用qdel删除正在运行的作业。 查看结果:使用文本编辑软件vi或者系统命令cat, less等查看输出及 错误信息显示。

并行程序的编译运行(openmpi)

编译程序: $ source /public/software/profile.d/openmpi-intel-env.sh $ mpicc -o hello hello.c $ mpif90 -o hello hello.f90 运行程序:OpenMPI 使用自带的 OpenRTE 进程管理器,启动命令为 mpirun/mpiexec/orterun,基本格式如下:

export PATH=/home/your_account/your_workdir:$PATH

并行程序的编译运行(openmpi)

OpenMPI 提供了C/C++,Fortran等语言的MPI编译器,如下表: 语言类型 C C++ Fortran77 Fortran90 MPI编译器 mpicc mpicxx mpif77 mpif90

$ cat TORQUEHOME/server_priv/nodes

node01 np=4 server dualcore ib

node02 np=8 bigmem matlab ib ……

#PBS -l nodes=2:blue:ppn=2+red:ppn=3+b1014

#PBS -l nodes=4:ppn=4,mem=200mb #PBS -l other=matlab

qorder <作业号1> <作业号2> qmove <队列名> <作业号> qalter -l <所需资源> <作业号> qhold <作业号> qrls <作业号> qsub -N <作业名> -l <所需资源> -q <队列名> <PBS作业脚本>

PBS 资源的申请

#PBS -l mem=200mb #PBS -l walltime=01:00:00 #PBS -l nodes=1:ppn=4 #PBS -l nodes=4:ppn=2 #PBS -l nodes=node01+node02+node03 #PBS -l nodes=server:ib+3:bigmem:ib

-a:列出所有结点及其属性,属性包括“state”和“properties” -l:以行的方式列出被标记的结点的状态,如 -l free,-l offline -o:将指定结点的状态标记为“offline”(管理员) -c:清除结点列表中的“offline”状态设置,使结点可用(管理员) -r:重设“offline”或ቤተ መጻሕፍቲ ባይዱdown”的节点的状态,如果可用,设为free(管理员)

普通用户可以做什么?

普通用户可以做什么?

使用 Clusportal 提交作业

多个集群

完善的 参数

运行程序的命令及PBS环境变量设置组成PBS作业脚本,格式如下: • • • • 注释以“#”开头 PBS指令以“#PBS”开头 SHELL命令 运行程序的命令及PBS #PBS -N test #PBS -l nodes=1:ppn=1 #PBS -l walltime=12:00:00 #PBS -q batch cd $PBS_O_WORKDIR mpirun ./test.exe

$ scp 文件名 username@登录节点IP地址:文件路径

Linux 用户可直接在命令行终端中执行scp命令登录

图形界面登录(远程桌面)

远程图形界面登录推荐使用VNC方式。

第一次使用VNC登录前,需要先以命令行终端方式登录到集群登录节点,执行 vncserver命令,会提示用户输入VNC登录密码,输入后会得到一个VNC会话, 一般是“主机名:VNC会话号”格式,如“node32:4”。

echo begin time is `date` | tee -a $LOGFILE mpirun -np $NP -hostfile $PBS_NODEFILE --mca orte_rsh_agent ssh --mca btl self,openib,sm ./cpi 2>&1 | tee -a $LOGFILE echo end time is `date` | tee -a $LOGFILE

Windows 用户推荐使用RealVNC软件,登录时输入集群 登录节点IP地址加VNC会话号即可:

$ vncviewer [登录节点IP地址]:[session number]

Linux 用户可直接在命令行终端中执行 vncviewer 命令

Gridview Web 登录

普通用户可通过Web方式登入曙光GridView集群管理系统, 进行查看、监控、和使用等操作。 在浏览器中输入以下URL即可出现登录界面:

$PBS_QUEUE

串行脚本示例

#PBS #PBS #PBS #PBS #PBS -N -l -j -l -q serial nodes=1:ppn=1 oe walltime=60:00:00 serial

echo "This jobs is "$PBS_JOBID@$PBS_QUEUE cd ${PBS_O_WORKDIR} echo begin time is `date` sleep 100 hostname echo end time is `date`

曙光高性能集群管理及使用

解决方案中心 2014 年 8 月

目录

集群系统的登录方式

程序编译与作业提交 使用 Gridview和ClusPortal 提交和管理作业 集群系统的管理与维护

命令行终端登录

Windows 用户可以用SSH Secure Shell Client,Xshell, PuTTY,SecureCRT 等 SSH客户端软件登录。 推荐使用SSH Secure Shell Client

PBS的基本命令

qmgr -c 'p s' 此命令可以查看作业调度系统的配置信息; qstat –q 该命令可以查看系统中存在的队列,qstat还有其他参数比较常用:

-B:列出PBS服务器的相关信息 -Q:列出队列的一些限制信息 -an:列出队列中的所有作业及其分配的节点 -r:列出正在运行的作业 -f jobid:列出指定作业的详细信息 -Qf queue:列出指定队列的所有信息

PBS 常用环境变量

变量名 登陆SHELL继承来的变量 $PBS_O_HOST $PBS_O_QUEUE $PBS_O_WORKDIR $PBS_JOBID $PBS_JOBNAME $PBS_NODEFILE 说 明

$HOME,$LANG,$PATH,$MAIL,$SHELL等

qsub 提交的节点名称 qsub 提交的作业的最初队列名称 qsub 提交的作业的绝对路径 作业被PBS系统指定的作业号 用户指定的作业名,可以在作业提交的时候用qsub –N <作业名 >指定,或者在PBS脚本中加入#PBS –N <作业名>。 PBS系统指定的作业运行的节点名。该变量在并行机和机群中使 用。当在PBS脚本中用#PBS –l nodes=2:ppn=2指定程序运 行的节点数时,可以使用$PBS_NODEFILE在脚本中引用PBS 系统指定的作业运行的节点名。比如: #PBS –l nodes=2:ppn=2 mpirun –np 4 –machinefile $PBS_NODEFILE <程序名> PBS脚本在执行时的队列名