文献翻译(1)

单片机外文文献 (1)

单片机系统广义地说,微处理系统是用于处理信息的,这种信息可以是电话交谈,仪器读数或企业帐户,但是各种情况下都涉及相同的主要操作:信息处理、存储和传递。

在常规的电子设计中,这些操作都是以功能平台方式组合起来的,例如计数器,无论是电子还是机械的,都要存储当前值,并按要求将该值增1。

诸如采用计数器的电子钟之类的任一系统要使其存储和处理能力遍布整个系统,因为每个计数器都能存储和处理一些数字。

当前微处理化系统与上述的常规方法不同,它将处理,存储和传输三个功能分离形成不同的系统单元。

这种形成三个主要单元的分离方法是冯-诺依曼在20世纪40年代所设想出来的,并且是针对微计算机的设想。

从此几乎所有制成的计算机都是用这种结构设计的,尽管包含宽广的物理形式,从根本上来说他们均是具有相同的基本设计。

在微处理器系统中,处理是由微处理器本身完成的。

存储是利用存储器电路,而进入和出自系统的信息传输则是利用特定的输入/输出(I/O)电路。

要在一个微处理器化时钟中找出执行计数功能的一个特殊硬件是不可能的,因为时间存储在存储器中,而在固定的时间间隔下由微处理器控制增值。

但是,规定系统运转过程的软件包含实现计数器功能的单元。

由于系统几乎完全由软件所定义,所以对微处理器结构和其辅助电路这种看起来非常抽象的处理方法使其在应用时非常灵活。

这种设计过程主要是软件工程,而且在生产软件时,就会遇到产生于常规工程中相似的构造和维护问题。

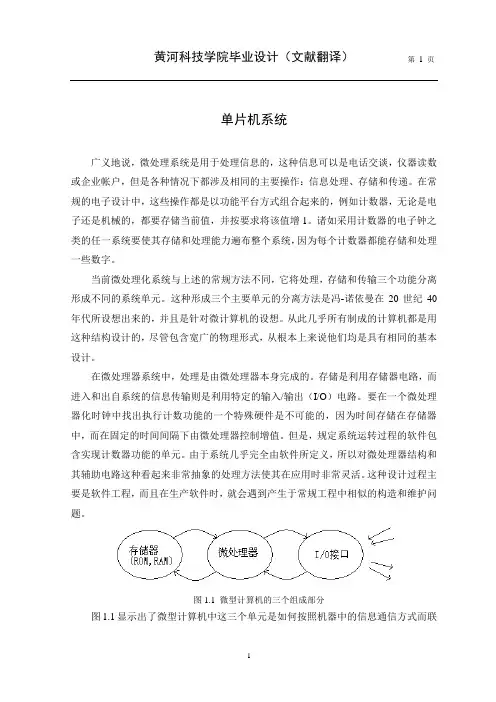

图1.1 微型计算机的三个组成部分图1.1显示出了微型计算机中这三个单元是如何按照机器中的信息通信方式而联接起来的。

该系统由微处理器控制,它管理自己与存储器和输入/输出单元的信息传输。

外部的连接与工程系统的其余部分(即非计算机部分)有关。

尽管图中显示的只有一个存储单元,实际中有RAM和ROM两种不同的存储器被使用。

由于概念上的计算机存储器更像一个公文柜,上述的“存储器”一词是非常不恰当的;信息存放在一系列已标号的“箱子”中,而且可按问题由“箱子”的序列号进行信息的参考定位。

文献翻译(中文)

翻译发达国家的环保政策在过去几十年有了显着进步。

早期的污染控制方案包括指挥和控制方法。

之后国家的相关政策中经常包括排污收费,排污权交易等市场基础的手段。

最近,“第三次环境政策的浪潮”已出现,强调环境信息披露是作为风险缓解战略的重要组成部分。

在这里,(更多的)政府的监管是为了取代或推定协助更多有效成本的私营市场和法律的力量公开提供的资料补充。

常见的例子包括有毒物质释放库存,含铅油漆解散关闭,饮用水水质告示,以及生态标签。

这种方案按照经验来看非常有效,但是,还有很大程度上的不确定性。

本文考察了著名的大型电力公用事业公司的燃料混合比例强制披露方案的影响。

强制性信息披露政策不仅仅限于环境领域。

例如,经合组织国家的股市通常需要企业财务信息的披露。

在许多国家,农业产品需要原籍国和其他健康标签。

餐厅的增加,需要卫生显示卡。

国内高校的法律规定,告知犯罪统计资料,公平和未来的学生当前数据和能力指标。

即使重大医疗差错,现在必须向社会公布。

有一些政策提出了信息披露的潜在优势,相关理论也表明披露程序,可以有效地实现企业的目标。

希利和佩普(2001)提供了在资本市场的证据调查。

Brouhle和卡纳(2007年)表明,提供信息可以提高产品质量。

在环境方面,肯尼迪埃塔尔。

(1994年),阿罗拉和Gangopadhyay(1999),麦克斯韦埃塔尔。

(2000年),柯彻夫(2000年)和卡纳(2001)表明,对污染信息提供可能纠正市场失灵,提高性能,并改善社会福利。

尽管有许多关于信息披露的相关文献的理论研究结果,披露方案的经验影响仍然没有起到很好的效果。

证券监管的早期研究发现不同的结果。

见斯蒂格勒(1964年),罗宾斯和Werner(1964),和斯顿(1973年)。

更加近期的文献表明,在金融市场披露程序可以实现其预期的效果;拉波塔等。

(2006)和绿宝石等。

(2006年)发现,市场规模和市场回报具有正面的强制披露方案的影响。

文献翻译 译文+原文

09届本科毕业设计(论文)外文文献翻译学 院: 物理与电子工程学院专 业: 光电信息工程姓 名: 徐 驰学 号: Y05209222 外文出处: Surface & Coatings Technology214(2013)131-137附 件: 1.外文资料翻译译文;2.外文原文。

(用外文写)附件1:外文资料翻译译文气体温度通过PECVD沉积对Si:H薄膜的结构和光电性能的影响摘要气体温度的影响(TG)在等离子体增强化学气相沉积法(PECVD)生长的薄膜的结构和光电特性:H薄膜已使用多种表征技术研究。

气体的温度被确定为制备工艺的优化、结构和光电薄膜的性能改进的一个重要参数。

薄膜的结构性能进行了研究使用原子力显微镜(AFM),傅立叶变换红外光谱(FTIR),拉曼光谱,和电子自旋共振(ESR)。

此外,光谱椭偏仪(SE),在紫外线–可见光区域的光传输的测量和电气测量被用来研究的薄膜的光学和电学性能。

它被发现在Tg的变化可以修改的表面粗糙度,非晶网络秩序,氢键模式和薄膜的密度,并最终提高光学和电学性能。

1.介绍等离子体增强化学气相沉积法(PECVD)是氢化非晶硅薄膜制备一种技术,具有广泛的实际应用的重要材料。

它是用于太阳能电池生产,在夜视系统红外探测器,和薄膜晶体管的平板显示装置。

所有这些应用都是基于其良好的电气和光学特性以及与半导体技术兼容。

然而,根据a-Si的性质,PECVD制备H薄膜需要敏感的沉积条件,如衬底温度,功率密度,气体流量和压力。

许多努力已经花在制备高品质的薄膜具有较低的缺陷密度和较高的结构稳定性的H薄膜。

众所周知,衬底温度的强烈影响的自由基扩散的生长表面上,从而导致这些自由基更容易定位在最佳生长区。

因此,衬底温度一直是研究最多的沉积参数。

至于温度参数在PECVD工艺而言,除了衬底温度,气体温度(Tg)美联储在PECVD反应室在辉光放电是定制的a-Si的性能参数:H薄膜的新工艺。

外文文献翻译译稿和原文

外文文献翻译译稿1卡尔曼滤波的一个典型实例是从一组有限的,包含噪声的,通过对物体位置的观察序列(可能有偏差)预测出物体的位置的坐标及速度。

在很多工程应用(如雷达、计算机视觉)中都可以找到它的身影。

同时,卡尔曼滤波也是控制理论以及控制系统工程中的一个重要课题。

例如,对于雷达来说,人们感兴趣的是其能够跟踪目标。

但目标的位置、速度、加速度的测量值往往在任何时候都有噪声。

卡尔曼滤波利用目标的动态信息,设法去掉噪声的影响,得到一个关于目标位置的好的估计。

这个估计可以是对当前目标位置的估计(滤波),也可以是对于将来位置的估计(预测),也可以是对过去位置的估计(插值或平滑)。

命名[编辑]这种滤波方法以它的发明者鲁道夫.E.卡尔曼(Rudolph E. Kalman)命名,但是根据文献可知实际上Peter Swerling在更早之前就提出了一种类似的算法。

斯坦利。

施密特(Stanley Schmidt)首次实现了卡尔曼滤波器。

卡尔曼在NASA埃姆斯研究中心访问时,发现他的方法对于解决阿波罗计划的轨道预测很有用,后来阿波罗飞船的导航电脑便使用了这种滤波器。

关于这种滤波器的论文由Swerling(1958)、Kalman (1960)与Kalman and Bucy(1961)发表。

目前,卡尔曼滤波已经有很多不同的实现。

卡尔曼最初提出的形式现在一般称为简单卡尔曼滤波器。

除此以外,还有施密特扩展滤波器、信息滤波器以及很多Bierman, Thornton开发的平方根滤波器的变种。

也许最常见的卡尔曼滤波器是锁相环,它在收音机、计算机和几乎任何视频或通讯设备中广泛存在。

以下的讨论需要线性代数以及概率论的一般知识。

卡尔曼滤波建立在线性代数和隐马尔可夫模型(hidden Markov model)上。

其基本动态系统可以用一个马尔可夫链表示,该马尔可夫链建立在一个被高斯噪声(即正态分布的噪声)干扰的线性算子上的。

系统的状态可以用一个元素为实数的向量表示。

能源类外文文献翻译(译文1)

太阳能蒸馏:一种有前途的供水代替技术,它使用免费的能源,技术简单,清洁Hassan E.S.Fath埃及,亚历山大,亚历山大大学机械学院工程系摘要:太阳能蒸馏为盐水淡化提供了一种替代技术,它使用免费的能源、技术简单、清洁,为人类提供所需的部分淡水。

太阳能蒸馏系统的发展已经证明:当天气情况良好,并且需求不太大时,比如少于200立方米/天,它在海水淡化过程中有一定的适用性。

太阳能蒸馏器的产量低这个问题迫使科学家研究许多提高蒸馏器产量和热效率,以此来降低产水的费用。

本文对许多最新发展的单效和多效太阳能蒸馏器进行了整体评论和技术评估。

同时,对蒸馏器构造的发展、各部件在运行过程中出现的问题、对环境的影响也进行了阐述。

关键词:太阳能;海水淡化1.简介在淡水需求超出了淡水资源所能满足的量的地方,对低质量的水进行去盐处理是一种合适的淡水来源途径。

对盐水或海水脱盐处理取得淡水满足了社会基本的需求。

一般说来,它不会对环境造成严重的损害作用。

因此,进行海水淡化的工序和工厂在数量上和能力上都有了巨大的进步。

许多不同的海水淡化技术被用来从盐水中分离淡水,包括有:多级闪蒸(MSF)、多效(ME)、蒸汽压缩(VC)、反渗透(RO)、离子交换、电渗析、相变和溶剂萃取。

但是,这些技术只能产生少量的淡水,因而是昂贵的。

另一方面,用来驱动这些技术的传统能源也会对环境产生消极的作用。

而太阳能蒸馏为盐水淡化技术提供了一种有前途的替代处理过程,它使用免费的能源,技术简单,清洁,并能为人类提供所需的部分淡水。

太阳能蒸馏系统的发展已经证明:当天气情况良好,并且需求不太大时,比如少于200立方米/天,它在海水淡化过程中有一定的适用性。

太阳能蒸馏器的产量和热效率,以此来最小化产水费用。

这些方法中包括被动的和主动的单效蒸馏器。

一些工作者也曾试图都产生的水蒸气在外部凝结(在额外的凝结表面上)。

另一方面,浪费的凝结潜热也被利用,从而增加馏出水的产量和提高效率。

翻译文献(1)(1)

翻译文献(1)(1)费兰德斯和荷兰水体中的优先有机污染物和用纳滤膜去除的可行性的评估摘要有机微污染物在地下水和地表水中的发现已经成为饮用水工业非常关注的问题,主要由于其可能的健康影响,由于这些污染物的极性,导致它们用传统的水处理栅栏无法完全去除,这篇论文综述了优先有机微污染物及它们在费兰德斯和荷兰的水体中的出现,此外,用纳滤膜去除的废弃物是对筛选优先微污染的定性预测,这个定性的预测是依据重要的溶质和纳滤膜参数,然后将预测值与文献中获得的实验值进行比较。

总之,定性地预测值与文献值大致相同,依据关键参数的预测可能因此被证明是一个在饮用水厂设计中评估纳滤膜的实施作为有机微污染的处理步骤的快速而有用的技术。

简介在上几个世纪,饮用水工业一直非常关注有机微污染物在饮用水中的出现,在二十世纪八十年代,荷兰和费兰德斯饮用水公司面临着地表水中的不断提高的杀虫剂的浓度问题,一个双轨办法可解决这个问题:政府对农民和生产者施加的压力是开发杀虫剂的替代物,饮用水问题通过实施活性炭吸附得到改善,在二十世纪九十年代,更精确的分析方法和更高的产量以及这些污染物再度侵入环境使其它有机微污染物也得到关注,尤其是内分泌干扰化合物,因为它们对人体与动物内分泌系统会产生负面影响。

对于多种化合物,世界卫生组织与美国环保局已经对人类安全饮水浓度发布指引,为了在水龙头提供安全的饮用水,研究新兴的微量污染物的去除,使其浓度低于健康限制浓度是必要的,特别是极微量的污染物往往在目前的饮用水过程中难以去除。

压力驱动膜过程,如纳滤膜(NF)和反渗透(RO)可能被证明是去除有机微污染物的一项有趣的技术。

然而,虽然观察到大多数有机微污染物有相对较高的废弃值,但多种污染物仍然可以在纳滤膜NF/ 反渗透RO装置中发现。

本文的目的是双重的,包括准备了有机微污染物的优先级列表(特别是佛兰德斯/荷兰的情况,但也是普遍适用的)。

其次用NF去除这些优先控制污染物的可能性进行评估,这一评估将为将预测排斥反应值比作实验测定的文献值提供更多的理论基础。

文献翻译参考

毕业设计(论文)译文及原稿译文题目一贸易能带来经济增长?原稿题目一Does Trade Cause Growth?原稿出处一Frankel J , and Romer D .Does Trade Cause Growth ? [J] . American Economic Review . 1999,89 (3): 379 -399.贸易能带来经济增长?1.构建模型A背景我们基本的想法可以表述为使用三个简单的等式模型。

首先,国家i的平均收入的函数包括:与其他国家经济交往(简称“国际贸易”),国内经济交往(“国内贸易”)和其他相关因素。

(1).这里是个人收入,是国际贸易,是国内贸易,是与收入相关的其他影响因素。

已正如大量的文献对贸易描述的那样,贸易可以通过很多途径影响收入,贸易通过比较优势,开发来自大市场的递增收益,通过交流和旅游交换思想,通过投资和开发新产品传播科技,从而使得专业分工更加显著。

因为各种因素相互作用共同促进,我们的方法不能确定具体是哪种贸易方式影响收入。

另外两个方程式包含了国际贸易和国内贸易的决定因素。

国际贸易的函数包括,是一个国家与另一个国家的接近度和其他因素。

(2)类似的,国内贸易的函数包括国家大小,和其他因素。

(3)三个等式中的剩余因素,和,很有可能相互关联。

比如说,那些拥有良好的交通系统或者政府的政策的国家,能够促进竞争并能够依赖市场分配资源,具有地理优势给他们带来大量的国际和国内贸易,贸易又给他们带来了大量的收入。

我们假设分析的关键是判定国家的地理特征(他们的和)与另外的等式(1)和(3)是没有关联的。

相似度和规模不会被收入或者其他因素影响,而政府政策可以影响收入。

我们回顾引言,除了作用于该国居民人数与外国人或者其他人之间的相互影响,我们很难想出有效的方法证明相似度和规模可以影响收入。

给出P和S与不相关联的假设。

通过变量Y,T,W,P和S,我们可以计算公式(1):P,S与T,W有关[通过公式(2)和公式 (3)] ,并且与无关(通过鉴别假设)。

毕业论文英文翻译文献

毕业论文英文翻译文献随着全球化的发展,英语在全球的运用越来越广泛。

下文是店铺为大家整理的关于毕业论文英文翻译文献的内容,欢迎大家阅读参考! 毕业论文英文翻译文献(一)1. 谢天振主编. 《当代国外翻译理论导读》. 天津:南开大学出版社,2008.2. 包惠南、包昂. 《中国文化与汉英翻译》. 北京:外文出版社, 2004.3. 包惠南. 《文化语境与语言翻译》. 北京:中国对外翻译出版公司. 2001.4. 毕继万. 《世界文化史故事大系——英国卷》. 上海:上海外语教育出版社, 2003.5. 蔡基刚. 《英汉汉英段落翻译与实践》. 上海:复旦大学出版社, 2001.6. 蔡基刚. 《英汉写作对比研究》. 上海:复旦大学出版社, 2001.7. 蔡基刚. 《英语写作与抽象名词表达》. 上海:复旦大学出版社, 2003.8. 曹雪芹、高鄂. 《红楼梦》.9. 陈定安. 《英汉比较与翻译》. 北京:中国对外翻译出版公司, 1991.10. 陈福康. 《中国译学理论史稿》(修订本). 上海:上海外语教育出版社. 2000.11. 陈生保. 《英汉翻译津指》. 北京:中国对外翻译出版公司. 1998.12. 陈廷祐. 《英文汉译技巧》. 北京:外语教学与研究出版社. 2001.13. 陈望道. 《修辞学发凡》. 上海:上海教育出版社, 1979.14. 陈文伯. 《英汉翻译技法与练习》. 北京:世界知识出版社. 1998.15. 陈中绳、吴娟. 《英汉新词新义佳译》. 上海:上海翻译出版公司. 1990.16. 陈忠诚. 《词语翻译丛谈》. 北京:中国对外翻译出版公司, 1983.17. 程希岚. 《修辞学新编》. 吉林:吉林人民出版社, 1984.18. 程镇球. 《翻译论文集》. 北京:外语教学与研究出版社. 2002.19. 程镇球. 《翻译问题探索》. 北京:商务印书馆, 1980.20. 崔刚. 《广告英语》. 北京:北京理工大学出版社, 1993.21. 单其昌. 《汉英翻译技巧》. 北京:外语教学与研究出版社. 1990.22. 单其昌. 《汉英翻译讲评》. 北京:对外贸易教育出版社. 1989.23. 邓炎昌、刘润清. 《语言与文化——英汉语言文化对比》. 北京:外语教学与研究出版社, 1989.24. 丁树德. 《英汉汉英翻译教学综合指导》. 天津:天津大学出版社, 1996.25. 杜承南等,《中国当代翻译百论》. 重庆:重庆大学出版社, 1994.26. 《翻译通讯》编辑部. 《翻译研究论文集(1894-1948)》. 北京:外语教学与研究出版社. 1984.27. 《翻译通讯》编辑部. 《翻译研究论文集(1949-1983)》. 北京:外语教学与研究出版社. 1984. .28. 范勇主编. 《新编汉英翻译教程》. 天津:南开大学出版社. 2006.29. 方梦之、马秉义(编选). 《汉译英实践与技巧》. 北京:旅游教育出版社. 1996.30. 方梦之. 《英语汉译实践与技巧》. 天津:天津科技翻译出版公司. 1994.31. 方梦之主编. 《译学辞典》. 上海:上海外语教育出版社. 2004.32. 冯翠华. 《英语修辞大全》,北京:外语教学与研究出版社, 1995.33. 冯庆华. 《文体与翻译》. 上海:上海外语教育出版社, 2002.34. 冯庆华主编. 《文体翻译论》. 上海:上海外语教育出版社. 2002.35. 冯胜利. 《汉语的韵律、词法与句法》. 北京:北京大学出版社, 1997.36. 冯志杰. 《汉英科技翻译指要》. 北京:中国对外翻译出版公司. 1998.37. 耿占春. 《隐喻》. 北京:东方出版社, 1993.38. 郭建中. 《当代美国翻译理论》. 武汉:湖北教育出版社. 2000.39. 郭建中. 《文化与翻译》. 北京:中国对外翻译出版公司. 2000.40. 何炳威. 《容易误译的英语》. 北京:外语教学与研究出版社. 2002.41. 何刚强. 《现代英汉翻译操作》. 北京:北京大学出版社. 1998.42. 何刚强. 《现代英语表达与汉语对应》. 上海:复旦大学出版社. 1994.43. 何刚强. 《英汉口笔译技艺》. 上海:复旦大学出版社, 2003. 毕业论文英文翻译文献(二)1. 何自然、张达三、杨伟钧等译. 《现代英语语法教程》. 北京:商务印书馆, 1990.2. 何自然. 《语用学概论》. 长沙: 湖南教育出版社, 1988.3. 侯维瑞. 《英语语体》. 上海:上海外语教育出版社, 1988.4. 胡庚申. 《怎样起草与翻译合同协议》. 合肥:中国科技大学出版社, 1993.5. 胡曙中. 《英汉修辞比较研究》. 上海:上海外语教育出版社, 1993.6. 胡晓吉. 《实用英汉对比翻译》. 北京:中国人民大学出版社. 1990.7. 胡燕平,张容建. 《实用英汉翻译类典》. 重庆:重庆出版社, 1997.8. 胡裕树. 《现代汉语》. 上海:上海教育出版社, 1987.9. 胡兆云. 《美学理论视野中的文学翻译研究》(第2版). 北京:现代教育出版社. 2009.10. 胡兆云. 《语言接触与英汉借词研究》. 济南:山东大学出版社. 2001.11. 胡壮麟. 《语篇的衔接与连贯》. 上海:上海外语教育出版社, 1994.12. 胡壮麟. 《语言学教程》. 北京:北京大学出版社, 1988.13. 黄伯荣, 廖序东. 《现代汉语》. 兰州:甘肃人民出版社, 1981.14. 黄国文. 《语篇分析概要》. 长沙:湖南教育出版社, 1988.15. 黄龙. 《翻译技巧指导》. 沈阳:辽宁人民出版社, 1986.16. 黄任. 《英语修辞与写作》. 上海:上海外语教育出版社, 1996.17. 黄雨石. 《英汉文学翻译探索》. 西安:陕西人民出版社. 1988.18. 黄振定. 《翻译学:艺术论与科学论的统一》. 长沙:湖南教育出版社. 1998.19. 黄振定. 《翻译学的语言哲学基础》. 上海:上海交通大学出版社. 2007.20. 黄忠廉. 《变译理论》. 北京:中国对外翻译出版公司. 2002.21. 贾尔斯英译. 《孙子兵法》. 长沙:湖南出版社, 1993.22. 贾文波. 《汉英时文翻译: 政治经济汉译英300句析》. 北京:中国对外翻译出版公司, 1999.23. 贾玉新. 《跨文化交际学》. 上海:上海外语教育出版社, 1997.24. 金隄. 《等效翻译探索》. 北京:中国对外翻译出版公司. 1998.25. 金惠康. 《汉英跨文化交际翻译》. 贵阳:贵州教育出版社. 1998.26. 金惠康. 《跨文华交际翻译》. 北京:中国对外翻译出版公司, 2003.27. 金惠康. 《跨文华交际翻译续编》. 北京:中国对外翻译出版公司, 2004.28. 金立鑫. 《语法的多视角研究》. 上海:上海外语教育出版社, 2000.29. 居祖纯. 《新编汉英语篇翻译》. 北京:清华大学出版社, 2002.30. 柯平. 《对比语言学》. 南京:南京师范大学出版社, 1999.31. 孔慧怡. 《翻译·文学·文化》. 北京:北京大学出版社. 1999.32. 李定坤. 《汉英辞格对比与翻译》. 武汉:华中师范大学出版社, 1994.33. 李国南. 《辞格与词汇》. 上海:上海外语教育出版社, 2002.34. 李国南. 《英汉修辞格对比研究》. 福州:福建人民出版社, 1999.35. 李明编著. 《英汉互动翻译教程》. 武汉:武汉大学出版社. 2006.36. 李瑞华(主编). 《英汉语言文化对比研究》. 上海:上海外语教育出版社. 1996.。

外文文献翻译译稿

外文文献翻译译稿1可用性和期望值来自Willliam S.Green, Patrick W.Jordan.产品的愉悦:超越可用性根据人机工程学会(HFES)的观点,人机工程学着眼于“发现和共享可用于各种系统和设备设计的、关于人的特点的知识”。

人们通常只是把它作为生物力学和人体测量所关注的内容,实际上它是从更广泛的意义上的一种对人(产品用户)的全面和综合的理解。

HFES从二战中有军方从事的系统分析中发展而来。

其中的三种主要研究的是人体测量、复杂信息的解释和管理,以及在部队和装备调配中应用的系统分析。

系统分析在尺度和复杂性方面跨度很大,大的系统分析有类似于诺曼底登陆准备的大型系统规划,小到去理解如何从合理性和规模的角度才最佳的布置和装备人员。

诺曼底登陆是20世纪最复杂的事件之一。

他要求建立一个在战斗开始之前还不确定的庞大的人员和物资的合理分配系统。

在更小的规模上,装备和军事人物的布置意味着如何去组织、训练和安排战士,最大限度的发挥他们的长处。

士兵必须迅速地接受训练,并且能够有效地使用和维护在二战中发展起来的一系列技术装备。

其中,对于飞行员、潜艇人员和坦克驾驶员有神采的限制。

复杂的新装备的开发要求找到最好的税收、密码便医院、破译人员、雷达和声纳操作员、轰炸机驾驶员和机组人员。

在战后,随着公司及其产品在尺度、领域和复杂性方面的增长,很多系统分析人员在商用领域找到了发展机会。

尽管是战后的发展才导致了1957年人机工程协会(HFES)的建立,但人机研究的起源可以追溯到大批量生产方式的成型阶段,是当时提高生产效率的要求。

随着工作方式从手工生产和农业生产中的转移,新的工厂工作的概念逐步发展起来。

福特的流水生产线和泰勒的效率理论开始对生产的规划和教育产生影响。

即使在家庭生活中,妇女们也开始接受了现代家庭管理理论,并运用这些理论来组织和规划家庭。

在20世纪末,一种涵盖面更广的人机工程正在发展之中。

新的人机工程学是为了适应已经被广泛意识到的对用户行为模式更深入的需求而诞生的,它开始应用定型研究方法,并探索人的情感和认知因素。

英文文献全文翻译

英文文献全文翻译全文共四篇示例,供读者参考第一篇示例:LeGuin, Ursula K. (December 18, 2002). "Dancing at the Edge of the World: Thoughts on Words, Women, Places".《世界边缘的舞蹈:关于语言、女性和地方的思考》Introduction:In "Dancing at the Edge of the World," Ursula K. LeGuin explores the intersection of language, women, and places. She writes about the power of words, the role of women in society, and the importance of our connection to the places we inhabit. Through a series of essays, LeGuin invites readers to think critically about these topics and consider how they shape our understanding of the world.Chapter 1: LanguageConclusion:第二篇示例:IntroductionEnglish literature translation is an important field in the study of language and culture. The translation of English literature involves not only the linguistic translation of words or sentences but also the transfer of cultural meaning and emotional resonance. This article will discuss the challenges and techniques of translating English literature, as well as the importance of preserving the original author's voice and style in the translated text.Challenges in translating English literature第三篇示例:Title: The Importance of Translation of Full English TextsTranslation plays a crucial role in bringing different languages and cultures together. More specifically, translating full English texts into different languages allows for access to valuable information and insights that may otherwise be inaccessible to those who do not speak English. In this article, we will explore the importance of translating full English texts and the benefits it brings.第四篇示例:Abstract: This article discusses the importance of translating English literature and the challenges translators face when putting together a full-text translation. It highlights the skills and knowledge needed to accurately convey the meaning and tone of the original text while preserving its cultural and literary nuances. Through a detailed analysis of the translation process, this article emphasizes the crucial role translators play in bridging the gap between languages and making English literature accessible to a global audience.IntroductionEnglish literature is a rich and diverse field encompassing a wide range of genres, styles, and themes. From classic works by Shakespeare and Dickens to contemporary novels by authors like J.K. Rowling and Philip Pullman, English literature offers something for everyone. However, for non-English speakers, accessing and understanding these works can be a challenge. This is where translation comes in.Translation is the process of rendering a text from one language into another, while striving to preserve the original meaning, tone, and style of the original work. Translating afull-length English text requires a deep understanding of both languages, as well as a keen awareness of the cultural andhistorical context in which the work was written. Additionally, translators must possess strong writing skills in order to convey the beauty and complexity of the original text in a new language.Challenges of Full-text TranslationTranslating a full-length English text poses several challenges for translators. One of the most significant challenges is capturing the nuances and subtleties of the original work. English literature is known for its rich and layered language, with intricate wordplay, metaphors, and symbolism that can be difficult to convey in another language. Translators must carefully consider each word and phrase in order to accurately convey the author's intended meaning.Another challenge of full-text translation is maintaining the author's unique voice and style. Each writer has a distinct way of expressing themselves, and a good translator must be able to replicate this voice in the translated text. This requires a deep understanding of the author's writing style, as well as the ability to adapt it to the conventions of the target language.Additionally, translators must be mindful of the cultural and historical context of the original work. English literature is deeply rooted in the history and traditions of the English-speaking world, and translators must be aware of these influences in orderto accurately convey the author's intended message. This requires thorough research and a nuanced understanding of the social, political, and economic factors that shaped the work.Skills and Knowledge RequiredTo successfully translate a full-length English text, translators must possess a wide range of skills and knowledge. First and foremost, translators must be fluent in both the source language (English) and the target language. This includes a strong grasp of grammar, syntax, and vocabulary in both languages, as well as an understanding of the cultural and historical context of the works being translated.Translators must also have a keen eye for detail and a meticulous approach to their work. Every word, sentence, and paragraph must be carefully considered and translated with precision in order to accurately convey the meaning of the original text. This requires strong analytical skills and a deep understanding of the nuances and complexities of language.Furthermore, translators must possess strong writing skills in order to craft a compelling and engaging translation. Translating a full-length English text is not simply a matter of substituting one word for another; it requires creativity, imagination, and a deep appreciation for the beauty of language. Translators mustbe able to capture the rhythm, cadence, and tone of the original work in their translation, while also adapting it to the conventions of the target language.ConclusionIn conclusion, translating a full-length English text is a complex and challenging task that requires a high level of skill, knowledge, and creativity. Translators must possess a deep understanding of both the source and target languages, as well as the cultural and historical context of the work being translated. Through their careful and meticulous work, translators play a crucial role in making English literature accessible to a global audience, bridging the gap between languages and cultures. By preserving the beauty and complexity of the original text in their translations, translators enrich our understanding of literature and bring the works of English authors to readers around the world.。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

语音识别在计算机技术中,语音识别是指为了达到说话者发音而由计算机生成的功能,利用计算机识别人类语音的技术。

(例如,抄录讲话的文本,数据项;经营电子和机械设备;电话的自动化处理),是通过所谓的自然语言处理的计算机语音技术的一个重要元素。

通过计算机语音处理技术,来自语音发音系统的由人类创造的声音,包括肺,声带和舌头,通过接触,语音模式的变化在婴儿期、儿童学习认识有不同的模式,尽管由不同人的发音,例如,在音调,语气,强调,语调模式不同的发音相同的词或短语,大脑的认知能力,可以使人类实现这一非凡的能力。

在撰写本文时(2008年),我们可以重现,语音识别技术不只表现在有限程度的电脑能力上,在其他许多方面也是有用的。

语音识别技术的挑战古老的书写系统,要回溯到苏美尔人的六千年前。

他们可以将模拟录音通过留声机进行语音播放,直到1877年。

然而,由于与语音识别各种各样的问题,语音识别不得不等待着计算机的发展。

首先,演讲不是简单的口语文本——同样的道理,戴维斯很难捕捉到一个note-for-note曲作为乐谱。

人类所理解的词、短语或句子离散与清晰的边界实际上是将信号连续的流,而不是听起来: I went to the store yesterday昨天我去商店。

单词也可以混合,用Whadd ayawa吗?这代表着你想要做什么。

第二,没有一对一的声音和字母之间的相关性。

在英语,有略多于5个元音字母——a,e,i,o,u,有时y和w。

有超过二十多个不同的元音, 虽然,精确统计可以取决于演讲者的口音而定。

但相反的问题也会发生,在那里一个以上的信号能再现某一特定的声音。

字母C可以有相同的字母K的声音,如蛋糕,或作为字母S,如柑橘。

此外,说同一语言的人使用不相同的声音,即语言不同,他们的声音语音或模式的组织,有不同的口音。

例如―水‖这个词,wadder可以显著watter,woader wattah等等。

每个人都有独特的音量——男人说话的时候,一般开的最低音,妇女和儿童具有更高的音高(虽然每个人都有广泛的变异和重叠)。

发音可以被邻近的声音、说话者的速度和说话者的健康状况所影响,当一个人感冒的时候,就要考虑发音的变化。

最后,考虑到不是所有的语音都是有意义的声音组成。

通常语音自身是没有任何意义的,但有些用作分手话语以传达说话人的微妙感情或动机的信息:哦,就像,你知道,好的。

也有一些听起来都不认为是字,这是一项词性的:呃,嗯,嗯。

嗽、打喷嚏、谈笑风生、呜咽,甚至打嗝的可以成为上述的内容之一。

在噪杂的地方与环境自身的噪声中,即使语音识别也是困难的。

语音识别的发展史尽管困难重重,语音识别技术却随着数字计算机的诞生一直被努力着。

早在1952年,研究人员在贝尔实验室就已开发出了一种自动数字识别器,取名“奥黛丽”。

如果说话的人是男性,并且发音者在词与词之间停顿350毫秒并把把词汇限制在1—9之间的数字,再加上“哦”,另外如果这台机器能够调整到适应说话者的语音习惯,奥黛丽的精确度将达到97℅—99℅,如果识别器不能够调整自己,那么精确度将低至60℅.奥黛丽通过识别音素或者两个截然不同的声音工作。

这些因素与识别器经训练产生的参考音素是有关联的。

在接下来的20年里研究人员花了大量的时间和金钱来改善这个概念,但是少有成功。

计算机硬件突飞猛进、语音合成技术稳步提高,乔姆斯基的生成语法理论认为语言可以被程序性地分析。

然而,这些似乎并没有提高语音识别技术。

乔姆斯基和哈里的语法生成工作也导致主流语言学放弃音素概念,转而选择将语言的声音模式分解成更小、更易离散的特征。

1969年皮尔斯坦率地写了一封信给美国声学学会的会刊,大部分关于语音识别的研究成果都发表在上面。

皮尔斯是卫星通信的先驱之一,并且是贝尔实验室的执行副主任,贝尔实验室在语音识别研究中处于领先地位。

皮尔斯说所有参与研究的人都是在浪费时间和金钱。

如果你认为一个人之所以从事语音识别方面的研究是因为他能得到金钱,那就太草率了。

这种吸引力也许类似于把水变成汽油、从海水中提取黄金、治愈癌症或者登月的诱惑。

一个人不可能用削减肥皂成本10℅的方法简单地得到钱。

如果想骗到人,他要用欺诈和诱惑。

皮尔斯1969年的信标志着在贝尔实验室持续了十年的研究结束了。

然而,国防研究机构ARPA选择了坚持下去。

1971年他们资助了一项开发一种语音识别器的研究计划,这种语音识别器要能够处理至少1000个词并且能够理解相互连接的语音,即在语音中没有词语之间的明显停顿。

这种语音识别器能够假设一种存在轻微噪音背景的环境,并且它不需要在真正的时间中工作。

到1976年,三个承包公司已经开发出六种系统。

最成功的是由卡耐基麦隆大学开发的叫做“Harpy”的系统。

“Harpy”比较慢,四秒钟的句子要花费五分多钟的时间来处理。

并且它还要求发音者通过说句子来建立一种参考模型。

然而,它确实识别出了1000个词汇,并且支持连音的识别。

研究通过各种途径继续着,但是“Harpy”已经成为未来成功的模型。

它应用隐马尔科夫模型和统计模型来提取语音的意义。

本质上,语音被分解成了相互重叠的声音片段和被认为最可能的词或词的部分所组成的几率模型。

整个程序计算复杂,但它是最成功的。

在1970s到1980s之间,关于语音识别的研究继续进行着。

到1980s,大部分研究者都在使用隐马尔科夫模型,这种模型支持着现代所有的语音识别器。

在1980s后期和1990s,DARPA资助了一些研究。

第一项研究类似于以前遇到的挑战,即1000个词汇量,但是这次要求更加精确。

这个项目使系统词汇出错率从10℅下降了一些。

其余的研究项目都把精力集中在改进算法和提高计算效率上。

2001年微软发布了一个能够与0ffice XP 同时工作的语音识别系统。

它把50年来这项技术的发展和缺点都包含在内了。

这个系统必须用大作家的作品来训练为适应某种指定的声音,比如埃德加爱伦坡的厄舍古屋的倒塌和比尔盖茨的前进的道路。

即使在训练之后,该系统仍然是脆弱的,以至于还提供了一个警告:“如果你改变使用微软语音识别系统的地点导致准确率将降低,请重新启动麦克风”。

从另一方面来说,该系统确实能够在真实的时间中工作,并且它确实能识别连音。

语音识别的今天技术当今的语音识别技术着力于通过共振和光谱分析来对我们的声音产生的声波进行数学分析。

计算机系统第一次通过数字模拟转换器记录了经过麦克风传来的声波。

那种当我们说一个词的时候所产生的模拟的或者持续的声波被分割成了一些时间碎片,然后这些碎片按照它们的振幅水平被度量,振幅是指从一个说话者口中产生的空气压力。

为了测量振幅水平并且将声波转换成为数字格式,现在的语音识别研究普遍采用了奈奎斯特—香农定理。

奈奎斯特—香农定理奈奎斯特—香农定理是在1928年研究发现的,该定理表明一个给定的模拟频率能够由一个是原始模拟频率两倍的数字频率重建出来。

奈奎斯特证明了该规律的真实性,因为一个声波频率必须由于压缩和疏散各取样一次。

例如,一个20kHz的音频信号能准确地被表示为一个44.1kHz的数字信号样本。

工作原理语音识别系统通常使用统计模型来解释方言,口音,背景噪音和发音的不同。

这些模型已经发展到这种程度,在一个安静的环境中准确率可以达到90℅以上。

然而每一个公司都有它们自己关于输入处理的专项技术,存在着4种关于语音如何被识别的共同主题。

1.基于模板:这种模型应用了内置于程序中的语言数据库。

当把语音输入到系统中后,识别器利用其与数据库的匹配进行工作。

为了做到这一点,该程序使用了动态规划算法。

这种语音识别技术的衰落是因为这个识别模型不足以完成对不在数据库中的语音类型的理解。

2.基于知识:基于知识的语音识别技术分析语音的声谱图以收集数据和制定规则,这些数据和规则回馈与操作者的命令和语句等值的信息。

这种识别技术不适用关于语音的语言和语音知识。

3.随机:随机语音识别技术在今天最为常见。

随机语音分析方法利用随机概率模型来模拟语音输入的不确定性。

最流行的随机概率模型是HMM(隐马尔科夫模型)。

识别指令当今语音识别软件最重要的目标是识别指令。

这增强了语音软件的功能。

例如微软Sync 被装进了许多新型汽车里面,据说这可以让使用者进入汽车的所有电子配件和免提。

这个软件是成功的。

它询问使用者一系列问题并利用常用词汇的发音来得出语音恒量。

这些常量变成了语音识别技术算法中的一环,这样以后就能够提供更好的语音识别。

当今的技术评论家认为这项技术自20世纪90年代开始已经有了很大进步,但是在短时间内不会取代手控装置。

听写关于指令识别的第二点是听写。

就像接下来讨论的那样,今天的市场看重听写软件在转述医疗记录、学生试卷和作为一种更实用的将思想转化成文字方面的价值。

另外,许多公司看重听写在翻译过程中的价值,在这个过程中,使用者可以把他们的语言翻译成为信件,这样使用者就可以说给他们母语中另一部分人听。

在今天的市场上,关于该软件的生产制造已经存在。

语句翻译中存在的错误当语音识别技术处理你的语句的时候,它们的准确率取决于它们减少错误的能力。

它们在这一点上的评价标准被称为单个词汇错误率(SWER)和指令成功率(CSR)。

当一个句子中一个单词被弄错,那就叫做单个词汇出错。

因为SWERs在指令识别系统中存在,它们在听写软件中最为常见。

指令成功率是由对指令的精确翻译决定的。

一个指令陈述可能不会被完全准确的翻译,但识别系统能够利用数学模型来推断使用者想要发出的指令。

今后的发展趋势和应用医疗行业医疗行业有多年来一直在宣传电子病历(EMR)。

不幸的是,产业迟迟不能够满足EMRs,一些公司断定原因是由于数据的输入。

没有足够的人员将大量的病人信息输入成为电子格式,因此,纸质记录依然盛行。

一家叫Nuance(也出现在其他领域,软件开发者称为龙指令)相信他们可以找到一市场将他们的语音识别软件出售那些更喜欢声音而非手写输入病人信息的医生。

军事国防工业研究语音识别软件试图将其应用复杂化而非更有效率和亲切。

为了使驾驶员更快速、方便地进入需要的数据库,语音识别技术是目前正在飞机驾驶员座位下面的显示器上进行试验。

军方指挥中心同样正在尝试利用语音识别技术在危急关头用快速和简易的方式进入他们掌握的大量资料库。

另外,军方也为了照顾病员涉足EMR。

军方宣布,正在努力利用语音识别软件把数据转换成为病人的记录。

附:英文原文Speech RecognitionIn computer technology, Speech Recognition refers to the recognition of human speech by computers for the performance of speaker-initiated computer-generated functions (e.g., transcribing speech to text; data entry; operating electronic and mechanical devices; automated processing of telephone calls) —a main element of so-called natural language processing through computer speech technology. Speech derives from sounds created by the human articulatory system, including the lungs, vocal cords, and tongue. Through exposure to variations in speech patterns during infancy, a child learns to recognize the same words or phrases despite different modes of pronunciation by different people—e.g., pronunciation differing in pitch, tone, emphasis, intonation pattern. The cognitive ability of the brain enables humans to achieve that remarkable capability. As of this writing (2008), we can reproduce that capability in computers only to a limited degree, but in many ways still useful.The Challenge of Speech RecognitionWriting systems are ancient, going back as far as the Sumerians of 6,000 years ago. The phonograph, which allowed the analog recording and playback of speech, dates to 1877. Speech recognition had to await the development of computer, however, due to multifarious problems with the recognition of speech.First, speech is not simply spoken text--in the same way that Miles Davis playing So What can hardly be captured by a note-for-note rendition as sheet music. What humans understand as discrete words, phrases or sentences with clear boundaries are actually delivered as a continuous stream of sounds: Iwenttothestoreyesterday, rather than I went to the store yesterday. Words can also blend, with Whaddayawa? representing What do you want?Second, there is no one-to-one correlation between the sounds and letters. In English, there are slightly more than five vowel letters--a, e, i, o, u, and sometimes y and w. There are more than twenty different vowel sounds, though, and the exact count can vary depending on the accent of the speaker. The reverse problem also occurs, where more than one letter canrepresent a given sound. The letter c can have the same sound as the letter k, as in cake, or as the letter s, as in citrus.In addition, people who speak the same language do not use the same sounds, i.e. languages vary in their phonology, or patterns of sound organization. There are different accents--the word 'water' could be pronounced watter, wadder, woader, wattah,and so on. Each person has a distinctive pitch when they speak--men typically having the lowest pitch, women and children have a higher pitch (though there is wide variation and overlap within each group.) Pronunciation is also colored by adjacent sounds, the speed at which the user is talking, and even by the user's health. Consider how pronunciation changes when a person has a cold.Lastly, consider that not all sounds consist of meaningful speech. Regular speech is filled with interjections that do not have meaning in themselves, but serve to break up discourse and convey subtle information about the speaker's feelings or intentions: Oh, like, you know, well. There are also sounds that are a part of speech that are not considered words: er, um, uh. Coughing, sneezing, laughing, sobbing, and even hiccupping can be a part of what is spoken. And the environment adds its own noises; speech recognition is difficult even for humans in noisy places.History of Speech RecognitionDespite the manifold difficulties, speech recognition has been attempted for almost as long as there have been digital computers. As early as 1952, researchers at Bell Labs had developed an Automatic Digit Recognizer, or "Audrey". Audrey attained an accuracy of 97 to 99 percent if the speaker was male, and if the speaker paused 350 milliseconds between words, and if the speaker limited his vocabulary to the digits from one to nine, plus "oh", and if the machine could be adjusted to the speaker's speech profile. Results dipped as low as 60 percent if the recognizer was not adjusted.Audrey worked by recognizing phonemes, or individual sounds that were considered distinct from each other. The phonemes were correlated to reference models of phonemes that were generated by training the recognizer. Over the next two decades, researchers spent largeamounts of time and money trying to improve upon this concept, with little success. Computer hardware improved by leaps and bounds, speech synthesis improved steadily, and Noam Chomsky's idea of generative grammar suggested that language could be analyzed programmatically. None of this, however, seemed to improve the state of the art in speech recognition. Chomsky and Halle's generative work in phonology also led mainstream linguistics to abandon the concept of the "phoneme" altogether, in favour of breaking down the sound patterns of language into smaller, more discrete "features".In 1969, John R. Pierce wrote a forthright letter to the Journal of the Acoustical Society of America, where much of the research on speech recognition was published. Pierce was one of the pioneers in satellite communications, and an executive vice president at Bell Labs, which was a leader in speech recognition research. Pierce said everyone involved was wasting time and money.It would be too simple to say that work in speech recognition is carried out simply because one can get money for it. . . .The attraction is perhaps similar to the attraction of schemes for turning water into gasoline, extracting gold from the sea, curing cancer, or going to the moon. One doesn't attract thoughtlessly given dollars by means of schemes for cutting the cost of soap by 10%. To sell suckers, one uses deceit and offers glamor.Pierce's 1969 letter marked the end of official research at Bell Labs for nearly a decade. The defense research agency ARPA, however, chose to persevere. In 1971 they sponsored a research initiative to develop a speech recognizer that could handle at least 1,000 words and understand connected speech, i.e., speech without clear pauses between each word. The recognizer could assume a low-background-noise environment, and it did not need to work in real time.By 1976, three contractors had developed six systems. The most successful system, developed by Carnegie Mellon University, was called Harpy. Harpy was slow—a four-second sentence would have taken more than five minutes to process. It also still required speakers to 'train' it by speaking sentences to build up a reference model. Nonetheless, it did recognize a thousand-word vocabulary, and it did support connected speech.Research continued on several paths, but Harpy was the model for future success. It used hidden Markov models and statistical modeling to extract meaning from speech. In essence, speech was broken up into overlapping small chunks of sound, and probabilistic models inferred the most likely words or parts of words in each chunk, and then the same model was applied again to the aggregate of the overlapping chunks. The procedure is computationally intensive, but it has proven to be the most successful.Throughout the 1970s and 1980s research continued. By the 1980s, most researchers were using hidden Markov models, which are behind all contemporary speech recognizers. In the latter part of the 1980s and in the 1990s, DARPA (the renamed ARPA) funded several initiatives. The first initiative was similar to the previous challenge: the requirement was still a one-thousand word vocabulary, but this time a rigorous performance standard was devised. This initiative produced systems that lowered the word error rate from ten percent to a few percent. Additional initiatives have focused on improving algorithms and improving computational efficiency.In 2001, Microsoft released a speech recognition system that worked with Office XP. It neatly encapsulated how far the technology had come in fifty years, and what the limitations still were. The system had to be trained to a specific user's voice, using the works of great authors that were provided, such as Edgar Allen Poe's Fall of the House of Usher, and Bill Gates' The Way Forward. Even after training, the system was fragile enough that a warning was provided, "If you change the room in which you use Microsoft Speech Recognition and your accuracy drops, run the Microphone Wizard again." On the plus side, the system did work in real time, and it did recognize connected speech.Speech Recognition TodayTechnologyCurrent voice recognition technologies work on the ability to mathematically analyze the sound waves formed by our voices through resonance and spectrum analysis. Computer systems first record the sound waves spoken into a microphone through a digital to analog converter. The analog or continuous sound wave that we produce when we say a word issliced up into small time fragments. These fragments are then measured based on their amplitude levels, the level of compression of air released from a person’s mouth. To measure the amplitudes and convert a sound wave to digital format the industry has commonly used the Nyquist-Shannon Theorem.Nyquist-Shannon TheoremThe Nyquist –Shannon theorem was developed in 1928 to show that a given analog frequency is most accurately recreated by a digital frequency that is twice the original analog frequency. Nyquist proved this was true because an audible frequency must be sampled once for compression and once for rarefaction. For example, a 20 kHz audio signal can be accurately represented as a digital sample at 44.1 kHz.How it Worksspeech recognition programs use statistical models to account for variations in dialect, accent, background noise, and pronunciation.These models have progressed to such an extent that in a quiet environment accuracy of over 90% can be achieved. While every company has their own proprietary technology for the way a spoken input is processed there exists 4 common themes about how speech is recognized.∙ 1. Template-Based: This model uses a database of speech patterns built into the program. After receiving voice input into the system recognition occurs by matchingthe input to the database. To do this the program uses Dynamic Programmingalgorithms. The downfall of this type of speech recognition is the inability for therecognition model to be flexible enough to understand voice patterns unlike those inthe database.∙ 2. Knowledge-Based: Knowledge-based speech recognition analyzes the spectrograms of the speech to gather data and create rules that return values equaling whatcommands or words the user said. Knowledge-Based recognition does not make use of linguistic or phonetic knowledge about speech.∙ 3. Stochastic: Stochastic speech recognition is the most common today. Stochastic methods of voice analysis make use of probability models to model the uncertainty of the spoken input. The most popular probability model is use of HMM (HiddenMarkov Model)Recognizing CommandsThe most important goal of current speech recognition software is to recognize commands. This increases the functionality of speech software. Software such as Microsost Sync is built into many new vehicles, supposedly allowing users to access all of the car’s electronic accessories, hands-free. This software is adaptive. It asks the user a series of questions and utilizes the pronunciation of commonly used words to derive speech constants. These constants are then factored into the speech recognition algorithms, allowing the application to provide better recognition in the future. Current tech reviewers have said the technology is much improved from the early 1990’s but will not be replacing hand controls any time soon.DictationSecond to command recognition is dictation. Today's market sees value in dictation software as discussed below in transcription of medical records, or papers for students, and as a more productive way to get one's thoughts down a written word. In addition many companies see value in dictation for the process of translation, in that users could have their words translated for written letters, or translated so the user could then say the word back to another party in their native language. Products of these types already exist in the market today.Errors in Interpreting the Spoken WordAs speech recognition programs process your spoken words their success rate is based on their ability to minimize errors. The scale on which they can do this is called Single Word Error Rate (SWER) and Command Success Rate (CSR). A Single Word Error is simply put, a misunderstanding of one word in a spoken sentence. While SWERs can be found in Command Recognition Programs, they are most commonly found in dictation software. Command Success Rate is defined by an accurate interpretation of the spoken command. All words in a command statement may not be correctly interpreted, but the recognition program is able to use mathematical models to deduce the command the user wants to execute.The Future of Speech RecognitionFuture Trends & ApplicationsThe Medical IndustryFor years the medical industry has been touting electronic medical records (EMR). Unfortunately the industry has been slow to adopt EMRs and some companies are betting that the reason is because of data entry. There isn’t enough people to enter the multitude of current patient’s data into electronic format and because of that the paper record prevails. A company called Nuance (also featured in other areas here, and developer of the software called Dragon Dictate) is betting that they can find a market selling their voice recognition software to physicians who would rather speak patients' data than handwrite all medical information into a person’s fi le.The MilitaryThe Defense industry has researched voice recognition software in an attempt to make complex user intense applications more efficient and friendly. Currently voice recognition is being experimented with cockpit displays in aircraft under the context that the pilot could access needed data faster and easier.Command Centers are also looking to use voice recognition technology to search and access the vast amounts of database data under their control in a quick and concise manner during situations of crisis. In addition the military has also jumped onboard with EMR for patient care. The military has voiced its commitment to utilizing voice recognition software in transmitting data into patients' records.。