基于改进词向量模型的深度学习文本主题分类

基于深度学习的文本分类技术研究

基于深度学习的文本分类技术研究第一章:引言随着互联网的普及,大量数据被积累,文本分类技术的应用也越来越广泛。

文本分类技术就是对一个文本进行分类,并对该文本的内容进行预测和分析。

文本分类技术的应用不仅可以用来做广告投放、消费行为分析等领域,在金融、医疗等领域也有重要的应用。

然而,传统的文本分类技术通常需要人工制定规则,这样的方法存在先验假设,分类结果容易出现偏差。

而基于深度学习的文本分类技术则可以更好地发现文本中的特征,提高分类准确度和效率。

本文就基于深度学习的文本分类技术进行研究和探讨。

第二章:深度学习技术概述2.1 概念深度学习是机器学习的一种特殊领域,其模型构建过程比传统机器学习更为灵活。

深度学习的核心是神经网络,通过模拟人类大脑的工作原理,将大量数据进行学习和处理,并从中提取有用的特征。

深度学习技术可以应用于图像识别、语音识别等领域,并取得了不俗的成果。

2.2 原理深度学习技术的原理是将多层神经网络连接起来,用多层非线性变换来提取输入数据的特征,最终作为分类任务的输入数据。

深度学习的核心思想是通过逐层抽象,使得高级别的特征表达方式更容易被学习和理解。

深度学习的每一层都会对上一层的输出进行下一层的计算,直到得到最终结果。

第三章:基于深度学习的文本分类技术3.1 自然语言处理自然语言处理是深度学习应用于文本分类领域的重要基础。

其目的是将人类自然语言转换为机器能够理解的形式。

其中经常使用到的技术有分词、词性标注、命名实体识别、句法分析等。

3.2 词向量表示词向量表示是一种将词语转化为数值向量的技术,也是深度学习模型处理自然语言的基础。

通过词向量表示,将文本转换为数字矩阵,可以更好地进行计算和处理。

常见的词向量表示方法有one-hot和词嵌入等。

3.3 模型构建在基于深度学习的文本分类技术中,常用的模型有卷积神经网络、循环神经网络、长短时记忆网络等。

其中,卷积神经网络在文本分类任务中的表现较为良好。

词向量空间模型

词向量空间模型词向量空间模型是自然语言处理中常用的一种技术,用于将文本表示为向量形式,从而实现对文本的语义理解和相关计算。

本文将介绍词向量空间模型的基本原理、应用场景以及发展趋势。

一、词向量空间模型的基本原理词向量空间模型基于分布假设,即在大量文本中,具有相似语境的词语往往具有相似的语义。

通过对大规模文本语料进行训练,词向量空间模型能够将每个词语表示为一个实数向量,使得语义相似的词语在向量空间中距离较近,而语义不相似的词语距离较远。

具体而言,词向量空间模型通过计算词语之间的共现概率或相似度,构建词语之间的语义关系。

常用的词向量模型包括基于矩阵分解的潜在语义分析(LSA)方法、基于预测的连续词袋模型(CBOW)和Skip-gram模型等。

这些模型能够从大规模语料中学习到词语之间的语义关系,并将其表示为高维向量。

词向量空间模型在自然语言处理领域有着广泛的应用。

其中,最重要的应用之一是词语的相似度计算。

通过计算词向量之间的距离,可以判断两个词语之间的语义相似度,从而实现词语的聚类、分类等任务。

此外,词向量空间模型还可以用于文本分类、情感分析、机器翻译、问答系统等自然语言处理任务,提升模型的性能和效果。

三、词向量空间模型的发展趋势随着深度学习的发展,词向量空间模型也得到了进一步的改进和扩展。

近年来,基于神经网络的词向量模型,如Word2Vec、GloVe 等,取得了很大的成功。

这些模型能够更好地捕捉词语之间的语义关系,并提供更加丰富的语义表示。

随着深度学习技术的不断发展,词向量空间模型也在不断拓展应用范围。

例如,将词向量与其他特征进行联合训练,可以实现更复杂的自然语言处理任务。

同时,将词向量与其他模型结合,如循环神经网络(RNN)、卷积神经网络(CNN)等,可以进一步提升模型的性能。

总结起来,词向量空间模型是自然语言处理中的重要技术之一。

通过将文本表示为向量形式,实现了对文本的语义理解和相关计算。

词向量空间模型在词语相似度计算、文本分类、情感分析等任务中有着广泛的应用,并且随着深度学习技术的发展,词向量空间模型也在不断改进和拓展。

基于深度学习的大规模文本数据分类算法研究

基于深度学习的大规模文本数据分类算法研究1. 前言在如今信息爆炸的时代,大量的文本数据被生成并存储,其中蕴含着海量的知识和价值。

如何高效地从这些文本数据中提取出有效的信息,成为了现代社会中重要的研究方向之一。

而文本分类技术,作为处理文本数据的基础技术之一,自然成为了研究的热点。

近年来,由于深度学习技术的发展和应用,深度学习方法在文本分类领域也取得了很大的成功,成为了一种热门的文本分类方法。

本文旨在介绍基于深度学习的大规模文本数据分类算法,着重探讨其原理、特点、应用等方面,以期为读者提供一个清晰的认识和了解。

2. 基本原理深度学习是一种基于神经网络的机器学习方法,具有自动学习和自适应能力。

而文本分类是指将文本数据划分为不同的类别,如正面评论、负面评论、新闻等。

在深度学习中,通常采用词向量表示文本,并通过多层神经网络将词向量映射到标签空间中进行分类。

具体地,基于深度学习的文本分类方法可以分为两类:(1)基于卷积神经网络(CNN)的文本分类方法卷积神经网络是一类神经网络模型,其主要用于处理具有网格化结构(如图像)的数据。

在文本分类中,通常将单词序列看作一种类似图像的结构,然后应用卷积运算提取特征,最后通过全连接层将提取到的特征映射到标签空间中进行分类。

(2)基于循环神经网络(RNN)的文本分类方法循环神经网络是一种具有记忆能力的神经网络,其特点在于可以处理不定长的序列数据。

在文本分类中,通过对文本序列进行循环神经网络以及LSTM(长短期记忆神经网络)等处理,将序列信息压缩成一个定长的向量表示,再通过全连接层进行分类。

3. 特点分析相较于传统的基于特征工程的文本分类方法,基于深度学习的文本分类方法具有如下优点:(1)自动学习特征:深度学习方法可以自动学习文本中的特征,不需要手动设计特征模板,大大提高了文本分类效率和准确率。

(2)最大程度保留文本信息:深度学习方法可以最大程度地保留文本信息,在处理长文本数据时,能够发挥更好的作用。

深度学习模型在文本分类中的应用研究

深度学习模型在文本分类中的应用研究深度学习是一种基于人工神经网络的机器学习方法,近年来在各个领域取得了巨大的成功。

其中,深度学习模型在文本分类中的应用备受关注,尤其是在自然语言处理和信息检索领域。

本文将讨论深度学习模型在文本分类中的应用研究,并探讨其在提高分类准确率和处理各种文本类型方面的优势。

一、深度学习模型的基本原理深度学习模型是一种多层次的神经网络模型,通过层次化的表示学习,可以模拟人类神经系统的工作原理。

其基本原理是通过多层次的非线性变换,从输入数据中提取和表示高层次的抽象特征。

在文本分类中,深度学习模型可以通过自动学习文本的语义和上下文信息,从而提取到更有用的特征,从而达到更好的分类效果。

二、深度学习模型在文本分类中的应用深度学习模型在文本分类中的应用可以基本分为两个部分,一是基于词向量的表示学习,二是基于递归神经网络的文本建模。

首先,基于词向量的表示学习是指将文本转化为向量表示,以便于进行后续的分类任务。

这种方法通常使用词嵌入技术,将每个词映射到一个低维连续向量空间中,从而能够表达词之间的语义关系。

常见的词嵌入模型有Word2Vec和GloVe等。

其次,基于递归神经网络的文本建模可以将文本看作是一种层次结构,通过递归神经网络的递归操作,可以对文本进行逐层的建模和特征提取。

三、深度学习模型在文本分类中的优势深度学习模型在文本分类中相较于传统的机器学习方法具有几个显著的优势。

首先,深度学习模型能够自动学习文本的底层特征表示,而无需手动设计特征,大大减少了特征工程的难度。

其次,深度学习模型能够捕捉语义和上下文的信息,从而能够更好地理解文本的含义。

这使得深度学习模型在处理自然语言处理任务时表现出色,例如情感分析和文本生成等。

此外,深度学习模型具备优秀的泛化能力,即使在面对大规模和复杂的文本数据时,也能够取得较好的分类效果。

四、深度学习模型在处理不同类型文本中的应用深度学习模型在文本分类中的应用不仅限于处理简单的文本数据,还可以处理多种不同类型的文本。

基于Albert_与TextCNN_的中文文本分类研究

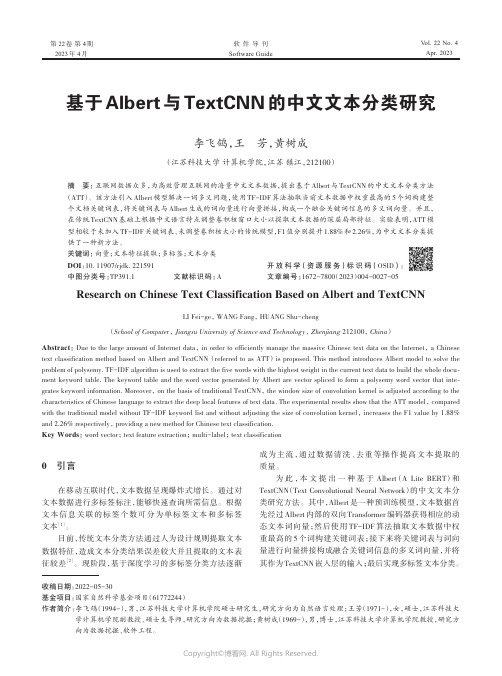

第 22卷第 4期2023年 4月Vol.22 No.4Apr.2023软件导刊Software Guide基于Albert与TextCNN的中文文本分类研究李飞鸽,王芳,黄树成(江苏科技大学计算机学院,江苏镇江,212100)摘要:互联网数据众多,为高效管理互联网的海量中文文本数据,提出基于Albert与TextCNN的中文文本分类方法(ATT)。

该方法引入Albert模型解决一词多义问题,使用TF-IDF算法抽取当前文本数据中权重最高的5个词构建整个文档关键词表,将关键词表与Albert生成的词向量进行向量拼接,构成一个融合关键词信息的多义词向量。

并且,在传统TextCNN基础上根据中文语言特点调整卷积核窗口大小以提取文本数据的深层局部特征。

实验表明,ATT模型相较于未加入TF-IDF关键词表、未调整卷积核大小的传统模型,F1值分别提升1.88%和2.26%,为中文文本分类提供了一种新方法。

关键词:向量;文本特征提取;多标签;文本分类DOI:10.11907/rjdk.221591开放科学(资源服务)标识码(OSID):中图分类号:TP391.1 文献标识码:A文章编号:1672-7800(2023)004-0027-05Research on Chinese Text Classification Based on Albert and TextCNNLI Fei-ge, WANG Fang, HUANG Shu-cheng(School of Computer, Jiangsu University of Science and Technology, Zhenjiang 212100, China)Abstract:Due to the large amount of Internet data, in order to efficiently manage the massive Chinese text data on the Internet, a Chinese text classification method based on Albert and TextCNN (referred to as ATT) is proposed. This method introduces Albert model to solve the problem of polysemy. TF-IDF algorithm is used to extract the five words with the highest weight in the current text data to build the whole docu‐ment keyword table. The keyword table and the word vector generated by Albert are vector spliced to form a polysemy word vector that inte‐grates keyword information. Moreover, on the basis of traditional TextCNN, the window size of convolution kernel is adjusted according to the characteristics of Chinese language to extract the deep local features of text data. The experimental results show that the ATT model, compared with the traditional model without TF-IDF keyword list and without adjusting the size of convolution kernel, increases the F1 value by 1.88% and 2.26% respectively, providing a new method for Chinese text classification.Key Words:word vector; text feature extraction; multi-label; text classification0 引言在移动互联时代,文本数据呈现爆炸式增长。

使用AI技术进行文本分类的常见方法

使用AI技术进行文本分类的常见方法概述文本分类是指根据文本内容的特征将其划分为不同类别的任务。

近年来,随着人工智能技术的快速发展,使用AI技术进行文本分类已经成为研究热点之一。

在本文中,我将介绍一些常见的AI技术在文本分类中的应用方法。

一、传统机器学习方法1. 基于词袋模型的方法基于词袋模型的方法是最早也是最简单的文本分类方法之一。

该方法将文本表示为一个向量,并计算每个词在向量中出现次数或者TF-IDF值。

然后,利用这些特征向量训练一个机器学习模型(如朴素贝叶斯、支持向量机等)来进行分类。

2. N-gram模型N-gram是指连续N个词组成的序列。

使用N-gram模型可以考虑上下文信息,在某些语境下更准确地表示文本内容。

基于N-gram模型的方法通常使用n元语法来提取特征,并将其输入到机器学习模型中。

3. 特征工程特征工程是指对原始文本数据进行转换和处理以提取有用特征。

在传统机器学习方法中,特征工程非常重要。

一些常见的特征包括词频、句法结构、主题模型等。

通过合理选择和设计特征,可以显著提高分类性能。

二、深度学习方法1. 卷积神经网络(CNN)卷积神经网络是深度学习中常用的模型之一,在图像处理领域取得了巨大成功。

近年来,人们发现CNN也可以应用于文本分类任务中。

CNN通过多层卷积和池化操作来提取不同层次的抽象特征,并将其作为输入送入全连接层进行分类。

2. 递归神经网络(RNN)递归神经网络是一种具有记忆功能的神经网络结构。

在文本分类中,RNN可以将上下文信息考虑进去,并学习到文本之间的依赖关系。

其中,长短期记忆网络(LSTM)和门控循环单元(GRU)是常用的RNN变体。

3. 注意力机制注意力机制是指模型能够更加关注输入序列中与当前任务相关或重要的部分。

在文本分类任务中,注意力机制可以帮助模型区分关键词语并进行准确分类。

4. 预训练模型预训练模型是指在大规模数据上进行预训练后得到的通用模型。

例如,BERT (Bidirectional Encoder Representations from Transformers)是一种经过预训练的语言表示模型,它学习到了丰富的语义信息,在文本分类中广泛应用。

基于深度学习的新闻文本分类系统

基于深度学习的新闻文本分类系统一、本文概述随着信息技术的快速发展和大数据时代的到来,新闻文本数据呈现出爆炸性增长的趋势。

如何从海量的新闻文本中快速、准确地提取出有价值的信息,成为当前研究的热点之一。

新闻文本分类作为一种有效的信息处理方法,能够将新闻文本按照不同的主题或类别进行划分,从而帮助用户更好地理解和利用新闻信息。

近年来,深度学习技术在自然语言处理领域取得了显著的进展,为新闻文本分类提供了新的解决方案。

本文旨在探讨基于深度学习的新闻文本分类系统的设计与实现,以期提高新闻文本分类的准确性和效率,为新闻信息处理和推荐提供有力支持。

本文首先介绍了新闻文本分类的研究背景和意义,分析了当前新闻文本分类面临的挑战和深度学习在其中的应用前景。

随后,详细阐述了基于深度学习的新闻文本分类系统的整体架构和关键技术,包括数据预处理、特征提取、模型训练与评估等方面。

在特征提取部分,重点介绍了卷积神经网络(CNN)和循环神经网络(RNN)等深度学习模型在新闻文本特征提取中的应用。

在模型训练与评估部分,通过实验对比了不同深度学习模型在新闻文本分类中的性能表现,并对实验结果进行了详细分析和讨论。

总结了本文的主要工作和贡献,并展望了基于深度学习的新闻文本分类系统未来的研究方向和应用前景。

通过本文的研究,旨在为新闻文本分类提供一种高效、准确的解决方案,推动新闻信息处理技术的发展和应用。

也为深度学习在自然语言处理领域的应用提供了一定的参考和借鉴。

二、相关理论和技术基础随着信息技术的迅猛发展,新闻文本数据呈现出爆炸性增长,如何有效地对这些数据进行分类和管理成为了亟待解决的问题。

基于深度学习的新闻文本分类系统应运而生,它利用深度学习模型强大的特征提取和分类能力,为新闻文本分类提供了新的解决方案。

深度学习是机器学习领域的一个新的研究方向,主要是通过学习样本数据的内在规律和表示层次,让机器能够具有类似于人类的分析学习能力。

在文本分类任务中,深度学习可以自动提取文本中的关键信息,避免了传统方法中手工提取特征的繁琐和主观性。

无监督文本分类的深度学习方法研究

无监督文本分类的深度学习方法研究随着互联网的迅猛发展和信息爆炸式增长,大量的文本数据涌现出来,给人们的信息获取和处理带来了巨大的挑战。

文本分类作为一种重要的文本挖掘技术,可以帮助人们快速准确地对海量文本进行分类和归类,从而更好地理解和利用这些信息。

然而,传统的文本分类方法需要大量的人工标注数据,而这种方法在处理大规模文本数据时效率低下。

因此,无监督文本分类的深度学习方法成为了研究的热点。

无监督文本分类的深度学习方法主要包括词向量表示、聚类和主题模型等技术。

首先,词向量表示是无监督文本分类的基础。

传统的文本分类方法通常使用词袋模型表示文本,但这种方法忽略了词与词之间的语义关系。

而深度学习方法通过训练神经网络模型,将每个词映射到一个低维的连续向量空间中,从而更好地捕捉词与词之间的语义信息。

常用的词向量表示方法有word2vec和GloVe等。

其次,聚类是无监督文本分类的关键技术之一。

聚类算法可以将相似的文本样本聚集到一起,形成不同的类别。

传统的聚类算法如K-means和层次聚类等需要预先指定聚类的个数,而且对初始聚类中心的选择非常敏感。

而深度学习方法通过自动学习数据的特征表示,可以更好地发现文本数据中的隐藏模式和潜在类别。

例如,基于深度自编码器的聚类方法将文本数据映射到一个低维的隐空间中,并通过最大化数据的重构误差来学习特征表示,从而实现无监督的文本聚类。

此外,主题模型也是无监督文本分类的重要方法之一。

主题模型可以将文本数据分解为若干个主题,每个主题包含一组相关的词。

传统的主题模型如LDA (Latent Dirichlet Allocation)可以有效地挖掘文本数据的主题结构,但是这种方法需要预先指定主题的个数,并且对于长文本数据的处理效果较差。

而基于深度学习的主题模型如LDA2Vec和Doc2Vec等可以通过学习文本数据的低维表示来实现主题的发现,从而避免了预先指定主题个数的问题,并且能够更好地处理长文本数据。

大模型做文本分类的案例

大模型做文本分类的案例1. 介绍在自然语言处理领域,文本分类是一个重要的任务,其目标是将给定的文本分为不同的预定义类别。

随着深度学习和大模型的发展,大规模的预训练语言模型被广泛应用于文本分类任务中。

这些大模型具有强大的表征能力和泛化能力,可以从海量的文本数据中学习到丰富的语义信息,从而提高文本分类的准确性和效率。

2. BERT模型BERT(Bidirectional Encoder Representations from Transformers)是一种基于Transformer的预训练语言模型,由Google于2018年提出。

BERT模型采用了双向的Transformer结构,能够同时考虑上下文信息,从而捕捉到词语之间的关系。

BERT模型在大规模文本数据上进行预训练,学习到了丰富的语义特征,可以用于各种自然语言处理任务,包括文本分类。

3. BERT在文本分类中的应用BERT模型在文本分类任务中的应用已经取得了显著的成果。

通过将文本输入BERT模型中,可以得到文本的向量表示,然后使用这些向量表示进行分类。

由于BERT模型具有强大的表征能力,可以从文本中学习到丰富的语义信息,因此在文本分类任务中取得了很好的效果。

4. 情感分析情感分析是文本分类的一个重要应用场景,其目标是判断文本中所表达的情感倾向,如正面、负面或中性。

大模型可以从大规模的文本数据中学习到丰富的情感特征,从而提高情感分析的准确性。

通过将文本输入BERT模型中,可以得到文本的向量表示,然后使用这些向量表示进行情感分类。

5. 文本主题分类文本主题分类是将文本分为不同主题的任务,例如新闻分类、微博分类等。

大模型可以从大规模的文本数据中学习到不同主题的语义特征,从而提高文本主题分类的准确性。

通过将文本输入BERT模型中,可以得到文本的向量表示,然后使用这些向量表示进行主题分类。

6. 命名实体识别命名实体识别是将文本中的命名实体(如人名、地名、组织机构名等)识别出来的任务。

《2024年基于深度学习的情感词向量及文本情感分析的研究》范文

《基于深度学习的情感词向量及文本情感分析的研究》篇一一、引言随着互联网的快速发展和普及,大量的文本数据在社交媒体、论坛、博客等平台上不断涌现。

对这些文本数据进行情感分析,对于理解公众情绪、市场趋势以及产品反馈等方面具有重要意义。

近年来,基于深度学习的情感词向量及文本情感分析技术得到了广泛关注。

本文旨在研究基于深度学习的情感词向量表示及文本情感分析方法,为相关领域的研究和应用提供参考。

二、深度学习与情感词向量表示1. 传统词向量表示的局限性传统的词向量表示方法,如Word2Vec、GloVe等,主要关注词的上下文关系,而忽略了词的情感色彩。

在情感分析任务中,具有情感色彩的词对于准确判断文本情感至关重要。

因此,传统的词向量表示方法在情感分析领域存在一定的局限性。

2. 情感词向量的提出与发展为了解决上述问题,研究者提出了情感词向量的概念。

情感词向量是在传统词向量基础上,融入了词的情感色彩信息。

通过训练大量带有情感标签的文本数据,可以学习到具有情感色彩的词向量表示。

这种表示方法能够更好地捕捉词的情感信息,提高情感分析的准确性。

三、深度学习在文本情感分析中的应用1. 循环神经网络(RNN)循环神经网络是一种适用于处理序列数据的神经网络结构。

在文本情感分析中,RNN可以捕捉文本的时序信息和上下文关系。

通过训练大量带有情感标签的文本数据,RNN可以学习到文本的情感特征,从而实现情感分析。

2. 卷积神经网络(CNN)与文本情感分析卷积神经网络在文本情感分析中主要用于提取文本的局部特征。

通过卷积操作和池化操作,CNN可以捕捉到文本中的关键信息,如关键词、短语等。

这些关键信息对于判断文本的情感具有重要意义。

结合深度学习技术,CNN可以进一步提高文本情感分析的准确性。

3. 深度学习在情感词向量学习中的应用深度学习在情感词向量学习中发挥了重要作用。

通过构建深度神经网络模型,可以学习到具有情感色彩的词向量表示。

这些词向量表示不仅包含了词的上下文信息,还融入了词的情感信息。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Computer Science and Application 计算机科学与应用, 2016, 6(11), 629-637 Published Online November 2016 in Hans. /journal/csa /10.12677/csa.2016.611077文章引用: 周盈盈, 范磊. 基于改进词向量模型的深度学习文本主题分类[J]. 计算机科学与应用, 2016, 6(11): 629-637.Deep Learning on Improved WordEmbedding Model for Topic ClassificationYingying Zhou, Lei FanSchool of Information Security Engineering, Shanghai Jiao Tong University, ShanghaiReceived: Oct. 18th , 2016; accepted: Nov. 6th , 2016; published: Nov. 9th, 2016Copyright © 2016 by authors and Hans Publishers Inc.This work is licensed under the Creative Commons Attribution International License (CC BY)./licenses/by/4.0/AbstractTopic classification has wide applications in content searching and information filtering. It can be divided into two core parts: text embedding and classification modeling. In recent years, methods have brought out significant results using distributed word embedding as input and convolutional neural network (CNN) as classifiers. This paper discusses the impact of different word embedding for CNN classifiers, proposes topic2vec, a new word embedding specifically suitable for Chinese corpora, and conducts an experiment on Zhihu, a representative content-oriented internet com-munity. The experiment turns out that CNN with topic2vec gains an accuracy of 98.06% for long content texts, 93.27% for short title texts and an improvement comparing with other word em-bedding models.KeywordsTopic Classification, Deep Learning, Convolutional Neural Network, Word Embedding基于改进词向量模型的深度学习文本主题分类周盈盈,范 磊上海交通大学信息安全工程学院,上海收稿日期:2016年10月18日;录用日期:2016年11月6日;发布日期:2016年11月9日Open Access周盈盈,范磊摘要主题分类在内容检索和信息筛选中应用广泛,其核心问题可分为两部分: 文本表示和分类模型。

近年来,基于分布式词向量对文本进行表示,使用卷积神经网络作为分类器的文本主题分类方法取得了较好的分类效果。

本文研究了不同词向量对卷积神经网络分类效果的影响,提出针对中文语料的topic2vec词向量模型。

本文利用该模型,对具有代表性的互联网内容生成社区“知乎”进行了实验与分析。

实验结果表明,利用topic2vec词向量的卷积神经网络,在长内容文本和短标题文本的分类问题中分别取得了98.06%,93.27%的准确率,较已知词向量模型均有显著提高。

关键词主题分类,深度学习,卷积神经网络,词向量1. 引言文本主题分类将文本按照潜在的主题进行分类,在内容检索和信息筛选中应用广泛,涉及语言学、自然语言处理、机器学习等领域。

文本主题分类的核心问题包括文本表示、分类模型等。

传统的文本表示方法主要基于词袋模型,该方法认为文档是无序词项的集合。

词袋模型存在数据稀疏问题,并且丢弃了词序、语法等文档结构信息,对分类效果的提升存在瓶颈。

传统的文本分类模型以词袋为输入特征,并基于一定的模型假设。

其基本思想是,假设数据分类服从某种概率分布,利用贝叶斯理论获得最佳的分类器。

由于对于数据附加了额外的假设,因此,一旦假设不成立则会严重影响模型准确率。

近年来,对文本分类问题的改进研究主要集中于深度学习。

针对深度学习的分类模型,文本表示可使用Mikolov等人提出的分布式词向量[1]方法。

该方法针对词袋模型中语义信息丢失的问题,利用语言神经网络将字典空间映射为词向量空间。

分析表明,对于空间距离相近的词项,其语义或词性也具有强关联性。

在分类模型方面,以分布式词向量作为模型的输入特征,循环神经网络、递归神经网络、卷积神经网络等深度学习模型都可应用于文本分类。

其中,Kim等人于2014年提出的卷积神经网络(CNN) [2][3] [4] [5]在文本主题分类中具有较高的准确率,在MR数据集[6]中的分类准确率达81.5%。

本文主要研究基于卷积神经网络的文本分类方法,并通过改进词向量空间模型提高分类的准确性。

针对中文语料的特点,提出了改进的词向量模型topic2vec,并通过对比实验,研究不同词向量作为卷积神经网络的输入特征,对分类准确率的影响,其中,利用topic2vec的卷积神经网络在长短语料中分别取得98.06%,93.27%的准确率,较其他词向量如word2vec [1]、GloVe [7]和随机词向量都有提高。

实验表明,对于中文语料而言,利用卷积神经网络进行文本主题分类是有效的,且将topic2vec作为原始特征的模型分类效果优于其他词向量。

本文的结构如下:第二章介绍文本分类的相关工作。

第三章介绍topic2vec模型的原理及文本分类模型的结构。

第四章介绍实验设定和实验结果,并对实验结果进行讨论。

第五章为总结。

2. 相关工作深度学习是文本分类的主流方法,取得比较好的效果。

其核心是卷积神经网络作为分类器,同时使用词向量模型作为文本表示。

周盈盈,范磊2.1. 卷积神经网络基于卷积神经网络的文本分类模型是一个有监督的三层网络模型,由输入层、隐层和输出层构成,通过后向传播算法[8]进行参数优化。

输入层为一组大小相等的文档矩阵,矩阵第n 行对应文档第n 个词项的向量表示;隐层通过一组不同大小的卷积核(filter)对文本进行自上而下的卷积运算,提取一组特征向量,并从每个特征向量中选取最大项(max-pooling [9]),组成特征地图;输出层通过Softmax 分类器[10]计算文档落在各个主题下的概率并输出最终分类结果。

模型结构如图1。

模型的训练使用极大似然估计,即求出一组参数θ,使得目标函数最大化()()(),log |,Tx y D p y x θθ∈∑()()()1log |,log exp K j j p y x y y θ==−∑其中T D 为训练集,K 为主题数,(),x y 为训练文档及其对应的正确主题分类标号。

模型采用随机梯度下降法(SGD)优化上述目标。

令学习率为α,在每一轮迭代中,随机选取一组样本()ˆˆ,xy ,并用下式进行一轮梯度迭代()()ˆˆlog |,p yx θθθαθ∂←+∂Zhang 等人[3]分别利用word2vec 、GloVe 、word2vec+GloVe 作为CNN 模型的输入特征,并在不同英文数据集下进行实验。

实验结果表明,对于不同数据集,word2vec 和GloVe 的分类效果各不相同,因此,词向量的选择直接影响模型的性能。

2.2. 分布式词向量词向量是深度学习模型的输入特征,根据向量之间的相关性,可分为随机词向量和分布式词向量。

随机词向量将词项随机表示为两两正交的单位向量,由1个1和W -1个0组成,其中W 为字典长度,其构造方式简单,但词项之间的关联关系则被完全割裂,并可能造成维数灾难。

分布式词向量则将词项表示为一个几十到几百维的稠密型实值向量,并可通过向量空间距离考察词项之间的语义相似度,其中,最具代表性的是word2vec 。

对于长度为N 的文档,word2vec 考察每个词项t w 的c 个上下文,其目标函数为极大对数似然Figure 1. Text classification model based on convolutional neural network图1. 基于卷积神经网络的文本分类模型周盈盈,范磊()()1,01log |Nt j t t c j c j p w w N+=−≤≤≠∑∑通过随机梯度下降法求解目标函数可得词向量。

其中,词项上下文的条件概率()|t j t p w w +由Softmax 函数给出()()()TT1exp |exp O IIw w O I Ww w w v v p w w vv==∑由于word2vec 仅考察目标词t w 的局部上下文,因此损失了语料中全文性的关联信息,主题模型可以体现语料的全文关联性信息。

2.3. 主题模型主题模型[11]是无监督的文本聚类模型。

模型由文档、词项、主题三个维度构成,通过模拟文档的生成过程,对文档在各主题下的概率分布矩阵θ和各个词语在各主题下的概率分布矩阵β进行参数估计。

假设θ服从先验分布()|p θα,接着随机为文档分配一个主题()~|z p z θ,并随机生成一个单词()~|,w p w z β。

假设语料库D 大小为M ,第d 篇文档长度为d N ,则语料库的目标函数为()()()()11|,|||,d dn n n dn N Md d d d d d d n z p D p p z p w z αβθαθβθ===∏∏∑∫ 将主题数设置为词向量的维度,得词项的稀疏主题分布向量,并可作为字典在向量空间的映射,通过向量空间距离考察词项的在全局语料范围内的主题相似度。