融合词向量及BTM模型的问题分类方法

面向专利的主题短语提取

2019年5月计算机工程与设计May2019第40卷第5期COMPUTER ENGINEERING AND DESIGN Vol.40No.5面向专利的主题短语提取马建红,姬帅,刘硕(河北工业大学计算机科学与软件学院,天津300401)摘要:在中文专利主题挖掘研究中,针对基于单词的传统主题模型结果可解释性较差问题,提出一种融合词向量和Generalized Polya urn(GPU)的改进模型GW_PhraseLDA。

根据专利文本特点,使用BLSTM-CRF模型进行专利短语抽取,利用训练好的词向量生成先验知识。

在Gibbs采样的迭代过程中,利用GPU策略提升语义相关短语在同一主题下的概率%在中文专利文本上的实验结果表明,所提模型能够有效提高专利主题生成质量,相比传统的主题模型更具可解释性和判别性。

关键词:专利挖掘;短语抽取;双向长短时记忆网络;条件随机场;主题模型中图法分类号:TP391文献标识号:A文章编号:1000-7024(2019)05-1365-05doi:10.16208/j.issnl000-7024.2019.05.031Topical phrase mining for patentMA Jian-hong,JI Shuai,LIU Shuo(School of Computer Science and Engineering,Hebei University of Technology,Tianjin300401,China) Abstract:In the study of Chinese patent topic mining,an improved model GW_PhraseLDA,which combined word vector and Generalized Polya urn(GPU),was proposed to solve the problem of poor interpretability of the result of the traditional topic model based on the word.According to the characteristics of the patent text,the BLSTM-CRF model was used to extract the patent phrases.The trained word vec t ors were used to generat e prior knowledge.In the iterative process of Gibbs sampling,the GPU strategy was used to improve the probability of semantic related phrases under the same topic.Results of experiments on Chinese patent texts show that the model proposed can effectively improve the quality of patent topic,which is much more interpretable and discriminant than traditional topic models.Key words:patent mining;term extraction;bidirectional long short-term memory;conditional random fields;topic model9引言以LDA为代表的主题模型为表示和总结大型语料库内容提供了一个强有力的框架与方法。

向量融合的方法

向量融合的方法

向量融合的方法主要包括以下几种:

1. 加权融合:将不同模态的特征向量按照一定的权重进行加权平均。

这个权重可以根据不同模态的重要性来进行设置。

2. 基于特征选择的融合:根据特征的重要性来选择不同模态的特征向量。

这个方法可以使用各种特征选择算法,例如互信息、相关系数等。

通过选择最重要的特征向量,可以获得更准确的融合结果。

3. 向量的外积:更具有表达性。

但是向量的外积会引起维度的急剧增加,因此需要进行降维和避免直接计算外积。

4. MCB(Multi-modal Compressed Basis)方法:通过双线性模型,利

用count sketch projection function将向量进行降维,从而避免直接计算外积。

以上是向量融合的几种方法,具体使用哪种方法取决于实际需求和数据情况。

自然语言处理中的词向量表示与文本分类

自然语言处理中的词向量表示与文本分类自然语言处理(Natural Language Processing,NLP)是人工智能领域的一个重要分支,旨在实现计算机对人类语言的理解和处理。

在NLP中,词向量表示和文本分类是两个重要的研究方向。

本文将介绍词向量表示的概念和方法,并探讨其在文本分类中的应用。

一、词向量表示的概念及方法在NLP中,词向量表示是将词语转化为数值向量的过程。

通过将词语映射到向量空间,可以将语义信息转化为数值,便于计算机进行处理和分析。

常见的词向量表示方法有以下几种:1. 独热编码(One-Hot Encoding)独热编码是最简单的词向量表示方法之一。

它将每个词语表示为一个与词汇表大小相等的向量,其中只有一个元素为1,其余元素都为0。

这种表示方法没有考虑词之间的语义关系,只是用来表示词语的存在与否。

2. 词袋模型(Bag-of-Words Model)词袋模型是将文本看作一个无序的词语集合,忽略词语在文本中的位置和顺序。

它将文本表示为一个固定长度的向量,向量的每个元素表示对应词语的出现次数或者TF-IDF值。

3. Word2VecWord2Vec是一种基于神经网络的词向量表示方法,通过训练一个两层的神经网络,学习到词语之间的语义关系。

它将每个词语表示为一个固定长度的向量,具有较强的语义表示能力。

4. GloVeGloVe(Global Vectors for Word Representation)是一种基于全局词共现统计的词向量表示方法。

它利用词语之间的共现信息,通过矩阵分解的方法得到词向量表示。

二、词向量表示在文本分类中的应用词向量表示在文本分类中具有重要的应用价值。

通过将文本转化为向量表示,可以利用机器学习算法对文本进行分类和预测。

以下是文本分类中常用的方法:1. 朴素贝叶斯分类器(Naive Bayes Classifier)朴素贝叶斯分类器是一种基于概率模型的文本分类方法。

基于双词语义增强的BTM主题模型研究

基于双词语义增强的BTM主题模型研究BTM(Biterm Topic Model)是一种用于文本主题建模的机器学习算法。

它基于词语共现的双词拓展(biterm expansion)方法,可以有效地挖掘主题信息。

传统的主题模型,如LDA(Latent Dirichlet Allocation),通常基于单个词语进行建模,而BTM则利用了双词的语义信息进行主题建模。

双词是由一个文档内的两个词语组成的,它可以捕捉更多的语义信息,因为两个词语的组合可能比单个词语更能表达主题。

BTM主题模型的基本思想是,首先将文档划分为双词,然后通过统计每个双词在主题下出现的次数,来估计每个主题的概率分布。

具体的步骤如下:1. 预处理:对文本进行预处理,包括分词、去除停用词等。

2. 双词提取:将文档划分为所有可能的双词对,记为BTM输入的数据。

3. 模型训练:利用BTM算法进行模型训练,得到每个主题的概率分布。

4. 主题推断:对新文档进行主题推断,即对文档中的双词进行主题分配。

BTM主题模型的核心优势在于其对双词语义的增强。

通过考虑双词的语义信息,BTM可以更准确地表示主题。

BTM还可以解决LDA中的稀疏问题,因为它将文档划分为双词对,增加了词语共现的次数,从而提高了模型的稳定性和性能。

BTM主题模型在中文文本建模中具有广泛应用。

可以将BTM应用于文本分类任务,通过挖掘文档中的主题信息,实现对文本的分类。

BTM还可以用于文本聚类、情感分析、信息检索等应用领域,提高文本分析的准确性和效果。

基于双词语义增强的BTM主题模型是一种有效的文本主题建模算法。

它通过考虑双词的语义信息,增强了主题建模的效果,并且可以应用于各种中文文本分析任务中。

融合HowNet和BTM模型的短文本聚类方法

融合HowNet和BTM模型的短文本聚类方法阳小兰;杨威;钱程;朱福喜【摘要】针对常规技术对短文本聚类时出现的相似度计算准确度较差、聚类结果不稳定等问题,提出一种以HowNet语义词库和BTM主题建模为基础的相似度计算方法,将两者进行线性组合,综合考察短文本的相似性.建立基于聚类质量和聚类差异度的聚类结果评价指标,进行优劣评价,过滤出质量较好的结果,利用CSPA融合算法进行聚类融合.实验结果表明,该方法提高了短文本相似度计算的准确性,改进了融合结果稳定性.%Using conventional techniques in the short-text clustering, the similarity calculation accuracy is poor, and the clustering result is unstable.A similarity calculation method based on HowNet semantics thesaurus and BTM topic model was proposed.Both of them were linearly combined and short text similarity was comprehensively studied.Evaluation based on the clustering quality and clustering degree of difference was established, it was used to evaluate advantages and disadvantages.Better quality results were filtered out, clustering integration was realized using CSPA fusion algorithm.Experimental results show that the proposed method improves the accuracy of the calculation of short-text similarity, and improves the stability of the fusion results.【期刊名称】《计算机工程与设计》【年(卷),期】2017(038)005【总页数】6页(P1258-1263)【关键词】短文本;知网;Biterm主题模型;聚类;融合【作者】阳小兰;杨威;钱程;朱福喜【作者单位】武昌理工学院信息工程学院,湖北武汉 430223;武汉大学计算机学院,湖北武汉 430072;武昌理工学院信息工程学院,湖北武汉 430223;武昌理工学院信息工程学院,湖北武汉 430223;武汉大学计算机学院,湖北武汉 430072【正文语种】中文【中图分类】TP391.1短文本数量庞大、长度短小、携带的信息相对较少,存在严重的特征稀疏问题。

基于双词语义增强的btm主题模型研究

文章编号:2096-1472(2020)-04-01-06DOI:10.19644/ki.issn2096-1472.2020.04.001软件工程 SOFTWARE ENGINEERING 第23卷第4期2020年4月V ol.23 No.4Apr. 2020基于双词语义增强的BTM 主题模型研究王云云,张云华(浙江理工大学信息学院,浙江 杭州 310018)1528723134@ ;605498519@摘 要:针对目前短文本在BTM主题模型建模过程中存在的共现双词之间语义联系较弱的问题,提出一种结合cw2vec词向量模型的改进BTM主题模型(cw2vec-BTM)。

使用cw2vec模型来训练短文本语料得到词向量,并计算词向量相似度。

然后通过设置采样阈值来改进BTM主题模型共现双词的采样方式,增加语义相关词语的被采样概率。

实验结果证明,本文提出的改进模型能有效地提高主题模型的主题凝聚度和KL散度。

关键词:短文本;BTM主题模型;词向量;吉布斯采样中图分类号:TP391.1 文献标识码:AResearch on BTM Topic Model Based on Two-Word Meaning EnhancementWANG Yunyun,ZHANG Yunhua(School of Information Science and Technology ,Zhejiang Sci-Tech University ,Hangzhou 310018,China )1528723134@;605498519@Abstract:Aimingat the problem of weak semantic relationship between co-occurrence words in the short text in the BTM topic model modeling process,an improved BTM topic model (cw2vec-BTM) combined with the cw2vec word vector model was proposed.This research uses the cw2vec model to train short text corpora to obtain word vectors and calculates the word vector similarity.Then by setting the sampling threshold,the sampling method for co-occurrence words in the BTM topic model is improved,while the sampling probability of semantically related words is increased.The experimental results prove that the improved model proposed in this paper can effectively improve the topic cohesion and KL divergence of the topic model.Keywords:short text;BTM topic model;word vector;gibbs sampling1 引言(Introduction)短文本字数少、篇幅小,在分析短文本时,很难准确的挖掘出语义信息。

融合词汇特征的生成式摘要模型

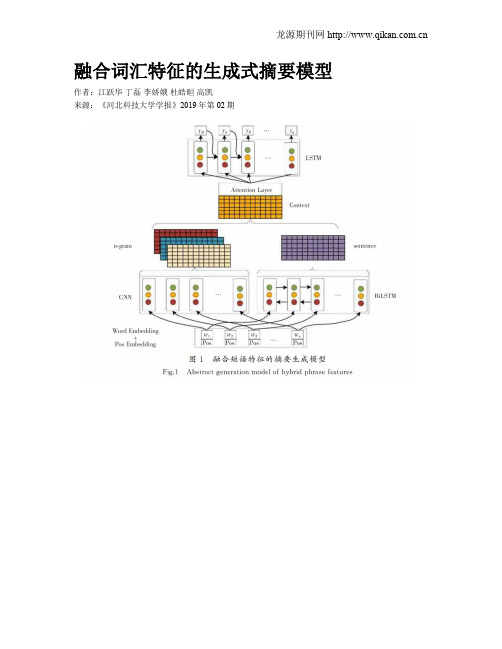

融合词汇特征的生成式摘要模型作者:江跃华丁磊李娇娥杜皓晅高凯来源:《河北科技大学学报》2019年第02期摘要:为了能在摘要生成过程中利用词汇特征(包含n-gram和词性信息)识别更多重点词汇内容,进一步提高摘要生成质量,提出了一种基于sequence-to-sequence(Seq2Seq)结构和attention机制的、融合了词汇特征的生成式摘要算法。

算法的输入层将词性向量与词向量合并后作为编码器层的输入,编码器层由双向LSTM组成,上下文向量由编码器的输出和卷积神经网络提取的词汇特征向量构成。

模型中的卷积神经网络层控制词汇信息,双向LSTM控制句子信息,解码器层使用单向LSTM为上下文向量解码并生成摘要。

实验结果显示,在公开数据集和自采数据集上,融合词汇特征的摘要生成模型性能优于对比模型,在公开数据集上的ROUGE-1,ROUGE-2,ROUGE-L分数分别提升了0.024,0.033,0.030。

因此,摘要的生成不仅与文章的语义、主题等特征相关,也与词汇特征相关,所提出的模型在融合关键信息的生成式摘要研究中具有一定的参考价值。

关键词:自然语言处理;文本摘要;注意力机制;LSTM;CNN中图分类号:TP319文献标志码:AAbstract: In order to use lexical features (including n-gram and part of speech information)to identify more key vocabulary content in the summarization generation process to further improve the quality of the summarization, an algorithm based on sequence-to-sequence (Seq2Seq)structure and attention mechanism and combining lexical features is proposed. The input layer of the algorithm combines the part of speech vector with the word vector, which is the input of the encoder layer. The encoder layer is composed of bi-directional LSTM, and the context vector is composed of the output of the encoder and the lexical feature vector extracted from the convolution neural network. The convolutional neural network layer in the model controls the lexical information, the bi-directional LSTM controls the sentence information, and the decoder layer uses unidirectional LSTM to decode the context vector and generates the summarization. The experiments on public dataset and the self-collected dataset show that the performance of the summarization generation model considering lexical feature is better than that of the contrast model. The ROUGE-1, ROUGE-2 and ROUGE-L scores on the public dataset are improved by 0.024, 0.033 and 0.030,respectively. Therefore, the generation of summarization is not only related to the semantics and themes of the article, but also to the lexical features.The proposed model provides a certain reference value in the research of generating summarization of integrating key infromation.Keywords:natural language processing; text summarization; attention mechanism; LSTM; CNN近年來,由于互联网技术的迅猛发展以及用户规模的爆发式增长,互联网的数据呈现指数级增长。

一种融合语义知识和bilstm-cnn的短文本分类方法

一种融合语义知识和bilstm-cnn的短文本分类方法

在近几年中,自然语言处理一直是人工智能领域发展的一个热点,其中短文本分类也受到了极大的关注。

短文本分类是基于短文本的分类任务,其优点是较少的数据量和简短的文本,导致它比其他文本分类任务更容易受外部影响。

为了解决这个问题,最近出现了一种融合语义知识和bilstm-cnn的短文本分类方法。

该方法利用语义知识和bilstm-cnn模型结合来解决短文本分类问题。

首先,借助语义知识,可以把短文本转换为多个关键字,用于后续模型训练。

然后,利用bilstm-cnn模型对这些转换后的关键字进行处理,可以获得更有用的信息。

在最后,利用关键字和模型抽取的信息,可以构建出一个多要素的特征向量,然后通过传统的机器学习算法对这个特征向量进行分类,从而实现短文本的分类。

这种模型的优势在于,它在保留短文本内容具体信息的同时,还把短文本的语义隐藏的更有用的特征融入到特征向量中,使得分类任务更准确完成。

总之,融合语义知识和bilstm-cnn的这种短文本分类方法在短文本分类任务中发挥了重要作用,可以很好地捕捉短文本的语义特征信息,使分类准确率提升。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2019年2月计算机工程与设计 Feb.2019第 %〇卷第 2 期 COMPUTER ENGINEERING ANDDESIGN Vol.40 No.2融合词向量及BTM模型的问题分类方法黄贤英,谢晋+,龙姝言(重庆理工大学计算机科学与工程学院,重庆400054)摘要:针对传统短文本分类算法对问题分类效果不佳的问题,提出一种融合词向量及B T M模型的问题分类方法。

使用 Word2vec对问题语料库进行训练得到词向量;对语料进行基于吉布斯采样的B T M主题模型构建,得到文本主题扩展向 量;将文本主题扩展向量与词向量拼接得到新的问句扩展文本,利用S V M进行文本分类。

实验结果表明,该方法在准确 率、召回率及F值上的表现均有提高。

关键词:问答系统'问题分类;词向量'B T M主题模型;问句扩展中图法分类号!TP391 文献标识号:A文章编号$ 1000-7024 (2019) 02-0384-05doi: 10. 16208!. issnl000-7024. 2019. 02. 015Q u estio n classification m ethod com bining w ord vector and B T M m odelH U A N G X ia n-y in g,X IE J in+ &L O N G S hu-yan(College of Computer Science and Engineering,Chongqing University of Technology,Chongqing 400054, China) Abstract:As the traditional short text classification algorithms do not work well in classification,a problem classification method based on the fusion of word vector and B TM model was proposed.Word2vec was used to train the corpus and word vector was obtained.The B TM t opic modd was constructed based on Gibbs sampling of data.The text topic extension vector and the word vector were spliced to ge t the new ques t ion extension text and text classification was implemented based resu1t s show t h a t using t h e proposed me t hod improves t h e accuracy,recall rat e and F valu.. Keywords:Q A#question classification;w ordvector;B TM m odel;questionexpansion/引言问答系统(Q A)的任务是快速的为用户提出的问题提 供一个用户满意的答案[1],而在回答问题的过程中蕴含着许 多信息检索领域息息相关的技术。

通常来说,问答系统包括 三个重要模块:对用户所提出问题的分析、对信息进行检索 和抽取出最优答案集合)]。

问题分析作为问答系统的第一项 关键技术,其主要工作是分析用户问句所包含的信息,而分 析问句的关键环节就是对问题进行分类,所以从某种程度上 来说,问题分类效果影响着问答系统的工作效率)]。

问题文本指的是要求问答系统回答或者解释的文本,一般来说问题文本的长度较短且重复的词项较少,所以问 题分类不可以看作为一般的文本分类任务)]。

与文本分类 相比,问题分类存在不少难题,首先问题文本长度较短,形成的特征向量空间存在较大的稀疏性;其次,问题文本难以找到合适的方法或者模型来表示;再次,由于问题文 本中的重复的词项较少,那么词频就不能作为问句特征的衡量标准)5]。

目前在问题分类研究领域,使用的工具和方法与短文 本分类相似,大致分为两个方向,第一种是基于规则的分 类方式;第二种是基于数理统计的机器学习算法。

张栋 等[6]在扩充问句特征的过程中,将答案语料融人原始的问 句文本;冶忠林等)]利用搜索引擎来扩展知识库,并结合 L D A来进行主题模型的构建;文献)]中引人词向量模 型来代替传统的空间向量模型;张青等[9]提出一种优质主 题的思想,并使用L D A模型扩展文本的特征项。

近些年,随着信息检索、文本表示相关领域的飞速发展,专家学者 意识到L D A主题模型对短文本建模的稀疏问题。

Yan 等)0]提出中文短文本双词主题模型BTM(biterm topic model),改善了 L D A主题模型的建模缺陷;刘良选等)1]收稿日期:2017-12-26;修订日期:2019-01-08基金项目:国家社会科学基金项目(17XXW004);重庆市教委基金项目(15YK790061)作者简介:黄贤英(1967 -)女,重庆人,硕士,教授,CCF会员,研究方向为信息检索;+通讯作者:谢晋(1993 -)男,湖北 十堰人,硕士研究生,研究方向为信息检索、文本挖掘;龙姝言(1992-)女,重庆人,硕士研究生,研究方向为推荐系统。

E-mail:895309382@第40卷第2期黄贤英,谢晋,龙姝言:融合词向量及BTM模型的问题分类方法•385 •提出基于词向量参数分布的文本分类算法,并采用B T M主题建模;郑诚等[12]在进行文本分类时,两次使用B T M建模,达到扩充训练集的效果,得到最大的语料库,从而提高文本分类的准确率。

现存的问题文本语句较短、特征稀疏,使用传统的短文本分类算法无法解决数据稀疏的问题,从而导致分类效果较差。

本文针对传统短文本分类算法存在的不足,提出融合词向量及B T M模型的问题分类方法,核心思想是首先融合全部的问题语料文本及答案语料,随后对该大规模文本进行词向量的扩充,然后使用B T M主题模型建模,最后 将上述过程形成的向量进行组合,得到最终的问答语料向 量,使用SVM(support vectormachine)来进行问题分类 检验。

对比传统算法及单一模型,分析实验结果。

1词向量及B T M建模1.1 利用word2vec产生词向量T om asM ikolov在N N L M和R N N L M的基础上提出了 Word2vec,传统的N N LM(前馈神经网络模型)由输入 层、映射层、隐藏层和输出层4部分构成,而随后产生的 R N N L M在N N L M基础上对于使用环境进行了优化)3]。

W o d2vec可以在百万数量级的词典和上亿的数据集上进行 高效的训练,该工具得到的词向量(word embedding),可 以很好地度量词与词之间的相似性)4]。

作者提出了两种计 算模型分别是C BO W和Skip-gram。

这两个模型的区别在 于CBOW模型是输入当前词项相邻的4个词项来进行预测 并输出当前词项,而Skip-gram模型是输入当前词项来进 行预测并输出当前词相邻的4个词,如图1和图2所示。

图1CBOW模型的工作原理1.2 B T M主题建模传统的主题模型主要是通过计算词项在文档中的重要 程度来进行模型建立,当语料较短时难以计算词项的重要 性,导致数据稀疏。

针对L D A对短文本建模的缺陷,B TM 主题模型应运而生,B T M模型的思想是对训练集中的同一 上下文共同出现的一对无序词项进行建模。

通过分析建模 的结果,两个词项是否属于同一类别取决于它们的共现次图2 Skip-gram模型的工作原理数。

在B T M模型中,假设多个主题模型的混合分布产生全 部的训练集,全局的主题分布中产生每个主题。

D表示训练集语料,W${it#,…,_}表示从训练集语 料中建模得到的双词集合,圳表示一个双词单元$,,,也2)。

假定a和卢是D irichlet先验参数。

利用B T M模型进 行模型建立的全过程如图3所示。

上图中,K为人为确定的主题个数,彡为文本语料库上 的主题分布,^为该主题下的词项分布,M^()为多项分 布,D ir()表示D irichlet分布。

Z为主题0的D irichlet分布。

B T M模型建立步骤如下:$)通过D irichlet分布从参数^中抽样出一个主题下的词分布〜D V$) #$)在a的D irichlet分布中,抽样出文本训练集的全 局主题分布^〜D V$) #$)从短文本语料库共同参数彡抽取主题Z,服从 Z〜M tdt$) #$)设语料中的一个词对为6,6 $ (l o i),从上述 抽取的主题Z中抽取^,i•这两个词,并使其服从取,10 〜M idt('(p Z) #()从短文本语料库共同参数彡抽取主题Z,服从 Z〜Midt() #(6)设语料中的一个词对为6,6 $ (l o i),从上述 抽取的主题Z中抽取这两个词,并使其服从取,U0 〜MidtC(p Z)。

•386 •计算机工程与设计2019 年2融合词向量及B T M的问题分类方法2.1方法流程使用L D A主题模型对长文本建模往往有着良好的效果,而当面对较短的文本语料时,由于无法合适的计算出 词项的重要程度,容易发生数据稀疏的问题,本文提出融 合词向量及B T M模型的问题分类方法,新的问题分类流程 框架如图4所示。

该模型主要得关键步骤如下:第一,对 问句训练集进行B T M主题模型的训练;第二,训练得到融 合了问句及答句语料的词向量;第三,利用前两步的结果 来提取相关的特征值,并将特征值作为问句的扩展,充分 扩展短文本的规模,提升分类效果[15]。

融合所有的问句及答句语料,并对大规模语料预处理;(2%利用word2vec训练得到词向量;(3)对大规模语料进行B T M主题建模;$%利用B T M建模得到的主题特征向量及训练得到的 词向量,扩充原始问句;$)利用支持向量机(SVM)对扩展后的文本进行分 类测试,检验本文方法的分类效果。

图4 融合词向量及B T M模型的问题分类流程框架2.2融合词向量及B T M模型的问句表示在前期实验过程中经过不断的观察,发现许多的问答 组合中,答句中也存在较大的信息量,所以在使用w or d2ve c训练词向量时,有意融合问句及答句,这使得原 始训练集的信息量更大。

第一步将所有的问句文本连同答 句文本融合成为单个训练集,第二步使用融合而成的单个 训练集来得到词向量。