支持向量机算法以及Libsvm工具箱介绍

C中的机器学习框架和深度学习

C中的机器学习框架和深度学习近年来,机器学习和深度学习技术迅速发展,已经在各个领域展现出强大的应用潜力。

然而,在C语言这门古老而经典的编程语言中,很多开发者也希望能够利用其底层的优势来实现机器学习和深度学习。

因此,在C语言中,一些机器学习框架和深度学习库应运而生,本文将介绍其中几个主要的框架。

一、LibSVMLibSVM是一个成熟且高效的C语言机器学习库,它主要用于支持向量机(Support Vector Machine)的建模和训练。

支持向量机是一种广泛应用于分类和回归问题的有监督学习算法,具有较强的泛化能力和鲁棒性。

LibSVM提供了多种核函数和参数配置,可以满足不同问题的需求。

并且,LibSVM还提供了Python、Java和Matlab等语言的接口,方便与其他语言进行交互。

二、TinyAITinyAI是一个轻量级的机器学习框架,专门设计用于嵌入式系统和边缘计算设备。

相比于其他框架,TinyAI具有较小的体积和低功耗的特点,非常适合资源受限的环境。

TinyAI提供了一系列优化的机器学习算法,如线性回归、逻辑回归和决策树等。

开发者可以使用TinyAI在C语言中快速实现一些简单的机器学习任务。

三、MidgardMidgard是一个C语言深度学习框架,致力于将深度学习引入到低功耗嵌入式系统中。

Midgard提供了基础的深度学习算法实现,如卷积神经网络和循环神经网络等。

此外,Midgard还支持自定义网络结构和优化算法,方便开发者根据自己的需求进行定制化。

虽然相对于其他深度学习框架而言,Midgard的功能相对较弱,但它在资源受限的环境下的性能表现非常出色。

四、EigenEigen是一个开源的C++模板库,提供了丰富的线性代数运算和矩阵计算功能。

虽然Eigen是使用C++编写的,但由于C++与C语言兼容,因此可以在C程序中使用Eigen进行矩阵计算和数值分析。

矩阵计算在机器学习和深度学习中起到至关重要的作用,Eigen的出现使得C语言开发者能够方便地进行各种数学计算,并结合其他机器学习库进行综合应用。

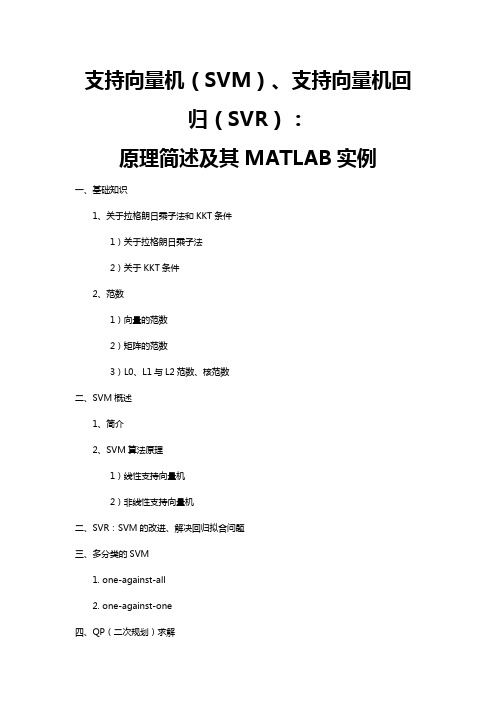

支持向量机(SVM)、支持向量机回归(SVR):原理简述及其MATLAB实例

支持向量机(SVM)、支持向量机回归(SVR):原理简述及其MATLAB实例一、基础知识1、关于拉格朗日乘子法和KKT条件1)关于拉格朗日乘子法2)关于KKT条件2、范数1)向量的范数2)矩阵的范数3)L0、L1与L2范数、核范数二、SVM概述1、简介2、SVM算法原理1)线性支持向量机2)非线性支持向量机二、SVR:SVM的改进、解决回归拟合问题三、多分类的SVM1. one-against-all2. one-against-one四、QP(二次规划)求解五、SVM的MATLAB实现:Libsvm1、Libsvm工具箱使用说明2、重要函数:3、示例支持向量机(SVM):原理及其MATLAB实例一、基础知识1、关于拉格朗日乘子法和KKT条件1)关于拉格朗日乘子法首先来了解拉格朗日乘子法,为什么需要拉格朗日乘子法呢?记住,有需要拉格朗日乘子法的地方,必然是一个组合优化问题。

那么带约束的优化问题很好说,就比如说下面这个:这是一个带等式约束的优化问题,有目标值,有约束条件。

那么你可以想想,假设没有约束条件这个问题是怎么求解的呢?是不是直接 f 对各个 x 求导等于 0,解 x 就可以了,可以看到没有约束的话,求导为0,那么各个x均为0吧,这样f=0了,最小。

但是x都为0不满足约束条件呀,那么问题就来了。

有了约束不能直接求导,那么如果把约束去掉不就可以了吗?怎么去掉呢?这才需要拉格朗日方法。

既然是等式约束,那么我们把这个约束乘一个系数加到目标函数中去,这样就相当于既考虑了原目标函数,也考虑了约束条件。

现在这个优化目标函数就没有约束条件了吧,既然如此,求法就简单了,分别对x求导等于0,如下:把它在带到约束条件中去,可以看到,2个变量两个等式,可以求解,最终可以得到,这样再带回去求x就可以了。

那么一个带等式约束的优化问题就通过拉格朗日乘子法完美的解决了。

更高一层的,带有不等式的约束问题怎么办?那么就需要用更一般化的拉格朗日乘子法,即KKT条件,来解决这种问题了。

大数据十大经典算法SVM-讲解PPT

contents

目录

• 引言 • SVM基本原理 • SVM模型构建与优化 • SVM在大数据处理中的应用 • SVM算法实现与编程实践 • SVM算法性能评估与改进 • 总结与展望

01 引言

算法概述

SVM(Support Vector Machine,支持向量机)是一种监督学习模型,用于数据 分类和回归分析。

性能评估方法

01

准确率评估

通过计算模型在测试集上的准确率来评估SVM算法的性能,准确率越

高,说明模型分类效果越好。

02

混淆矩阵评估

通过构建混淆矩阵,可以计算出精确率、召回率、F1值等指标,更全面

地评估SVM算法的性能。

03

ROC曲线和AUC值评估

通过绘制ROC曲线并计算AUC值,可以评估SVM算法在不同阈值下的

核函数是SVM的重要组成部分 ,可将数据映射到更高维的空 间,使得原本线性不可分的数 据变得线性可分。常见的核函 数有线性核、多项式核、高斯 核等。

SVM的性能受参数影响较大, 如惩罚因子C、核函数参数等 。通过交叉验证、网格搜索等 方法可实现SVM参数的自动调 优,提高模型性能。

SVM在文本分类、图像识别、 生物信息学等领域有广泛应用 。通过具体案例,可深入了解 SVM的实际应用效果。

SVM算法实现步骤

模型选择

选择合适的SVM模型,如CSVM、ν-SVM或One-class SVM等。

模型训练

使用准备好的数据集对SVM模 型进行训练,得到支持向量和 决策边界。

数据准备

准备用于训练的数据集,包括 特征提取和标签分配。

参数设置

设置SVM模型的参数,如惩罚 系数C、核函数类型及其参数 等。

《支持向量机SVM》课件

多分类SVM

总结词

多类分类支持向量机可以使用不同的核函数和策略来解决多 类分类问题。

详细描述

多类分类支持向量机可以使用不同的核函数和策略来解决多 类分类问题。常用的核函数有线性核、多项式核和RBF核等 。此外,一些集成学习技术也可以与多类分类SVM结合使用 ,以提高分类性能和鲁棒性。

03

SVM的训练与优化

细描述

对于非线性数据,线性不可分SVM通 过引入核函数来解决分类问题。核函 数可以将数据映射到更高维空间,使 得数据在更高维空间中线性可分。常 用的核函数有线性核、多项式核和径 向基函数(RBF)。

通过调整惩罚参数C和核函数参数, 可以控制模型的复杂度和过拟合程度 。

详细描述

多分类支持向量机可以通过两种策略进行扩展:一对一(OAO)和一对多(OAA)。 在OAO策略中,对于n个类别的多分类问题,需要构建n(n-1)/2个二分类器,每个二分 类器处理两个类别的分类问题。在OAA策略中,对于n个类别的多分类问题,需要构建

n个二分类器,每个二分类器处理一个类别与剩余类别之间的分类问题。

鲁棒性高

SVM对噪声和异常值具有 一定的鲁棒性,这使得它 在许多实际应用中表现良 好。

SVM的缺点

计算复杂度高

对于大规模数据集,SVM的训练时间可能会很长,因为其需要解决一 个二次规划问题。

对参数敏感

SVM的性能对参数的选择非常敏感,例如惩罚因子和核函数参数等, 需要仔细调整。

对非线性问题处理有限

SVM的优点

分类效果好

SVM在许多分类任务中表 现出了优秀的性能,尤其 在处理高维数据和解决非 线性问题上。

对异常值不敏感

SVM在训练过程中会寻找 一个最优超平面,使得该 平面的两侧的类别距离最 大化,这使得SVM对异常 值的影响较小。

支持向量机原理SVMPPT课件

回归分析

除了分类问题,SVM也可以用于 回归分析,如预测股票价格、预 测天气等。通过训练模型,SVM

能够预测未知数据的输出值。

数据降维

SVM还可以用于数据降维,通过 找到数据的低维表示,降低数据

的复杂性,便于分析和理解。

02 支持向量机的基本原理

线性可分与不可分数据

线性可分数据

在二维空间中,如果存在一条直线, 使得该直线能够将两类样本完全分开 ,则称这些数据为线性可分数据。

支持向量机原理 svmppt课件

目录

CONTENTS

• 引言 • 支持向量机的基本原理 • 支持向量机的数学模型 • 支持向量机的优化问题 • 支持向量机的核函数 • 支持向量机的训练和预测 • 支持向量机的应用案例 • 总结与展望

01 引言

什么是支持向量机

定义

支持向量机(Support Vector Machine,简称SVM)是一种监督学习算法, 用于分类和回归分析。它通过找到一个超平面来分隔数据集,使得分隔后的两 类数据点到该平面的距离最远。

支持向量机的优势和局限性

01

对大规模数据集效 率较低

对于大规模数据集,支持向量机 可能需要较长时间进行训练和预 测。

02

核函数选择和参数 调整

核函数的选择和参数调整对支持 向量机的性能有很大影响,需要 仔细选择和调整。

03

对多分类问题处理 不够灵活

对于多分类问题,支持向量机通 常需要采用一对一或一对多的策 略进行处理,可能不够灵活。

图像识别

• 总结词:支持向量机用于图像识别,通过对图像特征的提取和分类,实现图像 的自动识别和分类。

• 详细描述:支持向量机在图像识别中发挥了重要作用,通过对图像特征的提取 和选择,将图像数据映射到高维空间,然后利用分类器将相似的图像归为同一 类别,不相似图像归为不同类别。

libsvm参数说明

libsvm参数说明【原创实用版】目录1.LIBSVM 简介2.LIBSVM 参数说明3.LIBSVM 的使用方法4.LIBSVM 的应用场景5.总结正文1.LIBSVM 简介LIBSVM(Library for Support Vector Machines)是一个开源的支持向量机(SVM)算法库,它提供了一系列用于解决分类和回归问题的高效算法。

LIBSVM 由 Chenning Peng 和 Tsung-Yuan Lee 开发,是 SVM 领域最为知名和广泛使用的工具之一。

2.LIBSVM 参数说明LIBSVM 包含了许多参数,这些参数可以影响模型的性能。

以下是一些重要的 LIBSVM 参数及其说明:- "kernel": 指定核函数类型,如"linear"(线性核)、"rbf"(高斯径向基函数核)等。

- "C": 指定惩罚参数 C,用于控制模型对训练数据的拟合程度。

较小的 C 值会导致更宽松的边界,可能允许一些误分类,但可以提高模型的泛化能力。

较大的 C 值则会强制模型在训练集上尽量减少误差,可能导致过拟合。

- "degree": 指定多项式核函数的阶数。

- "gamma": 指定高斯核函数的参数,用于控制核函数的形状。

- "coef0": 指定拉格朗日乘子 alpha 的初始值。

- " CacheSize": 指定 LIBSVM 使用的内存缓存大小。

3.LIBSVM 的使用方法使用 LIBSVM 主要包括以下步骤:(1)数据预处理:将数据集分为特征矩阵 X 和目标向量 y。

(2)训练模型:调用 LIBSVM 的 train 函数,传入预处理后的数据和参数设置,训练 SVM 模型。

(3)预测:使用训练好的模型,调用 LIBSVM 的 predict 函数,对新的数据进行分类预测。

LIBSVM使用方法

LIBSVM1 LIBSVM简介LIBSVM是台湾大学林智仁(Lin Chih-Jen)副教授等开发设计的一个简单、易于使用和快速有效的SVM模式识别与回归的软件包,他不但提供了编译好的可在Windows 系列系统的执行文件,还提供了源代码,方便改进、修改以及在其它操作系统上应用;该软件还有一个特点,就是对SVM所涉及的参数调节相对比较少,提供了很多的默认参数,利用这些默认参数就可以解决很多问题;并且提供了交互检验(Cross -SVM回归等问题,包括基于一对一算法的多类模式识别问题。

SVM用于模式识别或回归时,SVM方法及其参数、核函数及其参数的选择,目前国际上还没有形成一个统一的模式,也就是说最优SVM算法参数选择还只能是凭借经验、实验对比、大范围的搜寻或者利用软件包提供的交互检验功能进行寻优。

ν-SVM回归和ε-SVM分类、νValidation)的功能。

该软件包可以在.tw/~cjlin/免费获得。

该软件可以解决C-SVM分类、-SVM回归等问题,包括基于一对一算法的多类模式识别问题。

SVM用于模式识别或回归时,SVM方法及其参数、核函数及其参数的选择,目前国际上还没有形成一个统一的模式,也就是说最优SVM算法参数选择还只能是凭借经验、实验对比、大范围的搜寻或者利用软件包提供的交互检验功能进行寻优。

2 LIBSVM使用方法LibSVM是以源代码和可执行文件两种方式给出的。

如果是Windows系列操作系统,可以直接使用软件包提供的程序,也可以进行修改编译;如果是Unix类系统,必须自己编译,软件包中提供了编译格式文件,我们在SGI工作站(操作系统IRIX6.5)上,使用免费编译器GNU C++3.3编译通过。

2.1 LIBSVM 使用的一般步骤:1) 按照LIBSVM软件包所要求的格式准备数据集;2) 对数据进行简单的缩放操作;3) 考虑选用RBF 核函数;4) 采用交叉验证选择最佳参数C与g;5) 采用最佳参数C与g 对整个训练集进行训练获取支持向量机模型;6) 利用获取的模型进行测试与预测。

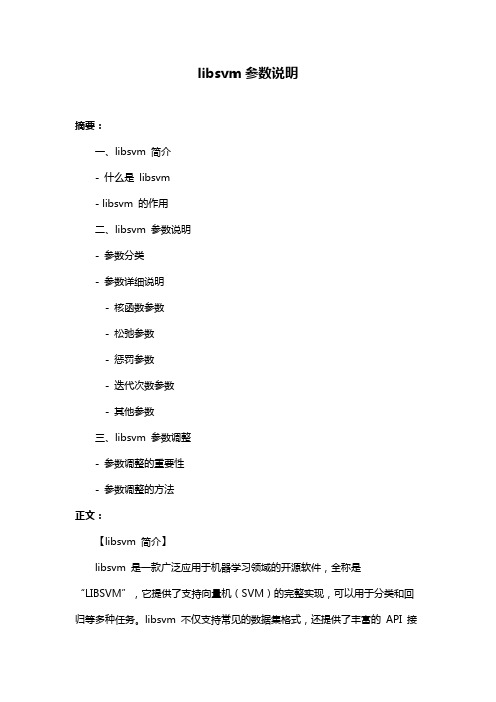

libsvm参数说明

libsvm参数说明摘要:一、libsvm 简介- 什么是libsvm- libsvm 的作用二、libsvm 参数说明- 参数分类- 参数详细说明- 核函数参数- 松弛参数- 惩罚参数- 迭代次数参数- 其他参数三、libsvm 参数调整- 参数调整的重要性- 参数调整的方法正文:【libsvm 简介】libsvm 是一款广泛应用于机器学习领域的开源软件,全称是“LIBSVM”,它提供了支持向量机(SVM)的完整实现,可以用于分类和回归等多种任务。

libsvm 不仅支持常见的数据集格式,还提供了丰富的API 接口,方便用户进行二次开发和应用。

libsvm 的主要作用是帮助用户解决高维数据分类和回归问题。

在面对高维数据时,传统的分类算法可能会遇到“维数灾难”,导致分类效果不佳。

而libsvm 通过使用核函数技术,将高维数据映射到低维空间,从而有效地解决了这个问题。

【libsvm 参数说明】libsvm 提供了丰富的参数供用户调整,以达到最佳分类效果。

这些参数主要分为以下几类:1.核函数参数:包括核函数类型(如线性核、多项式核、径向基函数核等)和核函数参数(如径向基函数核的核径宽)。

2.松弛参数:用于控制分类间隔的大小,对最终分类结果有一定影响。

3.惩罚参数:控制模型对误分类的惩罚力度,对分类效果有重要影响。

4.迭代次数参数:控制支持向量机算法的迭代次数,影响模型的收敛速度。

5.其他参数:如学习率、最小化目标函数的迭代次数等。

【libsvm 参数调整】参数调整是libsvm 使用过程中非常重要的一环,合适的参数设置可以使模型达到更好的分类效果。

参数调整的方法主要有以下几种:1.网格搜索法:通过遍历参数空间的各个点,找到最佳参数组合。

这种方法适用于参数空间较小的情况。

2.随机搜索法:在参数空间中随机选取一定数量的点进行遍历,找到最佳参数组合。

这种方法适用于参数空间较大,且网格搜索法效果不佳的情况。

3.贝叶斯优化法:利用贝叶斯理论,对参数进行加权调整,以提高搜索效率。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

SVM工具箱介绍

Libsvm函数

参数优化

KKT条件:

bL

(

i 1

l i 1

l

i

i) 0

w L w ( i i ) x i 0

L C i

i

()

i

( )

0

i ( i ( w , xi ) b y i ) 0

SVM优化算法

SVM工具箱介绍

Libsvm函数

参数优化

引入Lagrange函数:

m in

l

1 2

|| w || C ( i i ) ( i i i i ) i ( i ( w , x i ) b y i )

2 i 1 i 1 i 1

Svmpredict()函数

Svmpredict函数用于预测,将模型和预测样本输入就能够输 出预测数据,以及预测精度。 [T, accuracy, prob_estimates] = svmpredict(Ytest,Xtest,model);

SVM原理介绍

SVM优化算法

SVM工具箱介绍

Libsvm函数

2

/ )

2

Sogmiod核函数: K ( X , X i ) = tan h (v( X X i )+ c)

SVM原理介绍

SVM优化算法

Libsvm工具箱

Libsvm函数

参数优化

LIBSVM

LIBSVM是台湾大学林智仁(Lin Chih-Jen)副教授等开发 设计的一个简单、易于使用和快速有效的SVM模式识 别与回归的软件包,他不但提供了编译好的可在 Windows系列系统的执行文件,还提供了源代码,方便 改进、修改以及在其它操作系统上应用;该软件对 SVM所涉及的参数调节相对比较少,提供了很多的默 认参数,利用这些默认参数可以解决很多问题;并提 供了交互检验(Cross Validation)的功能。该软件包可在 .tw/~cjlin/免费获得。该软件可以 解决C-SVM、ν-SVM、ε-SVR和ν-SVR等问题,包括基 于一对一算法的多类模式识别问题。

l

l

l

i ( i ( w , x i ) b y i )

i 1

其中 η,η,α,α为Lagrange乘子,满足:

i

()

( i , i ) 0, i

()

( i , i ) 0

由此得到该问题的KKT条件。

SVM原理介绍

SVM优化算法

SVM原理介绍

SVM优化算法

SVM工具箱介绍

Libsvm函数

参数优化

非线性回归函数估计决策函数:

f (x)

l

( i i

()

) ( x i , x ) b

i 1

多项式核函数: 径项基核函数:

K ( X , X i ) = [( X X i )+ 1 ]

q

K ( X , X i ) = e x p (- X - X i

SVM原理介绍

SVM优化算法

SVM工具箱介绍

Libsvm函数

参数优化

留一法

将原始数据集DataSet均分为N份:一份作为测试集,即 testingSet,其余作为训练集,即trainingSet,然后分别 用训练集中一个数据去做测试,用其余数据去验证;将 N次所得的误差经行处理作为总体数据的预测误差。

SVM原理介绍

SVM优化算法

SVM工具箱介绍

Libsvm函数

参数优化

K折法

将原始数据集DataSet均分为N份:K份作为训练集,即 testingSet,其余N-K作为测试集,即trainingSet,然后用 训练集去做训练,用测试集去验证;之后再分别将训练 集作为测试集,测试集作为训练集进行迭代一次,将K 次所得的误差经行处理作为总体数据的预测误差。

(1)

SVs

x1 , , x i , , x n

w

(2) ,然后求出b

由KKT条件的

l

( i i ) x i

i 1

所以最终表达式变成

f (x)

l

i 1

( i i ( ) )( x i x ) b

= s v _ c o e f s v '

*

Y=w.X+b

长度为

间隔=w.w

图2

SVM原理介绍

SVM优化算法

SVM常用工具箱

Libsvm函数

参数优化

Support vector machine

样本数据集为线性时,f(x)可以表示为:

f ( x) (w, x) b, w X

N

,b R

N

求解以下二次优化问题,得到向量w

yi ( w , xi ) b m in | w | s .t . 2 ( w , xi ) b yi i , i ,得到以下问题 允许误差存在,引入松弛变量

i , j 1

l

( i i )(

j

j

)( x i , x j )

l

( i i )

i 1

l

y i ( i i )

i 1

(

i 1

l

i

i ) 0, i , i [0, C ]

通过求解该对偶问题求解

sv_ co ef 1 1 , , i i , , n n

支持向量机算法以及Libsvm 工具箱介绍

汇报人:ctj

SVM原理介绍

SVM优化算法

SVM常用工具箱

Libsvm函数

参数优化

Support vector machine

一元回归方程

y=a.x+b Y=w.X+b

图1

SVM原理介绍

SVM优化算法

SVM常用工具箱

Libsvm函数

参数优化

Support vector machine

谢谢!

i ( i ( w , x i ) b y i ) 0

( C i ) i 0

( C i ) i 0

SVM原理介绍

SVM优化算法

SVM工具箱介绍

Libsvm函数

参数优化

由KKT条件将Lagrange函数转换成对偶规划问题:

m ax 1 2

参数优化

Model主要参数介绍

model =

Parameters: [5x1 double] nr_class: 2 totalSV: 328 rho: -3.2425 -b Label: [] ProbA: [] ProbB: [] nSV: [] sv_coef: [328x1 double] SVs: [328x2 double]

SVM原理介绍

SVM优化算法

SVM工具箱介绍

Libsvm函数

参数优化

Svmtrain()函数

Svmtrain函数用于训练支持向量机模型,选择相关参数和训 练样本就能够输出一个结构体model,model中包含模型表达 式中全部参数。 model=svmtrain(Ytrain,Xtrain, ‘-s 3 -t 1 -h 0 –d 1 -c 0.1 –p 2’);

模型参数

支持向量数目

支持向量系数

支持向量

SVM原理介绍

SVM优化算法

SVM工具箱介绍

Libsvm函数

参数优化

二折法

将原始数据集DataSet均分为两份:一份作为训练集, 即trainingSet,一份作为测试集,即testingSet,然后用 训练集去做训练,用测试集去验证;之后再将训练集作 为测试集,测试集作为训练集进行迭代一次,将两次所 得的误差经行处理作为总体数据的预测误差。(注:这 里强调一点,就是数据集一定要均分为两份,理由是: 作为训练集,数据量一定要不小于测试集,所以在迭代 的过程中,使得数据不出现错误情况,必须均分。)

1

2

m in

1 2

|| w || C ( i i )

2 i 1

l

yi ( w , xi ) b i s .t . ( w , xi ) b yi i

其中C为对估计误差大于 的样本数据的惩罚因子。

SVM原理介绍