支持向量机非线性回归通用MATLAB源码

python机器学习之支持向量机非线性回归SVR模型

python机器学习之⽀持向量机⾮线性回归SVR模型本⽂介绍了python ⽀持向量机⾮线性回归SVR模型,废话不多说,具体如下:import numpy as npimport matplotlib.pyplot as pltfrom sklearn import datasets, linear_model,svmfrom sklearn.model_selection import train_test_splitdef load_data_regression():'''加载⽤于回归问题的数据集'''diabetes = datasets.load_diabetes() #使⽤ scikit-learn ⾃带的⼀个糖尿病病⼈的数据集# 拆分成训练集和测试集,测试集⼤⼩为原始数据集⼤⼩的 1/4return train_test_split(diabetes.data,diabetes.target,test_size=0.25,random_state=0)#⽀持向量机⾮线性回归SVR模型def test_SVR_linear(*data):X_train,X_test,y_train,y_test=dataregr=svm.SVR(kernel='linear')regr.fit(X_train,y_train)print('Coefficients:%s, intercept %s'%(regr.coef_,regr.intercept_))print('Score: %.2f' % regr.score(X_test, y_test))# ⽣成⽤于回归问题的数据集X_train,X_test,y_train,y_test=load_data_regression()# 调⽤ test_LinearSVRtest_SVR_linear(X_train,X_test,y_train,y_test)def test_SVR_poly(*data):'''测试多项式核的 SVR 的预测性能随 degree、gamma、coef0 的影响.'''X_train,X_test,y_train,y_test=datafig=plt.figure()### 测试 degree ####degrees=range(1,20)train_scores=[]test_scores=[]for degree in degrees:regr=svm.SVR(kernel='poly',degree=degree,coef0=1)regr.fit(X_train,y_train)train_scores.append(regr.score(X_train,y_train))test_scores.append(regr.score(X_test, y_test))ax=fig.add_subplot(1,3,1)ax.plot(degrees,train_scores,label="Training score ",marker='+' )ax.plot(degrees,test_scores,label= " Testing score ",marker='o' )ax.set_title( "SVR_poly_degree r=1")ax.set_xlabel("p")ax.set_ylabel("score")ax.set_ylim(-1,1.)ax.legend(loc="best",framealpha=0.5)### 测试 gamma,固定 degree为3, coef0 为 1 ####gammas=range(1,40)train_scores=[]test_scores=[]for gamma in gammas:regr=svm.SVR(kernel='poly',gamma=gamma,degree=3,coef0=1)regr.fit(X_train,y_train)train_scores.append(regr.score(X_train,y_train))test_scores.append(regr.score(X_test, y_test))ax=fig.add_subplot(1,3,2)ax.plot(gammas,train_scores,label="Training score ",marker='+' )ax.plot(gammas,test_scores,label= " Testing score ",marker='o' )ax.set_title( "SVR_poly_gamma r=1")ax.set_xlabel(r"$\gamma$")ax.set_ylabel("score")ax.set_ylim(-1,1)ax.legend(loc="best",framealpha=0.5)### 测试 r,固定 gamma 为 20,degree为 3 ######rs=range(0,20)train_scores=[]test_scores=[]for r in rs:regr=svm.SVR(kernel='poly',gamma=20,degree=3,coef0=r)regr.fit(X_train,y_train)train_scores.append(regr.score(X_train,y_train))test_scores.append(regr.score(X_test, y_test))ax=fig.add_subplot(1,3,3)ax.plot(rs,train_scores,label="Training score ",marker='+' )ax.plot(rs,test_scores,label= " Testing score ",marker='o' )ax.set_title( "SVR_poly_r gamma=20 degree=3")ax.set_xlabel(r"r")ax.set_ylabel("score")ax.set_ylim(-1,1.)ax.legend(loc="best",framealpha=0.5)plt.show()# 调⽤ test_SVR_polytest_SVR_poly(X_train,X_test,y_train,y_test)def test_SVR_rbf(*data):'''测试⾼斯核的 SVR 的预测性能随 gamma 参数的影响'''X_train,X_test,y_train,y_test=datagammas=range(1,20)train_scores=[]test_scores=[]for gamma in gammas:regr=svm.SVR(kernel='rbf',gamma=gamma)regr.fit(X_train,y_train)train_scores.append(regr.score(X_train,y_train))test_scores.append(regr.score(X_test, y_test))fig=plt.figure()ax=fig.add_subplot(1,1,1)ax.plot(gammas,train_scores,label="Training score ",marker='+' ) ax.plot(gammas,test_scores,label= " Testing score ",marker='o' ) ax.set_title( "SVR_rbf")ax.set_xlabel(r"$\gamma$")ax.set_ylabel("score")ax.set_ylim(-1,1)ax.legend(loc="best",framealpha=0.5)plt.show()# 调⽤ test_SVR_rbftest_SVR_rbf(X_train,X_test,y_train,y_test)def test_SVR_sigmoid(*data):'''测试 sigmoid 核的 SVR 的预测性能随 gamma、coef0 的影响.'''X_train,X_test,y_train,y_test=datafig=plt.figure()### 测试 gammam,固定 coef0 为 0.01 ####gammas=np.logspace(-1,3)train_scores=[]test_scores=[]for gamma in gammas:regr=svm.SVR(kernel='sigmoid',gamma=gamma,coef0=0.01) regr.fit(X_train,y_train)train_scores.append(regr.score(X_train,y_train))test_scores.append(regr.score(X_test, y_test))ax=fig.add_subplot(1,2,1)ax.plot(gammas,train_scores,label="Training score ",marker='+' ) ax.plot(gammas,test_scores,label= " Testing score ",marker='o' ) ax.set_title( "SVR_sigmoid_gamma r=0.01")ax.set_xscale("log")ax.set_xlabel(r"$\gamma$")ax.set_ylabel("score")ax.set_ylim(-1,1)ax.legend(loc="best",framealpha=0.5)### 测试 r ,固定 gamma 为 10 ######rs=np.linspace(0,5)train_scores=[]test_scores=[]for r in rs:regr=svm.SVR(kernel='sigmoid',coef0=r,gamma=10)regr.fit(X_train,y_train)train_scores.append(regr.score(X_train,y_train))test_scores.append(regr.score(X_test, y_test))ax=fig.add_subplot(1,2,2)ax.plot(rs,train_scores,label="Training score ",marker='+' )ax.plot(rs,test_scores,label= " Testing score ",marker='o' )ax.set_title( "SVR_sigmoid_r gamma=10")ax.set_xlabel(r"r")ax.set_ylabel("score")ax.set_ylim(-1,1)ax.legend(loc="best",framealpha=0.5)plt.show()# 调⽤ test_SVR_sigmoidtest_SVR_sigmoid(X_train,X_test,y_train,y_test)以上就是本⽂的全部内容,希望对⼤家的学习有所帮助,也希望⼤家多多⽀持。

基于支持向量机的非线性预测和建模方法研究

基于支持向量机的非线性预测和建模方法研究随着数据科学领域的不断发展,预测和建模方法也应运而生。

其中,支持向量机(Support Vector Machine, SVM)是一种常用的非线性预测和建模方法。

在此,我们将探索基于SVM的非线性预测和建模方法,并探究其在实践中的应用。

一、SVM简介SVM,最初由Vapnik和Cortes于1995年提出,是一种常见的监督学习算法,尤其适合于高维样本空间中的分类问题。

其基本思想是找到使划分超平面最大的间隔,使得在此超平面两侧的数据可以被很好地分类。

SVM可以用于线性和非线性分类和回归问题,其主要优点包括:1. 针对高维样本空间中的分类和回归问题,具有良好的泛化性能和鲁棒性;2. 在处理非线性问题时,采用核函数将数据映射到高维特征空间中,从而有效地解决了非线性问题;3. 支持向量的数目通常很少,可以有效减小训练时间和存储开销。

二、基于SVM的非线性预测和建模方法1. SVM回归SVM回归在基于SVM的非线性预测和建模中占有一席之地。

对于回归问题,其主要思想是找到一个回归函数,使得在经过超平面的两侧之间的最大间隔内的样本均能落在该回归函数上。

在SVM回归中,核函数被广泛使用,如径向基函数(Radial Basis Function, RBF)、多项式函数(Polynomial Function, Poly)等,以实现数据在高维特征空间中的映射。

同时,SVM回归还可以利用正则化项,以避免在样本空间中过度拟合。

2. 基于SVM的非线性分类在基于SVM的非线性预测和建模中,SVM分类是一种常见的应用。

对于分类问题,SVM通常采用核函数将数据映射到高维特征空间,然后在此特征空间中找到一个超平面,使得在这个超平面两侧的数据可以被很好地分类。

与SVM回归相似,SVM分类也可以通过正则化学习来避免过度拟合。

3. 基于SVM的异常检测在工业和金融领域中,异常检测通常用于检测离群值或异常事件。

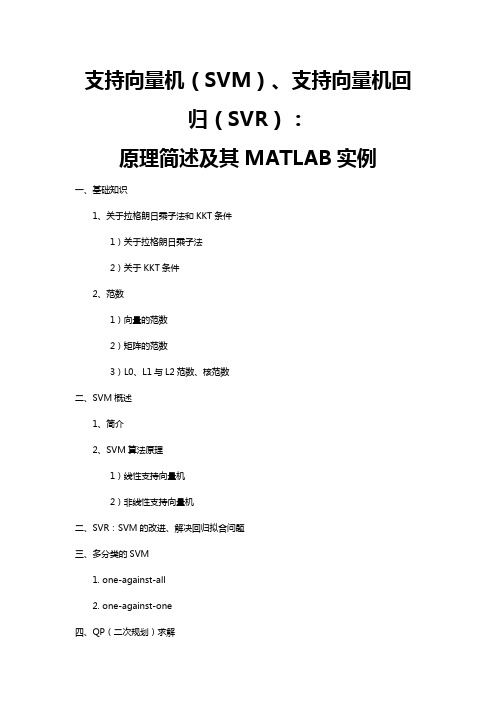

支持向量机(SVM)、支持向量机回归(SVR):原理简述及其MATLAB实例

支持向量机(SVM)、支持向量机回归(SVR):原理简述及其MATLAB实例一、基础知识1、关于拉格朗日乘子法和KKT条件1)关于拉格朗日乘子法2)关于KKT条件2、范数1)向量的范数2)矩阵的范数3)L0、L1与L2范数、核范数二、SVM概述1、简介2、SVM算法原理1)线性支持向量机2)非线性支持向量机二、SVR:SVM的改进、解决回归拟合问题三、多分类的SVM1. one-against-all2. one-against-one四、QP(二次规划)求解五、SVM的MATLAB实现:Libsvm1、Libsvm工具箱使用说明2、重要函数:3、示例支持向量机(SVM):原理及其MATLAB实例一、基础知识1、关于拉格朗日乘子法和KKT条件1)关于拉格朗日乘子法首先来了解拉格朗日乘子法,为什么需要拉格朗日乘子法呢?记住,有需要拉格朗日乘子法的地方,必然是一个组合优化问题。

那么带约束的优化问题很好说,就比如说下面这个:这是一个带等式约束的优化问题,有目标值,有约束条件。

那么你可以想想,假设没有约束条件这个问题是怎么求解的呢?是不是直接 f 对各个 x 求导等于 0,解 x 就可以了,可以看到没有约束的话,求导为0,那么各个x均为0吧,这样f=0了,最小。

但是x都为0不满足约束条件呀,那么问题就来了。

有了约束不能直接求导,那么如果把约束去掉不就可以了吗?怎么去掉呢?这才需要拉格朗日方法。

既然是等式约束,那么我们把这个约束乘一个系数加到目标函数中去,这样就相当于既考虑了原目标函数,也考虑了约束条件。

现在这个优化目标函数就没有约束条件了吧,既然如此,求法就简单了,分别对x求导等于0,如下:把它在带到约束条件中去,可以看到,2个变量两个等式,可以求解,最终可以得到,这样再带回去求x就可以了。

那么一个带等式约束的优化问题就通过拉格朗日乘子法完美的解决了。

更高一层的,带有不等式的约束问题怎么办?那么就需要用更一般化的拉格朗日乘子法,即KKT条件,来解决这种问题了。

30个智能算法matlab代码

30个智能算法matlab代码以下是30个使用MATLAB编写的智能算法的示例代码: 1. 线性回归算法:matlab.x = [1, 2, 3, 4, 5];y = [2, 4, 6, 8, 10];coefficients = polyfit(x, y, 1);predicted_y = polyval(coefficients, x);2. 逻辑回归算法:matlab.x = [1, 2, 3, 4, 5];y = [0, 0, 1, 1, 1];model = fitglm(x, y, 'Distribution', 'binomial'); predicted_y = predict(model, x);3. 支持向量机算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3];y = [1, 1, -1, -1, -1];model = fitcsvm(x', y');predicted_y = predict(model, x');4. 决策树算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3]; y = [0, 0, 1, 1, 1];model = fitctree(x', y');predicted_y = predict(model, x');5. 随机森林算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3]; y = [0, 0, 1, 1, 1];model = TreeBagger(50, x', y');predicted_y = predict(model, x');6. K均值聚类算法:matlab.x = [1, 2, 3, 10, 11, 12]; y = [1, 2, 3, 10, 11, 12]; data = [x', y'];idx = kmeans(data, 2);7. DBSCAN聚类算法:matlab.x = [1, 2, 3, 10, 11, 12]; y = [1, 2, 3, 10, 11, 12]; data = [x', y'];epsilon = 2;minPts = 2;[idx, corePoints] = dbscan(data, epsilon, minPts);8. 神经网络算法:matlab.x = [1, 2, 3, 4, 5];y = [0, 0, 1, 1, 1];net = feedforwardnet(10);net = train(net, x', y');predicted_y = net(x');9. 遗传算法:matlab.fitnessFunction = @(x) x^2 4x + 4;nvars = 1;lb = 0;ub = 5;options = gaoptimset('PlotFcns', @gaplotbestf);[x, fval] = ga(fitnessFunction, nvars, [], [], [], [], lb, ub, [], options);10. 粒子群优化算法:matlab.fitnessFunction = @(x) x^2 4x + 4;nvars = 1;lb = 0;ub = 5;options = optimoptions('particleswarm', 'PlotFcn',@pswplotbestf);[x, fval] = particleswarm(fitnessFunction, nvars, lb, ub, options);11. 蚁群算法:matlab.distanceMatrix = [0, 2, 3; 2, 0, 4; 3, 4, 0];pheromoneMatrix = ones(3, 3);alpha = 1;beta = 1;iterations = 10;bestPath = antColonyOptimization(distanceMatrix, pheromoneMatrix, alpha, beta, iterations);12. 粒子群-蚁群混合算法:matlab.distanceMatrix = [0, 2, 3; 2, 0, 4; 3, 4, 0];pheromoneMatrix = ones(3, 3);alpha = 1;beta = 1;iterations = 10;bestPath = particleAntHybrid(distanceMatrix, pheromoneMatrix, alpha, beta, iterations);13. 遗传算法-粒子群混合算法:matlab.fitnessFunction = @(x) x^2 4x + 4;nvars = 1;lb = 0;ub = 5;gaOptions = gaoptimset('PlotFcns', @gaplotbestf);psOptions = optimoptions('particleswarm', 'PlotFcn',@pswplotbestf);[x, fval] = gaParticleHybrid(fitnessFunction, nvars, lb, ub, gaOptions, psOptions);14. K近邻算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3]; y = [0, 0, 1, 1, 1];model = fitcknn(x', y');predicted_y = predict(model, x');15. 朴素贝叶斯算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3]; y = [0, 0, 1, 1, 1];model = fitcnb(x', y');predicted_y = predict(model, x');16. AdaBoost算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3];y = [0, 0, 1, 1, 1];model = fitensemble(x', y', 'AdaBoostM1', 100, 'Tree'); predicted_y = predict(model, x');17. 高斯混合模型算法:matlab.x = [1, 2, 3, 4, 5]';y = [0, 0, 1, 1, 1]';data = [x, y];model = fitgmdist(data, 2);idx = cluster(model, data);18. 主成分分析算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3]; coefficients = pca(x');transformed_x = x' coefficients;19. 独立成分分析算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3]; coefficients = fastica(x');transformed_x = x' coefficients;20. 模糊C均值聚类算法:matlab.x = [1, 2, 3, 4, 5; 1, 2, 2, 3, 3]; options = [2, 100, 1e-5, 0];[centers, U] = fcm(x', 2, options);21. 遗传规划算法:matlab.fitnessFunction = @(x) x^2 4x + 4; nvars = 1;lb = 0;ub = 5;options = optimoptions('ga', 'PlotFcn', @gaplotbestf);[x, fval] = ga(fitnessFunction, nvars, [], [], [], [], lb, ub, [], options);22. 线性规划算法:matlab.f = [-5; -4];A = [1, 2; 3, 1];b = [8; 6];lb = [0; 0];ub = [];[x, fval] = linprog(f, A, b, [], [], lb, ub);23. 整数规划算法:matlab.f = [-5; -4];A = [1, 2; 3, 1];b = [8; 6];intcon = [1, 2];[x, fval] = intlinprog(f, intcon, A, b);24. 图像分割算法:matlab.image = imread('image.jpg');grayImage = rgb2gray(image);binaryImage = imbinarize(grayImage);segmented = medfilt2(binaryImage);25. 文本分类算法:matlab.documents = ["This is a document.", "Another document.", "Yet another document."];labels = categorical(["Class 1", "Class 2", "Class 1"]);model = trainTextClassifier(documents, labels);newDocuments = ["A new document.", "Another new document."];predictedLabels = classifyText(model, newDocuments);26. 图像识别算法:matlab.image = imread('image.jpg');features = extractFeatures(image);model = trainImageClassifier(features, labels);newImage = imread('new_image.jpg');newFeatures = extractFeatures(newImage);predictedLabel = classifyImage(model, newFeatures);27. 时间序列预测算法:matlab.data = [1, 2, 3, 4, 5];model = arima(2, 1, 1);model = estimate(model, data);forecastedData = forecast(model, 5);28. 关联规则挖掘算法:matlab.data = readtable('data.csv');rules = associationRules(data, 'Support', 0.1);29. 增强学习算法:matlab.environment = rlPredefinedEnv('Pendulum');agent = rlDDPGAgent(environment);train(agent);30. 马尔可夫决策过程算法:matlab.states = [1, 2, 3];actions = [1, 2];transitionMatrix = [0.8, 0.1, 0.1; 0.2, 0.6, 0.2; 0.3, 0.3, 0.4];rewardMatrix = [1, 0, -1; -1, 1, 0; 0, -1, 1];policy = mdpPolicyIteration(transitionMatrix, rewardMatrix);以上是30个使用MATLAB编写的智能算法的示例代码,每个算法都可以根据具体的问题和数据进行相应的调整和优化。

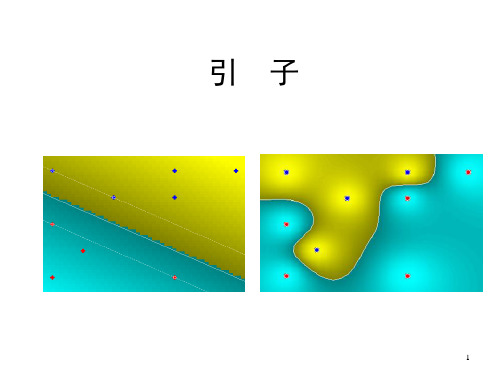

处理非线性分类和回归的新方法—支持向量机方法(SVM)

—支持向量机方法(SVM)

(Support Vector Machine)

支持向量机方法(SVM) 简介

(Support Vector Machine)

机器学习问题的提法

利用有限数量的观测来 寻求待求的依赖关系

模式识别(分类) 回归分析(回归) 概率密度估计

SVM应用于 降水分类预报的试验

四川盆地面雨量的 SVM建模与预报检验

预报对象: 由于单站降水的不确定性较 大,因此,采用面雨量做为预报 对象。 考虑四川盆地降雨的气候特点, 将四川省内盆地部分划分为三个 片区: 盆地西北部(1)、 盆地东北部(2)、 盆地西南部(3),

分别作为预报对象进行试验

x

i

) exp r

x

x

2 i

i

。要构造(3)式的决策规则,就需要估计: 参数r的值;中心 i 的数目N;描述各中心的向量xx ; 参数 i的值。

这四种类型的参数都是通过控制泛函的参数来最小化测试错误概率的界确定。

将预报对象进行分类

我们关注的是大于15mm降水 的面雨量,因此把面雨量 大于或等于15mm的归为 +1类, 小于15mm的归为 -1类。

资料长度: 1990—2000年4—9月 共11年的历史资料

建模方式:

确定核函数 归一化因子

将预报对象进行分类

将预报因子和预报对象进行整理,分为三部分: 训练集、测试集、检验集 选取参数建立SVM模型

确定核函数

我们以径向基函数(满足Mercer定理)做为SVM中内积的回旋函数建立推 理模型。径向基函数采用下面的决策规则集合: N (3)

( x1 ,

y ),( xl ,

支持向量机及其编程实现

1

Support Vector Machine

支持向量机

2

相关参考资料

• 统计学习理论的本质,Vladimir N. Vapnik 著, 张学工译,清华大学出版社,2000.09 • 支持向量机导论,N.Cristianini, J.ShaweTaylor著,电子工业出版社,2004.03 • Support Vector Classification. Steven Gunn. • • • Bernhard Scholkopf, Alex J. Smola , CHRISTOPHER J.C.

l

yi ( w, xi b) 1

y

i 1 i

l

i

0

i 0

i 1, 2,L , l

i 1, 2,l

原始问题与对偶问题解的关系:

w* yi i* xi

i 1 l

22

KKT条件与支持向量

对偶问题的解 *i (i 1, 2,, l ) 是最优解的前提条件是:

支持向量机的编程实现

25

一、Matlab图像编程概要

1.读入图像: RGB=imread(‘1.jpg’); 该函数的返回值RGB是一个三维的数组,分别代表 像素点所在的行号、列号和像素点的R、G、B三个 通道的值。 例: RGB(1,1,1); %图像第一行第一列的R值; RGB(1,3,2); %图像第一行第三列的G值; RGB(2,4,3); %图像第二行第四列的B值; RR=RGB(:,:,1); %彩色图像的红色像素通道 GG=RGB(:,:,2); %彩色图像的绿色像素通道 BB=RGB(:,:,3); %彩色图像的蓝色像素通道

SVM

男或女

支持向量机及支持向量回归简介

3.支持向量机(回归)3.1.1 支持向量机支持向量机(SVM )是美国Vapnik 教授于1990年代提出的,2000年代后成为了很受欢迎的机器学习方法。

它将输入样本集合变换到高维空间使得其分离性状况得到改善。

它的结构酷似三层感知器,是构造分类规则的通用方法。

SVM 方法的贡献在于,它使得人们可以在非常高维的空间中构造出好的分类规则,为分类算法提供了统一的理论框架。

作为副产品,SVM 从理论上解释了多层感知器的隐蔽层数目和隐节点数目的作用,因此,将神经网络的学习算法纳入了核技巧范畴。

所谓核技巧,就是找一个核函数(,)K x y 使其满足(,)((),())K x y x y φφ=,代替在特征空间中内积(),())x y φφ(的计算。

因为对于非线性分类,一般是先找一个非线性映射φ将输入数据映射到高维特征空间,使之分离性状况得到很大改观,此时在该特征空间中进行分类,然后再返会原空间,就得到了原输入空间的非线性分类。

由于内积运算量相当大,核技巧就是为了降低计算量而生的。

特别, 对特征空间H 为Hilbert 空间的情形,设(,)K x y 是定义在输入空间n R 上的二元函数,设H 中的规范正交基为12(),(),...,(),...n x x x φφφ。

如果221(,)((),()),{}k k k k k K x y a x y a l φφ∞==∈∑,那么取1()()k k k x a x φφ∞==∑即为所求的非线性嵌入映射。

由于核函数(,)K x y 的定义域是原来的输入空间,而不是高维的特征空间。

因此,巧妙地避开了计算高维内积(),())x y φφ(所需付出的计算代价。

实际计算中,我们只要选定一个(,)K x y ,并不去重构嵌入映射1()()k k k x a x φφ∞==∑。

所以寻找核函数(,)K x y (对称且非负)就是主要任务了。

满足以上条件的核函数很多,例如可以取为d-阶多项式:(,)(1)d K x y x y =+,其中y 为固定元素。

matlab fitsvm参数

matlab fitsvm参数fitcsvm是MATLAB中用于构建支持向量机(SVM)分类模型的函数。

SVM是一种常用的分类方法,其基本思想是将数据映射到高维空间,在该空间中找到一个最优的超平面,以区分不同类别的数据。

fitcsvm函数具有丰富的参数选项,可以根据具体的需求来调整模型的性能和精度。

下面将介绍一些常用的参数及其相关参考内容:1. 'KernelFunction'参数:指定SVM模型所使用的核函数类型。

常见的核函数有线性核函数、多项式核函数、高斯核函数等。

可以使用以下代码来设置核函数类型:```matlabSVMModel = fitcsvm(X, Y, 'KernelFunction', 'linear');```有关不同核函数的详细信息和选取准则,可以参考MATLAB官方文档中的KernelFunction参数说明。

2. 'BoxConstraint'参数:用于控制模型的复杂度和鲁棒性。

该参数的取值范围是大于0的实数,较小的值表示更简单的模型,较大的值表示更复杂的模型。

可以使用以下代码来设置BoxConstraint的值:```matlabSVMModel = fitcsvm(X, Y, 'BoxConstraint', 1.0);```3. 'Standardize'参数:指定是否对输入数据进行标准化处理。

标准化是将输入数据减去其均值并除以标准差,以消除不同特征量级对模型的影响。

可以使用以下代码来设置是否进行标准化处理:```matlabSVMModel = fitcsvm(X, Y, 'Standardize', true);```更多关于数据标准化的信息可以参考MATLAB官方文档中的Standardize参数说明。

4. 'KernelScale'参数:用于指定核函数的缩放因子。

应用matlab进行非线性回归分析

应用MATLAB进行非线性回归分析摘要早在十九世纪,英国生物学家兼统计学家高尔顿在研究父与子身高的遗传问题时,发现子代的平均高度又向中心回归大的意思,使得一段时间内人的身高相对稳定。

之后回归分析的思想渗透到了数理统计的其他分支中。

随着计算机的发展,各种统计软件包的出现,回归分析的应用就越来越广泛。

回归分析处理的是变量与变量间的关系。

有时,回归函数不是自变量的线性函数,但通过变换可以将之化为线性函数,从而利用一元线性回归对其进行分析,这样的问题是非线性回归问题。

下面的第一题:炼钢厂出钢水时用的钢包,在使用过程中由于钢水及炉渣对耐火材料的侵蚀,使其容积不断增大。

要找出钢包的容积用盛满钢水时的质量与相应的实验次数的定量关系表达式,就要用到一元非线性回归分析方法。

首先我们要对数据进行分析,描出数据的散点图,判断两个变量之间可能的函数关系,对题中的非线性函数,参数估计是最常用的“线性化方法”,即通过某种变换,将方程化为一元线性方程的形式,接着我们就要对得到的一些曲线回归方程进行选择,找出到底哪一个才是更好一点的。

此时我们通常可采用两个指标进行选择,第一个是决定系数,第二个是剩余标准差。

进而就得到了我们想要的定量关系表达式。

第二题:给出了某地区1971—2000年的人口数据,对该地区的人口变化进行曲线拟合。

也用到了一元非线性回归的方法。

首先我们也要对数据进行分析,描出数据的散点图,然后用MATLAB编程进行回归分析拟合计算输出利用Logistic模型拟合曲线。

关键词:参数估计,Logistic模型,MATLAB正文一、一元非线性回归分析的求解思路:•求解函数类型并检验。

•求解未知参数。

可化曲线回归为直线回归,用最小二乘法求解;可化曲线回归为多项式回归。

二、回归曲线函数类型的选取和检验1、直接判断法2、作图观察法,与典型曲线比较,确定其属于何种类型,然后检验。

3、直接检验法(适应于待求参数不多的情况)4、表差法(适应于多想式回归,含有常数项多于两个的情况)三、化曲线回归为直线回归问题用直线检验法或表差法检验的曲线回归方程都可以通过变量代换转化为直线回归方程,利用线性回归分析方法可求得相应的参数估计值。

matlab解非线性方程

matlab解非线性方程MATLAB求解非线性方程一、Matlab求解非线性方程的原理1. 非线性方程是指当函数中的变量出现不同的次方数时,得出的方程就是非线性的。

求解非线性方程的准确性决定于得出的解集是否丰富,以及解的精度是否符合要求。

2. Matlab是一款多功能的软件,可以快速求解工程中的数学方程和模型,包括一元非线性方程。

Matlab 具有非线性解析计算能力,可以极大地提高求解效率。

二、Matlab求解非线性方程的方法1. 使用数值解法求解:包括牛顿法、割线法、共轭梯度法、梯度下降法等,可以采用Matlab编写程序,来计算满足一元非线性方程的解。

2. 使用符号解法求解:在Matlab中,可以直接使用solve函数来解决一元非线性方程。

3. Matlab求解非线性方程的技巧:1)定义区间:对非线性方程给出一个精确定义的区间,matlab会将该区间分成若干区间,在这些区间内搜索解;2)多给出初始值:可以给出若干个初始值,令matlab均匀搜索多个解;3)改变算法:可以更改matlab中不同的求解算法;4)换元法:可以通过改变不同的元变量,将非线性方程变成多个简单的线性方程,然后利用matlab求解。

三、Matlab求解非线性方程的特点1. 高效:Matlab求解的方式高效有效,性能优异,可以节省大量的求解时间。

2. 准确:Matlab采用符号解法时,解的准确度精度更高,可以满足大部分要求。

3. 节省资源:Matlab求解非线性方程节省计算机资源,可以很好地利用资源,提高工作效率。

四、 Matlab求解非线性方程的步骤1. 对结构表达式编写程序;2. 设定相应的条件;3. 优化程序;4. 运行程序;5. 分析结果;6. 测试代码;7. 验证学习结果。

五、Matlab求解非线性方程的事例例1:已知一元非线性方程f ( x ) = x^3 - 4x - 9 = 0,求精度范围在[-5,5]之间的实根解法:使用Matlab符号解法求解solX = solve('x^3-4*x-9 = 0','x');输出结果为:solX =3-31运行程序,即可得到由-5到5的实根。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

支持向量机非线性回归通用MA TLAB源码支持向量机和BP神经网络都可以用来做非线性回归拟合,但它们的原理是不相同的,支持向量机基于结构风险最小化理论,普遍认为其泛化能力要比神经网络的强。

大量仿真证实,支持向量机的泛化能力强于BP网络,而且能避免神经网络的固有缺陷——训练结果不稳定。

本源码可以用于线性回归、非线性回归、非线性函数拟合、数据建模、预测、分类等多种应用场合,GreenSim团队推荐您使用。

function [Alpha1,Alpha2,Alpha,Flag,B]=SVMNR(X,Y,Epsilon,C,TKF,Para1,Para2)%%% SVMNR.m% Support Vector Machine for Nonlinear Regression% All rights reserved%%% 支持向量机非线性回归通用程序% GreenSim团队原创作品,转载请注明% GreenSim团队长期从事算法设计、代写程序等业务% 欢迎访问GreenSim——算法仿真团队→/greensim% 程序功能:% 使用支持向量机进行非线性回归,得到非线性函数y=f(x1,x2,…,xn)的支持向量解析式,% 求解二次规划时调用了优化工具箱的quadprog函数。

本函数在程序入口处对数据进行了% [-1,1]的归一化处理,所以计算得到的回归解析式的系数是针对归一化数据的,仿真测% 试需使用与本函数配套的Regression函数。

% 主要参考文献:% 朱国强,刘士荣等.支持向量机及其在函数逼近中的应用.华东理工大学学报% 输入参数列表% X 输入样本原始数据,n×l的矩阵,n为变量个数,l为样本个数% Y 输出样本原始数据,1×l的矩阵,l为样本个数% Epsilon ε不敏感损失函数的参数,Epsilon越大,支持向量越少% C 惩罚系数,C过大或过小,泛化能力变差% TKF Type of Kernel Function 核函数类型% TKF=1 线性核函数,注意:使用线性核函数,将进行支持向量机的线性回归% TKF=2 多项式核函数% TKF=3 径向基核函数% TKF=4 指数核函数% TKF=5 Sigmoid核函数% TKF=任意其它值,自定义核函数% Para1 核函数中的第一个参数% Para2 核函数中的第二个参数% 注:关于核函数参数的定义请见Regression.m和SVMNR.m内部的定义% 输出参数列表% Alpha1 α系数% Alpha2 α*系数% Alpha 支持向量的加权系数(α-α*)向量% Flag 1×l标记,0对应非支持向量,1对应边界支持向量,2对应标准支持向量% B 回归方程中的常数项%--------------------------------------------------------------------------%%%-----------------------数据归一化处理--------------------------------------nntwarn offX=premnmx(X);Y=premnmx(Y);%%%%%-----------------------核函数参数初始化------------------------------------switch TKFcase 1%线性核函数K=sum(x.*y)%没有需要定义的参数case 2%多项式核函数K=(sum(x.*y)+c)^pc=Para1;%c=0.1;p=Para2;%p=2;case 3%径向基核函数K=exp(-(norm(x-y))^2/(2*sigma^2))sigma=Para1;%sigma=6;case 4%指数核函数K=exp(-norm(x-y)/(2*sigma^2))sigma=Para1;%sigma=3;case 5%Sigmoid核函数K=1/(1+exp(-v*sum(x.*y)+c))v=Para1;%v=0.5;c=Para2;%c=0;otherwise%自定义核函数,需由用户自行在函数内部修改,注意要同时修改好几处!%暂时定义为K=exp(-(sum((x-y).^2)/(2*sigma^2)))sigma=Para1;%sigma=8;end%%%%%-----------------------构造K矩阵-------------------------------------------l=size(X,2);K=zeros(l,l);%K矩阵初始化for i=1:lfor j=1:lx=X(:,i);y=X(:,j);switch TKF%根据核函数的类型,使用相应的核函数构造K矩阵case 1K(i,j)=sum(x.*y);case 2K(i,j)=(sum(x.*y)+c)^p;case 3K(i,j)=exp(-(norm(x-y))^2/(2*sigma^2));case 4K(i,j)=exp(-norm(x-y)/(2*sigma^2));case 5K(i,j)=1/(1+exp(-v*sum(x.*y)+c));otherwiseK(i,j)=exp(-(sum((x-y).^2)/(2*sigma^2)));endendend%%%%%------------构造二次规划模型的参数H,Ft,Aeq,Beq,lb,ub------------------------%支持向量机非线性回归,回归函数的系数,要通过求解一个二次规划模型得以确定Ft=[Epsilon*ones(1,l)-Y,Epsilon*ones(1,l)+Y];Aeq=[ones(1,l),-ones(1,l)];Beq=0;ub=C*ones(2*l,1);%%%%%--------------调用优化工具箱quadprog函数求解二次规划------------------------OPT=optimset;rgeScale='off';OPT.Display='off';%%%%%------------------------整理输出回归方程的系数------------------------------Alpha1=(Gamma(1:l,1))';Alpha2=(Gamma((l+1):end,1))';Alpha=Alpha1-Alpha2;Flag=2*ones(1,l);%%%%%---------------------------支持向量的分类----------------------------------Err=0.000000000001;for i=1:lAA=Alpha1(i);BB=Alpha2(i);if (abs(AA-0)<=Err)&&(abs(BB-0)<=Err)Flag(i)=0;%非支持向量endif (AA>Err)&&(AA Flag(i)=2;%标准支持向量endif (abs(AA-0)<=Err)&&(BB>Err)&&(BB Flag(i)=2;%标准支持向量endif (abs(AA-C)<=Err)&&(abs(BB-0)<=Err)Flag(i)=1;%边界支持向量endif (abs(AA-0)<=Err)&&(abs(BB-C)<=Err)Flag(i)=1;%边界支持向量endend%%%%%--------------------计算回归方程中的常数项B--------------------------------- B=0;counter=0;for i=1:lAA=Alpha1(i);BB=Alpha2(i);if (AA>Err)&&(AA %计算支持向量加权值SUM=0;for j=1:lif Flag(j)>0switch TKFcase 1SUM=SUM+Alpha(j)*sum(X(:,j).*X(:,i));case 2SUM=SUM+Alpha(j)*(sum(X(:,j).*X(:,i))+c)^p;case 3SUM=SUM+Alpha(j)*exp(-(norm(X(:,j)-X(:,i)))^2/(2*sigma^2));case 4SUM=SUM+Alpha(j)*exp(-norm(X(:,j)-X(:,i))/(2*sigma^2));case 5SUM=SUM+Alpha(j)*1/(1+exp(-v*sum(X(:,j).*X(:,i))+c));otherwiseSUM=SUM+Alpha(j)*exp(-(sum((X(:,j)-X(:,i)).^2)/(2*sigma^2)));endendendb=Y(i)-SUM-Epsilon;B=B+b;counter=counter+1;endif (abs(AA-0)<=Err)&&(BB>Err)&&(BB SUM=0;for j=1:lif Flag(j)>0switch TKFcase 1SUM=SUM+Alpha(j)*sum(X(:,j).*X(:,i));case 2SUM=SUM+Alpha(j)*(sum(X(:,j).*X(:,i))+c)^p;case 3SUM=SUM+Alpha(j)*exp(-(norm(X(:,j)-X(:,i)))^2/(2*sigma^2));case 4SUM=SUM+Alpha(j)*exp(-norm(X(:,j)-X(:,i))/(2*sigma^2));case 5SUM=SUM+Alpha(j)*1/(1+exp(-v*sum(X(:,j).*X(:,i))+c));otherwiseSUM=SUM+Alpha(j)*exp(-(sum((X(:,j)-X(:,i)).^2)/(2*sigma^2)));endendendb=Y(i)-SUM+Epsilon;B=B+b;counter=counter+1;endendif counter==0B=0;elseB=B/counter;end欢迎访问GreenSim团队主页:/greensim欢迎访问GreenSim——算法仿真团队→/greensimfunction y=Regression(Alpha,Flag,B,X,Y,TKF,Para1,Para2,x)%--------------------------------------------------------------------------% Regression.m% 与SVMNR.m函数配套使用的仿真测试函数% 函数功能:% 本函数相当于支持向量得到的回归方程的解析方程,输入一个待测试的列向量x,得到一% 个对应的输出值y% GreenSim团队原创作品,转载请注明% GreenSim团队长期从事算法设计、代写程序等业务% 欢迎访问GreenSim——算法仿真团队→/greensim%--------------------------------------------------------------------------% 输入参数列表% Alpha 支持向量的加权系数(α-α*)向量% Flag 1×l标记,0对应非支持向量,1对应边界支持向量,2对应标准支持向量% B 回归方程中的常数项% X 输入样本原始数据,n×l的矩阵,n为变量个数,l为样本个数% Y 输出样本原始数据,1×l的矩阵,l为样本个数% Para1 核函数中的第一个参数% Para2 核函数中的第二个参数% 注:关于核函数参数的定义请见Regression.m和SVMNR.m内部的定义% x 待测试的原始数据,n×1的列向量% 输出参数列表% y 仿真测试的输出值%%%-----------------------核函数参数初始化------------------------------------switch TKFcase 1%线性核函数K=sum(x.*y)%没有需要定义的参数case 2%多项式核函数K=(sum(x.*y)+c)^pc=Para1;%c=0.1;p=Para2;%p=2;case 3%径向基核函数K=exp(-(norm(x-y))^2/(2*sigma^2))sigma=Para1;%sigma=6;case 4%指数核函数K=exp(-norm(x-y)/(2*sigma^2))sigma=Para1;%sigma=3;case 5%Sigmoid核函数K=1/(1+exp(-v*sum(x.*y)+c))v=Para1;%v=0.5;c=Para2;%c=0;otherwise%自定义核函数,需由用户自行在函数内部修改,注意要同时修改好几处!%暂时定义为K=exp(-(sum((x-y).^2)/(2*sigma^2)))sigma=Para1;%sigma=8;end%%%%%----------------------数据归一化处理---------------------------------------[X,minX,maxX]=premnmx(X);x=2*((x-minX)./(maxX-minX))-1;[Y,minY,maxY]=premnmx(Y);%%%%%---------------------计算仿真测试的输出值----------------------------------l=length(Alpha);SUM=0;for i=1:lif Flag(i)>0switch TKFcase 1SUM=SUM+Alpha(i)*sum(x.*X(:,i));case 2SUM=SUM+Alpha(i)*(sum(x.*X(:,i))+c)^p;case 3SUM=SUM+Alpha(i)*exp(-(norm(x-X(:,i)))^2/(2*sigma^2));case 4SUM=SUM+Alpha(i)*exp(-norm(x-X(:,i))/(2*sigma^2));case 5SUM=SUM+Alpha(i)*1/(1+exp(-v*sum(x.*X(:,i))+c));otherwiseSUM=SUM+Alpha(i)*exp(-(sum((x-X(:,i)).^2)/(2*sigma^2)));endendendy=SUM+B;%%%%%--------------------反归一化处理-------------------------------------------y=postmnmx(y,minY,maxY);。