Hadoop集群规划

Hadoop集群配置详细

Linux系统配置

7安装JDK 将JDK文件解压,放到/usr/java目录下 cd /home/dhx/software/jdk mkdir /usr/java mv jdk1.6.0_45.zip /usr/java/

cd /usr/java

unzip jdk1.6.0_45.zip

从当前用户切换root用户的命令如下: 编辑主机名列表的命令

从当前用户切换root用户的命令如下:

Linux系统配置

操作步骤需要在HadoopMaster和HadoopSlave节点

上分别完整操作,都是用root用户。 从当前用户切换root用户的命令如下:

su root

从当前用户切换root用户的命令如下:

Linux系统配置

1拷贝软件包和数据包 mv ~/Desktop/software ~/

环境变量文件中,只需要配置JDK的路径

gedit conf/hadoop-env.sh

从当前用户切换root用户的命令如下: 编辑主机名列表的命令

Hadoop配置部署

3配置核心组件core-site.xml

gedit conf/core-site.xml

<configuration> <property> <name></name> /*2.0后用 fs.defaultFS代替*/ <value>hdfs://master:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/home/dhx/hadoopdata</value> </property> </configuration>

hadoop核心组件概述及hadoop集群的搭建

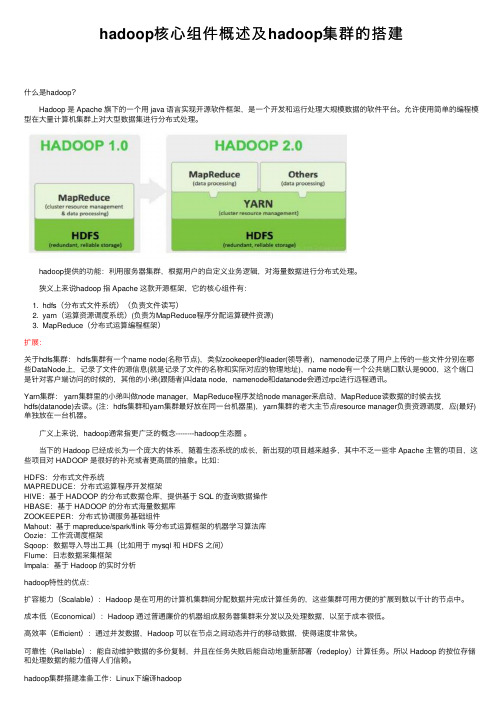

hadoop核⼼组件概述及hadoop集群的搭建什么是hadoop? Hadoop 是 Apache 旗下的⼀个⽤ java 语⾔实现开源软件框架,是⼀个开发和运⾏处理⼤规模数据的软件平台。

允许使⽤简单的编程模型在⼤量计算机集群上对⼤型数据集进⾏分布式处理。

hadoop提供的功能:利⽤服务器集群,根据⽤户的⾃定义业务逻辑,对海量数据进⾏分布式处理。

狭义上来说hadoop 指 Apache 这款开源框架,它的核⼼组件有:1. hdfs(分布式⽂件系统)(负责⽂件读写)2. yarn(运算资源调度系统)(负责为MapReduce程序分配运算硬件资源)3. MapReduce(分布式运算编程框架)扩展:关于hdfs集群: hdfs集群有⼀个name node(名称节点),类似zookeeper的leader(领导者),namenode记录了⽤户上传的⼀些⽂件分别在哪些DataNode上,记录了⽂件的源信息(就是记录了⽂件的名称和实际对应的物理地址),name node有⼀个公共端⼝默认是9000,这个端⼝是针对客户端访问的时候的,其他的⼩弟(跟随者)叫data node,namenode和datanode会通过rpc进⾏远程通讯。

Yarn集群: yarn集群⾥的⼩弟叫做node manager,MapReduce程序发给node manager来启动,MapReduce读数据的时候去找hdfs(datanode)去读。

(注:hdfs集群和yarn集群最好放在同⼀台机器⾥),yarn集群的⽼⼤主节点resource manager负责资源调度,应(最好)单独放在⼀台机器。

⼴义上来说,hadoop通常指更⼴泛的概念--------hadoop⽣态圈。

当下的 Hadoop 已经成长为⼀个庞⼤的体系,随着⽣态系统的成长,新出现的项⽬越来越多,其中不乏⼀些⾮ Apache 主管的项⽬,这些项⽬对 HADOOP 是很好的补充或者更⾼层的抽象。

hadoop集群部署之双虚拟机版

1、采用一台机器开两个虚拟机的方式构成两台电脑的环境,用root登录。

分别查看其IP地址:输入# ifconfig,可得主机IP:192.168.1.99;分机为:192.168.1.100。

2、在两台机器上的/etc/hosts均添加相应的主机名和IP地址:这里主机名命名为shenghao,分机名命名为slave:保存后重启网络:3、两台机器上均创立hadoop用户(注意是用root登陆)# useradd hadoop# passwd hadoop输入111111做为密码登录hadoop用户:注意,登录用户名为hadoop,而不是自己命名的shenghao。

4、ssh的配置进入centos的“系统→管理→服务器设置→服务,查看sshd服务是否运行。

在所有的机器上生成密码对:# ssh-keygen -t rsa这时hadoop目录下生成一个.ssh的文件夹,可以通过# ls .ssh/来查看里面产生的私钥和公钥:id_rsa和id_rsa.pub。

更改.ssh的读写权限:# chmod 755 .ssh在namenode上(即主机上)进入.ssh,将id_rsa.pub直接复制为authorized_keys(namenode的公钥):# cp id_rsa.pub authorized_keys更改authorized_keys的读写权限:# chmod 644 authorized_keys 【这个不必须,但保险起见,推荐使用】然后上传到datanode上(即分机上):# scp authorized_keys hadoop@slave:/home/hadoop/.ssh# cd .. 退出.ssh文件夹这样shenghao就可以免密码登录slave了:然后输入exit就可以退出去。

然后在datanode上(即分机上):将datanode上之前产生的公钥id_rsa.pub复制到namenode上的.ssh目录中,并重命名为slave.id_rsa.pub,这是为了区分从各个datanode上传过来的公钥,这里就一个datanode,简单标记下就可。

搭建hadoop集群的步骤

搭建hadoop集群的步骤Hadoop是一个开源的分布式计算平台,用于存储和处理大规模的数据集。

在大数据时代,Hadoop已经成为了处理海量数据的标准工具之一。

在本文中,我们将介绍如何搭建一个Hadoop集群。

步骤一:准备工作在开始搭建Hadoop集群之前,需要进行一些准备工作。

首先,需要选择适合的机器作为集群节点。

通常情况下,需要至少三台机器来搭建一个Hadoop集群。

其次,需要安装Java环境和SSH服务。

最后,需要下载Hadoop的二进制安装包。

步骤二:配置Hadoop环境在准备工作完成之后,需要对Hadoop环境进行配置。

首先,需要编辑Hadoop的配置文件,包括core-site.xml、hdfs-site.xml、mapred-site.xml和yarn-site.xml。

其中,core-site.xml用于配置Hadoop的核心参数,hdfs-site.xml用于配置Hadoop分布式文件系统的参数,mapred-site.xml用于配置Hadoop的MapReduce参数,yarn-site.xml用于配置Hadoop的资源管理器参数。

其次,需要在每个节点上创建一个hadoop用户,并设置其密码。

最后,需要在每个节点上配置SSH免密码登录,以便于节点之间的通信。

步骤三:启动Hadoop集群在完成Hadoop环境的配置之后,可以启动Hadoop集群。

首先,需要启动Hadoop的NameNode和DataNode服务。

NameNode是Hadoop分布式文件系统的管理节点,负责管理文件系统的元数据。

DataNode是Hadoop分布式文件系统的存储节点,负责实际存储数据。

其次,需要启动Hadoop的ResourceManager和NodeManager服务。

ResourceManager 是Hadoop的资源管理器,负责管理集群中的资源。

NodeManager是Hadoop的节点管理器,负责管理每个节点的资源。

Hadoop集群部署有几种模式?Hadoop集群部署方法介绍

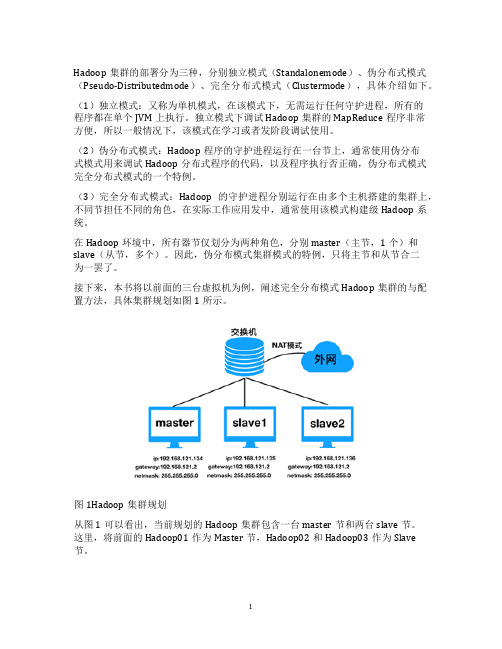

Hadoop集群的部署分为三种,分别独立模式(Standalonemode)、伪分布式模式(Pseudo-Distributedmode)、完全分布式模式(Clustermode),具体介绍如下。

(1)独立模式:又称为单机模式,在该模式下,无需运行任何守护进程,所有的

程序都在单个JVM上执行。

独立模式下调试Hadoop集群的MapReduce程序非常

方便,所以一般情况下,该模式在学习或者发阶段调试使用。

(2)伪分布式模式:Hadoop程序的守护进程运行在一台节上,通常使用伪分布

式模式用来调试Hadoop分布式程序的代码,以及程序执行否正确,伪分布式模式完全分布式模式的一个特例。

(3)完全分布式模式:Hadoop的守护进程分别运行在由多个主机搭建的集群上,不同节担任不同的角色,在实际工作应用发中,通常使用该模式构建级Hadoop系统。

在Hadoop环境中,所有器节仅划分为两种角色,分别master(主节,1个)和slave(从节,多个)。

因此,伪分布模式集群模式的特例,只将主节和从节合二

为一罢了。

接下来,本书将以前面的三台虚拟机为例,阐述完全分布模式Hadoop集群的与配置方法,具体集群规划如图1所示。

图1Hadoop集群规划

从图1可以看出,当前规划的Hadoop集群包含一台master节和两台slave节。

这里,将前面的Hadoop01作为Master节,Hadoop02和Hadoop03作为Slave

节。

1。

大数据集群部署方案

八、风险与应对措施

1.技术风险:关注技术动态,及时更新和升级相关软件。

2.数据安全风险:加强数据安全防护措施,定期进行合规性检查。

3.人才短缺:加强团队培训,提高技能水平。

4.成本控制:合理规划项目预算,控制成本。

九、总结

本方案为企业提供了一套完整、科学的大数据集群部署方案,旨在实现高效、稳定的数据处理和分析。通过严谨的技术选型和部署架构设计,确保数据安全、合规性。同时,注重运维保障和人才培养,提高大数据应用能力。在项目实施过程中,积极应对各类风险,确保项目顺利推进,为企业创造持续的业务价值。

二、项目目标

1.搭建一套完整的大数据集群环境,满足业务部门对数据处理、分析、挖掘的需求。

2.确保集群系统的高可用性、高性能、易扩展性,降低运维成本。

3.遵循国家相关法律法规,确保数据安全与合规性。

三、技术选型

1.分布式存储:采用Hadoop分布式文件系统(HDFS)进行数据存储,确保数据的高可靠性和高可用性。

- Kafka集群:用于收集和传输实时数据,支持实时数据处理。

五、数据安全与合规性

1.数据加密:对存储在HDFS上的数据进行加密,防止数据泄露。

2.访问控制:采用Kerberos进行身份认证,结合HDFS权限管理,实现数据访问控制。

3.数据脱敏:对敏感数据进行脱敏处理,确保数据合规使用。

4.审计日志:开启Hadoop审计日志,记录用户操作行为,便于审计和监控。

- ZooKeeper集群:负责集群的分布式协调服务,确保集群的高可用性。

- Kafka集群:用于收集和传输实时数据,为实时数据处理提供支持。

五、数据安全与合规性

1.数据加密:对存储在HDFS上的数据进行加密处理,防止数据泄露。

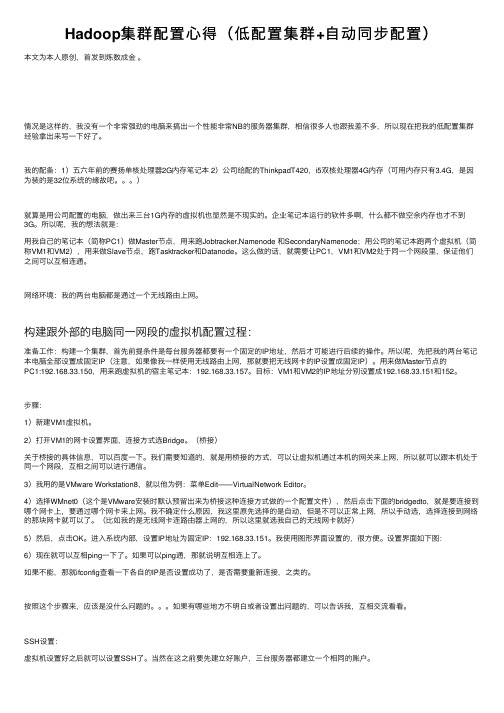

Hadoop集群配置心得(低配置集群+自动同步配置)

Hadoop集群配置⼼得(低配置集群+⾃动同步配置)本⽂为本⼈原创,⾸发到炼数成⾦。

情况是这样的,我没有⼀个⾮常强劲的电脑来搞出⼀个性能⾮常NB的服务器集群,相信很多⼈也跟我差不多,所以现在把我的低配置集群经验拿出来写⼀下好了。

我的配备:1)五六年前的赛扬单核处理器2G内存笔记本 2)公司给配的ThinkpadT420,i5双核处理器4G内存(可⽤内存只有3.4G,是因为装的是32位系统的缘故吧。

)就算是⽤公司配置的电脑,做出来三台1G内存的虚拟机也显然是不现实的。

企业笔记本运⾏的软件多啊,什么都不做空余内存也才不到3G。

所以呢,我的想法就是:⽤我⾃⼰的笔记本(简称PC1)做Master节点,⽤来跑Jobtracker,Namenode 和SecondaryNamenode;⽤公司的笔记本跑两个虚拟机(简称VM1和VM2),⽤来做Slave节点,跑Tasktracker和Datanode。

这么做的话,就需要让PC1,VM1和VM2处于同⼀个⽹段⾥,保证他们之间可以互相连通。

⽹络环境:我的两台电脑都是通过⼀个⽆线路由上⽹。

构建跟外部的电脑同⼀⽹段的虚拟机配置过程:准备⼯作:构建⼀个集群,⾸先前提条件是每台服务器都要有⼀个固定的IP地址,然后才可能进⾏后续的操作。

所以呢,先把我的两台笔记本电脑全部设置成固定IP(注意,如果像我⼀样使⽤⽆线路由上⽹,那就要把⽆线⽹卡的IP设置成固定IP)。

⽤来做Master节点的PC1:192.168.33.150,⽤来跑虚拟机的宿主笔记本:192.168.33.157。

⽬标:VM1和VM2的IP地址分别设置成192.168.33.151和152。

步骤:1)新建VM1虚拟机。

2)打开VM1的⽹卡设置界⾯,连接⽅式选Bridge。

(桥接)关于桥接的具体信息,可以百度⼀下。

我们需要知道的,就是⽤桥接的⽅式,可以让虚拟机通过本机的⽹关来上⽹,所以就可以跟本机处于同⼀个⽹段,互相之间可以进⾏通信。

《hadoop基础》课件——第三章 Hadoop集群的搭建及配置

19

Hadoop集群—文件监控

http://master:50070

20

Hadoop集群—文件监控

http://master:50070

21

Hadoop集群—文件监控

http://master:50070

22

Hadoop集群—任务监控

http://master:8088

23

Hadoop集群—日志监控

http://master:19888

24

Hadoop集群—问题 1.集群节点相关服务没有启动?

1. 检查对应机器防火墙状态; 2. 检查对应机器的时间是否与主节点同步;

25

Hadoop集群—问题

2.集群状态不一致,clusterID不一致? 1. 删除/data.dir配置的目录; 2. 重新执行hadoop格式化;

准备工作:

1.Linux操作系统搭建完好。 2.PC机、服务器、环境正常。 3.搭建Hadoop需要的软件包(hadoop-2.7.6、jdk1.8.0_171)。 4.搭建三台虚拟机。(master、node1、node2)

存储采用分布式文件系统 HDFS,而且,HDFS的名称 节点和数据节点位于不同机 器上。

2、vim编辑core-site.xml,修改以下配置: <property>

<name>fs.defaultFS</name> <value>hdfs://master:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/opt/soft/hadoop-2.7.6/tmp</value> </property> <property> <name>fs.trash.interval</name> <value>1440</value> </property>

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

• 提高网络速度最直接的办法是通过端口绑定, 将服务器的多个端口绑定为一个

• •

–

IP ip

–

•

Linux

• •

• • 3 Hadoop HBase 10

10GBE

•

• InfiniBand 10G InifiBand 20G 40G

• InfiniBand

• 4~10个节点,解决较小规模问题

– NN:NameNode,2NN:SecondaryNameNode, JT:JobTracker, ZK: ZooKeeper, Hmaster: HBaseMaster, DN: DataNode, TT: TaskTracker, RS: HBase RegionServer

• 大规模生产需要高可用性,配置方案:

MapReduce实际计算 节点 Hive元数据以及驱动 程序

角色 ZooKeeper

描述 用以提供集群高可用性的 锁服务 HBase用以调度 RegionServer的主模块 HBase中用以管理数据的 模块 可能的集群监控管理节点

节点数目 3个或3个以上的奇数的独 立节点(小规模可以和其 它角色共享节点) 与其它角色共享节点的多 个节点 一般与DataNode运行与相 同的节点之上 一般为一个独立的节点, 如果小规模集群的话可以 与其它角色共享

角色

HDFS NameNode

描述

分布式文件系统用以 存储文件系统以及数 据块的元数据 NameNode的影子节 点 HDFS数据存储 MapReduce调度程序

节点数目

1个独立节点

HDFS Secondary NameNode HDFS DataNode MapReduce JobTracker

项目 处理器CPU 内存 磁盘接口 磁盘 指标 双路四核服务器处理器,2x4 2.6GHz 32G或者以上内存,DDR3,ECC SAS 6GB/s 6x或者12x SATA 1T 7200RPM监控级 硬盘

网络

两个以太网口

• 20+个节点,解决中等规模问题,实际上能够满足大多数中小企 业的需求

项目 处理器CPU 内存 磁盘接口 磁盘 指标 双路六核服务器处理器,处理器缓存 15MB,2x6 2.9GHz 64G或者以上内存,DDR3,ECC SAS 6GB/s 6x或者12x SATA 1T或者3T 7200RPM监 控级硬盘(依据数据规模而定)

确保用于构建集群的所有的服务 器满足集群节点要求 (包括硬件 要求、软件要求和网络要求。)

做好构造Hadoop集群的规划

进行系统安装

在集群中的所有 节点上安装需要 的操作系统

正确配置所有节 点的RAID

安装Hadoop

参数配置

• 在规划中,除了选取硬件之外,还需要进 行角色的规划 • 角色的规划即确定Hadoop的某一个运行角 色运行在哪个节点之上 • 与硬件推荐情况一致,首先需要确定集群 的本身负载,针对小规模,中规模以及大 规模集群有不同的集群规划方案

网络

两个以太网口

• 依据问题规模确定所需要的节点数目,解决大规模问题,使用 高端的内存,高速网络

项目 处理器CPU 指标 双路六核服务器处理器,处理器缓存 15MB,2x6 2.9GHz,依据应用可以选 用更高端的处理器 96G或者以上内存,DDR3,ECC 2xSAS 6GB/s 24x 1TB 告诉SAS硬盘 10Gb以太网口

– NN:NameNode,2NN:SecondaryNameNode, JT:JobTracker, ZK: ZooKeeper, Hmaster: HBaseMaster, DN: DataNode, TT: TaskTracker, RS: HBase RegionServer

• 小规模生产需要高可用性,配置方案:

•

• • •

+ +MapReduce

• 典型使用以太网络,为了使得系统能够正常运 行,最低使用千兆以太网连接,由于需要有数 据交换的需求,建议配置大容量的网络交换机 • 当一台机器上有多个网络适配器时,推荐使用 网络适配器绑定Linux的方法配置链路聚合,并 把工作模式设为6。在工作模式为6时,负载平 衡可以通过循环取得,并且这些网络适配器可 以在没有配置交换器的情况下正常工作

• 最常见的是使用服务器本身的万兆以太网络, 每一个机架使用一个交换机,在多个机架之间 进行带宽聚合。这种方式在总的节点数目较少 (少于40个)集群比较合适 • 如果应用(例如ETL的应用)的IO高负载,这 样的话,网络会成为性能瓶颈

– 12块以上的硬盘,每块以100MB/s速度运行,会很 快吃掉所有网络带宽 – 低端的交换器不能够支持线速,产生阻塞

• • • • •

标准的x86的服务器 以太网络 多机架数据中心 软件环境 硬件的选择 (处理器,硬盘,网络)

HDFS 客户端

MapReduce 客户端

HBase 客户端

……

Hive 客户端

Hadoop 集群

HDFS MapReduce HBase Hive

管理节点

……

节点2 节点3

节点1

…… 节点N

Hadoop

• 规划使用Hadoop的组件,这些组件包括HDFS, MapReduce,Hive,HA组件等 • 规划集群的硬件参数,包括服务器数量,物理 布局,机架数目以及服务器在机架上的分配 • 规划集群使用的网络,即决定使用网络的拓扑, 节点到交换机的连接,机柜之间的连接 • 规划节点的IP地址设置以及节点的角色,例如 用以各个逻辑角色管理的节点,用以存储元数 据的NameNode,MapReduce程序的JobTracker, 管理节点等

•

– HDFS HBase map

DataNode, MapReduce TaskTracker Region Server slot slots reduce slots 16 2GB + 2GB + 512MB*16 + 16GB = 28GB

• HBase

• JBOD vs. RAID

–

RAID – RAID RAID 0

内存 磁盘接口 磁盘 网络

高端网络可以考虑使用InifinBand网络

• 支持的操作系统为Linux,要求64位系统,版本 至少6以上。包括:

– RedHat Enterprise Linux – CentOS – Oracle Linux

• 软件依赖:

– Java 1.6 – openssh

» 在把服务器加入集群前,须要确保openssh-server在运行。如果 openssh-server没有在运行,在Hadoop集群中的所有节点中安装 openssh-server包。

• 千兆以太网接口是最基本的要求,更重要的是交换机的背板带宽,是 决定数据传输的关键因素 • 一个以太网交换机的接口是以太网交换机到主机的速度,这个速度决 定主机到交换机的速度级别,在Hadoop环境中,这个速度最少应该是 千兆以太网 • 接口速度即使达到了千兆以太网,实际的运行速度可能并不能真正达 到千兆以太网的速度,因为可能有数十个设备同时共享这个交换机 • 决定交换机的性能的关键因素是交换机的背板带宽,具有良好背板交 换能力的交换机能够使得任意两个接口之间的速度以及上行的速度都 能够达到千兆的速度,而通过总线进行共享的带宽往往不能达到理想 的速度 • 为了能够使得Hadoop的处理能力能够得到充分的释放,交换机对于系 统运行的性能起到了决定性的左右,建议在可能的情况下尽量选择高 端的交换机,使得每一个接口都能够达到线速(网线能够达到什么速 度,交换机就能够提供什么速度,没有性能损失)

– – – – – 单独的NameNode节点:NN 单独的JobTracker节点:JT+ZK+Hmaster NameNode的副本: backup NN+2NN+ZK+Hmaster JobTracker节点的副本:Backup JT+ZK+HMaster 数据节点Data Node:DN+TT+RS, 在一个数据节点中部 署ZK+HMaster – 保证ZK的数目为奇数 – NN:NameNode,2NN:SecondaryNameNode, JT:JobTracker, ZK: ZooKeeper, Hmaster: HBaseMaster, DN: DataNode, TT: TaskTracker, RS: HBase RegionServer

小规模集群可以和 NameNode共享节点,大规 模集群用独立节点 多个独立节点 1个独立节点,小规模集群 可以与NameNode共享,大 规模集群使用独立节点 与DataNode运行在相同的 节点之上 独立配置的话可以与 NameNode共享节点,或者 将元数据存放在客户端

MapReduce TaskTracker Hive

HBase HMaster

HBase RegionServer Management Node

ห้องสมุดไป่ตู้ •

Hadoop Hadoop

•

–

• •

– IO

• • •

• •

4

16GB

服务器角色及服务类型 MapReduce Job Tracker MapReduce Task Tracker MapReduce Slots on Task Tracker HDFS NameNode HDFS Secondary NameNode HDFS DataNode ZooKeeper HBase Master Server HBase Region Server Hive Server 客户端 内存要求 2GB 2GB 512MB * slot数量 16GB 16GB 2GB 4GB 2GB 16GB 2GB 8GB