k中心和k均值算法

k均值聚类的方法原理

k均值聚类的方法原理k均值聚类是最常见的非层次聚类算法之一,它通过将数据点划分为k个聚类来对数据进行聚类分析,其中k是用户预先指定的聚类数量。

在该算法中,数据点被分配给最接近的聚类,以此来形成聚类。

1. 选择k个初始聚类中心点:在一开始,需要选择k个点作为聚类的中心点。

通常情况下,这些点被选择为随机的数据点。

2. 分配每个数据点到最近的聚类中心:每个数据点将被分配到最接近的聚类中心。

这可以通过计算数据点与每个聚类中心之间的距离来完成。

通常,欧氏距离是用于计算两点之间距离的最常用方法。

3. 更新聚类中心:在每个数据点被分配给最近的聚类中心后,需要更新聚类中心,以确保它们仍然代表该聚类中心的所有数据点。

为此,需要通过计算每个聚类中心周围所有数据点的平均值来更新该中心点。

4. 重复以上步骤:以上三个步骤需要不断重复,直到聚类中心不再发生变化,或者指定的迭代次数达到预定值。

通过以上步骤,k均值聚类可以将数据点分成k个聚类,每个聚类中心代表该聚类的中心点。

该聚类方法的优点在于它易于实现和可扩展性,而且对于大规模数据集具有较高的速度和良好的适应性。

1. 初始聚类中心的选择会影响聚类结果:如果初始聚类中心点选择的不够好,就有可能导致算法不能正确地将数据点分配到它们所属的聚类中。

3. 对于非球形分布的数据集,k均值聚类的效果会受到影响:如果数据点不是均匀分布在球形区域内,就有可能导致聚类结果不准确。

在实际使用k均值聚类算法时,需要根据具体数据集的特征选择最合适的k值和初始聚类中心点,以达到最佳的聚类效果。

需要注意算法的局限性,避免使用不适合该算法的数据集。

在进一步了解k均值聚类的方法原理之前,需要先了解什么是聚类分析。

聚类分析是一种常见的无监督学习方法,它可以将数据集中的每个数据点划分到不同的类别中,以便研究数据中的内在结构。

聚类分析可用于各种各样的应用,如市场细分、图像分割、搜索引擎、信号处理、家庭健康研究等。

K均值算法在医疗诊断中的应用技巧(六)

医疗诊断是医学领域中的重要应用场景,其结果直接影响患者的健康和生命。

近年来,随着人工智能技术的发展,K均值算法在医疗诊断中得到了广泛的应用。

K均值算法是一种常用的聚类分析方法,通过将数据集划分成K个簇,使得同一簇内的数据点彼此相似,而不同簇的数据点差异较大。

本文将就K均值算法在医疗诊断中的应用技巧进行探讨。

一、K均值算法原理K均值算法是一种基于距离的聚类分析方法,其原理较为简单。

首先,随机初始化K个簇的中心点,然后将数据集中的每个数据点分配给与其最近的中心点所在的簇。

接着,更新每个簇的中心点,直至簇中心点不再发生变化或达到预设的迭代次数。

最终,得到K个簇,使得每个数据点与其所属的簇中心点距离最小化。

在医疗诊断中,K均值算法可以应用于疾病分类、医学影像分析等方面。

例如,在疾病分类中,可以根据患者的生理指标和临床表现将患者分为不同的疾病类型;在医学影像分析中,可以根据影像特征将影像数据分为不同的疾病阶段或病灶位置。

二、K均值算法的优势相较于其他聚类算法,K均值算法具有计算简单、易于理解和实现的优势。

此外,K均值算法对大规模数据集的处理速度较快,适用于实时医疗诊断的场景。

在医疗诊断中,需要对大量的患者数据进行分析和处理,K均值算法能够有效地应对这一需求。

另外,K均值算法在处理高维数据时也表现良好。

在医疗诊断中,常常需要分析包括生理指标、基因数据、医学影像等在内的多种数据类型,这些数据往往是高维的。

K均值算法能够有效地处理高维数据,帮助医生更好地理解和分析患者的病情。

三、K均值算法的应用技巧在实际应用中,K均值算法需要根据具体的医疗诊断场景进行一定的调整和优化。

首先,需要对数据集进行预处理,包括数据清洗、特征选择、数据标准化等步骤。

通过预处理,可以提高K均值算法的准确性和稳定性,避免噪声数据对聚类结果的影响。

其次,K的取值对聚类结果有着重要的影响。

K值的选择需要根据具体的医疗诊断需求和数据特点来确定。

一般来说,可以通过肘部法则、轮廓系数等方法来确定最优的K值。

K均值算法PPT

初始中心位置选择对结果影响不大,那么是样本统计特性决定了分类 结果;但不能忽视初始中心设定对计算量的影响

8

考虑样本协方差

10

5

0

-5

-10 6 4 2 0 -2 -6 -2 -4 2 0 4

协方差相近时分类效果与样本的分布规律相关,方差越大, 错判的几率越大

9

结论及初始中心约与距离判别公式和样本本身统计特性关联度大,与初 始中心设定无关;但考虑大数据的聚类情况下,需要对阈值和初始中心进行 一定的约束,以此减少算法的时间复杂度,提高效率。 现提出初始中心设定的约束:

由其原理:考虑其优劣性应该由以下两点出发: 1.对应的样本数据的统计特征 2.算法内设的距离判别方式及阈值,初始分类中心的选择

4

样本统计特性影响

4 3 2 1 0 -1 -2 6 4 2 0 -2 -4 -2 2 0 4

协方差矩阵:

5

考虑均值差异较大时

结论:各类均值差异较大时,分类效果好

2

2.Kmeans算法的结构

原理流程: 1.选取样本总体(n个)中前k个个体,做为分类 中心F1 2.依次对第k+1个到第n个进行对1步中分类中心 求欧式距离,并以最小距离归类 3.获得新的k个分类中心F2,判断F2与F1的距离 是否小于阈值,是则停止,否则重复2

3

2.Kmeans算法的结构

6

考虑样本均值相近分类效果

结论:均值类别相差不大时data和C分类和实际存在大的差异,data和C的处 理差异与阈值或距离公式或初始中心设定相关,通过减少阈值(0.00001) 和改变距离判别公式发现结果仍然不变。如果与初始中心设定无关,那么就 是样本本身统计特性(均值相近)使得分类结果差

K均值算法的效果评估指标及使用技巧

K均值算法是一种常用的聚类算法,它通过迭代寻找数据点的中心,将数据点分配到最近的中心点所代表的类别中。

作为一种无监督学习算法,K均值算法在数据挖掘和模式识别领域被广泛应用。

然而,K均值算法的效果评估指标及使用技巧一直都是研究者和从业者们关注的焦点之一。

一、效果评估指标在使用K均值算法进行数据聚类时,需要对聚类效果进行评估。

常用的聚类效果评估指标包括“轮廓系数”、“DB指数”、“Dunn指数”等。

1. 轮廓系数(Silhouette Coefficient)轮廓系数是一种常用的聚类效果评估指标,它结合了聚类的紧密度和分离度。

轮廓系数的取值范围在[-1, 1]之间,值越接近1表示聚类效果越好,越接近-1表示聚类效果越差。

计算轮廓系数的公式如下:s(i) = (b(i) - a(i)) / max{a(i), b(i)}其中,a(i)代表第i个样本点到同一聚类中其他样本点的平均距离,b(i)代表第i个样本点到其他聚类中所有样本点的平均距离。

2. DB指数(Davies-Bouldin Index)DB指数是一种用于评估聚类效果的指标,它同时考虑了类内距离和类间距离。

DB指数的计算公式如下:DB = (1 / n) * Σ(max(R(i) + R(j)) / d(c(i), c(j)))其中,n代表聚类的个数,R(i)代表第i个类的半径,c(i)代表第i个类的中心点,d(c(i), c(j))代表第i个类和第j个类中心点的距禮。

3. Dunn指数Dunn指数是一种用于评估聚类效果的指标,它通过最大化类内距离和最小化类间距离来评估聚类效果。

Dunn指数的计算公式如下:Dunn = min{ min{d(c(i), c(j)) / max{R(i), R(j)} }, i ≠ j}其中,R(i)代表第i个类的半径,c(i)代表第i个类的中心点。

二、使用技巧除了对聚类效果进行评估外,使用K均值算法时还需要注意一些技巧。

K-均值聚类算法

4.重复分组和确定中心的步骤,直至算法收敛;

2.算法实现

输入:簇的数目k和包含n个对象的数据库。 输出:k个簇,使平方误差准则最小。

算法步骤:

1.为每个聚类确定一个初始聚类中心,这样就有K 个初始 聚类中心。

2.将样本集中的样本按照最小距离原则分配到最邻近聚类

给定数据集X,其中只包含描述属性,不包含 类别属性。假设X包含k个聚类子集X1,X2,„XK;各 个聚类子集中的样本数量分别为n1,n2,„,nk;各个 聚类子集的均值代表点(也称聚类中心)分别为m1, m2,„,mk。

3.算法实例

则误差平方和准则函数公式为:

k

2

E p mi

i 1 pX i

单个方差分别为

E1 0 2.52 2 22 2.5 52 2 22 12.5 E2 13.15

总体平均误差是: E E1 E2 12.5 13.15 25.65 由上可以看出,第一次迭代后,总体平均误差值52.25~25.65, 显著减小。由于在两次迭代中,簇中心不变,所以停止迭代过程, 算法停止。

示为三维向量(分别对应JPEG图像中的红色、绿色 和蓝色通道) ; 3. 将图片分割为合适的背景区域(三个)和前景区域 (小狗); 4. 使用K-means算法对图像进行分割。

2 015/8/8

Hale Waihona Puke 分割后的效果注:最大迭代次数为20次,需运行多次才有可能得到较好的效果。

2 015/8/8

例2:

2 015/8/8

Ox y 102 200 3 1.5 0 450 552

数据对象集合S见表1,作为一个 聚类分析的二维样本,要求的簇的数 量k=2。

K均值算法的效果评估指标及使用技巧(五)

K均值算法是一种常用的聚类算法,被广泛应用于数据挖掘、模式识别和机器学习等领域。

它可以将数据集划分为K个不同的簇,使得每个数据点都属于离它最近的簇。

然而,K均值算法也存在一些问题,比如对初始簇中心的选择敏感以及对簇的形状和密度的假设。

因此,在使用K均值算法时,对其效果进行评估是非常重要的。

一、效果评估指标1. 轮廓系数(Silhouette Coefficient)轮廓系数是一种常用的聚类效果评估指标,它考虑了簇的紧密度和分离度。

对于每个数据点i,它的轮廓系数可以表示为:s(i) = (b(i) - a(i)) / max{a(i), b(i)}其中,a(i)是数据点i与同一簇内其他点的平均距离,b(i)是数据点i与最近其他簇的所有点的平均距离。

轮廓系数的取值范围在-1到1之间,值越接近1表示簇内紧密度和簇间分离度越高,说明聚类效果越好。

2. 簇内离差平方和(Intra-cluster Sum of Squares)簇内离差平方和是指每个簇中所有数据点与簇中心的距离平方和。

它可以用来衡量簇的紧密度,值越小表示簇内数据点越接近簇中心,聚类效果越好。

3. 轮廓图(Silhouette Plot)轮廓图可以直观地展示每个数据点的轮廓系数,帮助我们理解数据点在簇内和簇间的分布情况。

通过观察轮廓图,我们可以对聚类效果进行直观的评估和比较。

二、使用技巧1. 选择合适的K值K均值算法中的K值表示簇的数量,选择合适的K值对于聚类效果至关重要。

一般来说,可以通过绘制肘部法则(Elbow Method)图来选择最佳的K值。

肘部法则图会显示不同K值下的簇内离差平方和,找到拐点所对应的K值即可作为最佳K 值。

2. 针对数据特点进行预处理在使用K均值算法之前,需要对数据进行适当的预处理。

例如,对数据进行标准化或归一化,可以使不同特征的尺度统一,避免某些特征对聚类结果产生过大影响。

3. 多次运行算法由于K均值算法对初始簇中心的选择敏感,因此可以多次运行算法,选择聚类效果最好的一次作为最终结果。

k均值算法

k均值算法

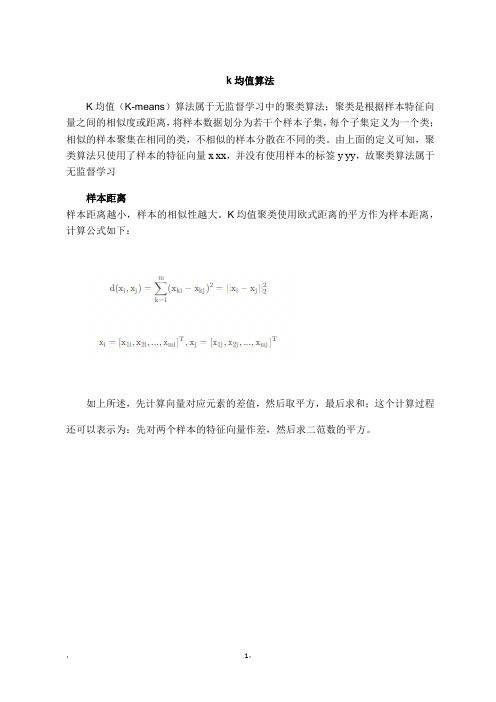

K均值(K-means)算法属于无监督学习中的聚类算法;聚类是根据样本特征向

量之间的相似度或距离,

将样本数据划分为若干个样本子集,每个子集定义为一个类;相似的样本聚集在相同的类,不相似的样本分散在不同的类。

由上面的定义可知,聚类算法只使用了样本的特征向量x xx,并没有使用样本的标签y yy,故聚类算法属于无监督学习

样本距离

样本距离越小,样本的相似性越大。

K均值聚类使用欧式距离的平方作为样本距离,计算公式如下:

如上所述,先计算向量对应元素的差值,然后取平方,最后求和;这个计算过程还可以表示为:先对两个样本的特征向量作差,然后求二范数的平方。

,1,。

数学建模-聚类分析

满足输出;不满足循环;

(7)重复;

初始聚类中心的选择

初始聚类中心的选取决定着计算的迭代 次数,甚至决定着最终的解是否为全局最优, 所以选择一个好的初始聚类中心是很有必要 的。

(1)方法一:选取前k个样品作为初始凝聚点。

(2)方法二: 选择第一个样本点作为第一个聚类 中心。然后选取距离第一个点最远的点作为第二个 聚 类中心。……

数据变换:进行[0,1]规格化得到

初始类个数的选择; 初始类中心的选择;

设k=3,即将这15支球队分成三个集团。现抽取日 本、巴林和泰国的值作为三个类的种子,即初始化三 个类的中心为 A:{0.3, 0, 0.19}; B:{0.7, 0.76, 0.5}; C:{1, 1, 0.5};

样品到类中心的距离; 归类;

计算所有球队分别对三个中心点的欧氏 距离。下面是用程序求取的结果:

第一次聚类结果: A:日本,韩国,伊朗,沙特; B:乌兹别克斯坦,巴林,朝鲜; C:中国,伊拉克,卡塔尔,阿联酋,泰 国,越南,阿曼,印尼。

重新计算类中心;

下面根据第一次聚类结果,采用k-均值法调整各个类的 中心点。

A类的新中心点为:{(0.3+0+0.24+0.3)/4=0.21,

数据变换

(5)极差正规化变换:

x*ij

=

xij

min 1t n

xij

Rj

i 1,,2,...,,n; j 1,..., m

(6)对数变换x*:ij = log xij

i 1,,2,...,,n; j 1,..., m

k

样品间的距离

(1)绝对值距离:

m

dij

xit x jt

t 1