统计学习理论的本质

统计学习方法

统计学习方法统计学习方法是一种利用数据来进行模式识别和预测的方法,它在各个领域都有着广泛的应用。

统计学习方法的核心是从数据中学习模型,然后利用学习到的模型对新数据进行预测或者分析。

在本文中,我们将介绍统计学习方法的基本原理、常见的算法以及其在实际问题中的应用。

首先,统计学习方法的基本原理是通过对数据的学习来获取数据中的模式和规律。

这个过程可以简单地分为三个步骤,首先是收集和准备数据,其次是选择合适的模型来拟合数据,最后是利用拟合好的模型对新数据进行预测或者分析。

在这个过程中,统计学习方法涉及到很多统计理论和机器学习算法,比如线性回归、逻辑回归、支持向量机、决策树等。

其次,统计学习方法有着丰富的算法和模型。

其中,线性回归是最简单的统计学习方法之一,它通过拟合一个线性模型来描述输入变量和输出变量之间的关系。

逻辑回归则是一种广泛应用于分类问题的统计学习方法,它通过拟合一个逻辑函数来对数据进行分类。

支持向量机是一种强大的统计学习方法,它通过在高维空间中寻找一个最优的超平面来进行分类。

决策树是一种直观的统计学习方法,它通过构建一棵树来对数据进行分类或者回归。

最后,统计学习方法在实际问题中有着广泛的应用。

比如在金融领域,统计学习方法可以用来进行股票价格的预测和风险管理;在医疗领域,统计学习方法可以用来进行疾病的诊断和预测;在推荐系统中,统计学习方法可以用来进行用户的个性化推荐。

除此之外,统计学习方法还可以应用于自然语言处理、计算机视觉、生物信息学等各个领域。

综上所述,统计学习方法是一种通过对数据的学习来获取模式和规律的方法,它有着丰富的算法和模型,并且在各个领域都有着广泛的应用。

希望本文能够帮助读者更好地理解统计学习方法,并且在实际问题中应用统计学习方法来解决问题。

学习统计学心得体会范文10篇

学习统计学心得体会范文10篇Experience in learning statistics编订:JinTai College学习统计学心得体会范文10篇小泰温馨提示:心得体会是指一种读书、实践后所写的感受性文字。

语言类读书心得同数学札记相近;体会是指将学习的东西运用到实践中去,通过实践反思学习内容并记录下来的文字,近似于经验总结。

本文档根据心得体会内容要求和针对主题是读书学习群体的特点展开说明,具有实践指导意义,便于学习和使用,本文下载后内容可随意修改调整及打印。

本文简要目录如下:【下载该文档后使用Word打开,按住键盘Ctrl键且鼠标单击目录内容即可跳转到对应篇章】1、篇章1:学习统计学心得体会范文2、篇章2:学习统计学心得体会范文3、篇章3:学习统计学心得体会范文4、篇章4:学习统计学心得体会范文5、篇章5:学习统计学心得体会范文6、篇章6:学习统计学心得体会范文7、篇章7:统计学课程学习心得体会文档8、篇章8:统计学课程学习心得体会文档9、篇章9:统计学课程学习心得体会文档10、篇章10:统计学课程学习心得体会文档统计学的学习内容是什么呢?统计学是通过搜索、整理、分析数据等手段,以达到推断所测对象的本质。

下面是带来的学习统计学心得体会范文,希望大家喜欢。

篇章1:学习统计学心得体会范文花几天时间,整体复习了一遍统计学,准确的来说是从第一页开始较为仔细的阅读了一遍《统计学》这本教科书。

随后统计为我打开了另一扇窗,让我得以从不同的视角重新思考这门让我痛苦了一个学期的课程。

至此统计学不再仅仅是一些无数抽象公式的代名词,而是一门理论联系实际,工作活动中不可或缺的一门重要科学。

《总论》和《统计数据》的内容比较简单,引出概念,复习以往学习过的知识。

就在我们放松警惕,大呼统计学一点也不难的时候,《抽样估计》彻底震住了自鸣得意的我们。

理论上来说《假设检验与方差分析》的内容要难于《抽样估计》。

但是个人觉得《抽样估计》的行文并不像《假设检验》那么好理解。

再生核

再生核定义:H是一个定义在一抽象集合B的实值或复值的Hilbert函数空间,对任意f(x)属于H,x属于B,若存在二元函数K(x,y),满足:(1)对任意固定y属于B,K(x,y)作为x的函数属于H;(2)对任意f(x)属于H,有f(y)=(f(x),K(x,y))H(H为下标)。

则称K(x,y)为H的再生核,H是以K(x,y)为再生核的Hilbert空间,简称再生核Hilbert空间,简记为RKHS(Reproducing Kernel Hilbert Space)。

通常称(2)为再生性质。

性质:(1)唯一性:如果Hilbert空间有再生核K(x,y),则再生核唯一(如果内积不同,也可能有不同的再生核);(2)存在性:Hilbert空间H有再生核=所有的泛函et(t为下标),t∈E在H上连续;(3)全空间与子空间核的关系;参考《以{EI}I^N=1为正交基的再生核HILBERT空间》--李莎莎,郭锐(4)正定性:任何一个再生核都是正定矩阵(对应的二次型)。

数学解释定义:H是一个定义在一抽象集合B的实值或复值的Hilbert函数空间,对任意f(x)属于H,x属于B,若存在二元函数K(x,y),满足:(1)对任意固定y属于B,K(x,y)作为x的函数属于H;(2)对任意f(x)属于H,有f(y)=(f(x),K(x,y))H(H为下标)。

则称K(x,y)为H的再生核,H是以K(x,y)为再生核的Hilbert空间,简称再生核Hilbert空间,简记为RKHS(Reproducing Kernel Hilbert Space)。

通常称(2)为再生性质。

性质:(1)唯一性:如果Hilbert空间有再生核K(x,y),则再生核唯一(如果内积不同,也可能有不同的再生核);(2)存在性:Hilbert空间H有再生核=所有的泛函et(t为下标),t∈E在H上连续;(3)全空间与子空间核的关系;参考《以{EI}I^N=1为正交基的再生核HILBERT空间》--李莎莎,郭锐(4)正定性:任何一个再生核都是正定矩阵(对应的二次型)。

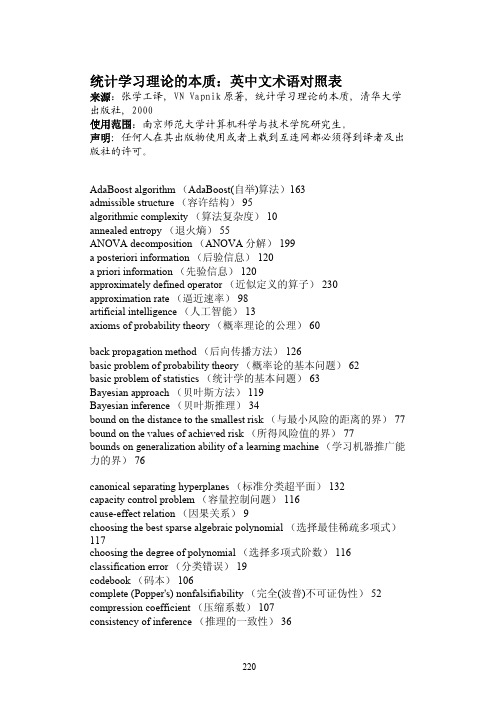

英中文术语对照表(统计学习理论的本质-张学工译)

统计学习理论的本质:英中文术语对照表来源:张学工译, VN Vapnik原著, 统计学习理论的本质, 清华大学出版社, 2000使用范围:南京师范大学计算机科学与技术学院研究生。

声明:任何人在其出版物使用或者上载到互连网都必须得到译者及出版社的许可。

AdaBoost algorithm (AdaBoost(自举)算法)163admissible structure (容许结构) 95algorithmic complexity (算法复杂度) 10annealed entropy (退火熵) 55ANOVA decomposition (ANOVA分解) 199a posteriori information (后验信息) 120a priori information (先验信息) 120approximately defined operator (近似定义的算子) 230 approximation rate (逼近速率) 98artificial intelligence (人工智能) 13axioms of probability theory (概率理论的公理) 60back propagation method (后向传播方法) 126basic problem of probability theory (概率论的基本问题) 62basic problem of statistics (统计学的基本问题) 63Bayesian approach (贝叶斯方法) 119Bayesian inference (贝叶斯推理) 34bound on the distance to the smallest risk (与最小风险的距离的界) 77 bound on the values of achieved risk (所得风险值的界) 77bounds on generalization ability of a learning machine (学习机器推广能力的界) 76canonical separating hyperplanes (标准分类超平面) 132capacity control problem (容量控制问题) 116cause-effect relation (因果关系) 9choosing the best sparse algebraic polynomial (选择最佳稀疏多项式)117choosing the degree of polynomial (选择多项式阶数) 116 classification error (分类错误) 19codebook (码本) 106complete (Popper's) nonfalsifiability (完全(波普)不可证伪性) 52 compression coefficient (压缩系数) 107consistency of inference (推理的一致性) 36constructive distribution-independent bound on the rate of convergence (构造性的不依赖于分布的收敛速度界) 69convolution of inner production (内积回旋) 140criterion of nonfalsifiability (不可证伪性判据) 47data smoothing problem (数据平滑问题) 209decision-making problem (决策选择问题) 296decision trees (决策树) 7deductive inference (演绎推理) 47density estimation problem (密度估计问题):parametric(Fisher-Wald) setting(参数化(Fisher-Wald)表示) 20nonparametric setting (非参数表示) 28discrepancy (差异) 18discriminant analysis (判别分析) 24discriminant function (判别函数) 25distribution-dependent bound on the rate of convergence (依赖于分布的收敛速度界) 69distribution-independent bound on the rate of convergence (不依赖于分布的收敛速度界) 69ΔΔ-margin separating hyperplane (间隔分类超平面) 132 empirical distribution function (经验分布函数) 28empirical processes (经验过程) 40empirical risk functional (经验风险泛函) 20empirical risk minimization inductive principle (经验风险最小化归纳原则) 20ensemble of support vector machines (支持向量机的组合) 163 entropy of the set of functions (函数集的熵) 42entropy on the set of indicator functions (指示函数集的熵) 42 equivalence classes (等价类) 292estimation of the values of a function at the given points (估计函数在给定点上的值) 292expert systems (专家系统) 7ε-insensitivity (ε不敏感性) 181ε-insensitive loss function (ε不敏感损失函数) 181feature selection problem (特征选择问题) 118function approximation (函数逼近) 98function estimation model (函数估计模型) 17Gaussian (高斯函数) 26generalized Glivenko-Cantelli problem (广义Glivenko-Cantelli问题)66generalized growth function (广义生长函数) 85generator random vectors (随机向量产生器) 17Glivenko-Cantelli problem (Glivenko-Cantelli问题) 66growth function (生长函数) 55Hamming distance (汉明距离) 104handwritten digit recognition (手写数字识别) 146hard threshold vicinity function (硬限邻域函数) 103hard vicinity function (硬领域函数) 269hidden Markov models (隐马尔可夫模型) 7hidden units (隐结点) 101Huber loss function (Huber损失函数) 183ill-posed problems (不适定问题): 9solution by variation method (变分方法解) 236solution by residual method (残差方法解) 236solution by quasi-solution method (拟解方法解) 236 independent trials (独立试验) 62inductive inference (归纳推理) 50inner product in Hilbert space (希尔伯特空间中的内积) 140 integral equations (积分方程):solution for exact determined equations (精确确定的方程的解)237solution for approximately determined equations (近似确定的方程的解) 237kernel function (核函数) 27Kolmogorov-Smirnov distribution (Kolmogorov-Smirnov分布) 87 Kulback-Leibler distance (Kulback-Leibler距离) 32Kuhn-Tücker conditions (库恩-塔克条件) 134Lagrangian multiplier (拉格朗日乘子) 133Lagrangian (拉格朗日函数) 133Laplacian (拉普拉斯函数) 277law of large number in the functional space (泛函空间中的大数定律)41law of large numbers (大数定律) 39law of large numbers in vector space (向量空间中的大数定律) 41 Lie derivatives (Lie导数) 20learning matrices (学习矩阵) 7least-squares method (最小二乘方法) 21least-modulo method (最小模方法) 182linear discriminant function (学习判别函数) 31linearly nonseparable case (线性不可分情况) 135local approximation (局部逼近) 104local risk minimization (局部风险最小化) 103locality parameter (局部性参数) 103loss-function (损失函数):for AdaBoost algorithm (AdaBoost算法的损失函数) 163for density estimation (密度估计的损失函数) 21for logistic regression (逻辑回归的损失函数) 156for pattern recognition (模式识别的损失函数) 21for regression estimation (回归估计的损失函数) 21 madaline(Madaline自适应学习机) 7main principle for small sample size problems (小样本数问题的基本原则) 28maximal margin hyperplane (最大间隔超平面) 131maximum likehood method (最大似然方法) 24McCulloch-Pitts neuron model (McCulloch-Pitts神经元模型) 2 measurements with the additive noise (加性噪声下的测量) 25 metric ε-entropy (ε熵度量) 44minimum description length principle (最小描述长度原则) 104 mixture of normal densities (正态密度的组合) 26National Institute of Standard and Technology (NIST) digit database (美国国家标准技术研究所(NIST)数字数据库) 173neural networks (神经网络) 126non-trivially consistent inference (非平凡一致推理) 36 nonparametric density estimation (非参数密度估计) 27normal discriminant function (正态判别函数) 31one-sided empirical process (单边经验过程) 40optimal separating hyperplane (最优分类超平面) 131overfitting phenomenon (过学习现象) 14parametric methods of density estimation (密度估计的参数方法) 24 partial nonfalsifiability (部分不可证伪性) 51Parzen's windows method (Parzen窗方法) 27pattern recognition problem (模式识别问题) 19perceptron (感知器) 1perceptron's stopping rule (感知器迭代终止规则) 6polynomial approximation of regression (回归的多项式逼近) 116 polynomial machine (多项式机器) 143potential nonfalsifiability (潜在不可证伪性) 53probability measure (概率测度) 59probably approximately correct (PAC) model (可能近似正确(PAC)模型) 13problem of demarcation (区分问题) 49pseudo-dimension (伪维) 90quadratic programming problem (二次规划问题) 133quantization of parameters (参数的量化) 110quasi-solution (拟解) 112radial basis function machine (径向基函数机器) 144random entropy (随机熵) 42radnom string (随机串) 10randomness concept (随机性概念) 10regression estimation problem (回归估计问题) 19regression function (回归函数) 19regularization theory (正则化理论) 9regularized functional (正则化泛函) 9reproducing kernel Hilbert space (再生核希尔伯特空间) 244 residual principle (残差原则) 236rigorous (distribution-dependent) bounds (严格(依赖于分布的)界) 85 risk functional (风险泛函) 18risk minimization from empirical data problem (基于经验数据最小化风险的问题) 20robust estimators (鲁棒估计) 26robust regression (鲁棒回归) 26Rosenblatt's algorithm (Rosenblatt算法) 5set of indicators (指示器集合) 73set of unbounded functions (无界函数集合) 77σ-algebra (σ代数) 60sigmoid function (S型(sigmoid)函数) 125small samples size (小样本数) 93smoothing kernel (平滑核) 100smoothness of functions (函数的平滑性) 100soft threshold vicinity function (软阈值领域函数) 103soft vicinity function (软领域函数) 269soft-margin separating hyperplane (软间隔分类超平面) 135spline function (样条函数):with a finite number of nodes (有限结点的样条函数) 194with an infinite number of nodes (无穷多结点的样条函数) 195 stochastic approximation stopping rule (随机逼近终止规则) 34 stochastic ill-posed problems (随机不适定问题) 113strong mode estimating a probability measure (强方式概率度量估计)63structural risk minimization principle (结构风险最小化原则) 94 structure (结构) 94structure of growth function (生长函数的结构) 79supervisor (训练器) 17support vector machines (支持向量机) 137support vectors (支持向量) 134support vector ANOVA decomposition (支持向量ANOVA分解) 199 SVM n approximation of the logistic regression (逻辑回归的SVM n逼近) 155SVM density estimator (SVM密度估计) 246SVM conditional probability estimator (SVM条件概率估计) 257 tails of distribution (分布的尾部) 78tangent distance (切距) 149training set (训练集) 18transductive inference (转导推理) 293Turing-Church thesis (Turing-Church理论) 177two layer neural networks machine (两层神经网络机器) 145two-sided empirical process (双边经验过程) 40U.S. Postal Service digit database (美国邮政数字数据库) 173 uniform one-sided convergence (一致单边收敛) 39uniform two-sided convergence (一致双边收敛) 39VC dimension of a set of indictor functions (指示函数集的VC维) 79 VC dimension of a set of real functions (实函数集的VC维) 81VC entropy (VC熵) 44VC subgraph (VC子图) 90vicinal risk minimization method(领域风险最小化) 268vicinity kernel(领域核):273one-vicinal kernel (单领域核) 273two-vicinal kernel (双领域核) 273VRM method (VRM方法):for pattern recognition (模式识别的VRM方法) 273for regression estimation (回归估计的VRM方法) 282for density estimation (密度估计的VRM方法) 284for conditional probability estimation (条件概率估计的VRM方法) 285for conditional density estimation (条件密度估计的VRM方法)286weak mode estimating a probability measure (弱方式概率度量估计)63weight decay procedure (权值衰减过程) 102。

机器学习论文

现代机器学习理论论文题目:综述机器学习与支持向量机学院:电子工程学院专业:学号:学生姓名:综述机器学习与支持向量机摘要机器学习是研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能,它是人工智能的核心,是使计算机具有智能的根本途径。

基于数据的机器学习是现代智能技术中的重要方面,研究从观测数据出发寻找规律,利用这些规律对未来数据或无法观测的数据进行预测,包括模式识别、神经网络等在内,现有机器学习方法共同的重要理论基础之一是统计学。

支持向量机是从统计学发展而来的一种新型的机器学习方法,在解决小样本、非线性和高维的机器学习问题中表现出了许多特有的优势,但是,支持向量机方法中也存在着一些亟待解决的问题,主要包括:如何用支持向量机更有效的解决多类分类问题,如何解决支持向量机二次规划过程中存在的瓶颈问题、如何确定核函数以及最优的核参数以保证算法的有效性等。

本文详细介绍机器学习的基本结构、发展过程及各种分类,系统的阐述了统计学习理论、支持向量机理论以及支持向量机的主要研究热点,包括求解支持向量机问题、多类分类问题、参数优化问题、核函数的选择问题等,并在此基础上介绍支持向量机在人脸识别中的应用,并通过仿真实验证明了算法的有效性。

关键词:机器学习;统计学习理论;SVM;VC维;人脸识别The Summarization of Machine Learning and Support Vector MachineABSTRACTMachine learning is to study how a computer simulates or realizes human behaviors to acquire new information and skills, then rebuilds its knowledge structure to improve itself capability constantly. It is the core of Artificial Intelligence,and is the underlying way in which a computer develops intelligence.Machine learning based on data is one of the most important aspects of modern intelligence technology. It is to investigate how to find a rule starting from data observation, and use the rule to predict future data and unavailable data. Statistics is one of the most common important theory elements of the existing methods of machine learning, including Pattern Recognition and Neural Networks.SVM(Support Vector Machine) is a novel method of machine learning evoling from Statistics. SVM presents many own advantages in solving machine learning problems such as small samples, nonlinearity and high dimension. However, SVM methods exist some problems need to be resolved, mainly including how to deal with multi-classification effectively, how to solve the bottle-neck problem appearing in quadratic programming process, and how to decide kernel function and optimistical kernel parameters to guarantee effectivity of the algorithm.This paper has introduced in detail the structure, evolvement history, and kinds of classification of machine learning, and demonstrated systemly SLT(Statistical Learning Theory), SVM and research hotspots of SVM, including seeking SVM problems, multi-classification, parameters optimization, kernel function selection and so on. The application on human face recognition has been introduced based on above theory, and the simulation experiment has validated the algorithm.Keywords: Machine learning, SLT, SVM, VC dimension, Human face recognition目录摘要 (I)ABSTRACT (II)1.绪论 (1)1.1研究背景及意义 (1)1.1.1 机器学习概念的出现 (1)1.1.2支持向量机的研究背景 (1)1.2本文主要内容 (3)2.机器学习的结构及分类 (4)2.1机器学习定义及发展 (4)2.2机器学习系统的基本结构 (5)2.3机器学习的分类 (6)2.4目前研究领域 (9)3.支持向量机的原理 (10)3.1统计学习理论 (10)3.1.1机器学习问题 (10)3.1.2统计学理论的发展与支持向量机 (11)3.1.3VC维理论 (12)3.1.4推广性的界 (12)3.1.5结构风险最小化原则 (13)3.2支持向量机理论 (14)3.2.1最优分类面 (16)3.2.2标准支持向量机 (18)4.支持向量机的主要研究热点 (20)4.1支持向量机多类分类方法 (20)4.2求解支持向量机的二次规划问题 (23)4.3核函数选择及其参数优化 (25)5.支持向量机的算法仿真 (27)5.1人脸识别的理论基础 (27)5.2基于PCA方法和SVM原理的人脸识别仿真 (28)6.参考文献 (33)1.绪论1.1研究背景及意义1.1.1 机器学习概念的出现学习是人类具有的一种重要智能行为,但究竟什么是学习,长期以来却众说纷纭。

机器学习书目推荐

机器学习推荐书目

1. 《机器学习》作者:Mitchell T.M.

2. 《统计学习理论的本质》作者:瓦普尼克译者:许建华,张学工出版社:电子工业出版社

3. 《模式识别(第4版) 》作者:Sergios Theodoridis

4. 《数学建模(英文影印精编版.第4版)》作者:Frank R. Giordano

5.《统计学习理论》作者:瓦普尼克译者:许建华,张学工出版社:电子工业出版社

6. 《统计自然语言处理基础》作者:Hinrich

6. 《支持向量机导论》(英文版) 作者:克里斯蒂亚尼

7. 《统计学习基础:数据挖掘、推理与预测》作者:Trevor Hastie

8. 《神经网络与机器学习(英文版第3版)》作者:Simon Haykin

9. 《模式分类(原书第2版)》(建议英文版)作者:richard o.duda

10. 《统计自然语言处理》作者:宗成庆。

数学的数学统计

数学的数学统计数学统计,是数学的一个分支学科,是应用数学的一种重要方法。

它研究如何收集、整理、分析和解释数据的方法和理论,为科学研究、经济决策、社会调查等提供了强有力的工具和支持。

数学统计通过运用统计学的理论和方法,能够从观测到的数据中推断和评价未观测到的现象,并为决策提供依据。

一、数学统计的概念与意义数学统计是研究统计学的基本理论、方法和应用的数学分支学科。

它主要包括描述统计和推断统计两大部分。

描述统计主要负责对数据进行收集、整理、总结和展示;推断统计则从已有数据中推断总体的未知特征。

数学统计凭借其严谨的数学基础和统计学的应用背景,成为现代科学发展、经济决策和市场预测中不可或缺的工具和方法。

数学统计的意义在于,通过对样本数据的收集和分析,能够帮助我们更好地认识和理解事物的规律和特征。

例如,在医学研究中,数学统计可以通过对大量样本的分析,推断出一种新药物的疗效;在市场调查中,数学统计可以帮助企业评估产品的市场需求和潜在销售量。

通过数学统计的方法,我们可以更客观地了解事物,做出更准确的判断和决策。

二、数学统计的基本原理1. 总体与样本在数学统计中,我们将研究对象称为“总体”,总体由全体个体或元素组成。

而从总体中选取的一部分个体组成的集合称为“样本”。

样本是我们进行统计分析的基本单位,通过对样本的分析,可以推断总体的特征。

2. 参数与统计量在数学统计中,我们通常会关注总体的各项特征,这些特征称为“参数”。

参数是总体的属性,例如总体均值、方差等。

而通过样本计算得出的数据,用来估计总体参数的量称为“统计量”。

统计量是样本的函数,可以通过对样本数据的分析来估计总体的未知特征。

3. 随机变量与概率分布随机变量是数学统计中的重要概念,它是随机试验结果的一种数值化表达。

概率分布是描述随机变量取值的分布情况,常见的概率分布包括正态分布、泊松分布等。

通过对随机变量的分析与概率分布的研究,我们可以描述和解释观测数据的规律。

基于超曲面的多类分类方法

2003年3月系统工程理论与实践第3期 文章编号:100026788(2003)0320092208基于超曲面的多类分类方法何 清1,史忠植1,任力安2(1.中科院计算技术研究所智能信息处理重点实验室,北京100080;2.中国科技大学研究生院计算机学部,北京100039)摘要: 使用支持向量机对非线性可分数据进行分类的基本思想是将样本集映射到一个高维线性空间使其线性可分Λ基于Jo rdan曲线定理,提出了一种通用的基于分类超曲面的分类法,它是通过直接构造分类超曲面,根据样本点关于分类曲面的围绕数的奇偶性进行分类的一种全新分类判断算法,不需作升维变换,不需要考虑使用何种核函数,而直接地解决非线性分类问题Λ对数据分类应用的结果说明,基于分类超曲面的多类分类法可以有效地解决非线性数据的分类问题,并能够提高分类效率和准确度Λ关键词: 支持向量机;分类超曲面;Jo rdan曲线定理中图分类号: T P30126 文献标识码: A T he M u lti2class C lassificati on M ethod Based on H yper Su rfaceH E Q ing1,SH I Zhong2zh i1,R EN L i2an2(1.T he Key L abo rato ry of In telligen t Info rm ati on P rocessing,In stitu te of Compu ting T echno logy,Ch inese A cadem y of Sciences,Beijing100080,Ch ina;2.Graduate Co llege,U n iversity of Science and T echno logy of Ch ina,Beijing100039, Ch ina)Abstract: T he m ain idea of classifying non linear separab le data by u sing SVM ie.Suppo rt V ecto rM ach ine is to m ap the data in to h igher di m en si on linear space in w h ich the data can be separated byhyper p lane.Based on Jo rdan Cu rve T heo rem,a un iversal classificati on m ethod based on hyper su rfaceis pu t fo rw ard in th is paper.T he classificati on hyper su rface is directly m ade to classify huge dataacco rding to w hether the w ind num ber is odd o r even.It is a novel app roach that needn’t m ake m app ingfrom low er di m en si on space to h igher di m en si on space and needn’t con sider kernel functi on too.It candirectly so lve the non linear classify p rob lem.T he experi m en tal repo rts show that the new m ethod canefficien tly and accu rately classify m u lti2class huge data.Key words: suppo rt vecto r m ach ine;separating hyper su rface;Jo rdan cu rve theo rem1 引言机器学习研究获取新知识、新技巧,重组已经出现的知识的计算方法,它是人工智能中的基本问题,甚至有人认为学习的能力是智能的表现Λ模式识别、函数拟合及概率密度估计等都属于基于数据学习的问题,其中分类问题是许多其它问题的基础和核心ΛV ap n ik等人从20世纪60年代开始研究有限样本下的机器学习问题[1-5]Λ到90年代,形成了一个比较完善的理论体系——统计学习理论(Statistical L earn ing T heo ry),也发展了一种新的通用学习算法——支持向量机(Suppo rt V ecto rM ach ine,SVM)Λ特别是SVM对小样本、非线性和高维特征具有很好的性能Λ其基本考虑是通过内积函数定义的非线性映射(核函数)将非线性样本集映射到一个高维线性空间,在计算上,借助二次规划求解支持向量需要反复计算一个m维的内积矩阵(其中m是样本个数),所需要收稿日期:2001212212资助项目:国家自然科学基金(60173017,90104021,60073019);北京市自然科学基金(4011003) 作者简介:何清(1965-),男,河北深泽人,副研究员,博士,研究方向:模糊集理论、人工智能、数据挖掘、机器学习;史忠植(1941-),男,江苏人,研究员,博士生导师,主要研究方向:人工智能、智能软件、神经计算;任力安(1975-);男,陕西西安人,硕士,研究方向:人工智能、模式识别、专家系统的计算开销是相当大的,因而解决海量数据的分析与处理几乎是不可能的Λ1999年,我国学者张铃与张钹教授提出二次规划优化函数的几何方法[6],采用球面投影函数作为非线性映射,完成样本点的分类问题,即将计算分类超平面的问题转换为计算样本点两两之间距离所构成的距离空间上的覆盖问题,这与V ap n ik 的思想在本质上是相同的Λ基于邻域的方法在计算样本之间内积的同时,判断哪些样本可以删除.每删除一个样本就意味着使得内积矩阵降低一维,因此,这个考虑特别适合内积矩阵阶数过大的情形Λ在文献[7]中,张文生、丁辉、王珏对邻域方法作了详尽的数学分析和几何解释,并给出了三种典型的求支持向量的邻域算法Λ另一方面,基于邻域方法的考虑与W idrow 的M adaline 非常类似,即使用多个超平面(邻域)对空间划分,这个方法暗示,无论使用什么样的非线性映射,邻域方法均可以求出一个解Λ不同非线性映射所求出解答的区别仅仅在于,所需要的超平面的个数ΛV ap n ik 对九十年代机器学习的考虑,他认为,这个时期以他为代表的研究只是返回到感知机年代Λ如果考虑这是V ap n ik 为改善“感知机”与“神经网络”所存在的缺陷而作出的努力的话,那么,应该说,这是V ap n ik 对统计机器学习的重要贡献Λ感知机的线性特性,虽然使其不能解决非线性函数的优化问题,但是,其算法却相对简单得多Λ是否可以使用感知机原理解决非线性优化问题呢?在历史上,为解决这个问题,在技术上曾经有过多次尝试,20世纪60年代W idrow 与Hoff [8,9]提出的自适应线性元件神经网络A daline ,以及由多个A daline 组成的M adaline 就是这种尝试之一Λ他们试图使用多个超平面的划分来解决非线性划分问题,这个考虑是重要的,但是,如何求出这些自适应线性元件却是一个一直未解决的问题Λ本文基于Jo rdan 曲线定理,提出了一种通用的基于分类超曲面的分类法,它不需要考虑使用何种核函数,旨在通过区域合并计算获得多个超平面组成的双侧闭曲面作为分类超曲面对空间划分,并根据超曲面关于样本点的围绕数的奇偶进行分类的一种分类算法Λ所获得的分类超曲面在一定意义下可以看作以超平面为自适应线性元件的神经网络Λ这种方法使得基于非凸的超曲面的分类判别变得直接、简便、易行,同时避免使用SVM 方法向高维空间的升维变换Λ实验结果表明,基于分类超曲面的分类法可以有效地解决海量数据的分类问题,特别是多类分类问题,并能够显著提高分类效率和准确度Λ2 基于分类超曲面的分类法实际上,在解决非线性问题时,支持向量机是在向高维空间作升维变换,最终构成分类超平面.如果这时考虑这个过程的逆变换2降维变换,则分类超平面就变形为分类超曲面了,这说明SVM 是间接地去解决非线性问题Λ张铃与张钹教授基于邻域的空间划分方法,在解决非线性问题上具有一定的通用性,他们的方法也是在作升维变换,因此,在低维空间来看,他们工作的本质也是在找分类超曲面Λ是否能找到一种方法,不通过向高维空间作升维变换,而直接地解决非线性分类问题呢?本文提出的基于分类超曲面的分类法则对此作了一种新的尝试Λ2.1 理论基础SVM 直接判别方法基于拓扑学中的Jo rdan 曲线定理[10],定理如下ΛJordan 曲线定理 设X <R 3是闭子集,X 同胚于球面S 2,那么它的余集R 3X 有两个连通分支,一个是有界的,另一个是无界的,X 中任何一点的任何邻域与这两个连通分支均相交ΖJo rdan 曲线定理表明任何由球面经连续变形得到的双侧闭曲面都把三维空间分成两个区域——一个外部和一个内部,这种曲面可用于分类,这就是本文中要研究的分类超曲面Ζ给定一个点,如何判断它在分类曲面的内部还是在外部呢?分类判别定理 设X <R 3是平面的闭子集,X 同胚于球面S 2,那么它的余集R 3 X 有两个连通分支,一个是内部,另一个是外部,任取x ∈R 3 X ,则x ∈X 的内部α]自x 引出的射线与X 的相交数(即X 关于x 的围绕数)为奇数,x ∈X 的外部α]自x 引出的射线与X 的相交数为偶数Ζ上述定理可推广到高维空间Ζ39第3期基于超曲面的多类分类方法图1 分类判别定理示意图定理(高维空间的Jordan曲线定理) 若X<R3 X同胚于球面S m,那么mΦn,否则X=S nΖ若m<n,余集的同调群为H k(S n X)≌Z Z,若m=n-1且k=0Z,若m<n-1且k=00,其余特别地,当m=n-1时,S n X由两个连通分支组成,当m<n-1时,只有一个连通分支Ζ基于拓扑学中的Jo rdan曲线定理,不需要考虑使用何种核函数,通过与球面同胚的双侧闭曲面作为分类超曲面(Sep arating H yp er Su rface)对空间进行划分Λ分类超曲面可以由多个超平面构成,而点属于超曲面内部还是外部取决于该点引出的射线与超曲面相交为奇数还是偶数,该判别方法使得基于非凸的超曲面的分类判别变得直接、简便Λ2.2 基于分类超曲面的构造与分类基本过程根据上述定理我们提出如下基于分类超曲面的分类法,整个过程如下:第1步 设已给的样本点落在一个长方体区域中;第2步 将此区域划分成若干小区域,使每个小区域至多含一个样本点;第3步 根据样本点的类别对每个含样本点的小区域边界进行标定,构成含类别分量的边界向量链表;第4步 合并相邻同类区域边界,获得若干小平面封闭组成的分类超曲面,并以链的形式存储分类超曲面;第5步 输入新样本点,计算该点关于以上分类超曲面的围绕数,根据围绕数判定该样本点所在的类;另一种简便方法是选择适当的由待定点出发的射线,通过射线与分类超曲面的相交数(即分类超曲面关于样本点的围绕数)的奇偶性判断样本点所在的类;若不能判断,就围绕该点做一个小矩形,并对边界进行标定,之后转入第4步Λ3 二维数据分类双螺旋分类问题[3]:两条螺旋线K1和K2(极坐标形式)K1:Θ=ΗK2:Θ=Η+Π, Π2ΦΘΦ8Π(1) 根据上述基本思想,设计出基于分类超曲面的分类法的训练算法及分类算法(二元)如下Ζ1)学习过程图2 实现方案设矩形区域为归一化单元格(如图2),训练样本落入此区域内一单元格内,按照类别(X,O)将此单元格分为两类,分别标注边界;将同类区域边界合并,并以链表形式存放Ζ2)细化方案若单元格内已有一不同类训练样本,则将此单元格细化,并进行归一化操作,继续标注,再合并边界,存放边界链表;循环完成此训练过程Ζ3)分类过程当一待识别的样本(A)进入此区域后,作射线,与存储链表形成的区域多边形各边作相交操作,根据判别点是否在多边形内的规则,即两类49系统工程理论与实践2003年3月边界围绕数的奇偶性,判断出此样本所属类别Ζ如果样本所在小区域已经细化,则将样本坐标单位化,放入细化区域,继续进行上述的分类过程Ζ训练所得分类链表及其对样本点的覆盖情况见图3.图3 二维分类链表及其对样本点的覆盖情况3.2.1 大规模样本实验结果1)二维训练结果见表1. 表1 二维大规模样本训练结果样本点个数训练所需时间分类所需时间3召回率(%)10,800,0001h 34m 57s 2h 17m 35s 100.0022,500,0023h 16m 9s 4h 49m 55s 100.0054,000,0007h 42m 52s11h 47m 7s100.00 3测试样本点集合为训练样本点本身集合.2)二维分类测试结果见表2.表2 二维大规模样本测试结果样本点个数3测试样本点个数分类所需时间3正确率(%)10,800,00022,500,0024h 7m 4s 100.0022,500,00254,000,00011h 25m 3s 100.0054,000,00067,500,00214h 37m 6s100.00 3样本点个数为训练点个数3.2.2 二维小样本训练,大样本分类测试结果(见表3).表3 二维小样本训练,大样本分类测试结果样本点个数3测试样本点个数33分类所需时间正确率(%)5,40254,00241s 99.595,402540,0006m 45s 99.5827,002540,0006m 44s 99.9854,002540,0006m 47s 100.0054,0025,400,0001h 7m 7s100.003样本点个数为训练点个数;33测试样本点由Sp iral 螺线构造的另一样本集合(样本数量为训练样本的10倍以上)Λ表3表明基于分类超曲面的分类法有很好的泛化能力Λ59第3期基于超曲面的多类分类方法4 三维数据分类三维数据分类方法与二维基本相同,不同之处有以下几点:样本空间为归一化立方体;各单元区域表示为以下结构:单元区域区域标号类别标志边界(面)链表训练样本分层链表结构:训练样本同层样本链表层次标志下层样本链表4.1 构造测试数据双螺旋分类问题[3]:两条螺旋线K 1和K 2(极坐标形式)K 1:Θ=ΗK 2:Θ=Η+Π Π2ΦΘΦ8Π(2)在公式(2)的基础上,增加一Z 分量,Z =Θ构造三维训练样本集合及测试样本集合,如图4所示Λ4.2 实验过程实验经过以下几个步骤:1)生成训练样本,导入数据库;2)对训练样本进行训练,记录训练所需时间;保存训练所得分类链表;3)从数据库提取分类链表,对测试样本进行分类,记录测试所需时间,记录分类结果,计算分类正确率Λ测试样本的选取一类为训练样本本身集合,一类为数量多倍于训练样本的另一样本集合Λ图4 三维测试数据4.2.1中小规模样本实验结果1)训练结果(见表4)69系统工程理论与实践2003年3月表4 三维中小规模样本训练结果样本点个数①训练所需时间②分类所需时间③召回率(%)④5,4027s 4s 100.0013,50012s 11s 100.0027,00223s 22s 100.0054,00240s 45s 100.00108,0001m 17s 1m 30s 100.00540,0006m 16s 7m 36s 100.001,350,00215m 41s 19m 21s 100.005,400,0001h 2m 39s1h 17m 53s100.00①样本点为等角速度构造;②时间表示为间隔:h (小时)、m (分钟)、s (秒);③测试样本点集合为训练样本点本身集合;④测试样本点实际类别为构造时所得.2)训练所得分类链表训练所得分类链表的保存和提取均可在几秒内完成,且需要的存储空间极少Λ训练所得分类链表及其对样本点的覆盖情况见图5.3)分类测试结果(见表5)表5 三维中小规模样本测试结果样本点个数①测试样本点个数②分类所需时间正确率(%)5,40213,50012s 99.8713,50027,00223s 99.9527,00254,00245s 99.9954,002108,0001m 30s 100.00108,000540,0007m 30s 100.00540,0001,350,00218m 59s 100.001,350,0025,400,0001h 17m 13s100.00 ①样本点个数为训练点个数;②测试样本点为同公式构造的另一样本集合Λ4.2.2 大规模样本实验结果1)训练结果(见表6)表6 三维大规模样本训练结果样本点个数训练所需时间①分类所需时间召回率(%)10,800,0002h 6m 23s 2h 34m 45s 100.0022,500,0024h 23m 18s5h 22m 26s100.00 ①测试样本点集合为训练样本点本身集合.2)分类测试结果(见表7)表7 三维大规模样本测试结果样本点个数①测试样本点个数分类所需时间正确率(%)5,400,00010,800,0002h 35m 48s 100.0010,800,00022,500,0025h 14m 51s 100.0022,500,00260,000,00014h 25m 8s100.00 ①样本点个数为训练点个数4.2.3 小样本训练,大样本分类测试结果(见表8)79第3期基于超曲面的多类分类方法图5 分类链表及其对样本点的覆盖情况表8 三维小样本训练,大样本分类测试结果样本点个数①测试样本点个数②分类所需时间正确率(%)5,40254,00245s 99.825,402540,0007m 42s 99.8127,002540,0007m 34s 99.9854,002540,0007m 33s 100.0054,0025,400,0001h 15m 59s 100.0054,00222,500,0025h 15m 19s100.00 ①样本点个数为训练点个数;②测试样本点由同公式构造的另一样本集合(样本数量为训练样本的10倍以上)Λ表8表明基于分类超曲面的基于分类超曲面的分类法具有很好的泛化能力Λ4.2.4 多类测试结构(见表9).89系统工程理论与实践2003年3月表9 多类测试结果类数样本点个数①测试样本点个数②分类所需时间正确率(%)6270061620062m 19s 99.76%627006162000023m 99.76%1045010270000039m 45s 99.71%12540123240124m 55s99.72% ①样本点个数为训练点个数;②测试样本点由同公式构造的另一样本集合Λ4.3 算法与实验结果分析根据分类超曲面的思想,我们给出以上算法实现过程.当同类样本点在有限个连通分支分布时,学习算法与分类算法的算法复杂度都是多项式的Λ为保证分类曲面的连续性,在实际学习算法中,链表需同时记录同区域内同类训练样本,但在样本集规模很大的情况下,可对细化的层次进行控制,即在训练过程中将不影响分类曲面生成的样本删除,可保证计算速度Λ此外,在记录分类曲面时,只需存储对分类过程中与样本所引射线正交的边界面,可进一步减少对计算机资源的要求Λ注 上面两节所有数据均在以下测试环境中获得:1)主机 处理器:奔腾III ,733M H z ;内存:256M ;2)操作系统 M icro soft W indow s 2000Server ,Service Pack 2;3)数据库 M icro soft A ccess 2000;4)编译环境 V isual C ++6.0,Service Pack 4.5 结论本文基于分类超曲面,提出了一种通用的基于分类超曲面的分类法用于数据分类,并由此提出了分类超曲面的思想Λ实验证明采用基于分类超曲面的分类方法,在对非线性数据进行分类是完全可行的,而在处理大规模样本数据时,分类速度和正确率都可以得到保证,并且无须考虑矩阵的复杂计算,因而可以大大节省计算资源,大大提高分类效率Λ同时,实验证明基于分类超曲面的分类法处理三维多类数据,可得到较好的效果Λ对于海量数据(107),基于分类超曲面的分类法可得到较高的计算速度,同时对计算机资源要求很低,而传统的SVM 不具备有这种优点Λ另外小样本训练大样本测试结果表明基于分类超曲面的分类法的泛化能力较好Λ应当指出,本文所讨论方法是对直接解决非线性分类问题的一种尝试,此方法的一个前提是同类样本点应具有在有限个连通分支分布的特点,但与连通分支的形状无关Λ实际中处理的数据大多满足这种条件Λ此种方法在处理如此分布的数据集时,有较好的效果Λ并且有望把此算法推广到更高维数据Λ参考文献:[1] V apn ik V N .Suppo rt vecto r m ethod fo r functi on app rox i m ati on ,regressi on esti m ati on and signal p rocessing [J ].N eu ral Info rm ati on P rocessing System s ,Cam b ridge ,M A :M IT P ress ,1996,9:281-287.[2] V apn ik V N .T he N atu re of Statistical L earn ing T heo ry [M ].N ew Yo rk :Sp ringer 2V erlag ,1995.[3] 张学工.关于统计学习理论与支持向量机[J ].自动化学报,2000,26(1):32-42.[4] V apn ik V N .统计学习理论的本质[M ].张学工,译.北京:清华大学出版社,2000.[5] V apn ik V N .Statistical L earn ing T heo ry [M ].N ew Yo rk :J W iley ,1998.[6] L ing Zhang ,Bo Zhang .A Geom etrical R ep resen tati on of M cCu lloch 2P itts N eu ral M odel and Its A pp licati on s [J ].IEEE T ran sacti on s on N eu ral N etw o rk s ,1999,10(4):925-929.[7] 张文生,丁辉,王珏.基于邻域原理计算海量数据支持向量的研究[J ].软件学报,2001,12(5):711-720.[8] W idrow B ,W in ter R G .L ayered neu ral nets fo r pattern recogn iti on [J ].IEEE T ran sacti on s on A cou stics ,Speechand Signal P rocessing ,1988,36(3):1109-1118.[9] W idrow B ,HoffM .A dap tive s w itch ing circu its [J ].I R E W escon Conven si on R eco rd ,N ew Yo rk :In stitu te of R adi oEng ,1960,4:96-104.[10] W illiam Fu lton .A lgeb raic Topo logy ——a F irst Cou rse [M ].N ew Yo rk :Sp ringer 2V erlag 1995.[11] 边肇棋,等.模式识别(第二版)[M ].北京:清华大学出版社,2000.[12] Bu rges C J C .A tu to rial on suppo rt vecto r m ach ines fo r pattern recogn iti on [J ].D ata M in ing and Know ledgeD iscovery ,1998,2(2):121-167.99第3期基于超曲面的多类分类方法。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

推广性的界

❖ 函数集合的VC维描述了函数的复杂程度,利用

VC维可以确定推广性的界,下列不等式右半部

分至少以概率1-η成立:

Remp w R w Remp w

hln 2n h 1 ln 4

7.1 统计学习的本质

❖ 系统S为研究对象,通过一系列的观测样本来求得 学习机LM,使得LM的输出 yˆ 能够尽量准确的预测 S的输出y。

(x1,y1),(x2,y2),…,(xn,yn)

输入 x

系统(S)

输出 y

学习机(LM)

预测输出 yˆ

风险

❖ 学习机LM的输出 yˆ 与输入x之间可以看作是一个函 数关系:

经验风险为0的条件下(超平面能够正确分类全部训练样

本),最小化权值矢量的长度 w 。

验证技术(Validation)

❖ 当无法计算函数集的VC维时,可以采用验证技术。将样本集 分为训练集和验证集,用训练集的样本训练网络,用验证集 的样本测试网络,寻找一个验证集风险最小的模型和参数。

权值衰减

❖ 实验表明,多层感知器网络中比较小的权值往 往能够提高系统的推广能力,因此在训练过程 中可以有意地衰减权值:

lim

n

Remp

w

R

w

பைடு நூலகம்

期望风险与经验风险的关系

期望风险R(w) 经验风险Remp(w)

R(w*)

n

Remp w Rw

7.2 函数集的VC维与推广性的界

❖ 统计学习的推广能力不仅同训练样本数n有关系, 而且同学习机的函数集选择有关系,“简单的”的 函数集合推广能力强,“复杂”的函数集合推广能 力差。

wnew 1 wold

❖ 或者采用一个等价的目标函数:

J ef

J w 2

wT w

n

其中h为函数集合的VC维,n为训练样本数。

❖ 当n/h较小时,置信范围较大;n/h较大时,置信 范围较小:

Remp

w

R

w

Remp

w

n h

7.3 提高推广能力的方法

❖ 提高推广能力的本质方法是由原来只优化经验风险 Remp w

变为优化期望风险的上界 Remp w n h :

欠学习

过学习

结构风险最小化原则

SRM在线性分类器上的应用(SVM)

❖ d维空间中的线性函数的VC维为d+1,但当限制判别界 面的分类间隔时,其VC有可能更小。

❖ 定理:在d维空间中,设所有n个样本都在一个超球范围

之内,超球的半径为R,那么△-间隔分类超平面集合的

VC维h满足如下不等式:

R2

h

min

2

,

n

1

❖ 而间隔 1 w ,因此根据SRM的原则,只需在保证

(SRM,Structural Risk Minimization)

❖ 首先把函数集 S f x, w, w 分解为一个函

数子集序列:

S1 S2 L Sk L S

各个子集按照VC维的大小排序:

h1 h2 L hk L

在子集序列中寻找经验风险与置信范围之和最 小的子集,这个子集中使经验风险最小的函数 就是所求的最优函数。

❖ 期望风险定义为:

Rw L y, f x, wdF x, y

❖ 统计学习的目的就是要寻找到一个最优的函数 f(x,w*),使得R(w*)最小。

经验风险

❖ 期望风险一般来说无法计算,在工程上转而计

算经验风险:

Remp

w

1 n L n i1

yi , f xi , w

❖ 求取最优参数w*,使得经验风险Remp(w*)最小。 ❖ 当学习过程具有一致性时,统计学有如下关系:

❖ 当函数集过于“复杂”时,很容易产生“过学习” 现象:对于训练样本风险很小,而对非训练样本风 险却很大。

过学习

VC维

❖ 打散:如果存在一个有h个样本的样本集能够被一 个函数集中的函数按照所有可能的2h种形式分为两 类,则称函数集能够将样本数为h的样本集打散;

❖ VC维:如果函数集能够打散h个样本的样本集,而 不能打散h+1个样本的样本集,则称函数集的VC维 为h。

yˆ f x

❖ 一般需要将函数 f x 限定在特定的一组函数 f x, w

中求取。

❖ 定义风险: L y, f x, w

均方误差: L y, f x, w y f x, w2

似然函数: L px, w ln px, w

期望风险

❖ y与x之间存在一定的依赖关系,可以用一个未 知的联合概率F(x,y)描述。